일반 소개

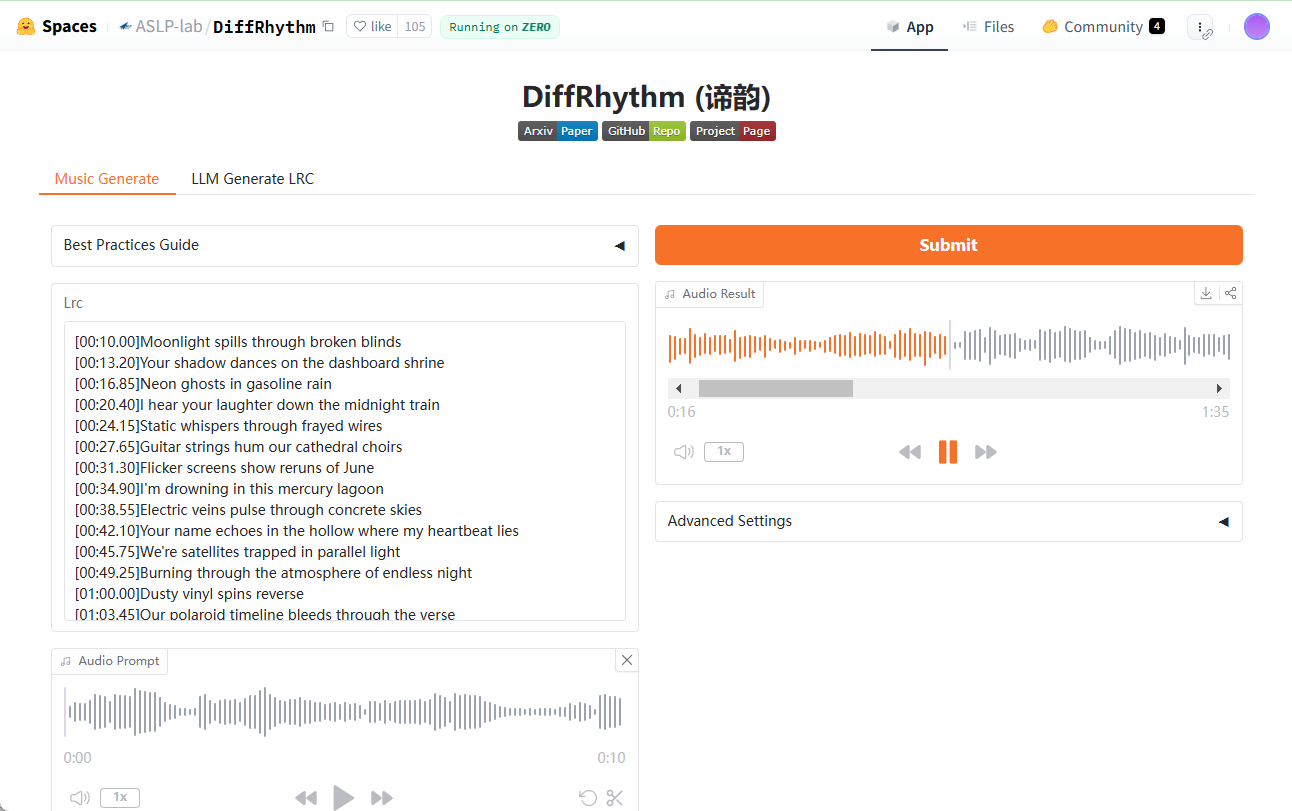

DiffRhythm은 노스웨스턴 폴리테크닉 대학교의 오디오, 음성 및 언어 처리 그룹인 ASLP-lab에서 개발한 오픈 소스 프로젝트로, 인공지능 기술을 통한 엔드투엔드 음악 제작에 중점을 두고 있습니다. 잠재 확산 모델을 기반으로 하며 보컬과 백 보컬을 포함해 최대 4분 45초 길이의 완전한 곡을 단 10초 만에 생성할 수 있습니다. 이 도구는 빠를 뿐만 아니라 사용이 간편하고 가사와 스타일 단서만 제공하면 고품질 음악을 생성할 수 있으며, DiffRhythm의 목표는 복잡성이 높고 생성 시간이 긴 기존 음악 생성 모델을 해결하는 것이며, 엔터테인먼트 업계의 음악 제작자, 교육자 및 사용자에게 적합한 문제점의 일부만 생성할 수 있습니다.

ComfyUI 워크플로 캡슐화: Chttps://github.com/billwuhao/ComfyUI_DiffRhythm

체험: https://huggingface.co/spaces/ASLP-lab/DiffRhythm

기능 목록

- 엔드투엔드 곡 생성가사와 스타일 단서를 입력하면 보컬과 백킹 트랙이 포함된 전체 노래를 자동으로 생성합니다.

- 빠른 추론최대 4분 45초 분량의 노래를 10초 안에 생성합니다.

- 멜로디와 동기화된 가사생성된 멜로디가 가사의 음절과 리듬과 자연스럽게 일치하는지 확인합니다.

- 스타일 사용자 지정다양한 음악 스타일 큐를 지원하여 사용자의 요구에 맞는 음악을 생성합니다.

- 오픈 소스 지원:: 사용자가 기능을 사용자 지정하고 확장할 수 있는 소스 코드와 모델을 제공합니다.

- 고품질 출력생성된 음악은 음질과 청취성 측면에서 높은 수준의 음악입니다.

도움말 사용

설치 프로세스

DiffRhythm은 GitHub 기반 오픈 소스 프로젝트로, 설치 및 실행을 위해 일부 프로그래밍 기반이 필요합니다. 자세한 설치 단계는 다음과 같습니다:

- 환경 준비

- 컴퓨터에 Python 3.8 이상이 설치되어 있는지 확인하세요.

- GitHub에서 코드를 다운로드하려면 Git을 설치하세요.

- 가상 환경을 사용하는 것이 좋습니다(예

venv어쩌면conda)를 사용하여 종속성 충돌을 방지합니다.

- 프로젝트 코드 다운로드

- 터미널을 열고 다음 명령을 입력하여 DiffRhythm 리포지토리를 복제합니다:

git clone https://github.com/ASLP-lab/DiffRhythm.git - 프로젝트 카탈로그로 이동합니다:

cd DiffRhythm

- 터미널을 열고 다음 명령을 입력하여 DiffRhythm 리포지토리를 복제합니다:

- 종속성 설치

- 프로젝트는 일반적으로 다음을 제공합니다.

requirements.txt파일에 필요한 파이썬 라이브러리가 나열되어 있습니다. - 터미널에서 다음 명령을 실행하여 종속성을 설치합니다:

pip install -r requirements.txt - 이 파일이 없는 경우 GitHub 페이지 또는 문서에서 종속성 노트를 참조하여 PyTorch와 같은 핵심 라이브러리를 수동으로 설치할 수 있습니다.

- 프로젝트는 일반적으로 다음을 제공합니다.

- 사전 학습된 모델 다운로드

- DiffRhythm의 사전 학습된 모델은 일반적으로 Hugging Face 또는 기타 클라우드 스토리지 플랫폼에서 호스팅됩니다.

- 인터뷰 ASLP-lab/DiffRhythm-base 모델 파일 다운로드(예

cfm_model.pt). - 다운로드한 모델 파일을 프로젝트 디렉터리의 지정된 폴더에 넣습니다(일반적으로 문서에 설명되어 있습니다).

models/).

- 설치 확인

- 예를 들어 터미널에서 간단한 테스트 명령을 실행합니다(정확한 명령은 GitHub의 README 파일 참조):

python main.py --test - 오류가 보고되지 않으면 설치에 성공한 것입니다.

- 예를 들어 터미널에서 간단한 테스트 명령을 실행합니다(정확한 명령은 GitHub의 README 파일 참조):

DiffRhythm 사용 방법

DiffRhythm의 핵심 기능은 가사와 스타일 단서를 입력하여 노래를 생성하는 것입니다. 자세한 작동 절차는 다음과 같습니다:

1. 입력 준비

- 노래 가사가사(중국어, 영어 등)를 작성하고 텍스트 파일로 저장합니다(예

lyrics.txt)를 클릭하거나 명령줄에 직접 입력합니다. - 스타일 팁:: 스타일에 대한 간단한 설명을 준비합니다(예: '팝 록', '클래식 피아노' 또는 '일렉트로닉 댄스 음악').

2. 노래 생성

- 터미널을 열고 DiffRhythm 프로젝트 디렉토리에 들어갑니다.

- 생성 명령을 실행합니다(구체적인 매개변수는 공식 문서를 기반으로 하며, 샘플 명령은 다음과 같습니다):

python generate.py --lyrics "lyrics.txt" --style "pop rock" --output "song.wav"

- 매개변수 설명:

--lyrics: 가사 파일 경로를 지정합니다.--style: 음악 스타일 큐를 입력합니다.--output: 출력 오디오 파일 경로와 이름을 지정합니다.

- 약 10초간 기다리면 프로그램이 지정된 경로에 WAV 형식의 오디오 파일을 생성합니다.

3. 출력 확인

- 생성이 완료되면

song.wav파일을 열고 오디오 플레이어(예: Windows Media Player 또는 VLC)를 사용하여 재생합니다. - 가사가 멜로디와 동기화되어 있는지, 음질이 예상과 일치하는지 확인합니다.

주요 기능

- 엔드투엔드 곡 생성: 세분화할 필요 없이 한 번에 완전한 곡을 생성하는 DiffRhythm. 사용자는 가사와 스타일만 제공하면 되며, 완성된 결과물을 얻기 위해 추가적인 매개변수 조정이 필요하지 않습니다.

- 빠른 추론비회귀 구조와 잠복 확산 기법 덕분에 생성 속도가 매우 빠릅니다. 몇 분씩 걸리는 기존 모델의 생성 시간과 비교하면 DiffRhythm의 10초 생성은 효율성을 크게 향상시킵니다.

- 멜로디와 동기화된 가사생성된 멜로디가 가사와 일치하지 않는 경우 가사의 음절 수를 조정하거나 스타일 팁에 '명확한 템포'와 같은 설명을 추가하여 출력을 최적화할 수 있습니다.

- 스타일 사용자 지정:: '재즈', '포크', '힙합' 등 다양한 스타일 큐를 시도하고 결과가 어떻게 달라지는지 관찰하세요. 스타일 큐가 구체적일수록 생성된 음악이 예상되는 음악에 더 가까워집니다.

팁 및 유용한 정보

- 가사 최적화짧은 가사는 긴 가사보다 멜로디에 맞추기 쉬우므로 지나치게 복잡한 문구를 피하세요.

- 일괄 생성:: 호출을 반복하는 간단한 스크립트를 작성합니다.

generate.py한 번에 여러 곡에 대해 노래를 생성할 수 있습니다. - 디버그 출력생성된 결과가 만족스럽지 않으면 로그 파일(있는 경우)을 확인하거나 GitHub 문서에 설명된 대로 모델 매개변수(예: 확산 단계 수)를 조정하세요.

주의

- 하드웨어 요구 사항생성 과정에는 높은 연산 리소스가 필요하므로 속도를 높이려면 GPU가 장착된 컴퓨터를 사용하는 것이 좋습니다.

- 오픈 소스 기여프로그래밍에 능숙하다면 프로젝트를 포크하여 코드를 최적화하거나 새로운 기능을 추가하고 풀 리퀘스트를 제출할 수 있습니다.

- 저작권 알림생성된 음악은 문체 유사성으로 인해 저작권 위험이 있을 수 있으므로 학습용 또는 비상업적 용도로만 사용하는 것을 권장합니다.

이 단계를 통해 DiffRhythm을 빠르게 시작하고 가사부터 완전한 노래까지 곡을 만드는 과정을 경험할 수 있습니다!

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...