일반 소개

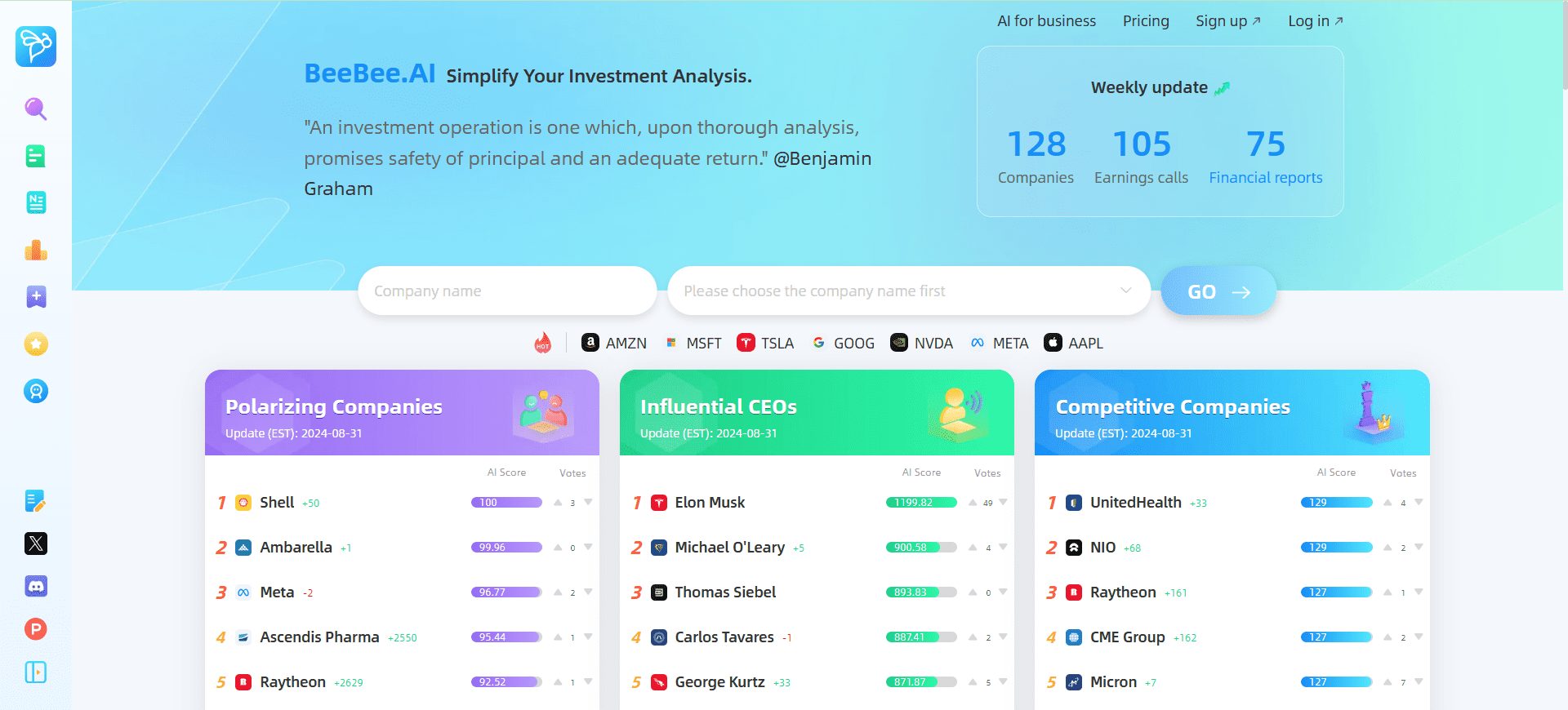

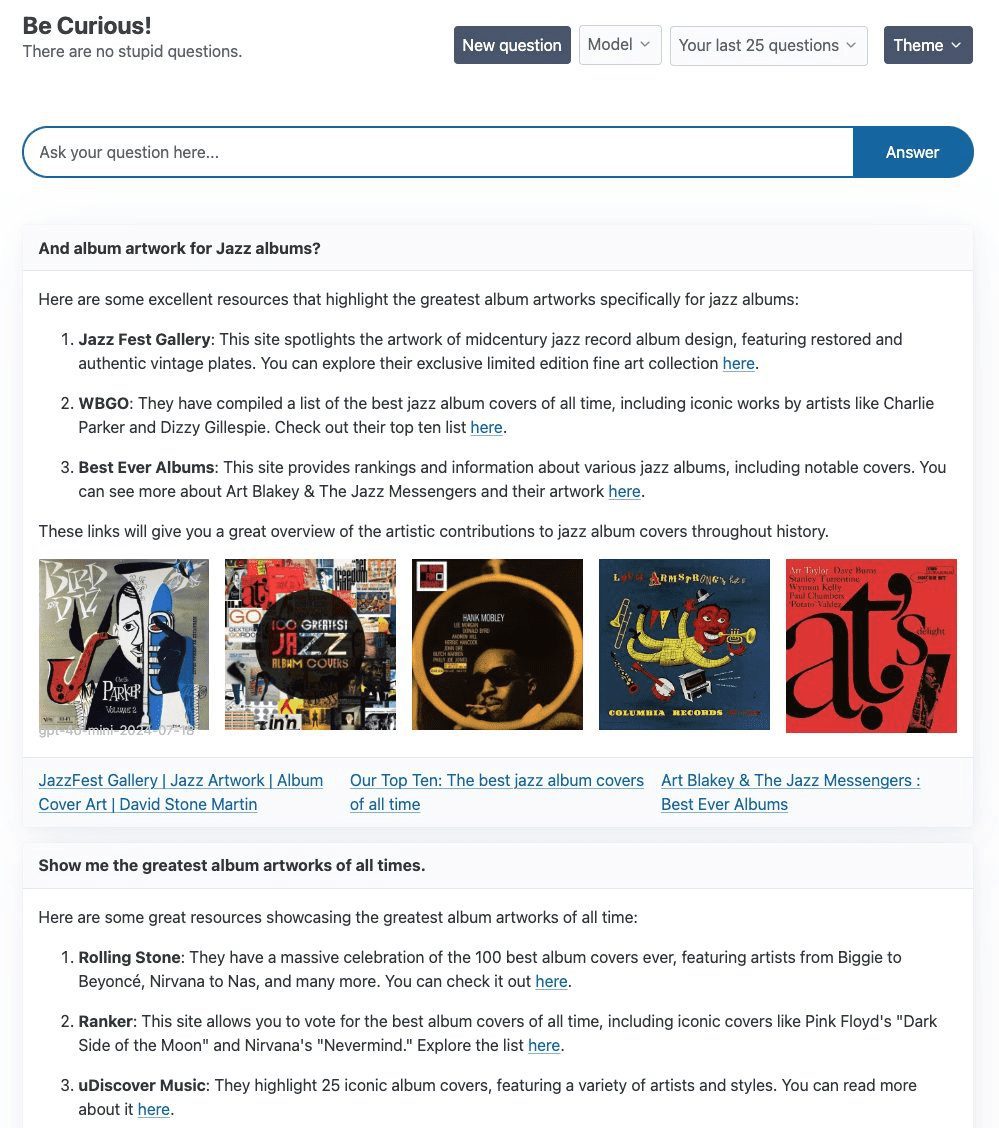

호기심은 탐구하고 실험하기 위해 고안된 프로젝트로, 주로 LangGraph 및 FastHTML 기술 스택을 구축하는 것을 목표로 합니다. 퍼플렉서티 AI 의 검색 제품입니다. 이 프로젝트의 핵심은 간단한 ReAct 에이전트를 사용하여 Tavily Curiosity는 OpenAI의 gpt-4o-mini, Groq의 llama3-groq-8b-8192-tool-use-preview를 비롯한 다양한 대규모 언어 모델(LLM)을 지원합니다. Ollama 이 프로젝트는 기술적 구현뿐만 아니라 고품질의 시각적 및 대화형 경험을 보장하기 위해 프런트엔드 디자인에도 많은 시간을 할애했습니다.

기능 목록

- LangGraph 및 FastHTML 기술 스택 사용

- 통합 타빌리 검색 강화 텍스트 생성

- gpt-4o-mini, llama3-groq 및 llama3.1을 포함한 여러 LLM 지원

- 유연한 백엔드 스위칭 기능 제공

- 프런트엔드는 FastHTML로 구축되었으며 WebSockets 스트리밍을 지원합니다.

도움말 사용

설치 단계

- 복제 창고:

git clone https://github.com/jank/curiosity - 최신 Python3 인터프리터가 있는지 확인하세요.

- 가상 환경을 설정하고 종속성을 설치합니다:

python3 -m venv venv source venv/bin/activate pip install -r requirements.txt - 설정

.env파일을 열고 다음 변수를 설정합니다:OPENAI_API_KEY=<your_openai_api_key> GROQ_API_KEY=<your_groq_api_key> TAVILY_API_KEY=<your_tavily_api_key> LANGCHAIN_TRACING_V2=true LANGCHAIN_ENDPOINT="https://api.smith.langchain.com" LANGSMITH_API_KEY=<your_langsmith_api_key> LANGCHAIN_PROJECT="Curiosity" - 프로젝트를 실행합니다:

python curiosity.py

사용 가이드라인

- 프로젝트 시작: 실행

python curiosity.py그 후 프로젝트가 시작되고 로컬 서버에서 실행됩니다. - LLM 선택필요에 따라 적절한 LLM(예: gpt-4o-mini, llama3-groq 또는 llama3.1)을 선택합니다.

- Tavily로 검색대화에 쿼리를 입력하면 ReAct 에이전트가 Tavily 검색을 통해 텍스트 생성을 향상시킵니다.

- 프런트엔드 상호 작용프로젝트의 프런트엔드는 FastHTML을 사용하여 구축되었으며 실시간 응답을 보장하기 위해 WebSockets 스트리밍을 지원합니다.

일반적인 문제

- LLM 전환 방법: in

.env파일에서 적절한 API 키를 구성하고 프로젝트를 시작할 때 원하는 LLM을 선택합니다. - 웹 소켓 문제뚜렷한 이유 없이 웹소켓이 닫히는 문제가 발생하면 네트워크 연결 및 서버 구성을 확인하는 것이 좋습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...