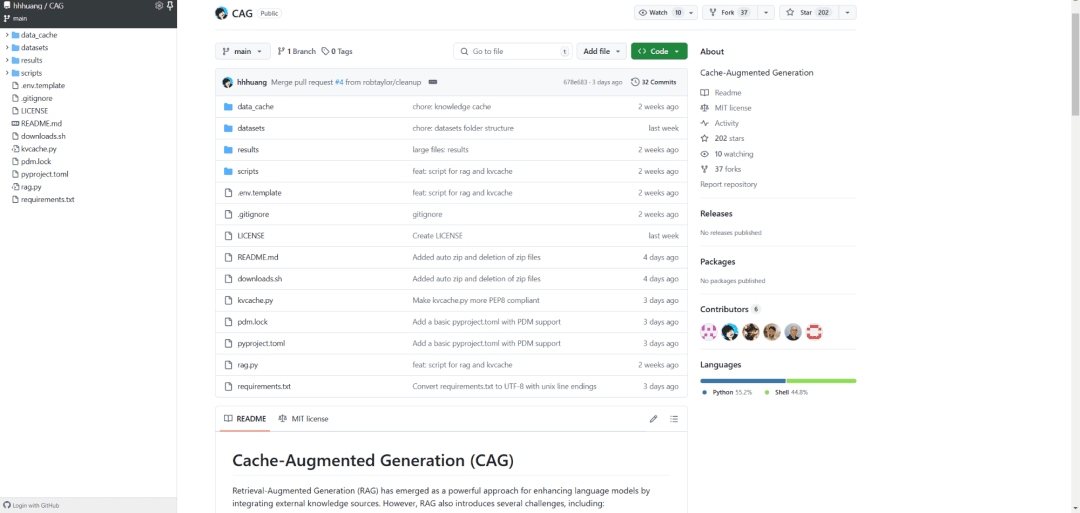

RAG(검색 증강 세대)보다 40배 빠른 CAG(캐시 증강 세대)는 외부 데이터를 실시간으로 검색하는 대신 모든 지식을 모델 컨텍스트에 미리 로드하여 지식 습득을 혁신적으로 개선합니다. 이는 마치 거대한 라이브러리를 필요할 때 넘겨볼 수 있는 이동형 툴킷으로 압축한 것과 같으며, CAG 구현은 매우 우아합니다:

- 먼저 문서가 LLM 컨텍스트 창에 맞도록 사전 처리됩니다.

- 그런 다음 처리된 콘텐츠는 키-값 캐시로 인코딩됩니다.

- 마지막으로 이 캐시는 메모리 또는 하드 드라이브에 저장되어 언제든지 불러올 수 있습니다.

그 결과는 놀랍습니다. HotPotQA 및 SQuAD와 같은 벤치마크 데이터 세트에서 CAG는 40배 더 빠를 뿐만 아니라 훨씬 더 정확하고 일관성이 높습니다. 이는 검색 오류나 불완전한 데이터의 문제 없이 전체적으로 컨텍스트를 캡처할 수 있기 때문입니다.

실제 적용 측면에서 이 기술은 의료 진단, 재무 분석, 고객 서비스 등의 분야에서 유망한 기술입니다. 복잡한 아키텍처의 유지 관리 부담을 피하면서 AI 시스템이 높은 성능을 유지할 수 있습니다.

결국 CAG의 혁신은 '테이크-어스-유고'를 '캐리-어라운드'로 전환하여 효율성을 개선할 뿐만 아니라 AI 배포의 새로운 가능성을 열어준다는 점입니다. 이는 차세대 AI 아키텍처의 표준이 될 수 있습니다.

참조:

[1] https://github.com/hhhuang/CAG

[2] https://arxiv.org/abs/2412.15605

[3] 긴 컨텍스트의 LLM, 긴 인컨텍스트 학습으로 어려움을 겪다: https://arxiv.org/pdf/2404.02060v2

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...