일반 소개

분재는 딥그로브-ai에서 개발한 오픈 소스 언어 모델로, 삼항 가중치를 사용하여 매개변수 크기가 5억 개입니다. 라마 아키텍처를 기반으로 하며 미스트랄 이 분류기는 3값 가중치를 지원하도록 조정된 선형 계층으로 설계되었습니다. 이 모델은 주로 총 50억 개 미만의 토큰으로 구성된 DCLM-Pro 및 Fineweb-Edu 데이터 세트를 사용하여 훈련되었습니다. 적은 양의 훈련 데이터에도 불구하고 Bonsai는 우수한 성능을 발휘하며 경쟁사 수준의 경량 3값 모델 중 하나입니다. 사용자는 허깅페이스 트랜스포머 라이브러리를 통해 호출할 수 있습니다. 프로젝트 코드는 효율적인 AI 모델을 탐색하는 개발자를 위해 GitHub에서 공개적으로 사용할 수 있습니다.

기능 목록

- 가볍고 효율적인 운영3값 가중치 기법이 사용되며, 작고 빠르며 리소스가 적은 기기에 적합한 모델입니다.

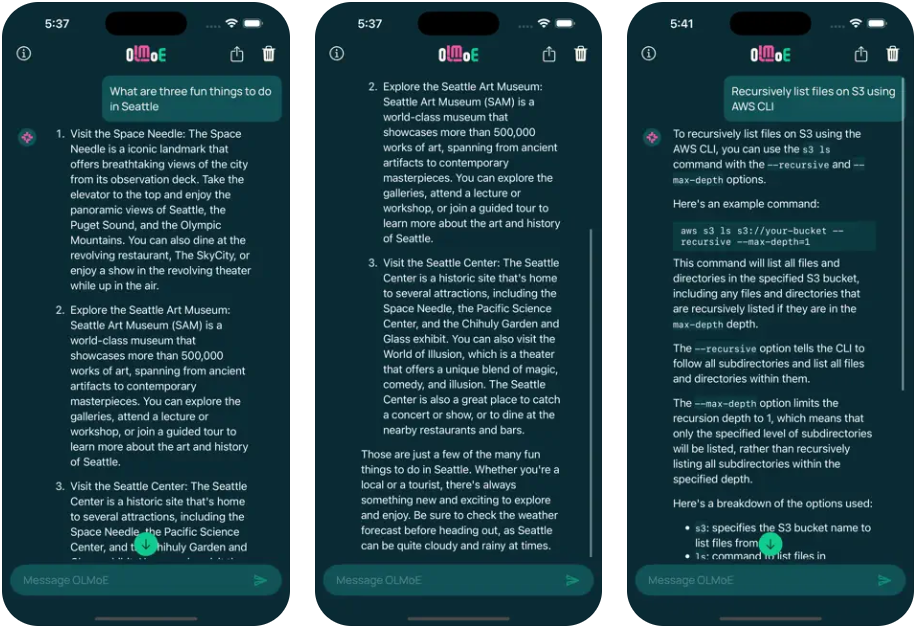

- 자연어 생성대화, Q&A 및 기타 작업에 사용할 수 있는 유창한 텍스트 생성을 지원합니다.

- 오픈 소스 액세스전체 코드는 GitHub에서 다운로드, 수정 및 최적화할 수 있습니다.

- 허깅페이스 호환간편한 로딩 및 배포를 위해 Transformers 라이브러리에 원활하게 통합됩니다.

- 뛰어난 성능: 소량의 학습 데이터로 동급 모델과 비슷한 성능을 발휘합니다.

도움말 사용

설치 프로세스

분재를 사용하려면 먼저 런타임 환경을 설정해야 합니다. 자세한 단계는 다음과 같습니다:

- Python 환경 확인

컴퓨터에 Python 3.8 이상이 설치되어 있는지 확인합니다. 터미널에 입력합니다:

python --version

아직 가지고 있지 않다면 Python 웹사이트에서 다운로드할 수 있습니다.

- 트랜스포머 라이브러리 설치

분재는 허깅페이스의 트랜스포머 라이브러리를 사용합니다. 터미널에서 실행합니다:

pip install transformers

설치 후 pip show transformers 버전을 확인합니다.

- 분재 모델 다운로드

이 모델은 허깅페이스에서 호스팅됩니다. 코드를 통해 자동으로 로드하거나(아래 참조) 수동으로 다운로드하는 것이 좋습니다. - 선택적 종속성 설치

미세 조정 또는 가속이 필요한 경우torch노래로 응답datasets::

pip install torch datasets

사용 방법

분재는 Python 스크립트를 사용하여 호출합니다. 기본 단계는 다음과 같습니다:

모델 및 스플리터 로드

Python에서 다음 코드를 실행합니다:

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("deepgrove/Bonsai", trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained("deepgrove/Bonsai", trust_remote_code=True)

텍스트 생성

텍스트를 입력하고 결과를 생성합니다:

text = "中国的首都是哪里?"

inputs = tokenizer(text, return_tensors="pt")

outputs = model.generate(**inputs, max_length=100)

result = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(result)

출력은 "중국의 수도는 베이징입니다."일 수 있습니다. .

조정 매개변수

예를 들어 생성 매개변수를 수정할 수 있습니다:

outputs = model.generate(**inputs, max_length=50, temperature=0.7)

max_length: 출력 길이를 설정합니다.temperature출력의 무작위성을 제어하며, 값이 작을수록 안정적입니다.

주요 기능 작동

효율적인 운영

분재는 세 가지 값에 가중치를 부여하여 16비트 정밀도로 잘 실행됩니다. GPU를 사용할 수 있는 경우 자동으로 가속할 수 있습니다:

import torch

print(torch.cuda.is_available()) # 返回 True 表示 GPU 可用

GPU는 성능을 크게 향상시키지만 CPU는 정상적으로 작동합니다.

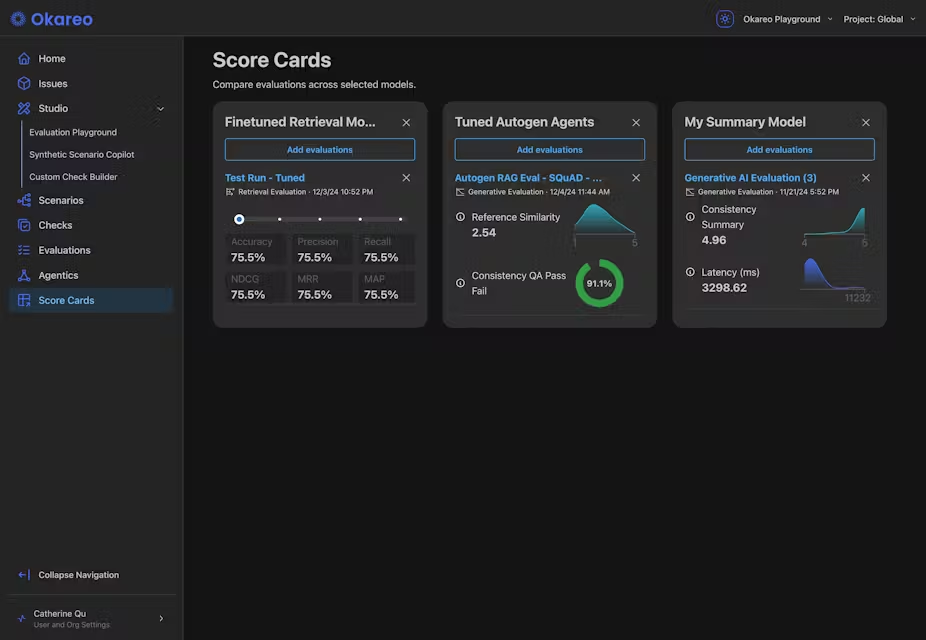

성능 평가

분재는 여러 벤치마크에서 좋은 성적을 거두고 있습니다. 공식 수치는 다음과 같습니다:

| 모델링 | ARC-c | ARC-e | HS. | OBQA | PiQA | Wino. | MMLU | 평균 점수 |

|---|---|---|---|---|---|---|---|---|

| MobiLlama 0.5B | 26.62 | 46.68 | 51.66 | 30.00 | 71.65 | 54.50 | 28.61 | 44.25 |

| Qwen 2 0.5B | 28.84 | 50.29 | 49.12 | 33.00 | 69.26 | 56.99 | 31.78 | 45.61 |

| MobileLLM 600M | 29.01 | 56.65 | 55.35 | 34.00 | 71.65 | 59.75 | 31.40 | 48.13 |

| Qwen 2.5 0.5B | 32.25 | 58.29 | 52.18 | 35.40 | 69.91 | 56.12 | 33.40 | 48.22 |

| 분재 | 33.36 | 57.95 | 48.04 | 34.00 | 70.24 | 54.85 | 30.28 | 46.96 |

| ARC, OBQA, MMLU 등을 포함한 이러한 테스트에서 Bonsai는 경량 모델 중 상위권에 랭크되었습니다. |

모델 미세 조정

분재는 범용 생성 작업에는 미세 조정할 수 없습니다. 특정 용도(예: 퀴즈)에 맞게 최적화해야 하는 경우 미세 조정할 수 있습니다:

- 데이터 준비: 텍스트 파일을 사용하거나

datasets라이브러리 로드 중입니다. - 구성 매개변수: 함께

TrainingArguments설정. - 교육 모델:

from transformers import Trainer, TrainingArguments

training_args = TrainingArguments(

output_dir="./bonsai_finetuned",

num_train_epochs=3,

per_device_train_batch_size=4

)

trainer = Trainer(model=model, args=training_args, train_dataset=your_dataset)

trainer.train()

자세한 내용은 다음을 참조하세요. 허깅페이스 문서.

주의

- 정밀도 제한현재 16비트 정밀도 연산만 지원되며, 개발팀은 혼합 정밀도 지원을 개발 중입니다.

- 명령 없는 튜닝기본 모델은 복잡한 명령어 작업에서 직접 사용하기에 적합하지 않으며 미세 조정이 필요합니다.

- 하드웨어 요구 사항일반 CPU로 실행 가능하며, GPU는 필수는 아니지만 권장됩니다.

애플리케이션 시나리오

- 교육 보조 자료

분재는 "프랑스의 수도는 어디인가요?"와 같은 기본 지식 질문에 답할 수 있습니다. . 입력 후 빠르게 답변이 생성되어 학습에 적합합니다. - 엣지 디바이스 애플리케이션

이 모델은 가볍고 현지화된 언어 처리를 위해 휴대폰이나 임베디드 장치에 배포하기에 적합합니다. - 모델링 연구

연구자들은 이를 사용하여 3값 가중치 기법의 잠재력을 테스트하고 효율적인 AI 모델 설계를 탐색할 수 있습니다.

QA

- 분재의 핵심 강점은 무엇인가요?

3값 가중치 기법을 사용하여 리소스가 제한된 시나리오에 적합한 가볍고 높은 효율을 달성하며, 훈련 데이터는 적지만 강력한 성능을 제공합니다. - GPU가 필요하신가요?

CPU가 실행할 필요는 없지만 GPU가 속도를 높여줍니다. - 대화에 직접 사용할 수 있나요?

기본 모델에는 커맨드 튜닝 기능이 없으므로 특정 작업에 사용하기 전에 미세 조정하는 것이 좋습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...