일반 소개

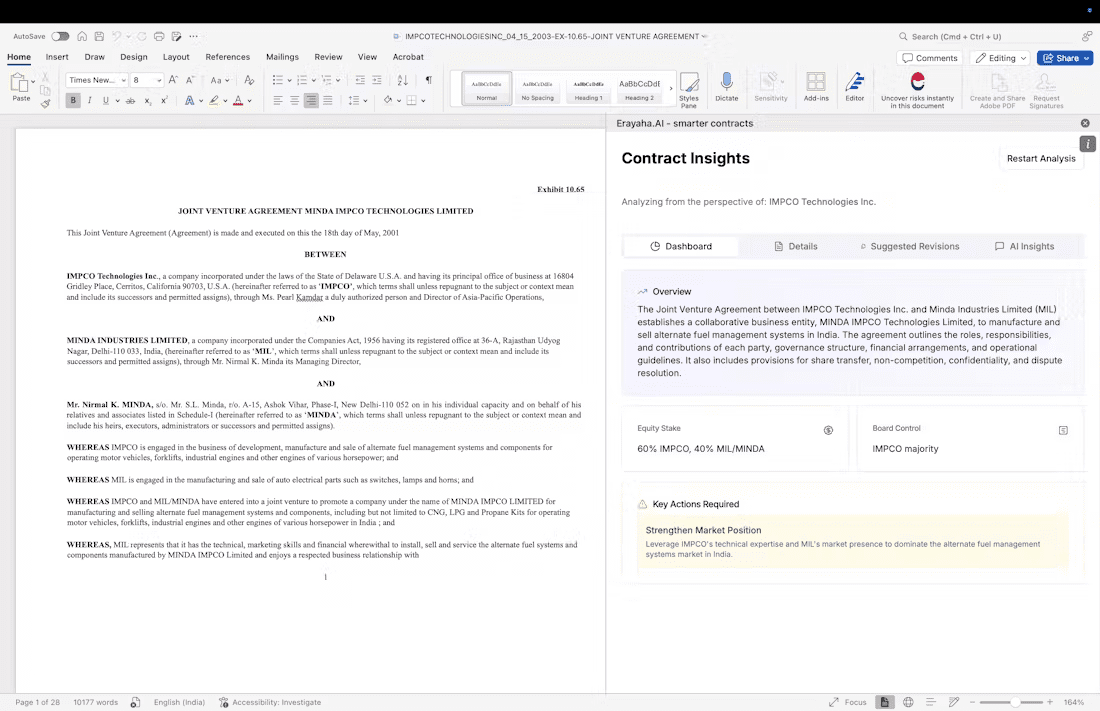

아카시챗은 탈중앙화된 클라우드 기반 인공지능 채팅 플랫폼입니다. 아카시 네트워크 개발 및 지원. 아카시챗은 엔비디아 GPU가 제공하는 고성능 컴퓨팅 파워를 활용하여 여러 오픈소스 대규모 언어 모델(예: QwQ-32B, 라마 3.3 70B, 라마 3.1 405B, 딥시크 R1 671B 등)을 실행하여 사용자에게 빠르고 무료이며 프라이버시 친화적인 대화 경험을 제공합니다. 아카시챗은 계정을 등록하지 않고도 사용할 수 있으며, 데이터 보안을 위해 채팅 로그는 사용자의 로컬 브라우저에만 저장되며, 아카시 슈퍼클라우드의 탈중앙화 아키텍처에 의존하여 기존의 중앙화된 클라우드 서비스의 한계를 극복하고 빠른 응답 시간뿐만 아니라 여러 AI 모델 간의 전환을 지원하여 효율적인 대화 도구가 필요한 사용자에게 적합합니다.

두 번째 추천은 아카시챗으로, 채팅을 위한 다양한 대형 추론 모델에 로그인 없이 접근할 수 있으며, 무료 API 키를 제공하여 클라이언트 측에서 대형 모델에 접근하고 싶지만 API 비용을 지불하고 싶지 않은 분들에게 매우 친절합니다(심지어 임베디드 모델인 BAAI-bge-large-en-v1-5를 무료로 제공합니다). 페이지 어시스트 + 아카시챗입니다. 페이지 어시스트 + 아카시챗은 매일 사용하기에 매우 가볍습니다!

- 아카시 애플리케이션 API 인터페이스: https://chatapi.akash.network/

- 존재 페이지 지원 에서 키를 구성합니다.

기능 목록

- 다중 모델 선택QwQ-32B, 라마 3.3 70B, 딥시크 R1 671B, 라마 3.1 405B, 아카시젠(사진 생성 모델) 및 기타 오픈소스 AI 모델을 지원하며, 사용자는 필요에 따라 전환할 수 있습니다.

- 고성능 대화NVIDIA H100 및 A100 GPU로 초당 최대 27 토큰의 응답 속도.

- 개인정보 보호채팅 로그는 클라우드 업로드 없이 로컬에 저장되므로 사용자 데이터 보안이 보장됩니다.

- 등록 필요 없음웹 페이지를 열면 사용할 수 있으며, 계정 로그인이 필요하지 않고 쉽고 편리하게 조작할 수 있습니다.

- 오픈 소스 지원코드가 완전히 오픈 소스이며 사용자가 직접 기능을 배포하거나 기여할 수 있습니다.

- 사용자 친화적인 인터페이스: 초보자와 전문가 모두에게 직관적이고 적합한 최신 채팅 인터페이스를 제공합니다.

도움말 사용

아카시챗을 시작하는 방법

아카시챗은 어떤 소프트웨어도 설치할 필요가 없으며, 브라우저를 통해 https://chat.akash.network/即可使用 을 방문하기만 하면 됩니다. 다음은 사용자가 빠르게 시작하고 기능을 최대한 활용할 수 있도록 도와드리는 자세한 지침입니다.

웹사이트에 액세스

- 최신 브라우저(예: Chrome, Firefox, Edge)를 엽니다.

- 주소창에 입력

https://chat.akash.network/를 클릭하고 Enter 키를 누릅니다. - 페이지가 로드되면 로그인이나 등록 없이도 바로 사용할 수 있는 깔끔하고 간단한 채팅 인터페이스가 표시됩니다.

AI 모델 선택

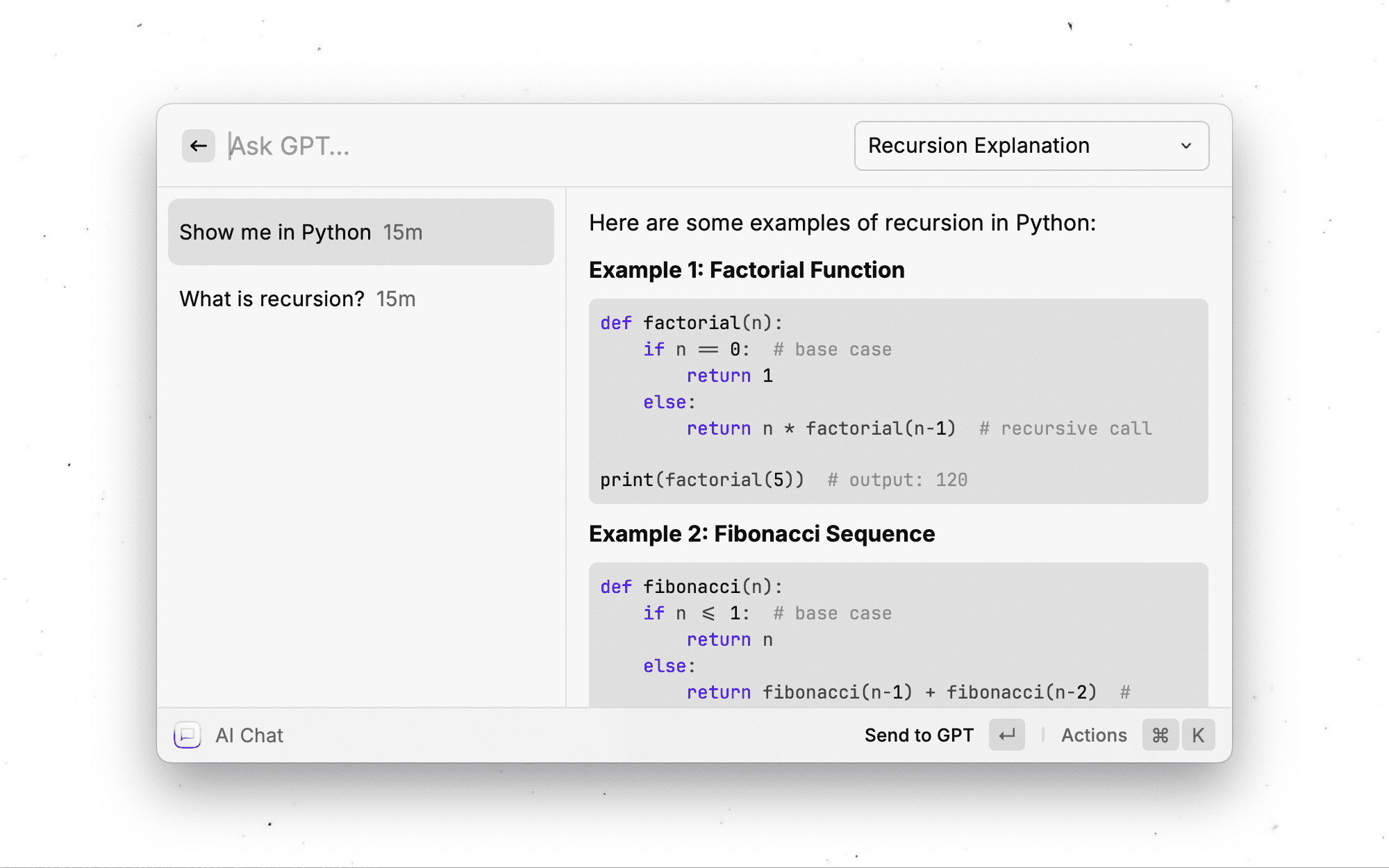

아카시챗은 다양한 오픈소스 AI 모델을 지원하며, 사용자는 필요에 따라 적절한 모델을 선택할 수 있습니다. 작동 단계는 다음과 같습니다:

- 채팅 인터페이스 상단 또는 사이드바(최신 인터페이스 디자인에 따라 정확한 위치가 변경될 수 있음)에서 '모델 선택' 드롭다운 메뉴를 찾습니다.

- 예를 들어 드롭다운 메뉴를 클릭하면 현재 지원되는 모델 목록이 표시됩니다:

- Llama 3.1 405B복잡한 질문에 대한 답변과 강력한 성능에 적합합니다.

- 미스트랄-7B: 반응이 빠르고 일상적인 대화에 적합한 가벼운 모델입니다.

- QwQ-32B일부 대형 모델보다 성능이 뛰어난 최신 고성능 모델입니다.

- 원하는 모델의 이름을 클릭하면 시스템이 자동으로 전환되며, 전환 과정은 일반적으로 몇 초 밖에 걸리지 않습니다.

질문을 입력하고 답변 받기

- 채팅 화면의 텍스트 입력란에 "오늘 날씨가 어때요?" 또는 "짧은 문자를 써줘"와 같이 묻고 싶은 질문이나 내용을 입력합니다. 또는 "짧은 글 써줘"와 같이 입력합니다.

- Enter 키를 누르거나 보내기 버튼(일반적으로 화살표 아이콘)을 클릭합니다.

- AI는 몇 초 내에 응답을 생성하여 대화 상자에 표시합니다. 응답 속도는 모델과 네트워크 조건에 따라 다르며 일반적으로 초당 27토큰 이내입니다.

채팅 로그 관리

아카시챗의 가장 큰 특징 중 하나인 개인 정보 보호 설계는 채팅 로그가 서버에 업로드되지 않고 브라우저에 로컬로 저장된다는 점입니다. 로그를 관리하는 방법은 다음과 같습니다:

- 기록 보기페이지를 열 때마다 이전 대화 상자가 자동으로 로드됩니다(동일한 브라우저를 사용하고 캐시가 지워지지 않은 경우).

- 기록 지우기채팅 기록을 지워야 하는 경우, 브라우저 설정에서 캐시를 지우거나 브라우저의 '추적 금지 모드'를 사용하여 기록이 남지 않도록 할 수 있습니다.

- 주의기기나 브라우저를 변경한 후에는 데이터가 클라우드 저장소에 의존하지 않으므로 이전 채팅을 동기화할 수 없습니다.

오픈 소스 배포(고급 사용자)

기술적 배경을 가진 사용자를 위해, 아카시챗은 로컬 또는 아카시 네트워크 자체에 배포할 수 있는 오픈 소스 코드를 제공합니다. 단계는 다음과 같습니다:

- 코드 받기GitHub 리포지토리(https://github.com/akash-network/akash-chat)를 방문하여 '복제' 또는 'ZIP 다운로드'를 클릭하고 소스 코드를 다운로드합니다.

- 종속성 설치::

- Node.js와 npm이 로컬에 설치되어 있는지 확인합니다.

- 터미널의 프로젝트 폴더로 이동하여 다음을 실행합니다.

npm i필요한 종속성을 설치합니다.

- 구성 환경::

- 프로젝트 루트 디렉터리에서

.env.local문서화. - 다음 구성을 입력합니다(실제 필요에 맞게 조정):

DEFAULT_MODEL=mistral DEFAULT_SYSTEM_PROMPT=你是一个有帮助的助手,提供准确信息。 API_KEY=你的密钥 API_HOST=你的API端点(如Ollama部署地址)

- 프로젝트 루트 디렉터리에서

- 프로젝트 실행::

- 터미널에 다음을 입력합니다.

npm run dev를 클릭하면 로컬 개발 서버가 시작됩니다. - 브라우저를 열고 다음 사이트를 방문하세요.

http://localhost:3000자체 배포 버전을 사용할 수 있습니다.

- 터미널에 다음을 입력합니다.

- 아카시에 배포::

- 아카시 공급자 콘솔을 사용하여 아카시 슈퍼클라우드에 프로젝트를 배포하고, 자세한 단계는 아카시 공식 웹사이트 문서(https://akash.network/)를 참조하세요.

주요 기능 작동

- 모델을 전환하여 다양한 스타일 경험하기다양한 모델 응답 스타일을 사용해 보세요(예: Llama 3.1은 심층 분석에 적합하고, Mistral-7B는 더 간결하고 직접적입니다).

- 신속한 응답 테스트복잡한 질문(예: "양자역학 설명하기")을 입력하고 응답 속도와 답변의 품질을 관찰하세요.

- 개인 정보 보호 모드 사용데이터 유출이 걱정된다면 브라우저의 추적 금지 창을 사용하여 흔적이 남지 않도록 할 수 있습니다.

주의

- 네트워크 요구 사항네트워크 안정성 보장, 아카시챗은 실시간 계산에 의존하며 지연 시간이 길면 경험에 영향을 줄 수 있습니다.

- 모델 제약 조건일부 모델은 도메인별 문제를 잘 처리하지 못할 수 있으므로 모델을 더 자주 전환해 보는 것이 좋습니다.

- 피드백 제안문제가 발생하거나 기능 제안이 있는 경우 GitHub를 통해 피드백을 제출하고 오픈 소스 커뮤니티에 참여하여 개선할 수 있습니다.

무료 모델 목록(채팅 인터페이스에서 제공되는 모델과 정확히 일치하지 않음)

채팅 + 완료

DeepSeek-R1-Distill-Llama-70B

DeepSeek-R1-Distill-Qwen-14B

DeepSeek-R1-Distill-Qwen-32B

Meta-Llama-3-1-8B-Instruct-FP8

Meta-Llama-3-1-405B-Instruct-FP8

Meta-Llama-3-2-3B-Instruct

Meta-Llama-3-3-70B-Instruct

임베딩

BAAI-bge-large-en-v1-5

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...