Tarsier: 高品質な動画説明を生成するためのオープンソース動画理解モデル

はじめに

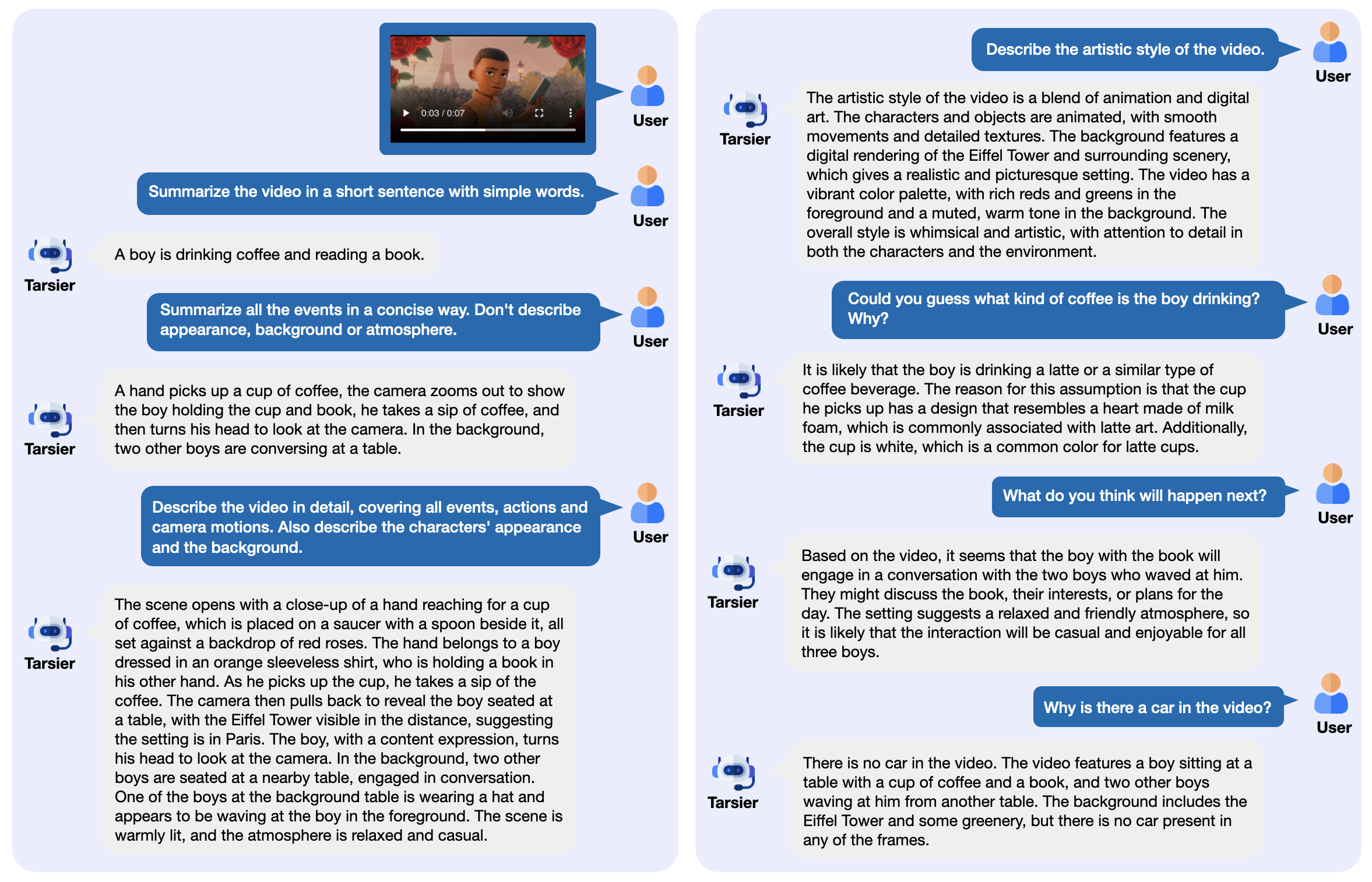

Tarsierは、ByteDanceによって開発されたオープンソースのビデオ言語モデルファミリーで、主に高品質のビデオ記述を生成するために使用される。CLIP-ViTがビデオフレームを処理し、Large Language Model (LLM)と組み合わせて時間的関係を分析するというシンプルな構造で構成されている。最新版のTarsier2-7B(2025年1月リリース)は16の公開ベンチマークでトップレベルに達し、GPT-4oなどのモデルと競合できる。 Tarsierは動画記述、Q&A、ゼロサンプル字幕生成をサポートしており、コード、モデル、データはGitHubで公開されている。このプロジェクトは、動画記述能力を評価するためのDREAM-1Kベンチマークも立ち上げており、1000の多様な動画クリップが含まれている。

機能一覧

- 詳細な動画説明文の生成:動画コンテンツを分析し、詳細なテキストを出力します。

- ビデオQ&Aサポート:イベントや詳細など、ビデオ関連の質問にお答えします。

- ゼロサンプル字幕生成:トレーニングなしでビデオの字幕を生成します。

- マルチタスク・ビデオ理解:クイズやキャプションなど、複数のタスクをこなす。

- オープンソースの展開:ローカルまたはクラウドで実行するためのモデルウェイトとコードを提供する。

- 評価ツールの提供:DREAM-1KデータセットとAutoDQ評価手法を含む。

ヘルプの使用

Tarsierは開発者や研究者など、技術的なバックグラウンドを持つユーザーに適しています。詳しいインストール方法と使い方は以下の通りです。

設置プロセス

- 環境を整える

Python 3.9以降が必要です。仮想環境を推奨:

conda create -n tarsier python=3.9

conda activate tarsier

- クローン倉庫

Tarsierプロジェクトコードをダウンロードする:

git clone https://github.com/bytedance/tarsier.git

cd tarsier

git checkout tarsier2

- 依存関係のインストール

インストールスクリプトを実行する:

bash setup.sh

これにより、PyTorchやHugging Faceのツールなど、必要なライブラリがすべてインストールされる。

- GPUサポート(オプション)

NVIDIA GPUを持っている場合は、CUDA付きのPyTorchをインストールしてください:

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu118

- ダウンロードモデル

Hugging Faceからモデルをダウンロードする:

huggingface-cli download omni-research/Tarsier2-7b

Tarsier-34bやTarsier2-Recap-7bのような他のモデルも公式リンクから入手できる。

- インストールの確認

クイックテストスクリプトを実行します:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --input_path assets/videos/coffee.gif

出力は、「男性がハート型の泡がついたコーヒーカップを手に取り、一口飲む」といったビデオの説明文にする。

主な機能

動画の説明を生成する

- 動く

- 動画ファイルを用意する(MP4、GIFなどのフォーマットに対応)。

- コマンドを実行する:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --instruction "Describe the video in detail." --input_path your/video.mp4

- 出力は端末に表示され、例えば映像の動作やシーンを説明する。

- 銘記する

- 長すぎる動画はより多くのメモリを必要とする可能性がありますので、まずは短い動画でテストすることをお勧めします。

- フレームレートなどの調整可能なパラメータ

configs/tarser2_default_config.yaml).

ビデオQ&A

- 動く

- 質問とビデオを指定する:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --instruction "视频里的人在做什么?" --input_path your/video.mp4

- 彼はコーヒーを飲んでいます」など、直接的な答えを出力する。

- 注意を引く

- 質問は具体的で曖昧さを避けるべきである。

- 中国語とその他の言語をサポートし、中国語が最も効果的です。

ゼロサンプル字幕生成

- 動く

- 字幕モードを有効にするために設定ファイルを修正する (

configs/tarser2_default_config.yamlセットアップtask: caption). - 走っている:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --config configs/tarser2_default_config.yaml --input_path your/video.mp4

- 一人でコーヒーを飲む」などの短い字幕を出力する。

現地でのサービス展開

- 動く

- vLLM(推奨バージョン0.6.6)をインストールします:

pip install vllm==0.6.6

- サービスを開始する:

python -m vllm.entrypoints.openai.api_server --model path/to/Tarsier2-7b

- APIで呼び出される:

curl http://localhost:8000/v1/completions -H "Content-Type: application/json" -d '{"prompt": "描述这个视频", "video_path": "your/video.mp4"}'

- バンテージ

- ビデオはバッチ処理できる。

- 他のシステムとの統合が容易

注目の機能操作

DREAM-1Kアセスメント

- 動く

- DREAM-1Kデータセットをダウンロードする:

wget https://tarsier-vlm.github.io/DREAM-1K.zip

unzip DREAM-1K.zip

- 運用評価:

bash scripts/run_inference_benchmark.sh path/to/Tarsier2-7b output_dir dream

- 出力には、記述の質を示すF1スコアなどのメトリクスが含まれる。

AutoDQの評価

- 動く

- 設置の確認 チャットGPT 依存関係(Azure OpenAIの設定が必要)。

- 評価スクリプトを実行する:

python evaluation/metrics/evaluate_dream_gpt.py --pred_dir output_dir/dream_predictions

- 説明の正確さを測る自動評価スコアを出力します。

よくある質問

- 設置失敗Pythonのバージョンとネットワークをチェックし、pipをアップグレードする。

pip install -U pip). - モデルの読み込みが遅いディスク容量が十分あることを確認してください。少なくとも50GBを推奨します。

- GPU出力なし走る

nvidia-smiCUDAが正常に動作していることを確認する。

オンライン体験

- インタビュー Tarsier2-7B オンラインデモ説明文とQ&A機能をテストしたい場合は、ビデオをアップロードしてください。

これらのステップを踏めば、Tarsierで動画タスクを簡単に処理できます。説明文の作成もサービスの展開も、シンプルで効率的です。

アプリケーションシナリオ

- ビデオ・コンテンツの照合

メディア関係者はTarsierを使ってビデオ要約を作成し、映像を素早く整理することができる。 - 教育ビデオ支援

教師はコースのビデオに字幕やクイズを作成し、指導や学習を強化することができます。 - 短いビデオ分析

マーケティング担当者は、TikTokのような短い動画の内容を分析し、プロモーションのための重要なメッセージを抽出することができる。

品質保証

- どのようなビデオフォーマットに対応していますか?

FFmpegがデコードできる限り、MP4、GIF、AVIなどをサポートする。 - ハードウェアの要件は?

最低16GBのRAMと4GBのビデオメモリ、NVIDIA GPUを推奨(3090など)。 - 市販されていますか?

はい、TarsierはApache 2.0ライセンスを使用しており、条件付きで商用利用が許可されています。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません