RunPod:AI向けに設計されたGPUクラウド・サービス、高速コールド・スタートSDと秒単位の課金を実現

はじめに

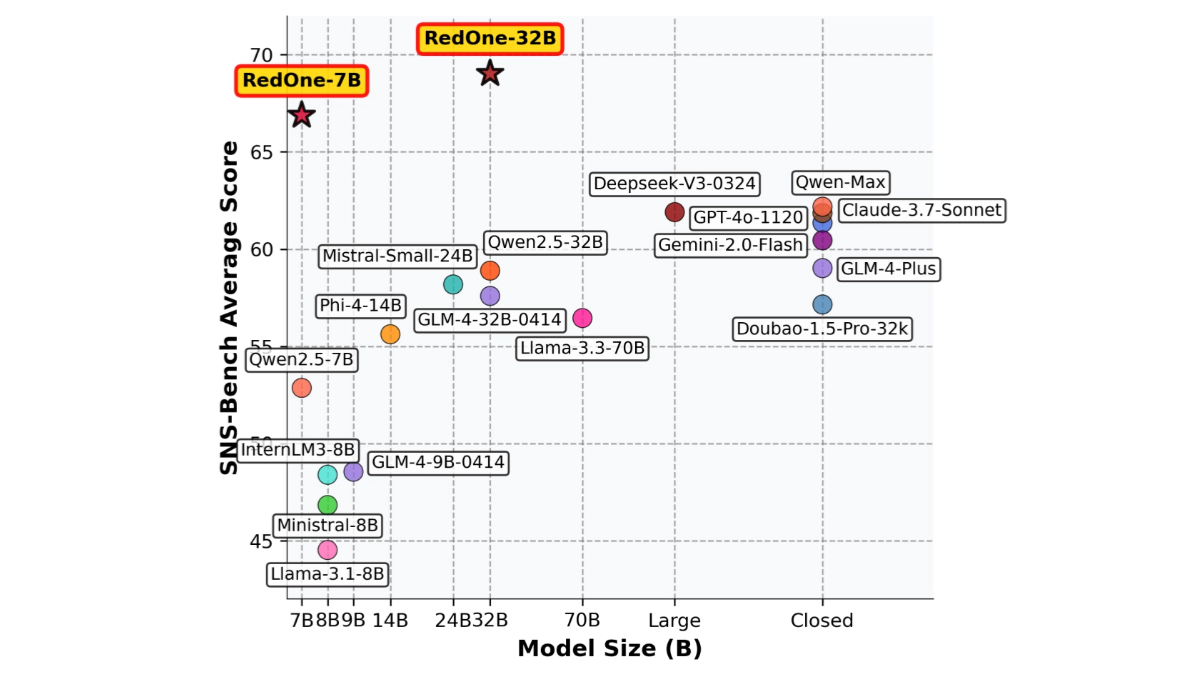

RunPodはAI専用に設計されたクラウドコンピューティングプラットフォームで、開発者、研究者、企業にAIモデル開発、トレーニング、スケーリングのためのワンストップソリューションを提供することを目指しています。このプラットフォームは、オンデマンドGPUリソース、サーバーレス推論、自動スケーリングなどを統合し、AIプロジェクトの全フェーズを強力にサポートする。RunPodの基本理念は、AI開発プロセスを簡素化することであり、ユーザーはインフラの問題をあまり気にすることなく、モデルの革新に集中することができる。

リクエスト時のみ支払い、コールドスタートが速く、低頻度のサービスに適しており、高品質な運用が要求される。一方、大規模な言語モデルの自然言語処理クラスは、トークンごとの支払いをサポートしています。

機能一覧

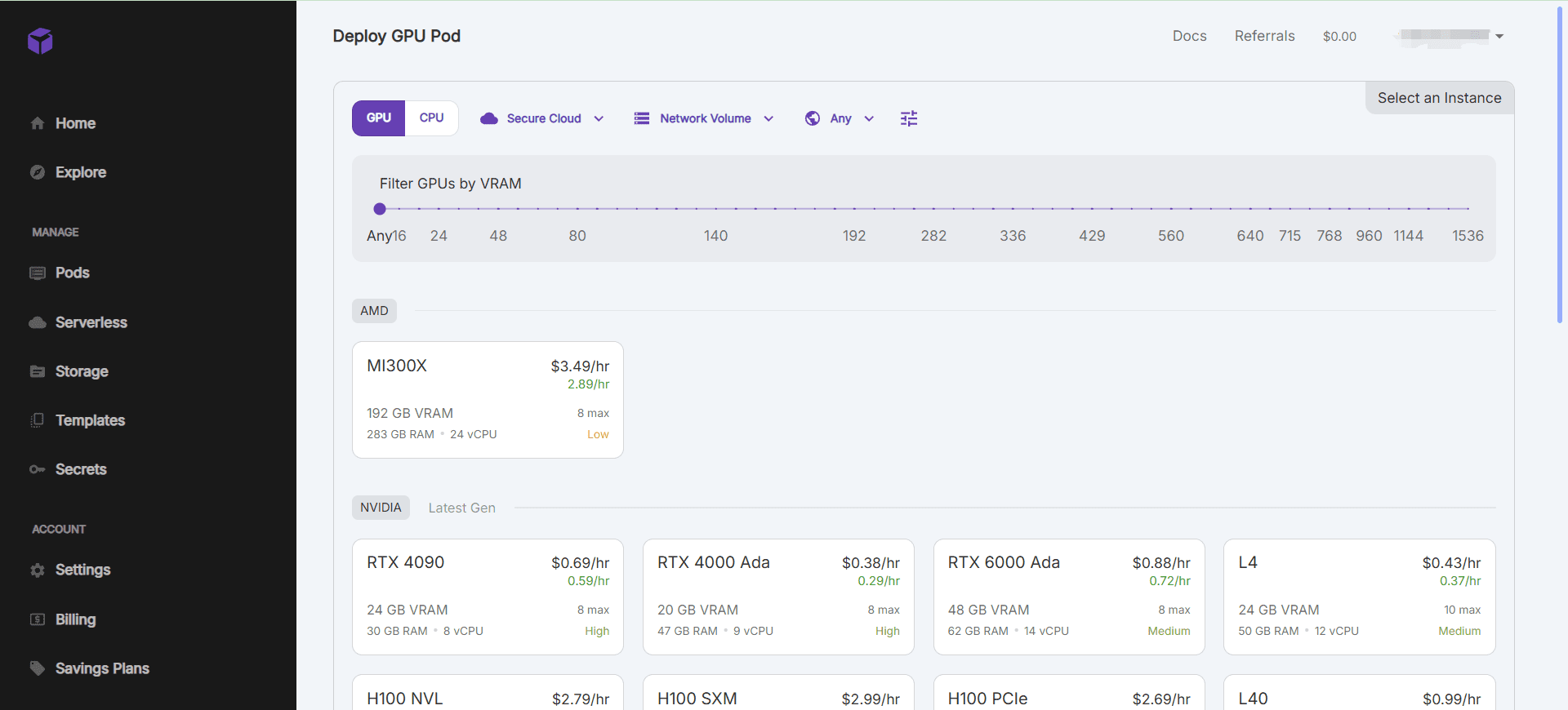

- オンデマンドGPUリソースGPUインスタンスの高速起動と、異なる演算要件に対応する複数のGPUモデルのサポート。

- サーバーレス推論変化するワークロードを効率的に処理するために、推論機能を自動的に拡張します。

- 開発環境の統合一般的に使用されているディープラーニングフレームワークやツールをサポートした、設定済みのAI開発環境。

- データ管理と保管効率的なデータ転送とアクセスメカニズムを備えた統合データストレージソリューション。

- コラボレーションとバージョン管理共同チーム開発をサポートし、モデルのバージョン管理機能を提供します。

ヘルプの使用

インストールと使用

- GPUインスタンスの作成::

- ログインしたら、コンソールページに移動し、「Create Pod」をクリックします。

- 希望するGPUモデルと構成を選択し、"Create "をクリックしてインスタンスを開始します。

- インスタンスが起動すると、SSHまたはウェブターミナル接続で操作できる。

- 設定済みの環境を使用する::

- RunPodは、PyTorchやTensorFlowなど、設定済みのAI開発環境を幅広く提供している。

- インスタンスを作成する際、希望の環境テンプレートを選択し、プロジェクト開発を素早く開始することができます。

- データ管理::

- RunPodは、コンソールでデータセットを管理するための統合データストレージソリューションを提供します。

- データのアップロード、ダウンロード、共有をサポートし、データのセキュリティとプライバシー保護を保証します。

- コラボレーションとバージョン管理::

- 共同チーム開発をサポートし、チームメンバーを招待して一緒にプロジェクトに取り組むことができます。

- モデルのバージョン管理機能を提供し、異なるバージョンのモデルを簡単に追跡・管理できる。

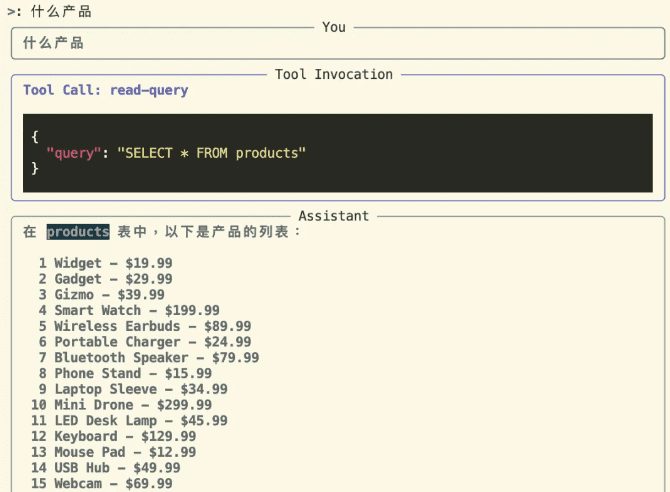

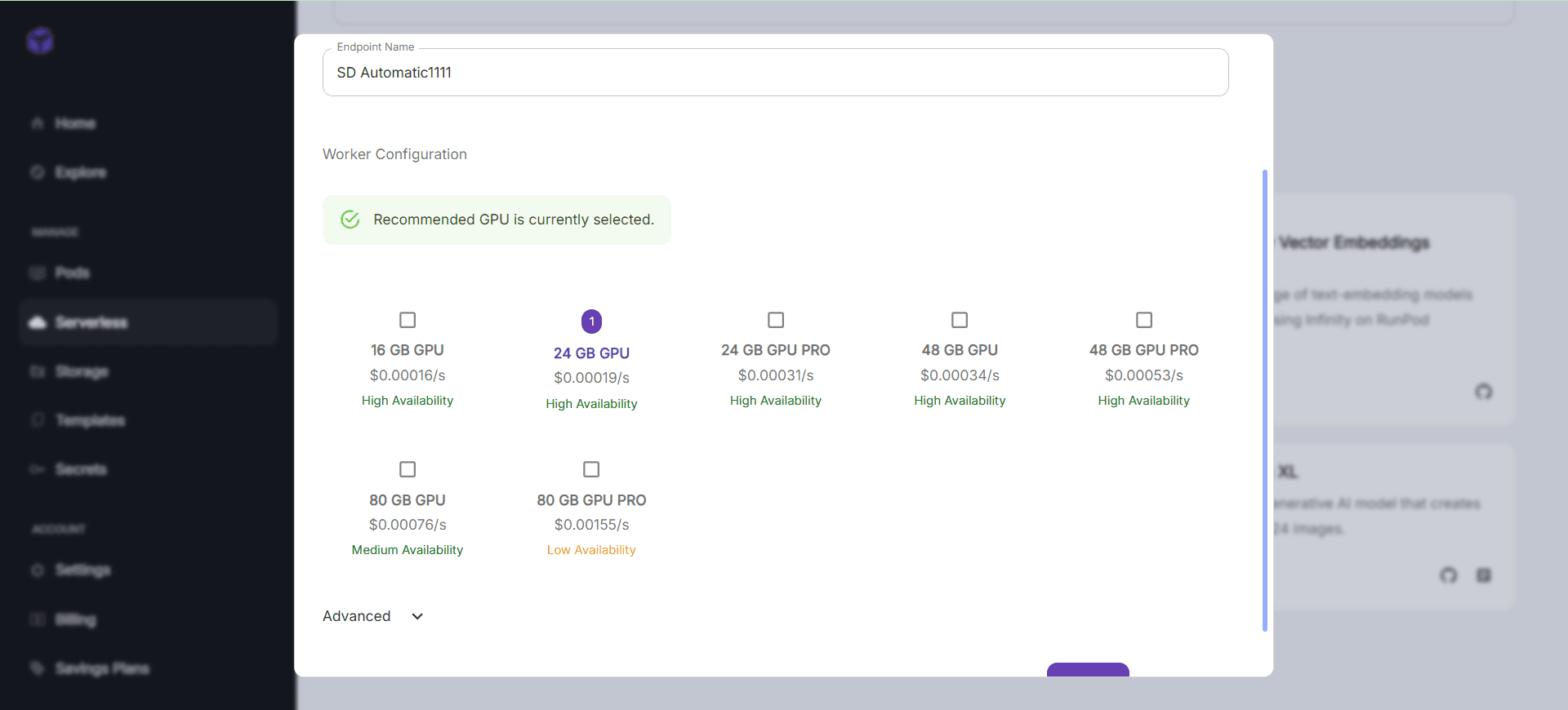

- サーバーレス推論::

- RunPodはサーバーレスアーキテクチャをサポートし、推論機能を自動的にスケールする。

- モデルのオンライン推論サービスを有効にするために、APIエンドポイントをコンソールで設定することができる。

ワークフロー

- クイックスタートGPUの例::

- コンソールにログインし、"Create Pod "を選択する。

- 希望するGPUモデルと構成を選択し、"Create "をクリックします。

- インスタンス起動後は、SSHまたはウェブターミナル接続で操作する。

- 設定済みの環境を使用する::

- インスタンスを作成する際に、必要な環境テンプレートを選択します。

- インスタンスに接続した後、設定済みの開発環境をプロジェクト開発に直接使用することができます。

- データ管理::

- コンソールでデータセットを管理し、データのアップロード、ダウンロード、共有をサポートします。

- データセキュリティとプライバシー保護を確保する。

- コラボレーションとバージョン管理::

- チームメンバーをプロジェクトに招待し、バージョン管理機能を使ってモデルのバージョンを追跡・管理します。

- サーバーレス推論::

- コンソールでAPIエンドポイントを設定し、モデルのオンライン推論サービスを有効にする。

- 自動的に推論機能を拡張し、ワークロードの変化に効率的に対応。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません