ゲーム「Clue of Time」において、GRPOがo1、o3-mini、R1をどのように凌駕したか。

近年、人工知能の分野では推論能力が大きく進歩している。昨年、OpenAIが大規模言語モデル(LLM)の強力な推論の可能性を示した後、Google DeepMind、アリババ、DeepSeek、そして アンソロピック カリフォルニア大学バークレー校のような組織は、「思考の連鎖」(CoT)機能を持つ高度なモデルを訓練するために強化学習(RL)技術を使用し、いち早く追随してきた。これらのモデルは、数学やプログラミングなどの分野における多くのベンチマークテストで、ほぼ飽和に近いスコアを達成している。

しかし、無視できない事実として、今日利用可能な最高のモデルでさえ、論理的推論の問題を扱う際には、まだいくつかの乗り越えられない障害に直面している。大規模な言語モデルは、関連するすべての細部に常に注意を払いながら論理的推論の首尾一貫した連鎖を維持したり、複数の推論ステップを確実につなげたりするのに苦労することが多い。通常のモデルの10倍から100倍の長さのコンテンツを生成する最先端のモデルでさえ、人間の問題解決者が容易に検出できる低レベルのエラーをしばしば起こす。

この疑問を探るため、この記事の著者であるブラッド・ヒルトンとカイル・コービットは、最新の強化学習技術を活用して、小規模なオープンソースモデルを推論性能の最前線に押し上げることはできないか、と考え始めた。この疑問に答えるために、彼らは次のような手法を選んだ。 グループ相対ポリシー最適化(GRPO) 強化学習アルゴリズムの

GRPOとは?

簡単に言えば、GRPOは戦略勾配を最適化する手法である。GRPOは、一連のモデル応答の相対的なメリットを比較することで、より効率的にポリシーを更新します。Proximal Policy Optimization (PPO)のような従来の手法と比較して、GRPOは優れた性能を保証しながら学習プロセスを簡素化する。

GRPOの妥当性を検証するために、彼らは "GRPO "と呼ばれるプログラムを選んだ。時間的手がかり「実験プラットフォームとしての推論ゲーム。

タイムクルーとは?

"Time Clue "は、古典的なボードゲーム "Clue (Cluedo) "にインスパイアされたパズルゲームです。このゲームでは、プレイヤーは一連の手がかりから犯人、凶器、場所、殺害時刻、動機を探し出さなければならない。オリジナルのゲームとは異なり、「タイム・クルー」は問題を5つの次元に拡大し、ゲームの複雑さと難易度を高めている。

著者らは、比較的弱いモデルから開始し、GRPOアルゴリズムを用いてゲーム「Time Clue」で繰り返し学習させた。時間の経過とともに、これらのモデルの推論能力は著しく向上し、最終的には最も強力なプロプライエタリモデルに匹敵するか、それを上回ることさえ観測された。

今、彼らは次のような情報を共有している。テストそして研修プログラムそしてデータセット 歌で応えるモデル重量 これらはすべてMITライセンスの下で自由に利用できる。

ベンチマーキング

実験を行うためには、まず、明確に検証可能な解を持ち、スケーラブルな複雑性を持つ、困難な推論タスクを特定する必要がある。偶然にも、著者の一人であるブラッド・ヒルトンは、以前、次のようなプロジェクトを立ち上げていた。 時間的手がかり これらのニーズを完璧に満たすパズルセットの基本的な事実のわかりやすさという基準を満たすだけでなく、必要に応じて新しいパズルを作ることもできる。

Temporal Clueは、人気のボードゲームにインスパイアされている。 クルーテンポラルクルーこのゲームでは、プレイヤーはチューダー邸でMr.ボディを殺した犯人を見つけるために競争します。Temporal Clueはこのゲームを、標準的なロジックパズルを超えた独立したロジックパズルに変えます。誰そして何を?そしてどこそして2つの次元を追加した:いつ?(時間)と何のために?(動機)。パズルはランダムに生成され、必要最低限だが十分なヒントが使われる。 ORツール な CP-SATソルバー 当選。

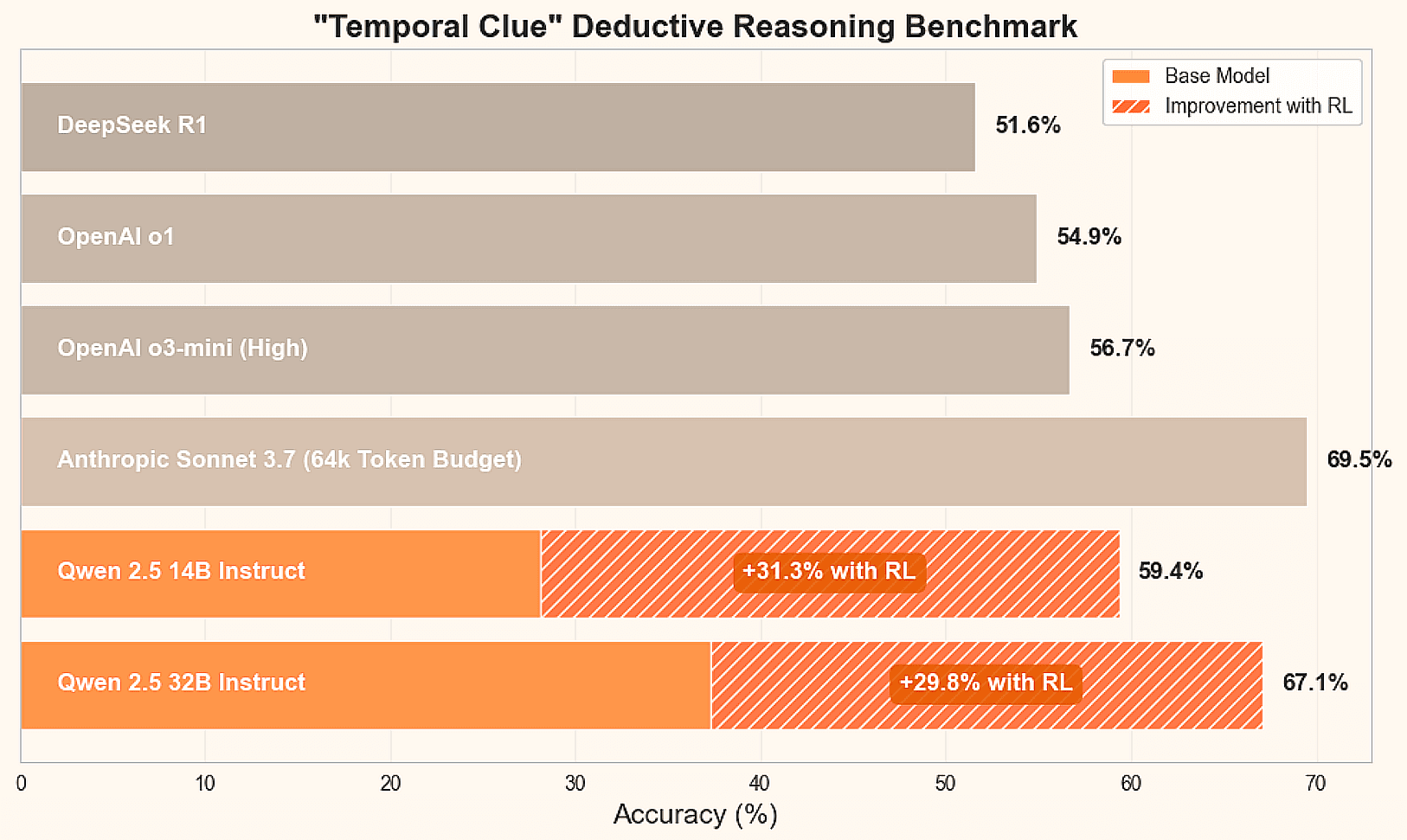

この推論タスクの現状を把握するために、彼らは以下のような主要な推論モデルをベンチマークした。 ディープシーク R1, 人類 クロード ソネット3.7、アリババのQwen2.5 14Bおよび32Bインストラクター・モデル。さらに、最終結果のプレビューも提供している:

| メカニズム | モデリング | 推理力 | 平均精度 | 平均コスト |

|---|---|---|---|---|

| ディープシーク | R1 | デフォルト | 51.6% | $0.029 |

| アンソロピック | ソネット3.7 | ない | 51.7% | $0.017 |

| アンソロピック | ソネット3.7 | 16k | 61.7% | $0.222 |

| アンソロピック | ソネット3.7 | 64k | 69.5% | $0.392 |

| アリババ、『アラビアンナイト』の登場人物 | クウェン 2.5 14B インストラクター | ない | 28.1% | $0.001 |

| アリババ、『アラビアンナイト』の登場人物 | クウェン 2.5 32B インストラクター | ない | 37.3% | $0.002 |

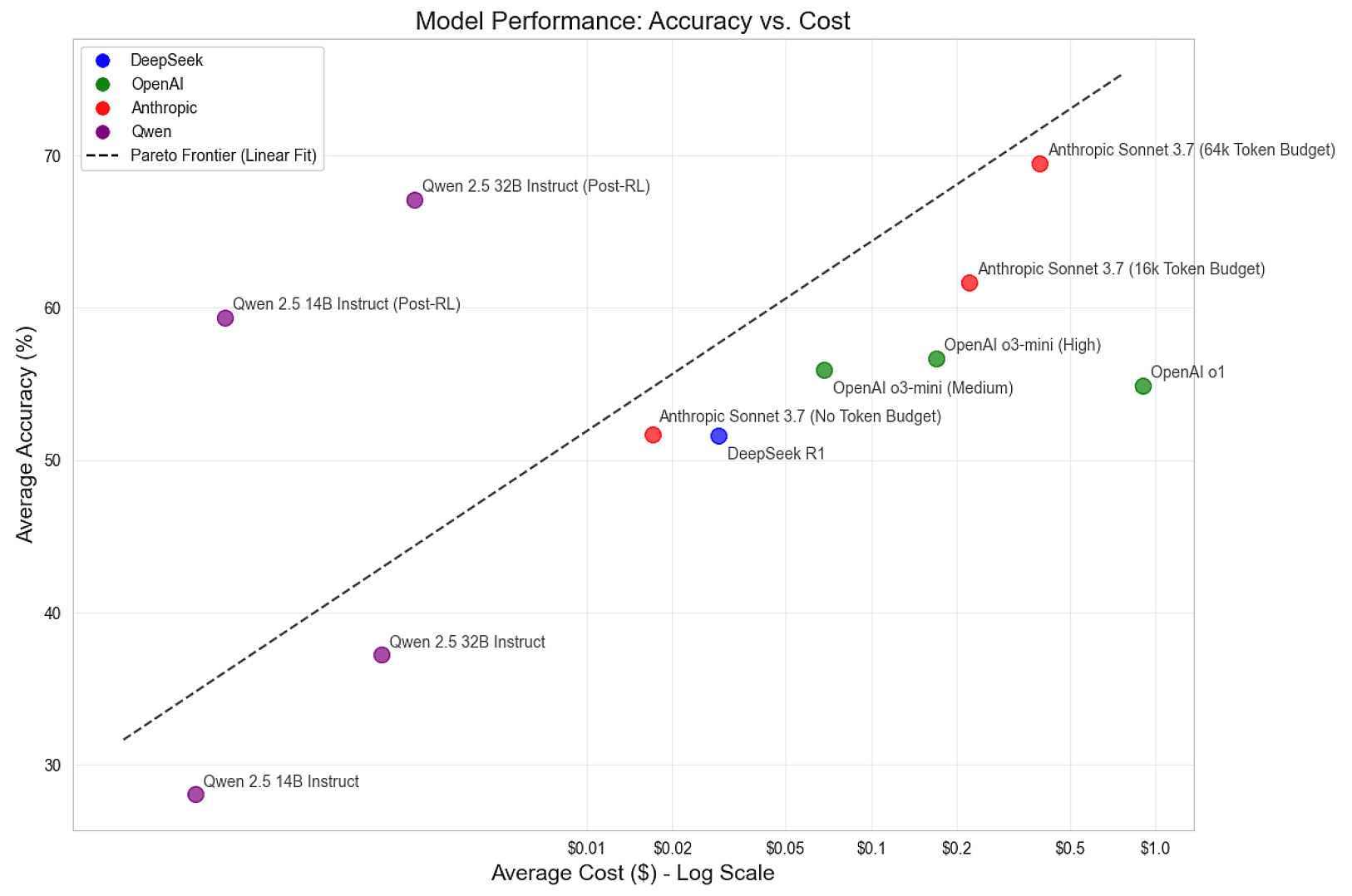

これらのベンチマークから、64k トークン AnthropicのClaude Sonnet 3.7は、このタスクで最高のパフォーマンスを示しましたが、すべての主要モデルには改善の余地があります。一般的なオープンソースモデルであるDeepSeek R1は、AnthropicのClaude Sonnet 3.7の平均精度51.7%に近いパフォーマンスを示しました。しかし、チューニングされていないQwen 2.5 Instructモデルの性能は比較的低い。大きな疑問は、このような小規模なオープンソースモデルを最先端のレベルまで訓練できるのか、ということだ。

電車

最先端の推論モデルを学習させるために、彼らは強化学習を用いた。強化学習とは、制御された環境の中で、知能が自らの経験から学習する手法である。ここでは、LLMが知能で、パズルが環境である。彼らはLLMに各パズルに対して複数の回答を生成させ、問題の風景を探索させることで、LLMの学習を誘導した。正解に導く推論を強化し、モデルを迷わせる推論にはペナルティを課す。

様々なRL手法の中から、DeepSeek社が開発した人気の高いGroup Relative Policy Optimisation(GRPO)アルゴリズムを選択した。Proximal Policy Optimization (PPO)のような伝統的な手法に比べ、GRPOは学習プロセスを簡略化しつつ、強力なパフォーマンスを発揮する。実験をスピードアップするために、彼らは カルバック・ライブラー(KL)分散 たとえトレーニングプログラムがそれをサポートしていたとしてもだ。

要約すると、トレーニングサイクルは以下のような基本ステップを踏む:

- パズル課題に対する模範解答の生成

- 回答を採点し、各グループのチャットを完了する利点を見積もる(これはGRPOの「グループ相対」の部分である)。

- モデルは、これらの優性推定値によって導かれるテーラリング戦略の勾配を使用して微調整される。

- 最適なパフォーマンスが得られるまで、新しいパズルと最新バージョンのモデルでこれらの手順を繰り返す。

レスポンスを生成するために、彼らは人気のある ブイエルエルエム 推論エンジン。彼らは、スループットを最大化し、起動時間を最小化するようにパラメータ選択をチューニングした。プリフィックスのキャッシュは、各タスクに対して多くのレスポンスをサンプリングするため特に重要であり、ヒントをキャッシュすることで冗長な計算を避けることができる。

彼らは、リクエストが多すぎると ブイエルエルエム この問題は、セマフォを使用してリクエストを制限することである。この問題に対処するために、彼らは、スワッピングを最小限に抑えながら、高いキーバリュー(KV)キャッシュ利用率を維持するように調整されたセマフォを使ってリクエストを制限している。より高度なスケジューリングメカニズムは、柔軟な世代長をサポートしながら、より高い利用率を生み出すことができる。

サンプリング後、標準 ハグ顔トランスフォーマー オートトケナイザー 処理は完了した。そのチャットテンプレート機能は、どのトークンがLLMによって生成されたかを決定するためのヘルパーマスクを含むプロンプト文字列としてメッセージオブジェクトを提示する。 %generation% ラベルはラベリングステップで修正される。生成されたヘルパーマスクは、チューニングに使用されるテンソル辞書に含まれ、損失を計算するために必要な位置を特定するために使用される。

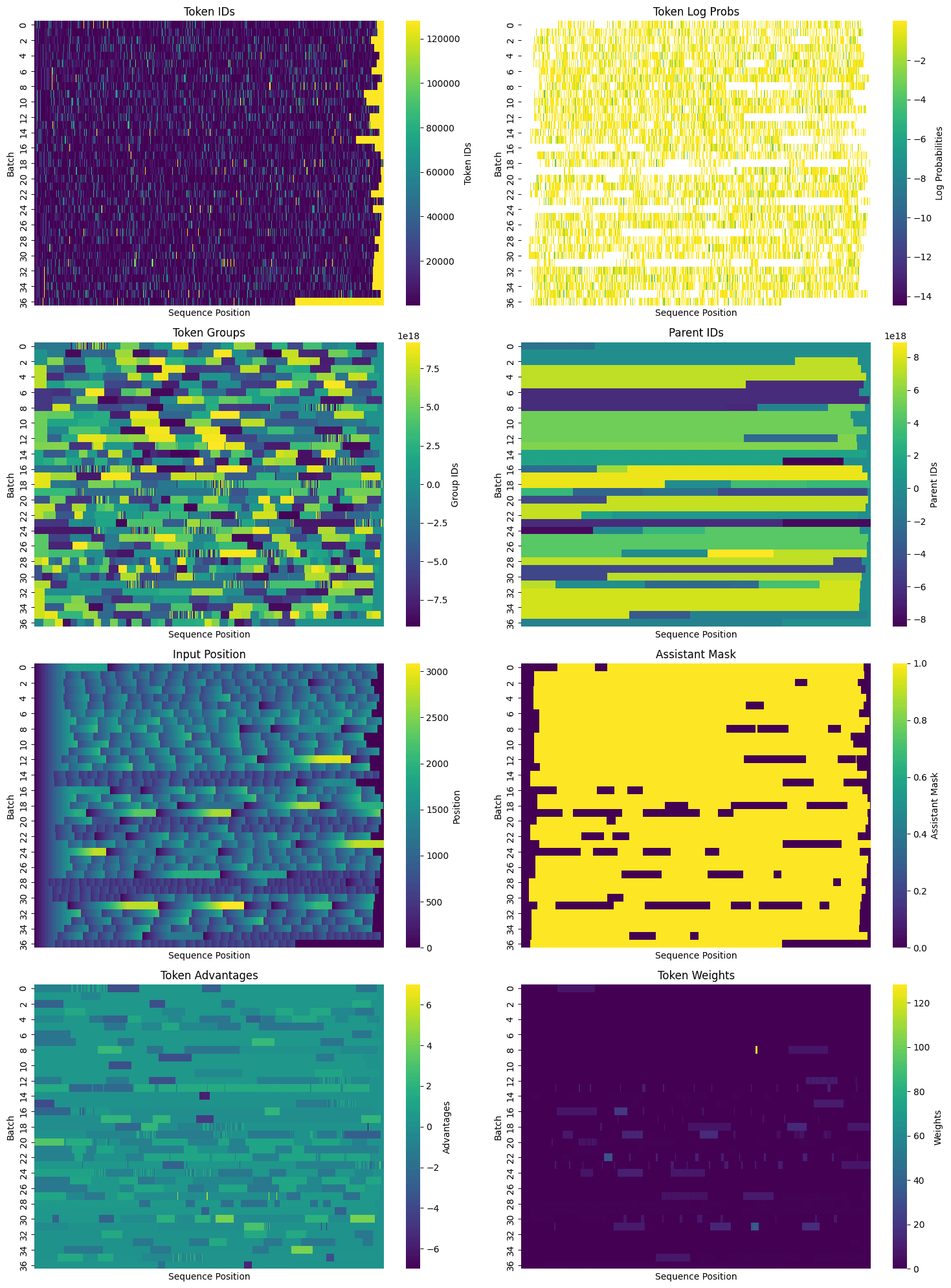

回答をビニングし、ヘルパーマスクを取得した後、チューニングのためにデータをパッケージ化した。特にTemporal Clueのようなタスク(1パズルあたり平均1,000以上のトークン)では、各タスクに対して多数の回答を生成し、効率的にテンソルをパッキングすることで、冗長性を大幅に減らすことができる。を効率的にパッキングすることで、冗長性を大幅に減らすことができる。必要な情報がすべて詰め込まれると、トレーニングデータセットは2次元で可視化され、各行は複数のヒントと完了を含む可能性のあるトークンのシーケンスとなります:

ぎっしり詰まったデータでは、チューニングの時間だ。モデルは事前に訓練され、命令的に調整され、かなり賢く、命令に従うのが得意だ。しかし、まだ時間的手がかりパズルを確実に解くことはできない。しかし、時折成功することがあり、それで十分なのだ。徐々に、良い推論の確率を上げ、悪い推論の確率を下げることで、モデルは「スルース」状態へと導かれる。これは標準的な機械学習技術を用いて達成され、政策勾配アプローチを用いて損失を計算し、重みを有利にシフトする。

トレーニングのために、PyTorchチームは トーチューン トーチューンは高効率のデコーダーを搭載している。 変流器 Torchtuneは、Llama、Gemma、Phiなどの一般的なモデルの実装も提供している。このプロジェクトでは主にQwenモデルを使用したが、MetaのLlama 8Bと70Bモデルも実験に使用した。Torchtuneはまた、以下のようなメモリ節約とパフォーマンス向上のユーティリティも提供している:

- チェックポイントの有効化

- アクティベーション アンインストール

- 定量的

- パラメータ効率ファインチューニング(PEFT)例えば ローランク・アダプティブ(LoRA)

サポートされるオプティマイゼーションの完全なリストについては説明不要の文書はこちら.

さらに、Torchtuneはマルチデバイスをサポートしています。マルチノード)トレーニングが可能で、大規模モデルに最適です。FSDP(Fully Sliced Data Parallel)とTP(Tensor Parallel)の両方をサポートしており、組み合わせて使用することができる。また12のプログラムそして、ユーザーがそれを再現し、自分たちのユースケースに合わせてカスタマイズすることを奨励している。彼らは、完全な微調整プログラムをサポートする修正版を作成した:

- マルチ機器とシングル機器のトレーニング

- KL分散を計算するための参照モデルの荷重と重量の交換

- グループIDと親IDを使った高度な因果関係マスク計算

- GRPOロスの統合とコンポーネント・ロギング

このプログラムは以下の言語でご覧いただけます。以下は見てほしい。将来的には、テンソル並列のサポートを追加し、PEFTと量子化を探求したいという。

RLの学習プロセスには、多数のハイパーパラメータの選択が含まれる。モデルを訓練する間、彼らは様々な構成をテストし、主に以下の構成を特定した:

- モデル:Qwen 2.5 Instruct 14Bおよび32B

- 反復ごとのタスク数:32

- 各タスクの反復あたりのサンプル数:50

- 反復あたりの総サンプル数: 32 * 50 = 1600

- 学習率:6e-6

- マイクロバッチサイズ:14Bモデルは4配列、32Bモデルは8配列

- バッチサイズ: シーケンス数により可変

バッチサイズは可変である。なぜなら、応答の長さはトレーニング中に変化し、シーケンスパッキング効率は各反復で変動し、ゼロ優勢応答(すなわち、モデルが正または負のフィードバックを与えない応答)は破棄されるからである。1回の実行では、バッチサイズに基づいて学習率を動的に調整する試みがなされたが、その結果、バッチサイズが小さい場合には学習率が高すぎ、上限を設定する必要があった。上限を設定したバージョンは、一定の学習率を使用した場合と大きな違いはなかったが、バッチサイズと学習率を調整することは、今後の実験にとって興味深い分野である。

また、反復あたりのタスク数を増やしながらタスクあたりのサンプル数を減らす、あるいはその逆で、反復あたりの総サンプル数をほぼ等しく保つという簡単な実験も行った。これらの変更は短期間のトレーニングでは意味のある違いを示さなかったことから、このスキームはタスク数とタスクあたりのサンプル数のトレードオフの違いに対してロバストであることが示唆された。

結局

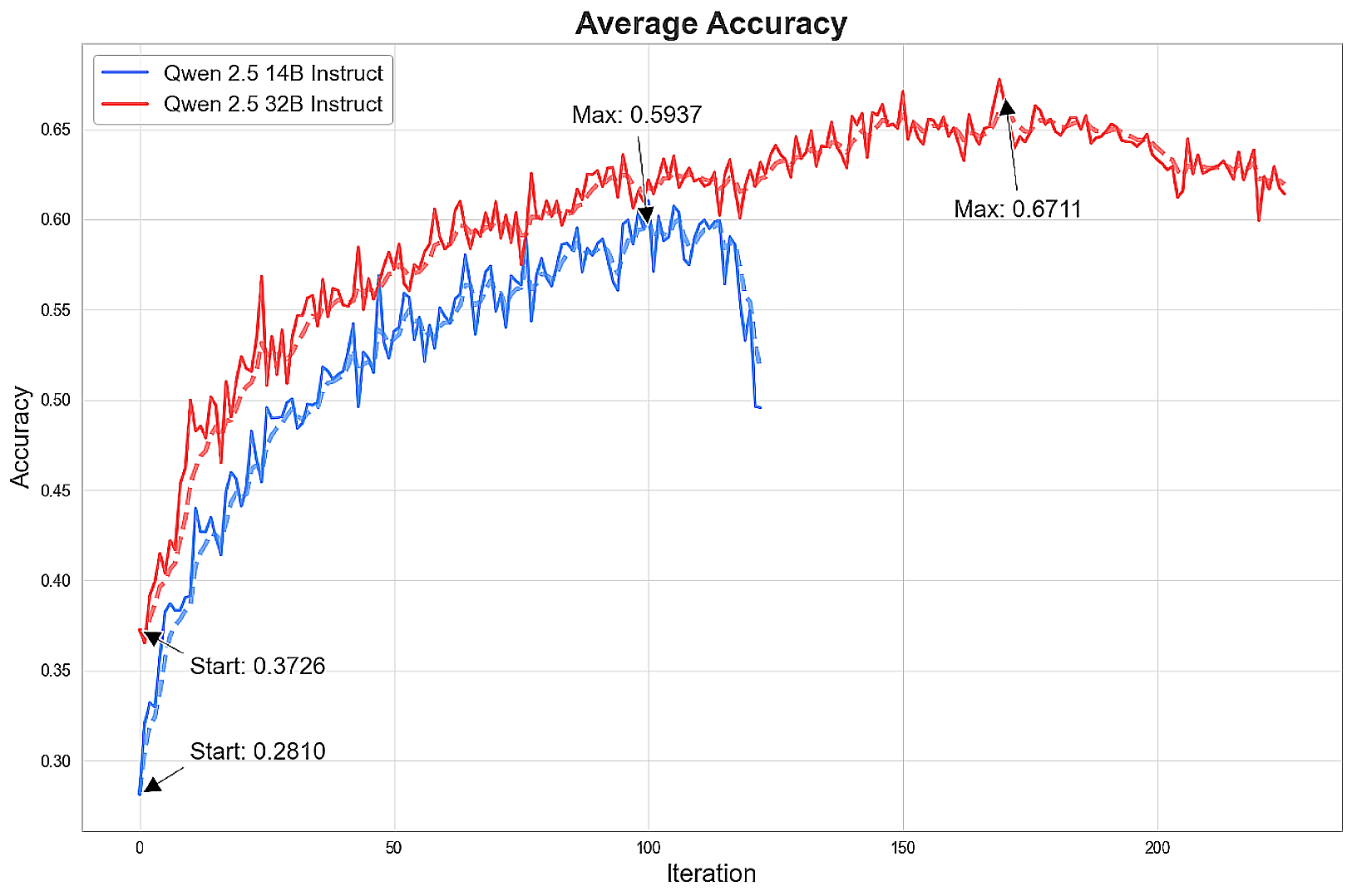

モデルを100回以上繰り返しトレーニングした結果、最先端の推論レベルを達成した。

モデルは急速に向上し、その後、精度の向上は減少し始め、最終的には劇的に低下することもある。14Bモデルは16kトークンでクロード・ソネット3.7の性能に近づき、32Bモデルは64kトークンでソネットの結果とほぼ一致する。

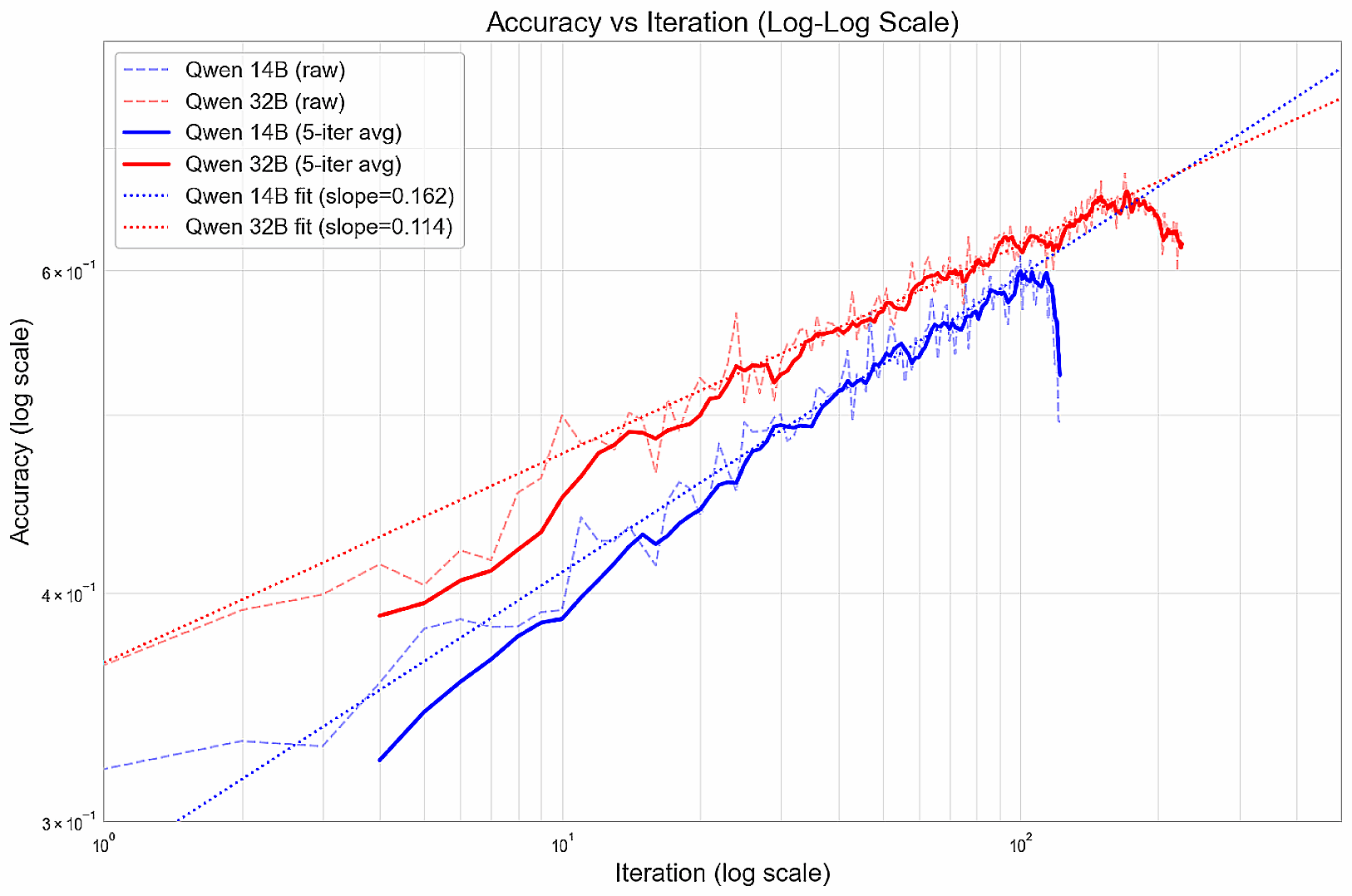

トレーニング中、パフォーマンスの向上はべき乗則に従い、対数プロット上(悪化前)では直線関係を形成する。

このようなモデルは、当初はうまくいくが、長期的な展望を制限するような貪欲な戦略に、時期尚早に収束してしまう可能性があると彼らは考えている。次のステップとしては、多様な回答を奨励する方法、段階的に能力を高める方法(コース学習など)、特に優れた解決策に大きな報酬を割り当てて徹底的な探求を奨励する方法などを模索することが考えられる。

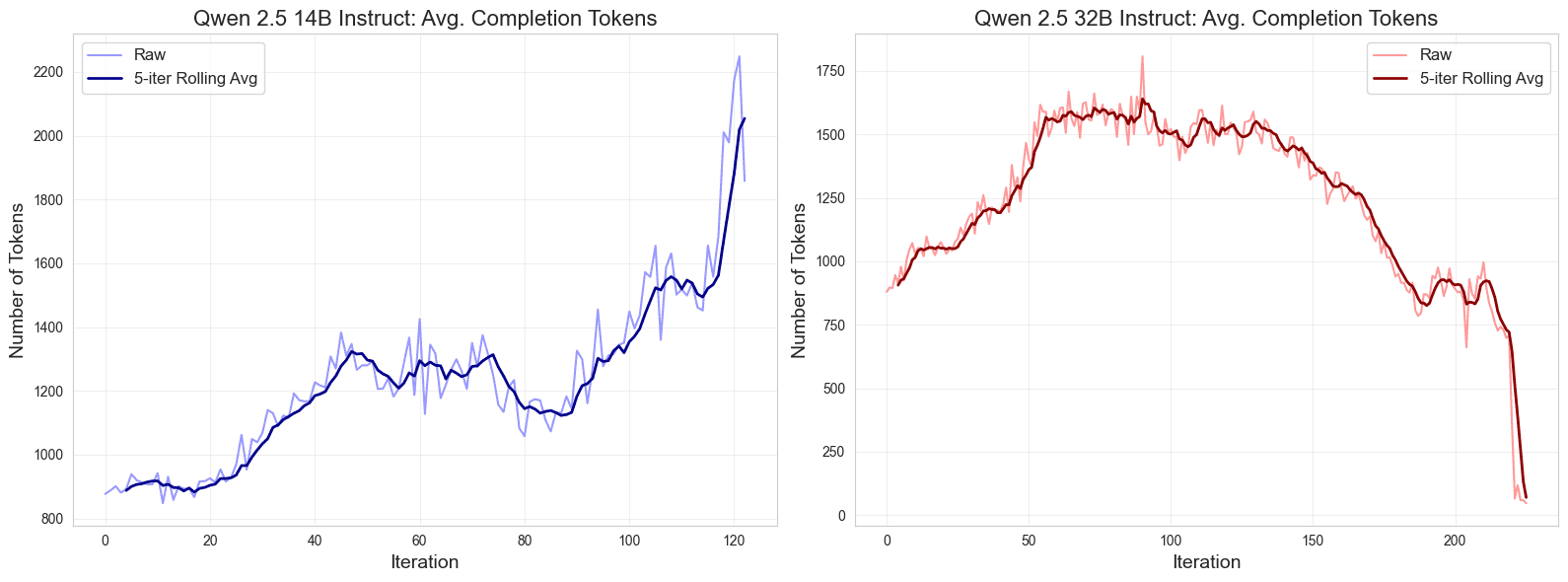

さらに、トレーニング中の出力の長さに興味深いパターンがあることに気づいた。当初、応答は長くなり、その後安定し、トレーニングの終盤になると発散し、14Bモデルの応答は長くなり、32Bモデルの応答は短くなる。

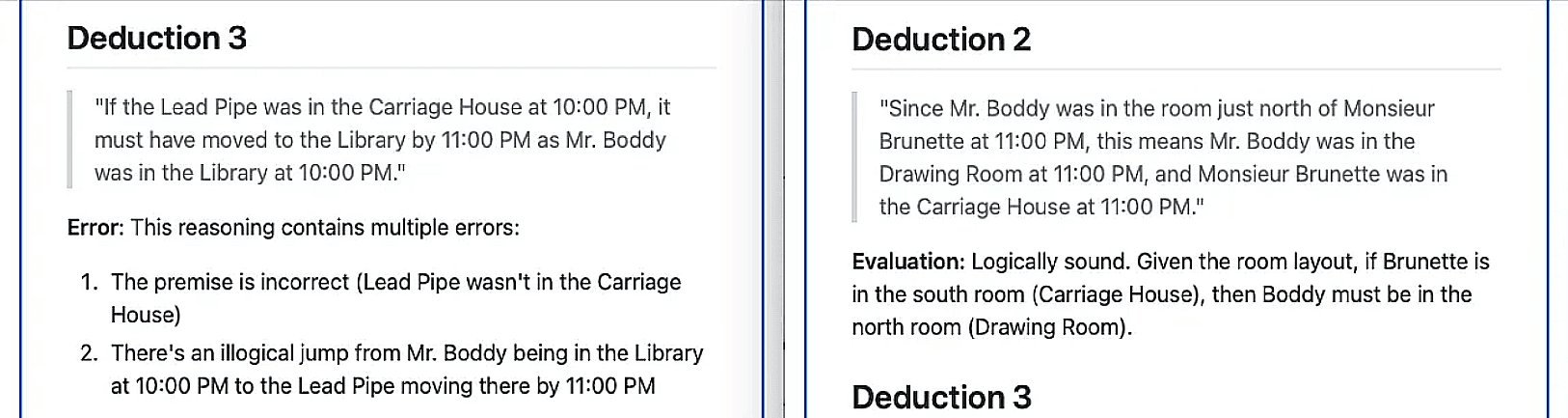

論理的推論の改善を定性的に評価するため、最強の最先端モデルであるクロード・ソネット3.7に、同様のパズルに対してクウェン32Bモデルが行った推論の妥当性を、100回以上の反復トレーニングの前後で識別・評価させた。ソネットはベースモデルから6つの推論を特定し、そのうち1つを除いてすべて偽と判定された;その代わりに、訓練されたモデルから7つの推論を特定し、そのうちの1つを除いては論理的に正しいと判断された。

最後にオンデマンド配備持つ十分なスループットそれらは、次のようなものである。 花火AI なサーバーレスの価格帯はQwenモデルのコストを推定した。彼らは、精度と回答あたりの平均推論コストの自然対数を比較し、未調整モデルにおいて明確な線形パレートフロンティアを観察した。コストと精度のトレードオフは、オープンソースモデルをフロンティアの精度レベルまでうまくトレーニングすることで大幅に改善されました。

概要

今回の調査では、強化学習によって、より小規模なオープンソースの言語モデルが最先端の推論能力を達成できるかどうかを探った。Qwen 14B と 32B のモデルを、慎重に選択したハイパーパラメータと GRPO メソッドを使用して、難易度の高い Temporal Clue パズルでトレーニングした結果、目覚ましい性能向上を達成しました。これらの改善により、コストを大幅に削減しながら、オープンソースモデルを推論性能の最前線に押し上げました。この結果は、複雑な推論タスクでオープンモデルを効率的に訓練する強化学習の可能性を強調している。

前述の通りだ。データセットそしてテストそして研修プログラム とモデルの重み(14B, 32B)は、MITライセンスのもと無料で利用できる。

加えて、次のことも判明した。 16のトレーニング例 最大10-15%の有意義な性能向上を達成できる。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません