Gaze-LLE:映像中の人物注視のターゲット予測ツール

はじめに

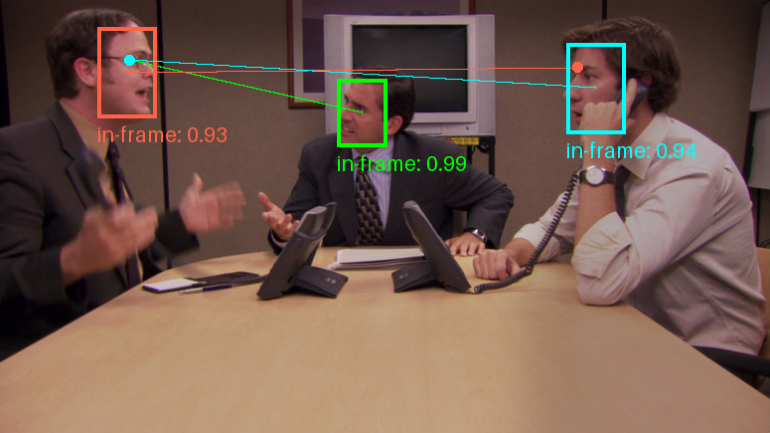

Gaze-LLEは、大規模学習エンコーダーに基づいた視線ターゲット予測ツールです。このプロジェクトは、Fiona Ryan、Ajay Bati、Sangmin Lee、Daniel Bolya、Judy Hoffman、James M. Rehgによって開発され、DINOv2のような事前に訓練された視覚ベースモデルで効率的な視線ターゲット予測を可能にすることを目的としています。Gaze-LLEのアーキテクチャはすっきりとシンプルで、事前に訓練された視覚コーダーをフリーズさせるだけで、軽量な視線デコーダーを学習します。これは、これまでの研究と比べてパラメーターの量を1~2桁減らし、奥行きやポーズ情報などの追加の入力モダリティを必要としません。

機能一覧

- ターゲット予測に重点を置く事前訓練された視覚コーダーに基づく視線ターゲットの効率的な予測。

- 複数の視線による予測1枚の画像から複数の人物の視線予測を行うことができます。

- 事前学習モデル様々なバックボーンネットワークやトレーニングデータをサポートするために、事前にトレーニングされた様々なモデルを提供します。

- 軽量アーキテクチャ事前に訓練された視覚コーダーのみで軽量視線デコーダーを学習。

- 追加入力モードなし深度・姿勢情報の追加入力は不要です。

ヘルプの使用

設置プロセス

- クローン倉庫

git clone https://github.com/fkryan/gazelle.git

cd gazelle

- 仮想環境を作成し、依存関係をインストールする:

conda env create -f environment.yml

conda activate gazelle

pip install -e .

- オプション:注目度計算を高速化するためにxformersをインストールする(システムでサポートされている場合):

pip3 install -U xformers --index-url https://download.pytorch.org/whl/cu118

事前に訓練されたモデルの使用

Gaze-LLEは、ユーザーが必要に応じてダウンロードして使用できる様々な事前学習済みモデルを提供しています:

- ガゼルディノブ2vitb14DINOv2 ViT-BにGazeFollowの学習データを加えたモデル。

- ガゼルディノブ2vitl14DINOv2 ViT-LにGazeFollowの学習データを加えたモデル。

- ガゼルディノブ2vitb14_inoutGazeFollowとVideoAttentionTargetの学習データを用いたDINOv2 ViT-Bに基づくモデル。

- ガゼル大きいvitl14_inoutGazeFollowとVideoAttentionTargetの学習データを用いたDINOv2 ViT-Lに基づくモデル。

使用例

- PyTorch Hubにモデルをロードします:

import torch

model, transform = torch.hub.load('fkryan/gazelle', 'gazelle_dinov2_vitb14')

- Google Colabのデモノートブックをチェックして、画像内のみんなの視線の対象を検出する方法を学んでください。

予報に注意

Gaze-LLEは複数の人物の視線予測をサポートする。すなわち、1つの画像を一度エンコードし、その画像内の複数の人物の視線ターゲットを予測するために特徴量を使用する。このモデルは、シーン内の視線ターゲットの位置の確率を[0,1]の範囲の値で表す空間ヒートマップを出力します。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません