GPUStack : gestion de grappes de GPU pour exécuter de grands modèles de langage et intégrer rapidement des services d'inférence communs pour les LLM.

Introduction générale

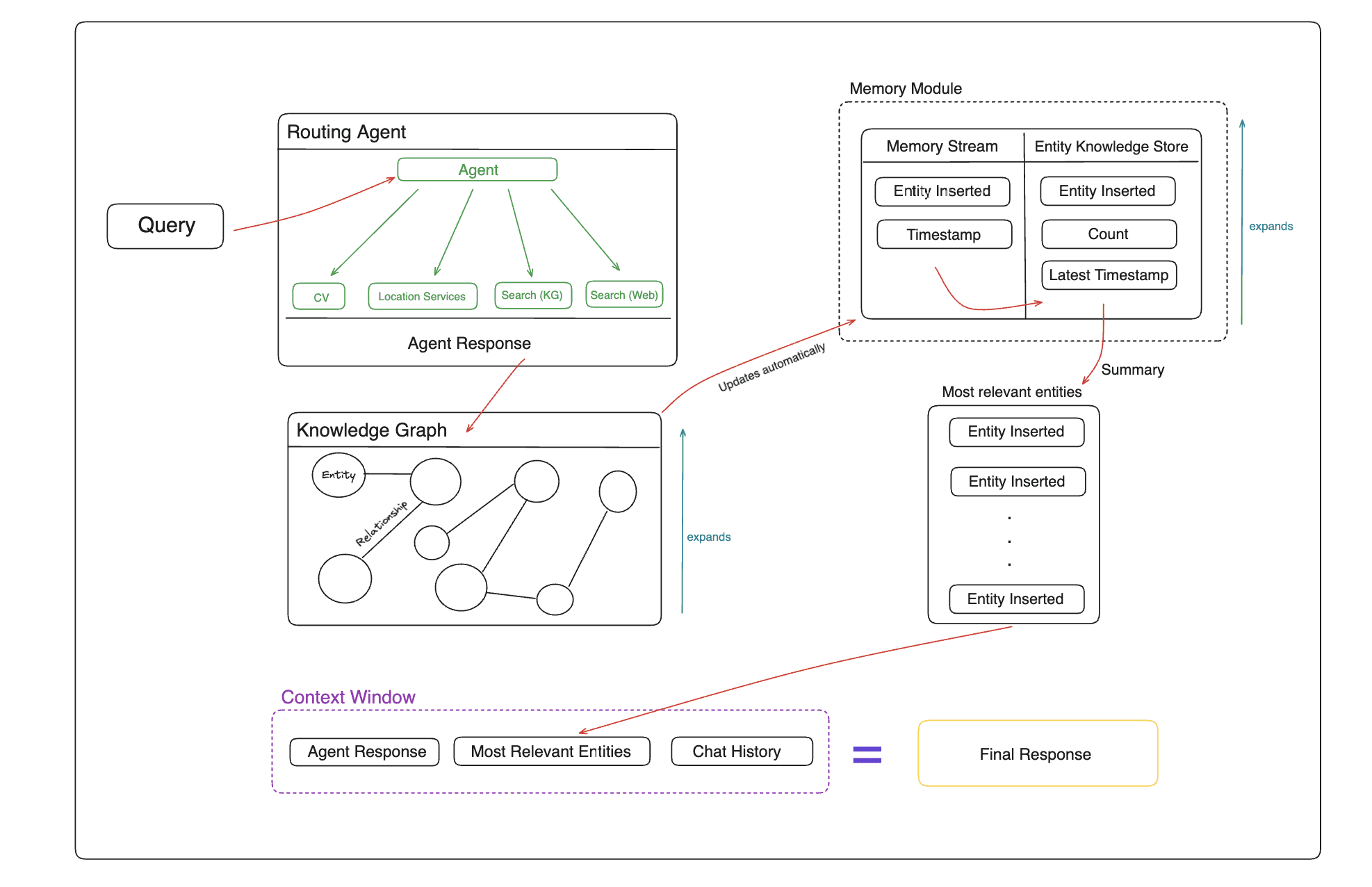

GPUStack est un outil open source de gestion de grappes de GPU conçu pour l'exécution de grands modèles de langage (LLM). Il prend en charge une large gamme de matériel, y compris les Apple MacBooks, les PC Windows et les serveurs Linux. GPUStack fournit des capacités d'inférence distribuées, supporte l'inférence et les services multi-GPU et multi-nœuds, et est compatible avec l'API OpenAI, simplifiant la gestion des utilisateurs et des clés API et le contrôle en temps réel de la performance et de l'utilisation des GPU. Il est compatible avec l'API OpenAI, simplifie la gestion des utilisateurs et des clés API et surveille en temps réel les performances et l'utilisation du GPU. Sa conception de paquetage Python léger garantit un minimum de dépendances et de surcharge opérationnelle, ce qui en fait un outil idéal pour les développeurs et les chercheurs.

Liste des fonctions

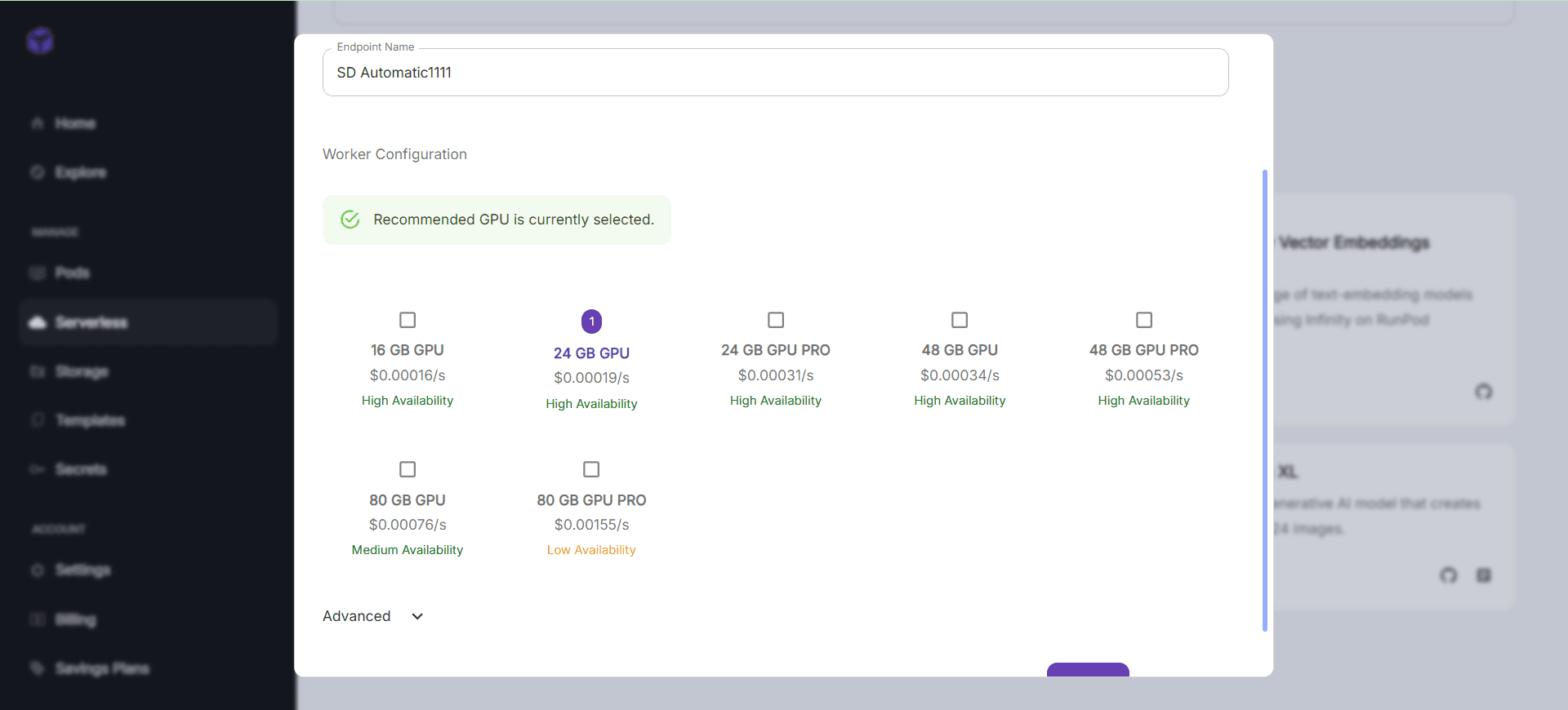

- Prise en charge d'une large gamme de matériel : compatible avec Apple Metal, NVIDIA CUDA, Ascend CANN, Moore Threads MUSA, etc.

- Inférence distribuée : prend en charge l'inférence et les services multi-GPU et multi-nœuds à un seul nœud.

- Plusieurs backends d'inférence : prise en charge de llama-box (llama.cpp) et de vLLM.

- Paquets Python légers : dépendances et surcharge opérationnelle minimales.

- API compatible OpenAI : fournit des services API compatibles avec la norme OpenAI.

- Gestion des utilisateurs et des clés API : simplifie la gestion des utilisateurs et des clés API.

- Surveillance des performances du GPU : surveillez les performances et l'utilisation du GPU en temps réel.

- Surveillance de l'utilisation des jetons et du débit : gestion efficace de l'utilisation des jetons et de la limitation du débit.

Utiliser l'aide

Processus d'installation

Linux ou MacOS

- Ouvrir le terminal.

- Exécutez la commande suivante pour installer GPUStack :

curl -sfL https://get.gpustack.ai | sh -s -

- Après l'installation, GPUStack fonctionnera en tant que service sur le système systemd ou launchd.

Windows (ordinateur)

- Exécutez PowerShell en tant qu'administrateur (évitez d'utiliser PowerShell ISE).

- Exécutez la commande suivante pour installer GPUStack :

Invoke-Expression (Invoke-WebRequest -Uri "https://get.gpustack.ai" -UseBasicParsing).Content

Lignes directrices pour l'utilisation

configuration initiale

- Accès à l'interface utilisateur de GPUStack : Ouvrir dans le navigateur

http://myserver. - Utiliser le nom d'utilisateur par défaut

adminet le mot de passe initial pour se connecter. Méthode pour obtenir le mot de passe initial :- Linux ou MacOS : exécuter

cat /var/lib/gpustack/initial_admin_password. - Windows : en cours

Get-Content -Path "$env:APPDATA\gpustack\initial_admin_password" -Raw.

- Linux ou MacOS : exécuter

Création de clés API

- Après vous être connecté à l'interface utilisateur de GPUStack, cliquez sur "Clés API" dans le menu de navigation.

- Cliquez sur le bouton "Nouvelle clé API", saisissez le nom et enregistrez-le.

- Copiez la clé API générée et enregistrez-la correctement (visible uniquement au moment de la création).

Utiliser l'API

- Définition des variables d'environnement :

export GPUSTACK_API_KEY=myapikey

- Utilisez curl pour accéder aux API compatibles avec OpenAI :

curl http://myserver/v1-openai/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $GPUSTACK_API_KEY" \

-d '{

"model": "llama3.2",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"}

],

"stream": true

}'

Courir et discuter

- Exécutez la commande suivante dans le terminal pour discuter avec le modèle llama3.2 :

gpustack chat llama3.2 "tell me a joke."

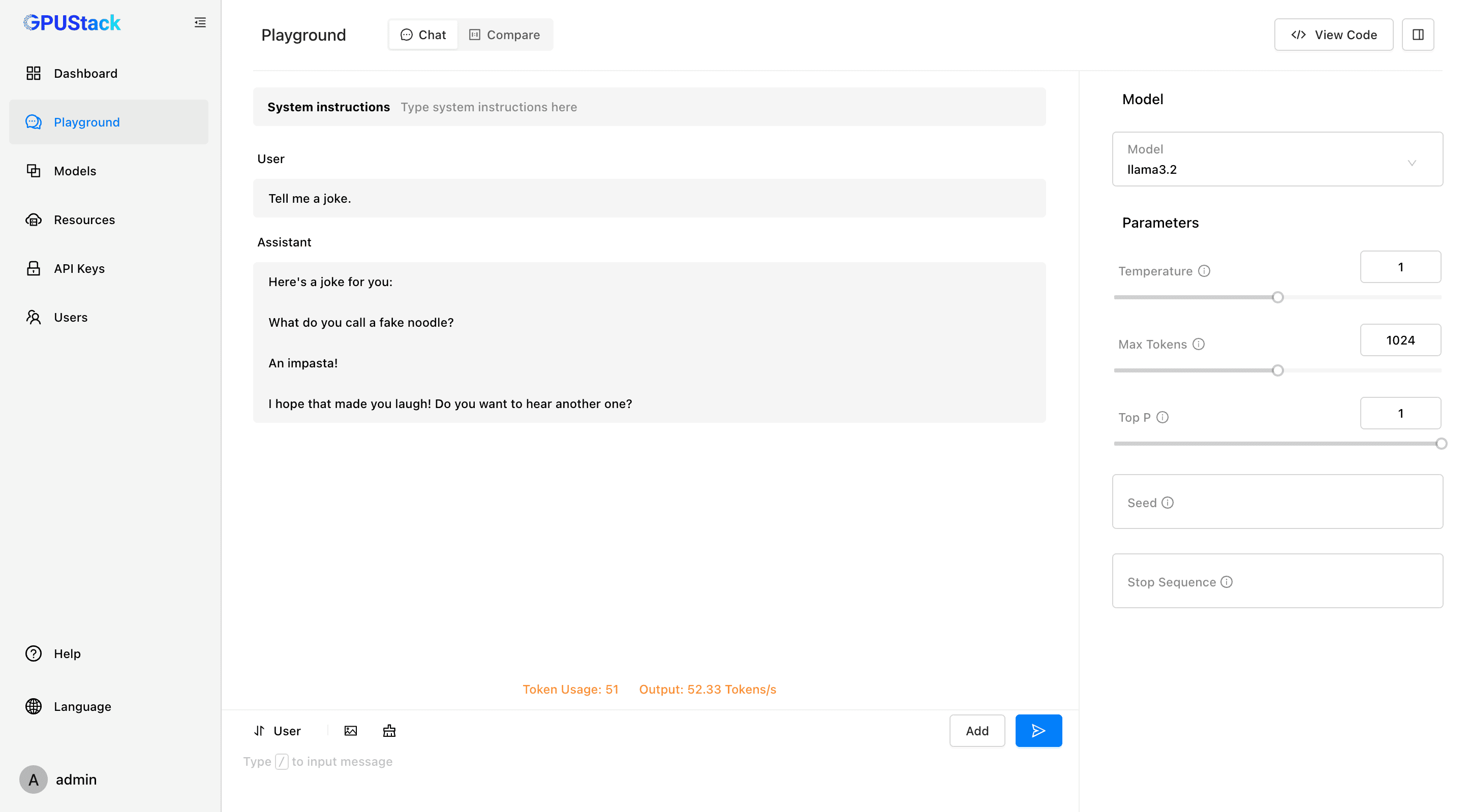

- Cliquez sur "Playground" dans l'interface utilisateur de GPUStack pour interagir.

Suivi et gestion

- Contrôlez les performances et l'utilisation du GPU en temps réel.

- Gestion des clés d'utilisateur et d'API, suivi de l'utilisation des jetons et des taux.

Modèles et plateformes pris en charge

- Modèles pris en charge : LLaMA, Mistral 7B, Mixtral MoE, Falcon, Baichuan, Yi, Deepseek, Qwen, Phi, Grok-1 et autres.

- Modèles multimodaux pris en charge : Llama3.2-Vision, Pixtral, Qwen2-VL, LLaVA, InternVL2 et autres.

- Plateformes prises en charge : macOS, Linux, Windows.

- Accélérateurs pris en charge : Apple Metal, NVIDIA CUDA, Ascend CANN, Moore Threads MUSA, avec des plans futurs pour prendre en charge AMD ROCm, Intel oneAPI, Qualcomm AI Engine.

Documentation et communauté

- Documentation officielle : visitez GPUStack Documentation Obtenez le guide complet et la documentation de l'API.

- Guide des contributions : Lecture Lignes directrices relatives aux contributions Découvrez comment vous pouvez contribuer à GPUStack.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Postes connexes

Pas de commentaires...