Lanzamiento de Qwen3: una nueva generación de grandes modelos lingüísticos para pensar en profundidad y responder con rapidez

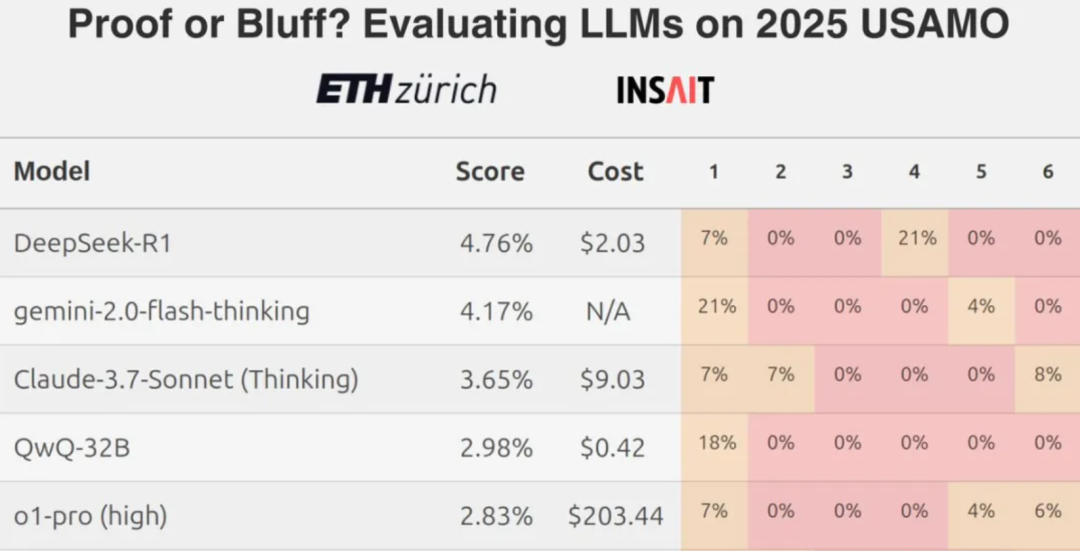

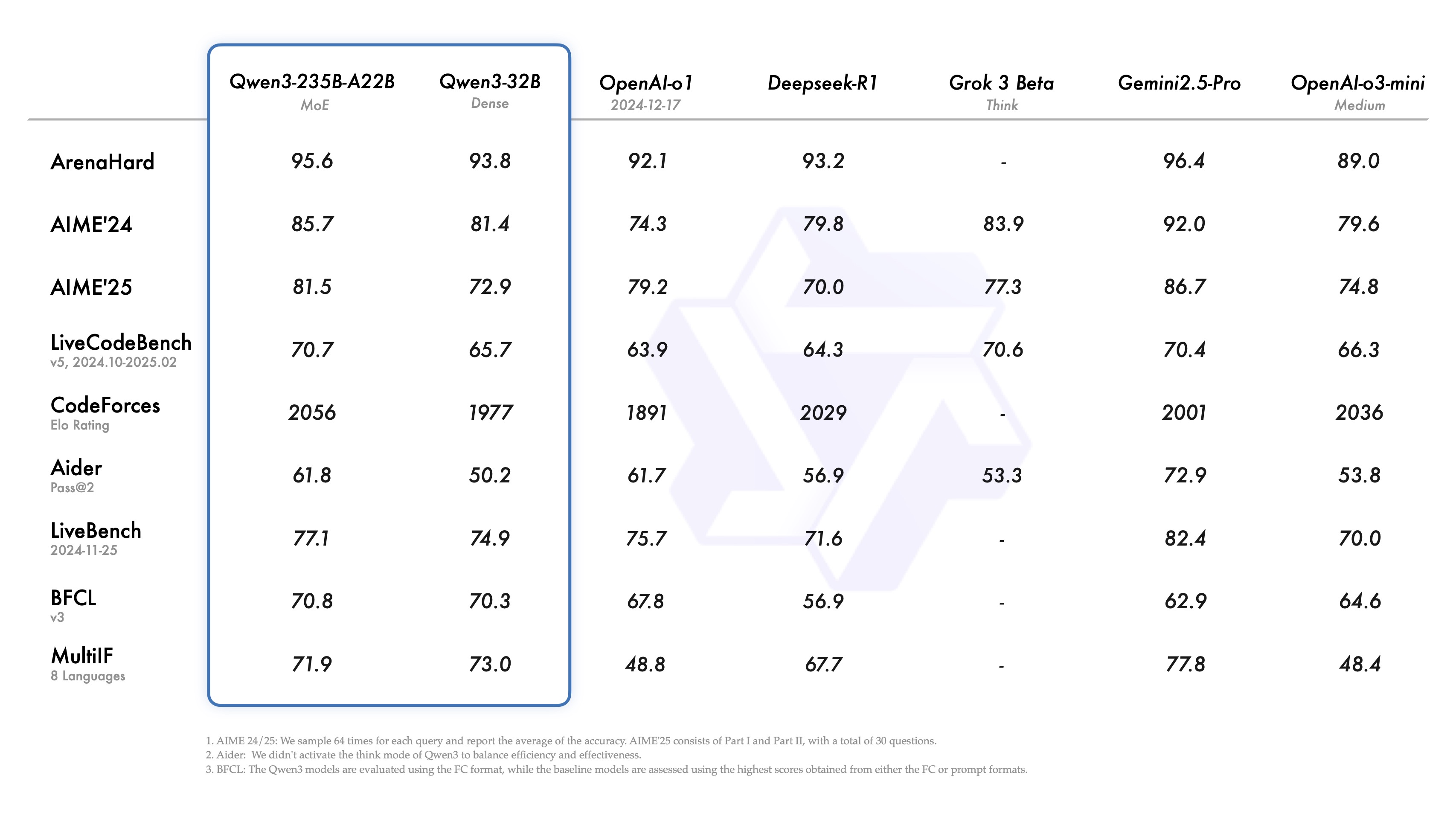

El campo de los grandes modelos lingüísticos cuenta con un nuevo miembro. Recientemente, la familia Qwen de grandes modelos lingüísticos ha lanzado su última versión, Qwen3. Según el equipo de desarrollo, su modelo estrella, Qwen3-235B-A22B, ha demostrado compararse favorablemente con Qwen3-235B-A22B en pruebas comparativas de capacidades de codificación, matemáticas y de uso general. DeepSeek-R1 , o1 . o3-mini El Qwen3 está diseñado para igualar el rendimiento de los mejores modelos del sector, como el Grok-3 y el Gemini-2.5-Pro. La selección de estos competidores refleja el posicionamiento de Qwen3, ya que pretende dialogar directamente con los referentes de rendimiento actuales.

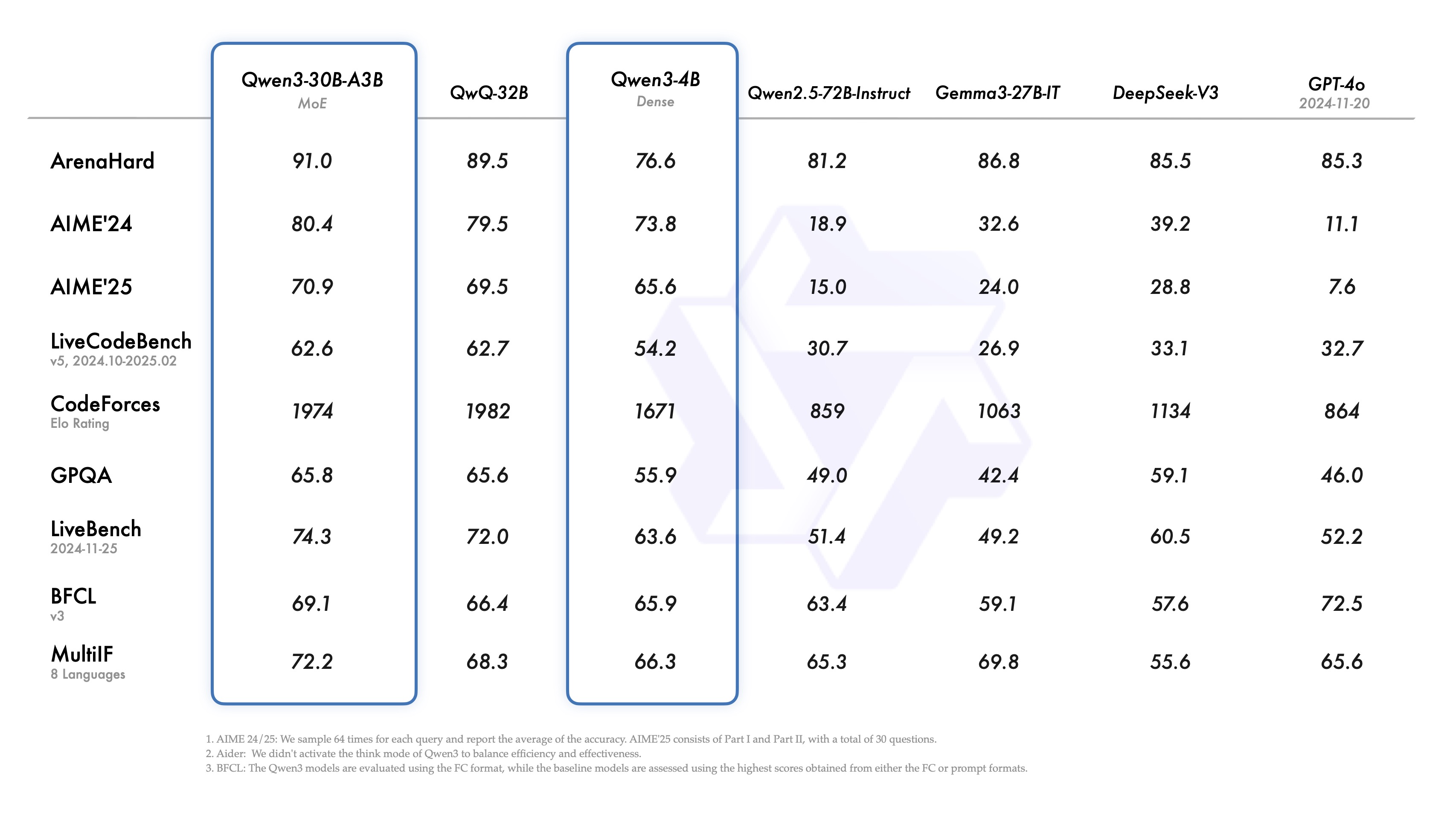

Es interesante observar que el pequeño modelo de Experto Mixto (MoE) Qwen3-30B-A3B supera a QwQ-32B con un mayor número de covariables (aunque con una décima parte de los parámetros de activación de este último), e incluso el modelo más pequeño Qwen3-4B iguala el rendimiento de Qwen2.5-72B-Instruct. Esto demuestra un aumento significativo de la eficacia gracias a la arquitectura optimizada del modelo y a la mejora de los métodos de entrenamiento.

Uno de los aspectos más destacados del lanzamiento es la apertura de las ponderaciones de dos modelos MoE: Qwen3-235B-A22B (235.000 millones de parámetros totales, 22.000 millones activados) y Qwen3-30B-A3B (30.000 millones de parámetros totales, 3.000 millones activados). MoE es una técnica que permite a un modelo activar sólo una parte de la red "experta" al razonar. MoE es una técnica que permite a los modelos activar sólo una parte de la red "experta" cuando razonan, lo que reduce significativamente los requisitos computacionales al tiempo que mantiene un gran rendimiento, lo que es importante para impulsar el despliegue de grandes modelos en una gama más amplia de escenarios.

Además, siguiendo la licencia Apache 2.0, el equipo ha abierto las ponderaciones de seis modelos densos con una cobertura de tamaño de parámetros que va de 600 millones a 32.000 millones, concretamente Qwen3-32B, Qwen3-14B, Qwen3-8B, Qwen3-4B, Qwen3-1,7B y Qwen3-0,6B.

Resumen de las especificaciones del modelo (modelos densos):

| Modelos | Capas | Cabezas (Q / KV) | Empalme | Contexto Longitud |

|---|---|---|---|---|

| Qwen3-0,6B | 28 | 16 / 8 | Sí | 32K |

| Qwen3-1.7B | 28 | 16 / 8 | Sí | 32K |

| Qwen3-4B | 36 | 32 / 8 | Sí | 32K |

| Qwen3-8B | 36 | 32 / 8 | No | 128K |

| Qwen3-14B | 40 | 40 / 8 | No | 128K |

| Qwen3-32B | 64 | 64 / 8 | No | 128K |

Visión general de las especificaciones del modelo (modelo MoE):

| Modelos | Capas | Cabezas (Q / KV) | # Expertos (Total / Activado) | Contexto Longitud |

|---|---|---|---|---|

| Qwen3-30B-A3B | 48 | 32 / 4 | 128 / 8 | 128K |

| Qwen3-235B-A22B | 94 | 64 / 4 | 128 / 8 | 128K |

Estos modelos y sus versiones preentrenadas (por ejemplo, Qwen3-30B-A3B-Base) ya están disponibles en las principales plataformas, como Hugging Face, ModelScope y Kaggle, entre otras. Para el despliegue de modelos, se recomienda utilizar SGLang y vLLM y otros marcos. Para escenarios de uso local, Ollama, LMStudio, MLX llama.cppy KTransformers y otras herramientas facilitan el acceso.

Los desarrolladores pueden utilizar el Qwen Chat Web y aplicaciones móviles para experimentar la potencia de Qwen3.

Análisis de las características principales

Qwen3 introduce varias características dignas de mención:

- Modos de pensamiento híbridosQwen3 admite dos modos de resolución de problemas:

- Modo de pensar. El modelo realiza un razonamiento paso a paso, muestra el proceso de pensamiento y luego da la respuesta final. Esto se aplica a problemas complejos que requieren un análisis en profundidad.

- Modo no pensante. El modelo proporciona una respuesta rápida, casi instantánea, para escenarios en los que la rapidez es importante y el problema es relativamente sencillo.

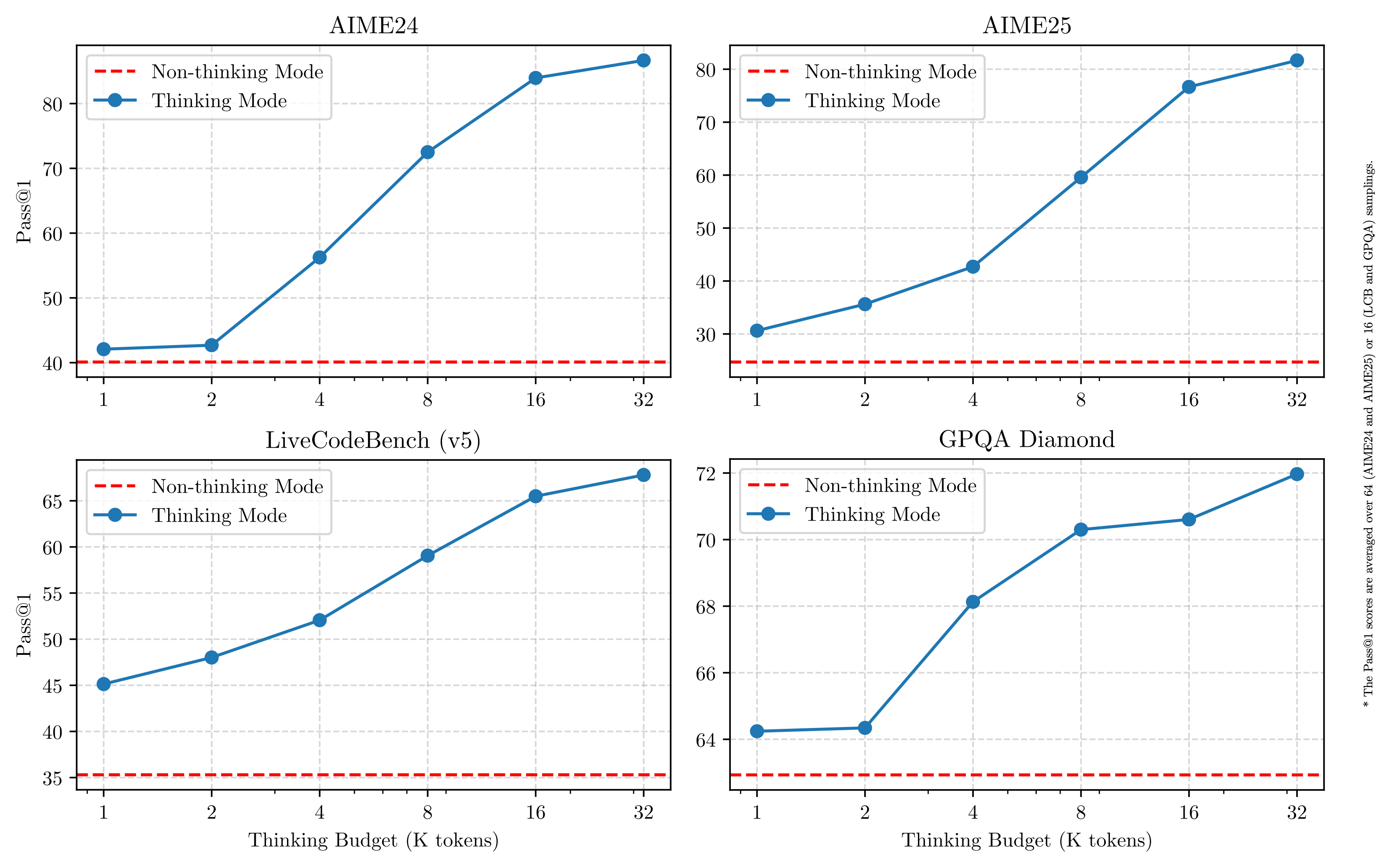

Este diseño ofrece al usuario la flexibilidad de controlar la "profundidad de pensamiento" del modelo en función de las necesidades de la tarea. Y lo que es más importante, este modelo híbrido permite un control estable y eficiente del "presupuesto de pensamiento" del modelo. Como se muestra en la siguiente figura, el rendimiento de Qwen3 muestra una escalabilidad y unas mejoras suaves directamente relacionadas con el presupuesto de razonamiento computacional asignado. Los usuarios pueden configurar más fácilmente los presupuestos para tareas específicas, encontrando así un mejor equilibrio entre rentabilidad y calidad de razonamiento. Esto aporta nuevas ideas para la gestión de costes de grandes modelos en aplicaciones del mundo real.

- Amplio soporte multilingüeLos modelos Qwen3 admiten hasta 119 lenguas y dialectos. Esta amplia capacidad multilingüe abre nuevas posibilidades para las aplicaciones internacionalizadas y ayuda a los usuarios de todo el mundo a sacar partido de los modelos.

Familia lingüística Lenguas y dialectos Indoeuropeo Inglés, francés, portugués, alemán, rumano, sueco, danés, búlgaro, ruso, checo, griego, ucraniano, español, neerlandés, eslovaco, croata. Polaco, lituano, bokmål noruego, nynorsk noruego, persa, esloveno, gujarati, letón, italiano, occitano, nepalí, marathi, bielorruso. Serbio, luxemburgués, veneciano, asamés, galés, silesiano, asturiano, chhattisgarhi, awadhi, maithili, bhojpuri, sindhi, irlandés, feroés, hindi. Punjabi, bengalí, oriya, tayiko, yiddish oriental, lombardo, ligur, siciliano, friulano, sardo, gallego, catalán, islandés, tosco albanés. Limburgués, dari, afrikaans, macedonio, cingalés, urdu, magahi, bosnio, armenio. Sino-Tibetano Chino (chino simplificado, chino tradicional, cantonés), birmano Afroasiático Árabe (estándar, najdi, levantino, egipcio, marroquí, mesopotámico, ta'izzi-adení, tunecino), hebreo, maltés Austronesia Indonesio, malayo, tagalo, cebuano, javanés, sundanés, minangkabau, balinés, banjar, pangasinan, iloko, waray (Filipinas). Dravidian Tamil, Telugu, Kannada, Malayalam Turco Turco, azerbaiyano del norte, uzbeko del norte, kazajo, bashkir, tártaro Tai-Kadai Tailandés, laosiano Uralic Finlandés, estonio, húngaro Austroasiático Vietnamita, jemer Otros Japonés, coreano, georgiano, euskera, haitiano, papiamento, kabuverdianu, tok pisin, swahili - Capacidades agenéticas mejoradasEl modelo Qwen3 está optimizado para la codificación y la capacidad de realizar tareas como agente inteligente (Agent). El equipo también ha mejorado el soporte para MCP, que puede referirse a Plataforma de Colaboración Multiagente. El siguiente enlace de vídeo muestra cómo Qwen3 piensa e interactúa con el entorno (por ejemplo, invocando herramientas).Enlace al vídeo de presentación: https://qianwen-res.oss-accelerate-overseas.aliyuncs.com/mcp.mov

Detalles de la formación: datos, fases y optimización

La cantidad de datos de preentrenamiento de Qwen3 es significativamente mayor que la de Qwen2.5, que utilizó 18 billones de tokens, y Qwen3, que tiene casi el doble de datos de preentrenamiento, unos 36 billones de tokens, que abarcan 119 lenguas y dialectos.

Las fuentes de datos incluían no sólo páginas web, sino también documentos en formato PDF. El equipo utiliza Qwen2.5-VL El modelo extrajo texto de estos documentos y utilizó Qwen2.5 para mejorar la calidad del contenido extraído. Para aumentar la proporción de datos de matemáticas y código, también se generaron datos sintéticos como libros de texto, pares de cuestionarios y fragmentos de código utilizando Qwen2.5-Math y Qwen2.5-Coder.

El proceso de formación previa se divide en tres etapas:

- Fase S1. Más de 30 billones de dólares ficha El preentrenamiento se realiza sobre un contexto de 4K tokens, con el fin de dotar al modelo de las competencias lingüísticas básicas y de conocimientos generales.

- Fase S2. Aumentar la proporción de datos intensivos en conocimiento (por ejemplo, tareas de STEM, codificación y razonamiento), optimizar el conjunto de datos y continuar el preentrenamiento con 5 billones de tokens adicionales.

- Fase S3. El uso de datos de contexto largos de alta calidad amplía la longitud de contexto del modelo a 32K tokens (e incluso 128K en algunos modelos), lo que garantiza que el modelo pueda manejar entradas largas de forma eficiente.

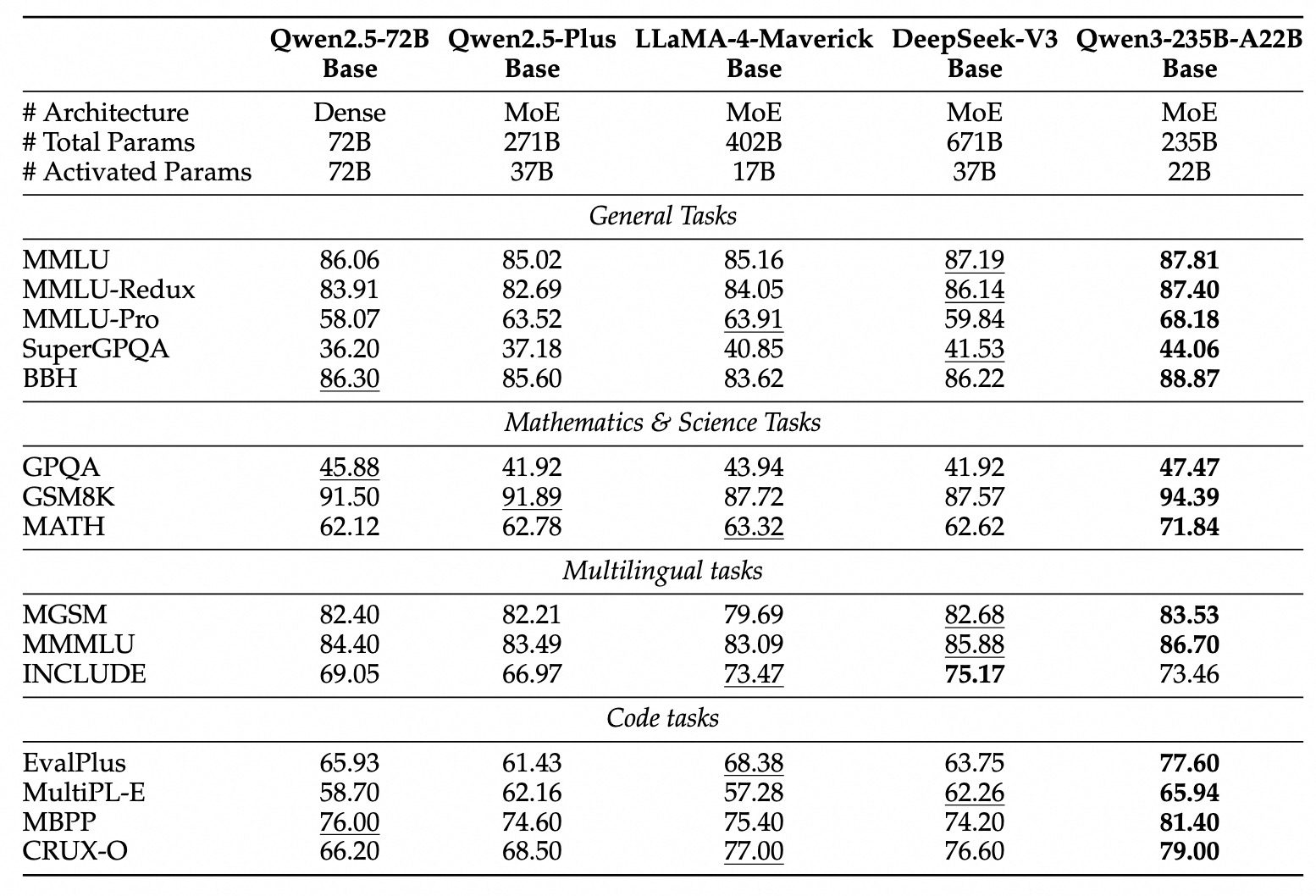

Gracias a la arquitectura mejorada del modelo, al aumento de los datos de entrenamiento y a los métodos de entrenamiento más eficaces, el rendimiento global del modelo de base densa Qwen3 alcanza el nivel del modelo de base Qwen2.5, que tiene un número mucho mayor de covariables. Por ejemplo, Qwen3-1.7B/4B/8B/14B/32B-Base tiene un rendimiento comparable al de Qwen2.5-3B/7B/14B/32B/72B-Base, respectivamente. En concreto, el modelo Qwen3 de base densa supera incluso al modelo Qwen2.5 de mayor tamaño en áreas como STEM, codificación e inferencia.

Para el modelo base Qwen3-MoE, consiguen un rendimiento similar al del modelo base denso Qwen2.5 utilizando sólo unos 10% parámetros de activación, lo que implica un ahorro significativo tanto en costes de entrenamiento como de inferencia.

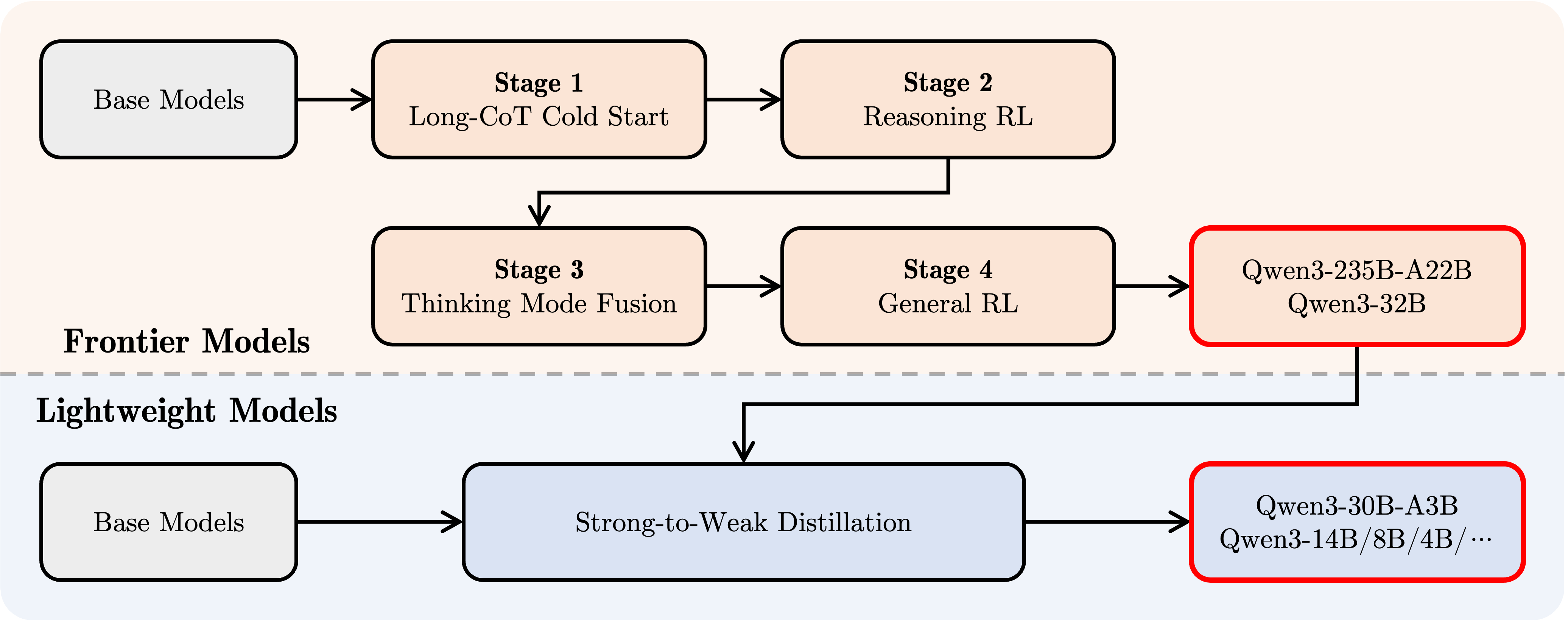

Proceso posterior a la formación

Con el fin de desarrollar un modelo de modo mixto que combine el razonamiento escalonado con la capacidad de respuesta rápida, el equipo de Qwen puso en marcha un proceso de post-entrenamiento en cuatro etapas:

- Arranque en frío CoT largo. Los modelos se afinan utilizando largas cadenas de datos de pensamiento que abarcan diversas tareas y dominios como las matemáticas, la codificación, el razonamiento lógico, STEM, etc., con el objetivo de construir habilidades de razonamiento fundacional.

- RL basado en el razonamiento. Ampliar la inversión de recursos computacionales en el aprendizaje por refuerzo y utilizar las recompensas basadas en reglas (RBR) para potenciar la exploración y explotación de modelos con el fin de mejorar aún más el rendimiento de la inferencia.

- Convergencia de patrones de pensamiento. Integración de las capacidades no pensantes en el modelo de pensamiento. La integración de las capacidades de razonamiento y respuesta rápida se consigue mediante el ajuste fino de una combinación de datos de CoT largos y datos de ajuste fino de órdenes generalizadas (generados por el modelo de pensamiento mejorado en la fase 2).

- Aprendizaje por refuerzo general (RL general). El aprendizaje por refuerzo se aplica en más de 20 tareas de dominio genérico para reforzar aún más las capacidades genéricas del modelo (por ejemplo, adherencia a las instrucciones, adherencia al formato, capacidades del Agente, etc.) y para corregir comportamientos no deseados.

Desarrollo con Qwen3

He aquí una breve guía para utilizar Qwen3 en diferentes frameworks. El primero es un ejemplo estándar de uso de Qwen3-30B-A3B en la biblioteca de transformadores Hugging Face:

from modelscope import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-30B-A3B"

# 加载 tokenizer 和模型

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

# 准备模型输入

prompt = "给我简要介绍一下大型语言模型。"

messages = [

{"role": "user", "content": prompt}

]

# apply_chat_template 用于构建符合 Qwen 对话格式的输入

# enable_thinking=True 启用思考模式 (默认为 True)

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True,

enable_thinking=True # 在思考模式和非思考模式间切换,默认为 True

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

# 进行文本生成

generated_ids = model.generate(

**model_inputs,

max_new_tokens=32768 # 设置最大生成 token 数

)

# 提取生成的内容部分 (去除输入部分)

output_ids = generated_ids[0][len(model_inputs.input_ids[0]):].tolist()

# 解析思考内容 (如果存在)

# 寻找 '</think>' 对应的 token id (151668)

try:

# rindex 从后往前查找 151668

index = len(output_ids) - output_ids[::-1].index(151668)

except ValueError:

# 如果没有找到 '</think>',说明没有思考内容

index = 0

# 分别解码思考内容和最终回复内容

thinking_content = tokenizer.decode(output_ids[:index], skip_special_tokens=True).strip("\n")

content = tokenizer.decode(output_ids[index:], skip_special_tokens=True).strip("\n")

print("思考内容:", thinking_content)

print("最终回复:", content)

Para desactivar el modo de pensamiento, basta con establecer el parámetro enable_thinking en False:

text = tokenizer.apply_chat_template( messages, tokenize=False, add_generation_prompt=True, enable_thinking=False # 默认为 True )

Para el despliegue de modelos, pueden crearse puntos finales compatibles con la API OpenAI utilizando sglang>=0.4.6.post1 o vllm>=0.8.4:

- Uso de SGLang.

python -m sglang.launch_server --model-path Qwen/Qwen3-30B-A3B --reasoning-parser qwen3

- Uso de vLLM.

vllm serve Qwen/Qwen3-30B-A3B --enable-reasoning --reasoning-parser deepseek_r1

(Nota: el artículo original utiliza el parser deepseek_r1, los desarrolladores deben comprobar su compatibilidad con Qwen3)

En el entorno de desarrollo local, ollama puede utilizarse con el sencillo comando ollama ejecuta qwen3:30b-a3b para interactuar con el modelo. Además, herramientas como LMStudio, llama.cpp y ktransformers permiten construir y ejecutar Qwen3 localmente.

Uso avanzado: cambio dinámico de los modos de pensamiento

Qwen3 proporciona un mecanismo de "cambio suave" que permite al usuario controlar dinámicamente el comportamiento del modelo cuando enable_thinking=True. Concretamente, puedes añadir etiquetas /think o /no_think a las preguntas del usuario o a los mensajes del sistema para cambiar el modo de pensamiento del modelo de una ronda a otra. En un diálogo de varias rondas, el modelo seguirá la instrucción más reciente.

A continuación se presenta un ejemplo de diálogo en varias rondas:

from transformers import AutoModelForCausalLM, AutoTokenizer

class QwenChatbot:

def __init__(self, model_name="Qwen/Qwen3-30B-A3B"):

self.tokenizer = AutoTokenizer.from_pretrained(model_name)

# 注意:实际运行时需要确保有足够的 GPU 显存加载模型

# device_map="auto" 可能需要根据实际硬件调整

self.model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto", # 自动选择合适的精度

device_map="auto" # 自动分配模型到可用设备

)

self.history = [] # 用于存储对话历史

def generate_response(self, user_input):

# 将当前用户输入加入历史记录

messages = self.history + [{"role": "user", "content": user_input}]

# 使用 apply_chat_template 构建输入

# 注意:这里没有显式设置 enable_thinking,会使用模型的默认行为或最近的 /think /no_think 指令

text = self.tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

inputs = self.tokenizer(text, return_tensors="pt").to(self.model.device)

# 生成回复

response_ids = self.model.generate(

**inputs,

max_new_tokens=32768 # 设置最大生成 token 数

)[0][len(inputs.input_ids[0]):].tolist() # 提取生成内容

# 解码回复文本

response = self.tokenizer.decode(response_ids, skip_special_tokens=True).strip()

# 更新对话历史

self.history.append({"role": "user", "content": user_input})

# 注意:此处仅添加解码后的纯文本回复,未处理思考内容

# 如果需要保留或展示思考过程,需要像之前的例子一样解析 output_ids

self.history.append({"role": "assistant", "content": response})

# 返回解码后的回复文本

return response

# 示例用法

if __name__ == "__main__":

# 确保在有足够资源的机器上运行

try:

chatbot = QwenChatbot()

# 第一次输入 (默认启用思考模式)

user_input_1 = "strawberries 这个单词里有多少个 'r'?"

print(f"用户: {user_input_1}")

response_1 = chatbot.generate_response(user_input_1)

print(f"助手: {response_1}")

print("----------------------")

# 第二次输入,使用 /no_think 禁用思考模式

user_input_2 = "那么,blueberries 这个单词里有多少个 'r'? /no_think"

print(f"用户: {user_input_2}")

response_2 = chatbot.generate_response(user_input_2)

print(f"助手: {response_2}")

print("----------------------")

# 第三次输入,使用 /think 再次启用思考模式

user_input_3 = "真的吗?请再想想。 /think"

print(f"用户: {user_input_3}")

response_3 = chatbot.generate_response(user_input_3)

print(f"助手: {response_3}")

except Exception as e:

print(f"运行出错: {e}")

print("请确保已安装所需依赖,并拥有足够的计算资源(如 GPU 显存)。")

Uso del agente: Llamada de herramienta

Qwen3 destaca por su capacidad para llamar a las herramientas. Uso recomendado Qwen-Agente (https://github.com/QwenLM/Qwen-Agent) para aprovechar al máximo las capacidades de agente de Qwen3. Qwen-Agent encapsula internamente plantillas y analizadores sintácticos para llamadas a herramientas, simplificando la complejidad del desarrollo.

Para ello MCP Archivos de configuración, utilizando las herramientas de integración de Qwen-Agent, o integrando otras herramientas por su cuenta para definir el conjunto de herramientas disponibles.

import os

from qwen_agent.agents import Assistant

# 定义 LLM 配置

llm_cfg = {

'model': 'Qwen3-30B-A3B', # 指定使用的 Qwen3 模型

# 如果使用阿里云 ModelScope 提供的 DashScope API:

# 'model_type': 'qwen_dashscope',

# 'api_key': os.getenv('DASHSCOPE_API_KEY'), # 需要设置环境变量

# 如果使用兼容 OpenAI API 的自定义端点 (例如 VLLM 或 SGLang 部署的):

'model_server': 'http://localhost:8000/v1', # 替换为你的 API 地址

'api_key': 'EMPTY', # 对于本地部署或不需要 key 的情况

# 可选:其他生成参数配置

# 'generate_cfg': {

# # 如果模型的原始输出将思考过程 <think>...</think> 包含在最终内容里,设为 True

# # 如果 VLLM/SGLang 等框架已分离 reasoning_content 和 content,则设为 False 或不设置

# 'thought_in_content': False,

# },

}

# 定义工具列表

tools = [

{'mcpServers': { # 可以指定 MCP 配置文件或直接定义服务

'time': { # 定义一个名为 'time' 的工具

'command': 'uvx', # 使用 uvx 启动

# 启动参数,运行 mcp-server-time,并设置时区

'args': ['mcp-server-time', '--local-timezone=Asia/Shanghai']

},

"fetch": { # 定义一个名为 'fetch' 的工具,用于访问网页

"command": "uvx",

"args": ["mcp-server-fetch"]

}

}

},

'code_interpreter', # 使用 Qwen-Agent 内置的代码解释器工具

# 可以继续添加其他自定义或内置工具

]

# 初始化 Agent

# 需要确保 uvx 和相应的 mcp-server-* 已安装并配置好

bot = Assistant(llm=llm_cfg, function_list=tools)

# 流式生成调用示例

messages = [{'role': 'user', 'content': '访问 https://qwenlm.github.io/blog/ 页面,并介绍一下 Qwen 的最新进展。'}]

responses = None # 初始化 responses 变量

# bot.run 返回一个生成器,用于流式输出

for responses in bot.run(messages=messages):

# 可以在这里处理中间步骤的输出,例如工具调用和观察结果

# print(responses) # 打印每个中间步骤或最终回复

pass # 循环结束后,responses 将包含最终的完整回复

# 打印最终的回复内容

if responses:

print(responses)

else:

print("未能获取到回复。")

(Nota: Para ejecutar el ejemplo de agente, es necesario instalar la biblioteca qwen-agent y las dependencias relacionadas, y asegurarse de que las herramientas uvx y mcp-server-* están disponibles).

perspectivas de futuro

Qwen3 se considera un hito importante en el camino hacia la Inteligencia Artificial General (AGI) y la Superinteligencia Artificial (ASI). Al ampliar el preentrenamiento y el aprendizaje por refuerzo, el modelo alcanza un mayor nivel de inteligencia. La fusión de modelos de pensamiento híbridos proporciona a los usuarios la flexibilidad necesaria para controlar su presupuesto de pensamiento, mientras que el amplio soporte lingüístico mejora la accesibilidad global.

De cara al futuro, el equipo de Qwen tiene previsto seguir mejorando las capacidades de los modelos en múltiples dimensiones, como la optimización de las arquitecturas de los modelos y los métodos de entrenamiento para el escalado de datos, el aumento del tamaño de los modelos, la ampliación de la longitud del contexto, la ampliación del soporte de modalidades y el avance del aprendizaje de refuerzo a través de la retroalimentación ambiental para permitir el razonamiento a largo plazo. El equipo cree que la industria está pasando de la era de la formación de "modelos" a la era de la formación de "inteligencias" (agentes). Su próxima iteración promete aportar avances más significativos al trabajo y a la vida.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...