Nuevo modelo multimodal Qwen2.5-VL-32B-Instruct con prestaciones de Super 72B.

Recientemente, el tan esperado Qwen2.5-VL Se ha lanzado Qwen2.5-VL-32B-Instruct, un nuevo miembro de la serie Qwen2.5-VL. Este modelo de lenguaje visual multimodal a escala de 32 billones de parámetros hereda las ventajas de la serie Qwen2.5-VL y se optimiza aún más mediante el aprendizaje por refuerzo y otras técnicas para lograr mejoras significativas en el rendimiento, especialmente en el razonamiento complejo y la experiencia de usuario.

A finales de enero de este año, el equipo de Qwen lanzó la serie de modelos Qwen2.5-VL, y rápidamente obtuvo una amplia atención y comentarios positivos de la comunidad. Para responder a las expectativas de la comunidad y seguir promoviendo el desarrollo de la tecnología de modelado multimodal, el equipo ha dedicado varios meses a pulir cuidadosamente la serie Qwen2.5-VL y finalmente ha lanzado este nuevo modelo Qwen2.5-VL-32B-Instruct, de código abierto mediante el protocolo Apache 2.0, con el objetivo de beneficiar a un mayor número de desarrolladores e investigadores.

Un salto en rendimiento, con una serie de métricas que superan las de generaciones anteriores y modelos similares.

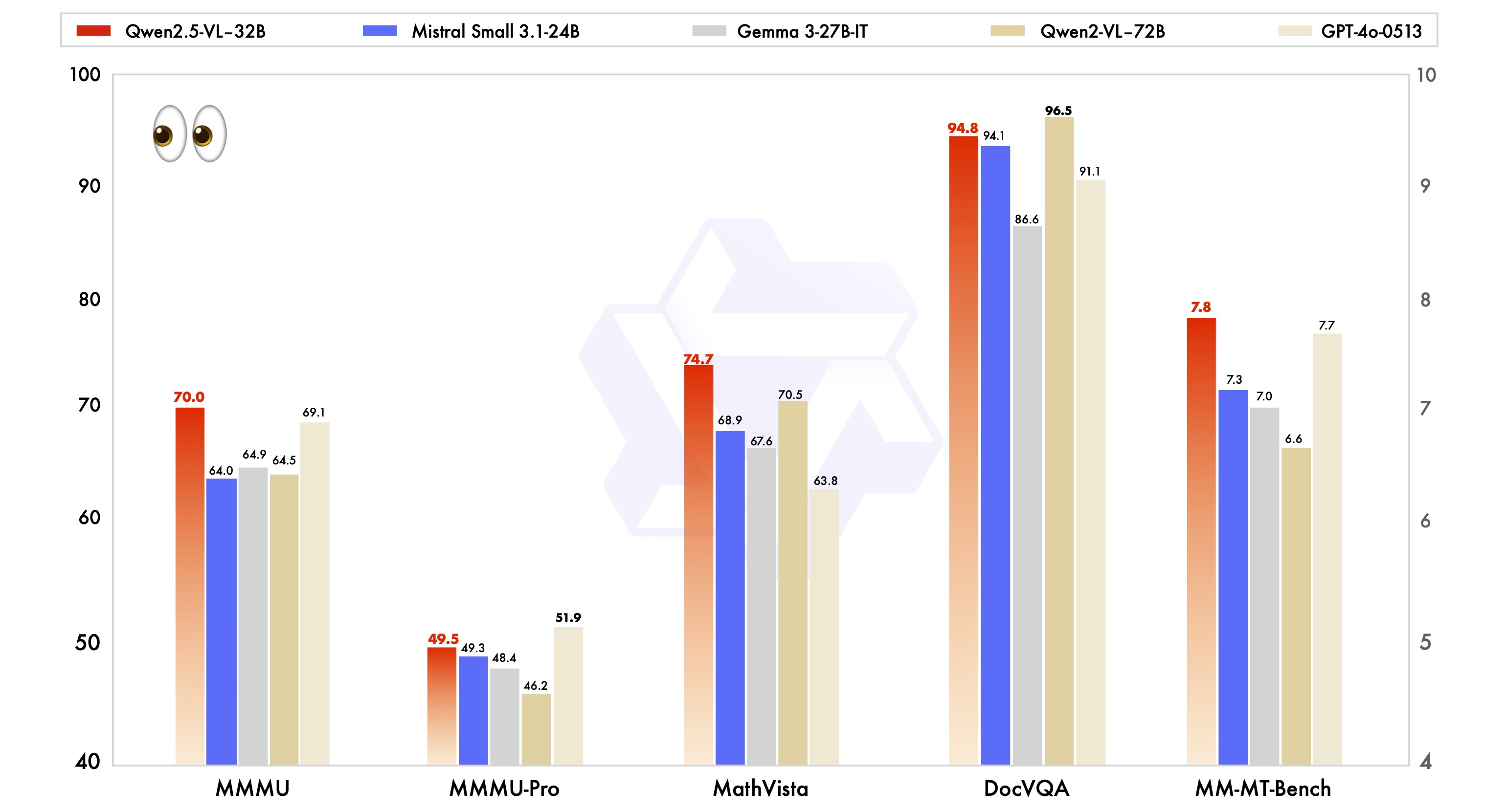

Los datos oficiales muestran que el modelo Qwen2.5-VL-32B-Instruct consigue mejoras significativas en una serie de indicadores clave de rendimiento en comparación con la serie Qwen2.5-VL lanzada anteriormente.

En primer lugar, en cuanto a las preferencias subjetivas de los usuarios, el nuevo modelo, al ajustar el estilo de salida, hace que las respuestas sean más detalladas y tengan un formato más normalizado, más acorde con los hábitos y preferencias de lectura humanos. Esto significa que los usuarios obtendrán una experiencia de interacción más fluida y natural durante su uso.

En segundo lugar, en cuanto a la capacidad de razonamiento matemático, el modelo Qwen2.5-VL-32B-Instruct ha progresado notablemente en la precisión de la resolución de problemas matemáticos complejos. Esto indica que el modelo se ha mejorado eficazmente en términos de razonamiento lógico y capacidad de cálculo, y es más capaz de hacer frente a tareas que requieren un pensamiento profundo y un cálculo preciso.

Además, el modelo Qwen2.5-VL-32B-Instruct muestra una mayor fortaleza en la comprensión y el razonamiento detallado de imágenes. Ya sea en la precisión del análisis sintáctico de imágenes, la amplitud del reconocimiento de contenidos o la profundidad de la inferencia lógica visual, el nuevo modelo muestra un nivel superior y es capaz de analizar la información de la imagen de forma más precisa y meticulosa.

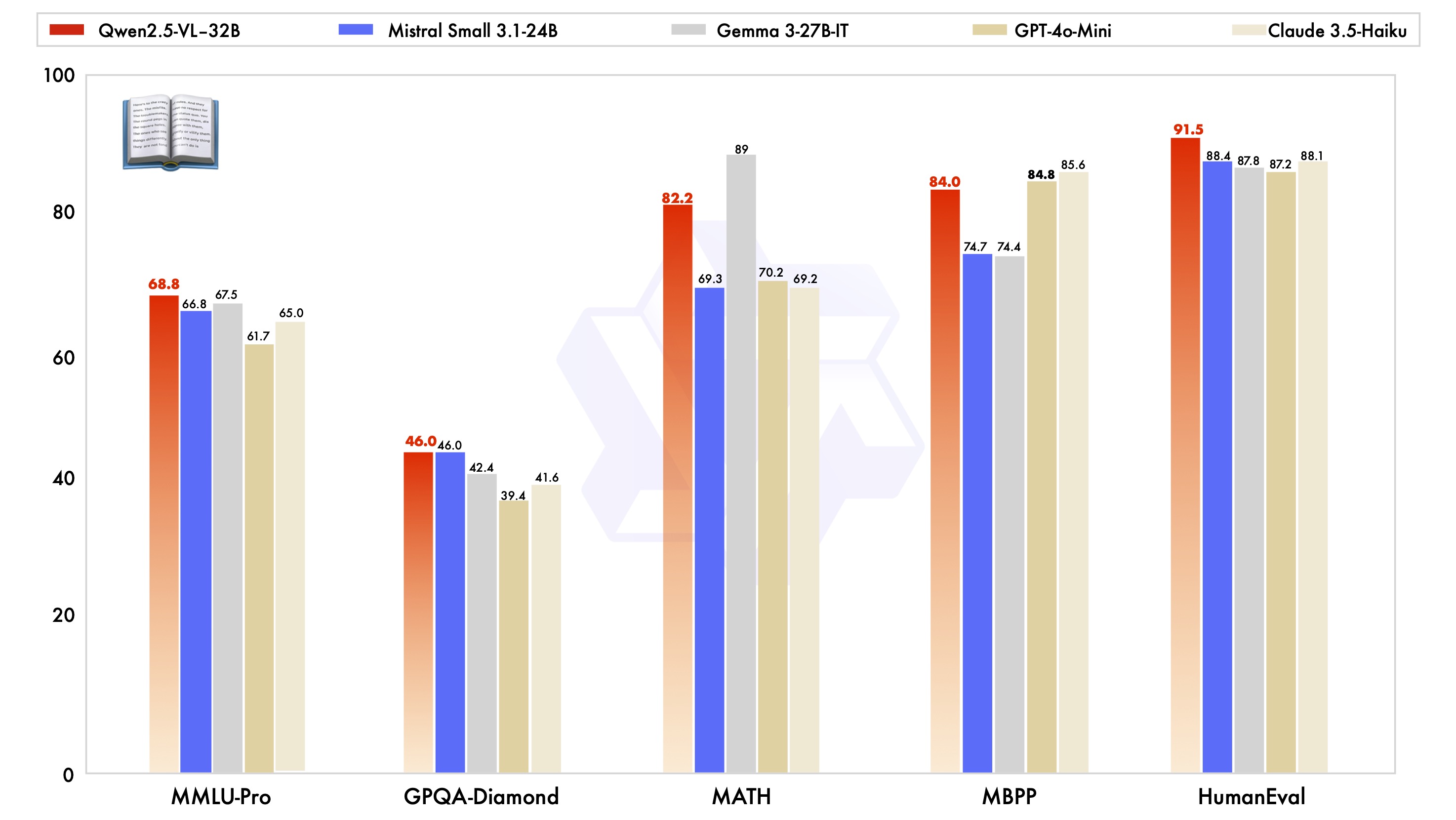

Para demostrar las ventajas de rendimiento del modelo Qwen2.5-VL-32B-Instruct, también se probó frente a modelos líderes del sector del mismo tamaño, como Mistral-Small-3.1-24B y Gemma-3-27B-IT. Los resultados muestran que el modelo Qwen2.5-VL-32B-Instruct presenta ventajas evidentes en muchas tareas multimodales, y algunos de los índices incluso superan al modelo Qwen2-VL-72B-Instruct, de mayor escala. En concreto, el excelente rendimiento del modelo Qwen2.5-VL-32B-Instruct es impresionante en tareas como MMMU, MMMU-Pro y MathVista, que hacen hincapié en el razonamiento complejo de varios pasos. En la prueba comparativa MM-MT-Bench, que se centra en la experiencia subjetiva del usuario, el modelo también ha progresado notablemente en comparación con su predecesor, Qwen2-VL-72B-Instruct.

Cabe destacar que el modelo Qwen2.5-VL-32B-Instruct no sólo obtiene buenos resultados en cuanto a capacidad visual, sino que también alcanza el nivel óptimo del modelo a la misma escala en cuanto a capacidad de texto plano.

Tecnología destacada: resolución dinámica, codificador visual eficaz

La serie de modelos Qwen2.5-VL también presenta una serie de innovaciones y mejoras en la arquitectura técnica.

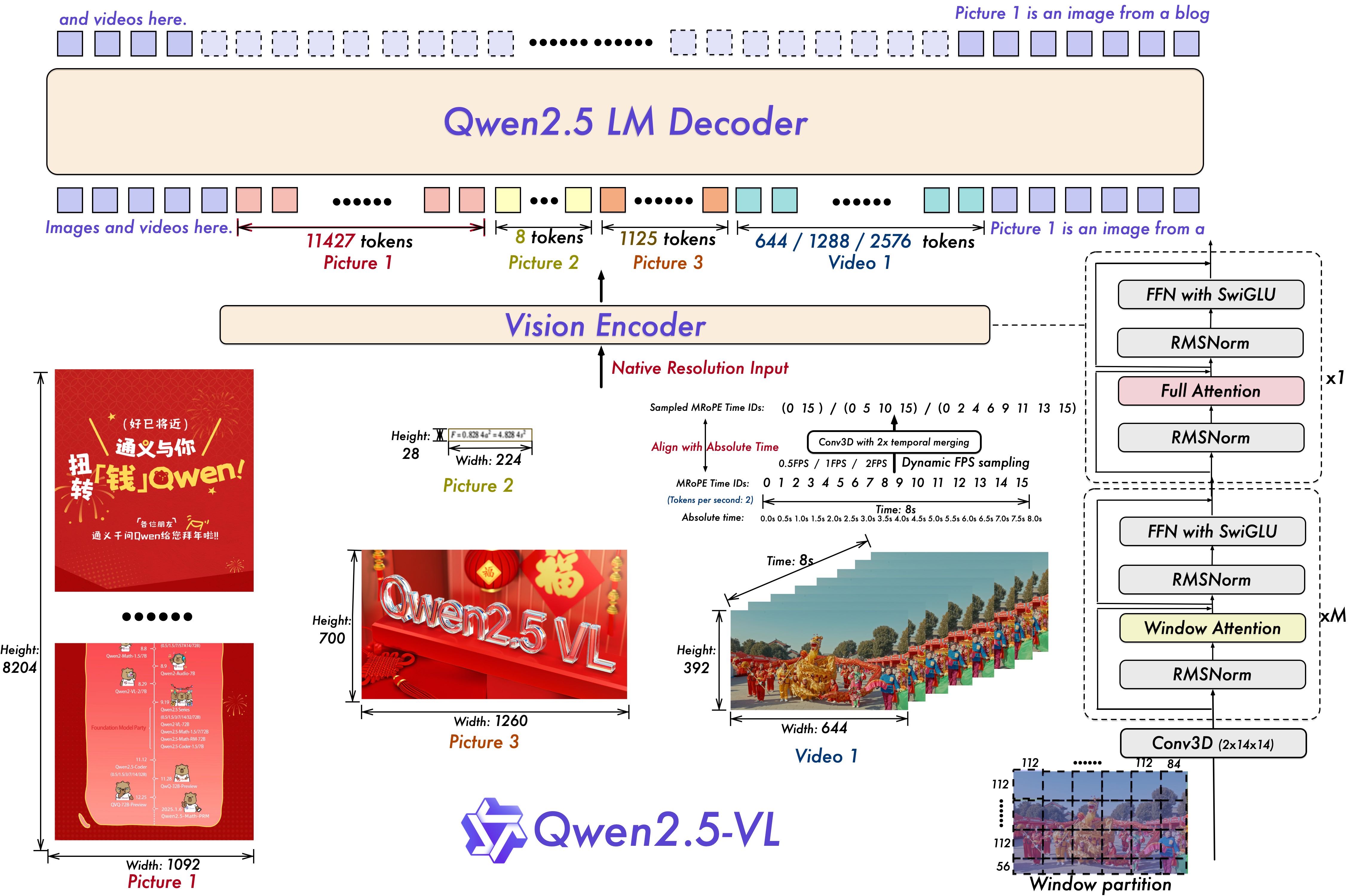

Para la comprensión del vídeo, el modelo utiliza técnicas de entrenamiento dinámicas de resolución y frecuencia de fotogramas, que le permiten comprender contenidos de vídeo con diferentes frecuencias de muestreo introduciendo un muestreo dinámico de FPS. Mientras tanto, la codificación mRoPE (Multiple Relative Position Encoding) se actualiza en la dimensión temporal y se combina con ID y alineación temporal absoluta para que el modelo aprenda información sobre series temporales y velocidad, lo que le confiere la capacidad de captar momentos clave del vídeo.

Para el codificador de visión, la serie de modelos Qwen2.5-VL utiliza un codificador de visión racionalizado y eficiente, que puede utilizarse en el codificador ViT (Vision). Transformador) introduce estratégicamente el mecanismo de atención en ventanas en Qwen2.5 LLM y lo combina con optimizaciones como SwiGLU y RMSNorm para hacer la arquitectura ViT más consistente con la estructura de Qwen2.5 LLM, mejorando así de forma efectiva la velocidad de entrenamiento e inferencia del modelo.

Inclusión del código abierto en la innovación de aplicaciones multimodales

La publicación en código abierto del modelo Qwen2.5-VL-32B-Instruct inyectará sin duda nueva vitalidad al campo del lenguaje visual multimodal. A partir de este modelo, los desarrolladores e investigadores podrán profundizar en la investigación y desarrollar aplicaciones más amplias, como la comprensión de contenidos de imagen y vídeo, los agentes inteligentes, la generación de contenidos multimodales, etc.

El modelo Qwen2.5-VL-32B-Instruct ya está disponible en Hugging Face Transformers y ModelScope, con ejemplos de código detallados e instrucciones para que los usuarios puedan empezar a utilizarlo rápidamente, y el equipo de Qwen ha indicado que seguirá centrándose en los comentarios de la comunidad para optimizar y mejorar la serie Qwen2.5-VL. Los modelos de la serie Qwen2.5-VL seguirán atentos a los comentarios de la comunidad, optimizándolos y mejorándolos, y contribuyendo al desarrollo de la tecnología multimodal.

Para aquellos que deseen experimentar el modelo Qwen2.5-VL-32B-Instruct, se puede empezar rápidamente de la siguiente manera:

Configuración del entorno

Se recomienda que los usuarios creen la biblioteca de transformadores a partir del código fuente para garantizar la compatibilidad:

pip install git+https://github.com/huggingface/transformers accelerateEjemplo de código de inicio rápido (usando 🤗 Transformers).

from transformers import Qwen2_5_VLForConditionalGeneration, AutoTokenizer, AutoProcessor

from qwen_vl_utils import process_vision_info

# 加载模型

model = Qwen2_5_VLForConditionalGeneration.from_pretrained(

"Qwen/Qwen2.5-VL-32B-Instruct", torch_dtype="auto", device_map="auto"

)

# 加载 processor

processor = AutoProcessor.from_pretrained("Qwen/Qwen2.5-VL-32B-Instruct")

# 构建 messages

messages = [

{

"role": "user",

"content": [

{

"type": "image",

"image": "https://qianwen-res.oss-cn-beijing.aliyuncs.com/Qwen-VL/assets/demo.jpeg",

},

{"type": "text", "text": "Describe this image."},

],

}

]

# 预处理

text = processor.apply_chat_template(

messages, tokenize=False, add_generation_prompt=True

)

image_inputs, video_inputs = process_vision_info(messages)

inputs = processor(

text=[text],

images=image_inputs,

videos=video_inputs,

padding=True,

return_tensors="pt",

)

inputs = inputs.to("cuda")

# 模型推理

generated_ids = model.generate(**inputs, max_new_tokens=128)

generated_ids_trimmed = [

out_ids[len(in_ids) :] for in_ids, out_ids in zip(inputs.input_ids, generated_ids)

]

output_text = processor.batch_decode(

generated_ids_trimmed, skip_special_tokens=True, clean_up_tokenization_spaces=False

)

print(output_text)

El lanzamiento del modelo Qwen2.5-VL-32B-Instruct aporta sin duda nuevos avances en el campo de los modelos de lenguaje visual multimodal, y se espera que sus ventajas en cuanto a rendimiento, tecnología y código abierto aceleren la popularidad y aplicación de la tecnología multimodal, lo que merece la atención continua de la industria.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Puestos relacionados

Sin comentarios...