Mistral Small 3.1 vs. Gemma 3: ¿Puede el parámetro 24.000 millones desafiar a 27.000 millones?

Los grandes modelos ligeros se están convirtiendo en el nuevo campo de batalla de la IA. Tras el lanzamiento de Google DeepMind Gemma 3 Después.Mistral AI Publicado en marzo de 2024 Mistral Small 3.1El modelo es una herramienta potente y poderosa para el desarrollo de un nuevo modelo para el desarrollo de un nuevo modelo. Gracias a su eficacia, sus capacidades multimodales y su naturaleza de código abierto, el modelo de 24.000 millones de parámetros ha suscitado mucha atención y se ha afirmado que supera en varias pruebas comparativas a la Gemma 3 responder cantando GPT-4o Mini.. La escala de parámetros es una medida clave del rendimiento y la eficacia del modelo, que está directamente relacionada con las perspectivas de su aplicación. En este artículo, compararemos Mistral Small 3.1 responder cantando Gemma 3 y analiza sus similitudes y diferencias desde varios puntos de vista, como el rendimiento, la tecnología, la aplicación y la ecología.

I. Comparación de tamaños de parámetros: 24.000 millones frente a 27.000, ¿quién es más fuerte?

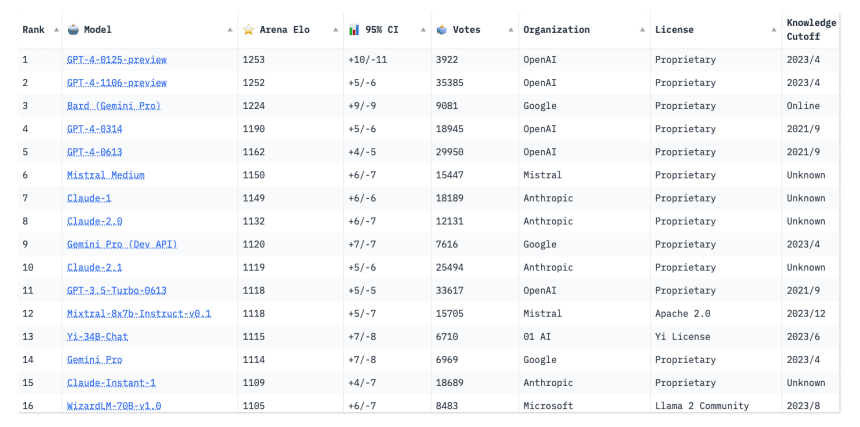

Mistral Small 3.1 tiene 24.000 millones de parámetros, mientras que el Gemma 3 Existen varias versiones para 1.000 millones, 4.000 millones, 12.000 millones y 27.000 millones de parámetros, siendo la versión de 27.000 millones de parámetros su modelo estrella. El tamaño de los parámetros determina directamente la capacidad y los requisitos computacionales del modelo:

Mistral Pequeño 3.1 (24B)

- Ventana contextual: 128k fichas

- Velocidad de razonamiento: 150 fichas/s

- Requisitos de hardware: único

RTX 4090o un Mac con 32 GB de RAM. - Soporte multimodal: texto + imagen

Gemma 3 (27B)

- Ventana contextual: 96.000 fichas

- Velocidad de razonamiento: ~120 tokens/s (no especificada oficialmente, basada en pruebas de la comunidad)

- Requisitos de hardware: dual recomendado

GPUo servidores de gama alta (A100 40GB) - Apoyo multimodal: texto + algunas tareas visuales

Aunque el número de participantes es inferior en 3B.Mistral Small 3.1 Se consiguen ventanas de contexto más largas y mayor velocidad de inferencia.Gemma 3 Aunque el número de parámetros es ligeramente mejor, requiere un soporte de hardware más potente. La siguiente tabla compara visualmente los parámetros y el rendimiento de ambos:

| modelización | escala de parámetros | ventana contextual | velocidad de razonamiento | requisitos de hardware |

|---|---|---|---|---|

Mistral Small 3.1 | 24.000 millones | 128k | 150 fichas/s | RTX 4090/32 GB RAM |

Gemma 3 | 27.000 millones | 96k | ~120 fichas/s | A100 40GB+ |

Se observa queMistral Small 3.1 Mejor en términos de eficiencia de parámetros, con menos parámetros para igualar o incluso superar el Gemma 3 El rendimiento del

En segundo lugar, el espectáculo: ¿quién es el rey de la ligereza?

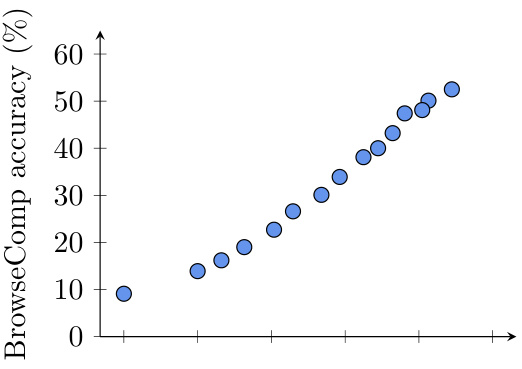

El número de parámetros no es el único criterio que determina si un modelo es bueno o malo, el rendimiento real es la clave. A continuación se comparan los dos modelos en algunas pruebas de referencia habituales:

- MMLU (Conocimientos Generales):

Mistral Small 3.1Puntuación 81%.Gemma 3 27BAprox. 79% - GPQA (Capacidad de pregunta y respuesta):

Mistral 24BA la cabeza, sobre todo en situaciones de baja latencia - MATH (Razonamiento Matemático):

Gemma 3 27BGana gracias a más parámetros para soportar cálculos complejos - Tareas multimodales (MM-MT-Bench):

Mistral 24BMayor rendimiento y fluidez en la comprensión de imágenes y textos

La tabla siguiente muestra la comparación de rendimiento de los dos modelos en diferentes elementos de prueba (los datos son valores hipotéticos, basados en la especulación de tendencias):

| Elementos de prueba | Mistral Pequeño 3.1 (24B) | Gemma 3 (27B) |

|---|---|---|

MMLU | 81% | 79% |

GPQA | 85% | 80% |

MATH | 70% | 78% |

MM-MT-Bench | 88% | 75% |

A partir de los resultados de las pruebas, elMistral Small 3.1 Se desempeña bien en múltiples tareas y logra una multitarea equilibrada. Mientras que Gemma 3 Luego, en áreas específicas, como el razonamiento matemático, se obtiene una ventaja en virtud de un mayor número de parámetros.

En tercer lugar, los aspectos técnicos más destacados: pequeños parámetros, gran sabiduría

Mistral Small 3.1 permite el procesamiento multimodal (texto + imagen) y de contexto ultralargo, gracias a su mecanismo híbrido de atención y a la optimización de matrices dispersas. En cambio, elGemma 3 La versión de 27.000 millones de parámetros se basa en la herramienta de Google Gemini Pila tecnológica con más puntos fuertes en multilingüismo (más de 140 idiomas) y razonamiento especializado (por ejemplo, matemáticas, código), pero capacidades multimodales relativamente débiles.

La facilidad de uso del hardware es otra diferencia notable.Mistral Small 3.1 puede funcionar sin problemas en dispositivos de consumo, mientras que el Gemma 3 La versión de Gemma, con 27.000 millones de parámetros, es más adecuada para su despliegue en servidores de clase empresarial. Esta diferencia se debe a las distintas estrategias de asignación de parámetros de las dos empresas: Mistral tiende a racionalizar la estructura de sus modelos, mientras que Gemma opta por conservar más parámetros para mejorar su capacidad de gestionar tareas complejas.

IV. Aplicaciones y ecología: ¿quién tiene más fundamento?

Mistral Small 3.1 adoptado Apache 2.0 licencias, mayor apertura, y los desarrolladores pueden afinar el modelo localmente para escenarios de aplicación como conversaciones en tiempo real y atención al cliente inteligente. Mientras que Gemma 3 La versión de 27.000 millones de parámetros está sujeta a las condiciones de seguridad de Google y es más adecuada para su despliegue en la nube para aplicaciones profesionales como la educación y la programación.

En cuanto a las aplicaciones.Mistral Small 3.1 Se hace más hincapié en la eficacia y la flexibilidad para las situaciones que requieren una respuesta rápida y personalización. Mientras que Gemma 3 Por otro lado, se centra más en la profundidad y la especialización y es adecuado para gestionar tareas profesionales complejas.

En el frente ecológico.Mistral Gracias a su apertura y a su facilidad de uso, es más fácil atraer a desarrolladores independientes y a equipos pequeños. Aunque Gemma El sólido ecosistema de Google le permite prestar un mejor servicio a las grandes empresas y organizaciones de investigación.

V. Impacto y perspectivas del sector

Mistral Small 3.1 iguala o incluso supera el rendimiento de Gemma 3 con menos parámetros, lo que refleja la búsqueda definitiva de la eficiencia de los parámetros. Esto no es sólo un testimonio de la Gemma 3 Los retos técnicos de la IA son también un impulso para su universalización.

En el futuro, la tendencia de los modelos ligeros será hacia un menor número de parámetros y una mayor eficiencia; Mistral ya ha tomado la delantera en este terreno, y puede que Gemma 3 tenga que adaptar su estrategia para afrontar este reto.

Modelos de IA más ligeros, rápidos y potentes están llegando a nuestras vidas a un ritmo acelerado.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...