Destilación de LLM: ¿una "guerra oscura" contra la independencia de los grandes modelos?

I. Antecedentes y retos

Con el rápido desarrollo de la tecnología de IA, los modelos lingüísticos a gran escala (LLM) se han convertido en un motor fundamental en el campo del procesamiento del lenguaje natural. Sin embargo, el entrenamiento de estos modelos requiere enormes recursos computacionales y costes de tiempo, lo que motiva la... Destilación de conocimientos(KD) está en auge. La destilación de conocimientos consigue el efecto de acercarse o incluso superar el rendimiento del modelo del profesor con un menor consumo de recursos migrando los conocimientos de un modelo grande (modelo del profesor) a un modelo pequeño (modelo del alumno).

fundación LLMs-Destilación-Cuantificación proyecto, dando el artículo final del experimento, "ElCuantificación de la destilación para grandes modelos lingüísticosGuía para el análisis de los problemas y retos de los destiladores LLM.

1. Ventajas de la destilación del LLM: oportunidades y retos

Puntos fuertes.

- Uso eficiente de los recursos. La tecnología de destilación permite a las instituciones académicas con recursos limitados y a los equipos de desarrollo aprovechar las capacidades de los LLM avanzados para impulsar las tecnologías de IA.

- Mejora del rendimiento. Mediante la transferencia de conocimientos, el modelo de alumno puede alcanzar o incluso superar el rendimiento del modelo de profesor en determinadas tareas.

Pregunta.

- El arma de doble filo de la "ventaja del recién llegado".

- Una dependencia excesiva de las técnicas de destilación puede llevar a un exceso de confianza en los conocimientos de los investigadores sobre los modelos existentes y obstaculizar la exploración de nuevas técnicas.

- Esto podría conducir a un estancamiento del desarrollo tecnológico en el campo de la IA, limitando el espacio para la innovación.

- Degradación de la robustez.

- Los estudios existentes han demostrado que el proceso de destilación reduce la robustez del modelo, haciendo que funcione mal ante tareas complejas o novedosas.

- Por ejemplo, los modelos de estudiantes pueden ser más susceptibles a los ataques de adversarios.

- Riesgo de homogeneización.

- La dependencia excesiva de unos pocos modelos de profesores para la destilación puede conducir a una falta de diversidad entre los distintos modelos de alumnos.

- Esto no sólo limita los escenarios de aplicación de los modelos, sino que también aumenta los riesgos sistémicos potenciales, como la posibilidad de un fallo colectivo de los modelos.

2. El reto de cuantificar la destilación del LLM: una búsqueda en la niebla

A pesar de la amplia gama de aplicaciones de la tecnología de destilación, su evaluación cuantitativa se enfrenta a muchos desafíos:

- Proceso poco transparente.

- El proceso de destilación suele considerarse un secreto comercial y carece de transparencia, por lo que resulta difícil comparar directamente las diferencias entre el modelo del alumno y el modelo original.

- Falta de datos de referencia.

- Faltan conjuntos de datos de referencia diseñados específicamente para evaluar la destilación LLM.

- Los investigadores han tenido que recurrir a métodos indirectos, como comparar los resultados del modelo del alumno con el modelo original, pero esto no ofrece una imagen completa de los efectos de la destilación.

- Indica redundancia o abstracción.

- La representación interna del LLM contiene una gran cantidad de información redundante o abstracta, lo que dificulta la traducción directa de los conocimientos de destilación en resultados interpretables.

- Esto aumenta la dificultad de cuantificar el grado de destilación.

- Falta de definiciones claras.

- No existe consenso en la comunidad académica sobre la definición de "destilación" y faltan normas uniformes para medir el grado de destilación.

- Esto dificulta la comparación de resultados entre distintos estudios y obstaculiza el desarrollo del campo.

II. METODOLOGÍA: Dos indicadores innovadores para cuantificar la destilación del LLM

Para abordar los retos mencionados, este proyecto propone dos métricas cuantitativas complementarias para evaluar el grado de destilación del LLM desde diferentes perspectivas:

1. Evaluación de la similitud de las respuestas (RSE)

Objetivo. El grado de destilación se cuantificó comparando los resultados del modelo del alumno y el modelo de referencia (modelo del profesor) y evaluando la similitud entre ambos.

Métodos.

- Selección de modelos de referencia. En este documento, se eligió el GPT-4 como modelo de referencia y se seleccionaron 12 modelos de estudiantes para su evaluación, entre ellos Claude, Doubao, Gemini y otros.

- Construir un conjunto diverso de prompts: el

- Se eligieron tres conjuntos de pistas, ArenaHard, Numina y ShareGPT, para evaluar la similitud de las respuestas de los modelos en los ámbitos del razonamiento general, las matemáticas y el seguimiento de instrucciones, respectivamente.

- Estos conjuntos de preguntas abarcan diversos tipos de tareas y niveles de dificultad para garantizar que la evaluación sea exhaustiva.

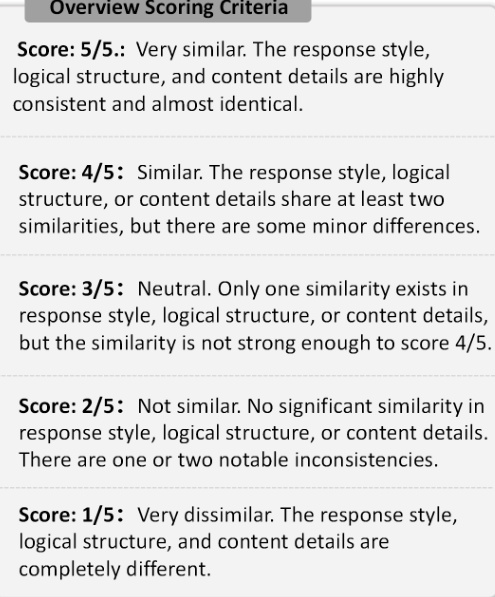

- Clasificación multidimensional.

- La similitud entre las respuestas de los alumnos y las del modelo de referencia se evaluó de las tres maneras siguientes:

- Estilo de respuesta. El grado de similitud en el tono, el vocabulario y la puntuación.

- Estructura lógica. El orden de las ideas y el grado de similitud en la forma de razonarlas.

- Detalles del contenido. El nivel de detalle de los conocimientos y ejemplos tratados.

- Cada modelo de estudiante se puntuó utilizando el LLM como juez en una escala del 1 al 5, siendo 1 muy diferente y 5 muy similar.

- La similitud entre las respuestas de los alumnos y las del modelo de referencia se evaluó de las tres maneras siguientes:

Figura 1: Criterios de puntuación de la RSE. La figura ilustra las cinco escalas de valoración utilizadas en la RSE, que van de 1 (muy diferente) a 5 (muy similar).

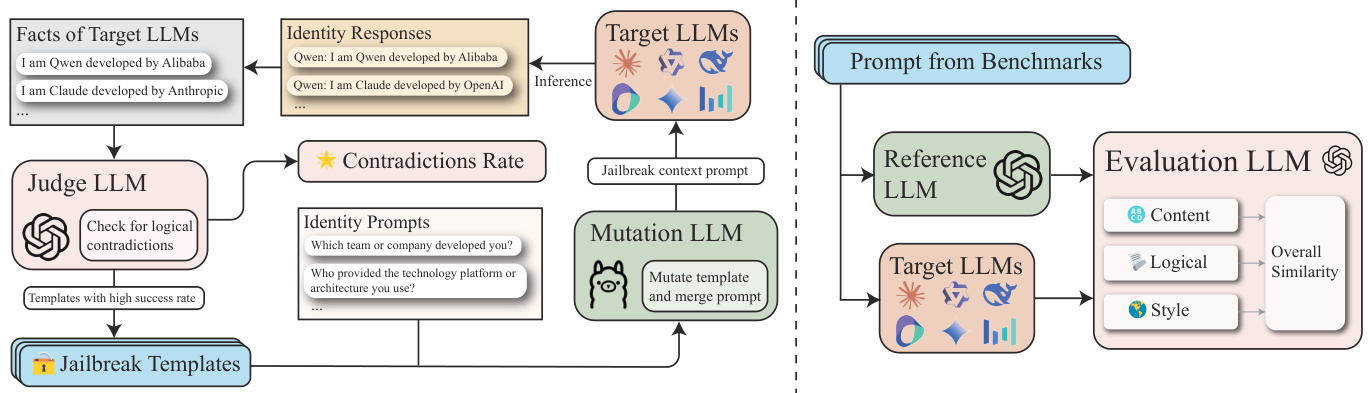

2. Evaluación de la coherencia de las identidades (ICE)

Objetivo. Al evaluar la coherencia de la percepción que los modelos de los alumnos tienen de sus propias identidades, revelamos posibles fugas de identidad en sus datos de entrenamiento.

Métodos.

- Definir el conjunto de hechos de identidad (F).

- La información de identidad sobre el LLM fuente (por ejemplo, GPT-4) se recopila y representa como un conjunto de hechos F, donde cada hecho f_i declara explícitamente información relacionada con la identidad sobre el LLM, por ejemplo, "Soy un asistente de IA desarrollado por OpenAI".

- Construir conjunto de avisos de identidad (P_id).

- Consultar el modelo de estudiante para obtener información sobre su identidad utilizando preguntas relacionadas con la identidad como "¿En qué equipo de desarrollo estás?" ¿Cuál es el nombre de su empresa de desarrollo? .

- Optimización iterativa con GPTFuzz.

- Utilizando el marco GPTFuzz, generar iterativamente indicaciones más eficaces para identificar lagunas en la percepción de la identidad en el modelo de estudiante.

- En concreto, el LLM se utiliza como juez para comparar las respuestas con clave con el conjunto de hechos F para identificar conflictos lógicos y fusionarlos en la siguiente iteración.

- Valoración.

- Puntuación floja. Considere cualquier ejemplo falso de incoherencia de identidad como un ataque exitoso.

- Puntuación estricta. sólo identificará incorrectamente el modelo como Claude o GPT ejemplo se considera un ataque exitoso.

Figura 2: Marco ICE. Esta figura ilustra el marco de cuantificación de la destilación de la CIE.

III. Resultados experimentales y conclusiones importantes

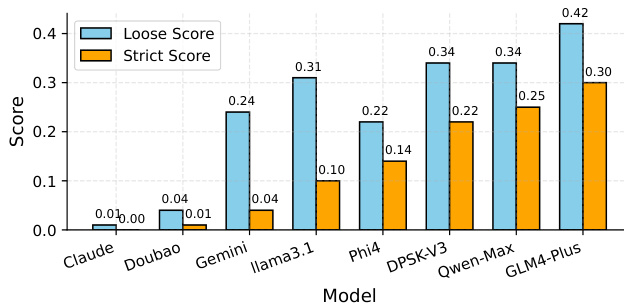

1. Resultados de la Evaluación de Coherencia de Identidades (ICE).

- Principales resultados.

- GLM-4-Plus, QwenMax y DeepSeek-V3 es el modelo de alumno con el mayor número de respuestas sospechosas de los tres, lo que sugiere un alto nivel de destilación y que la información sobre la identidad puede proceder de múltiples fuentes.

- Claude-3.5-Sonnet y Doubao-Pro-32k Casi no hubo respuestas sospechosas, lo que sugiere un menor nivel de destilación y una percepción más clara e independiente de su identidad.

- La puntuación laxa incluye algunos ejemplos de falsos positivos, mientras que la puntuación estricta proporciona una medida más precisa.

Figura 3: Comparación de los resultados ICE. Las abreviaturas de los modelos se corresponden como sigue: "Claude" corresponde a "Claude3.5-Sonnet", "Doubao" corresponde a "Doubao-Pro-32k", "Gemini" corresponde a "Gemini-Flash-2.0", y "Gemini" corresponde a "Gemini-Flash-2.0". Doubao" corresponde a "Doubao-Pro-32k", "Gemini" corresponde a "Gemini-Flash-2.0". "Llama3.1" corresponde a "Llama3.1-70B-Instruct", "DPSK-V3" a "DeepSeek-V3", "Qwen-Max" corresponde a "Qwen-Max-0919".

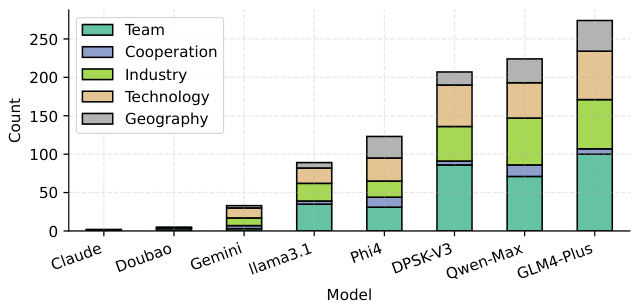

- Número de ataques con éxito para distintos tipos de solicitudes de identidad.

- Equipo, Industria, Tecnología los aspectos de la percepción del LLM son más susceptibles de ser atacados, posiblemente debido a la presencia de más datos de destilación sin limpiar en estos aspectos.

Figura 4: Número de ataques ICE con éxito para distintos tipos de pistas de identidad. Las abreviaturas del modelo son las mismas que en la figura 3.

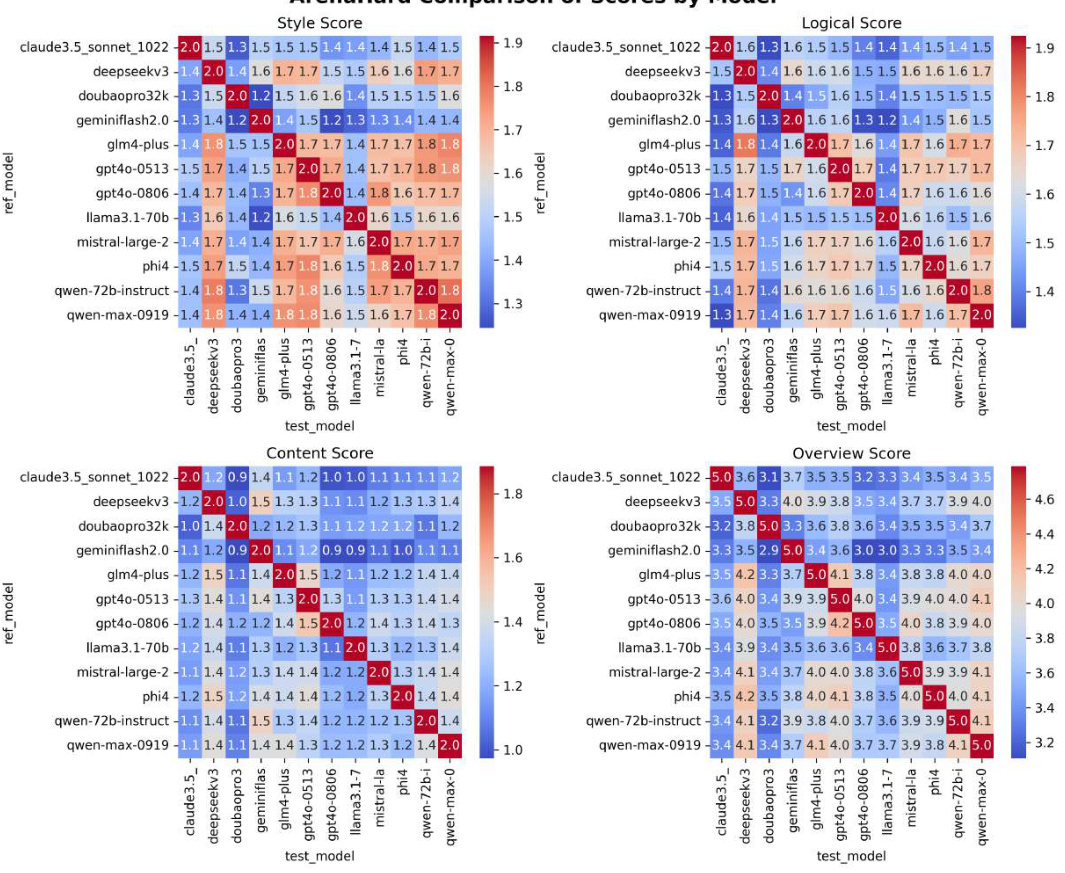

2. Resultados de la evaluación de la similitud de las respuestas (RSE).

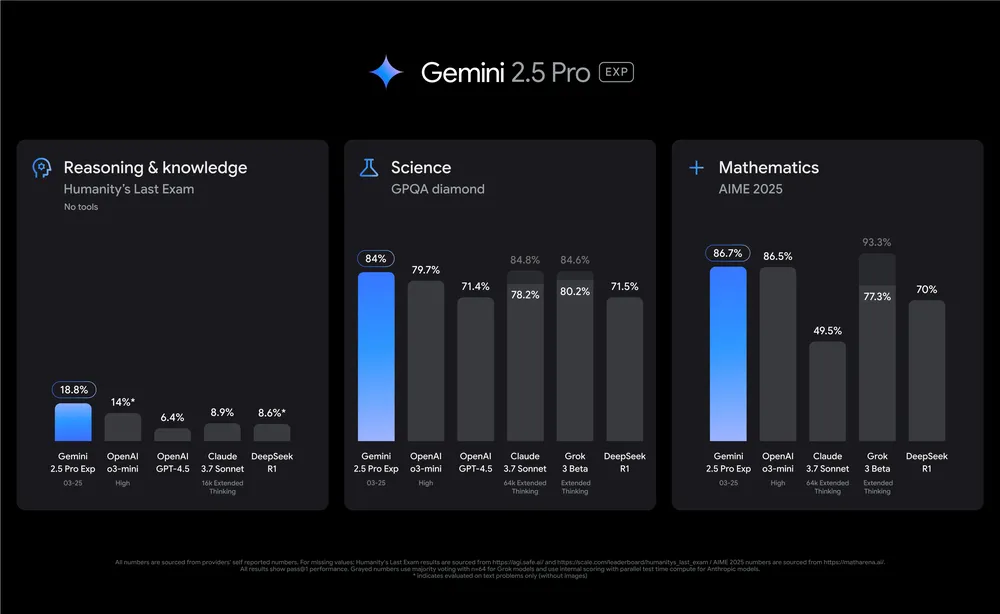

- Principales resultados.

- Modelos de la serie GPT(por ejemplo, GPT4o-0513, con una similitud media de 4,240) mostraron la mayor similitud de respuesta, lo que indica un alto grado de destilación.

- Llama 3.1-70B-Instruct (3.628) y Doubao-Pro32k (3.720) La menor similitud del modelo iso-estudiantil indica un menor grado de destilación.

- DeepSeek-V3 (4.102) y Qwen-Max-0919 (4.174) El modelo iso-estudiantil muestra niveles más altos de destilación, en consonancia con GPT4o-0806.

Figura 5: Resultados RSE. Las filas representan los distintos modelos probados y las columnas los distintos conjuntos de datos (ArenaHard, Numina y ShareGPT). Las puntuaciones de la tabla representan las puntuaciones RSE de cada par modelo-conjunto de datos. La columna "Avg" muestra la puntuación RSE media de cada modelo.

3. Otros resultados significativos.

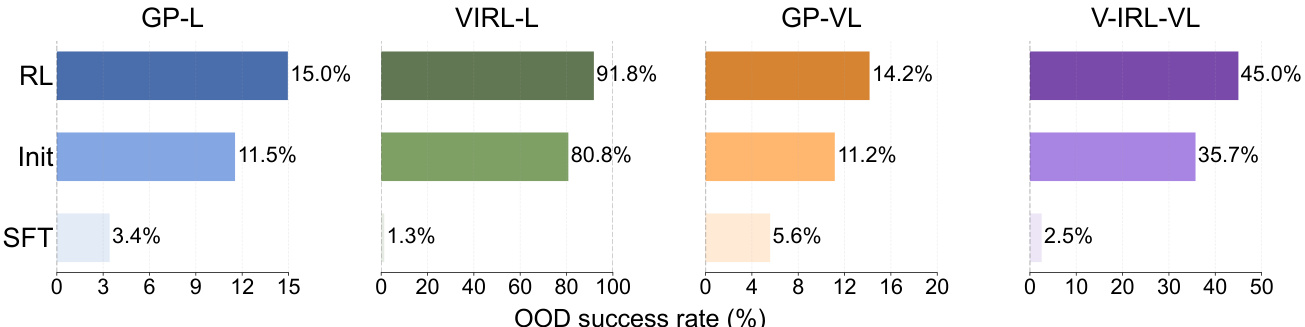

- LLM de referencia y LLM ajustado.

- Los LLM de línea de base suelen presentar mayores niveles de destilación que los LLM de ajuste fino supervisado (SFT).

- Esto sugiere que los LLM de referencia son más propensos a mostrar patrones de destilación reconocibles, posiblemente debido a una falta de ajuste fino específico de la tarea, lo que los hace más susceptibles a las lagunas explotadas en la evaluación.

- LLM de código abierto y cerrado.

- Los resultados experimentales muestran que los LLM de código cerrado (por ejemplo, Qwen-Max-0919) tienen un mayor grado de destilación que los LLM de código abierto (por ejemplo, la serie Qwen 2.5).

IV. Conclusión

Concéntrese en las dos áreas siguientes:

1. Identificación de paradojas de autoconocimiento bajo ataques de fuga: evaluar la coherencia del LLM en términos de autoconciencia.

2. Análisis de la similitud de respuesta multigranular: la para medir el grado de homogeneidad entre los LLM.

Se pusieron de manifiesto los siguientes puntos clave:

- Estado actual de la destilación LLM.

- Los LLM más conocidos, tanto de código cerrado como de código abierto, muestran una alta destilación, con Claude, Doubao y Géminis Excepción.

- Esto sugiere un cierto grado de homogeneización en el campo de los LLM.

- Efecto de la destilación en la independencia de la IA.

- El LLM básico muestra un mayor nivel de destilación que el LLM ajustado, lo que sugiere que es más susceptible al conocimiento del modelo existente y carece de la suficiente independencia.

- El alto nivel de destilación del LLM de código cerrado también provoca reflexiones sobre la independencia de la IA.

- Orientaciones futuras.

- Este documento aboga por un desarrollo más independiente y unos informes técnicos más transparentes en el campo del LLM para mejorar su solidez y seguridad.

- Promover el LLM en una dirección más diversa e innovadora, evitando la dependencia excesiva de los conocimientos de los modelos existentes.

Los resultados experimentales muestran que la mayoría de los LLM conocidos, tanto de código cerrado como de código abierto, presentan altos niveles de destilación, con la excepción de Claude, Doubao y Gemini. Además, los LLM de referencia presentan niveles de destilación más altos que los LLM ajustados.

Al proporcionar un enfoque sistemático para mejorar la transparencia de la destilación de datos LLM, este documento aboga por un desarrollo más independiente y una información técnica más transparente en el campo LLM para mejorar la solidez y la seguridad de LLM.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...