LatentSync: herramienta de código abierto para generar vídeo con sincronización labial directamente a partir de audio

Últimos recursos sobre IAActualizado hace 9 meses Círculo de intercambio de inteligencia artificial 126K 00

Introducción general

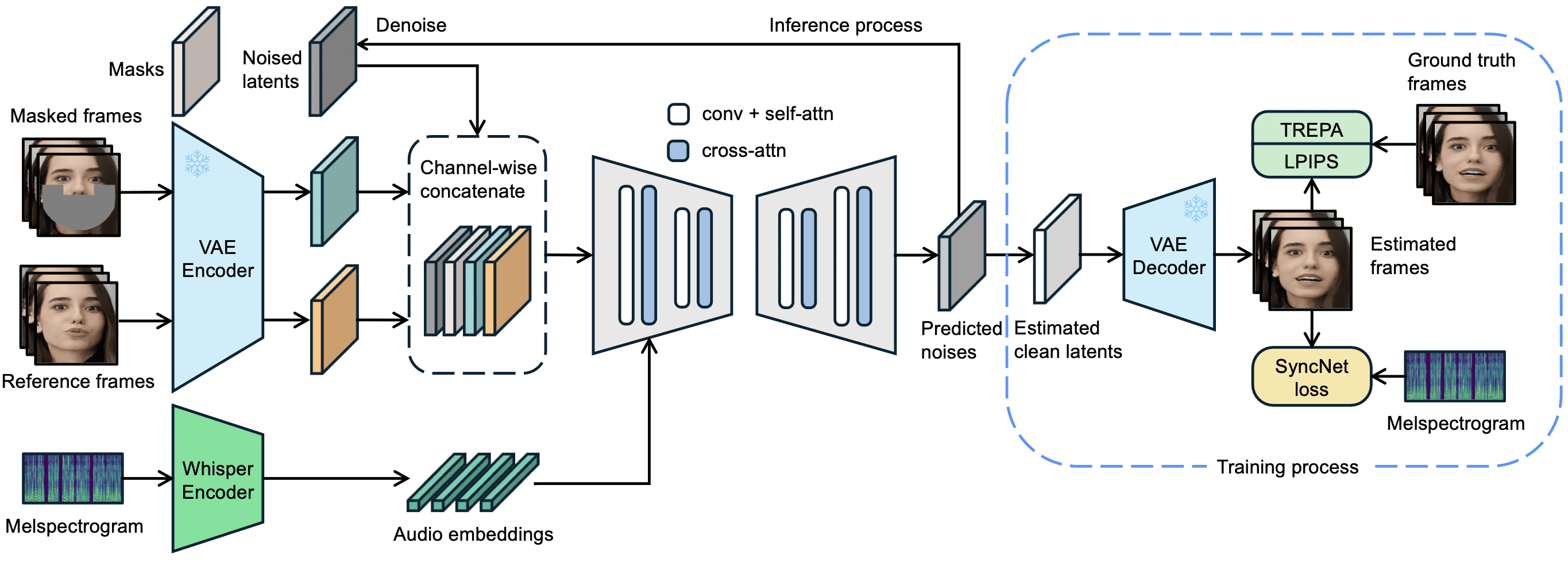

LatentSync es una herramienta de código abierto desarrollada por ByteDance y alojada en GitHub. Impulsa los movimientos labiales de los personajes en el vídeo directamente a través del audio, de modo que la forma de la boca coincide con precisión con la voz. El proyecto se basa en el modelo de difusión latente de Stable Diffusion, combinado con la tecnología Susurro Las características de audio se extraen para generar fotogramas de vídeo a través de la red U-Net. la versión 1.5 de latentSync, publicada el 14 de marzo de 2025, optimiza la coherencia temporal, la compatibilidad con vídeo en chino y reduce los requisitos de memoria de vídeo de entrenamiento a 20 GB. los usuarios pueden ejecutar el código de inferencia para generar vídeo sincronizado con los labios con una resolución de 256x256 simplemente disponiendo de una tarjeta gráfica que admita 6,8 GB de memoria de vídeo. vídeos en resolución 256x256. La herramienta es totalmente gratuita, con código y modelos preentrenados, y es adecuada tanto para entusiastas de la tecnología como para desarrolladores.

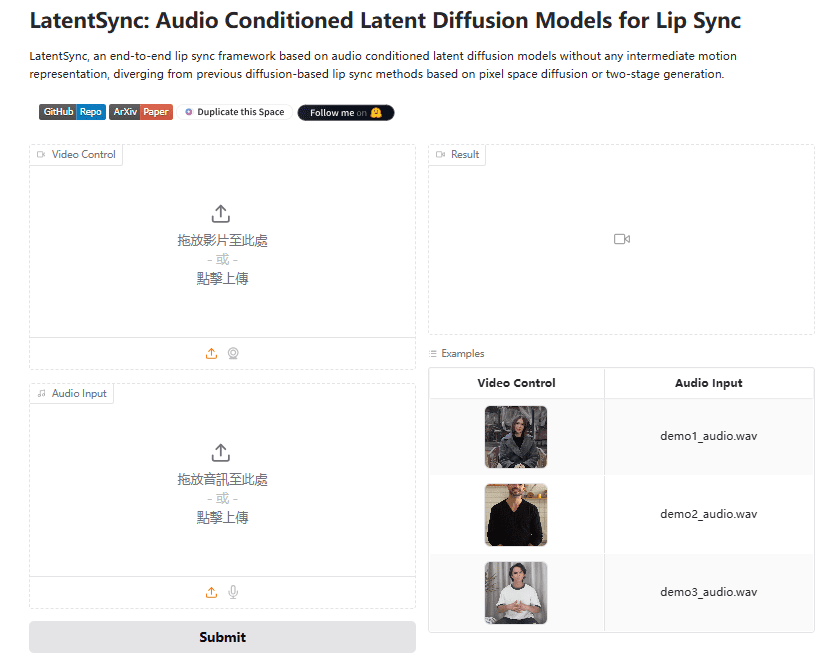

Experiencia: https://huggingface.co/spaces/fffiloni/LatentSync

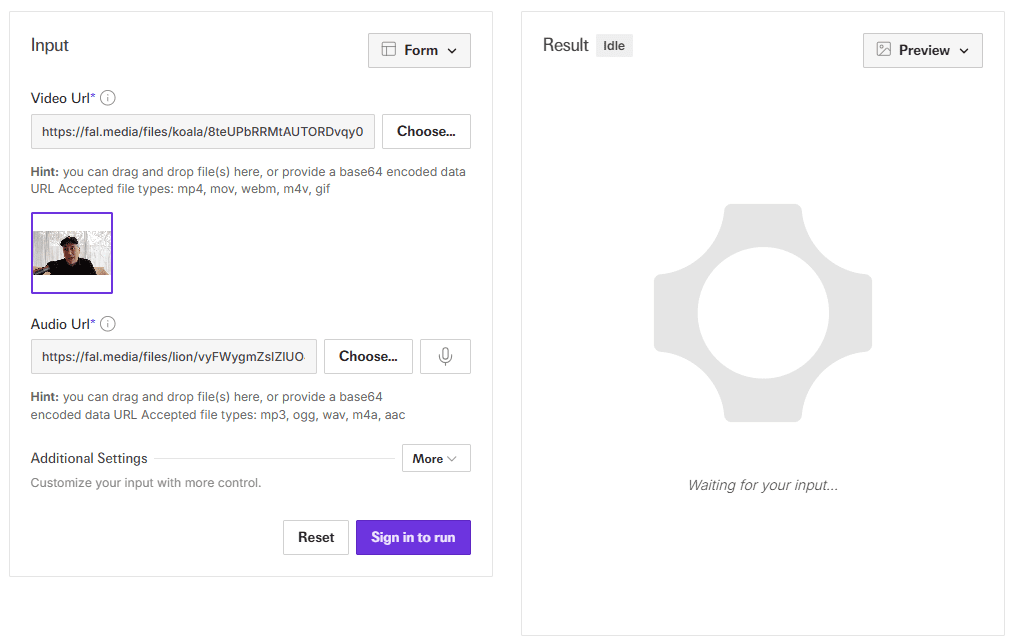

Dirección de la API de demostración: https://fal.ai/models/fal-ai/latentsync

Lista de funciones

- Sincronización labial del controlador de audioEntrada de audio y vídeo para generar automáticamente movimientos de los labios que coincidan con el sonido.

- Generación de vídeo de extremo a extremo: Sin necesidad de representación intermedia, salida directa de vídeo nítido sincronizado con los labios.

- Optimización de la coherencia temporal: Reduce los saltos de imagen gracias a la tecnología TREPA y a las capas de temporización.

- Soporte de vídeo chino: La versión 1.5 mejora el tratamiento del audio y el vídeo chinos.

- Apoyo eficaz a la formaciónU-Net está disponible en diversas configuraciones, con requisitos de memoria tan bajos como 20 GB.

- Proceso de datosHerramientas integradas para limpiar los datos de vídeo y garantizar la calidad de la generación.

- parametrizaciónSoporte para ajustar los pasos de inferencia y las escalas de guiado para optimizar la generación.

Utilizar la ayuda

LatentSync es una herramienta de ejecución local para usuarios con una base técnica. A continuación se describe detalladamente el proceso de instalación, razonamiento y formación.

Proceso de instalación

- Requisitos de hardware y software

- Requiere una tarjeta gráfica NVIDIA con al menos 6,8 GB de memoria de vídeo (para inferencia), se recomiendan 20 GB o más para entrenamiento (por ejemplo, RTX 3090).

- Compatible con Linux o Windows (Windows requiere un ajuste manual del script).

- Instale Python 3.10, Git y PyTorch con soporte CUDA.

- Descargar código

Se ejecuta en el terminal:

git clone https://github.com/bytedance/LatentSync.git

cd LatentSync

- Instalación de dependencias

Ejecute el siguiente comando para instalar las bibliotecas necesarias:

pip install -r requirements.txt

Instalación adicional de ffmpeg para el procesamiento de audio y vídeo:

sudo apt-get install ffmpeg # Linux

- Descargar modelos

- a través de (un hueco) Cara de abrazo descargando

latentsync_unet.ptresponder cantandotiny.pt. - Coloque el archivo en la carpeta

checkpoints/con la siguiente estructura:checkpoints/ ├── latentsync_unet.pt ├── whisper/ │ └── tiny.pt - Si entrena SyncNet, también tendrá que descargar

stable_syncnet.pty otros modelos auxiliares.

- Entorno de verificación

Ejecute el comando de prueba:

python gradio_app.py --help

Si no se informa de ningún error, el entorno se ha creado correctamente.

proceso de inferencia

LatentSync ofrece dos métodos de inferencia, ambos con un requisito de memoria de vídeo de 6,8 GB.

Método 1: Interfaz de Gradio

- Inicie la aplicación Gradio:

python gradio_app.py

- Abra su navegador y visite la dirección local indicada.

- Cargue los archivos de vídeo y audio, haga clic en Ejecutar y espere a que se generen los resultados.

Método 2: Línea de comandos

- Prepare el archivo de entrada:

- Vídeo (por ejemplo

input.mp4), deben contener caras claras. - Audio (por ejemplo

audio.wav), se recomiendan 16000Hz.

- Ejecute el script de razonamiento:

python -m scripts.inference

--unet_config_path "configs/unet/stage2_efficient.yaml"

--inference_ckpt_path "checkpoints/latentsync_unet.pt"

--inference_steps 25

--guidance_scale 2.0

--video_path "input.mp4"

--audio_path "audio.wav"

--video_out_path "output.mp4"

inference_steps: 20-50, cuanto mayor sea el valor, mayor será la calidad y menor la velocidad.guidance_scale: 1,0-3,0, cuanto más alto sea el valor más precisa será la forma del labio, puede haber una ligera distorsión.

- sonda

output.mp4Se confirma el efecto de la sincronización labial.

Preprocesamiento de entradas

- Se recomienda ajustar la frecuencia de imagen de vídeo a 25 FPS:

ffmpeg -i input.mp4 -r 25 resized.mp4

- La frecuencia de muestreo de audio debe ser de 16000 Hz:

ffmpeg -i audio.mp3 -ar 16000 audio.wav

Flujo de procesamiento de datos

Si hay que entrenar el modelo, primero hay que procesar los datos:

- Ejecuta el script:

./data_processing_pipeline.sh

- modificaciones

input_dirpara su catálogo de vídeos. - El proceso incluye:

- Elimina el vídeo dañado.

- Ajusta el vídeo a 25 FPS y el audio a 16000Hz.

- Divide la escena usando PySceneDetect.

- Corta el vídeo en segmentos de 5-10 segundos.

- Detectar caras con alineación de caras y redimensionar a 256x256.

- Filtra los vídeos con una puntuación de sincronización inferior a 3.

- Calcular la puntuación hyperIQA y eliminar los vídeos por debajo de 40.

- El vídeo procesado se guarda en la carpeta

high_visual_quality/Catálogo.

Formación U-Net

- Prepare los datos y todos los puntos de control.

- Seleccione el perfil (por ejemplo

stage2_efficient.yaml). - Entrenamiento de carrera:

./train_unet.sh

- Modifique la ruta de datos y la ruta de guardado en el archivo de configuración.

- Requisitos de memoria gráfica:

stage1.yaml: 23GB.stage2.yaml: 30GB.stage2_efficient.yaml20 GB para tarjetas gráficas normales.

advertencia

- Los usuarios de Windows deben configurar el

.shCambia a la ejecución de comandos Python. - Si la pantalla salta, aumente

inference_stepso ajustar la velocidad de fotogramas del vídeo. - La compatibilidad con audio chino se ha optimizado en la versión 1.5 para garantizar el uso de los modelos más recientes.

Con estos pasos, los usuarios pueden instalar y utilizar fácilmente LatentSync para generar vídeos de sincronización labial o seguir entrenando el modelo.

escenario de aplicación

- postproducción

Reemplace el audio de los vídeos existentes para generar nuevos labios adecuados para los ajustes de doblaje. - imagen virtual

Introduce audio para generar vídeos de avatares hablando para vídeos en directo o cortos. - producción de juegos

Añade animaciones dinámicas de diálogo a los personajes para mejorar la experiencia de juego. - multilingüismo

Genere vídeos instructivos con audio en diferentes idiomas, adaptados para usuarios de todo el mundo.

CONTROL DE CALIDAD

- ¿Admite la generación en tiempo real?

No es compatible. La versión actual requiere audio y vídeo completos y tarda entre segundos y minutos en generarse. - ¿Cuál es la memoria de vídeo mínima?

El razonamiento requiere 6,8 GB y el entrenamiento recomienda 20 GB (tras la optimización de la versión 1.5). - ¿Puedes con los vídeos de anime?

Can. Los ejemplos oficiales incluyen vídeos de anime que funcionan bien. - ¿Cómo mejorar el apoyo lingüístico en chino?

Utiliza la versión 1.5 de LatentSync, optimizada para el procesamiento de audio chino.

Instalador de LatentSync con un solo clic

Quark: https://pan.quark.cn/s/c3b482dcca83

Instalador independiente WIN/MAC

Quark: https://pan.quark.cn/s/90d2784bc502

Baidu: https://pan.baidu.com/s/1HwN1k6v-975uLfI0d8N_zQ?pwd=gewd

LatentSync Mejorado:https://pan.quark.cn/s/f8d3d9872abb

LatentSync 1.5 Despliegue local 1: https://pan.baidu.com/s/1QLqoXHxGbAXV3dWOC5M5zg?pwd=ijtt

LatentSync 1.5 Despliegue local 2: https://pan.baidu.com/share/init?surl=zIUPiJc0qZaMp2NMYNoAug&pwd=8520

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...