Replicando DeepSeek-R1: 8K ejemplos matemáticos ayudan a pequeños modelos a lograr avances en inferencia mediante aprendizaje por refuerzo

Github. https://github.com/hkust-nlp/simpleRL-reason

introducción

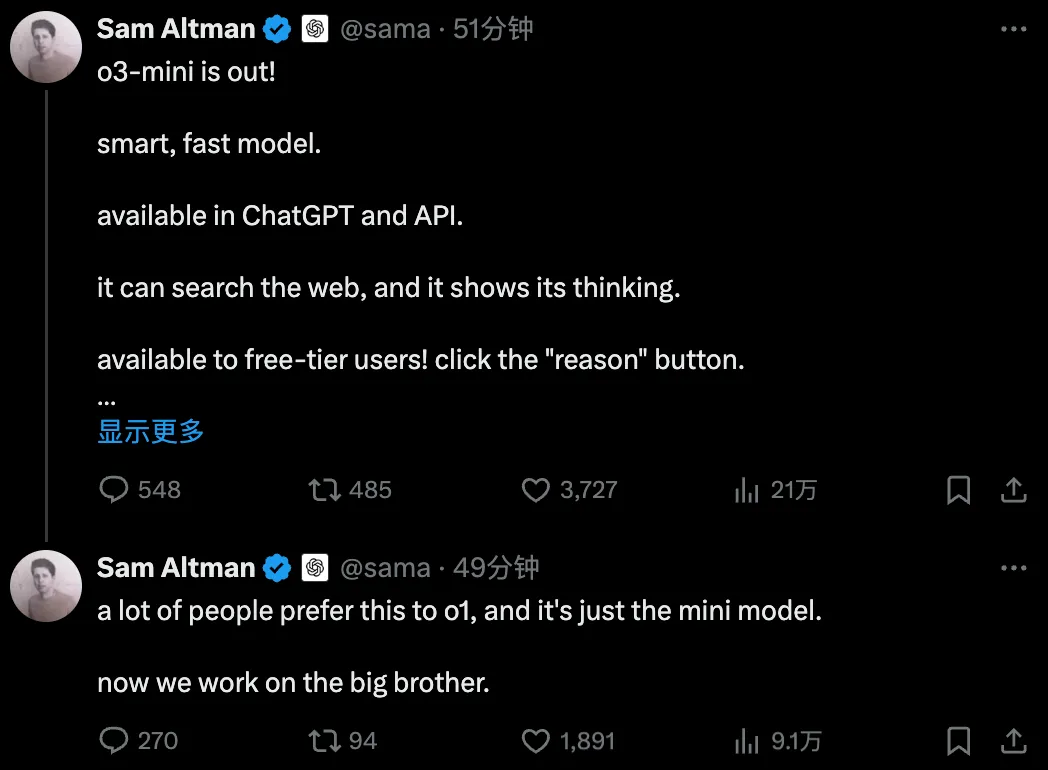

Variaciones dinámicas del entrenamiento Qwen2.5-SimpleRL-Zero partiendo del modelo base Qwen2.5-Math-7B, sin realizar SFT ni utilizar el modelo de recompensa. La precisión y la longitud medias de los puntos de referencia se basan en 8 puntos de referencia de razonamiento matemático complejo. Observamos una reducción de la longitud durante la fase inicial, ya que descubrimos que el modelo base Qwen2.5-Math-7B tiende a generar tanto lenguaje como código en la respuesta, lo que da como resultado una salida larga. Este patrón predeterminado se suprimió rápidamente durante la RL, en la que el modelo aprendió a emitir en un formato más apropiado, y entonces la longitud comenzó a aumentar con regularidad. Después de unos pocos pasos de entrenamiento, también experimentamos lo que el documento DeepSeek-R1 describe como un "momento epifánico", una autorreflexión en la respuesta del modelo.

Muchos investigadores están explorando posibles vías para el aprendizaje de modelos de tipo o, como la destilación, el MCTS, los modelos de recompensa basados en procesos y el aprendizaje por refuerzo. Recientemente.DeepSeek-R1responder cantandoKimi-k1.5En el camino hacia este objetivo demostraron una receta extremadamente sencilla para utilizar un algoritmo de RL simple para aprender patrones emergentes de pensamiento encadenado prolongado (CoT) y autorreflexión con resultados sólidos, sin utilizar MCTS ni modelos de recompensa. Sin embargo, sus experimentos se basaron en modelos enormes en una configuración de RL a gran escala. No está claro si modelos más pequeños podrían mostrar un comportamiento similar, cuántos datos se necesitarían y cómo se compararían los resultados cuantitativos con otros métodos. Este blog replica el entrenamiento de DeepSeek-R1-Zero y DeepSeek-R1 en razonamiento matemático complejo, comenzando con Qwen-2.5-Math-7B (el modelo base) y utilizando sólo 8K (consulta, respuesta final) ejemplos del conjunto de datos MATH original para RL con modelado de recompensa basado en reglas. MATH puede mejorar tanto el modelo base 7B sin necesidad de otras señales externas:

Todos los resultados son correctos

| AIME 2024 | MATEMÁTICAS 500 | AMC | Minerva Matemáticas | OlimpiadaBench | Avg. | |

|---|---|---|---|---|---|---|

| Qwen2.5-Math-7B-Base | 16.7 | 52.4 | 52.5 | 12.9 | 16.4 | 30.2 |

| Qwen2.5-Math-7B-Base + 8K MATH SFT | 3.3 | 54.6 | 22.5 | 32.7 | 19.6 | 26.5 |

| Qwen-2.5-Matemáticas-7B-Instrucción | 13.3 | 79.8 | 50.6 | 34.6 | 40.7 | 43.8 |

| Llama-3.1-70B-Instruct | 16.7 | 64.6 | 30.1 | 35.3 | 31.9 | 35.7 |

| rStar-Math-7B | 26.7 | 78.4 | 47.5 | - | 47.1 | - |

| Eurus-2-7B-PRIME | 26.7 | 79.2 | 57.8 | 38.6 | 42.1 | 48.9 |

| Qwen2.5-7B-SimpleRL-Cero | 33.3 | 77.2 | 62.5 | 33.5 | 37.6 | 48.8 |

| Qwen2.5-7B-SimpleRL | 26.7 | 82.4 | 62.5 | 39.7 | 43.3 | 50.9 |

Qwen2.5-7B-SimpleRL-Zero es un entrenamiento RL simple directamente desde el modelo base, utilizando sólo 8K ejemplos MATH. Consigue casi 20 puntos absolutos de crecimiento de media en comparación con el modelo base. Comparado con Qwen2.5-Math-7B-Base, que utiliza los mismos 8K datos SFT, RL disfruta de una mejor capacidad de generalización, que es 22% superior en términos absolutos.Además, Qwen2.5-7B-SimpleRL-Zero supera a Qwen-2.5-Math-7B-Instruct de media, y se compara favorablemente con el recientemente publicadoEurus-2-7B-PRIMEresponder cantandorStar-Math-7B(También se basan en Qwen-2.5-Math-7B) son aproximadamente equivalentes. Estas líneas de base contienen componentes más complejos, como modelos de recompensa, y utilizan al menos 50 veces más datos avanzados:

Datos comparativos de los distintos métodos

| Qwen2.5-Matemáticas-7B-Instrucción | rStar-Math-7B | Eurus-2-7B-PRIME | Qwen2.5-7B-SimpleRL-Cero | |

|---|---|---|---|---|

| Modelo base | Qwen2.5-Matemáticas-7B | Qwen2.5-Matemáticas-7B | Qwen2.5-Matemáticas-7B | Qwen2.5-Matemáticas-7B |

| Datos SFT | 2,5 millones (código abierto e interno) | ~7.3 M (MATH, NuminaMath, etc.) | 230K | 0 |

| Datos RM | 618K (interno) | ~7 k (en casa) | 0 | 0 |

| RM | Qwen2.5-Math-RM (72B) | Ninguno | Eurus-2-7B-SFT | Ninguno |

| Datos RL | 66K consultas × 32 muestras | ~3.647 M × 16 | 150.000 consultas × 4 muestras | 8K consultas × 8 muestras |

Estamos entusiasmados y sorprendidos por el importante crecimiento conseguido con sólo 8.000 ejemplos de MATH. En particular, **aunque las consultas MATH son mucho más fáciles de realizar que muchos puntos de referencia difíciles como AIME y AMC, esta sencilla formulación RL demuestra un poder de generalización significativo, mejorando el rendimiento en al menos 10 puntos absolutos en comparación con el modelo base. **Este efecto de generalización fácil de seguir es algo que no podríamos haber previsto realizando un entrenamiento SFT estándar en el mismo conjunto de datos. Hemos puesto a disposición de la comunidad el código de entrenamiento y los detalles con la esperanza de que sirva de base para seguir explorando el potencial de la RL para la inferencia.

A continuación, nos sumergiremos en los detalles de nuestra configuración y en lo que ocurre durante este proceso de entrenamiento de RL, como el largo CoT y la aparición de patrones autorreflexivos.

Receta sencilla de RL

Al igual que DeepSeek R1, nuestra formulación RL es muy sencilla y no utiliza modelos de recompensa ni técnicas similares a MCTS. Utilizamos el algoritmo PPO con una función de recompensa basada en reglas que asigna recompensas en función del formato y la corrección de las respuestas generadas:

- Si la respuesta proporciona la respuesta final en el formato especificado y es correcta, se concede una bonificación de +1.

- Si la respuesta proporciona la respuesta final pero es incorrecta, la recompensa se fija en -0,5.

- Si la respuesta no proporciona una respuesta definitiva, la recompensa se establece en -1.

La aplicación se basa enOpenRLHF. Nuestros experimentos preliminares muestran que esta función de recompensa ayuda al modelo de estrategia a converger rápidamente para generar respuestas en el formato deseado.

Montaje experimental

En nuestros experimentos, aprendimos delQwen2.5-Math-7B-BaseLos modelos se iniciaron y evaluaron en puntos de referencia de razonamiento matemático desafiantes, incluyendo AIME2024, AMC23, GSM8K, MATH-500, Minerva Math y OlympiadBench.El entrenamiento se realizó utilizando aproximadamente 8.000 consultas del conjunto de datos de entrenamiento MATH en los niveles de dificultad 3-5. Realizamos experimentos con las dos configuraciones siguientes según DeepSeek-R1-Zero y DeepSeek-R1, respectivamente:

- SimpleRL-CeroUtilizamos sólo 8K pares MATH (consulta, respuesta).

- SimpleRLLos datos de SFT son 8.000 consultas MATH con respuestas extraídas de QwQ-32B-Preview. A continuación, utilizamos los mismos 8K ejemplos MATH para nuestra formulación RL.

Parte I: SimpleRL-Zero - Aprendizaje intensivo desde cero

En la sección de introducción hemos informado de los principales resultados de SimpleRL-Zero, que supera a Qwen2.5-Math-7B-Instruct y logra resultados comparables con PRIME y rStar-Math, a pesar de que sólo utiliza 8K ejemplos de MATH. A continuación compartimos la dinámica de entrenamiento y algunos patrones emergentes interesantes.

Dinámica de formación

Incentivos a la formación y duración de la respuesta

Evaluación de la precisión (pass@1) y la longitud de la respuesta en 8 puntos de referencia

Como se muestra en la figura anterior, la precisión en todas las pruebas de referencia aumenta de forma constante durante el entrenamiento, mientras que la longitud primero disminuye y luego aumenta gradualmente. Tras una investigación más profunda, descubrimos que el modelo base Qwen2.5-Math-7B tiende a generar una gran cantidad de código al principio, lo que puede deberse a la distribución original de los datos de entrenamiento del modelo. Descubrimos que la longitud disminuye primero porque el entrenamiento RL elimina gradualmente este patrón y aprende a razonar en lenguaje ordinario. Después de esto, la longitud de generación empieza a aumentar de nuevo y el patrón autorreflexivo empieza a emerger, como se muestra en el siguiente ejemplo.

La aparición de la autorreflexión

Aproximadamente en el paso 40, observamos que el modelo empieza a generar patrones autorreflexivos, los "momentos epifánicos" del documento DeepSeek-R1. A continuación mostramos un ejemplo.

Parte II: SimpleRL - Aprendizaje intensivo con ejercicios imitativos de calentamiento

Como se ha mencionado anteriormente, hemos calentado con un SFT de pensamiento en cadena prolongado antes de proceder a la RL; el conjunto de datos SFT eran 8K ejemplos MATH con respuestas destiladas de QwQ-32B-Preview. El beneficio potencial de este arranque en frío es que el modelo parte de un modo de pensamiento en cadena prolongado y ya es autorreflexivo, por lo que puede aprender más rápido y mejor durante la fase de RL.

Principales resultados

| AIME 2024 | MATEMÁTICAS 500 | AMC | Minerva Matemáticas | OlimpiadaBench | Avg. | |

|---|---|---|---|---|---|---|

| Qwen2.5-Math-7B-Base | 16.7 | 52.4 | 52.5 | 12.9 | 16.4 | 30.2 |

| Qwen2.5-Math-7B-Base + 8K QwQ destilación | 16.7 | 76.6 | 55.0 | 34.9 | 36.9 | 44.0 |

| Eurus-2-7B-PRIME | 26.7 | 79.2 | 57.8 | 38.6 | 42.1 | 48.9 |

| Qwen2.5-7B-SimpleRL-Cero | 36.7 | 77.4 | 62.5 | 34.2 | 37.5 | 49.7 |

| Qwen2.5-7B-SimpleRL | 26.7 | 82.4 | 62.5 | 39.7 | 43.3 | 50.9 |

En comparación con Qwen2.5-Math-7B-Base + 8K QwQ distillation, el modelo mejoró Qwen2.5-7B-SimpleRL en una media de 6,91 TP3T en términos absolutos antes del entrenamiento RL. Además, Qwen2.5-7B-SimpleRL supera a Eurus-2-7B-PRIME en 3 de las 5 pruebas de referencia y supera a Qwen2.5-7B-SimpleRL-Zero.Aunque los resultados son buenos, nos sorprende un poco que la fase de destilación QwQ no produjera mayores ganancias que la configuración cero, dado que QwQ es un 32B potente modelo de profesor de pensamiento de cadena larga.

Dinámica de formación

Incentivos a la formación y duración de la respuesta

estado de formación

Evaluación de la precisión (pass@1) y la longitud de la respuesta en 8 puntos de referencia

La dinámica de entrenamiento de Qwen2.5-SimpleRL es similar a la de Qwen2.5-SimpleRL-Zero. Curiosamente, seguimos observando una reducción de la longitud al principio de RL, a pesar de nuestro SFT avanzado de pensamiento en cadena de larga duración. Sospechamos que esto se debe a que el patrón de inferencia QwQ destilado no es preferido por los modelos de estrategia pequeña o supera su capacidad. Como resultado, aprende a abandonarlo y desarrolla un nuevo razonamiento largo por su cuenta.

observaciones finales

La sencillez es la máxima complejidad.

- Leonardo da Vinci (1452-1519), pintor renacentista italiano

Agradecimientos y citas

El algoritmo de aprendizaje por refuerzo que aplicamos se basa enOpenRLHFAmpliado de. Utilizamos elvLLMRealiza inferencias y desarrolla una metodología basada en laQwen2.5-Matemáticasde los scripts de evaluación. En particular, agradecemos a los desarrolladores de DeepSeek-R1 y Kimi-k1.5 sus innovaciones y contribuciones a la comunidad de código abierto.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...