DeepSeek publica la primera versión de código abierto de su modelo v3, ahora con la mayor capacidad de código (en China)

DeepSeek-V3 es un potente modelo lingüístico de Mezcla de Expertos (MoE) con 671.000 millones de parámetros totales y 3.700 millones de parámetros activados para cada token. El modelo emplea una innovadora arquitectura de atención latente multicabezal (MLA) junto con la arquitectura DeepSeekMoE de eficacia probada.CogAgent implementa una estrategia de equilibrio de carga sin pérdida auxiliar y propone un objetivo de entrenamiento de predicción multi-token para mejorar significativamente el rendimiento del modelo. Está preentrenado con 14,8 millones de tokens diversos y de alta calidad y se somete a fases supervisadas de ajuste fino y aprendizaje de refuerzo para explotar todo su potencial.

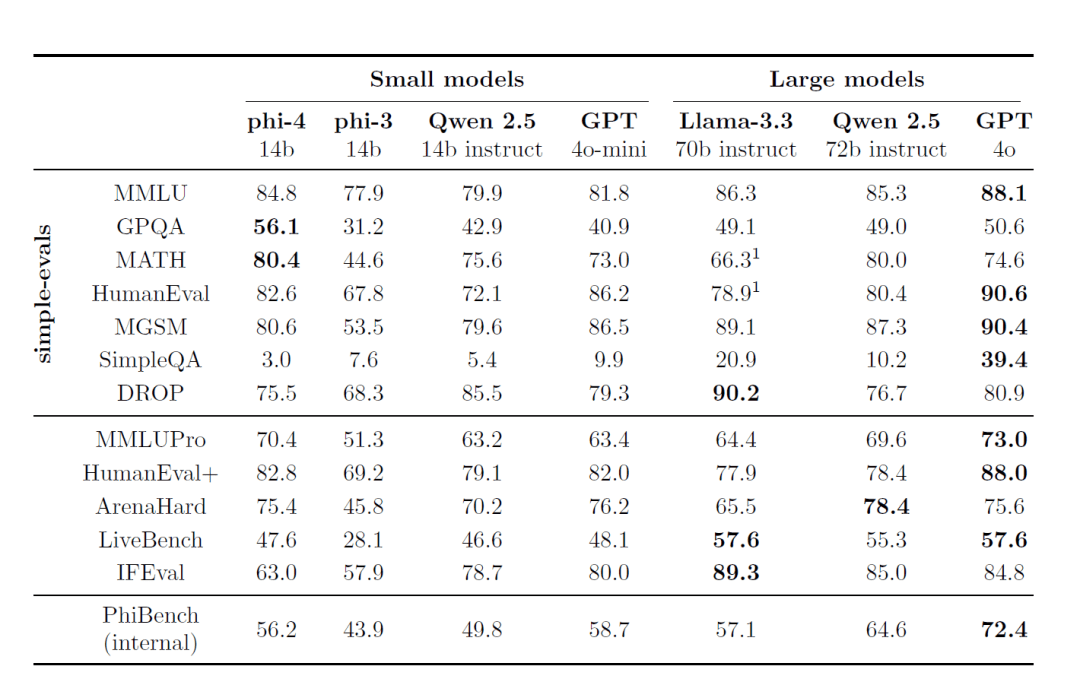

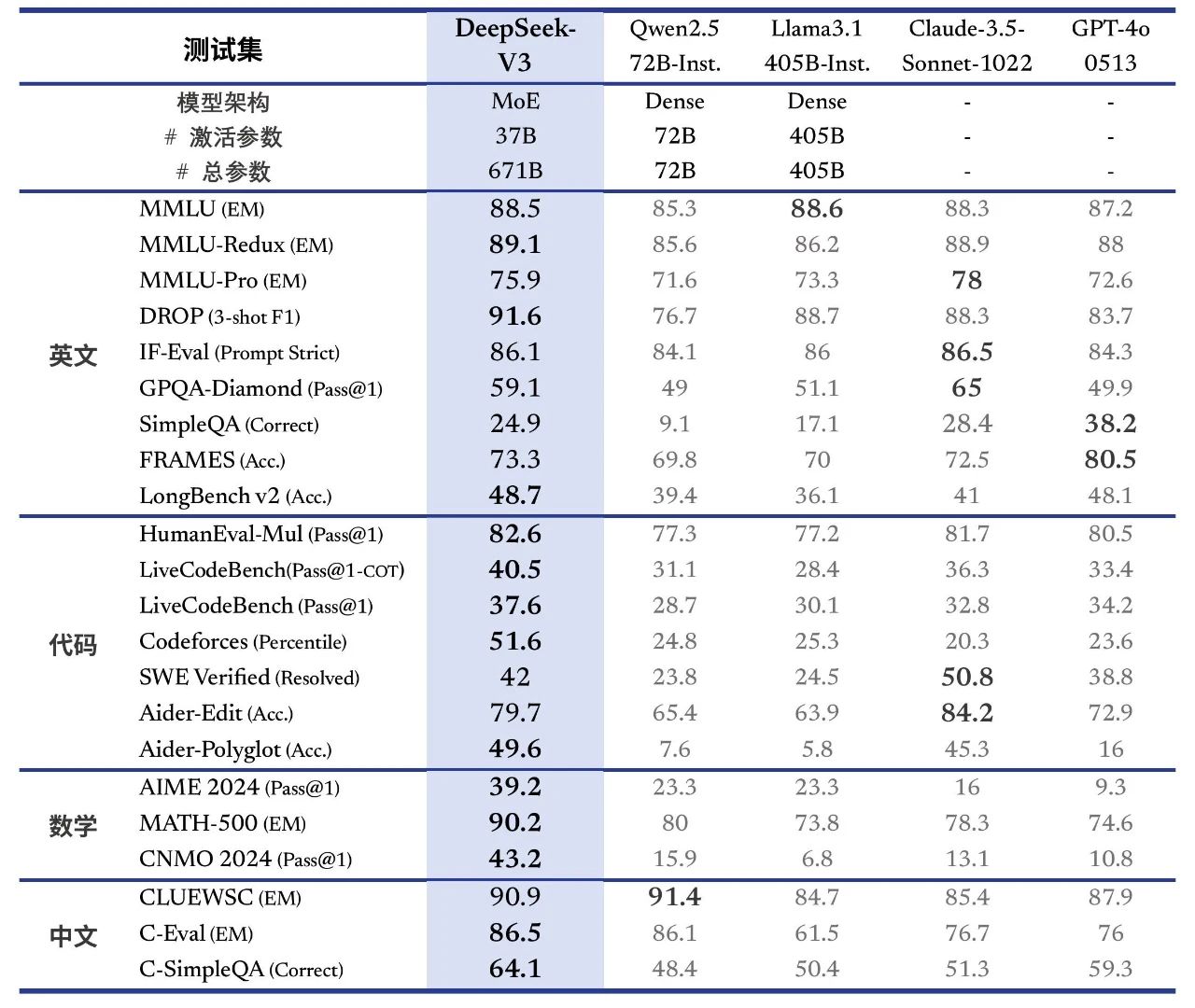

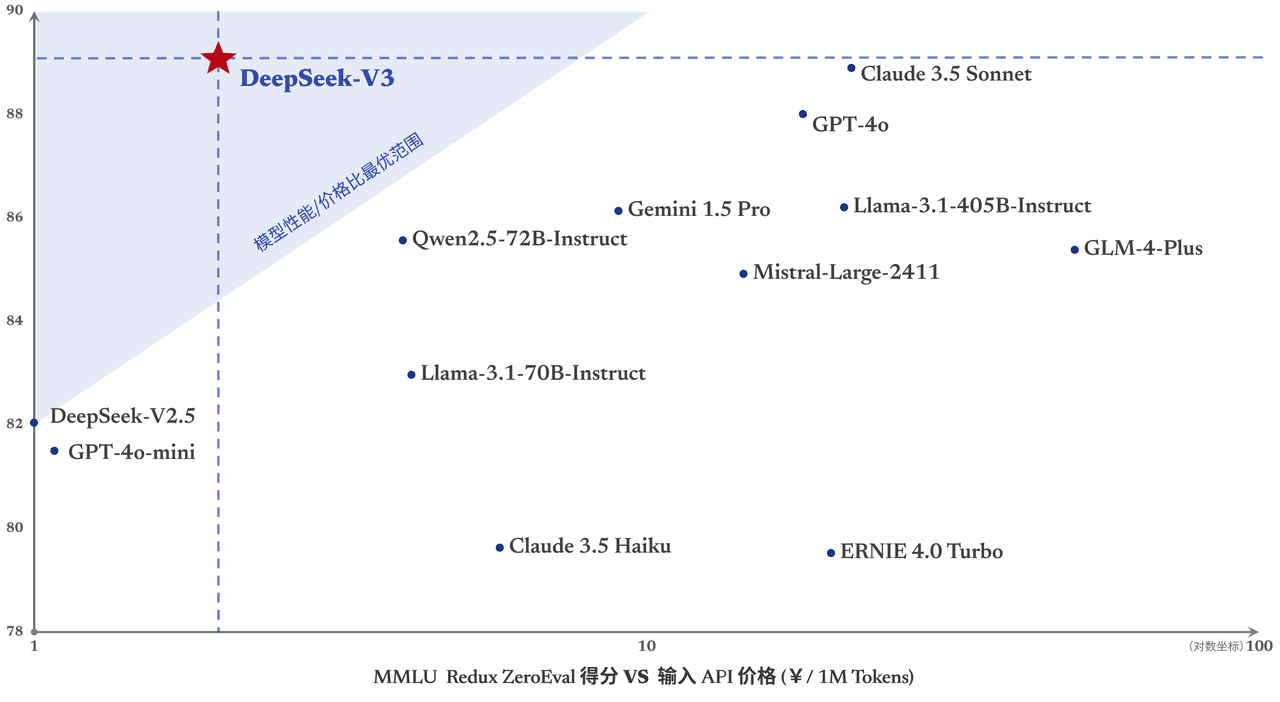

DeepSeek-V3 obtiene buenos resultados en muchas pruebas de referencia estándar, especialmente en tareas matemáticas y de código, lo que lo convierte en el modelo base de código abierto más potente disponible en la actualidad, con bajos costes de formación, y su estabilidad a lo largo de la formación es altamente reconocida.

Ayer, la primera versión de la nueva serie de modelos de DeepSeek, DeepSeek-V3, fue lanzada y open-sourced al mismo tiempo. Puede chatear con la última versión del modelo V3 accediendo a chat.deepseek.com. El servicio API se ha actualizado simultáneamente, por lo que no es necesario cambiar la configuración de la interfaz. La versión actual de DeepSeek-V3 no admite entrada y salida multimodal.

Alineación de resultados Líder en el extranjero Modelos de fuente cerrada

DeepSeek-V3 es un modelo MoE de creación propia con 671B parámetros y 37B activaciones a 14,8T ficha La formación previa se llevó a cabo en el

Enlace a la ponencia:

https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf

DeepSeek-V3 supera a otros modelos de código abierto como Qwen2.5-72B y Llama-3.1-405B en varias revisiones, e iguala el rendimiento de los mejores modelos de código cerrado del mundo GPT-4o y Claude-3.5-Sonnet.

- conocimiento enciclopédicoEl nivel de DeepSeek-V3 en tareas basadas en el conocimiento (MMLU, MMLU-Pro, GPQA, SimpleQA) ha mejorado significativamente en comparación con su predecesor, DeepSeek-V2.5, y se acerca al modelo actual con mejor rendimiento, Claude-3.5-Sonnet-1022.

- texto largoEn promedio, DeepSeek-V3 supera a los otros modelos en DROP, FRAMES y LongBench v2 en las medidas de texto largo.

- codificación::DeepSeek-V3 está muy por delante de todos los modelos no-o1 disponibles en el mercado en cuanto a fuerzas de código algorítmico.y se aproxima a Claude-3.5-Sonnet-1022 en el escenario de código de clase de ingeniería (SWE-Bench Verified).

- matemáticasDeepSeek-V3 superó ampliamente a todos los modelos de código abierto y código cerrado en la Competición Americana de Matemáticas (AIME 2024, MATH) y en la Liga Nacional de Matemáticas de Secundaria (CNMO 2024).

- Conocimientos de chinoDeepSeek-V3 se comporta de forma similar a Qwen2.5-72B en los conjuntos de evaluación C-Eval y Desambiguación de pronombres en Educación, pero es más avanzado en C-SimpleQA en Conocimiento de hechos.

Generación hasta 3 veces más rápida

A través de innovaciones algorítmicas y de ingeniería, DeepSeek-V3 aumenta drásticamente la velocidad de generación de palabras de 20 TPS a 60 TPS, un aumento de 3 veces en comparación con el modelo V2.5, ofreciendo a los usuarios una experiencia más rápida y fluida.

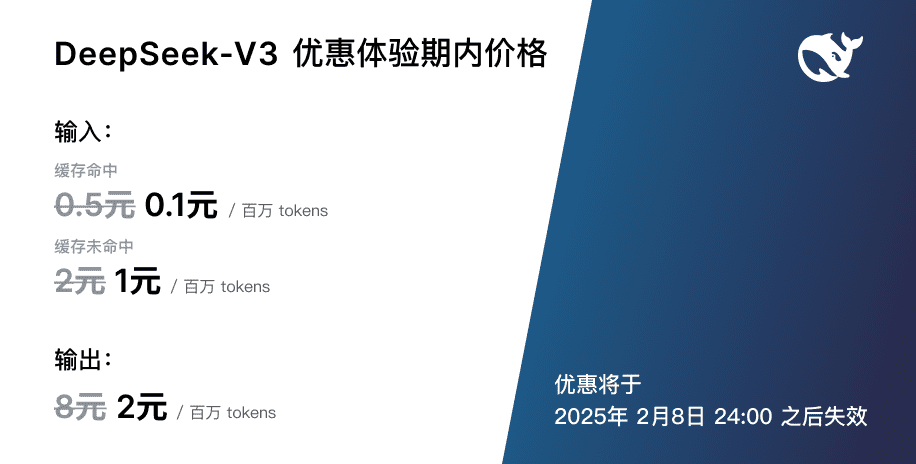

Ajuste del precio del servicio API

Con la puesta en marcha de la actualización de DeepSeek-V3, más potente y rápida, el precio de nuestro servicio de API de modelos también se ajustará a0,5 por millón de tokens de entrada (aciertos de caché) / 2 (fallos de caché), 8 por millón de tokens de salidaPara poder ofrecer continuamente mejores servicios de modelización a todos.  Al mismo tiempo, hemos decidido dar al nuevo modelo una pausa de 45 días en el precio: desde ahora hasta el 8 de febrero de 2025, el precio de los servicios API de DeepSeek-V3 seguirá siendo el ya conocido0,1 por millón de tokens de entrada (aciertos de caché) / 1 $ (fallos de caché), 2 $ por millón de tokens de salidaEstas tarifas reducidas están disponibles tanto para los usuarios actuales como para los nuevos que se registren durante este periodo.

Al mismo tiempo, hemos decidido dar al nuevo modelo una pausa de 45 días en el precio: desde ahora hasta el 8 de febrero de 2025, el precio de los servicios API de DeepSeek-V3 seguirá siendo el ya conocido0,1 por millón de tokens de entrada (aciertos de caché) / 1 $ (fallos de caché), 2 $ por millón de tokens de salidaEstas tarifas reducidas están disponibles tanto para los usuarios actuales como para los nuevos que se registren durante este periodo.

Pesos de código abierto e implantación local

DeepSeek-V3 utiliza entrenamiento FP8 y pesos FP8 nativos de código abierto. Gracias al apoyo de la comunidad de código abierto, SGLang y LMDeploy soportan por primera vez la inferencia nativa FP8 del modelo V3, mientras que TensorRT-LLM y MindIE implementan la inferencia BF16. Además, proporcionamos scripts de conversión de FP8 a BF16 para la comodidad de la comunidad para adaptar y ampliar los escenarios de aplicación.

La descarga de los pesos del modelo y más información sobre el despliegue local pueden encontrarse en:

https://huggingface.co/deepseek-ai/DeepSeek-V3-Base

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...