2025 Perspectivas de aterrizaje de agentes de IA: un análisis de los tres elementos de planificación, interacción y memoria

Los agentes de IA se están convirtiendo en un cambio de paradigma muy esperado en el espacio tecnológico de la IA, en rápida evolución. AI Share, una organización líder en análisis de tecnología de IA, ha analizado recientemente la tendencia de los agentes de IA y ha hecho referencia a una serie de artículos en profundidad publicados por el equipo de Langchain para ayudar a los lectores a comprender mejor el futuro de los agentes.

Este artículo integra las principales conclusiones del informe State of AI Agent publicado por Langchain, en el que se encuestó a más de 1.300 profesionales del sector, entre desarrolladores, jefes de producto, ejecutivos corporativos y otras funciones. Las conclusiones revelan el estado actual del desarrollo de Agentes de IA y los cuellos de botella en 2024: Aunque el 90% de las empresas están planificando y aplicando activamente Agentes de IA, los usuarios sólo pueden desplegar Agentes en procesos y escenarios de aplicación específicos debido a las limitaciones de sus capacidades actuales. La gente está más preocupada por mejorar las capacidades de los Agentes y la observabilidad y fiabilidad de sus comportamientos, que por factores como el coste y la latencia. La observabilidad y controlabilidad del comportamiento de los Agentes es más importante que el coste y la latencia.

Además, este artículo recopila un análisis en profundidad de los elementos clave del Agente de IA de la serie In the Loop del sitio web oficial de LangChain, centrándose en el Planificación, innovación interactiva UI/UX y Memoria. Estos tres elementos centrales. El artículo analiza en profundidad cinco patrones de interacción de productos nativos basados en los Grandes Modelos de Lenguaje (LLM) y analogiza tres complejos mecanismos de memoria de los seres humanos, con el objetivo de proporcionar ideas útiles para que los lectores comprendan la naturaleza y los elementos clave de los Agentes de IA. Para acercarse más a la práctica industrial, este artículo también incluye el análisis de elementos clave en la sección de Reflexión Se utilizan entrevistas con fundadores de IA y otros ejemplos de primera mano para anticipar los principales avances que pueden llegar a los agentes de IA en 2025.

Basándose en el marco de análisis anterior, AI Share cree que se espera que las aplicaciones del Agente AI experimenten un crecimiento explosivo en 2025 y avancen gradualmente hacia un nuevo paradigma de colaboración entre humanos y ordenadores. En cuanto a la capacidad de planificación del Agente de IA, los modelos emergentes representados por el modelo o3 muestran una gran capacidad de reflexión y razonamiento, lo que indica que el desarrollo de la tecnología de modelos está evolucionando rápidamente desde la fase de Razonador a la de Agente. Con la mejora continua de la capacidad de razonamiento, la posibilidad de que el Agente de IA logre realmente un aterrizaje a gran escala dependerá de la innovación de la interacción del producto y del mecanismo de memoria, lo que también será una oportunidad importante para que las empresas emergentes logren diferenciarse y avanzar. En el plano de la interacción, la industria ha estado esperando una revolución de la interacción persona-ordenador similar al "momento GUI" en la era de la IA; en el plano de la memoria, el Contexto se convertirá en la palabra clave central para el aterrizaje del Agente, ya sea la personalización del Contexto a nivel individual o la unificación del Contexto a nivel empresarial. Context (contexto) se convertirá en la palabra clave central del Agent landing, ya se trate de la personalización a nivel individual o de la unificación a nivel empresarial.

01 State of AI Agent: Estado actual del desarrollo de agentes de IA

Tendencias en la adopción de agentes: todas las empresas planifican activamente la implantación de agentes

La competencia en el sector de los agentes es cada vez mayor. En el último año han surgido muchos marcos de agentes populares. Por ejemplo, el ReAct que combina LLM para razonamiento y acción, orquestación de tareas utilizando el marco Multi-agente, y métodos como el LangGraph Se trata de un marco más manejable.

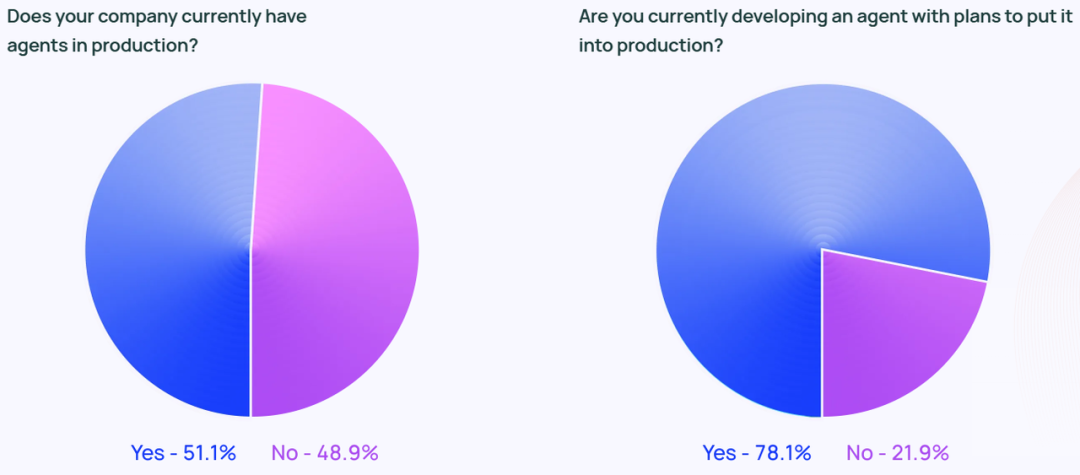

El entusiasmo por los Agentes no se limita a las redes sociales. Según la investigación, aproximadamente 51% de las organizaciones encuestadas ya están utilizando Agentes en sus entornos de producción. La investigación de Langchain también desglosa los datos por tamaño de empresa, mostrando que las empresas medianas con 100-2.000 empleados son las más activas en despliegues de producción de Agentes, con la friolera de 63%.

Además, 78% de los encuestados indicaron que planean desplegar Agentes en sus entornos de producción en un futuro próximo. Esto demuestra claramente que existe un gran interés por los Agentes de IA en todos los sectores, pero ¿cómo construir una verdadera plataforma de Agentes de IA? listo para la producción (para su uso en entornos de producción) Agente, sigue siendo un reto para muchas empresas.

Aunque el sector tecnológico suele considerarse el precursor de la tecnología de Agentes, el interés por los Agentes está creciendo rápidamente en todos los sectores. Entre los encuestados que trabajan en empresas no tecnológicas, 90% de las organizaciones tienen o planean poner Agentes en sus entornos de producción, lo que supone casi el mismo porcentaje que las empresas tecnológicas (89%).

Caso práctico del agente

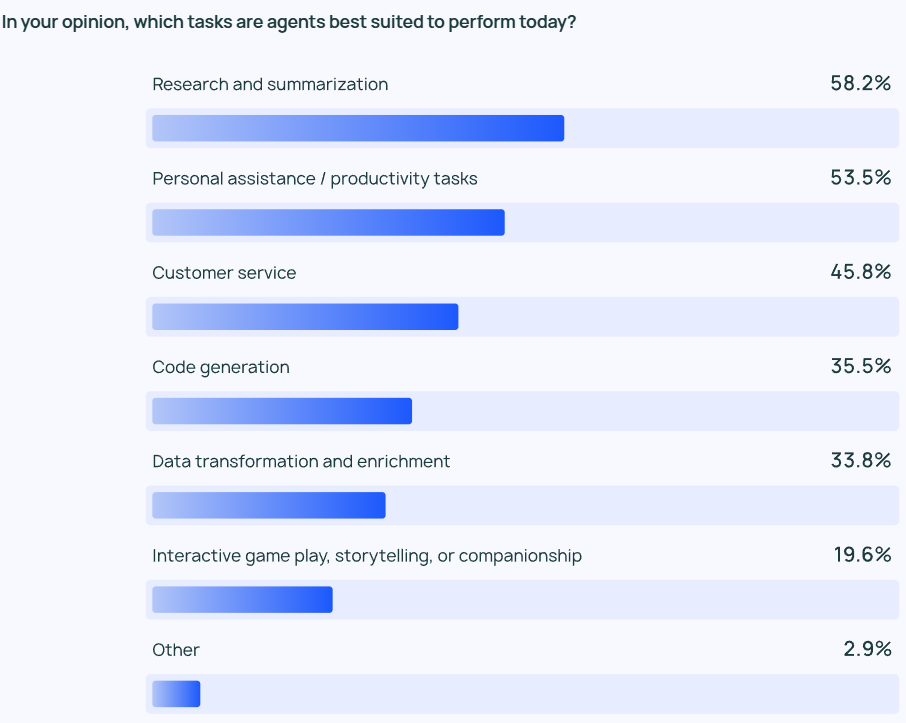

Los resultados de la investigación muestran que el agente más común caso de uso (escenario de aplicación) incluida la búsqueda de información y la síntesis de contenidos (58%), seguida de la agilización del flujo de trabajo mediante Agentes personalizados (53,5%).

Esto refleja el hecho de que los usuarios esperan que los Agentes les ayuden en tareas que requieren mucho tiempo y trabajo. Los usuarios pueden confiar en los Agentes de IA para extraer rápidamente información clave y perspectivas de grandes cantidades de información, en lugar de tener que escudriñar grandes cantidades de datos y realizar revisiones de datos o análisis de investigación por sí mismos. Del mismo modo, los Agentes de IA pueden ayudar en las tareas cotidianas, aumentando la productividad personal y permitiendo a los usuarios centrarse en aspectos más importantes de su trabajo.

No sólo los usuarios individuales necesitan mejorar su eficiencia, sino también las organizaciones y los equipos. El servicio de atención al cliente (45,8%) es otra de las principales áreas de aplicación de los agentes. Los agentes ayudan a las organizaciones a gestionar las consultas de los clientes, resolver problemas y reducir los tiempos de respuesta de los equipos. Los escenarios de aplicación cuarto y quinto más populares son más de código de bajo nivel y procesamiento de datos.

Supervisión: las aplicaciones de los agentes deben ser observables y controlables.

A medida que los Agentes se vuelven más potentes, es fundamental gestionar y supervisar eficazmente su comportamiento. Las herramientas de seguimiento y capacidad de observación se están convirtiendo en una opción imprescindible en la pila tecnológica de Agentes de los usuarios empresariales, ya que ayudan a los desarrolladores a obtener información sobre el comportamiento y el rendimiento de los Agentes. Muchas empresas también utilizan barandilla para evitar que el comportamiento del Agente se desvíe de la trayectoria predefinida.

Al probar las aplicaciones LLM, elEvaluación offline (39,8%) se utilizó con más frecuencia que el Evaluación en línea (32,5%), lo que refleja los muchos retos a los que todavía se enfrenta la supervisión de LLM en tiempo real. En las respuestas al cuestionario abierto de LangChain, muchas empresas indicaron que también se encargarían de que expertos humanos comprobaran o evaluaran manualmente los resultados de las respuestas de los Agentes como una capa adicional de seguridad.

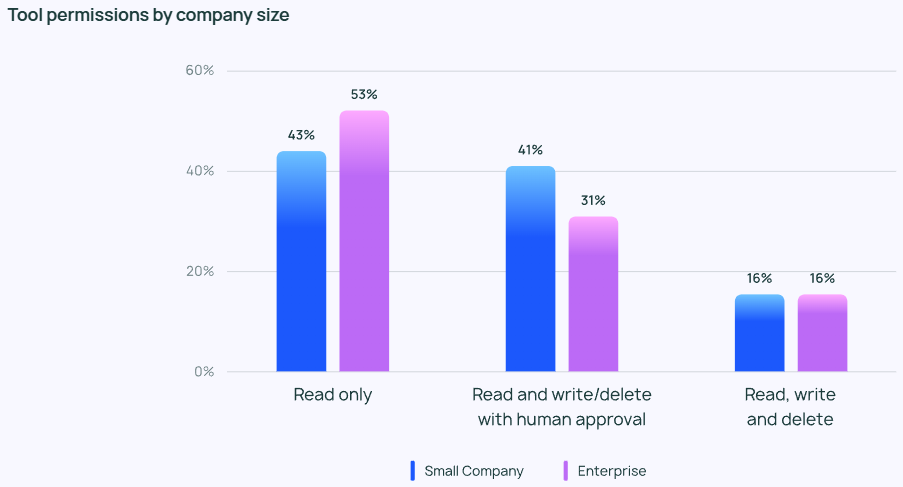

A pesar del entusiasmo por los Agentes, la gente suele ser conservadora en lo que respecta al control de privilegios de los Agentes. Pocos encuestados permiten a los agentes leer, escribir y borrar libremente. En su lugar, la mayoría de los equipos solo conceden a los agentes permisos de "solo lectura" o requieren aprobación manual cuando los agentes realizan operaciones más arriesgadas, como escribir o eliminar.

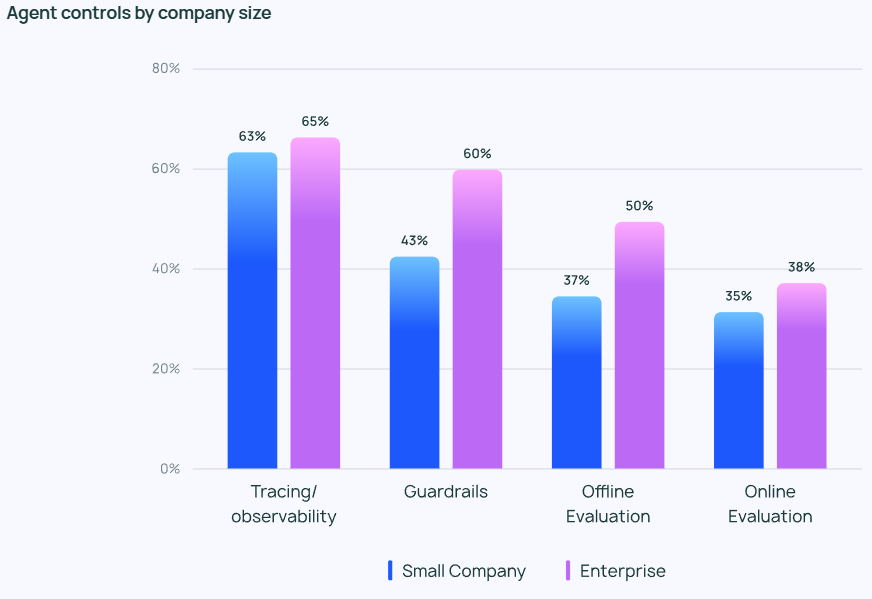

La importancia de los controles de los agentes varía en función del tamaño de la empresa. Las organizaciones más grandes (con más de 2.000 empleados) suelen ser más cautelosas y confían mucho en los permisos de "sólo lectura" para minimizar riesgos innecesarios. También tienden a colocar barandilla Combinado con evaluaciones fuera de línea, trata de evitar cualquier problema que pueda afectar negativamente al cliente.

Por su parte, las empresas más pequeñas y las startups (con menos de 100 empleados) están más interesadas en realizar un seguimiento de los agentes para conocer su rendimiento real (en lugar de otros controles). La investigación de LangChain muestra que las empresas más pequeñas tienden a analizar los datos para comprender los resultados, mientras que las organizaciones más grandes se centran en crear un sistema holístico de control.

Obstáculos y retos para poner el agente en producción

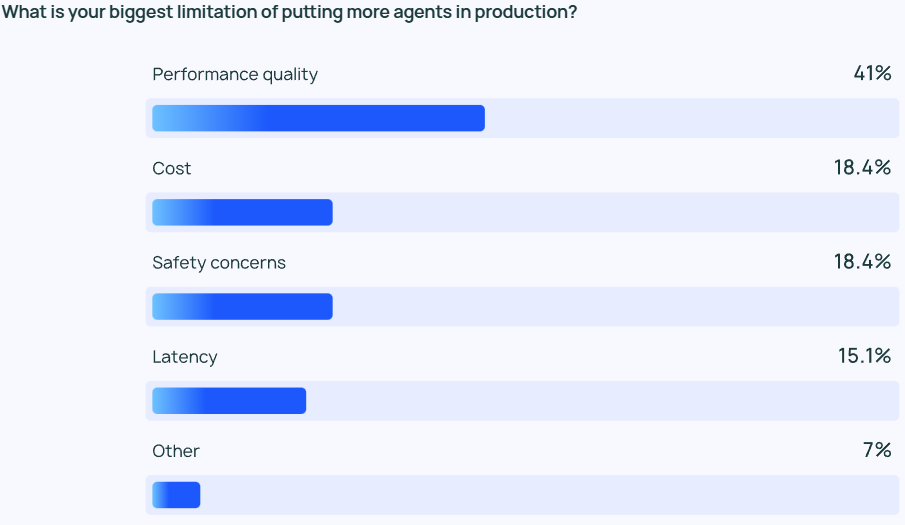

Garantizar que los resultados del LLM sean de alta calidad rendimiento sigue siendo una tarea difícil. Las respuestas de los agentes no sólo tienen que ser muy precisas, sino también estilísticamente correctas. Esta es una de las principales preocupaciones de los desarrolladores de agentes, más del doble de importante que otros factores como el coste y la seguridad.

El Agente LLM es esencialmente un modelo de salida de contenido basado en probabilidades, lo que significa que su salida es algo impredecible. Esta imprevisibilidad aumenta la probabilidad de error y dificulta al equipo de desarrollo la tarea de garantizar que el Agente proporcione respuestas precisas y contextualizadas de forma coherente.

Para las pequeñas empresasCalidad de las prestaciones El 45,81 TP3T de las empresas más pequeñas lo considera su principal preocupación, frente al 22,41 TP3T que lo considera el coste (la segunda preocupación más importante). Esta disparidad pone de manifiesto que un rendimiento fiable y de alta calidad es fundamental para impulsar la transición de los Agentes de una organización de la fase de desarrollo a la de producción.

La seguridad también es fundamental para las grandes organizaciones que deben cumplir estrictos requisitos de conformidad y manejar con cuidado los datos de sus clientes.

Además de los problemas de calidad, las respuestas al cuestionario abierto de LangChain revelaron que muchas organizaciones siguen teniendo reservas a la hora de seguir invirtiendo en el desarrollo y las pruebas de agentes. Se citaron dos obstáculos principales: en primer lugar, el desarrollo de un agente requiere una gran experiencia y la necesidad de estar al tanto de las tecnologías más avanzadas; y en segundo lugar, el tiempo que cuesta desarrollar e implantar un agente es elevado, pero sigue habiendo incertidumbre sobre su capacidad para funcionar de forma fiable y aportar los beneficios esperados.

Otros temas emergentes

En la sesión de preguntas abiertas, los encuestados valoraron muy positivamente el Agente de IA por demostrar las siguientes capacidades:

- Gestión de tareas de varios pasos. El Agente AI es capaz de un razonamiento más profundo y de gestionar el contexto, lo que le permite realizar tareas más complejas.

- Automatización de tareas repetitivas. AI Agent sigue considerándose una herramienta clave para gestionar tareas automatizadas, lo que ayuda a los usuarios a liberar su tiempo para centrarse en un trabajo más creativo.

- Planificación de misiones y colaboración. Una mejor capacidad de planificación de tareas garantiza que el agente adecuado trabaje en el problema adecuado en el momento adecuado, lo que es especialmente importante en los sistemas multiagente.

- Razonamiento similar al humano. A diferencia de los LLM tradicionales, un Agente de IA puede rastrear su proceso de toma de decisiones, incluyendo la revisión y modificación de decisiones pasadas basándose en nueva información.

Además, los encuestados identificaron dos expectativas clave para el futuro de los agentes de IA:

- Qué esperar de un agente de IA de código abierto. Los agentes de IA de código abierto han despertado un gran interés y muchos creen que la inteligencia colectiva puede acelerar el ritmo de la innovación en la tecnología de agentes.

- Expectativas de modelos más potentes. Muchos esperan con impaciencia el próximo salto adelante de los Agentes de IA impulsados por modelos más grandes y potentes, cuando los Agentes puedan manejar tareas más complejas con mayor eficiencia y autonomía.

Durante la sesión de preguntas y respuestas, muchos encuestados también mencionaron el mayor reto en el desarrollo del Agente: comprender su comportamiento. Algunos ingenieros dijeron que les costaba entender el comportamiento del Agente cuando lo presentaban a la empresa. partes interesadas Se encuentran con dificultades a la hora de explicar las capacidades y el comportamiento de un Agente de IA. Mientras que los plug-ins de visualización pueden ayudar a explicar el comportamiento del Agente hasta cierto punto, el LLM sigue siendo una "caja negra" en la mayoría de los casos. La carga adicional de la interpretabilidad sigue recayendo en el equipo de ingeniería.

02 Análisis de los elementos básicos de un agente de IA

Antes de la publicación del informe State of AI Agent, el equipo de Langchain ya había explorado el ámbito de los agentes basándose en el marco Langraph que desarrollaron, y publicado varios artículos sobre el análisis de los componentes clave de los agentes de IA a través del blog In the Loop. En este artículo, recopilaremos el contenido central de la serie de artículos In the Loop y analizaremos en profundidad los elementos clave del agente.

Para entender mejor los elementos básicos de un Agente, primero tenemos que comprender mejor el Sistema agentico Definición. El fundador de LangChain, Harrison Chase, da la siguiente definición de agente de IA:

💡

AI Agent es un sistema que utiliza LLM para controlar las decisiones de flujo de control de la aplicación.

Un agente AI es un sistema que utiliza un LLM para decidir el flujo de control de una aplicación.

En cuanto a la forma en que se aplica el Agente, el artículo presenta el Arquitectura cognitiva El concepto. arquitectura cognitiva Es cómo piensa el Agente y cómo el sistema orquesta el código o los Prompts que dirigen el LLM. Entender la arquitectura cognitiva nos ayuda a comprender cómo funciona el Agente:

- Cognitivo. El Agente utiliza el LLM para el razonamiento semántico para determinar cómo codificar o Prompt LLM.

- Arquitectura. Los sistemas de agentes siguen implicando una gran cantidad de prácticas de ingeniería similares a las arquitecturas de sistemas tradicionales.

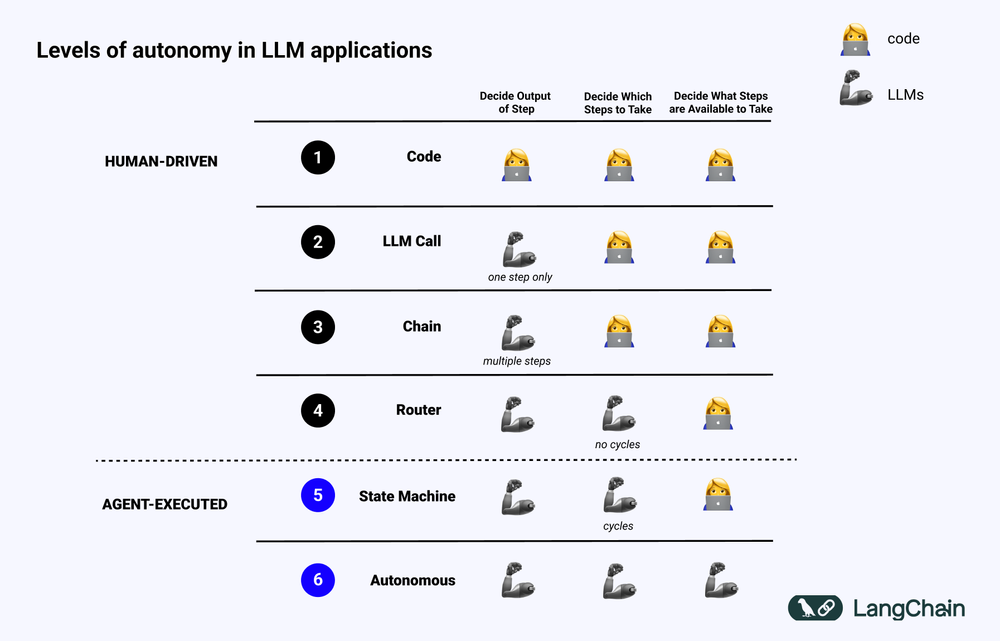

El siguiente diagrama muestra los diferentes niveles de Arquitectura cognitiva Ejemplo:

- Código de software normalizado (Código). Toda lógica es Código Duro implementación, los parámetros de entrada y salida se solidifican directamente en el código fuente. Este enfoque no constituye una arquitectura cognitiva debido a la falta de cognitivo Parte.

- Convocatoria LLM. Con la excepción de una pequeña cantidad de preprocesamiento de datos, la mayor parte de la funcionalidad de una aplicación depende de una única llamada LLM. Un Chatbot sencillo suele entrar en esta categoría.

- Cadena. Una serie de llamadas LLM donde Chain intenta descomponer un problema complejo en pasos y llamar a diferentes LLMs para resolverlos uno a uno. El complejo RAG (Search Enhanced Generation) entran en esta categoría: por ejemplo, el primer LLM es llamado para buscar y consultar, y el segundo LLM es llamado para generar la respuesta.

- Router. En estos tres sistemas, el usuario conoce de antemano todos los pasos que va a realizar el programa. Sin embargo, en la arquitectura Router, el LLM puede decidir de forma autónoma a qué LLM llamar y qué pasos dar. Esto aumenta la aleatoriedad e imprevisibilidad del sistema.

- Máquina de estados. Al combinar el LLM con el Router, la imprevisibilidad del sistema aumenta aún más. Como esta combinación crea un bucle, en teoría el sistema puede invocar el LLM un número infinito de veces.

- Sistema agentico. También suele denominarse "Agente autónomo (Autonomous Agent)" Cuando se utiliza una Máquina de Estado, todavía hay algunas limitaciones en las operaciones que se pueden realizar y los procesos que pueden seguirles. Cuando se utiliza una Máquina de Estado, todavía existen algunas restricciones sobre las operaciones que puede realizar el sistema y el flujo posterior a las mismas. Sin embargo, cuando se utiliza un Agente Autónomo, estas restricciones desaparecen. El LLM tiene total autonomía para decidir qué pasos dar y cómo programar los diferentes LLMs, lo que puede conseguirse mediante el uso de diferentes Prompts, herramientas o código.

En resumen, cuanto más "Agentic" Cuanto mayor sea el papel del LLM en la determinación de cómo se comporta el sistema, mayor será el papel del LLM en la determinación de cómo se comporta el sistema.

Elementos clave del Agente: capacidad de planificación

La fiabilidad de los agentes es un punto débil en la práctica actual de las aplicaciones. Muchas empresas han construido Agentes basados en LLM, pero se han encontrado con que la capacidad de planificación y razonamiento de los Agentes es insuficiente. Entonces, ¿qué significa la capacidad de planificación y razonamiento de los Agentes?

Agente Planificación responder cantando Razonamiento Competencia, que se refiere a la capacidad de LLM para pensar y tomar decisiones sobre las medidas que deben adoptarse. Esto implica tanto a corto como a largo plazo razonamiento . LLM necesita evaluar toda la información disponible y luego decidir: ¿Qué pasos debo dar para alcanzar mi objetivo final? ¿Cuál es el primer paso más importante que debo dar en este momento?

En la práctica, los desarrolladores suelen utilizar Llamada a la función para permitir que el LLM seleccione la acción a realizar. Llamada a la función es una característica añadida por primera vez a la API de LLM en junio de 2023 por OpenAI. Con la llamada a funciones, los usuarios pueden proporcionar estructuras JSON para diferentes funciones y hacer que LLM coincida con una (o más) de esas estructuras.

Para completar con éxito una tarea compleja, un sistema Agente normalmente necesita realizar una serie de operaciones de forma secuencial. Planificación y razonamiento a largo plazo Un reto muy complejo para el LLM: en primer lugar, el LLM tiene que considerar una planificación de acciones a largo plazo y luego refinarla a las acciones a corto plazo que hay que tomar en el momento; en segundo lugar, a medida que el Agente realiza más y más operaciones, los resultados de las operaciones se retroalimentarán continuamente al LLM, dando lugar a un crecimiento continuo de la ventana de contexto, lo que puede llevar a que el LLM se "distraiga " y reducir el rendimiento.

La forma más directa de mejorar la capacidad de planificación es asegurarse de que los LLM disponen de toda la información que necesitan para razonar y planificar racionalmente. Aunque esto parece sencillo, la realidad es que la información transmitida al LLM es a menudo insuficiente para permitirle tomar decisiones acertadas. Añadir un paso de búsqueda u optimizar el Prompt puede ser una mejora sencilla.

Yendo un paso más allá, considere la posibilidad de ajustar la aplicación de arquitectura cognitiva . Existen dos tipos principales de arquitecturas cognitivas que pueden utilizarse para mejorar la capacidad de razonamiento del Agente: Arquitectura cognitiva genérica responder cantando Arquitecturas cognitivas específicas.

1. Arquitectura cognitiva genérica

Arquitectura cognitiva genérica pueden aplicarse a diversos escenarios de tareas. Los académicos han propuesto dos arquitecturas genéricas representativas: "Arquitectura "Planificar y resolver responder cantando Arquitectura de reflexión.

"Arquitectura "Planificar y resolver Se presentó por primera vez en el artículo Plan-and-Solve Prompting: Improving Zero-Shot Chain-of-Thought Reasoning by Large Language Models. En esta arquitectura, un agente elabora primero un plan detallado y luego ejecuta cada paso del plan paso a paso.

Arquitectura de reflexión se presentó en el artículo Reflexion: Language Agents with Verbal Reinforcement Learning. En esta arquitectura, un Agente realiza una tarea y después añade un "Reflexión". pasos para evaluar si sus tareas se realizan correctamente. Sin entrar en los detalles específicos de estas dos arquitecturas, se remite al lector interesado a los dos documentos originales antes mencionados.

Aunque las arquitecturas "Plan and Solve" y Reflexion muestran cierto potencial teórico de mejora, suelen ser demasiado generales para ser útiles en el uso productivo de los Agentes. (Nota del traductor: en el momento de redactar este artículo, la familia de modelos o1 aún no había salido al mercado).

2. Arquitectura cognitiva específica de cada dominio

A diferencia de las arquitecturas cognitivas genéricas, muchos sistemas de agentes optan por utilizar la Arquitecturas cognitivas específicas . Esto suele reflejarse en un paso de categorización o planificación específico del ámbito, así como en un paso de validación específico del ámbito. Las ideas de planificación y reflexión presentadas en las arquitecturas cognitivas genéricas pueden tomarse prestadas y aplicarse en arquitecturas cognitivas específicas de un ámbito, pero normalmente deben adaptarse y optimizarse de una forma más específica.

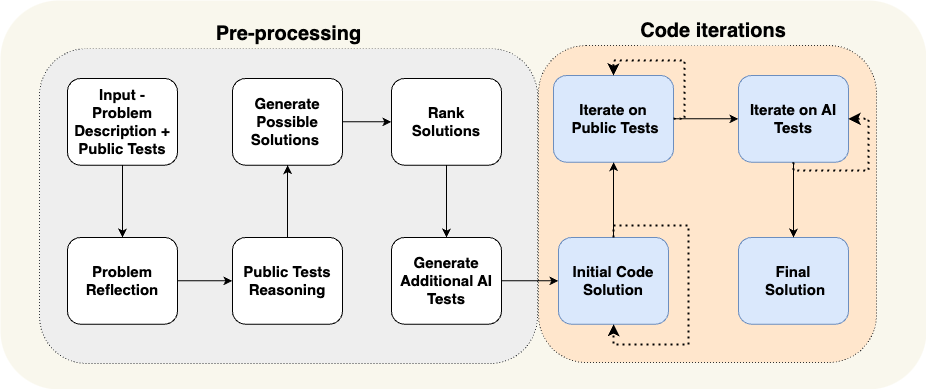

Un artículo de AlphaCodium es un buen ejemplo de arquitectura cognitiva específica de un dominio. El equipo de AlphaCodium lo ha conseguido utilizando lo que denominan el "Ingeniería de flujos". (en esencia, otra forma de describir las arquitecturas cognitivas), logrando un rendimiento puntero en aquel momento.

Como se muestra en la figura anterior, los procesos del Agente AlphaCodium están diseñados para ser altamente relevantes para el problema de programación que intentan resolver. Informan detalladamente al Agente sobre las tareas que necesita realizar por pasos: primero proponer un caso de prueba, luego proponer una solución, luego iterar sobre más casos de prueba, y así sucesivamente. Esta arquitectura cognitiva es muy específica del dominio, no es genérica y es difícil de generalizar directamente a otros dominios.

Estudio de caso: La visión del fundador de Reflection AI, Laskin, sobre el futuro de los agentes

En la entrevista de Sequoia Capital a Misha Laskin, fundador de Reflection AI, Misha Laskin comparte su visión del futuro del agente: combinando Capacidad de búsqueda para RL (aprendizaje por refuerzo) Junto con LLM, Reflection AI se centra en construir modelos de agentes con un rendimiento superior. Misha Laskin y el cofundador Ioannis Antonoglou (responsable de AlphaGo, AlphaZero, Gemini RLHF) se centran en entrenar modelos de agentes especialmente diseñados para la Flujo de trabajo agenético Modelización del diseño. A continuación se presentan las ideas centrales de las entrevistas:

- La profundidad es el ingrediente clave que le falta a un agente de IA. Aunque los modelos lingüísticos actuales destacan por su amplitud de conocimientos, carecen de la profundidad necesaria para completar con fiabilidad tareas complejas. Misha Laskin sostiene que resolver el "problema de la profundidad" es fundamental para crear agentes de IA realmente capaces. En este contexto, "capacidad" se refiere a la habilidad de un agente para planificar y ejecutar tareas complejas en varios pasos.

- Combinar Aprender y Buscar es la clave de un rendimiento sobrehumano. Basándose en el éxito de AlphaGo, Misha Laskin subrayó que la idea más profunda de la IA es la combinación eficaz de **Aprender** (basándose en LLM) y **Buscar** (encontrar el camino óptimo). Este enfoque es fundamental para crear agentes que superen a los humanos en tareas complejas.

- La formación posterior y los modelos de recompensa plantean grandes retos. A diferencia de los juegos con mecanismos de recompensa explícitos, las tareas del mundo real suelen carecer de señales de recompensa explícitas. Cómo desarrollar modelo de retribución El principal reto es crear un agente de IA fiable.

- Los Agentes Universales pueden estar más cerca de lo que pensamos. Misha Laskin predice que podríamos estar a sólo tres años de alcanzar el "AGI digital (Inteligencia Artificial General Digital)". Este calendario acelerado pone de relieve la urgencia de desarrollar rápidamente las capacidades de los agentes y, al mismo tiempo, abordar los problemas de seguridad y fiabilidad. Este calendario acelerado subraya la urgencia de desarrollar rápidamente las capacidades de los agentes y, al mismo tiempo, abordar los problemas de seguridad y fiabilidad.

- El camino hacia los Agentes Universales requiere un método. Reflection AI se centra en ampliar los límites funcionales del Agente, empezando por entornos específicos como navegadores, editores de código y sistemas operativos informáticos. Su objetivo final es desarrollar Agentes universales Esto les permite realizar tareas en una variedad de ámbitos diferentes y no se limita a tareas específicas.

Innovación en interacción UI/UX

La Interacción Persona-Ordenador (HCI) se convertirá en los próximos años en una línea de investigación clave en el campo de la IA. Los sistemas de agentes son muy diferentes de los sistemas informáticos tradicionales, y nuevas características como la latencia, la falta de fiabilidad y las interfaces de lenguaje natural plantean nuevos retos. Por tanto, es necesario un nuevo tipo de UI/UX (interfaz de usuario/experiencia del usuario) Surgirán paradigmas. Aunque los sistemas de agentes aún se encuentran en las primeras fases de desarrollo, hay una serie de paradigmas de UX emergentes. A continuación se analiza cada uno de ellos.

1. Interacción conversacional (Chat UI)

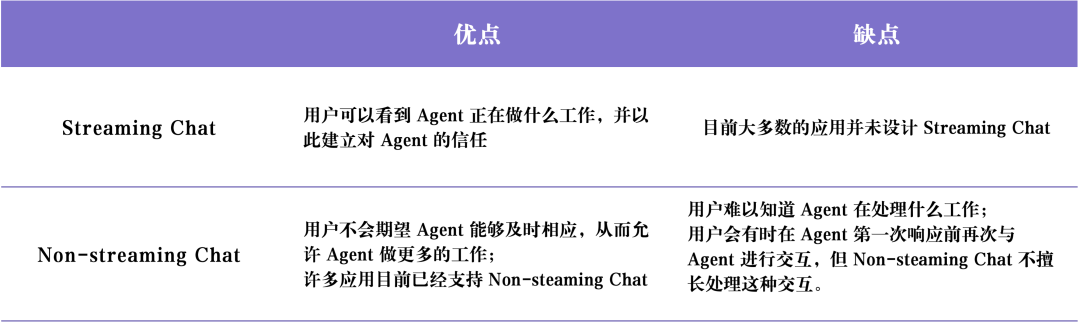

Interacción conversacional (Chat UI) Suele haber dos tipos principales: Chat en directo responder cantando Chat no retransmitido .

Chat en directo es el paradigma de UX más común hoy en día. Se trata esencialmente de un Chatbot, que toma el proceso de pensamiento y el comportamiento del Agente y lo escalona a través de un formato de diálogo similar al humano. Corriente al usuario. ChatGPT Es un representante típico del chat en streaming. Este modo de interacción parece simple, pero es muy eficaz por las siguientes razones: en primer lugar, los usuarios pueden utilizar el lenguaje natural para mantener un diálogo directo con los LLM, y casi no hay barreras de comunicación entre los usuarios y los LLM; en segundo lugar, los LLM suelen tardar tiempo en completar sus tareas, y el procesamiento en streaming permite a los hogares conocer el progreso de ejecución de las tareas en segundo plano en tiempo real; en tercer lugar, los LLM pueden cometer errores en ocasiones, y la interfaz de chat proporciona una forma amigable para que los usuarios corrijan y guíen de forma natural a los LLM, que se han acostumbrado mucho a mantener conversaciones de seguimiento. En tercer lugar, a veces los LLM cometen errores, y la interfaz de chat permite a los usuarios corregir y guiar de forma natural a los LLM, que se han acostumbrado a mantener conversaciones de seguimiento e iteraciones durante el proceso de chat para aclarar gradualmente los requisitos y resolver los problemas.

Sin embargo.Chat en directo También existen algunas limitaciones. En primer lugar, el chat en streaming es todavía una experiencia de usuario relativamente nueva, y aún no está comúnmente adoptada por nuestras plataformas de chat habituales (p. ej., iMessage, Facebook Messenger, Slack, etc.); en segundo lugar, la experiencia de usuario del chat en streaming es un poco insuficiente para tareas con un tiempo de ejecución largo, y los usuarios pueden tener que permanecer en la interfaz de chat durante mucho tiempo esperando a que el agente complete la tarea; en tercer lugar, el chat en streaming normalmente tiene que ser activado por usuarios humanos, lo que significa que aún se requiere una gran implicación humana (Human-in-the-tray) durante la ejecución de las tareas. En tercer lugar, los chats de streaming suelen ser desencadenados por usuarios humanos, lo que significa que sigue siendo necesaria una gran implicación humana (Human-in-the-loop) en el proceso de ejecución de los agentes.

Chat no retransmitido La principal diferencia con el chat streaming es que las respuestas del Agente se devuelven por lotes. El LLM funciona silenciosamente en segundo plano, por lo que el usuario no tiene que esperar impacientemente una respuesta inmediata del Agente. Esto significa que el chat sin streaming puede ser más fácil de integrar en los flujos de trabajo existentes. Los usuarios están acostumbrados a enviar mensajes de texto a sus amigos, así que ¿por qué no "enviar mensajes de texto" con la IA? El chat sin streaming hará que la interacción con sistemas de agentes más complejos sea más natural y sencilla. Dado que los sistemas de agentes complejos suelen tardar mucho tiempo en ejecutarse, los usuarios pueden sentirse frustrados si esperan una respuesta inmediata del agente. El chat no fluido elimina parte de la expectativa de una respuesta inmediata, lo que facilita la realización de tareas más complejas.

El siguiente cuadro resume Chat en directo responder cantando Chat no retransmitido Las ventajas e inconvenientes de la

2. Entorno backend (Ambient UX)

Los usuarios pueden enviar mensajes a la IA de forma activa, como se ha comentado anteriormente Chat UI (Interfaz de chat) Pero si el Agente sólo se está ejecutando silenciosamente en segundo plano, ¿cómo interactuamos con él? Pero, ¿cómo interactuamos con un Agente si se está ejecutando silenciosamente en segundo plano?

Para aprovechar todo el potencial del sistema de agentes, tenemos que cambiar el paradigma de la HCI a uno que permita la IA en la Entorno backend (Ambient UX) en segundo plano. Cuando las tareas se procesan en segundo plano, los usuarios suelen tolerar tiempos de ejecución más largos (porque reducen su necesidad del latencia expectativas). Esto permite al Agente disponer de más tiempo para realizar más tareas y, en general, realizar más razonamientos de forma más cuidadosa y eficiente que en Chat UX.

Además, en Entorno backend (Ambient UX) Ejecutar un Agente en una interfaz de chat ayuda a ampliar las capacidades de los propios usuarios humanos. Las interfaces de chat suelen limitar a los usuarios a una tarea cada vez. Sin embargo, si el Agente se ejecuta en un entorno de fondo, es posible admitir varios Agentes trabajando en varias tareas al mismo tiempo.

La clave para conseguir que un Agente funcione de forma fiable en segundo plano es generar la confianza del usuario en el Agente. ¿Cómo se consigue esta confianza? Una idea sencilla: mostrar al usuario exactamente lo que está haciendo el Agente. Mostrar todos los pasos que el Agente está realizando en tiempo real permite al usuario observar lo que está sucediendo. Aunque estos pasos no sean tan inmediatos como la transmisión de una respuesta, deben permitir al usuario hacer clic en ellos en cualquier momento y ver el progreso de la ejecución del Agente. Además, es importante no sólo permitir al usuario ver lo que el Agente está haciendo, sino también permitirle corregir los errores del Agente. Por ejemplo, si el usuario descubre que el Agente tomó una mala decisión en el paso 4 (de 10), el usuario tiene la opción de volver al paso 4 y corregir el comportamiento del Agente de alguna manera.

Este enfoque combina el modelo de interacción usuario-agente Del "In-the-loop" al "On-the-loop". . "On-the-loop". El modelo requiere que el sistema sea capaz de mostrar al usuario todos los pasos intermedios realizados por el Agente, permitiendo al usuario pausar el flujo de trabajo durante la ejecución de una tarea, proporcionar feedback y, a continuación, permitir que el Agente continúe realizando tareas posteriores basándose en el feedback del usuario.

Ingeniero de software de IA Devin es representativo de la implementación de aplicaciones de tipo UX. El tiempo de ejecución de Devin suele ser largo, pero el usuario puede ver claramente todos los pasos que ha realizado el Agente, retroceder hasta el estado de desarrollo en un momento determinado y emitir instrucciones correctivas desde ese estado. El hecho de que un Agente se ejecute en segundo plano no significa que tenga que realizar tareas de forma completamente autónoma. A veces un Agente puede no saber qué hacer a continuación, o puede no estar seguro de cómo responder a la pregunta de un usuario. En este caso, el Agente necesita proactivamente llamar la atención del usuario humano y buscar su ayuda.

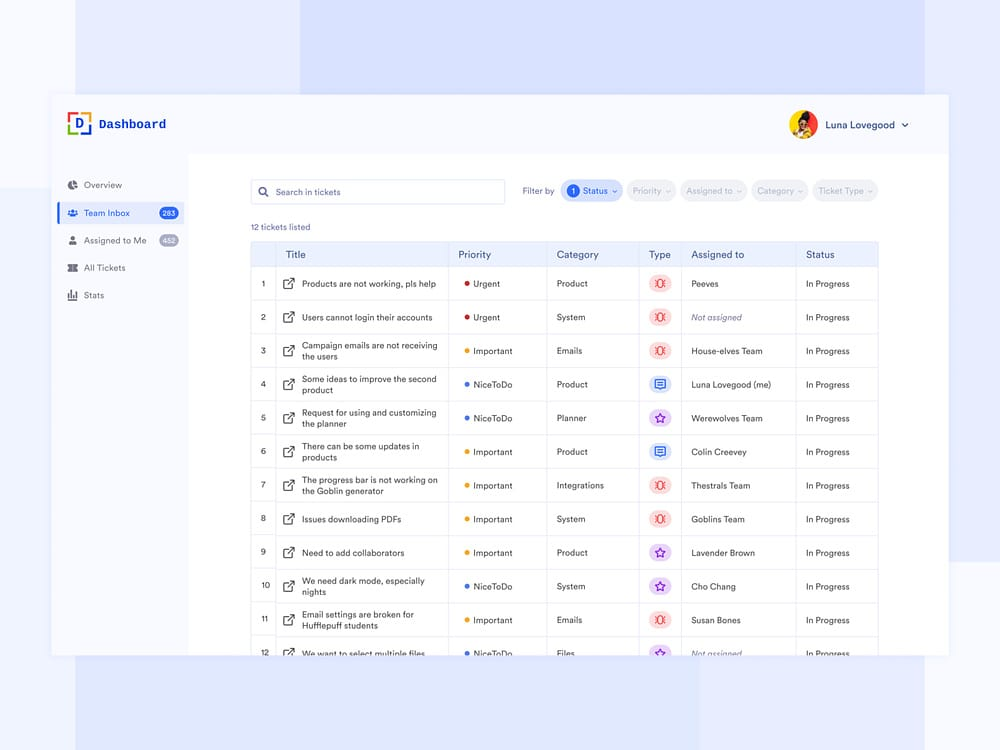

Correo electrónico Agente auxiliar Sí Ambient UX (entorno de fondo) Otro caso de uso de LangChain. El fundador de LangChain, Harrison Chase, está construyendo un agente asistente de correo electrónico. Mientras que el agente puede responder a correos electrónicos simples de forma automática, en algunos casos requiere que Harrison se dedique manualmente a tareas que no se prestan a la automatización, tales como: revisar complejos informes de errores de LangChain, revisar informes de errores complejos de LangChain, decidir si asistir a una reunión, etc. En estos casos, el Agente Asistente de Correo Electrónico necesita una forma eficiente de comunicar a Harrison que necesita ayuda humana para seguir completando la tarea. Tenga en cuenta que en lugar de pedir respuestas directamente a Harrison, el Agente pide a Harrison su opinión sobre determinadas tareas, y luego el Agente puede utilizar esa retroalimentación humana para escribir un correo electrónico de calidad o programar una invitación en el calendario de reuniones.

Actualmente, Harrison tiene este agente asistente de correo electrónico configurado en su espacio de trabajo de Slack. Cuando el agente necesita asistencia humana, envía una pregunta al Slack de Harrison, que Harrison puede responder en el Dashboard, una interacción que se integra perfectamente con el flujo de trabajo diario de Harrison. Este tipo de interacción se integra perfectamente en el flujo de trabajo diario de Harrison. La interfaz del Dashboard muestra claramente todas las tareas para las que el asistente necesita ayuda humana, la prioridad de la solicitud y otros datos relevantes.

3. Hoja de cálculo UX

Hoja de cálculo UX Es una forma de interactuar muy intuitiva y fácil de usar, especialmente adecuada para trabajos de procesamiento por lotes. En la interfaz de la hoja de cálculo, cada tabla, o incluso cada columna, puede tratarse como un Agente independiente para investigar y procesar tareas específicas. Esta capacidad de procesamiento por lotes permite a los usuarios ampliar fácilmente su interacción con múltiples Agentes.

Hoja de cálculo UX También tiene otras ventajas. El formato de hoja de cálculo es una UX con la que la mayoría de los usuarios están familiarizados, por lo que es fácil de integrar en los flujos de trabajo existentes. Este tipo de UX es ideal para escenarios de enriquecimiento de datos en los que cada columna de la hoja de cálculo puede representar un atributo de datos diferente que necesita ser ampliado.

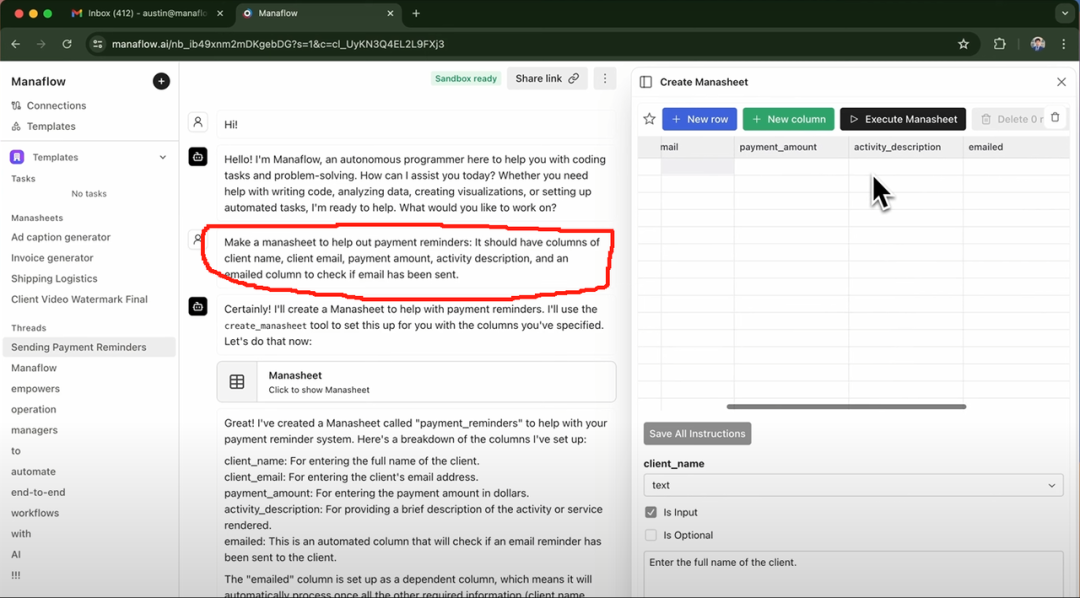

Exa AI, Clay AI, Manaflow y otras han utilizado la Hoja de cálculo UX A continuación se muestra un ejemplo de Manaflow. A continuación se muestra un ejemplo de Manaflow Hoja de cálculo UX Cómo se aplica a los flujos de trabajo de interacción con los agentes.

Caso práctico: Manaflow utiliza hojas de cálculo para las interacciones con los agentes

Manaflow se inspiró en Minion AI, la empresa para la que trabajaba su fundador, Lawrence. El producto principal de Minion AI es el Agente Web, que puede controlar el Google Chrome y permite a los usuarios interactuar con diversas aplicaciones web a través del Agente Web, como reservar vuelos en línea, enviar correos electrónicos, reservar lavados de coches, etc. Inspirándose en Minion AI, Manaflow ha optado por dejar que el Agente manipule directamente herramientas como hojas de cálculo. El equipo de Manaflow cree que los Agentes no son buenos trabajando directamente con interfaces UI humanas, y que para lo que los Agentes son realmente buenos es para Codificación Manaflow es el primero de su clase en el mundo. Como resultado, Manaflow permite al Agente llamar a scripts Python, interfaces de base de datos e interfaces API directamente desde la interfaz de usuario, y luego realizar operaciones directamente en la base de datos, incluyendo la lectura de datos, la programación, el envío de correo electrónico, y mucho más.

El flujo de trabajo de Manaflow es el siguiente: la principal interfaz interactiva de Manaflow es una hoja de cálculo (Manasheet). Cada columna de la Manasheet representa un paso en el flujo de trabajo, y cada fila corresponde a un agente de IA que realiza una tarea específica. Cada flujo de trabajo de Manasheet es programable en lenguaje natural (lo que permite a los usuarios no técnicos describir tareas y pasos en lenguaje natural). Cada Manasheet tiene un gráfico de dependencia interno que determina el orden de ejecución de cada columna. Estas órdenes de ejecución se asignan a los Agentes de cada fila, que realizan tareas en paralelo, gestionando procesos como la transformación de datos, las llamadas a la API, la recuperación de contenidos y la entrega de mensajes:

Los Manasheets se pueden generar de varias maneras: la más común es introducir un comando de lenguaje natural como el que aparece en el recuadro rojo de arriba. Por ejemplo, si desea enviar correos electrónicos masivos con información sobre precios a sus clientes, puede introducir una solicitud a través de la interfaz de chat y el agente generará automáticamente una hoja de cálculo que le mostrará el nombre del cliente, su dirección de correo electrónico, su sector y si el correo electrónico se ha enviado o no, entre otra información clave. Los usuarios pueden simplemente hacer clic en el botón "Ejecutar Manasheet" para realizar tareas de envío masivo de correo electrónico.

4. IU Generativa

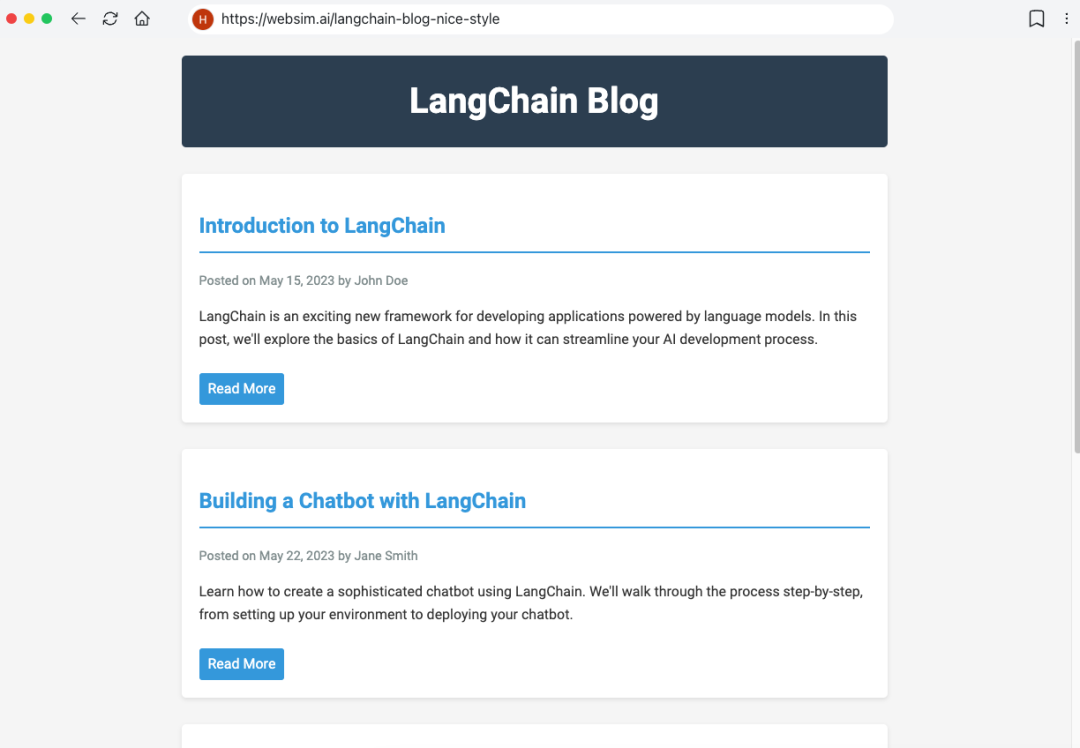

"IU Generativa". Existen dos implementaciones principales.

La primera consiste en que el modelo genere de forma autónoma las Componentes de interfaz de usuario . Esto es similar a Websim y otros productos. En segundo plano, el Agente escribe principalmente el código HTML sin procesar, lo que le da un control total sobre lo que muestra la interfaz de usuario. Sin embargo, el inconveniente de este enfoque es que la calidad de la Web App resultante es muy incierta y la experiencia del usuario puede ser variable.

Otro enfoque más restringido consiste en predefinir un conjunto de componentes de interfaz de usuario de uso común y luego pasarlos a través de la función Llamadas a la herramienta para representar dinámicamente los componentes de la interfaz de usuario. Por ejemplo, si LLM llama a la API del tiempo, activará la representación del componente de interfaz de usuario del mapa del tiempo. Dado que los componentes de interfaz de usuario renderizados están predefinidos (y el usuario tiene más opciones), la interfaz de usuario resultante será más pulida, pero su flexibilidad será algo limitada.

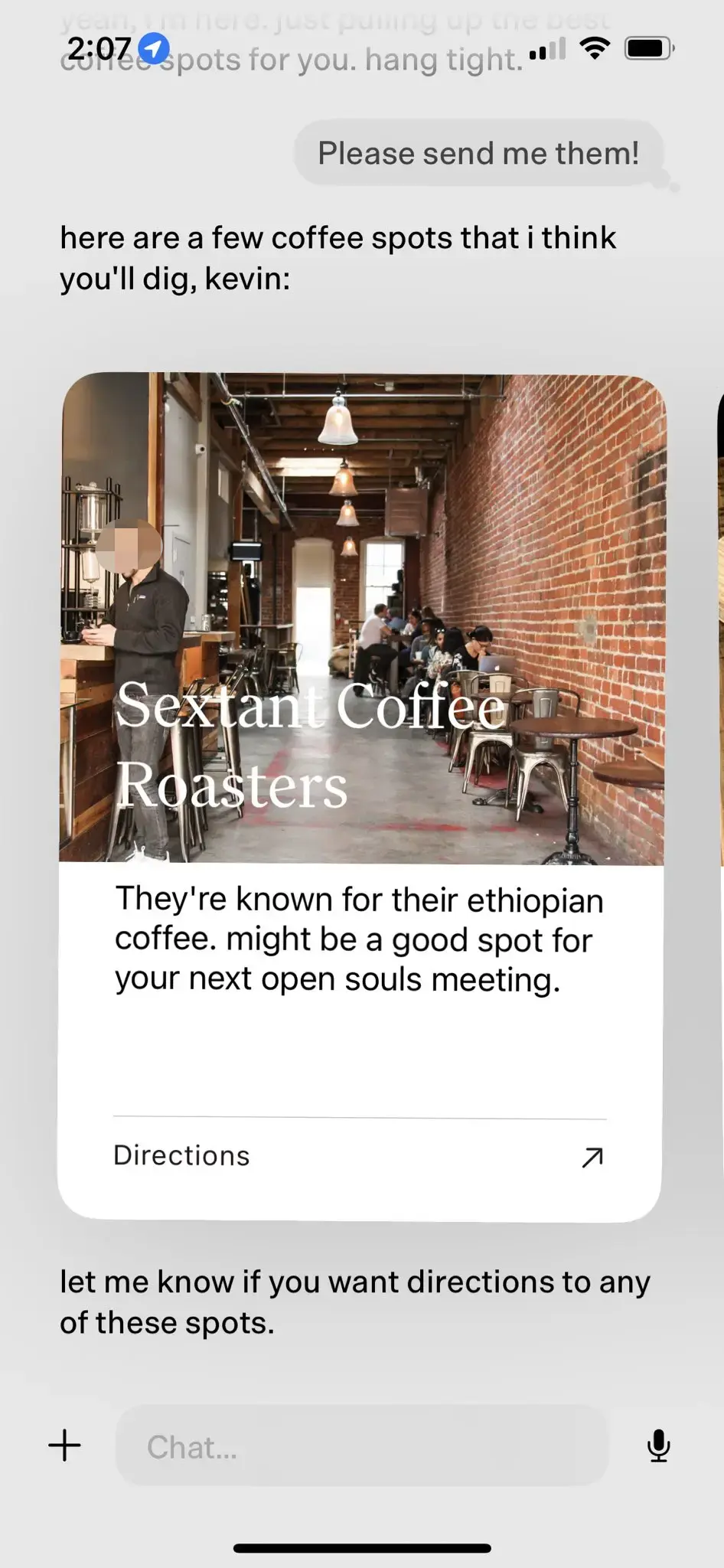

Estudio de caso: Personal AI product dot

Productos personales AI punto Sí Interfaz de usuario generativa El mejor ejemplo de ello. dot ha sido aclamado como el "mejor producto de IA personal" de 2024.

punto Sí Nuevo Ordenador El producto estrella de la empresa dot pretende ser un compañero digital a largo plazo para sus usuarios, no sólo una eficaz herramienta de gestión de tareas. Como dice Jason Yuan, cofundador de New Computer, el escenario de aplicación de dot es "cuando no sabes adónde ir, qué hacer o qué decir, recurres a dot". He aquí algunos casos típicos de uso de dot:

- Jason Yuan, fundador de New Computer, suele pedir a dot recomendaciones de bares a altas horas de la noche con la esperanza de "emborracharse". Tras meses de conversaciones nocturnas en bares, un día Jason Yuan le hizo a dot una pregunta similar, y dot empezó a decirle a Jason que "no podía seguir así".

- Mark Wilson, periodista de Fast Company, también pasó unos meses con dot. En un momento dado, compartió con dot una "O" manuscrita que había escrito en una clase de caligrafía. Sorprendentemente, dot sacó inmediatamente una foto de la "O" manuscrita de Mark Wilson unas semanas antes y le elogió por su "gran mejora" en caligrafía.

- A medida que los usuarios utilizan dot durante periodos de tiempo cada vez más largos, dot es capaz de conocer mejor sus intereses y preferencias. Por ejemplo, cuando dot se entera de que a un usuario le gusta visitar cafeterías, le recomienda cafeterías cercanas de calidad, detalla las razones de la recomendación y le pregunta si necesita navegar al final.

En el caso de la recomendación de café anterior, dot realiza el efecto de interacción natural persona-ordenador basado en LLM-native a través de componentes de interfaz de usuario predefinidos.

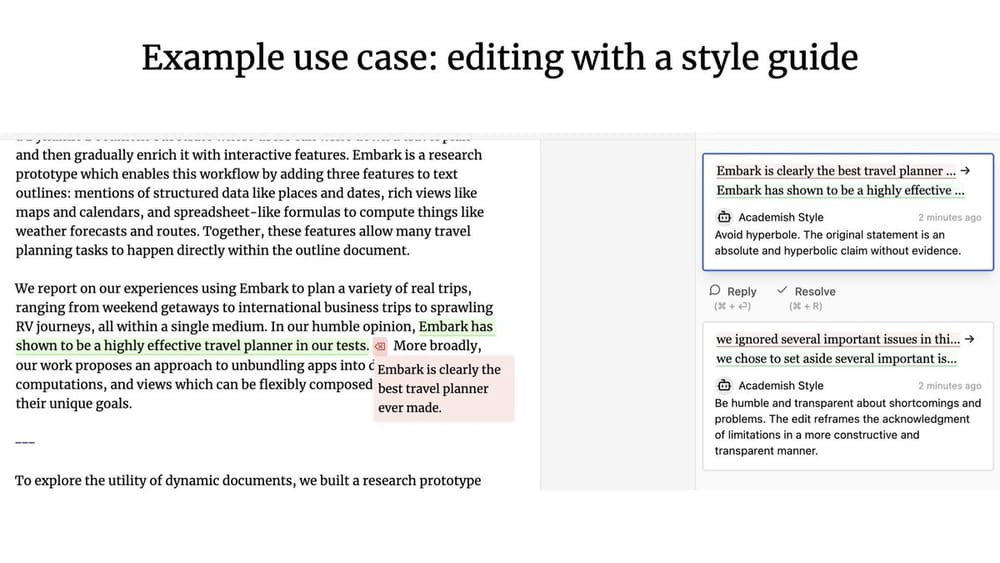

5. UX colaborativa

¿Qué tipo de patrones de interacción persona-ordenador surgen cuando un Agente y un usuario humano trabajan juntos? Al igual que en Google Docs, varios usuarios pueden colaborar en tiempo real para escribir o editar el mismo documento. ¿Y si uno de los colaboradores es un Agente?

Geoffrey Litt con Ink & Switch Proyecto Patchwork Es hombre-máquina. UX colaborativa El proyecto Patchwork es un gran ejemplo de lo que significa OpenAI. (Nota del traductor: la reciente actualización del producto Canvas de OpenAI puede haberse inspirado en el proyecto Patchwork).

UX colaborativa A diferencia de la Ambient UX (entorno de fondo) ¿Cuál es la diferencia? Nuno, ingeniero fundador de LangChain, subraya que la principal diferencia entre ambas es la disponibilidad del Concurrencia ::

- existe UX colaborativa En este caso, el usuario humano y el LLM suelen tener que trabajar simultáneamente y utilizar el producto de trabajo del otro como entrada.

- existe Ambient UX (entorno de fondo) En este caso, el LLM se ejecuta continuamente en segundo plano, mientras que el usuario puede centrarse en otras tareas y no necesita estar pendiente del estado de ejecución del Agente en tiempo real.

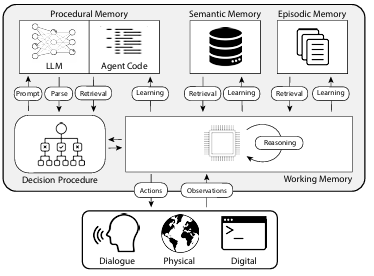

Memoria

Memoria Es crucial mejorar la experiencia de usuario del Agente. Imagina que tu colega nunca recuerda nada de lo que le has dicho y no para de pedirte que le repitas lo mismo una y otra vez, sería una experiencia de colaboración terrible. Es común esperar que los sistemas LLM sean inherentemente capaces de recordar, probablemente porque los LLM son en cierto modo muy cercanos a la cognición humana. Sin embargo, los LLM no tienen capacidades inherentes de memoria.

Agente Memoria El diseño debe adaptarse a las necesidades específicas del propio producto. Los distintos paradigmas de UX también proporcionan diferentes métodos para recopilar información y actualizar los comentarios. A partir de los mecanismos de memoria de los productos de los Agentes, podemos observar distintos tipos de patrones de memoria de alto nivel que imitan en cierta medida los tipos de memoria humana.

El artículo "CoALA: Cognitive Architectures for Language Agents" relaciona los tipos de memoria humana con los mecanismos de memoria de los agentes, categorizados como se muestra en la siguiente figura:

1. Memoria procedimental

Memoria procedimental Es una forma de hablar de Cómo llevar a cabo las tareas de la memoria a largo plazo, similar al conjunto básico de instrucciones del cerebro humano.

- Memoria procedimental humana. Por ejemplo, recuerda cómo montar en bicicleta.

- Memoria procedimental del agente. El documento CoALA describe la memoria procedimental como una combinación de pesos LLM y código de Agente que determina fundamentalmente cómo funciona el Agente.

En la práctica, el equipo de Langchain no ha encontrado ningún sistema Agente que actualice automáticamente sus LLMs o reescriba su código. Sin embargo, existen algunos sistemas de Agente que pueden actualizar dinámicamente sus Indicación del sistema El caso de.

2. Memoria semántica

Memoria semántica Es una reserva de conocimientos a largo plazo para almacenar conocimientos factuales.

- Memoria semántica en humanos. Consiste en diversas piezas de información, como hechos, conceptos y relaciones entre ellos aprendidos en la escuela.

- Memoria semántica para agentes. El documento CoALA describe la memoria semántica como un depósito de conocimiento factual.

En la práctica, la memoria semántica de un Agente se consigue normalmente utilizando LLM para extraer información del proceso de diálogo o interacción del Agente. La forma exacta en que se almacena la información suele depender de la aplicación específica. Luego, en diálogos posteriores, el sistema recupera esta información almacenada y la inserta en el Indicación del sistema para influir en la respuesta del Agente.

3. Memoria episódica

Memoria episódica Se utiliza para recordar hechos concretos del pasado.

- Memoria situacional en humanos. La memoria situacional se utiliza cuando una persona recuerda hechos concretos (o "episodios") vividos en el pasado.

- Memoria situacional para el Agente. El documento CoALA define la memoria situacional como una secuencia que almacena las acciones pasadas de un Agente.

La memoria situacional se utiliza principalmente para garantizar que el Agente se comporta como se espera de él. En la práctica, la memoria de situación suele actualizarse a través de la función Few-Shots Prompt para conseguirlo. Si, en la fase inicial, el sistema pasa por el Few-Shots Prompt Si el Agente recibe instrucciones para completar la operación correctamente, entonces puede reutilizar directamente este método de operación cuando se enfrente a problemas similares en el futuro. Por el contrario, si no existe un método efectivo para guiar al Agente a operar correctamente, o el Agente necesita probar nuevos métodos de operación constantemente, entonces el Memoria semántica será aún más importante.Memoria episódica El papel en estos escenarios es relativamente limitado.

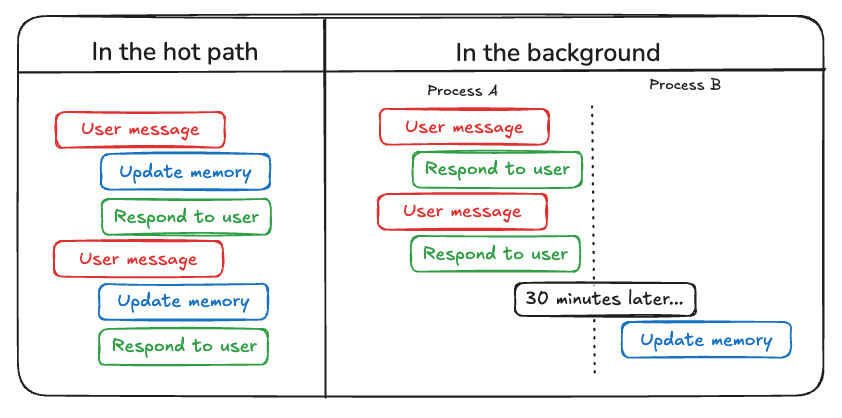

Además de considerar los tipos de memorias que deben actualizarse en Agent, los desarrolladores deben tener en cuenta lo siguiente Cómo actualizar la memoria del Agente . Actualmente existen dos métodos principales para actualizar la memoria del Agente:

El primer método es "en la senda caliente (actualización de la senda caliente)" . En este modelo, el sistema Agente recuerda la información factual relevante en tiempo real antes de generar una respuesta (normalmente conseguida a través de una llamada a una herramienta). ChatGPT utiliza actualmente este enfoque para actualizar su memoria.

El segundo método es "en segundo plano (actualización en segundo plano)" . En este modo, un proceso en segundo plano se ejecuta de forma asíncrona al final de la sesión y actualiza la memoria del Agente en segundo plano.

"en la senda caliente (actualización de la senda caliente)" La desventaja del método es que antes de que se devuelva cualquier respuesta, se requiere una cierta cantidad de latencia . Además, debe incorporar lógica de memoria junto con lógica del agente Estrechamente integrado.

"en segundo plano (actualización en segundo plano)" evita eficazmente el problema anterior, no aumenta la latencia de respuesta y la lógica de memoria pueden seguir siendo relativamente independientes. Sin embargo, "en segundo plano (actualización en segundo plano)" También tiene sus propias deficiencias: la memoria no se actualiza inmediatamente y se requiere lógica adicional para determinar cuándo debe iniciarse el proceso de actualización en segundo plano.

Otro enfoque de la actualización de memorias consiste en la retroalimentación del usuario, que es similar a la Memoria episódica especialmente relevante. Por ejemplo, si un usuario da una puntuación alta a una interacción con un Agente (Comentarios positivos), el Agente puede guardar esa información para utilizarla en situaciones similares en el futuro.

Basándose en la recopilación anterior, AI Share cree que el desarrollo simultáneo y el progreso continuo de los tres elementos clave, a saber, la capacidad de planificación, la innovación en la interacción y el mecanismo de memoria, darán lugar, con suerte, a más aplicaciones prácticas del agente de IA en 2025 y nos conducirán hacia una nueva era de trabajo colaborativo entre humanos y máquinas.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...