2024 Inventario GAR, Estrategia de aplicación GAR 100+

Base de conocimientos de IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 46.2K 00

De cara a 2024, los grandes modelos cambian día a día y cientos de organismos inteligentes compiten entre sí. Como parte importante de las aplicaciones de IA, RAG es también un "grupo de héroes y vasallos". A principios de año, ModularRAG sigue calentando motores, GraphRAG brilla, a mediados de año, las herramientas de código abierto están en pleno apogeo, los grafos de conocimiento crean nuevas oportunidades, y a finales de año, la comprensión de grafos y la RAG multimodal inician un nuevo viaje, por lo que es casi como "tú cantas y yo aparezco en el escenario", y aparecen técnicas extrañas, ¡y la lista sigue y sigue!

He seleccionado sistemas y documentos RAG típicos para 2024 (con notas de AI, fuentes e información resumida), y he incluido un resumen de RAG y material de evaluación comparativa de pruebas al final del documento, y espero poner en práctica este documento, que tiene 16.000 palabras, para ayudarle a pasar por RAG rápidamente.

El texto completo de 72 artículos, mes a mes a modo de esquema, fuertemente denominado "RAG setenta y dos estilos", con el fin de ofrecerle.

Observaciones:

Todo el contenido de este artículo ha sido alojado en el repositorio de código abierto Awesome-RAG, siéntase libre de enviar PRs para comprobar si hay lagunas.

Dirección de GitHub: https://github.com/awesome-rag/awesome-rag

(01) GraphReader [Experto en gráficos]

Expertos gráficosEs como un tutor que sabe hacer mapas mentales, transformando un texto largo en una red de conocimientos clara, de modo que la IA puede encontrar fácilmente los puntos clave necesarios para la respuesta como si explorara a lo largo de un mapa, superando eficazmente el problema de "perderse" cuando se trata de un texto largo.

- Hora: 01.20

- Tesis: GraphReader: creación de un agente basado en grafos para mejorar las capacidades de contexto largo de grandes modelos lingüísticos

GraphReader es un sistema de inteligencias basado en grafos diseñado para procesar textos largos construyéndolos en un grafo y utilizando inteligencias para explorar ese grafo de forma autónoma. Al recibir un problema, el organismo inteligente realiza primero un análisis paso a paso y elabora un plan razonable. A continuación, llama a un conjunto de funciones predefinidas para leer el contenido de los nodos y sus vecinos, lo que facilita una exploración del grafo que va de lo grueso a lo fino. A lo largo del proceso de exploración, el cuerpo inteligente registra continuamente nuevas percepciones y reflexiona sobre la situación actual para optimizar el proceso hasta que ha reunido suficiente información para generar una respuesta.

(02) MM-RAG [Polifacético]

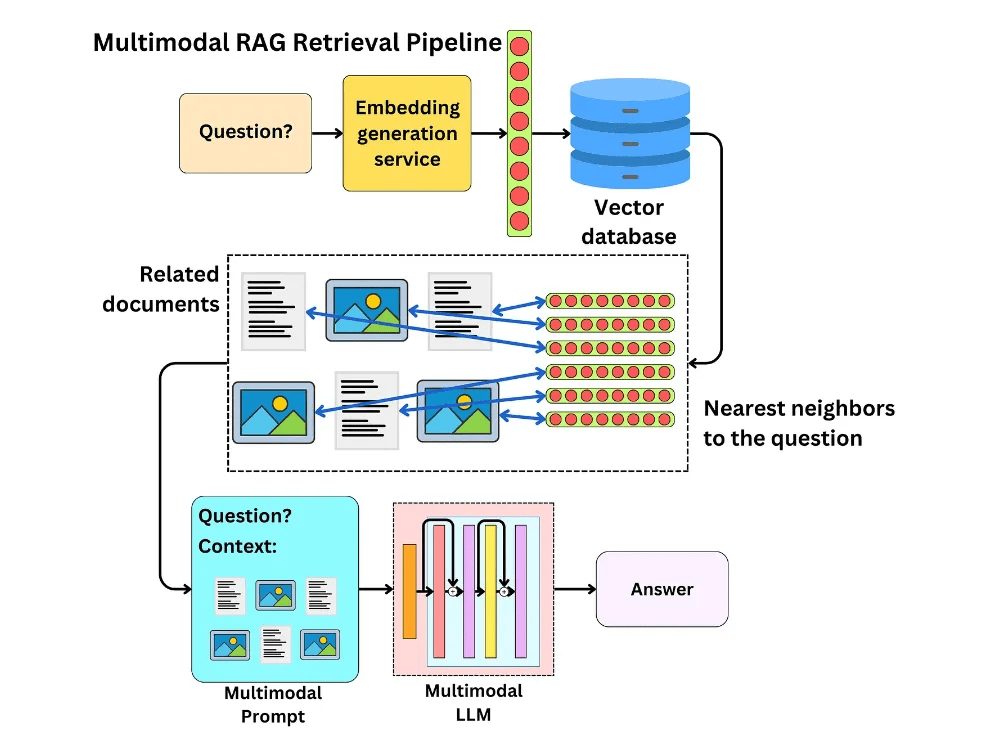

persona polifacéticaEs como un todoterreno que puede dominar la visión, el oído y el lenguaje al mismo tiempo, no sólo comprendiendo diferentes formas de información, sino también cambiando y correlacionando entre ellas libremente. Gracias a la comprensión global de información diversa, puede proporcionar servicios más inteligentes y naturales en diversos campos, como la recomendación, el asistente y los medios de comunicación.

Se presentan los avances en aprendizaje automático multimodal, incluido el aprendizaje comparativo, la búsqueda modal arbitraria implementada mediante incrustación multimodal, la generación aumentada de recuperación multimodal (MM-RAG) y cómo utilizar bases de datos vectoriales para construir sistemas de producción multimodal. También se exploran las tendencias futuras de la IA multimodal, destacando sus prometedoras aplicaciones en ámbitos como los sistemas de recomendación, los asistentes virtuales, los medios de comunicación y el comercio electrónico.

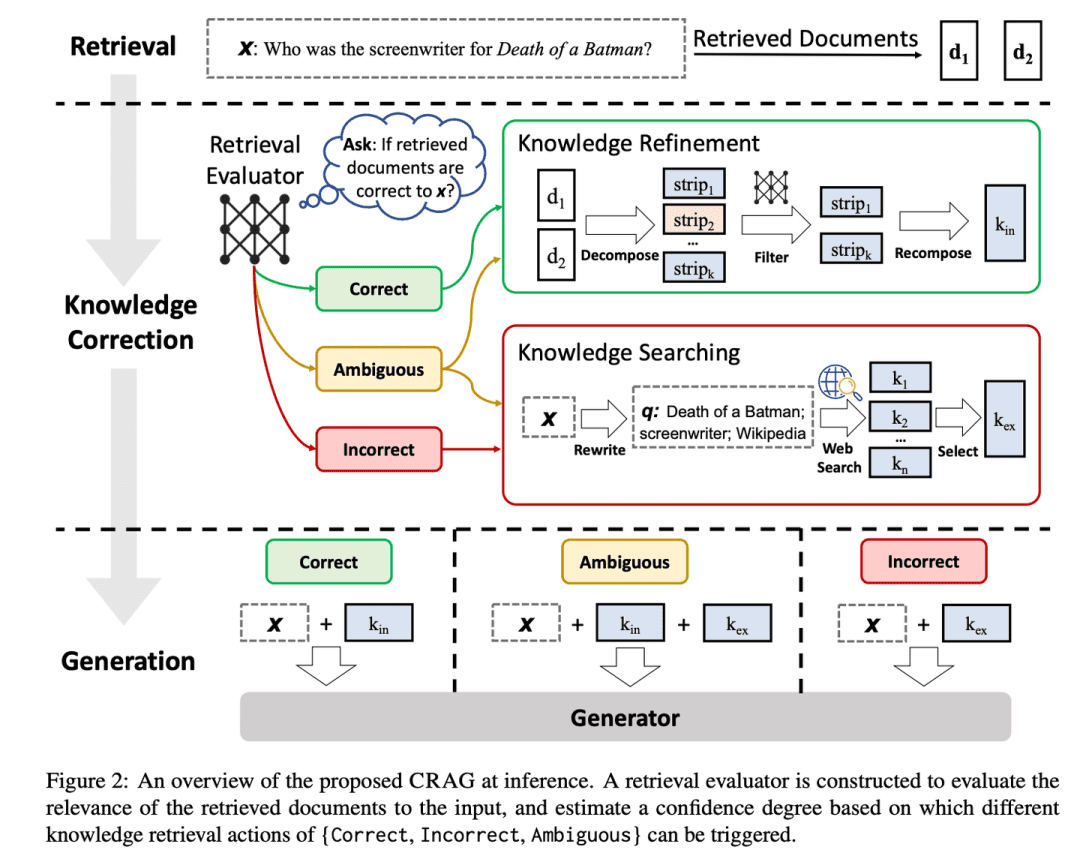

(03) CRAG [autocorrección]

autocorrección: Como un editor avezado, criba la información preliminar de forma sencilla y rápida, luego amplía la información buscando en la red y, por último, se asegura de que el contenido final presentado sea preciso y fiable desmontándolo y reorganizándolo. Es como poner un sistema de control de calidad en el GAR para que el contenido que produce sea más fiable.

- Hora: 01.29

- Tesis: Correctiva Recuperación Generación Aumentada

- Proyecto: https://github.com/HuskyInSalt/CRAG

CRAG mejora la calidad de los documentos recuperados diseñando un evaluador de recuperación ligero e introduciendo la búsqueda web a gran escala, y además refina la información recuperada mediante algoritmos de descomposición y reorganización para aumentar la precisión y fiabilidad del texto generado.CRAG es un complemento útil y una mejora de la técnica RAG existente, que aumenta la solidez del texto generado autocorrigiendo los resultados de la recuperación.

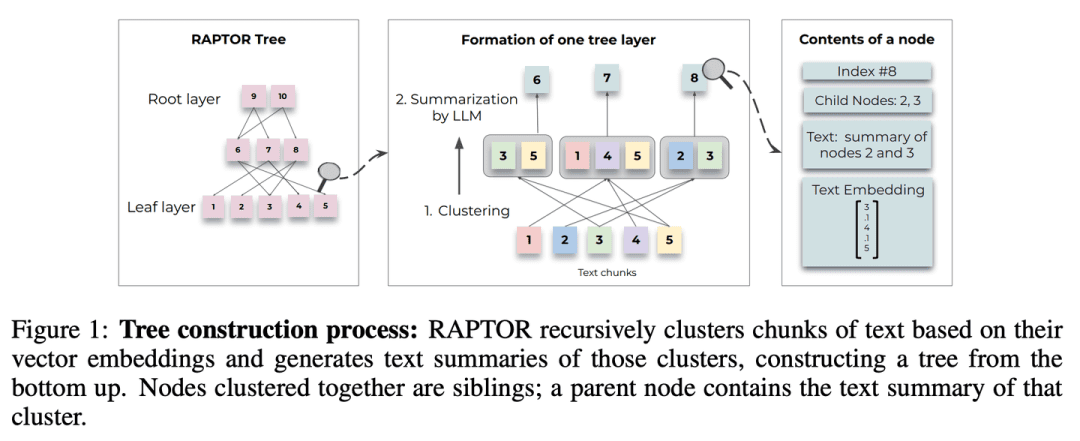

(04) RAPTOR [generalización jerárquica].

resumen jerárquicoAl igual que un bibliotecario bien organizado, el contenido del documento se organiza en una estructura de árbol de abajo arriba, lo que permite que la recuperación de información se mueva con flexibilidad entre los distintos niveles, tanto en términos de visión de conjunto como de detalles en profundidad.

- Hora: 01.31

- Tesis: RAPTOR: Recursive Abstractive Processing for Tree-Organised Retrieval (Procesamiento abstractivo recursivo para la recuperación organizada en árboles)

- Proyecto: https://github.com/parthsarthi03/raptor

RAPTOR (Recursive Abstractive Processing for Tree-Organised Retrieval) introduce un nuevo método de incrustación recursiva, agrupación y resumen de bloques de texto para construir árboles con distintos niveles de resumen de abajo arriba. En el momento de la inferencia, el modelo RAPTOR recupera a partir de este árbol, integrando información de documentos largos con distintos niveles de abstracción.

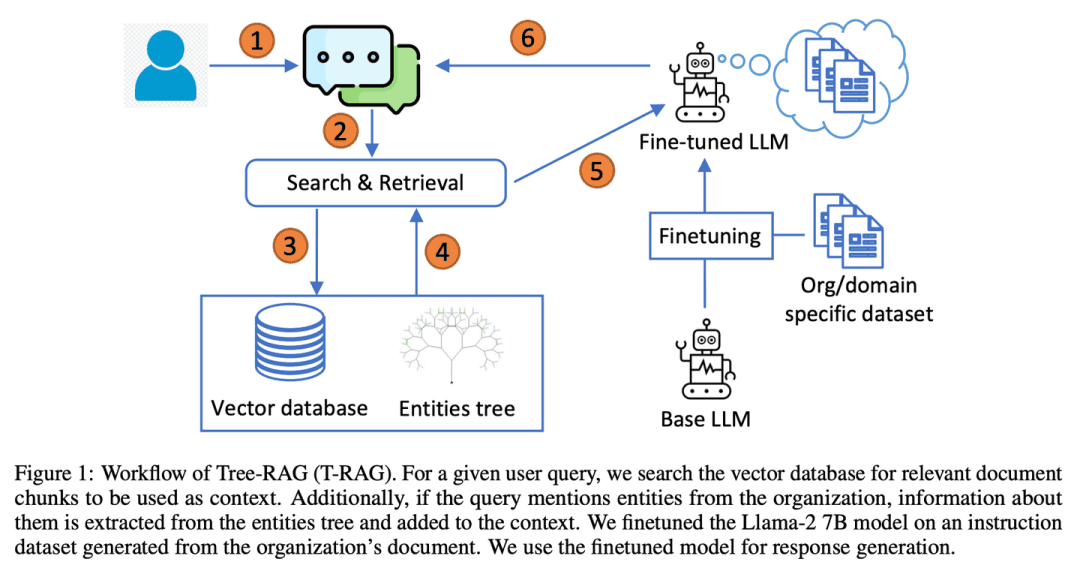

(05) T-RAG [consejero particular]

consejero privadoEl sistema de gestión de la información: como un consultor interno familiarizado con las estructuras organizativas, es experto en organizar la información utilizando una estructura de árbol para prestar servicios localizados de forma eficaz y rentable, protegiendo al mismo tiempo la privacidad.

- Tesis: T-RAG: Lecciones desde las trincheras del LLM

T-RAG (Tree Retrieval Augmentation Generation) combina RAG con LLM de código abierto perfeccionados que utilizan estructuras de árbol para representar jerarquías de entidades dentro de contextos de aumento de organizaciones, aprovechando modelos de código abierto alojados localmente para abordar las preocupaciones sobre la privacidad de los datos al tiempo que se resuelven los problemas de latencia de inferencia, costes de uso de tokens y disponibilidad regional y geográfica.

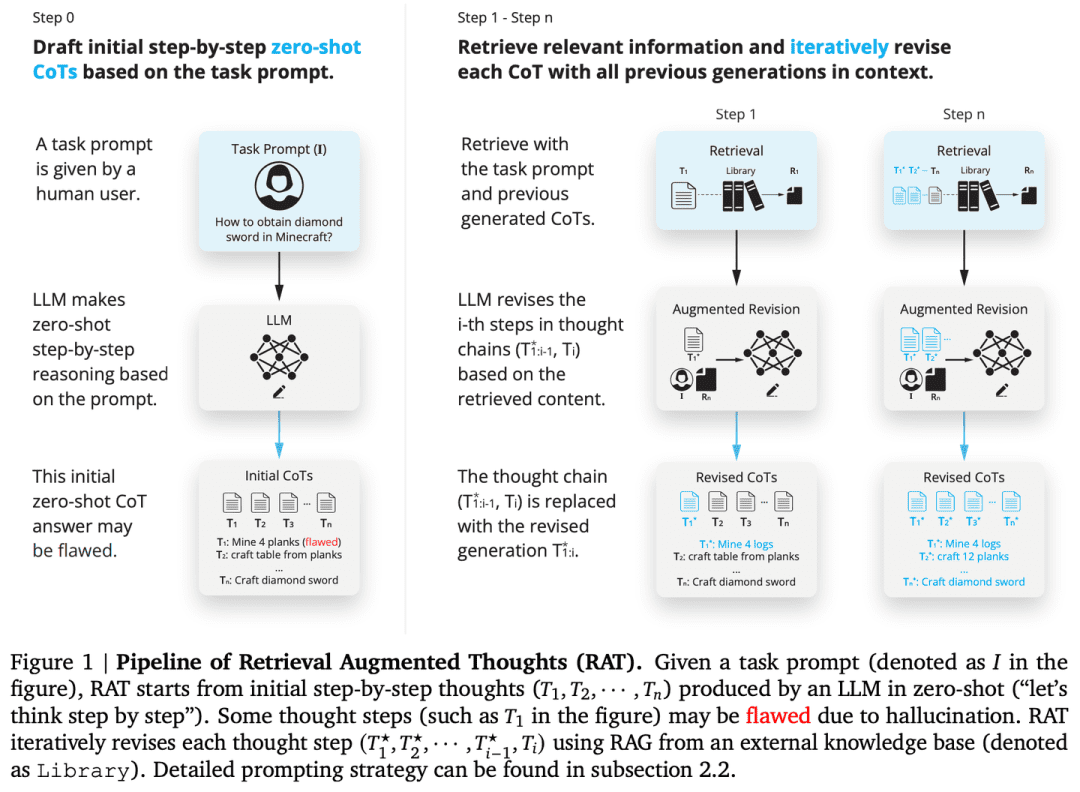

(06) RAT [Pensador]

pensadorComo un tutor reflexivo, en lugar de llegar a una conclusión de golpe, uno tiene pensamientos iniciales y luego utiliza la información relevante recuperada para revisar y refinar continuamente cada paso del proceso de razonamiento para que la cadena de pensamiento sea más tensa y fiable.

- Tesis: RAT: Pensamientos Aumentados de Recuperación Solicitar Razonamiento contextual en la generación de horizontes largos

- Proyecto: https://github.com/CraftJarvis/RAT

RAT (Retrieval Augmented Thinking) Después de generar una cadena de pensamientos (CoT) inicial de muestra cero, cada paso de pensamiento se revisa individualmente utilizando información recuperada relacionada con la consulta de la tarea, los pasos de pensamiento actuales y pasados, y RAT mejora significativamente el rendimiento en una amplia variedad de tareas de generación de tiempo largo.

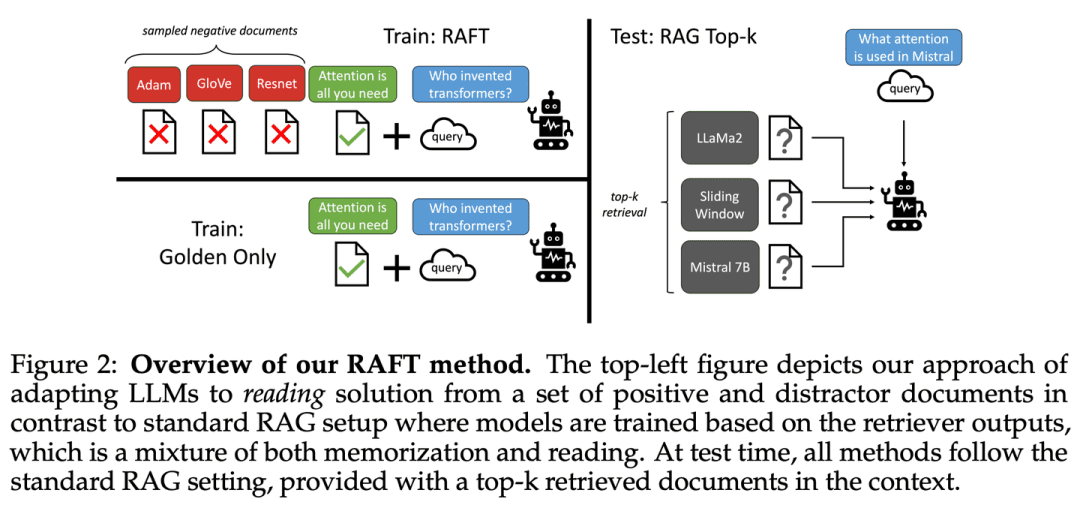

(07) RAFT [Maestro a libro abierto]

maestro de la apertura de librosComo buen candidato, no sólo encontrará las referencias adecuadas, sino que también citará los elementos clave con precisión y explicará el proceso de razonamiento con claridad para que la respuesta esté basada en pruebas y sea sensata.

- Tesis: RAFT: adaptación de un modelo lingüístico a un dominio específico RAG

El objetivo de RAFT es mejorar la capacidad de un modelo para responder a preguntas en un entorno de "libro abierto" específico del dominio, entrenando al modelo para que ignore los documentos irrelevantes y responda a las preguntas citando textualmente las secuencias correctas de los documentos relevantes, lo que, en combinación con las respuestas de encadenamiento de pensamientos, mejora significativamente la capacidad de razonamiento del modelo.

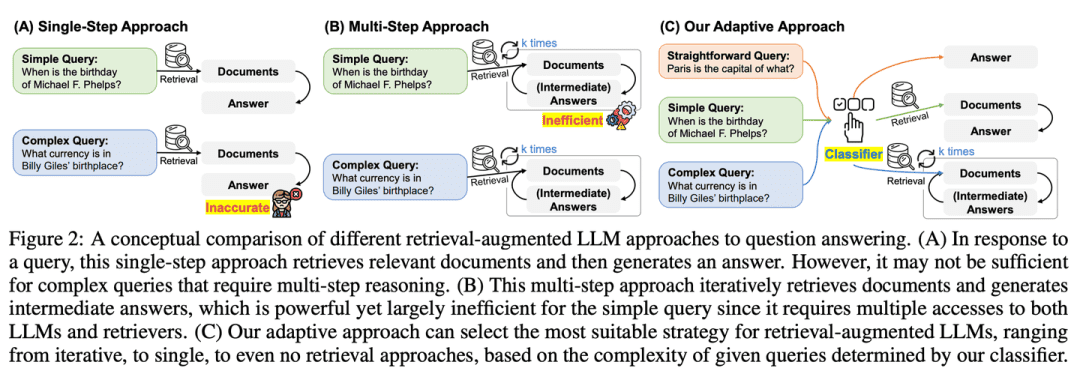

(08) Adaptive-RAG [Llegar a la persona adecuada para el trabajo adecuado].

(modismo) enseñar en función de la capacidad del alumnoAnte preguntas de distinta dificultad, elegirá inteligentemente la respuesta más adecuada. A las preguntas sencillas responderá directamente, mientras que a las preguntas complejas responderá con más información o razonando paso a paso, igual que un profesor experimentado que sabe ajustar el método de enseñanza en función de los problemas específicos de los alumnos.

- Tesis: Adaptive-RAG: Learning to Adapt Retrieval-Augmented Large Language Models through Question Complexity (Adaptación de modelos de lenguaje amplios mejorados mediante recuperación)

- Proyecto: https://github.com/starsuzi/Adaptive-RAG

Adaptive-RAG selecciona dinámicamente la estrategia de mejora de la recuperación más adecuada para el LLM en función de la complejidad de la consulta, seleccionando dinámicamente la estrategia más adecuada para el LLM desde la más sencilla a la más compleja. Este proceso de selección se implementa mediante un pequeño clasificador de modelos lingüísticos que predice la complejidad de la consulta y recoge automáticamente etiquetas para optimizar el proceso de selección. Este enfoque proporciona una estrategia equilibrada que se adapta a la perfección entre los LLM iterativos y los de recuperación mejorada en un solo paso, así como a los métodos sin recuperación para una serie de complejidades de consulta.

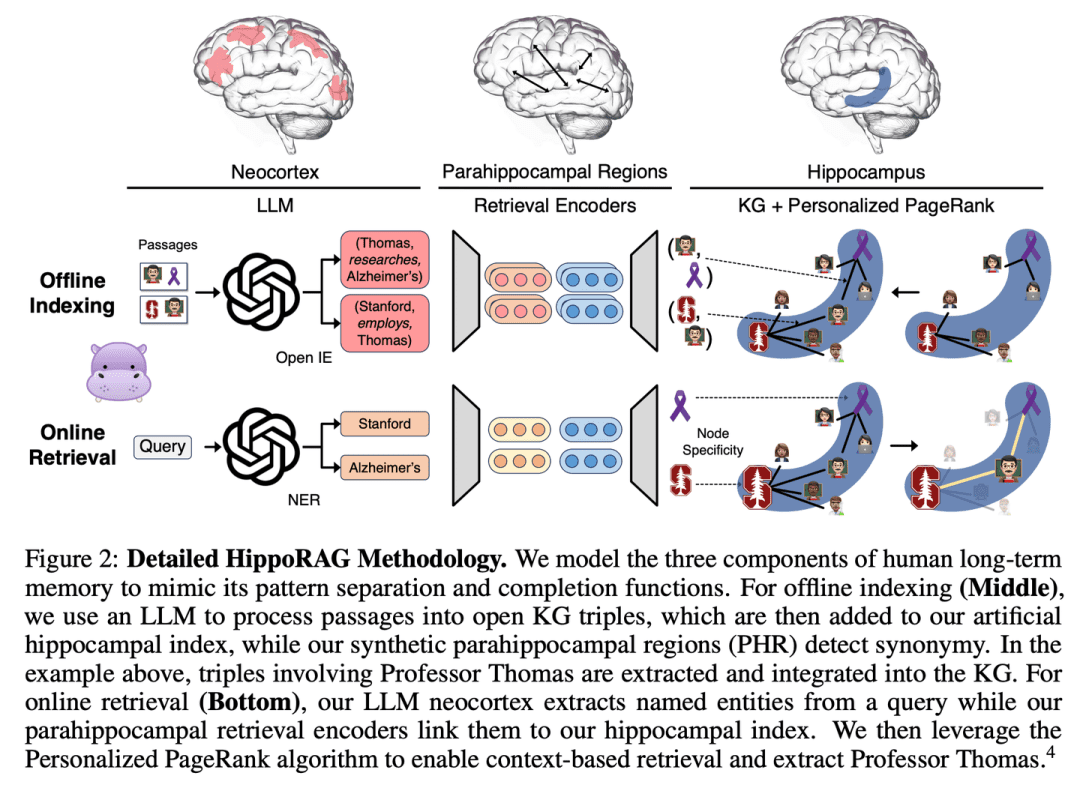

(09) HippoRAG [hipocampo]

hipocampoEl conocimiento: al igual que el cuerpo equino de la mente humana, el conocimiento antiguo y el nuevo se entretejen hábilmente en una red. No se trata simplemente de amontonar información, sino de permitir que cada nuevo conocimiento encuentre su lugar más apropiado.

- Tesis: HippoRAG: memoria a largo plazo de inspiración neurobiológica para grandes modelos lingüísticos

- Proyecto: https://github.com/OSU-NLP-Group/HippoRAG

HippoRAG es un novedoso marco de recuperación inspirado en la teoría de indexación hipocampal de la memoria humana a largo plazo, cuyo objetivo es permitir una integración más profunda y eficiente del conocimiento de nuevas experiencias. HippoRAG orquesta sinérgicamente LLM, grafos de conocimiento y algoritmos PageRank personalizados para imitar las diferentes funciones del neocórtex y el hipocampo en la memoria humana.

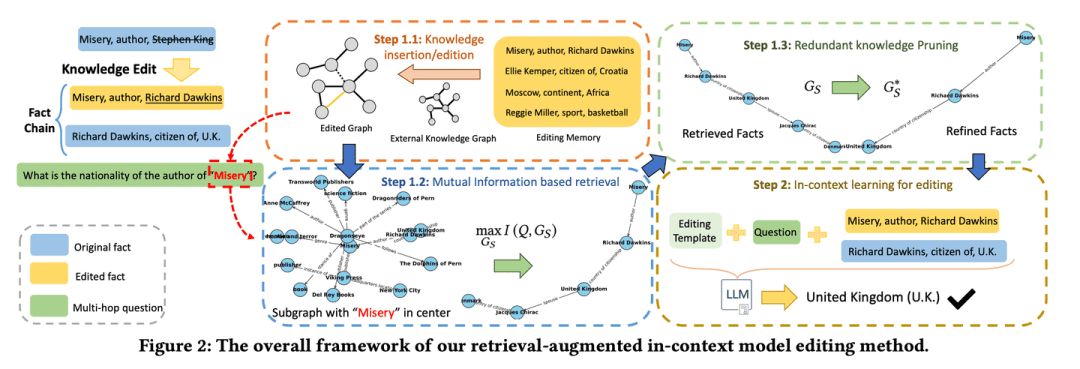

(10) RAE [edición inteligente]

editor inteligente (software)Como un cuidadoso redactor de noticias, no sólo profundizará en los hechos relevantes, sino que también descubrirá la información clave que puede pasarse por alto fácilmente mediante un razonamiento en cadena, y al mismo tiempo sabrá reducir la redundancia, para garantizar que la información final presentada sea a la vez precisa y concisa, y evitar el problema de "hablar mucho pero no ser fiable".

- Tesis: Edición de conocimientos mejorada por recuperación en modelos lingüísticos para la respuesta a preguntas multipunto

- Proyecto: https://github.com/sycny/RAE

RAE (Multi-hop Q&A Retrieval Enhanced Model Editing Framework) recupera primero los hechos editados y luego optimiza el modelo lingüístico mediante el aprendizaje contextual. El enfoque de recuperación basado en la maximización de la información mutua aprovecha la capacidad de razonamiento del gran modelo lingüístico para identificar hechos encadenados que las búsquedas tradicionales basadas en similitudes podrían pasar por alto. Además, el marco incluye una estrategia de poda para eliminar la información redundante de los hechos recuperados, lo que mejora la precisión de la edición y mitiga el problema de la ilusión.

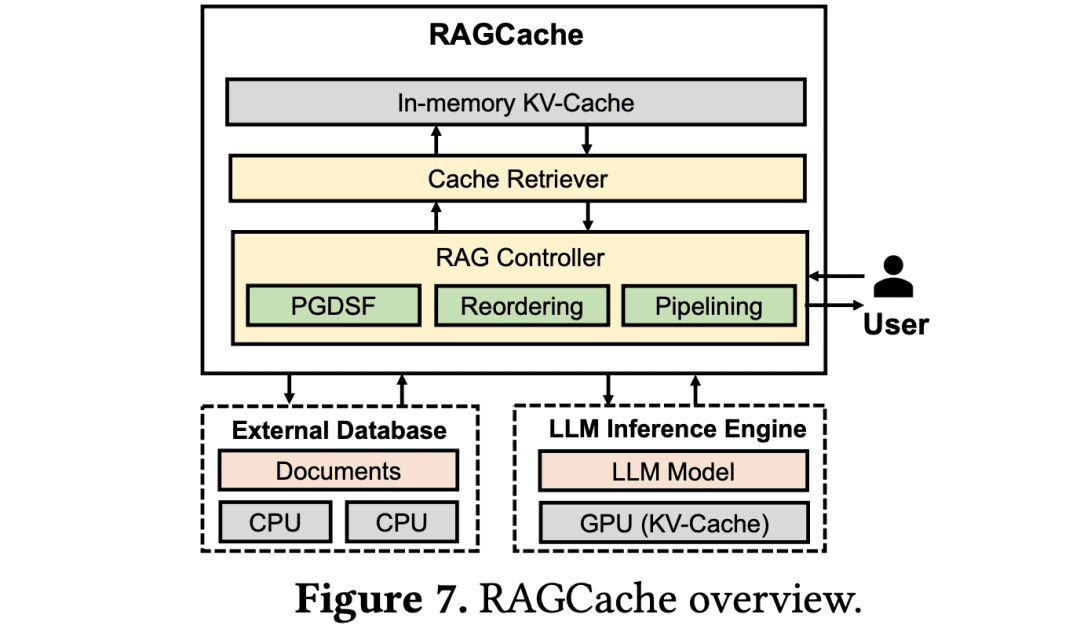

(11) RAGCache [Almacenero]

empleado de almacénComo en un gran centro logístico, coloque los conocimientos de uso frecuente en las estanterías más fáciles de recoger. Saber colocar los paquetes de uso frecuente en la puerta y los de uso infrecuente en los contenedores traseros para maximizar la eficacia de la recogida.

- Tesis: RAGCache: almacenamiento eficiente de conocimientos en caché para una generación mejorada de recuperaciones

RAGCache es un novedoso sistema de caché dinámica multinivel adaptado a RAG que organiza los estados intermedios del conocimiento recuperado en un árbol de conocimiento y los almacena en caché tanto en la GPU como en las jerarquías de memoria del host. RAGCache propone una estrategia de sustitución que tiene en cuenta las características del razonamiento LLM y los patrones de recuperación de RAG. También solapa dinámicamente los pasos de recuperación y razonamiento para minimizar la latencia de extremo a extremo.

(12) GraphRAG [Resumen comunitario]

Resúmenes comunitariosEn primer lugar, se ordena la red de residentes en el barrio y, a continuación, se asigna un perfil a cada círculo del barrio. Cuando alguien pregunta por una dirección, cada círculo del barrio proporciona pistas que finalmente se integran en la respuesta más completa.

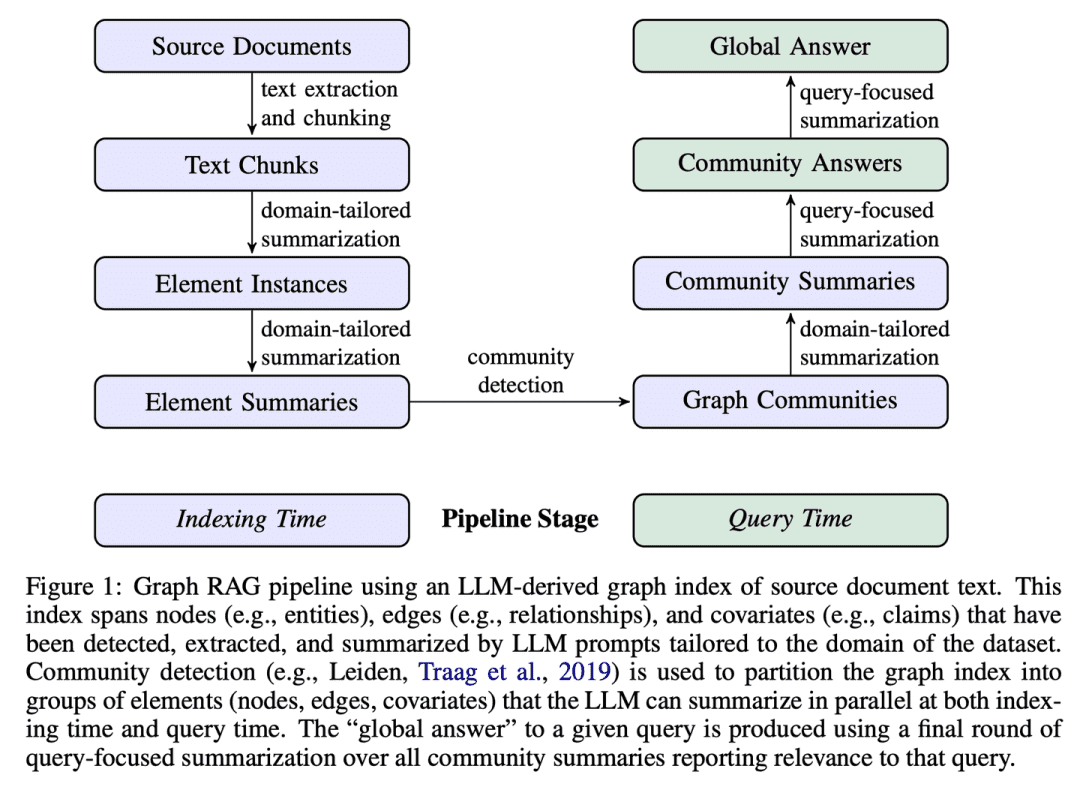

- Tesis: De lo local a lo global: un enfoque gráfico RAG para resumir consultas

- Proyecto: https://github.com/microsoft/graphrag

GraphRAG construye índices de texto basados en grafos en dos etapas: en primer lugar, se obtiene un grafo de conocimiento de entidades a partir de los documentos fuente y, a continuación, se generan previamente resúmenes de comunidad para todos los grupos de entidades estrechamente relacionadas. Ante un problema, cada resumen de comunidad se utiliza para generar una respuesta parcial y, a continuación, todas las respuestas parciales se resumen de nuevo en la respuesta final al usuario.

(13) R4 [Maestro coreógrafo]

maestro arreglistaComo un maestro tipógrafo, se mejora la calidad del resultado optimizando el orden y la presentación del material, haciendo que el contenido esté más organizado y centrado sin tener que cambiar el modelo central.

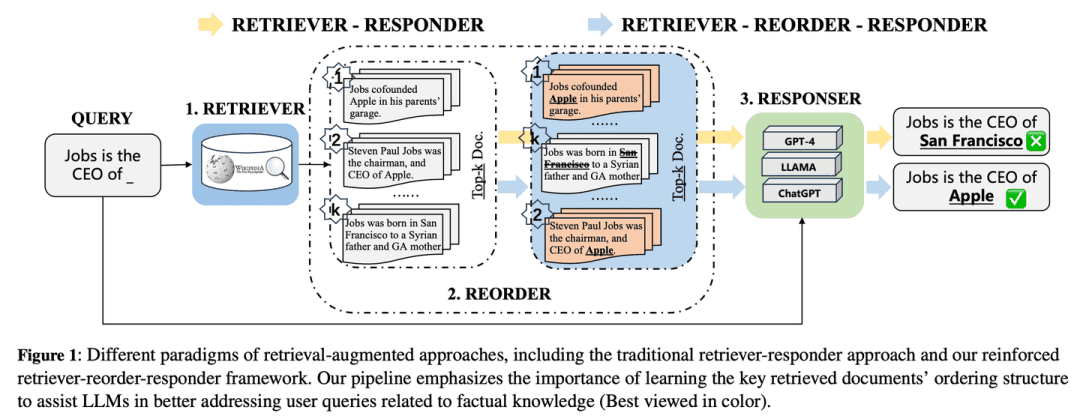

- Tesis: R4: Reinforced Retriever-Reorder-Responder for Retrieval-Augmented Large Language Models (Recuperación-Reorden-Respuesta reforzada para grandes modelos lingüísticos mejorados).

R4 (Reinforced Retriever-Reorder-Responder) se utiliza para aprender el ordenamiento de documentos para un modelo de lenguaje de gran tamaño mejorado para la recuperación, mejorando así aún más las capacidades generativas del modelo de lenguaje de gran tamaño mientras un gran número de sus parámetros permanecen congelados. El proceso de aprendizaje de la reordenación se divide en dos etapas basadas en la calidad de las respuestas generadas: el ajuste del orden de los documentos y la mejora de la representación de los documentos. En concreto, el ajuste del orden de los documentos tiene como objetivo organizar el orden de los documentos recuperados en las posiciones inicial, intermedia y final basándose en el aprendizaje de atención a grafos para maximizar la recompensa de refuerzo por la calidad de la respuesta. La mejora de la representación de los documentos refina aún más las representaciones de los documentos recuperados de las respuestas de baja calidad mediante el aprendizaje adversarial gradiente a nivel de documento.

(14) IM-RAG [hablar solo].

hablar soloCuando se enfrentan a un problema, calculan mentalmente "qué información necesito comprobar" y "¿es suficiente esta información?", y afinan la respuesta mediante un diálogo interno continuo. Esta capacidad de "monólogo" es como la de un experto humano, capaz de pensar en profundidad y resolver problemas complejos paso a paso.

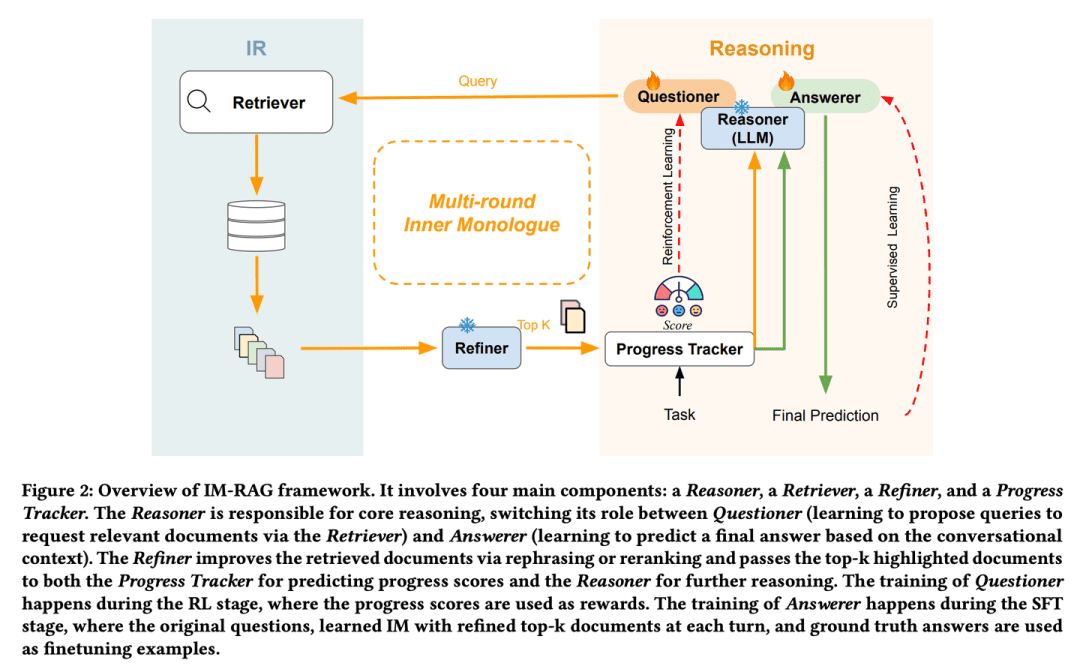

- Tesis: IM-RAG: Multi-Round Retrieval-Augmented Generation Through Learning Inner Monologues (IM-RAG: Generación mejorada por recuperación múltiple mediante el aprendizaje de monólogos internos)

IM-RAG admite múltiples rondas de generación de mejoras de recuperación mediante el aprendizaje de monólogos internos para conectar sistemas de RI con LLM. El enfoque integra el sistema de recuperación de información con grandes modelos lingüísticos para dar soporte a múltiples rondas de generación de mejoras en la recuperación mediante el aprendizaje de monólogos internos. Durante el monólogo interior, el gran modelo lingüístico actúa como modelo de razonamiento central, que puede plantear una consulta a través del recuperador para recabar más información o proporcionar una respuesta final basada en el contexto del diálogo. También introducimos un optimizador que mejora los resultados del recuperador, salvando así las distancias entre el razonador y los módulos de recuperación de información con distintas capacidades y facilitando la comunicación en varias rondas. Todo el proceso del monólogo interno se optimiza mediante el aprendizaje por refuerzo (RL), en el que también se introduce un rastreador de progreso para proporcionar recompensas de pasos intermedios, y las predicciones de respuesta se optimizan individualmente mediante el ajuste fino supervisado (SFT).

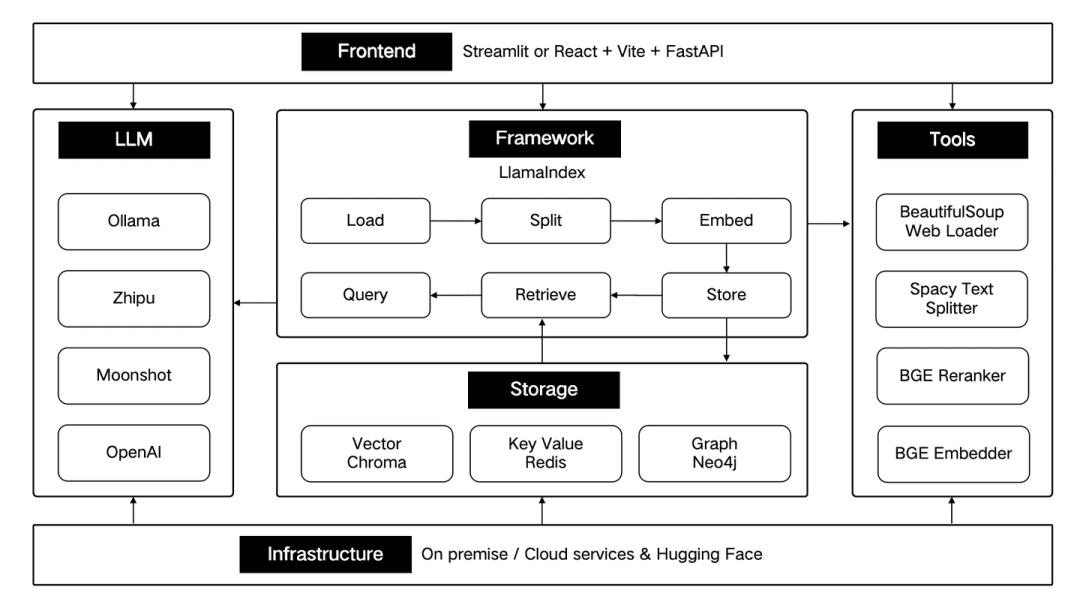

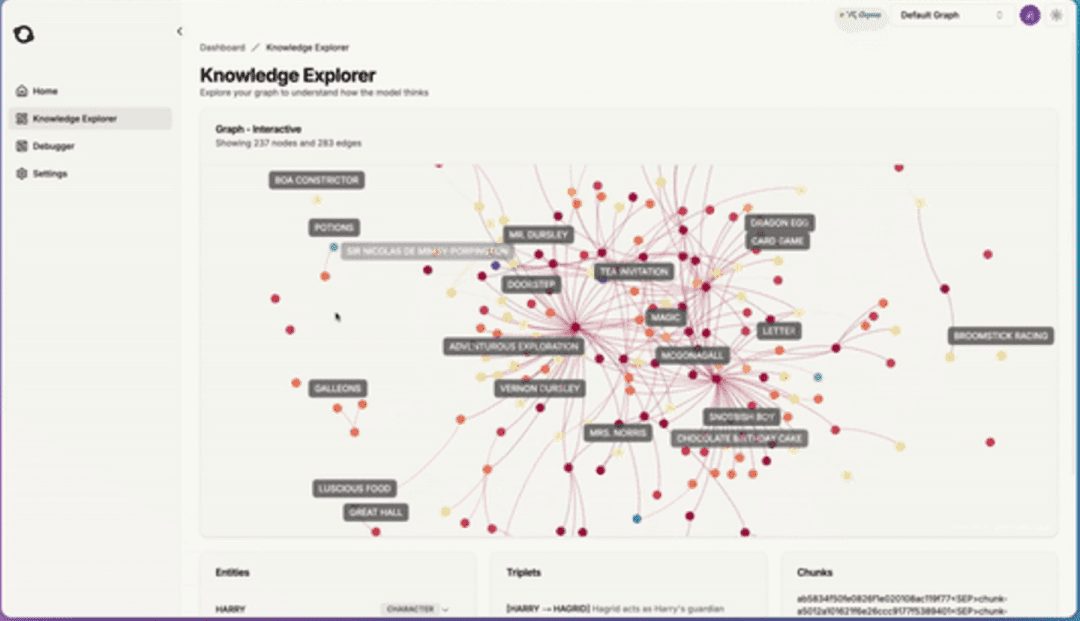

(15) AntGroup-GraphRAG [Cientos de expertos]

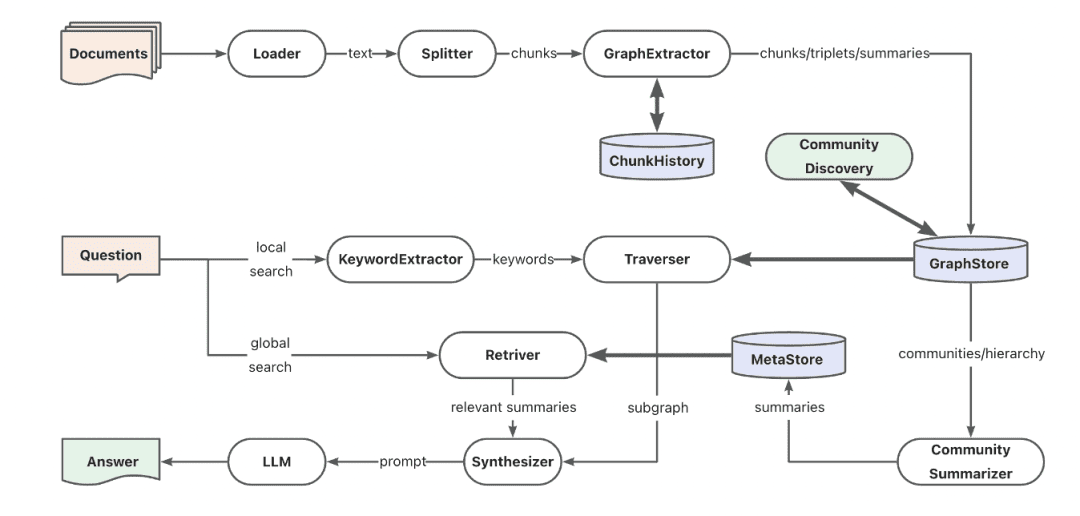

cien escuelas de pensamientoLa empresa reúne lo mejor de lo mejor del sector y se especializa en diversas formas de localizar información rápidamente, proporcionando búsquedas precisas y comprendiendo las consultas en lenguaje natural, lo que hace que las búsquedas de conocimientos complejos sean rentables y eficientes.

- Proyecto: https://github.com/eosphoros-ai/DB-GPT

El equipo de Ant TuGraph construyó el framework de código abierto GraphRAG basado en DB-GPT, que es compatible con una variedad de pedestales de indexación de bases de conocimiento como vector, grafo, texto completo, etc., y soporta extracción de conocimiento de bajo coste, mapeo de estructura de documentos y abstracción de comunidad de grafos con recuperación híbrida para resolver problemas de QFS Q&A. También admite diversas capacidades de recuperación, como palabras clave, vectores y lenguaje natural.

(16) Kotaemon [LEGO]

Lego (juguetes)Un conjunto listo de bloques de construcción de preguntas y respuestas que pueden utilizarse directamente o desmontarse y remodelarse libremente. Los usuarios pueden utilizarlos como deseen y los desarrolladores pueden modificarlos a su gusto.

- Proyecto: https://github.com/Cinnamon/kotaemon

Una interfaz de usuario RAG limpia y personalizable de código abierto para crear y personalizar su propio sistema de preguntas y respuestas sobre documentos. Se tienen en cuenta tanto las necesidades del usuario final como las del desarrollador.

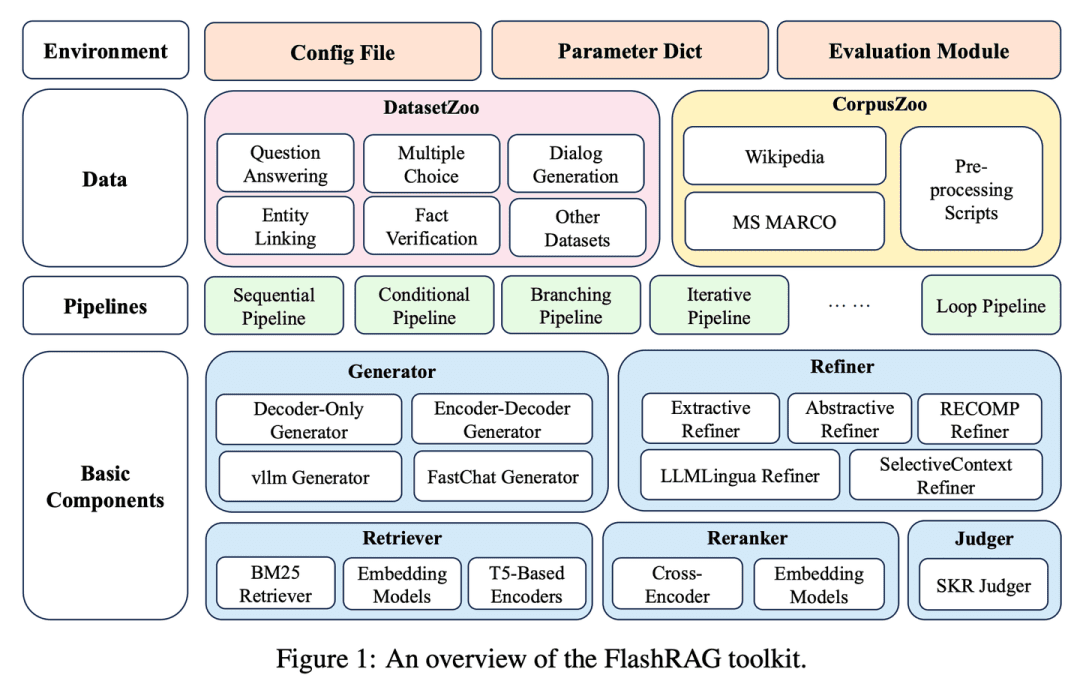

(17) FlashRAG [cofre del tesoro]

cofre del tesoroEmpaquetado de los diversos artefactos del GAR en un conjunto de herramientas que permita a los investigadores construir sus propios modelos de recuperación sobre la marcha, como si se tratara de elegir bloques de construcción.

- Tesis: FlashRAG: A Modular Toolkit for Efficient Retrieval-Augmented Generation Research (en inglés)

- Proyecto: https://github.com/RUC-NLPIR/FlashRAG

FlashRAG es un conjunto de herramientas de código abierto eficiente y modular diseñado para ayudar a los investigadores a reproducir los métodos RAG existentes y desarrollar sus propios algoritmos RAG dentro de un marco unificado. Nuestro kit de herramientas implementa 12 métodos RAG de última generación y recopila y coteja 32 conjuntos de datos de referencia.

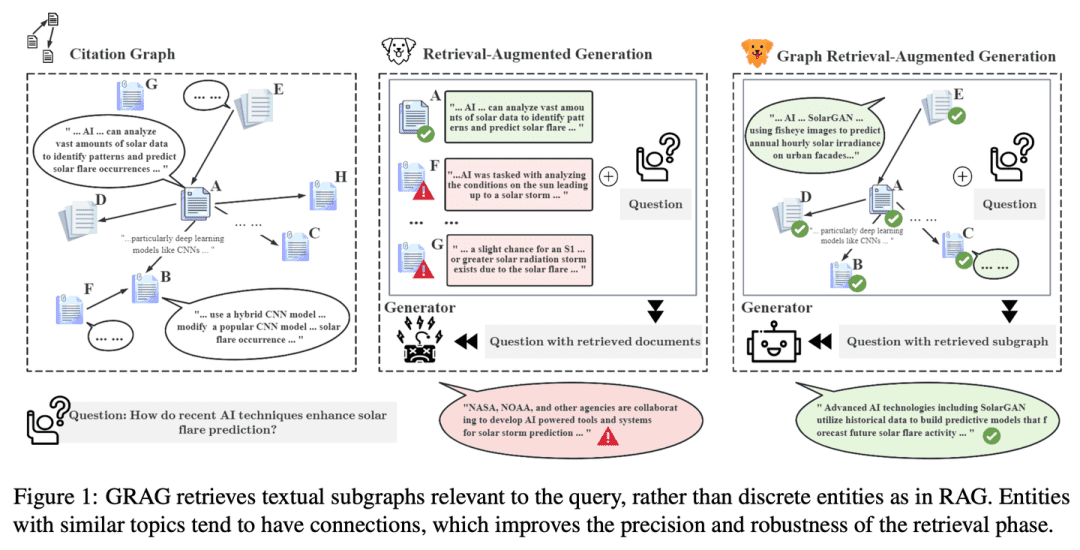

(18) GRAG [Detective]

hacer trabajo detectivesco: No se contenta con pistas superficiales, profundiza en la red de conexiones entre los textos, rastrea la verdad que hay detrás de cada dato como si fuera un crimen para que la respuesta sea más precisa.

- Tesis: GRAG: Graph Retrieval-Augmented Generation (Generación mejorada de recuperación de grafos)

- Proyecto: https://github.com/HuieL/GRAG

Los modelos RAG tradicionales ignoran las conexiones entre textos y la información topológica de la base de datos cuando se trata de datos complejos estructurados en grafos, lo que provoca cuellos de botella en el rendimiento.GRAG mejora significativamente el rendimiento y reduce las ilusiones del proceso de recuperación y generación al hacer hincapié en la importancia de las estructuras de subgrafos.

(19) Camel-GraphRAG [izquierda y derecha].

bofetada con una mano y luego con la otra, en rápida sucesiónUn ojo escanea el texto con Mistral para extraer información y el otro teje una red de relaciones con Neo4j. Al buscar, los ojos izquierdo y derecho trabajan juntos para encontrar similitudes, así como rastrear a lo largo del mapa de pistas, lo que hace que la búsqueda sea más exhaustiva y precisa.

- Proyecto: https://github.com/camel-ai/camel

Camel-GraphRAG se basa en el modelo Mistral para extraer conocimiento de un contenido dado y construir estructuras de conocimiento, almacenando después esta información en una base de datos gráfica Neo4j. A continuación, se utiliza un enfoque híbrido que combina la recuperación de vectores con la recuperación de grafos de conocimiento para consultar y explorar el conocimiento almacenado.

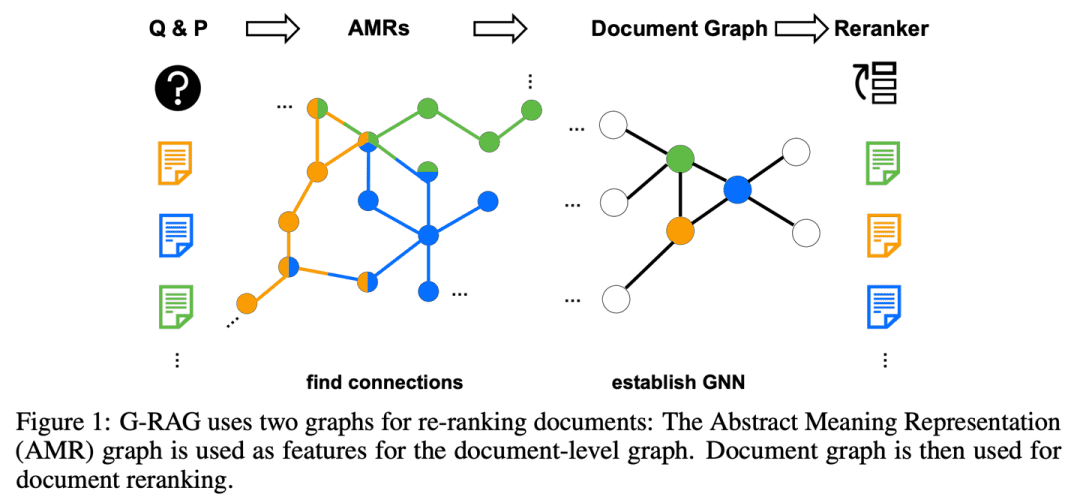

(20) G-RAG [Stringer]

lit. aldaba (modismo); fig. cura milagrosa para los problemas de la genteEn lugar de buscar información en solitario, construyes una red de relaciones para cada punto de conocimiento. Como un socialité, no sólo sabes en qué es bueno cada uno de tus amigos, sino que también sabes quién es amigo de quién, de modo que puedes seguir el rastro directamente cuando buscas respuestas.

- Artículo: No te olvides de conectar: mejora de la RAG con la reordenación basada en gráficos

RAG sigue teniendo dificultades para tratar la relación entre los documentos y el contexto de la pregunta, y el modelo puede no ser capaz de utilizar eficazmente los documentos cuando su relevancia para la pregunta no es obvia o cuando sólo contienen información parcial. Además, la forma de inferir razonablemente las conexiones entre documentos es también una cuestión importante.G-RAG implementa un reordenador basado en una red neuronal de grafos (GNN) entre el recuperador RAG y el lector. El método combina la información de conexión entre documentos y la información semántica (a través de un grafo abstracto de representación semántica) para proporcionar a RAG un clasificador basado en el contexto.

(21) LLM-Graph-Builder [Mover]

un portero: Dar al texto caótico un hogar comprensible. No simplemente llevarlo, sino como una persona obsesivo-compulsiva, etiquetar cada punto de conocimiento, dibujar líneas de relación, y finalmente construir un edificio de conocimiento bien ordenado en la base de datos de Neo4j.

- Proyecto: https://github.com/neo4j-labs/llm-graph-builder

Neo4j código abierto LLM basado en generador de extracción de grafos de conocimiento que puede convertir datos no estructurados en un grafo de conocimiento en Neo4j . Utiliza grandes modelos para extraer nodos , relaciones y sus atributos a partir de datos no estructurados .

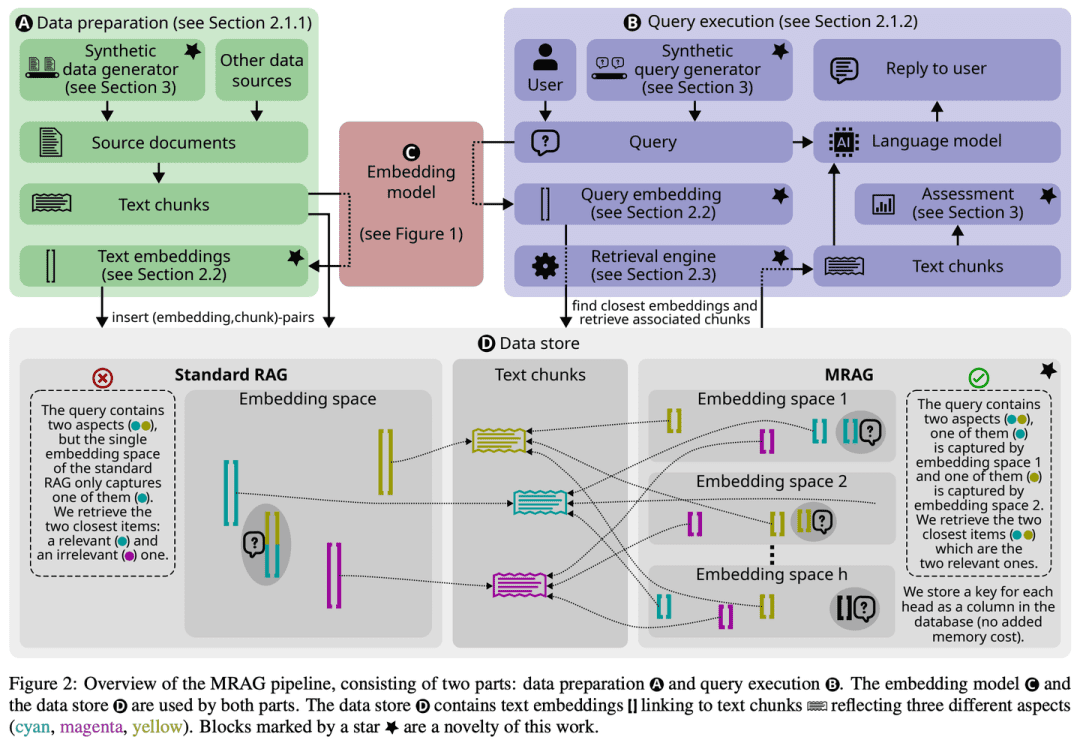

(22) MRAG [Octopus]

pulpoEn lugar de que le crezca una sola cabeza para morir por el problema, le crecen múltiples tentáculos como a un pulpo, y cada tentáculo es responsable de agarrar un ángulo. En pocas palabras, es la versión de la IA de la "multitarea".

- Tesis: RAG multicabezal: resolución de problemas multiaspecto con LLM

- Proyecto: https://github.com/spcl/MRAG

Las soluciones RAG existentes no se centran en las consultas que pueden requerir el acceso a varios documentos con contenidos muy diferentes. Este tipo de consultas son frecuentes, pero resultan complicadas porque las incrustaciones de estos documentos pueden estar muy separadas en el espacio de incrustación, lo que dificulta su recuperación. En este artículo se presenta Multihead RAG (MRAG), un novedoso esquema que pretende colmar esta laguna con una idea sencilla pero poderosa: utilizar la Transformador La activación de una capa de atención multicabezal, en lugar de una capa decodificadora, sirve de clave para captar documentos multifacéticos. La motivación es que distintas cabezas de atención pueden aprender a captar distintos aspectos de los datos. La utilización de las activaciones correspondientes produce incrustaciones que representan elementos de datos y diversos aspectos de la consulta, mejorando así la precisión de recuperación de consultas complejas.

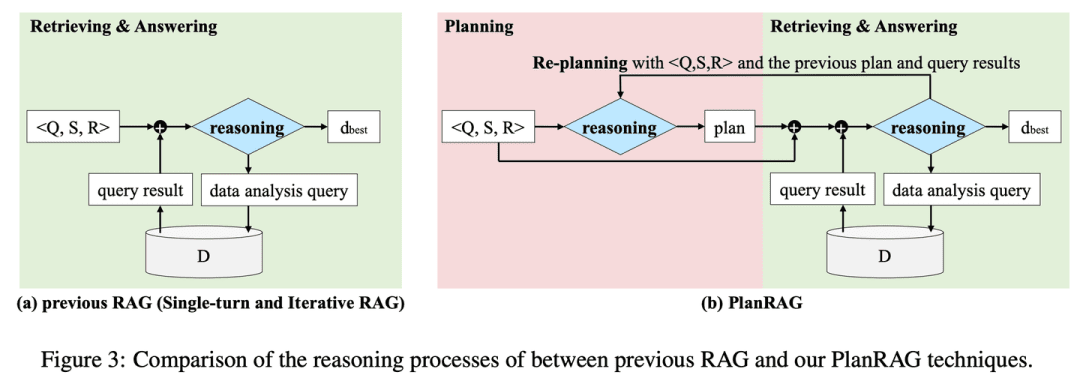

(23) PlanRAG [estratega]

un estrategaSe desarrolla un plan de batalla completo, luego se analiza la situación según las reglas y los datos y, por último, se toman las mejores decisiones tácticas.

- Tesis: PlanRAG: una generación aumentada de planificación y recuperación para modelos generativos de grandes lenguajes que toman decisiones.

- Proyecto: https://github.com/myeon9h/PlanRAG

PlanRAG investiga cómo utilizar modelos lingüísticos a gran escala para resolver problemas de decisión de análisis de datos complejos mediante la definición de la tarea Decision QA, es decir, determinar la mejor decisión basándose en el problema de decisión Q, las reglas de negocio R y la base de datos D. PlanRAG genera primero un plan de decisión y, a continuación, el recuperador genera consultas para el análisis de datos.

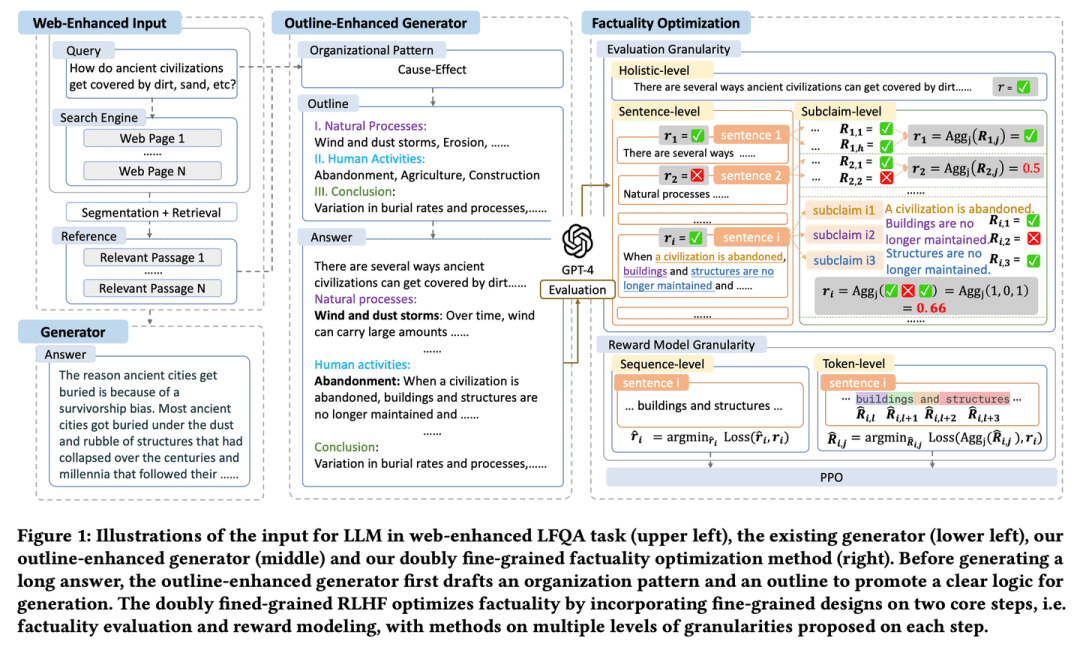

(24) FoRAG [escritor]

escritorEl ensayo se redacta en un esquema que lo enmarca y luego se amplía y perfecciona párrafo a párrafo. También hay un "editor" que ayuda a perfeccionar cada detalle y garantiza la calidad del trabajo mediante una cuidadosa comprobación de los hechos y sugerencias de cambios.

- Tesis: FoRAG: Factuality-optimised Retrieval Augmented Generation for Web-enhanced Long-form Question Answering (Generación aumentada de recuperación optimizada de datos para la respuesta a preguntas largas en la web).

FoRAG propone un novedoso generador de mejora de esquemas, en el que el generador utiliza plantillas de esquemas para redactar esquemas de respuesta basados en la consulta del usuario y el contexto en la primera etapa, y amplía cada punto de vista basándose en el esquema generado en la segunda etapa para construir la respuesta final. También se propone un enfoque de optimización factual basado en un marco RLHF de grano fino doble bien diseñado, que proporciona señales de recompensa más densas mediante la introducción de un diseño de grano fino en los dos pasos centrales de la evaluación factual y el modelado de recompensa.

(25) Multi-Meta-RAG [meta-screener] (meta-screener)

metafiltroAl igual que un gestor de datos experimentado, utiliza múltiples mecanismos de filtrado para localizar el contenido más relevante entre una gran cantidad de información. No se limita a mirar la superficie, sino que analiza las "etiquetas de identidad" (metadatos) de los documentos para cerciorarse de que cada información que encuentra está realmente relacionada con el tema.

- Tesis: Multi-Meta-RAG: mejora de la RAG para consultas multibucle mediante el filtrado de bases de datos con metadatos extraídos de LLM

- Proyecto: https://github.com/mxpoliakov/multi-meta-rag

Multi-Meta-RAG utiliza el filtrado de la base de datos y los metadatos extraídos del LLM para mejorar la selección que hace el GAR de los documentos pertinentes de diversas fuentes que son relevantes para el problema.

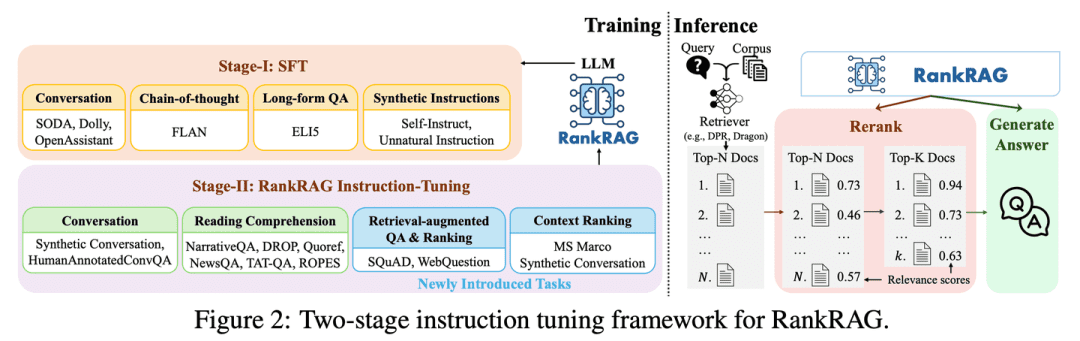

(26) RankRAG [Todoterreno]

todoterrenoCon un poco de entrenamiento, puedes ser a la vez "juez" y "competidor". Como un atleta superdotado, con un poco de entrenamiento puedes superar a los profesionales en múltiples disciplinas y dominar todas tus habilidades.

- Tesis: RankRAG: unificación de la clasificación por contextos con la generación mejorada por recuperación en los LLM

RankRAG ajusta un único LLM con instrucciones para realizar tanto la clasificación contextual como la generación de respuestas. Al añadir una pequeña cantidad de datos de clasificación a los datos de entrenamiento, el LLM afinado con instrucciones funciona sorprendentemente bien e incluso supera a los modelos de clasificación de expertos existentes, incluido el mismo LLM afinado específicamente con una gran cantidad de datos de clasificación. Este diseño no sólo simplifica la complejidad de los modelos múltiples de los sistemas GAR tradicionales, sino que también mejora el juicio de relevancia contextual y la eficacia de la utilización de la información al compartir los parámetros del modelo.

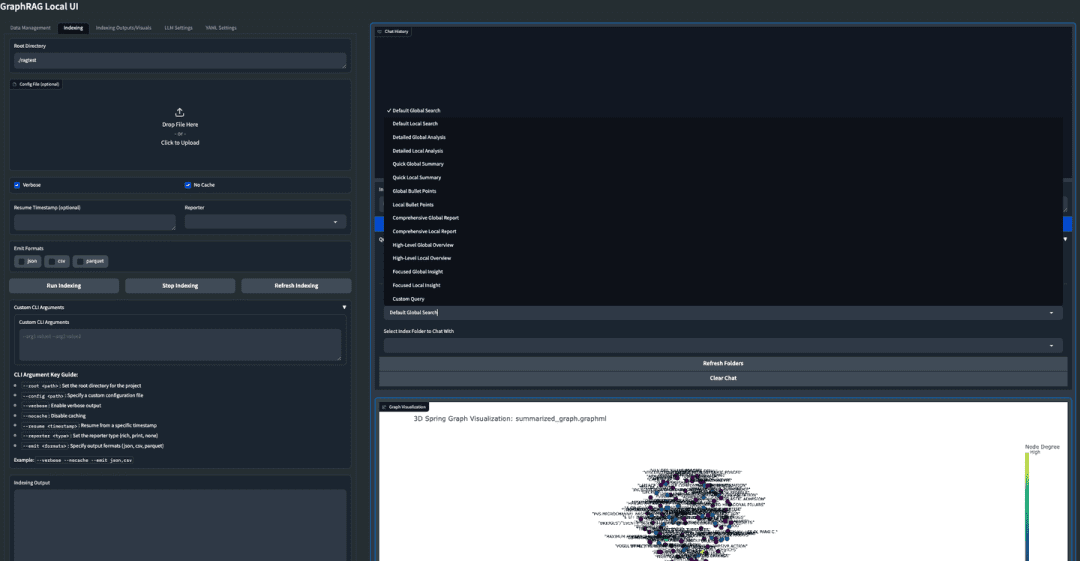

(27) GraphRAG-Local-UI [Modificador]

sintonizador: Convertir un deportivo en un coche práctico para las carreteras locales, con un salpicadero amigable que facilite la conducción a todo el mundo.

- Proyecto: https://github.com/severian42/GraphRAG-Local-UI

GraphRAG-Local-UI es una versión adaptada al modelo local de GraphRAG basado en Microsoft con un rico ecosistema de interfaces de usuario interactivas.

(28) ThinkRAG [secretaria pequeña]

secretario junior: Condensa un enorme corpus de conocimientos en una versión de bolsillo, como una pequeña secretaria de viaje, lista para ayudarle a encontrar respuestas sin necesidad de un gran dispositivo.

- Proyecto: https://github.com/wzdavid/ThinkRAG

El sistema ThinkRAG Big Model Retrieval Enhanced Generation puede implantarse fácilmente en ordenadores portátiles para permitir la interrogación inteligente de bases de conocimiento locales.

(29) Nano-GraphRAG [carga ligera]

lit. empacar liviano e ir a la batalla (modismo); fig. viajar con facilidad: Como un atleta ligeramente armado, se ha simplificado el elaborado equipamiento, pero se han conservado las competencias básicas.

- Proyecto: https://github.com/gusye1234/nano-graphrag

Nano-GraphRAG es un GraphRAG más pequeño, más rápido y más conciso que conserva las funciones básicas.

(30) RAGFlow-GraphRAG [Navegador]

navegante (en avión o barco)El objetivo es: atajar el laberinto de preguntas y respuestas dibujando primero un mapa que marque todos los puntos de conocimiento, eliminando las señales duplicadas y, sobre todo, reduciendo el mapa para que los que pregunten por una dirección no tomen el camino más largo.

- Proyecto: https://github.com/infiniflow/ragflow

RAGFlow se basa en la implementación de GraphRAG para introducir la construcción de grafos de conocimiento como una opción opcional en la fase de preprocesamiento de documentos para servir a los escenarios de QFS Q&A, e introduce mejoras como la desponderación de entidades y la optimización de tokens.

(31) Medical-Graph-RAG [Médico digital]

médico digitalAl igual que un consultor médico experimentado, los complejos conocimientos médicos se organizan de forma clara con diagramas, y las sugerencias de diagnóstico no se hacen de la nada, sino que se justifican, de modo que tanto el médico como el paciente puedan ver el fundamento de cada diagnóstico.

- Tesis: Medical Graph RAG: Towards Safe Medical Large Language Model via Graph Retrieval-Augmented Generation (RAG: hacia un modelo seguro de lenguaje médico extenso mediante la generación mejorada de recuperación de grafos).

- Proyecto: https://github.com/SuperMedIntel/Medical-Graph-RAG

MedGraphRAG es un marco diseñado para abordar los retos que plantea la aplicación de LLM en medicina. Utiliza un enfoque basado en grafos para mejorar la precisión diagnóstica, la transparencia y la integración en los flujos de trabajo clínicos. El sistema mejora la precisión diagnóstica generando respuestas respaldadas por fuentes fiables, abordando la dificultad de mantener el contexto en grandes volúmenes de datos médicos.

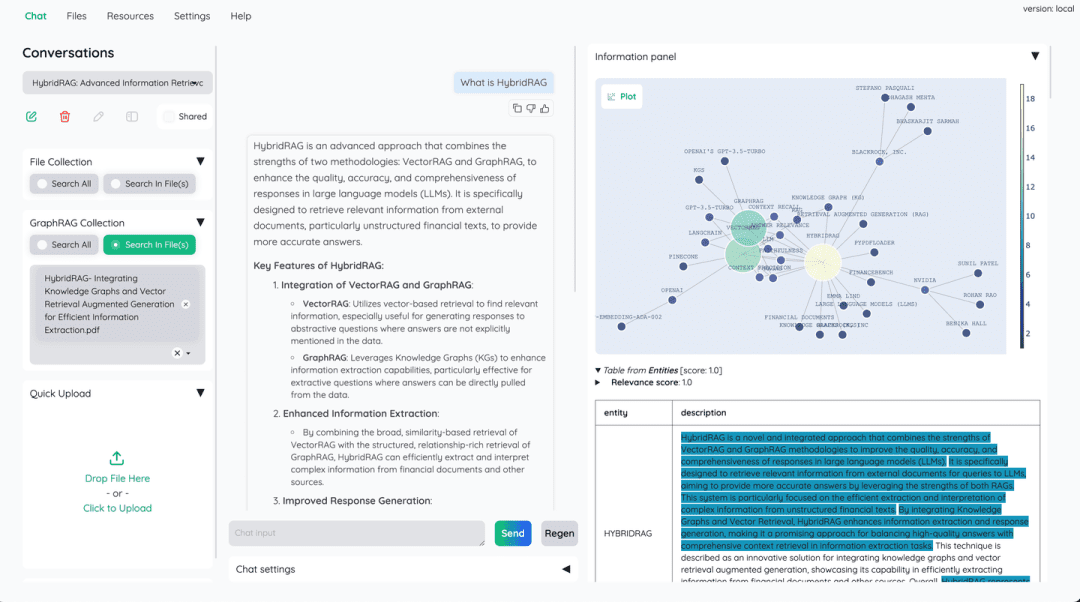

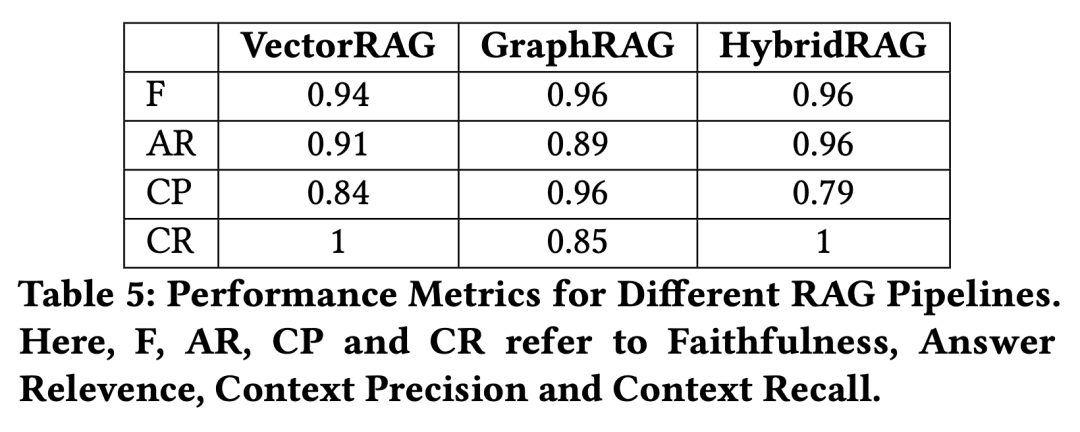

(32) HybridRAG [Fórmulas Combinadas de Medicina China]

Receta de medicina chinaAl igual que la medicina tradicional china (MTC), un solo medicamento no es tan eficaz como la combinación de varios. Las bases de datos vectoriales son responsables de la recuperación rápida, y los grafos de conocimiento complementan la lógica relacional, complementando mutuamente sus puntos fuertes.

- Tesis: HybridRAG: integración de grafos de conocimiento y generación aumentada de vectores de recuperación para la extracción eficiente de información

Se ha demostrado que un nuevo enfoque basado en una combinación de técnicas RAG de grafos de conocimiento (GraphRAG) y técnicas VectorRAG, denominado HybridRAG, para mejorar los sistemas de preguntas y respuestas destinados a extraer información de documentos financieros genera respuestas precisas y contextualmente relevantes. En las fases de recuperación y generación, HybridRAG para recuperar contexto a partir de bases de datos vectoriales y grafos de conocimiento supera a VectorRAG y GraphRAG tradicionales en términos de precisión de recuperación y generación de respuestas.

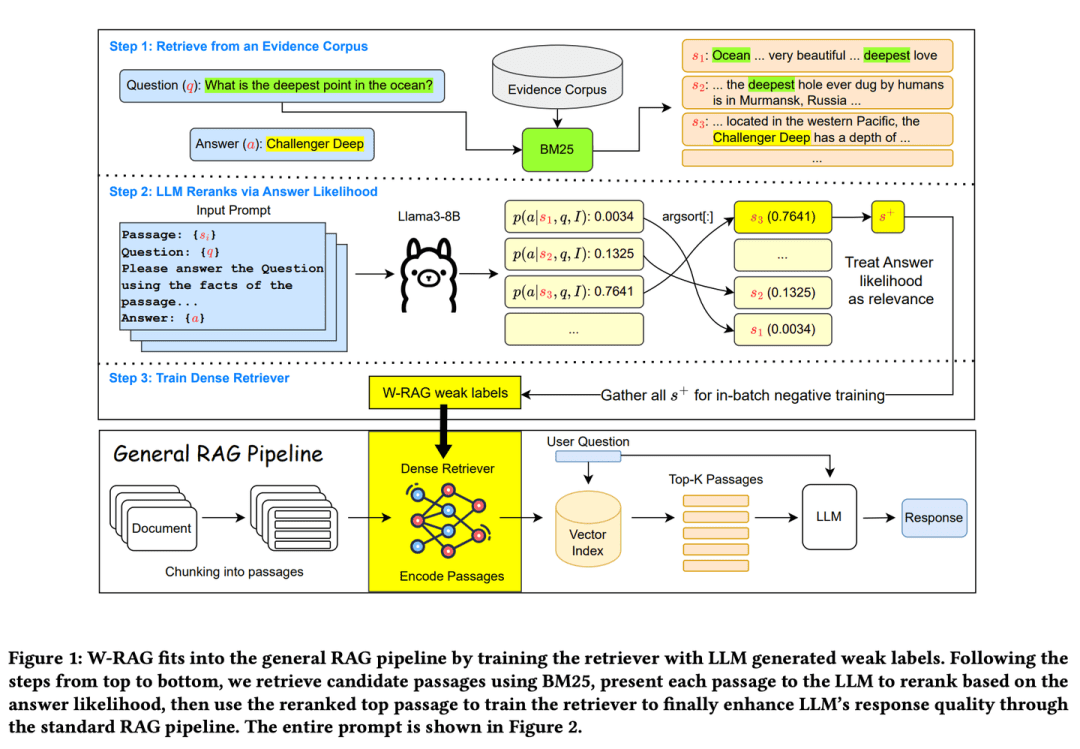

(33) W-RAG [Búsqueda Evolutiva]

Búsqueda de evolución: Como un buen motor de búsqueda autoevolutivo, aprende cuál es una buena respuesta puntuando párrafos de artículos en un gran modelo, mejorando gradualmente su capacidad para encontrar información clave.

- Tesis: W-RAG: Weakly Supervised Dense Retrieval in RAG for Open-domain Question Answering (W-RAG: Recuperación densa débilmente supervisada en RAG para la respuesta a preguntas de dominio abierto).

- Proyecto: https://github.com/jmnian/weak_label_for_rag

Las técnicas de recuperación densa débilmente supervisada en cuestionarios de dominio abierto explotan las capacidades de clasificación de los grandes modelos lingüísticos para crear datos débilmente etiquetados con los que entrenar a los recuperadores densos. Al evaluar la probabilidad de que el gran modelo lingüístico genere la respuesta correcta basándose en la pregunta y en cada párrafo, se calcula la probabilidad de aprobar el cuestionario. BM25 Los K mejores pasajes recuperados se vuelven a clasificar. Los pasajes mejor clasificados se utilizan como ejemplos positivos de entrenamiento para una recuperación intensiva.

(34) RAGChecker [inspector de calidad].

inspector de calidadLa respuesta no es simplemente correcta o incorrecta, sino que será examinada en profundidad, desde la búsqueda de información hasta la generación de la respuesta final, como un estricto examinador, que emitirá un informe de calificación detallado y señalará dónde se necesitan mejoras específicas.

- Tesis: RAGChecker: un marco detallado para diagnosticar la generación mejorada por recuperación

- Proyecto: https://github.com/amazon-science/RAGChecker

La herramienta de diagnóstico de RAGChecker proporciona informes de diagnóstico detallados, exhaustivos y fiables sobre el sistema RAG y ofrece orientaciones prácticas para seguir mejorando el rendimiento. No sólo evalúa el rendimiento global del sistema, sino que también analiza en profundidad el rendimiento de los dos módulos principales, el de recuperación y el de generación.

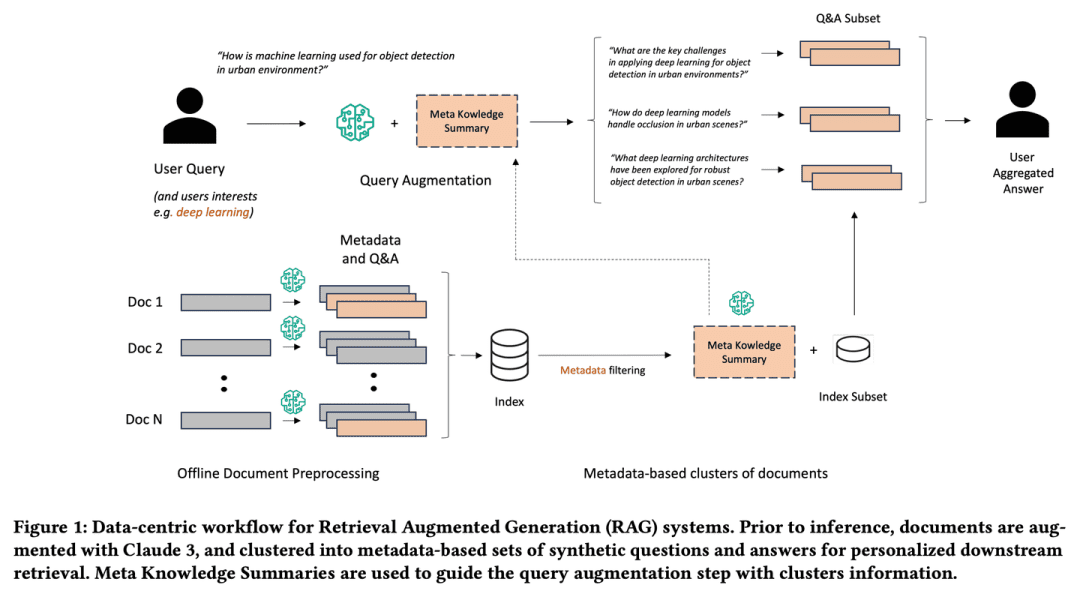

(35) Metaconocimiento-RAG [Scholar]

academiaAl igual que un investigador de alto nivel en el mundo académico, no sólo recopila información, sino que también reflexiona activamente sobre el problema, anota y resume cada documento, e incluso prevé posibles problemas de antemano. Vinculará puntos de conocimiento relacionados entre sí para formar una red de conocimiento, de modo que la consulta adquiera mayor profundidad y amplitud, como si un erudito le ayudara a hacer la revisión de la investigación.

- Tesis: Metaconocimiento para la recuperación de grandes modelos lingüísticos aumentados

Meta-Knowledge-RAG (Resumen MK) introduce un novedoso flujo de trabajo RAG centrado en los datos que transforma el sistema tradicional "recuperar-leer" en un marco más avanzado "preparar-reescribir-recuperar-leer "para lograr una mayor comprensión de la base de conocimientos por parte de los expertos. Nuestro enfoque se basa en la generación de metadatos y preguntas y respuestas sintéticas para cada documento, así como en la introducción de un nuevo concepto de resumen de metaconocimientos para la agrupación de documentos basada en metadatos. Las innovaciones propuestas permiten mejorar las consultas personalizadas de los usuarios y recuperar información en profundidad a través de las bases de conocimiento.

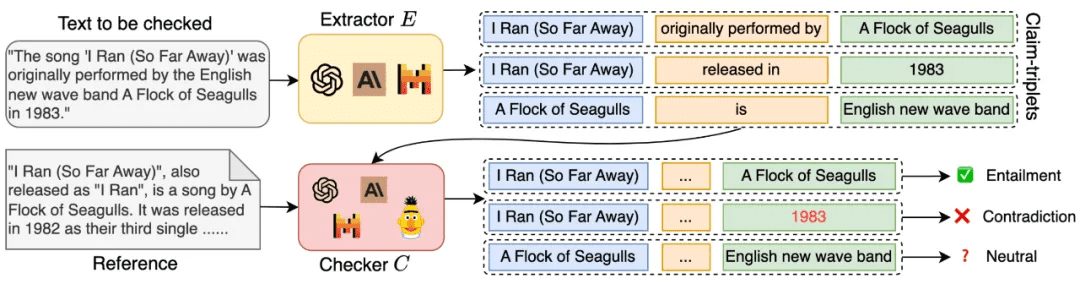

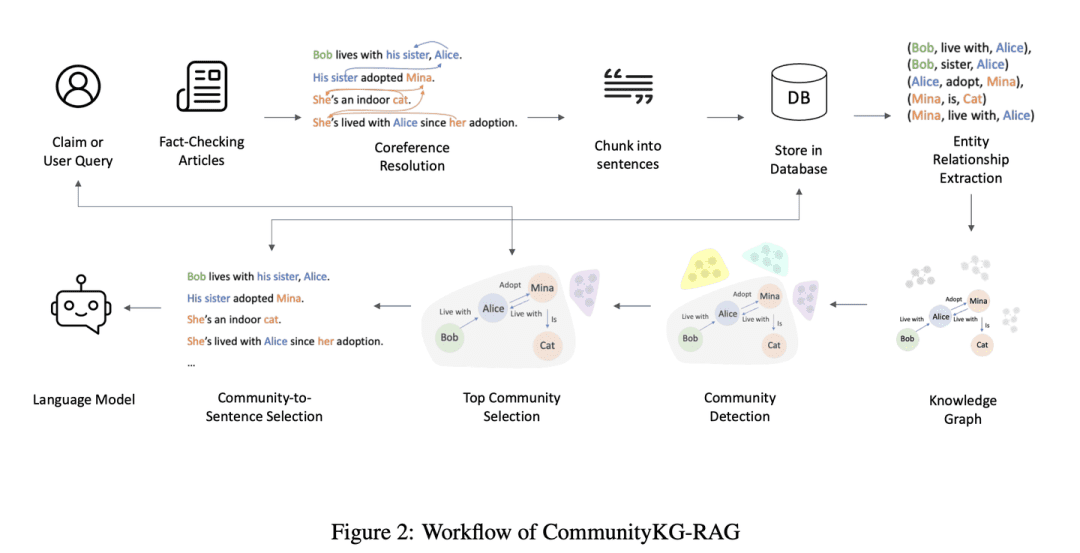

(36) CommunityKG-RAG [Exploración comunitaria]

Exploración de la Comunidad: Como un mago familiarizado con la red de relaciones de la comunidad, es experto en explotar las asociaciones entre los conocimientos y las características del grupo para encontrar información relevante con precisión y verificar su fiabilidad sin necesidad de un estudio especial.

- Tesis: CommunityKG-RAG: Leveraging Community Structures in Knowledge Graphs for Advanced Retrieval-Augmented Generation in Fact- Checking

CommunityKG-RAG es un novedoso marco de trabajo de muestra cero que combina estructuras de comunidad en el grafo de conocimiento con un sistema RAG para mejorar el proceso de comprobación de hechos. CommunityKG-RAG es capaz de adaptarse a nuevos dominios y consultas sin formación adicional, y explota la naturaleza multisalto de las estructuras de comunidad en el grafo de conocimiento para mejorar significativamente la precisión y la relevancia de la recuperación de información. relevancia.

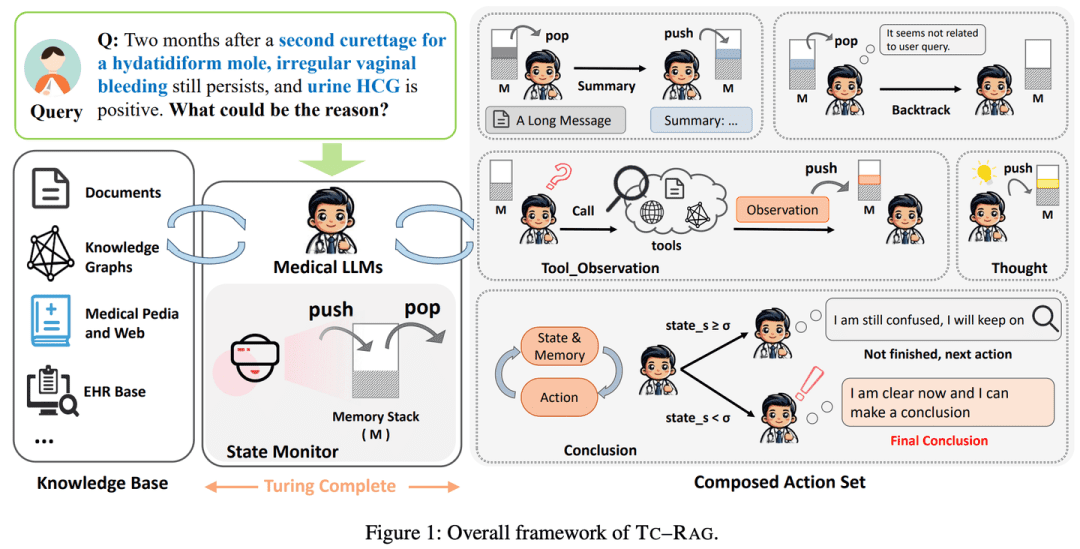

(37) TC-RAG [Brujo de la Memoria]

artista mnemotécnico: Pon un cerebro con función de auto-limpieza en LLM. Igual que resolvemos problemas, escribiremos los pasos importantes en el borrador del papel y los tacharemos cuando hayamos terminado. No es aprendizaje memorístico, recuerda lo que debe recordar y vacía lo que debe olvidar a tiempo, como un matón de colegio que puede limpiar su habitación.

- Tesis: TC-RAG: Caso práctico de RAG Turing-Completo en sistemas médicos LLM

- Proyecto: https://github.com/Artessay/TC-RAG

Al introducir un sistema Turing-completo para gestionar las variables de estado, se consigue una recuperación del conocimiento más eficaz y precisa. Al utilizar un sistema de pila de memoria con capacidades adaptativas de recuperación, razonamiento y planificación, TC-RAG no sólo garantiza la detención controlada del proceso de recuperación, sino que también mitiga la acumulación de conocimientos erróneos mediante operaciones Push y Pop.

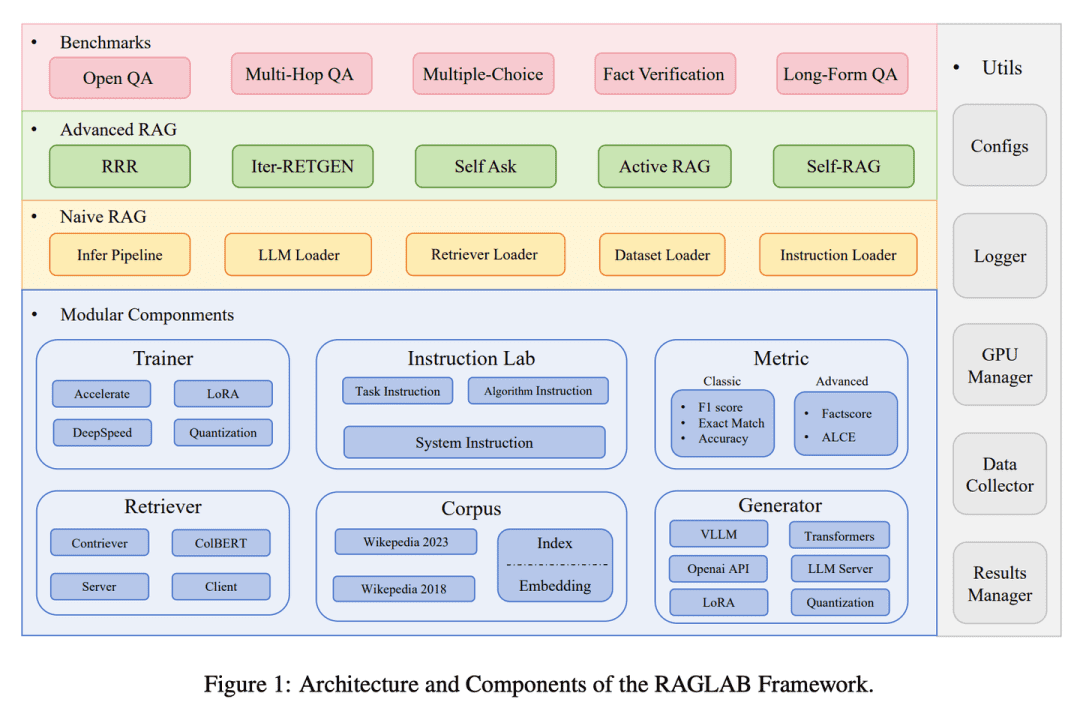

(38) RAGLAB [Arena]

arenaEl hecho de permitir que los algoritmos compitan y se comparen equitativamente bajo las mismas reglas, como un proceso de pruebas normalizado en un laboratorio científico, garantiza que cada nuevo método se evalúe de forma objetiva y transparente.

- Tesis: RAGLAB: A Modular and Research-Oriented Unified Framework for Retrieval-Augmented Generation (RAGLAB: un marco unificado modular y orientado a la investigación para la generación mejorada de recuperaciones).

- Proyecto: https://github.com/fate-ubw/RAGLab

Existe una creciente falta de comparaciones exhaustivas y justas entre los nuevos algoritmos RAG, y la abstracción de alto nivel de las herramientas de código abierto conduce a una falta de transparencia y limita la capacidad de desarrollar nuevos algoritmos y métricas de evaluación.RAGLAB es una biblioteca modular, orientada a la investigación y de código abierto que reproduce los 6 algoritmos y construye un ecosistema de investigación integral. Con RAGLAB, comparamos los 6 algoritmos de forma equitativa en 10 puntos de referencia, lo que ayuda a los investigadores a evaluar e innovar algoritmos de forma eficiente.

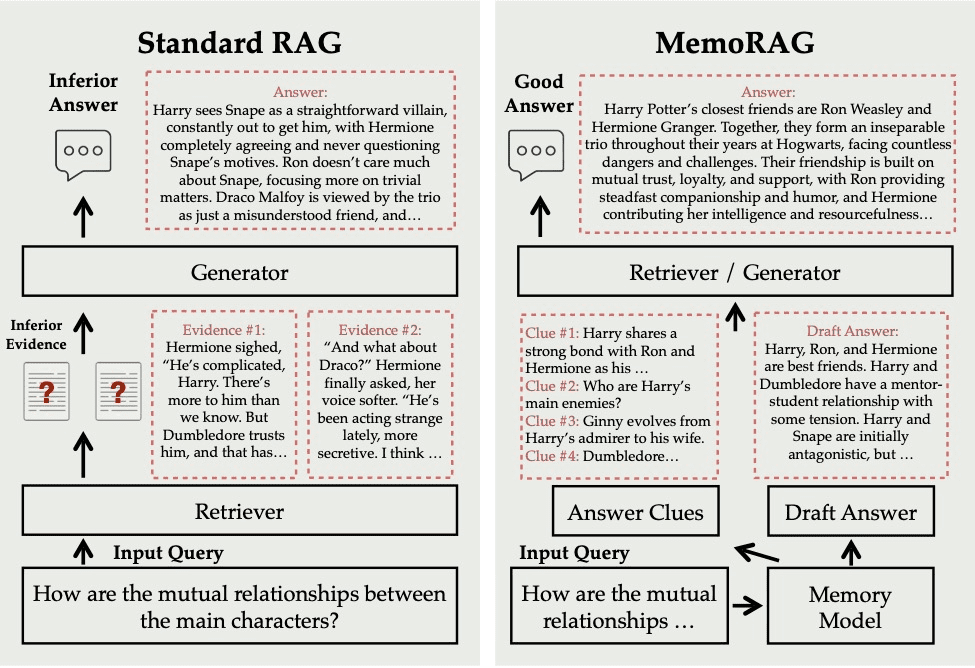

(39) MemoRAG.

tienen una memoria muy retentivaNo se limita a buscar información bajo demanda, sino que tiene toda la base de conocimientos profundamente comprendida y memorizada. Cuando le haces una pregunta, extrae rápidamente los recuerdos relevantes de este "supercerebro" y te da una respuesta precisa y perspicaz, como un experto.

- Proyecto: https://github.com/qhjqhj00/MemoRAG

MemoRAG es un innovador marco de Generación Aumentada de Recuperación (RAG) construido sobre un eficiente modelo de memoria ultralarga. A diferencia de los RAG estándar, que se ocupan principalmente de consultas con necesidades explícitas de información, MemoRAG utiliza su modelo de memoria para lograr una comprensión global de toda la base de datos. MemoRAG recupera de la memoria pistas específicas para cada consulta, lo que mejora la recuperación de pruebas y permite generar respuestas más precisas y contextualizadas.

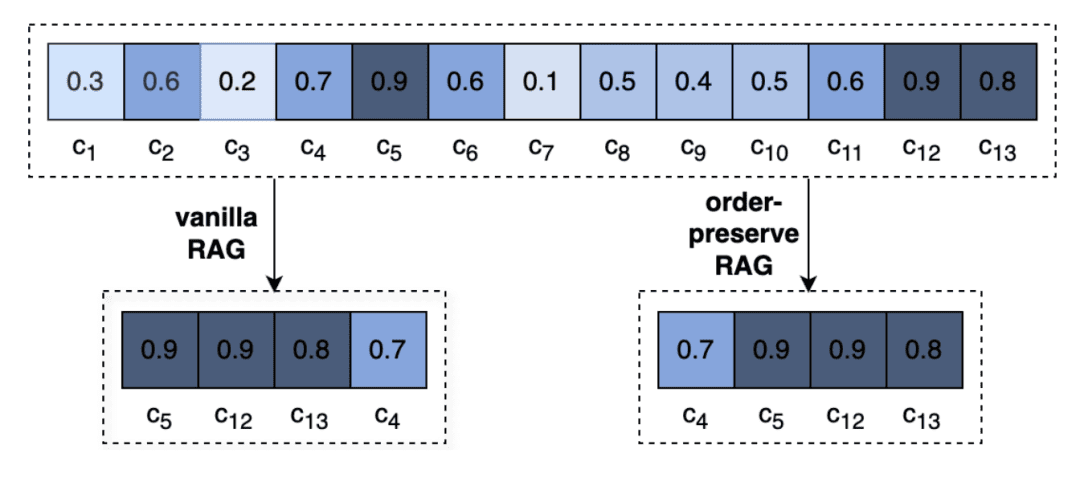

(40) OP-RAG [gestión de la atención]

Gestión de la atenciónEs como leer un libro especialmente grueso, es imposible recordar todos los detalles, pero los que saben marcar los capítulos clave son los maestros. No es leer sin rumbo, sino como un lector experto, mientras lee y anota los puntos clave, cuando lo necesita, pasa directamente a la página marcada.

- Tesis: En defensa de la RAG en la era de los modelos lingüísticos de contexto largo

Los contextos extremadamente largos de las LLM reducen la atención prestada a la información relevante y pueden degradar la calidad de las respuestas. Revisando la RAG en la generación de respuestas de contexto largo, proponemos un mecanismo de generación mejorado de recuperación que preserva el orden, OP-RAG, que mejora significativamente el rendimiento de la RAG en aplicaciones de preguntas y respuestas de contexto largo.

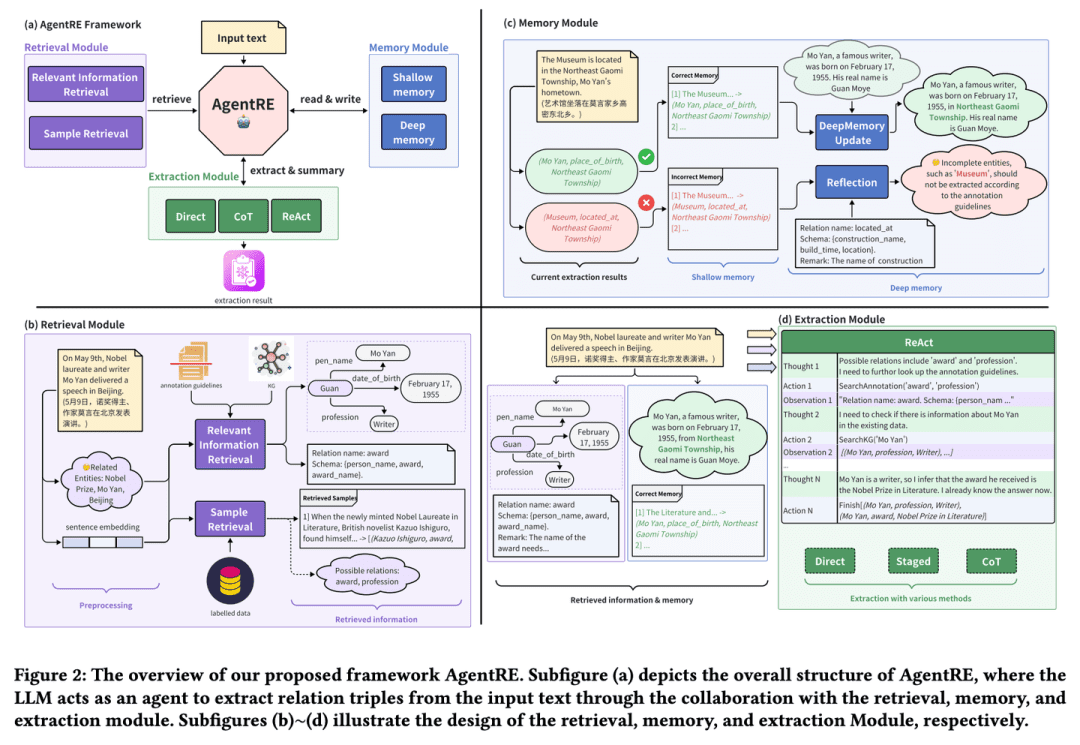

(41) AgenteRE [Extracción Inteligente]

Extracción inteligenteComo un sociólogo al que se le da bien observar las relaciones, no sólo recuerda la información clave, sino que toma la iniciativa de comprobarla y reflexionar sobre ella en profundidad, para comprender con precisión la compleja red de relaciones. Incluso ante relaciones complejas, es capaz de analizarlas desde múltiples perspectivas para darles sentido y evitar leer en ellas.

- Tesis: AgentRE: An Agent-Based Framework for Navigating Complex Information Landscapes in Relation Extraction (AgentRE: un marco basado en agentes para navegar por paisajes informativos complejos en la extracción de relaciones)

- Proyecto: https://github.com/Lightblues/AgentRE

Al integrar las capacidades de memoria, recuperación y reflexión de los modelos lingüísticos a gran escala, AgentRE aborda con eficacia los retos que plantean los diversos tipos de relaciones en la extracción de relaciones de escenas complejas y las relaciones ambiguas entre entidades de una misma frase.AgentRE consta de tres módulos principales que permiten a los agentes adquirir y procesar información de forma eficiente, y mejorar significativamente el rendimiento de RE.

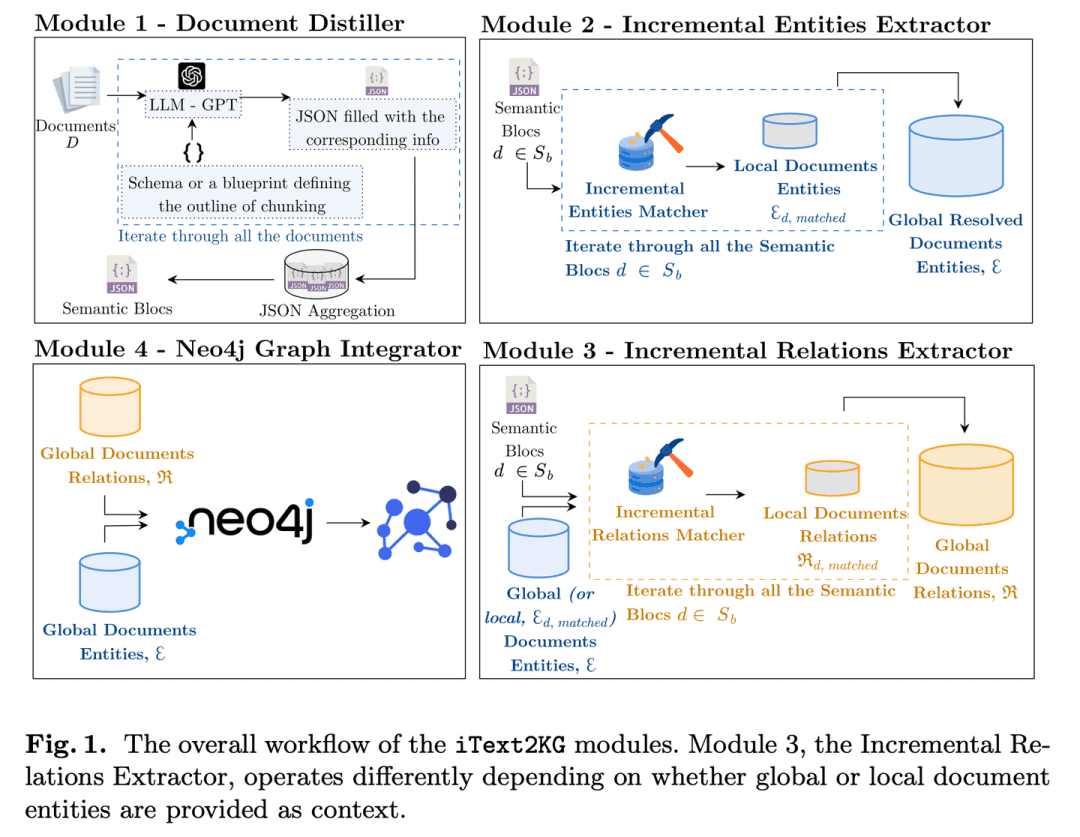

(42) iText2KG [Arquitecto]

arquitectos: Al igual que un ingeniero organizado, transforma gradualmente los documentos fragmentados en una red sistemática de conocimientos mediante el perfeccionamiento, la extracción y la integración de la información por etapas, y no requiere la preparación previa de planos arquitectónicos detallados, sino que puede ampliarse y mejorarse con flexibilidad según las necesidades.

- Tesis: iText2KG: construcción incremental de grafos de conocimiento mediante grandes modelos lingüísticos

- Proyecto: https://github.com/AuvaLab/itext2kg

iText2KG (Incremental Knowledge Graph Construction) utiliza grandes modelos lingüísticos (LLM) para construir grafos de conocimiento a partir de documentos sin procesar y permite la construcción incremental de grafos de conocimiento a través de cuatro módulos (refinador de documentos, extractor incremental de entidades, extractor incremental de relaciones e integrador de grafos) sin necesidad de definir ontologías previamente ni de una amplia formación supervisada.

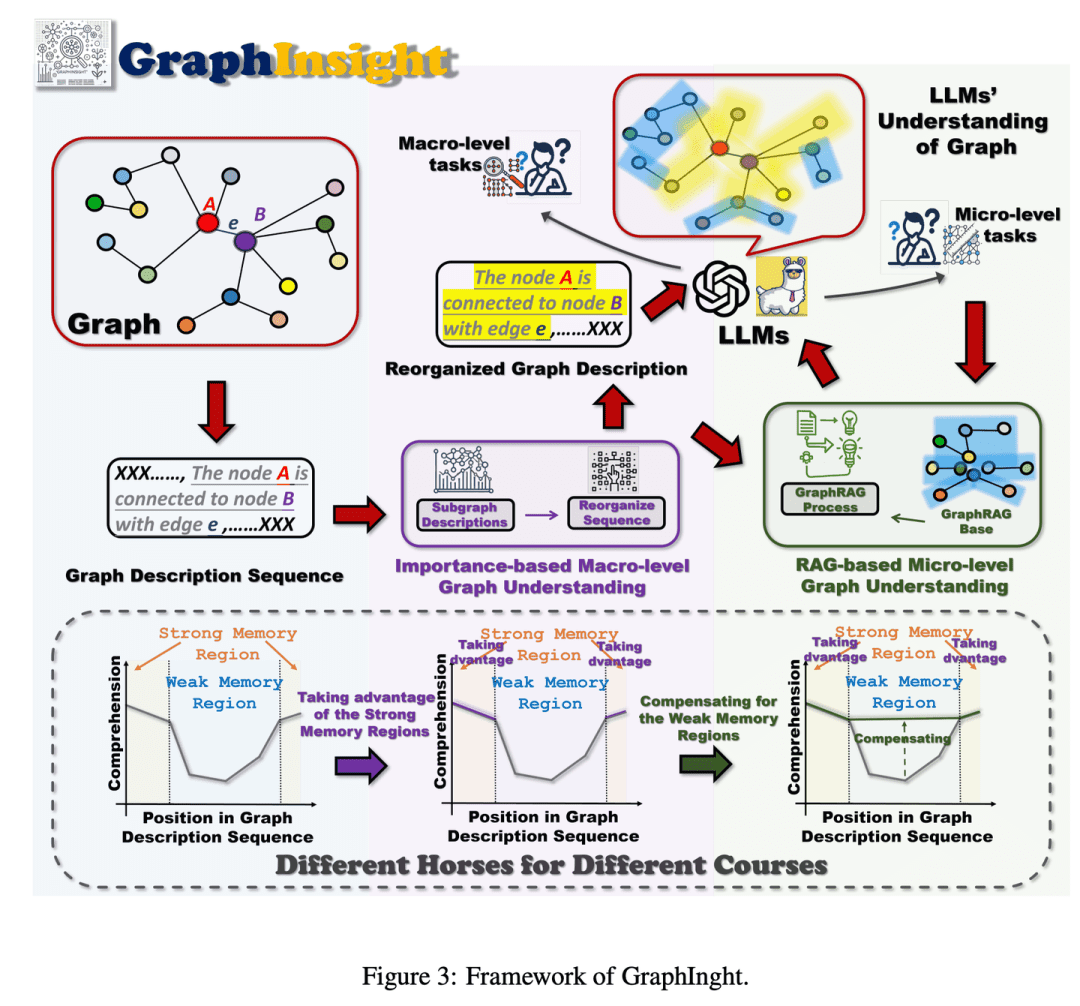

(43) GraphInsight [interpretación gráfica]

interpretación del atlasComo experto en el análisis de infografías, sabiendo colocar la información importante en los lugares más destacados, consultando al mismo tiempo las referencias para añadir detalles cuando sea necesario, y razonando paso a paso a través de gráficos complejos para que la IA capte el panorama general sin perderse los detalles.

- Tesis: GraphInsight: Unlocking Insights in Large Language Models for Graph Structure Understanding (en inglés)

GraphInsight se basa en dos estrategias clave: 1) situar la información clave de los grafos en lugares donde los LLM tengan un buen rendimiento de memoria, y 2) introducir bases de conocimiento externas ligeras para las regiones con un rendimiento de memoria débil, basándose en la idea de la Generación Aumentada de Recuperación (RAG). Además, GraphInsight explora la integración de estas dos estrategias en el proceso del agente LLM para tareas de grafos compuestos que requieren un razonamiento en varios pasos.

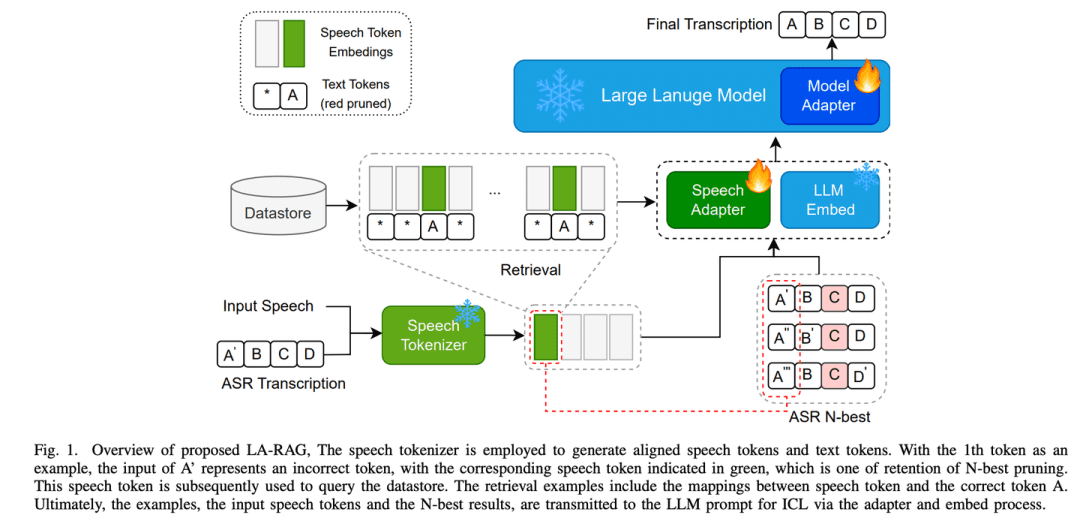

(44) LA-RAG [Paso dialectal]

libro de dialectoLa inteligencia artificial, al igual que un lingüista versado en los dialectos de distintos lugares, puede identificar con precisión no sólo el mandarín estándar, sino también entender acentos con características locales mediante un meticuloso análisis del habla y la comprensión contextual, lo que le permite comunicarse con personas de distintas regiones sin barreras.

- Tesis: LA-RAG: Mejora de la precisión de la ASR basada en LLM con generación mejorada de la recuperación

LA-RAG, un nuevo paradigma de Generación Aumentada de Recuperación (RAG) para la ASR basada en LLM. LA-RAG utiliza mecanismos de recuperación de voz a voz y almacenamiento de datos de voz a nivel de token de granularidad fina para mejorar la precisión de la ASR mediante la funcionalidad de Aprendizaje Contextual LLM (ICL).

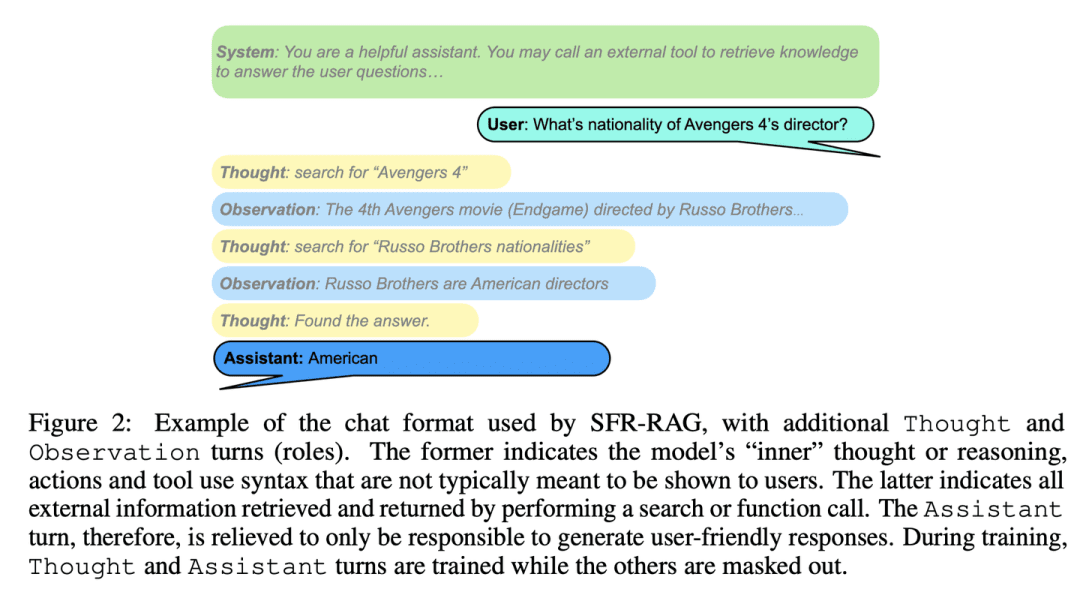

(45) SFR-RAG [búsqueda avanzada]

Búsqueda simplificada: Como un refinado asesor de referencia, pequeño en tamaño pero preciso en su función, comprende las necesidades y sabe cómo buscar ayuda externa, garantizando que las respuestas sean a la vez precisas y eficaces.

- Tesis: SFR-RAG: Hacia un LLM fiel al contexto

SFR-RAG es un pequeño modelo de lenguaje afinado con instrucciones centradas en la generación basada en el contexto y en minimizar las ilusiones. Al centrarse en reducir el número de argumentos manteniendo un alto rendimiento, el modelo SFR-RAG incluye funciones de llamada a funciones que le permiten interactuar dinámicamente con herramientas externas para recuperar información contextual de alta calidad.

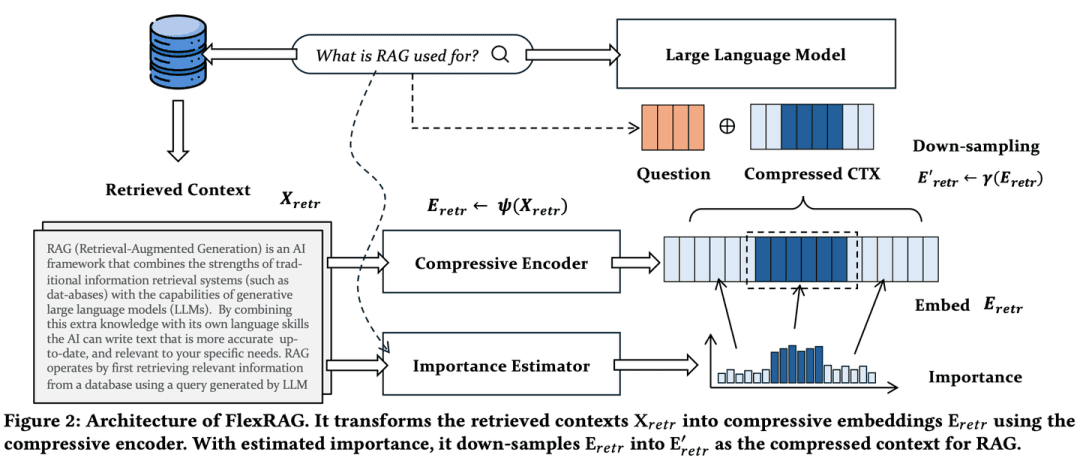

(46) FlexRAG [Experto en compresión]

Especialista en compresiónComprimir un discurso largo en un resumen conciso: la relación de compresión puede ajustarse con flexibilidad en función de las necesidades, de modo que no se pierda la información clave y se ahorren costes de almacenamiento y procesamiento. Es como convertir un libro grueso en una nota de lectura concisa.

- Tesis: Más ligero y mejor: hacia una adaptación flexible del contexto para una generación de recuperación aumentada

El contexto recuperado por FlexRAG se comprime en incrustaciones compactas antes de ser codificado por los LLM. Al mismo tiempo, estas incrustaciones comprimidas se optimizan para mejorar el rendimiento de las RAG posteriores. Una característica clave de FlexRAG es su flexibilidad para admitir eficazmente distintos ratios de compresión y retener de forma selectiva los contextos importantes. Gracias a estos diseños técnicos, FlexRAG consigue una calidad de generación superior al tiempo que reduce significativamente los costes operativos. Experimentos exhaustivos con diversos conjuntos de datos de preguntas y respuestas validan nuestro planteamiento como solución rentable y flexible para los sistemas RAG.

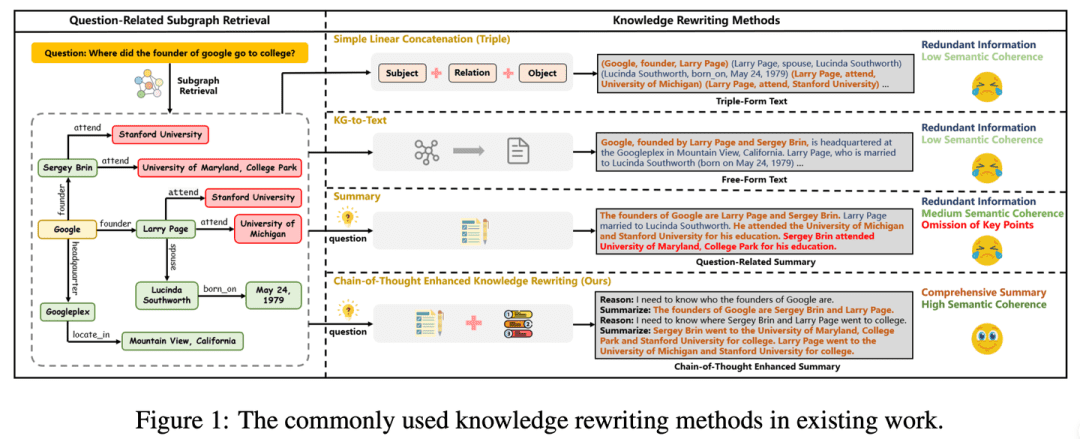

(47) CoTKR [traducción del atlas]

traducción del atlasComo un profesor paciente, comprende el contexto de los conocimientos y luego los explica paso a paso, sin limitarse a repetirlos, sino transmitiéndolos en profundidad. Al mismo tiempo, al recoger las opiniones de los alumnos, puede mejorar su propia forma de explicar, de modo que los conocimientos se transmitan con mayor claridad y eficacia.

- Tesis: CoTKR: Chain-of-Thought Enhanced Knowledge Rewriting for Complex Knowledge Graph Question Answering (Reescritura mejorada de la cadena de pensamiento para la respuesta a preguntas de grafos de conocimiento complejos)

- Proyecto: https://github.com/wuyike2000/CoTKR

El enfoque CoTKR (Chain-of-Thought Enhanced Knowledge Rewriting) alterna entre la generación de rutas de inferencia y el conocimiento correspondiente, superando así la limitación de la reescritura de conocimiento en un solo paso. Además, para salvar la diferencia de preferencias entre la reescritura de conocimientos y el modelo de garantía de calidad, proponemos una estrategia de formación que alinea las preferencias a partir de los comentarios de las preguntas y respuestas para optimizar aún más la reescritura de conocimientos explotando los comentarios del modelo de garantía de calidad.

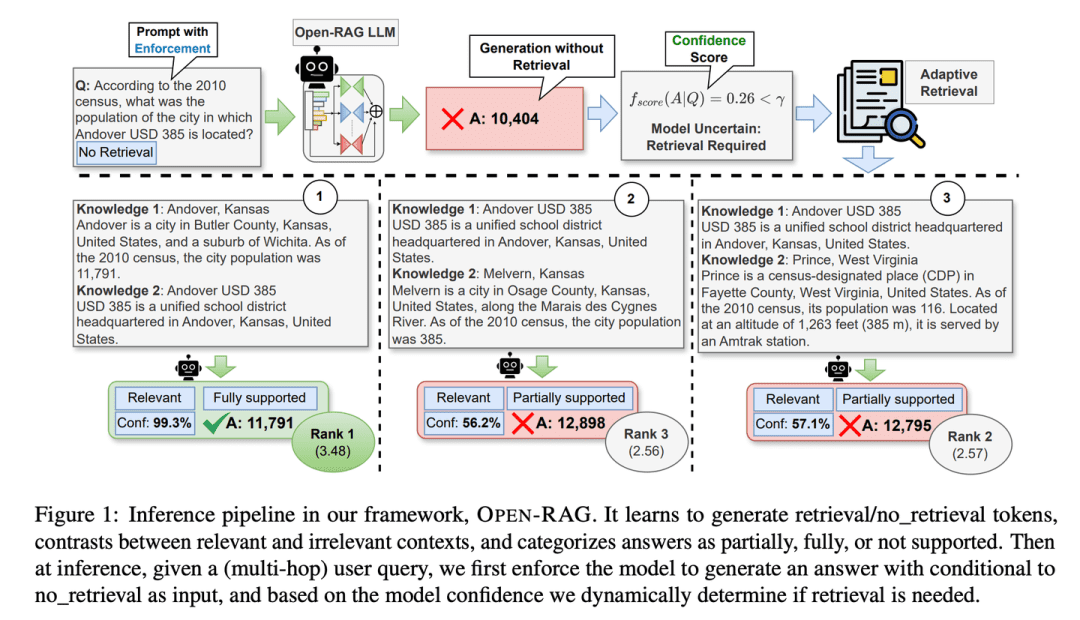

(48) Open-RAG [Grupo de reflexión]

repositorioLa descomposición de enormes modelos lingüísticos en grupos de expertos que pueden pensar de forma independiente y trabajar juntos, y ser especialmente buenos a la hora de distinguir entre información verdadera y falsa, sabiendo si buscar información o no en momentos críticos, como un grupo de reflexión experimentado.

- Tesis: Open-RAG: Enhanced Retrieval-Augmented Reasoning with Open-Source Large Language Models (en inglés)

- Proyecto: https://github.com/ShayekhBinIslam/openrag

Open-RAG mejora el razonamiento en RAG abriendo grandes modelos lingüísticos, convirtiendo modelos lingüísticos arbitrariamente densos en modelos de Mezcla de Expertos (MoE, Mixed-Mixture-of-Experts) dispersos y eficientes desde el punto de vista de los parámetros, capaces de gestionar tareas de razonamiento complejas, incluidas consultas de un solo salto y de varios saltos.

(49) TableRAG [Experto en Excel]

Especialista en Excel: Vaya más allá de la simple visualización de datos tabulares y sepa cómo comprender y recuperar datos tanto en dimensiones de cabecera como de celda, utilizando con la misma destreza una tabla dinámica para localizar y extraer rápidamente la información clave que necesita.

- Artículo: TableRAG: comprensión de tablas de millones de palabras con modelos lingüísticos

TableRAG ha diseñado un marco de generación mejorado para la recuperación específico para la comprensión de tablas, que combina la recuperación de esquemas y celdas mediante la expansión de consultas para localizar los datos clave antes de proporcionar información al modelo lingüístico, lo que permite una codificación de datos más eficiente y una recuperación más precisa, acortando drásticamente la longitud de las sugerencias y reduciendo la pérdida de información.

(50) LightRAG [Spider-Man]

spiderman: Navega ágilmente por la red del conocimiento, captando los filamentos entre los puntos, pero también utilizando la red para seguir los hilos. Como un bibliotecario clarividente, no sólo sabe dónde está cada libro, sino también qué libros leer juntos.

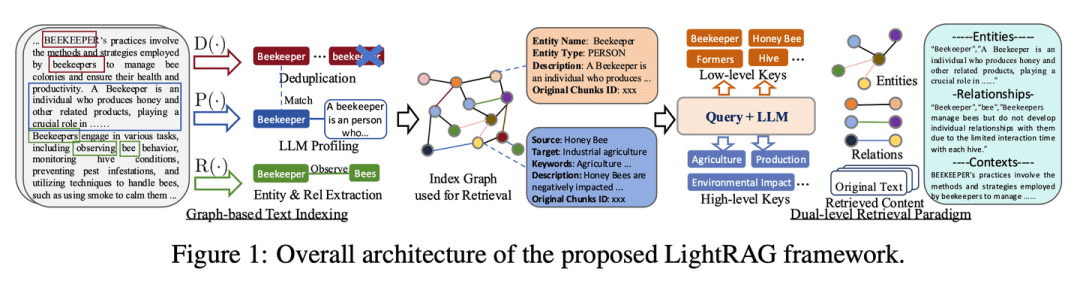

- Tesis: LightRAG: Generación mejorada de recuperación sencilla y rápida

- Proyecto: https://github.com/HKUDS/LightRAG

El marco integra estructuras de grafos en el proceso de indexación y recuperación de textos. Este innovador marco emplea un sistema de recuperación de dos niveles que mejora la recuperación de información exhaustiva a partir del descubrimiento de conocimientos tanto de bajo como de alto nivel. Además, la combinación de estructuras gráficas con representaciones vectoriales facilita la recuperación eficiente de entidades relevantes y sus relaciones, mejorando significativamente el tiempo de respuesta y manteniendo la relevancia contextual. Esta capacidad se ve reforzada por un algoritmo de actualización incremental que garantiza la integración oportuna de nuevos datos, lo que permite al sistema seguir siendo eficaz y receptivo en un entorno de datos que cambia rápidamente.

(51) AstuteRAG [Juez Sabio]

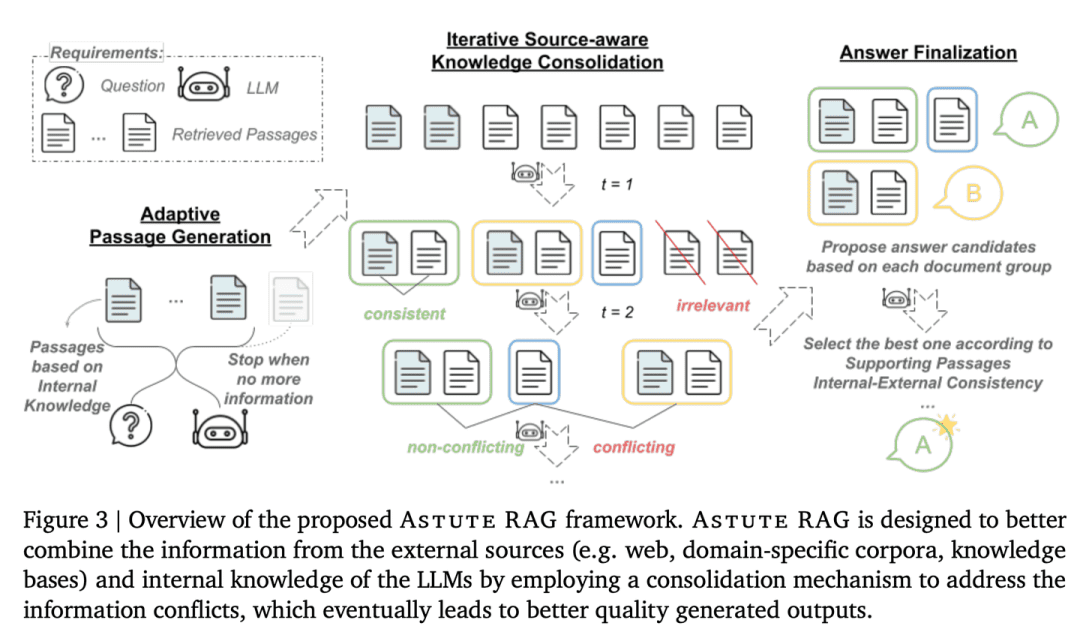

Juez sensatoPermanecer atento a la información externa, no fiarse de los resultados de las búsquedas, hacer buen uso del propio conocimiento acumulado, cribar la autenticidad de la información y sopesar las pruebas de muchas partes para llegar a una conclusión, como un juez superior.

- Tesis: Astute RAG: Superación del aumento imperfecto de la recuperación y de los conflictos de conocimiento para grandes modelos lingüísticos

La robustez y fiabilidad del sistema se mejoran extrayendo información de forma adaptativa del conocimiento interno de los LLM, combinándola con resultados de búsqueda externos y finalizando la respuesta basándose en la fiabilidad de la información.

(52) TurboRAG [taquigrafía maestro]

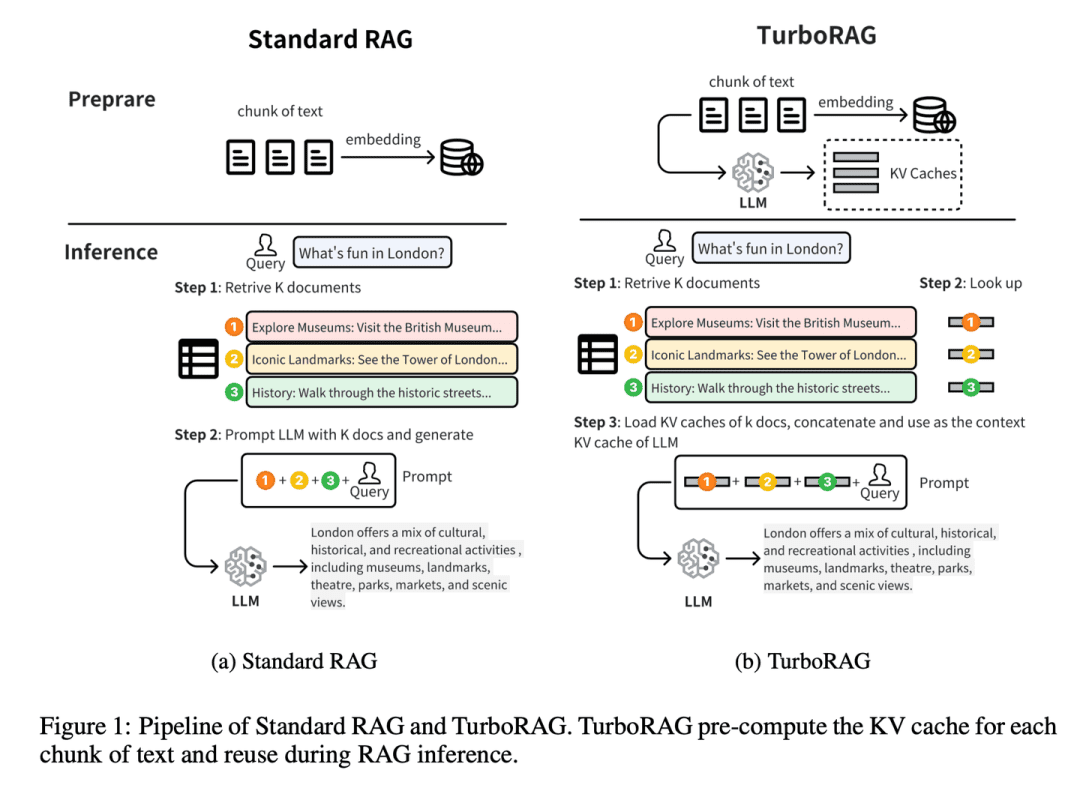

maestro taquígrafo: Haga su tarea con antelación y escribir todas las respuestas en un pequeño cuaderno. Al igual que un matón de la escuela redada pre-examen, no la escena del Buda, pero las preguntas comunes de antemano en el libro equivocado. Cuando usted necesita para convertir directamente a utilizar, guardar cada vez que tenga que deducir una vez en el acto.

- Tesis: TurboRAG: Accelerating Retrieval-Augmented Generation with Precomputed KV Caches for Chunked Text (Aceleración de la generación mejorada para la recuperación con cachés KV precalculadas para texto fragmentado).

- Proyecto: https://github.com/MooreThreads/TurboRAG

TurboRAG optimiza el paradigma de razonamiento del sistema RAG precalculando y almacenando las cachés KV de los documentos fuera de línea. A diferencia de los enfoques tradicionales, TurboRAG ya no calcula estas cachés KV en cada inferencia, sino que recupera las cachés precalculadas para una prepoblación eficaz, eliminando la necesidad de cálculos repetitivos en línea. Este enfoque reduce significativamente la carga computacional y acelera el tiempo de respuesta, al tiempo que mantiene la precisión.

(53) StructRAG [Organizador]

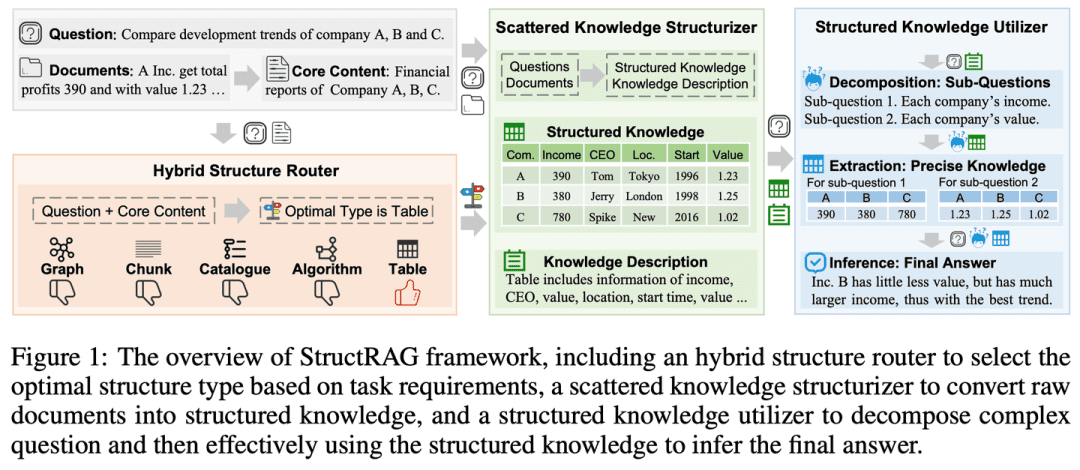

organizadorOrganiza el desorden de información en categorías, como un armario ordenado. Como un maestro de escuela que imita la mente humana, en lugar de memorizar, dibuja primero un mapa mental.

- Tesis: StructRAG: refuerzo del razonamiento intensivo en conocimiento de los LLM mediante la estructuración híbrida de la información en tiempo de inferencia

- Proyecto: https://github.com/Li-Z-Q/StructRAG

Inspirado en la teoría cognitiva según la cual los humanos convierten la información bruta en conocimiento estructurado cuando se enfrentan a razonamientos intensivos en conocimiento, el marco introduce un mecanismo híbrido de estructuración de la información que construye y utiliza el conocimiento estructurado en el formato más adecuado según los requisitos específicos de la tarea en cuestión. Al imitar procesos de pensamiento similares a los humanos, mejora el rendimiento del LLM en tareas de razonamiento intensivas en conocimiento.

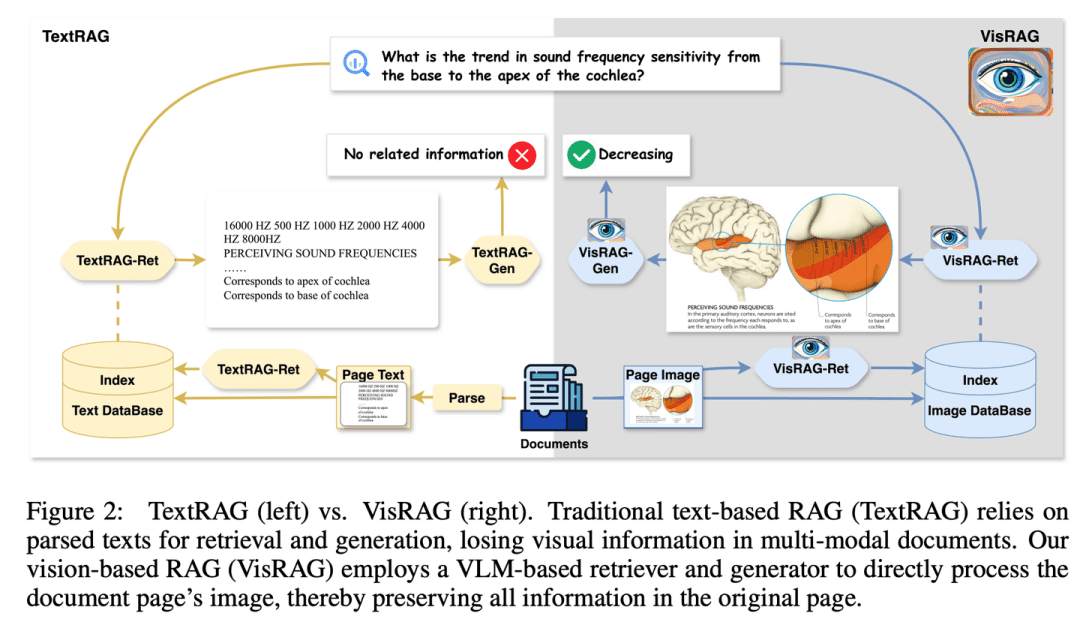

(54) VisRAG [ojos de fuego]

ojos perspicaces: Por fin me he dado cuenta de que las palabras no son más que una forma especial de expresión de las imágenes. Como un lector que ha abierto los ojos, ya no insiste en analizar palabra por palabra, sino que "ve" directamente la imagen completa. En lugar del OCR, utilicé una cámara y aprendí la esencia de "una imagen vale más que mil palabras".

- Tesis: VisRAG: Vision-based Retrieval-augmented Generation on Multi-modality Documents (VisRAG: Generación aumentada de recuperación basada en la visión de documentos multimodales)

- Proyecto: https://github.com/openbmb/visrag

La generación se mejora construyendo un proceso RAG basado en un Modelo Visual-Lingüístico (VLM) que incrusta y recupera directamente los documentos como imágenes. En comparación con la GAR de texto tradicional, VisRAG evita la pérdida de información durante el análisis sintáctico y conserva la información del documento original de forma más exhaustiva. Los experimentos demuestran que VisRAG supera a la RAG tradicional tanto en la fase de recuperación como en la de generación, con una mejora del rendimiento de extremo a extremo de 25-391 TP3 T. VisRAG no sólo hace un uso eficaz de los datos de entrenamiento, sino que también demuestra una gran capacidad de generalización, lo que la convierte en una opción ideal para la RAG de documentos multimodales.

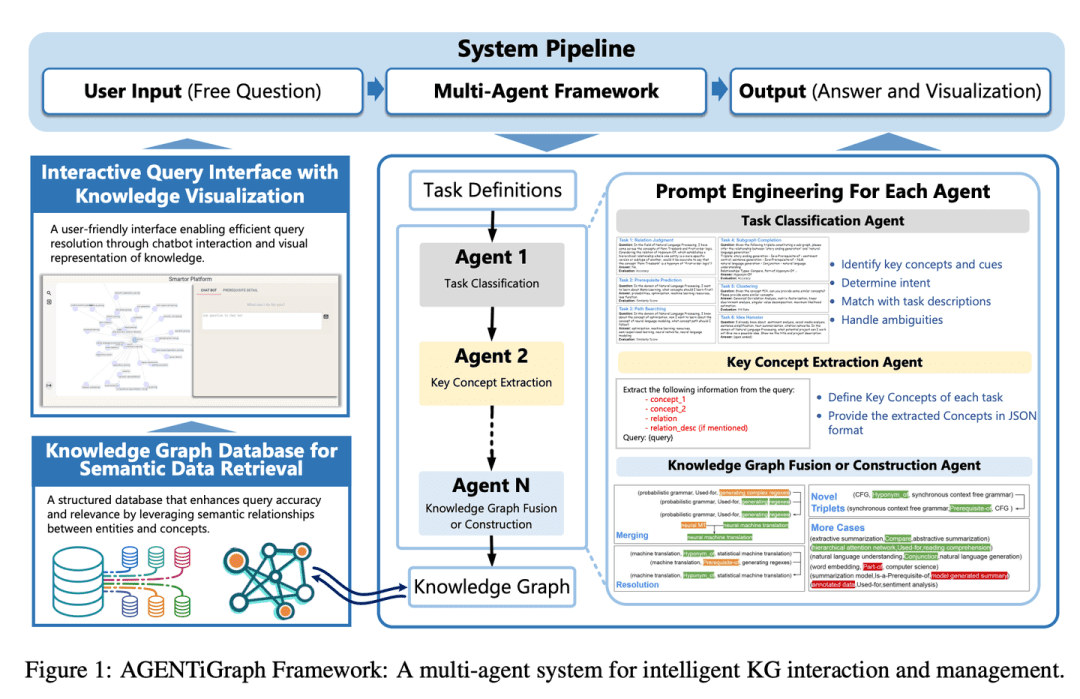

(55) AGENTiGraph [Gestor del conocimiento]

gestor del conocimientoComo un bibliotecario conversacional, te ayuda a organizar y presentar tus conocimientos a través de la comunicación diaria, con un equipo de asistentes dispuestos a responder preguntas y actualizar la información, haciendo que la gestión del conocimiento sea fácil y natural.

- Tesis: AGENTiGraph: plataforma interactiva de grafos de conocimiento para chatbots basados en LLM que utilizan datos privados

AGENTiGraph es una plataforma para la gestión del conocimiento a través de la interacción con el lenguaje natural. AGENTiGraph emplea una arquitectura multi-inteligencia para interpretar dinámicamente la intención del usuario, gestionar tareas e integrar nuevos conocimientos, garantizando que pueda adaptarse a las necesidades cambiantes del usuario y a los contextos de los datos.

(56) RuleRAG [Regla que sigue]

seguir la brújula e ir con la escuadra puesta (modismo); seguir las normas inflexiblementeLa enseñanza de la IA para hacer cosas con reglas es como traer a una persona nueva a bordo y darle primero un manual del empleado. En lugar de aprender sin rumbo, es como un profesor estricto que primero explica las reglas y los ejemplos, y luego deja que los alumnos lo hagan por sí mismos. Es más, estas reglas se convierten en memoria muscular, la próxima vez que te encuentres con problemas similares sabrás naturalmente cómo afrontarlos.

- Tesis: RuleRAG: Rule-guided retrieval-augmented generation with language models for question answering

- Proyecto: https://github.com/chenzhongwu20/RuleRAG_ICL_FT

RuleRAG propone un enfoque de generación mejorado por recuperación guiada por reglas basado en un modelo de lenguaje, que introduce explícitamente reglas simbólicas como ejemplos de aprendizaje contextual (RuleRAG - ICL) para guiar a un recuperador a recuperar documentos lógicamente relevantes en la dirección de las reglas y guía uniformemente a un generador a producir respuestas informadas guiadas por el mismo conjunto de reglas. Además, la combinación de consultas y reglas puede seguir utilizándose como datos de ajuste supervisados para actualizar los recuperadores y generadores (RuleRAG - FT) con el fin de lograr una mejor adherencia a las instrucciones basadas en reglas, lo que a su vez recupera resultados más favorables y genera respuestas más aceptables.

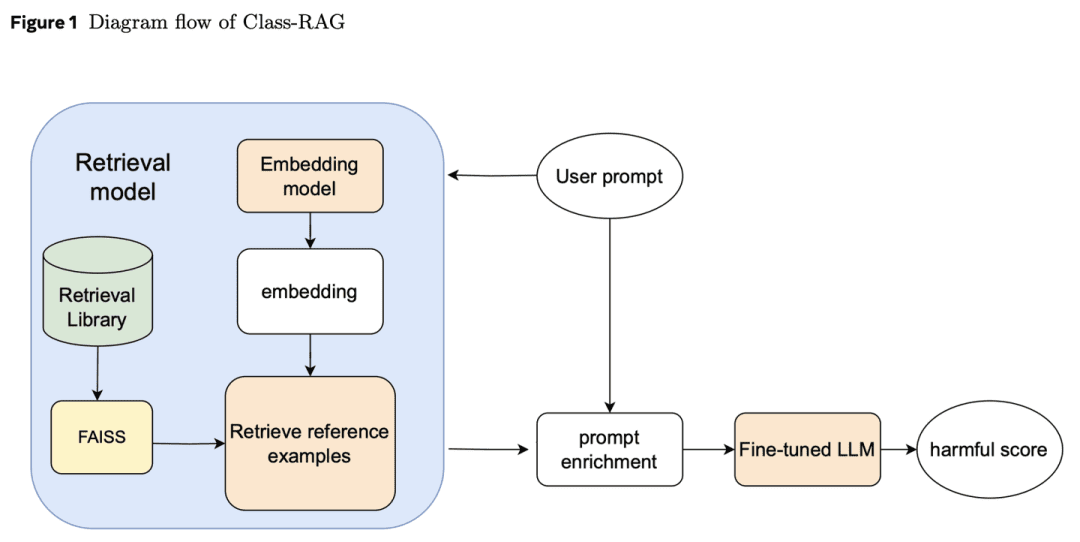

(57) Clase-RAG [Jueces]

juez: En lugar de basarse en disposiciones rígidas para decidir los casos, la sentencia se examina a través de una biblioteca de jurisprudencia en constante expansión. Como un juez experimentado, tiene un códice de hojas sueltas en la mano y lee los casos más recientes en cualquier momento, de modo que la sentencia tiene tanto temperatura como escala.

- Tesis: Class-RAG: Moderación de contenidos con generación aumentada de recuperación

Los clasificadores de verificación de contenidos son fundamentales para la seguridad de la IA generativa. Sin embargo, a menudo es difícil distinguir los matices entre contenidos seguros e inseguros. A medida que las tecnologías se generalizan, resulta cada vez más difícil y costoso ajustar continuamente los modelos para hacer frente a los riesgos. Por ello, proponemos el enfoque Class-RAG, que consigue mitigar los riesgos de forma inmediata actualizando dinámicamente la base de recuperación. Class-RAG es más flexible y transparente que los modelos tradicionales de ajuste fino, y obtiene mejores resultados en términos de clasificación y resistencia a los ataques. También se demuestra que la ampliación de la base de búsqueda puede mejorar eficazmente el rendimiento de la auditoría a bajo coste.

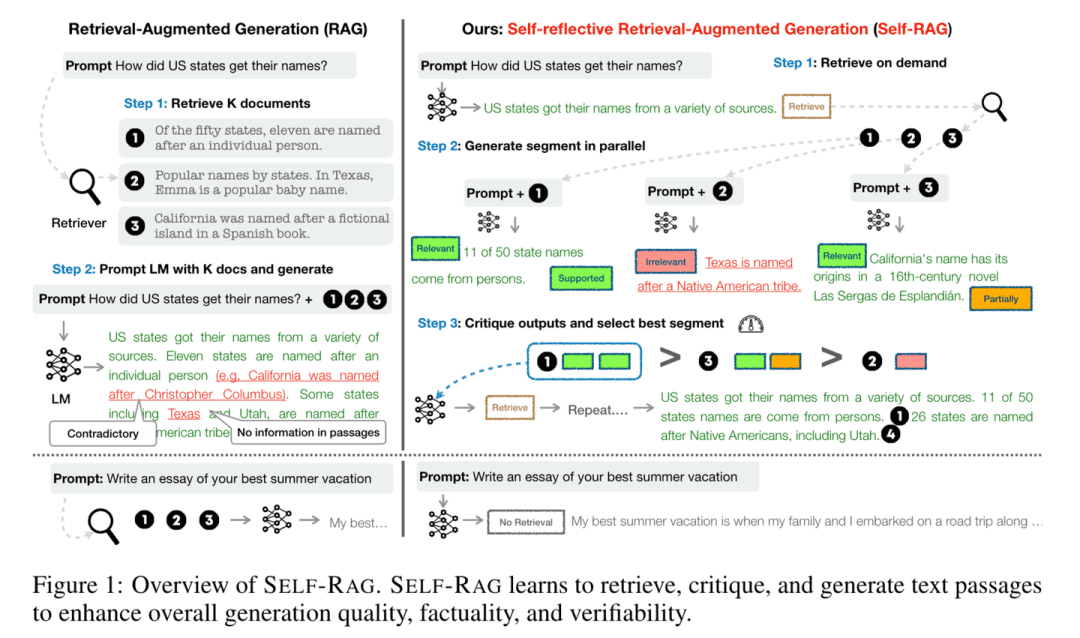

(58) Auto-RAG [Reflector]

pensadorAl responder a las preguntas, no sólo consultan la información, sino que también piensan y comprueban que sus respuestas sean correctas y completas. Al "pensar mientras habla", como un erudito prudente, se asegura de que cada punto de vista esté respaldado por pruebas sólidas.

- Tesis: Self-RAG: Aprender a recuperar, generar y criticar a través de la autorreflexión

- Proyecto: https://github.com/AkariAsai/self-rag

Self-RAG mejora la calidad y la precisión de los modelos lingüísticos mediante la recuperación y la autorreflexión. El marco entrena un único modelo lingüístico arbitrario que puede recuperar pasajes de forma adaptativa bajo demanda y utilizar marcadores especiales denominados marcadores reflexivos para generar y reflexionar sobre los pasajes recuperados y su propio contenido generado. La generación de marcadores reflexivos hace que el modelo lingüístico sea controlable en la fase de razonamiento, lo que le permite adaptar su comportamiento a los distintos requisitos de la tarea.

(59) SimRAG [autodidacta]

un genio hecho a sí mismoCuando se enfrente a un área de especialización, hágase sus propias preguntas antes de responderlas usted mismo, y aumente su reserva de conocimientos profesionales mediante la práctica constante, del mismo modo que los estudiantes se familiarizan con sus conocimientos profesionales haciendo ejercicios repetidamente.

- Tesis: SimRAG: Self-Improving Retrieval-Augmented Generation for Adapting Large Language Models to Specialised Domains (SimRAG: generación mejorada por recuperación para adaptar grandes modelos lingüísticos a dominios especializados).

SimRAG es un método de autoformación que dota a los LLM de capacidades combinadas de pregunta-respuesta y generación de preguntas adaptadas a ámbitos específicos. Sólo se pueden formular buenas preguntas si se comprenden realmente los conocimientos. Estas dos capacidades se complementan para ayudar al modelo a comprender mejor los conocimientos. En primer lugar, el LLM se pone a punto en cuanto a seguimiento de instrucciones, preguntas y respuestas y búsqueda de datos relevantes. A continuación, se pide al mismo LLM que genere una serie de preguntas relevantes para el dominio a partir de un corpus sin etiquetar, con estrategias de filtrado adicionales para retener ejemplos sintéticos de alta calidad. Utilizando estos ejemplos sintéticos, el LLM puede mejorar su rendimiento en tareas RAG específicas del dominio.

(60) ChunkRAG [extractos del máster]

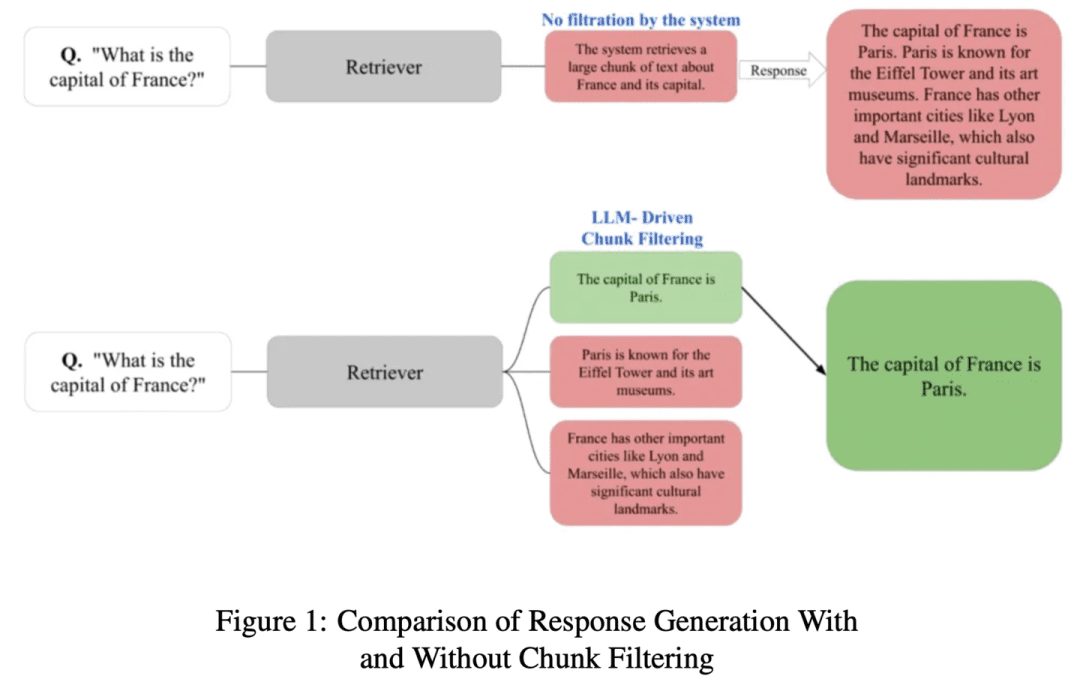

persona que extrae fragmentos de un libroElección de artículos: Divida los artículos largos en párrafos más pequeños y, a continuación, seleccione los fragmentos más relevantes con ojo profesional, sin perder el hilo ni distraerse con contenidos irrelevantes.

- Tesis: ChunkRAG: Nuevo método de filtrado LLM-Chunk para sistemas RAG

ChunkRAG propone un enfoque de filtrado de trozos basado en LLM para mejorar el marco de los sistemas RAG evaluando y filtrando la información recuperada a nivel de trozos, donde los "trozos" representan partes coherentes más pequeñas de un documento. Nuestro planteamiento emplea la fragmentación semántica para dividir el documento en partes coherentes y utiliza una puntuación de relevancia basada en un amplio modelo lingüístico para evaluar la adecuación de cada trozo a la consulta del usuario. Al filtrar los trozos menos relevantes antes de la fase de generación, reducimos significativamente las ilusiones y mejoramos la precisión factual.

(61) FastGraphRAG [Radar]

radar (préstamo): Al igual que Google Page Rank, da a los puntos de conocimiento una lista caliente. Es como un líder de opinión en una red social, cuanta más gente lo siga, más fácil será que lo vean. En lugar de buscar sin rumbo, es como un explorador con radar, que busca allí donde la señal es fuerte.

- Proyecto: https://github.com/circlemind-ai/fast-graphrag

FastGraphRAG proporciona un marco de trabajo de Generación Aumentada de Recuperación Rápida de Grafos (FastGraphRAG) eficiente, interpretable y de gran precisión. Aplica el algoritmo PageRank al proceso de recorrido del grafo de conocimiento para localizar rápidamente los nodos de conocimiento más relevantes. Al calcular la puntuación de importancia de un nodo, PageRank permite a GraphRAG filtrar y ordenar la información del grafo de conocimiento de forma más inteligente. Esto es como equipar a GraphRAG con un "radar de importancia", que puede localizar rápidamente la información clave en la enorme cantidad de datos.

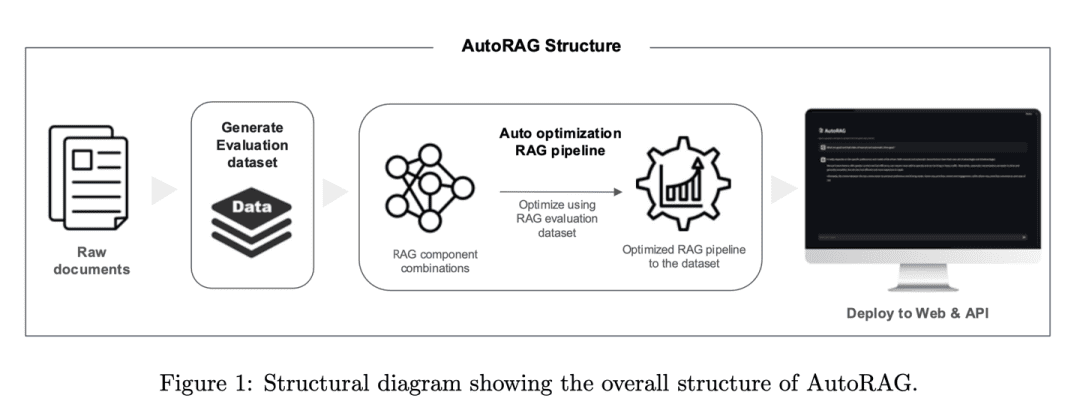

(62) AutoRAG [Sintonizador]

sintonizadorEl RAG es un afinador experimentado que encuentra el mejor sonido no adivinando, sino mediante pruebas científicas. Prueba automáticamente varias combinaciones de RAG, igual que un afinador prueba distintos equipos de audio para encontrar el "programa de reproducción" más armonioso.

- Tesis: AutoRAG: Marco automatizado para la optimización de la tubería de generación aumentada de recuperaciones

- Proyecto: https://github.com/Marker-Inc-Korea/AutoRAG_ARAGOG_Paper

El marco AutoRAG identifica automáticamente los módulos RAG adecuados para un conjunto de datos determinado y explora y aproxima la combinación óptima de módulos RAG para ese conjunto de datos. Al evaluar sistemáticamente diferentes configuraciones de GAR para optimizar la elección de técnicas, el marco es similar a la práctica de AutoML en el aprendizaje automático tradicional, donde se realizan experimentos exhaustivos para optimizar la elección de técnicas de GAR y mejorar la eficiencia y escalabilidad del sistema de GAR.

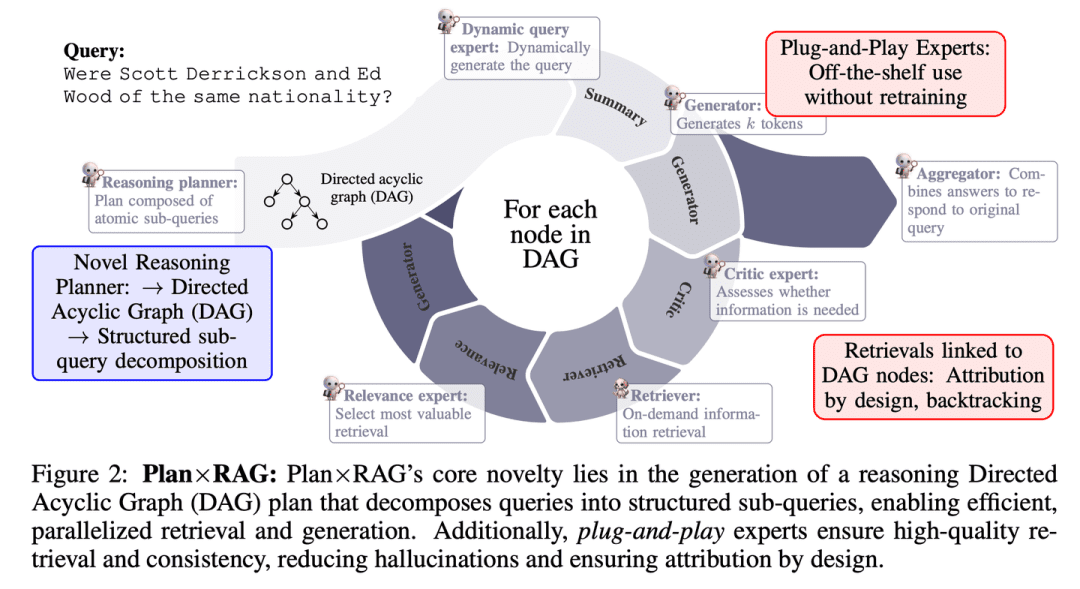

(63) Plan x RAG [Jefe de proyecto]

jefe de proyectoPlanificar antes de actuar, dividir las grandes tareas en otras más pequeñas y disponer que varios "expertos" trabajen en paralelo. Cada experto es responsable de su área, y el director del proyecto se encarga de resumir los resultados al final. Este planteamiento no sólo es más rápido y preciso, sino que también proporciona una explicación clara del origen de cada conclusión.

- Tesis: Plan × RAG: Generación Aumentada de Recuperación Guiada por la Planificación

Plan×RAG es un nuevo marco que amplía el paradigma "recuperación-razonamiento" de los marcos RAG existentes a un paradigma "plan-recuperación". Plan×RAG formula el plan de razonamiento como un grafo acíclico dirigido (DAG) y descompone la consulta en subconsultas atómicas interrelacionadas. La generación de respuestas sigue la estructura del DAG, lo que mejora significativamente la eficiencia gracias a la recuperación y generación paralelas. Mientras que las soluciones RAG más avanzadas requieren una amplia generación de datos y un ajuste preciso de los modelos lingüísticos (LM), Plan×RAG incorpora LM congelados como expertos "plug-and-play" para generar respuestas de alta calidad.

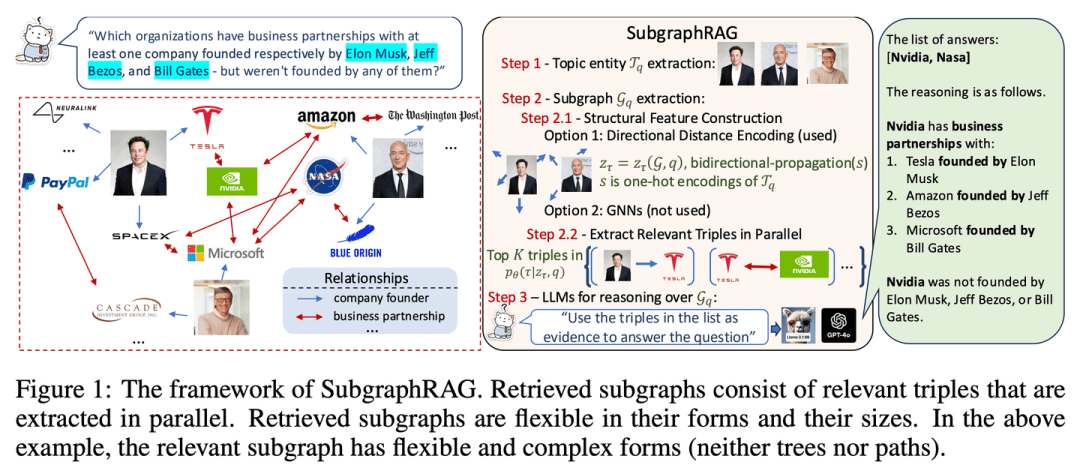

(64) SubgraphRAG [localizador]

posicionadorEn lugar de buscar una aguja en un pajar, se traza con precisión un pequeño mapa del conocimiento para que la IA pueda encontrar respuestas rápidamente.

- Tesis: Lo simple es eficaz: las funciones de los grafos y los modelos lingüísticos amplios en la recuperación basada en grafos de conocimiento - Generación mejorada

- Proyecto: https://github.com/Graph-COM/SubgraphRAG

SubgraphRAG amplía el marco RAG basado en KG recuperando subgrafos y utilizando LLM para la inferencia y la predicción de respuestas. Se combina un perceptrón multicapa ligero con un mecanismo de puntuación ternario paralelo para recuperar subgrafos de forma eficaz y flexible, al tiempo que se codifica la distancia de estructura dirigida para mejorar la eficacia de la recuperación. El tamaño de los subgrafos recuperados puede ajustarse con flexibilidad para adaptarse a los requisitos de la consulta y a la capacidad del LLM posterior. Este diseño logra un equilibrio entre la complejidad del modelo y la capacidad de inferencia, permitiendo un proceso de recuperación escalable y versátil.

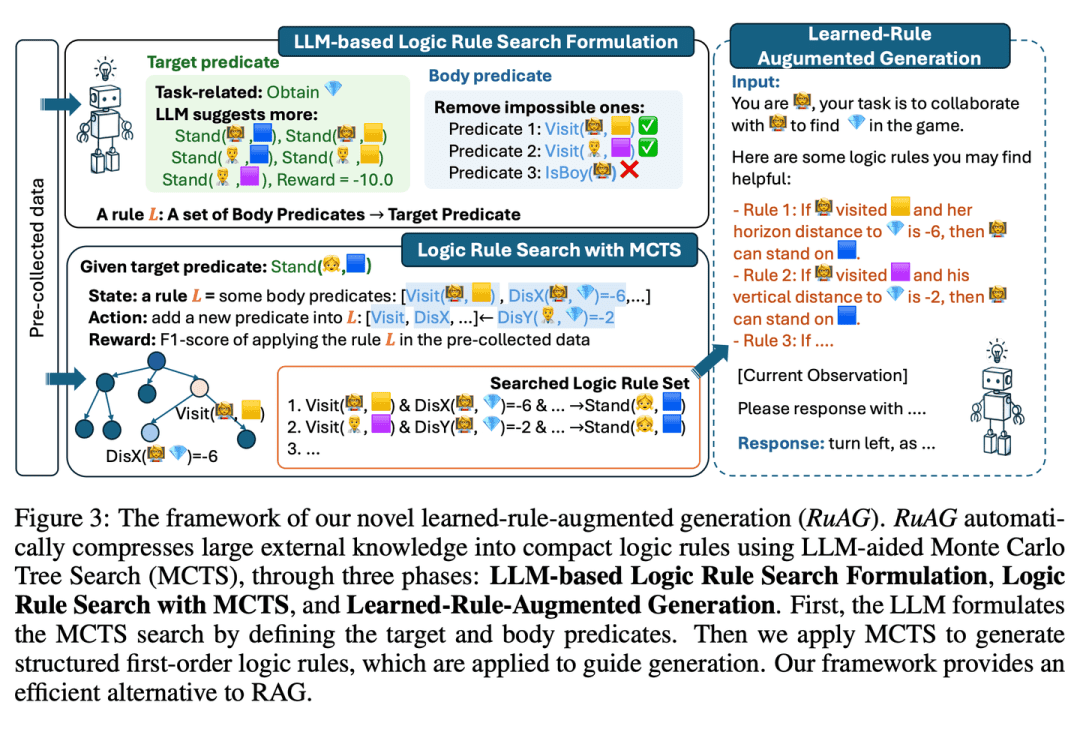

(65) RuRAG [Alquimista]

alquimistaLa inteligencia artificial: como un alquimista, puede destilar cantidades ingentes de datos en reglas lógicas claras y expresarlas en lenguaje llano, haciendo que la IA sea más inteligente en las aplicaciones prácticas.

- Tesis: RuAG: Generación aumentada por reglas aprendidas para grandes modelos lingüísticos

pretende mejorar las capacidades de razonamiento de los modelos lingüísticos a gran escala (LLM) destilando automáticamente grandes cantidades de datos offline en reglas lógicas de primer orden interpretables e inyectándolas en los LLM. El marco utiliza la búsqueda en árbol Monte Carlo (MCTS) para descubrir reglas lógicas y transformarlas en lenguaje natural, lo que permite la inyección de conocimientos y una integración perfecta para las tareas posteriores de los LLM. El artículo evalúa la eficacia del marco en tareas industriales públicas y privadas, demostrando su potencial para mejorar las capacidades de los LLM en diversas tareas.

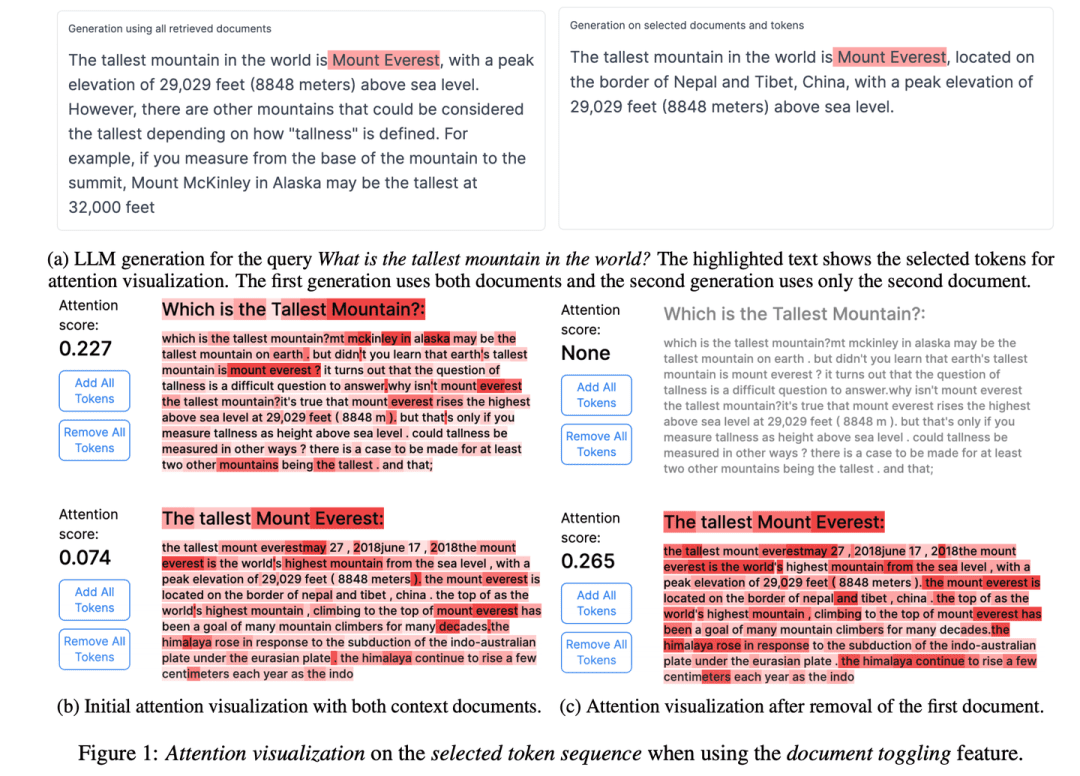

(66) RAGViz [ojo transparente]

visión de túnel: Haga que el sistema RAG sea transparente, vea qué frase está leyendo el modelo, como un médico mirando una placa de rayos X, y vea qué falla de un vistazo.

- Tesis: RAGViz: Diagnosticar y visualizar la generación mejorada por recuperación

- Proyecto: https://github.com/cxcscmu/RAGViz

RAGViz proporciona visualizaciones de los documentos recuperados y la atención del modelo para ayudar a los usuarios a comprender la interacción entre el marcado generado y los documentos recuperados, y puede utilizarse para diagnosticar y visualizar los sistemas RAG.

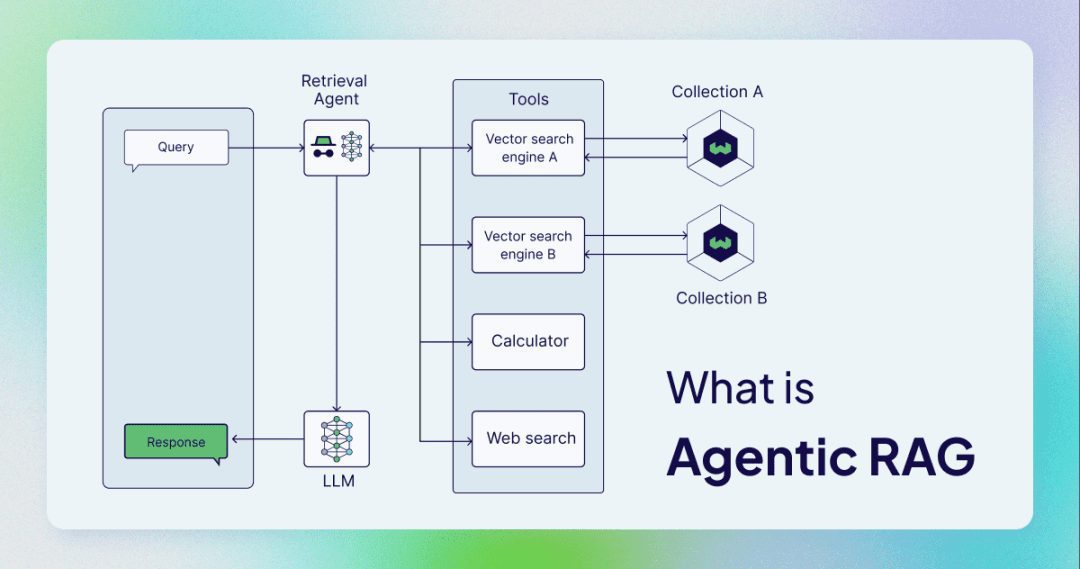

(67) AgenticRAG [Asistente inteligente]

asistente inteligenteYa no se trata simplemente de buscar y copiar, sino de un asistente que pueda actuar como secretario de confianza. Como un administrador competente, no sólo sabe buscar información, sino también cuándo hacer una llamada telefónica, cuándo celebrar una reunión y cuándo pedir instrucciones.

AgenticRAG describe un GAR basado en la implementación de inteligencias de IA. En concreto, incorpora inteligencias de IA en el proceso del GAR para coordinar sus componentes y realizar acciones adicionales más allá de la simple recuperación y generación de información para superar las limitaciones de los procesos corporales no inteligentes.

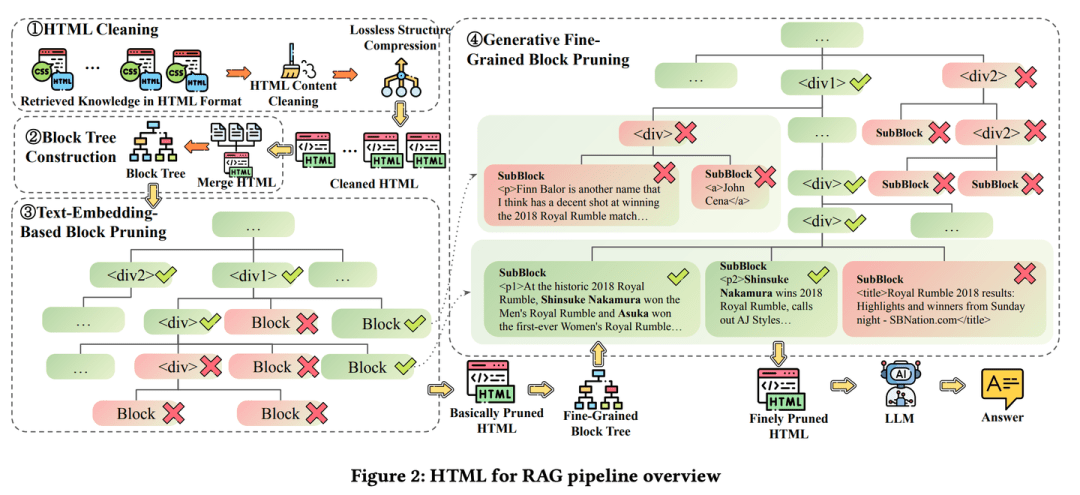

(68) HtmlRAG [Tipógrafo]

tipógrafo: El conocimiento no se mantiene como una cuenta corriente, sino como la maquetación de una revista, con negrita donde hace falta y etiquetado en rojo donde hace falta. Es como un editor quisquilloso que considera que no basta con el contenido, sino también con la maquetación, para que los puntos clave puedan verse de un vistazo.

- Tesis: HtmlRAG: HTML es mejor que el texto sin formato para modelizar el conocimiento recuperado en los sistemas RAG

- Proyecto: https://github.com/plageon/HtmlRAG

HtmlRAG utiliza HTML en lugar de texto sin formato como formato para recuperar conocimientos en RAG, ya que HTML es mejor que el texto sin formato a la hora de modelar conocimientos a partir de documentos externos y la mayoría de los LLM conocen bien el lenguaje HTML.

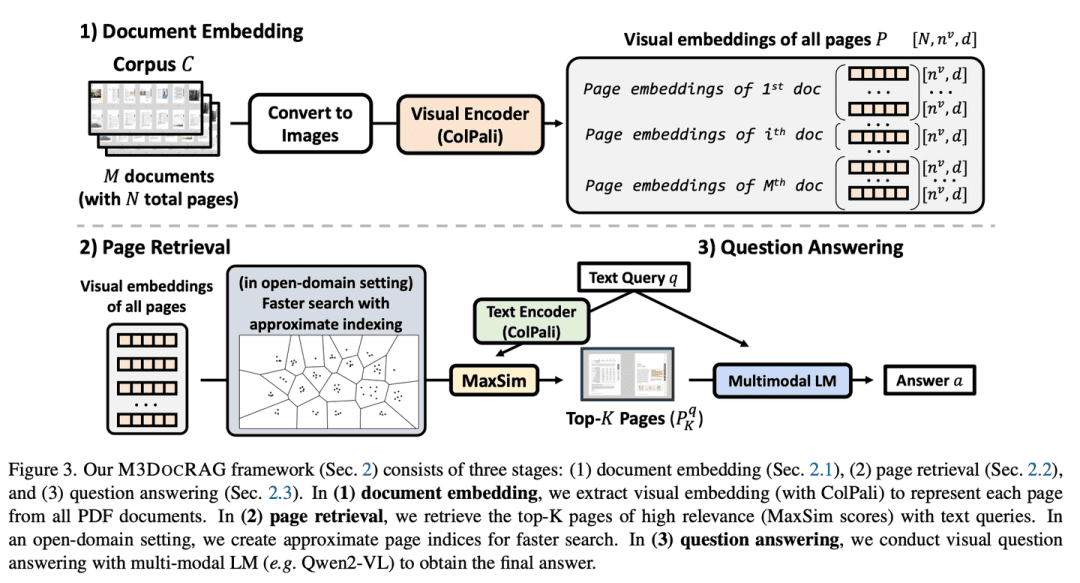

(69) M3DocRAG [Temerario Sensorial]

persona sensorialNo sólo lee, sino que también puede leer imágenes y escuchar voces. Como un concursante polifacético de un programa de variedades, puede leer imágenes, entender palabras, saltar cuando tiene que saltar, concentrarse en los detalles cuando tiene que concentrarse, y no puede dejarse vencer por todo tipo de retos.

- Tesis: M3DocRAG: Multi-modal Retrieval is What You Need for Multi-page Multi-document Understanding (M3DocRAG: La recuperación multimodal es lo que necesita para la comprensión de múltiples páginas y documentos).

M3DocRAG es un novedoso marco RAG multimodal que se adapta con flexibilidad a una variedad de contextos de documentos (dominios cerrados y abiertos), saltos de preguntas (simples y múltiples) y modos de evidencia (texto, tablas, gráficos, etc.).M3DocRAG utiliza un recuperador multimodal y un MLM para encontrar documentos relevantes y responder preguntas, y como tal, puede procesar eficientemente documentos simples o múltiples preservando la información visual. visual.

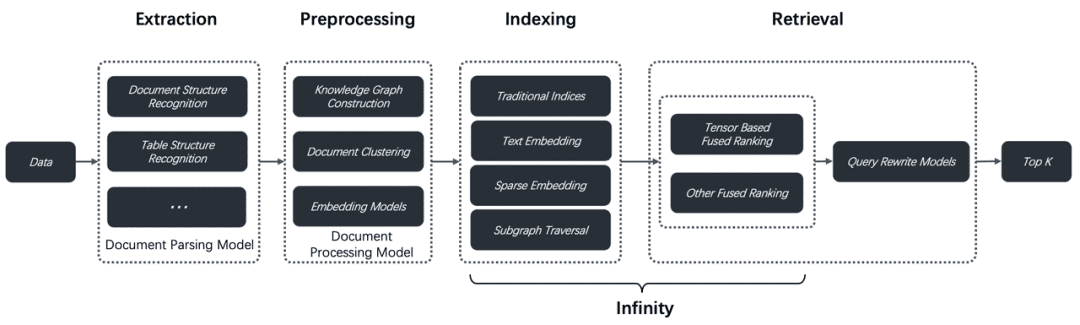

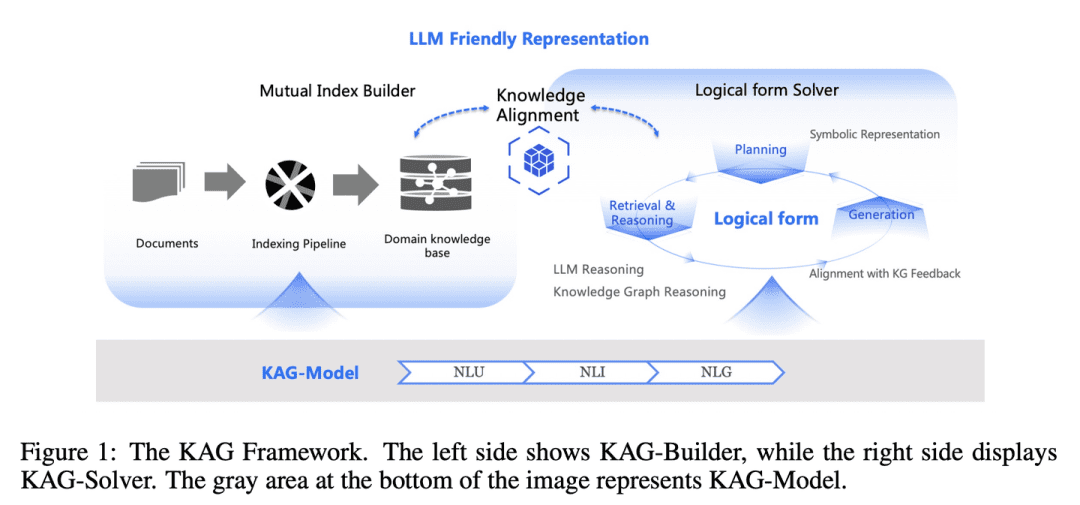

(70) KAG [Maestros de la Lógica]

maestro de lógica: No se trata sólo de encontrar respuestas similares por tanteo, sino también de la relación causa-efecto entre los conocimientos. Como un profesor de matemáticas riguroso, no sólo hay que saber cuál es la respuesta, sino también explicar cómo se ha obtenido esa respuesta paso a paso.

- Tesis: KAG: potenciación de los LLM en ámbitos profesionales mediante la generación aumentada de conocimientos

- Proyecto: https://github.com/OpenSPG/KAG

La brecha entre la similitud de los vectores y la relevancia del razonamiento del conocimiento en la RAG, así como la insensibilidad a la lógica del conocimiento (por ejemplo, valores numéricos, relaciones temporales, reglas de expertos, etc.) dificultan la eficacia de los servicios especializados. para mejorar la generación y el rendimiento de la inferencia: (1) representación del conocimiento compatible con el LLM, (2) indexación cruzada entre el grafo de conocimiento y los fragmentos sin procesar, (3) motor de inferencia híbrido guiado por la forma lógica, (4) alineación del conocimiento con la inferencia semántica, y (5) mejora de la capacidad de modelado del KAG.

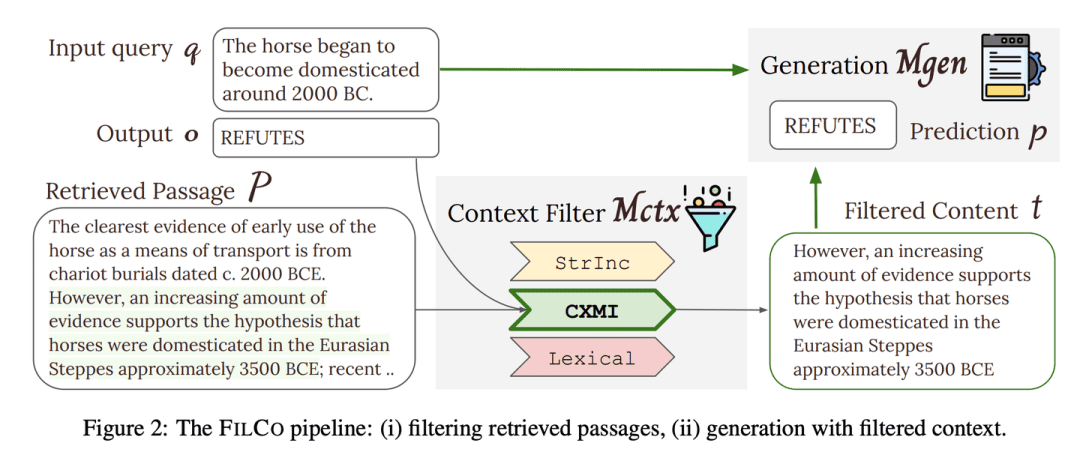

(71) FILCO [Criba]

cribasComo un editor riguroso, experto en identificar y retener la información más valiosa de grandes cantidades de texto, garantizando que cada pieza de contenido entregada a la IA sea precisa y relevante.

- Tesis: Aprender a filtrar el contexto para una generación mejorada de la recuperación

- Proyecto: https://github.com/zorazrw/filco

FILCO mejora la calidad del contexto proporcionado al generador identificando contextos útiles a partir de enfoques léxicos y teóricos de la información, y entrenando un modelo de filtrado de contextos para filtrar los contextos recuperados.

(72) LazyGraphRAG [actuario]

actuariosUn paso es un paso si puedes ahorrarlo, y dar un buen uso a los grandes modelos caros. Como un ama de casa que sabe vivir, no te limitas a comprar cuando ves una oferta en el supermercado, sino que comparas antes de decidir dónde gastar tu dinero para obtener la mejor relación calidad-precio.

- Proyecto: https://github.com/microsoft/graphrag

Un enfoque novedoso para la generación de recuperación mejorada mediante grafos (RAG). Este enfoque reduce significativamente los costes de indexación y consulta al tiempo que mantiene o supera a sus competidores en términos de calidad de respuesta, lo que lo hace altamente escalable y eficiente en una amplia gama de casos de uso.LazyGraphRAG retrasa el uso de LLM. Durante la fase de indexación, LazyGraphRAG utiliza únicamente técnicas ligeras de PLN para procesar el texto, retrasando la invocación de LLM hasta la consulta real. Esta estrategia "perezosa" evita los elevados costes iniciales de indexación y consigue una utilización eficiente de los recursos.

| GraphRAG tradicional | LazyGraphRAG | |

| fase de indexación | - Extracción y descripción de entidades y relaciones mediante LLM - Generar resúmenes para cada entidad y relación - Resumir contenidos comunitarios con LLM - Generar vectores de incrustación - Generación de archivos parquet | - Extracción de conceptos y relaciones co-ocurrentes mediante técnicas de PNL - Construir mapas conceptuales - Extracción de estructuras comunitarias - LLM no se utiliza en la fase de indexación |

| Fase de investigación | - Responder directamente a las consultas mediante resúmenes comunitarios - Falta de refinamiento de las consultas y de concentración en la información pertinente | - Uso de LLM para refinar consultas y generar subconsultas - Selección de segmentos de texto y comunidades en función de su pertinencia - Extraer y generar respuestas con LLM - Más centrado en contenidos relevantes, respuestas más precisas |

| Convocatoria LLM | - Uso intensivo tanto en la fase de indexación como en la de consulta | - LLM no se utiliza en la fase de indexación - Llamar a LLM sólo en la fase de consulta - El LLM se utiliza de forma más eficiente |

| rentabilidad | - Indexación costosa y lenta - La calidad del índice limita el rendimiento de las consultas | - El coste de indexación es sólo 0,1% del GraphRAG tradicional - Alta eficacia de las consultas y buena calidad de las respuestas |

| almacenamiento de datos | - Los archivos Parquet se generan a partir de datos indexados, adecuados para el almacenamiento y procesamiento de datos a gran escala. | - Los datos indexados se almacenan en formatos ligeros (por ejemplo, JSON, CSV), más adecuados para un desarrollo rápido y datos de pequeño tamaño. |

| Escenarios de uso | - Para situaciones poco sensibles a los recursos informáticos y al tiempo - El grafo de conocimiento completo debe construirse con antelación y almacenarse como un archivo Parquet para su posterior importación en la base de datos para análisis complejos. | - Para situaciones que requieren una indexación y respuesta rápidas - Ideal para consultas puntuales, análisis exploratorios y procesamiento de datos en flujo. |

Encuesta RAG

- Un estudio sobre la generación de textos mejorada por recuperación

- Recuperación de información multimodal para la generación aumentada: un estudio

- Generación mejorada por recuperación para grandes modelos lingüísticos: un estudio

- Retrieval-Augmented Generation for AI-Generated Content: A Survey (Generación mejorada de recuperación para contenidos generados por IA: estudio)

- Estudio sobre la generación de textos mejorados con recuperación para grandes modelos lingüísticos

- RAG y RAU: estudio sobre modelos lingüísticos mejorados para la recuperación en el procesamiento del lenguaje natural

- Encuesta sobre los LLM de reuniones RAG: hacia modelos lingüísticos de gran tamaño mejorados por recuperación

- Evaluación de la generación mejorada por recuperación: estudio

- Generación mejorada por recuperación para el procesamiento del lenguaje natural: un estudio

- Graph Retrieval-Augmented Generation: un estudio

- Estudio exhaustivo de la generación mejorada por recuperación (RAG): evolución, panorama actual y perspectivas de futuro

- Retrieval Augmented Generation (RAG) and Beyond: A Comprehensive Survey on How to Make Your LLMs Use External Data More Wisly

Objetivo de referencia RAG

- Evaluación comparativa de grandes modelos lingüísticos en la generación mejorada por recuperación

- RECALL: una prueba de la robustez de los LLM frente al conocimiento contrafáctico externo

- ARES: Marco de evaluación automatizada de sistemas de generación mejorada de consultas

- RAGAS: Evaluación automatizada de la generación aumentada de recuperaciones

- CRUD-RAG: un completo sistema chino de referencia para la generación mejorada de modelos lingüísticos de gran tamaño

- FeB4RAG: Evaluación de la búsqueda federada en el contexto de la generación aumentada de recuperación

- CodeRAG-Bench: ¿Puede la recuperación aumentar la generación de código?

- Long2RAG: evaluación de la generación mejorada de recuperación de contexto largo y forma larga con recuperación de puntos clave

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...