Interpretation der Schlüsselparameter des großen Modells: Token, Kontextlänge und Ausgabegrenzen

Groß angelegte Sprachmodelle (LLMs) spielen eine immer wichtigere Rolle im Bereich der künstlichen Intelligenz. Um LLMs besser verstehen und anwenden zu können, müssen wir ein tieferes Verständnis ihrer Kernkonzepte gewinnen. In diesem Beitrag konzentrieren wir uns auf drei Schlüsselkonzepte, nämlich Token, maximale Ausgabelänge und Kontextlänge, um den Lesern zu helfen, die Verständnisbarrieren zu überwinden, damit sie die LLM-Technologie effektiver nutzen können.

Token: LLMs grundlegende Verarbeitungseinheit

Token Token ist die Grundeinheit eines Large Language Model (LLM) zur Verarbeitung natürlichsprachlicher Texte und kann als die kleinste semantische Einheit verstanden werden, die das Modell erkennen und verarbeiten kann. Obwohl ein Token grob mit einem "Wort" oder einer "Phrase" gleichgesetzt werden kann, wird es genauer als der Baustein beschrieben, auf dem das Modell seine Textanalyse und -generierung aufbaut.

In der Praxis besteht eine gewisse Umrechnungsbeziehung zwischen Token und Wortanzahl. Ganz allgemein gesprochen:

- 1 englisches Zeichen ≈ 0.3 Token

- 1 chinesisches Zeichen ≈ 0,6 Token

Daher können wirungefähre Einschätzung(math.) Gattungin der RegelEin chinesisches Zeichen kann als eine Token.

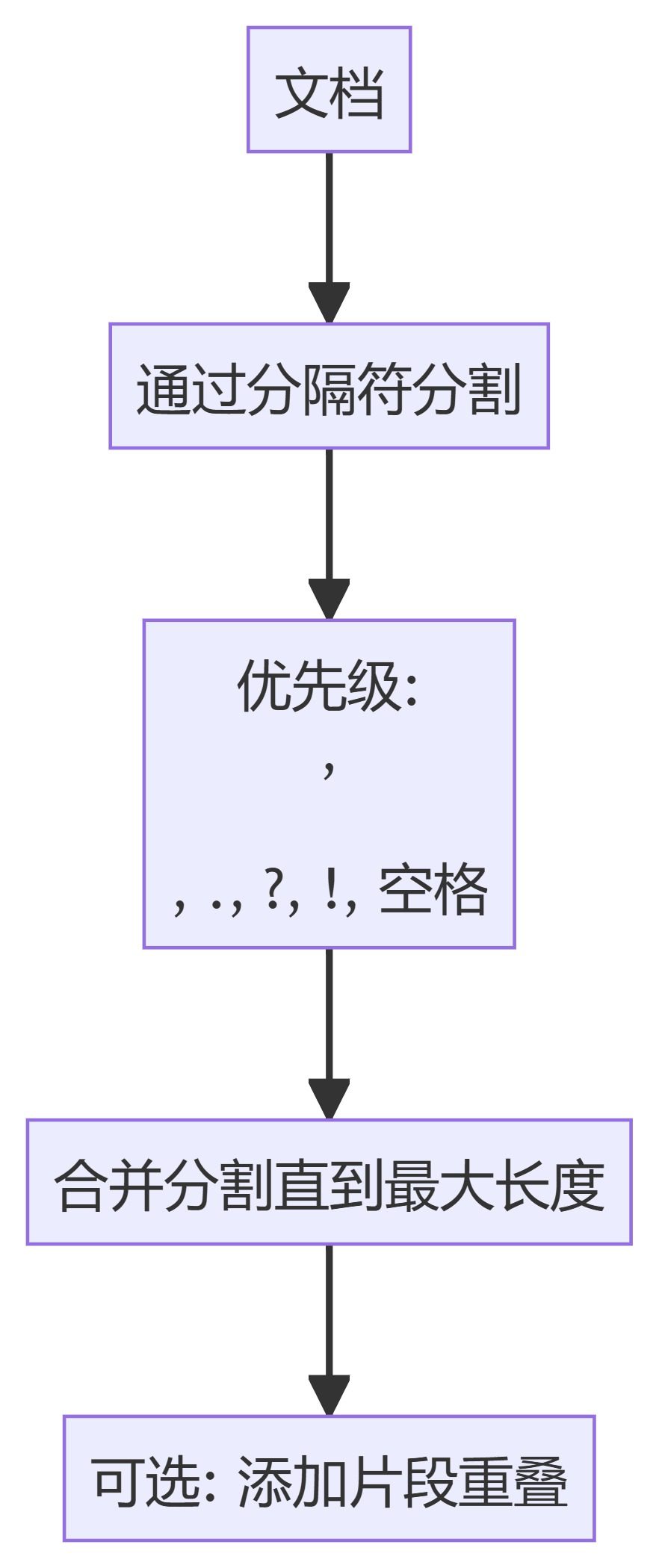

Wie in der obigen Abbildung dargestellt, zerlegt das Modell bei der Eingabe von Text in LLM den Text zunächst in Token-Sequenzen und verarbeitet diese Token-Sequenzen dann, um die gewünschte Ausgabe zu erzeugen. Die folgende Abbildung zeigt anschaulich den Prozess der Tokenisierung von Text:

Maximale Ausgabelänge (Ausgabelimit): die Obergrenze der Einzeltexterzeugung des Modells

laut DeepSeek Bei der Betrachtung der Serienmodelle lässt sich feststellen, dass die verschiedenen Modelle eine Grenze für die maximale Ausgabelänge setzen.

Oben.deepseek-chat Modellkorrespondenz DeepSeek-V3 Version, während deepseek-reasoner Modell entspricht dann DeepSeek-R1 Versionen. Sowohl für das Inferenzmodell R1 als auch für das Dialogmodell V3 ist die maximale Ausgabelänge auf 8K.

Unter Berücksichtigung der ungefähren Umrechnungsrelation, dass ein Kanji ungefähr einem Token entspricht.8K Die maximale Ausgabelänge von kann als interpretiert werden: Das Modell ist in der Lage, bis zu 8000 chinesische Zeichen in einer einzigen Interaktion zu erzeugen..

Das Konzept der maximalen Ausgabelänge ist relativ intuitiv und leicht zu verstehen; es begrenzt die maximale Textmenge, die das Modell in jeder Antwort produzieren kann. Sobald diese Grenze erreicht ist, kann das Modell keine weiteren Inhalte mehr erzeugen.

Kontextfenster: der Speicherbereich des Modells.

Die Kontextlänge, im technischen Bereich auch als Context Windowist ein Schlüsselparameter für das Verständnis der LLM-Fähigkeiten. Wir fahren fort mit dem DeepSeek Das Modell wird anhand eines Beispiels erläutert:

Wie in der Abbildung dargestellt, sind sowohl das Inferenzmodell als auch das Dialogmodell, dieDeepSeek (in Form eines Nominalausdrucks) Context Window alle sind 64K. Also.64K Was genau bedeutet die Kontextlänge der

Um die Kontextlänge zu verstehen, müssen wir zunächst ihre Definition klären. Context Window bezieht sich auf die maximale Anzahl von Token, die von einem Large Language Model (LLM) in einer einzigen Inferenzsitzung verarbeitet werden können.. Dieser Betrag besteht aus zwei Teilen:

(1) EingabebereichAlle Eingaben des Benutzers, wie z. B. Eingabeaufforderungen, Dialogverlauf und zusätzlicher Dokumentinhalt.

(2) AusgabebereichDer Inhalt der Antwort, die das Modell gerade erzeugt und zurückgibt.

Kurz gesagt, wenn wir eine einzelne Interaktion mit dem LLM haben, wird der gesamte Prozess, beginnend mit der Eingabe einer Frage und endend mit der Antwort des Modells, als "einzelne Inferenz" bezeichnet. Während dieser Schlussfolgerung kann die Summe aller eingegebenen und ausgegebenen Textinhalte (gezählt in Token) nicht größer sein als Context Window Die Einschränkungen für die DeepSeek In Bezug auf das Modell ist diese Einschränkung 64KDie Anzahl der chinesischen Schriftzeichen, die in der Studie verwendet werden, beträgt etwa 60.000, was der Anzahl der in der Studie verwendeten chinesischen Schriftzeichen entspricht.

Falls Sie sich das fragen.Gibt es also eine Grenze für die Eingabe von Informationen? Die Antwort lautet: Ja. Wie bereits erwähnt, hat das Modell eine Kontextlänge von 64K und eine maximale Ausgabelänge von 8K. Daher ist in einer einzigen Dialogrunde die maximale Anzahl von Token für den Eingabeinhalt theoretisch die Kontextlänge minus die maximale Ausgabelänge, d.h. 64K - 8K = 56K. Zusammengefasst kann der Benutzer in einer einzigen Frage-und-Antwort-Interaktion bis zu etwa 56.000 Wörter eingeben und das Modell kann bis zu etwa 8.000 Wörter ausgeben.

Mechanismen zur Behandlung von Kontexten für Mehrrunden-Dialoge

In der Praxis führen wir oft mehrere Dialogrunden mit den LLMs. Wie geht man also bei einem Mehrrunden-Dialog mit dem Kontext um? Nehmen Sie DeepSeek Wenn zum Beispiel ein Mehrrunden-Dialog eingeleitet wird, muss die Server-SeiteDer Dialogkontext des Benutzers wird nicht standardmäßig gespeichert. Dies bedeutet, dass inFür jede neue Dialoganfrage muss der Nutzer den gesamten Inhalt, einschließlich des Verlaufs des Dialogs, zusammenstellen und als Eingabeinformationen an die API übergeben.

Um die Mechanik eines Mehrrunden-Dialogs zu verdeutlichen, hier ein Python-Beispiel für einen Mehrrunden-Dialog unter Verwendung der DeepSeek-API:

from openai import OpenAI

client = OpenAI(api_key="<DeepSeek API Key>", base_url="https://api.deepseek.com")

# Round 1

messages = [{"role": "user", "content": "What's the highest mountain in the world?"}]

response = client.chat.completions.create(

model="deepseek-chat",

messages=messages

)

messages.append(response.choices[0].message)

print(f"Messages Round 1: {messages}")

# Round 2

messages.append({"role": "user", "content": "What is the second?"})

response = client.chat.completions.create(

model="deepseek-chat",

messages=messages

)

messages.append(response.choices[0].message)

print(f"Messages Round 2: {messages}")

Der Inhalt des Parameters messages, der in der ersten Runde der Dialoganfragen an die API übergeben wird, lautet wie folgt:

[

{"role": "user", "content": "What's the highest mountain in the world?"}

]

Erforderlich für die zweite Runde der Dialoganfragen:

(1) Addieren Sie den Output des Modells aus der vorangegangenen Dialogrunde zum Nachrichten Das Ende der Liste;

(2) Fügen Sie die neue Frage des Benutzers auch in die Nachrichten Das Ende der Liste.

In der zweiten Runde des Dialogs enthält der an die API übergebene Nachrichtenparameter also Folgendes:

[

{"role": "user", "content": "What's the highest mountain in the world?"},

{"role": "assistant", "content": "The highest mountain in the world is Mount Everest."},

{"role": "user", "content": "What is the second?"}

]

Daraus folgt, dass das Wesen eines Mehrrunden-Dialogs darin besteht, dieHistorische Dialogtranskripte (einschließlich Benutzereingabe und Modellausgabe) werden vor der letzten Benutzereingabe gespleißt, und der gespleißte vollständige Dialog wird dann in einem Durchgang an das LLM übermittelt.

Das bedeutet, dass in einem Mehrrunden-Dialogszenario das Kontextfenster für jede Dialogrunde nicht immer gleichbleibend 64K beträgt, sondern mit zunehmender Anzahl der Runden abnimmt. Wenn zum Beispiel die Ein- und Ausgaben der ersten Dialogrunde insgesamt 32K Token verwenden, dann beträgt das verfügbare Kontextfenster in der zweiten Dialogrunde nur noch 32K. Dieses Prinzip steht im Einklang mit der oben analysierten Begrenzung der Kontextlänge.

Vielleicht haben Sie auch eine Frage: Wenn nach diesem Mechanismus die Inputs und Outputs jeder Dialogrunde sehr lang sind, würde es dann nicht einige Dialogrunden brauchen, um die Grenzen des Modells zu überschreiten? In der Praxis scheint das Modell jedoch in der Lage zu sein, auch bei mehreren Dialogrunden korrekt zu reagieren.

Das ist eine sehr gute Frage, die uns zu einem weiteren Schlüsselkonzept führt: "kontextuelle Trunkierung".

Kontextuelle Kürzung: Strategien für den Umgang mit sehr langen Dialogen

Bei der Verwendung von LLM-basierten Produkten (z. B. DeepSeek, Wisdom Spectrum usw.) legen die Dienstanbieter die harten Grenzen des Kontextfensters in der Regel nicht direkt für den Benutzer offen, sondern verwenden Context Truncation, um Die Context Truncation-Strategie wird für die Verarbeitung sehr langer Texte verwendet.

Angenommen, das Modell unterstützt von Haus aus ein Kontextfenster von 64K. Wenn der Benutzer in mehreren Dialogrunden 64K oder annähernd 64K angesammelt hat und dann eine neue Anfrage (z.B. für 2K Token) stellt, wird die Grenze für das Kontextfenster überschritten. In diesem Fall behält der Server normalerweise die letzte 64K Token (einschließlich der jüngsten Eingabe), während der früheste Teil des Dialogverlaufs** verworfen wird. Für den Benutzer bleibt die jüngste Eingabe erhalten, während die früheste Eingabe (oder sogar Ausgabe) vom Modell "vergessen" wird. **

Aus diesem Grund leidet das Modell bei mehreren Dialogrunden manchmal an "Amnesie", auch wenn wir noch normale Antworten vom Modell erhalten können. Da die Kapazität des Kontextfensters begrenzt ist, kann sich das Modell nicht an alle historischen Dialoginformationen erinnern, es kann sich nur "an das Neueste erinnern und die lange zurückliegende Zeit vergessen".

Es ist zu betonen, dassDie "kontextabhängige Trunkierung" ist eine Strategie, die auf technischer Ebene implementiert wird, und nicht eine dem Modell selbst innewohnende Fähigkeit**. Die Benutzer nehmen den Trunkierungsprozess zum Zeitpunkt der Nutzung in der Regel nicht wahr, da die Serverseite dies im Hintergrund erledigt. **

Zusammenfassend können wir die folgenden Schlussfolgerungen zur Kontextlänge, zur maximalen Ausgabelänge und zur Kontextabschneidung ziehen:

- Das Kontextfenster (z.B. 64K) ist eine harte Grenze für das Modell zur Bearbeitung einer einzelnen AnfrageDie Gesamtzahl der Token-Eingänge und -Ausgänge darf diese Grenze nicht überschreiten.

- Serverseitige Verwaltung von sehr langem Text in Gesprächen mit mehreren Runden durch kontextabhängige KürzungsmaßnahmenErmöglicht es den Nutzern, in mehrere Dialogrunden auszubrechen Kontext-Fenster Dies würde jedoch auf Kosten der langfristigen Speicherkapazität des Modells gehen.

- Kontextfenster-Limits sind in der Regel eine Strategie des Dienstanbieters zur Kostenkontrolle oder RisikominderungDie technischen Möglichkeiten des Modells selbst sind nicht genau dieselben.

Vergleich der Modellparameter: OpenAI & Anthropic

Die Parametereinstellungen für die maximale Ausgabelänge und die Kontextlänge variieren zwischen den Modellanbietern. Die folgende Abbildung zeigt die Parameterkonfigurationen einiger Modelle, wobei OpenAI und Anthropic als Beispiele dienen:

In der Abbildung steht "Context Tokens" für die Kontextlänge und "Output Tokens" für die maximale Ausgabelänge.

Technische Grundsätze: Gründe für die Beschränkungen

Warum setzt der LLM Grenzen für die maximale Ausgabelänge und Kontextlänge? Aus technischer Sicht handelt es sich dabei um Beschränkungen der Modellarchitektur und der Rechenressourcen. Kurz gesagt, die Grenze für das Kontextfenster wird durch die folgenden Schlüsselfaktoren bestimmt:

(1) Bereich der Positionscodes: Transformator Das Modell stützt sich auf die Positionskodierung (z. B. RoPE, ALiBi), um jedem Token Positionsinformationen zuzuordnen, und der Bereich der Positionskodierungsdesigns bestimmt direkt die maximale Sequenzlänge, die das Modell verarbeiten kann.

(2) Berechnung des SelbstbeobachtungsmechanismusBei der Erzeugung jedes neuen Tokens muss das Modell die Aufmerksamkeitsgewichtung zwischen diesem Token und allen historischen Token (sowohl Eingabe als auch erzeugte Ausgabe) berechnen. Daher ist die Gesamtlänge der Sequenz streng begrenzt. Darüber hinaus ist die Speichernutzung des KV-Cache positiv mit der Gesamtlänge der Sequenz korreliert, und eine Überschreitung der Länge des Kontextfensters kann zu Speicherüberlauf oder Berechnungsfehlern führen.

Typische Anwendungsszenarien und Reaktionsstrategien

Es ist von entscheidender Bedeutung, die Konzepte der maximalen Ausgabelänge und der Kontextlänge sowie die dahinter stehenden technischen Prinzipien zu verstehen. Nach dem Erwerb dieses Wissens sollten die Nutzer entsprechende Strategien für den Einsatz großer Modellierungswerkzeuge entwickeln, um die Effizienz und Effektivität ihrer Nutzung zu erhöhen. Im Folgenden werden einige typische Anwendungsszenarien aufgeführt und die entsprechenden Reaktionsstrategien genannt:

- Kurzer Eingang + langer Ausgang

- AnwendungsszenarioBenutzer geben einen kleinen Betrag an Token ein (z. B. 1K) und möchten, dass das Modell lange Inhalte wie Artikel, Geschichten usw. generiert.

- Parameter Konfiguration: Zum Zeitpunkt des API-Aufrufs können Sie die max_tokens auf einen größeren Wert gesetzt wird, z. B. 63,000 (Vergewissern Sie sich, dass Sie die gleiche Anzahl von Token eingeben wie in der max_tokens und nicht mehr als Kontext-Fenster Grenzen, z. B. 1K + 63K ≤ 64K).

- potenzielles RisikoDie Modellausgabe kann aufgrund von Qualitätskontrollen (z. B. übermäßige Wiederholungen, Aufnahme sensibler Wörter usw.) vorzeitig abgebrochen werden.

- Langer Eingang + kurzer Ausgang

- AnwendungsszenarioDer Benutzer gibt ein langes Dokument ein (z.B. 60K Token) und bittet das Modell, es zusammenzufassen, Informationen zu extrahieren usw. und eine kurze Ausgabe zu produzieren.

- Parameter KonfigurationSie können einstellen max_tokens auf einen kleineren Wert gesetzt wird, zum Beispiel 4,000 (z. B. 60K + 4K ≤ 64K).

- potenzielles RisikoWenn das Modell tatsächlich mehr Output-Token benötigt als die Anzahl der max_tokens Wenn das Eingabedokument komprimiert wird (z. B. werden wichtige Absätze extrahiert, redundante Informationen reduziert usw.), um die Vollständigkeit der Ausgabe zu gewährleisten, wird auch die Ausgabe komprimiert.

- Management des Mehrrunden-Dialogs

- Regeln und VorschriftenWährend mehrerer Dialogrunden muss darauf geachtet werden, dass die Gesamtzahl der gesammelten Eingabe- und Ausgabemarken nicht höher ist als Kontext-Fenster Beschränkungen (deren Überschreitung abgeschnitten wird).

- typisches Beispiel::

(1) Dialog in Runde 1: Der Benutzer gibt 10K Token ein, das Modell gibt 10K Token aus und sammelt 20K Token.

(2) Dialog der Runde 2: Benutzereingabe 30K Token, Modellausgabe 14K Token, kumulierte 64K Token.

(3) Dialog in Runde 3: Der Benutzer gibt 5K Token ein, der Server schneidet die frühesten 5K Token ab und behält die letzten 59K Token. Token Geschichte, plus eine neue Eingabe von 5K Token für insgesamt 64K Token.

Wenn wir die drei Kernkonzepte Token, maximale Ausgabelänge und Kontextlänge verstehen und eine vernünftige Strategie auf der Grundlage spezifischer Anwendungsszenarien formulieren, können wir die LLM-Technologie effektiver nutzen und ihr Potenzial voll ausschöpfen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Verwandte Beiträge

Keine Kommentare...