Peso pesado! O primeiro modelo descentralizado de 10 bilhões do mundo treinado e de código aberto em uma semana!

Nasce o primeiro modelo paramétrico 10B treinado de forma descentralizada do mundo! A equipe da Prime Intellect anunciou que concluiu um trabalho histórico: uma rede de treinamento descentralizada nos EUA, na Europa e na Ásia que treinou com sucesso um grande modelo com 10 bilhões de parâmetros. Isso marca uma etapa revolucionária no campo do treinamento de IA.

A equipe da Prime Intellect anunciou que concluiu um trabalho histórico: uma rede de treinamento descentralizada nos EUA, na Europa e na Ásia que treinou com sucesso um grande modelo com 10 bilhões de parâmetros. Isso marca uma etapa revolucionária no campo do treinamento de IA.

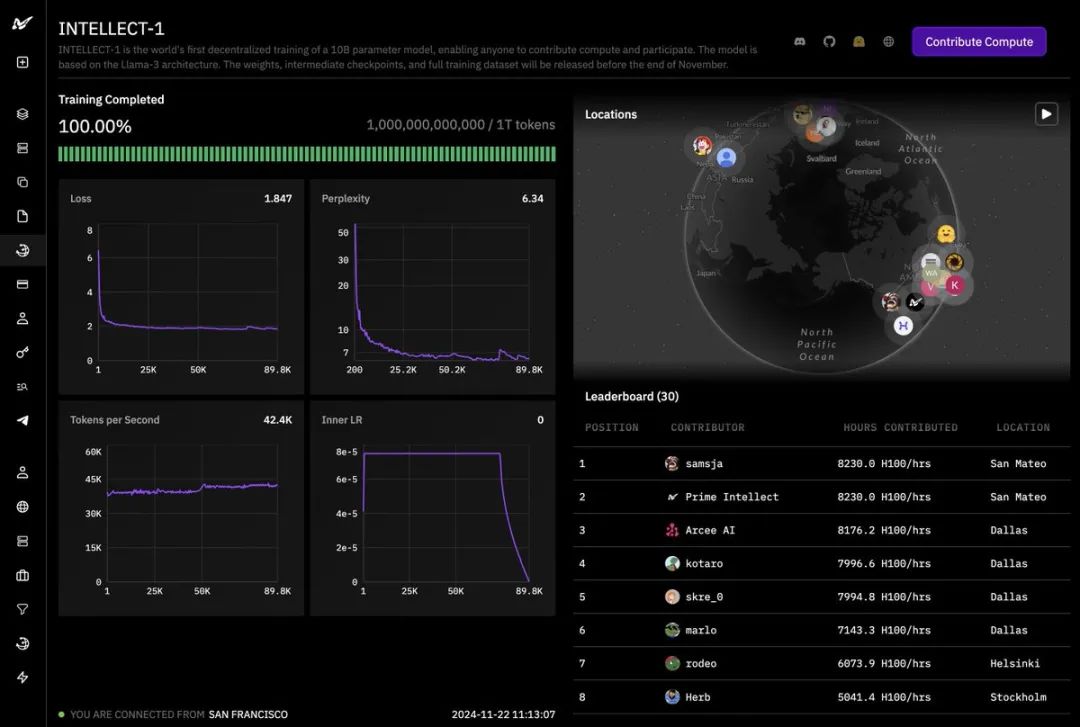

Como você pode ver no painel de treinamento, o projeto, chamado INTELLECT-1, já concluiu o treinamento de 1 trilhão (1T) de tokens.

As curvas de perda e perplexidade mostram uma tendência desejável de queda, e o número de tokens gerados por segundo permanece estável, indicando que o processo de treinamento foi muito bem-sucedido. O sucesso desse projeto não teria sido possível sem o apoio de muitos parceiros.

O sucesso desse projeto não teria sido possível sem o apoio de muitos parceiros.

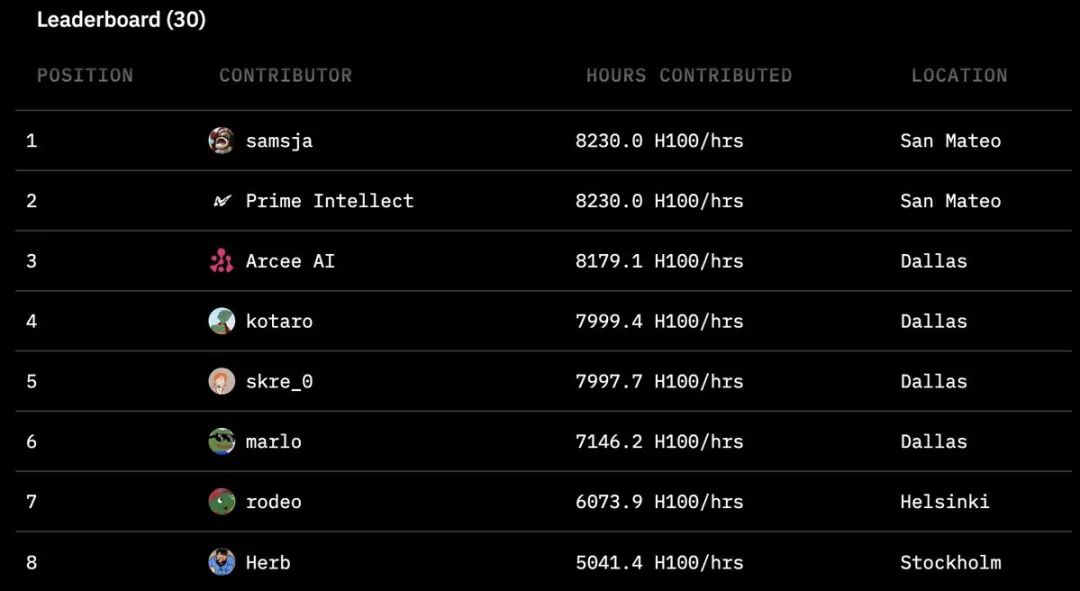

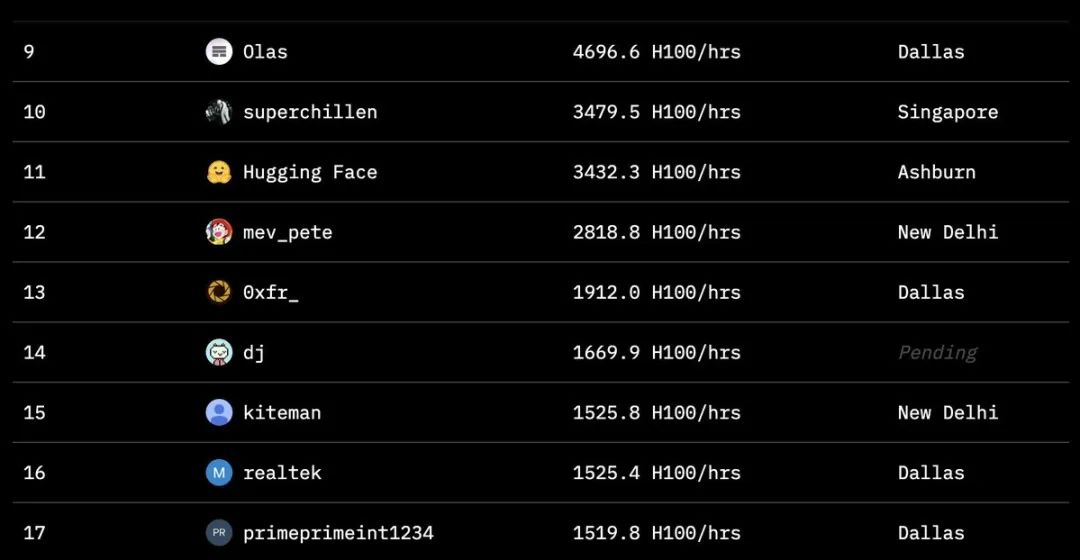

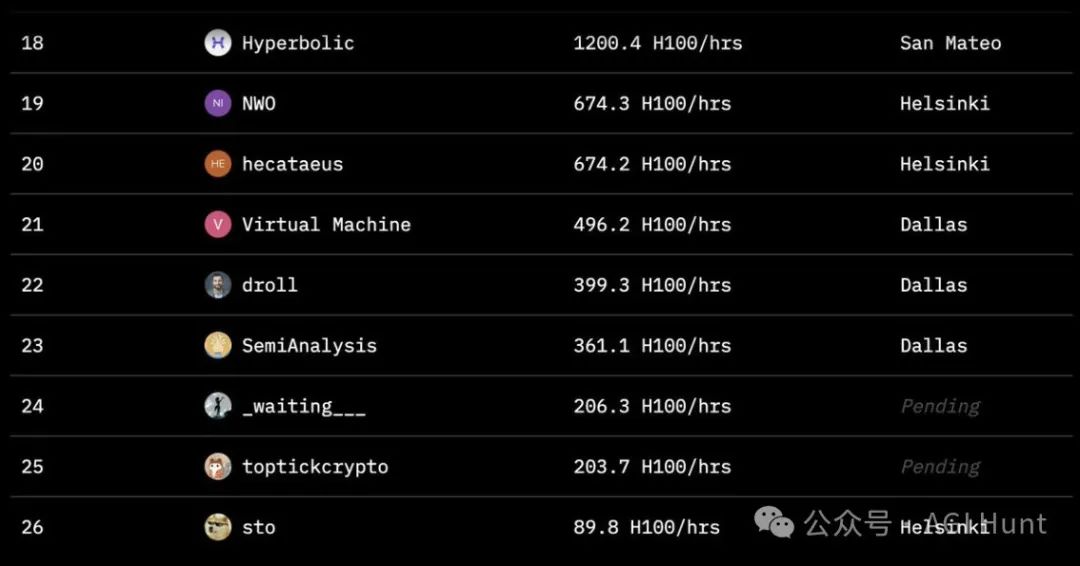

Várias organizações, incluindo Hugging Face, SemiAnalysis, Arcee.ai, Hyperbolic Labs, Olas, Akash, Schelling AI e outras, contribuíram com recursos aritméticos valiosos para o treinamento. Esse modelo de cooperação sem precedentes demonstra um novo tipo de colaboração em IA. Como você pode ver na tabela de classificação do projeto, colaboradores de todo o mundo forneceram uma quantidade impressionante de tempo de computação. O maior colaborador chegou a 8.230 horas, com participantes espalhados por San Mateo, Dallas, Helsinque e Estocolmo. Esse modelo global de colaboração aritmética permite que o treinamento em IA não fique mais limitado aos data centers de um punhado de gigantes da tecnologia.

Como você pode ver na tabela de classificação do projeto, colaboradores de todo o mundo forneceram uma quantidade impressionante de tempo de computação. O maior colaborador chegou a 8.230 horas, com participantes espalhados por San Mateo, Dallas, Helsinque e Estocolmo. Esse modelo global de colaboração aritmética permite que o treinamento em IA não fique mais limitado aos data centers de um punhado de gigantes da tecnologia.

Em um nível técnico, a inovação desse projeto é igualmente impressionante.

A equipe adotou a técnica de treinamento distribuído DiLoCo para enfrentar os desafios do treinamento entre regiões. Para lidar com os vários desafios em um ambiente distribuído, a equipe de pesquisa também implementou um mecanismo de treinamento tolerante a falhas e técnicas assíncronas de checkpointing distribuído.

Em termos de otimização de memória, a equipe optou por atualizar para a estrutura FSDP2, que resolveu com sucesso os problemas de alocação de memória presentes no FSDP1.

Enquanto isso, a eficiência do treinamento é significativamente aprimorada pela aplicação da tecnologia de computação paralela de tensores.

Por trás dessas inovações tecnológicas está uma forte equipe de pesquisa que trabalha silenciosamente. O líder do projeto agradece especialmente a Tristan Rice e Junjie Wang por suas contribuições em treinamento tolerante a falhas, e a Chien-Chin Huang e Iris Zhang por seu trabalho em checkpointing distribuído assíncrono. Além disso, Yifu Wang é creditado por suas orientações sobre computação paralela de tensores.

O que é ainda mais empolgante é que a equipe anunciou que lançará a versão completa de código aberto dentro de uma semana, incluindo o modelo básico, os arquivos de ponto de verificação, o modelo pós-treinamento e o conjunto de dados de treinamento. Isso significa que, em breve, pesquisadores e desenvolvedores de todo o mundo poderão inovar e desenvolver com base nesse modelo.

Já existem desenvolvedores que mal podem esperar para começar a fazer experiências. Um desenvolvedor demonstrou uma tentativa de inferência de modelo em duas placas de vídeo 4090 na costa oeste dos Estados Unidos e na Europa. Embora a conexão de rede entre os dois locais não fosse ideal, esse experimento comprovou a flexibilidade e a adaptabilidade do modelo.

O sucesso desse projeto não é apenas um avanço tecnológico, mas um marco importante na democratização da IA para todos.

Isso prova que, por meio da colaboração global, estamos bem posicionados para romper as limitações do treinamento tradicional em IA e envolver mais organizações e indivíduos na onda de desenvolvimento da IA.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...