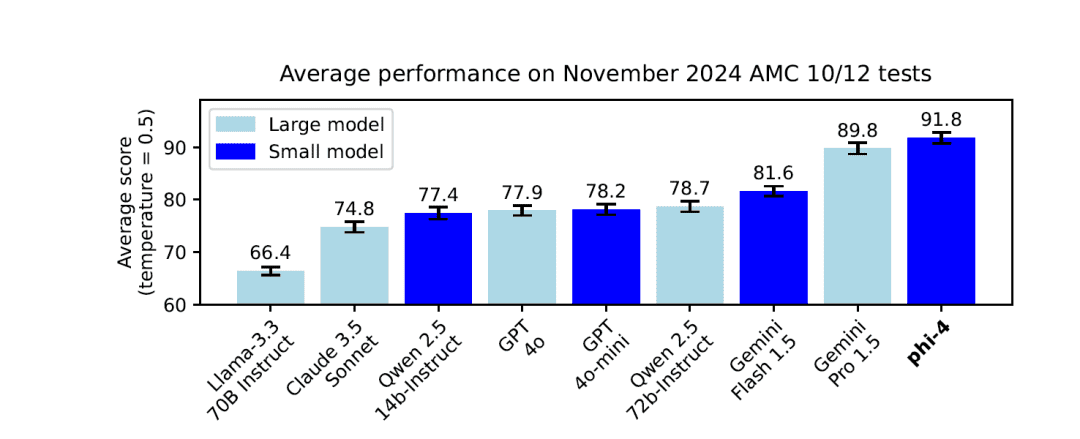

O novo modelo da Microsoft: Phi-4 está aqui, com parâmetros de 14B comparáveis a modelos de escala maior

Com apenas 14 bilhões (14B) de parâmetros, o Phi-4 demonstra desempenho comparável ou até mesmo superior a alguns modelos de maior escala por meio de métodos de treinamento inovadores e dados de alta qualidade. Este documento descreve em detalhes a arquitetura, os recursos, a metodologia de treinamento e o desempenho do Phi-4 em aplicativos e benchmarks do mundo real.

https://github.com/xinyuwei-david/david-share.git

I. Análise de indicadores para medir a capacidade

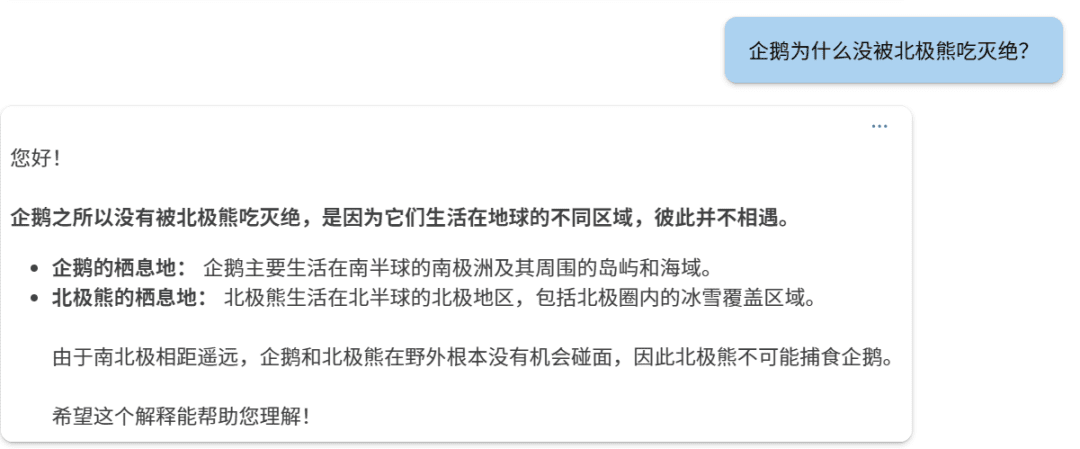

Meça três questões comparando o1 e Phi-4

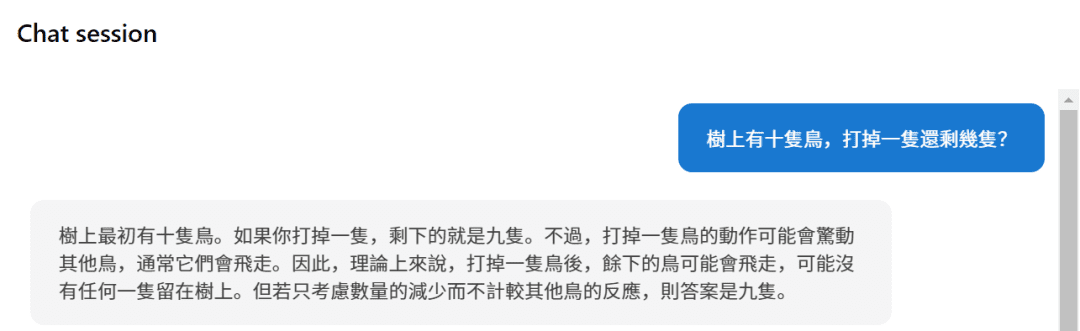

Primeira pergunta:

phi-4

o1

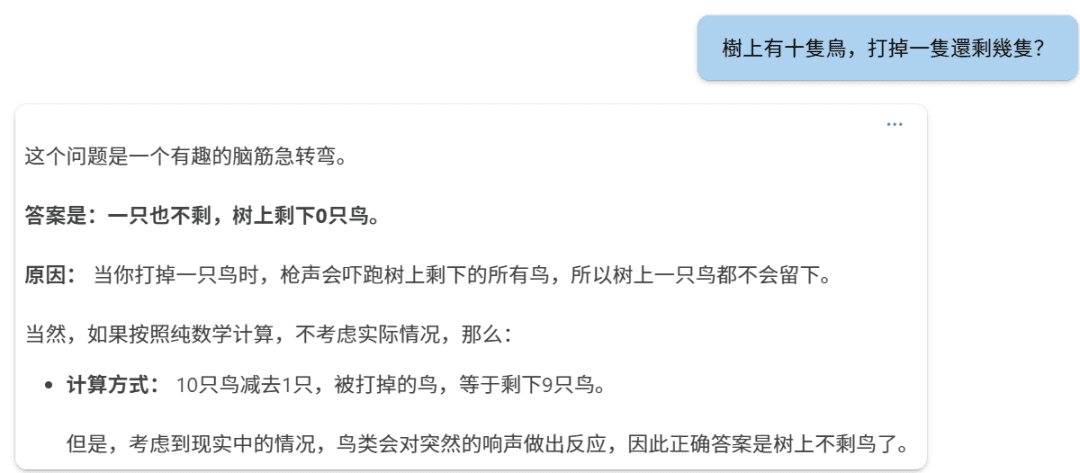

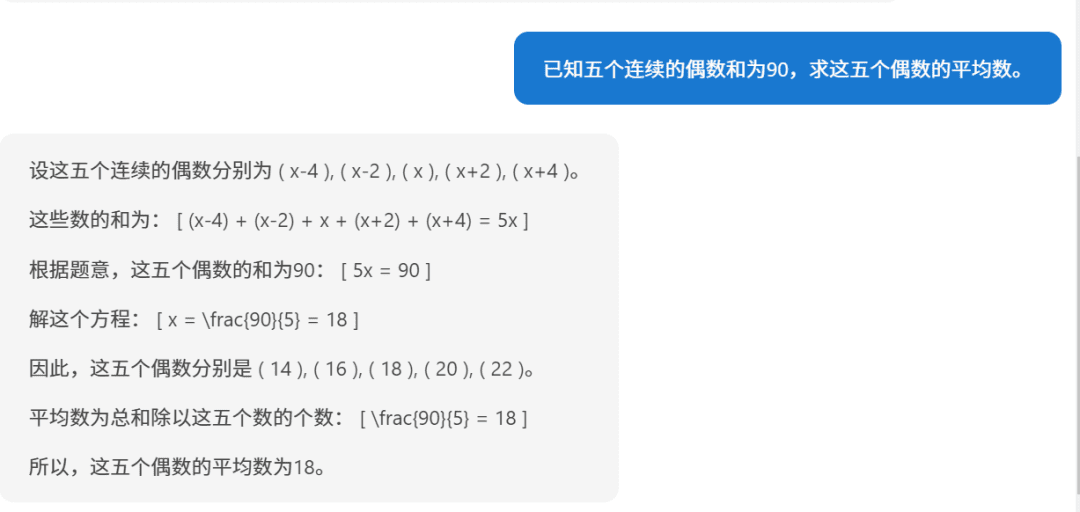

Segunda pergunta:

Phi-4.

o1:

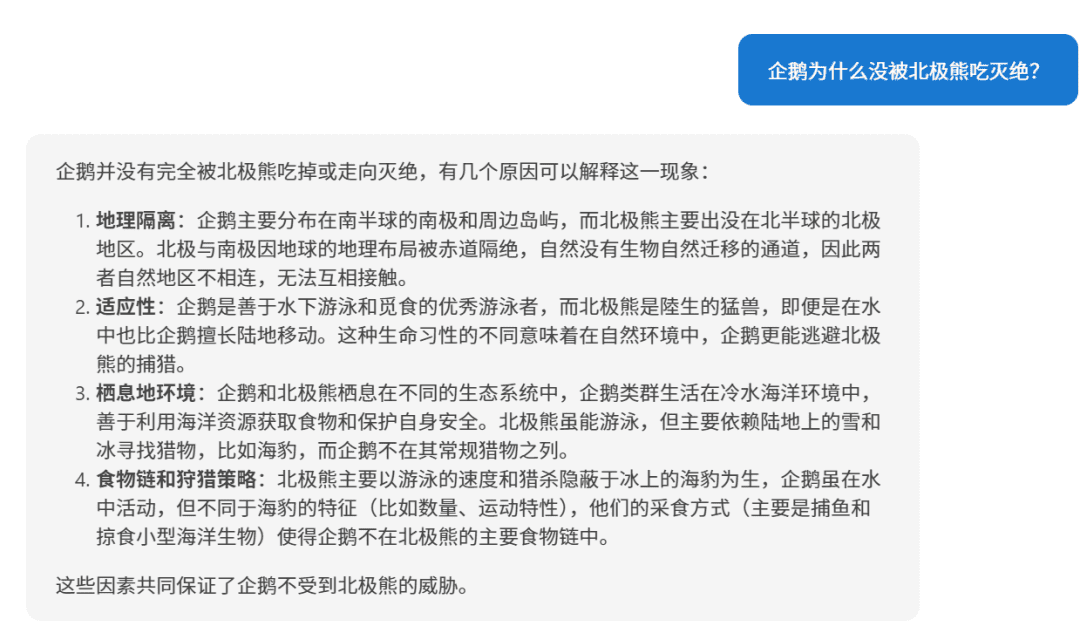

Terceira pergunta:

Phi-4

o1.

要求五个连续偶数的平均数,已知它们的和为90,下面我们逐步解答。步骤1:设未知数设这五个连续的偶数为:第一个偶数:( n - 4 )第二个偶数:( n - 2 )第三个偶数:( n )第四个偶数:( n + 2 )第五个偶数:( n + 4 )(因为偶数之间相差2,所以相邻的偶数可以这样表示)步骤2:列方程求和根据题目,五个数的和为90:[(n - 4) + (n - 2) + n + (n + 2) + (n + 4) = 90]步骤3:简化方程合并同类项:[5n = 90]步骤4:求解 n[n = frac{90}{5} = 18]步骤5:求出五个偶数第一个偶数:( 18 - 4 = 14 )第二个偶数:( 18 - 2 = 16 )第三个偶数:( 18 )第四个偶数:( 18 + 2 = 20 )第五个偶数:( 18 + 4 = 22 )步骤6:计算平均数平均数等于总和除以数量:[text{平均数} = frac{14 + 16 + 18 + 20 + 22}{5} = frac{90}{5} = 18]答案:这五个连续的偶数的平均数是 18。

Quando você olha dessa forma, o raciocínio de Phi-4 ainda é bom.

II. Phi-4 arquitetura do modelo

1. arquitetura do decodificador baseado em transformador

O Phi-4 emprega um sistema baseado no Transformador (usado em uma expressão nominal) Somente decodificador Essa arquitetura é semelhante à família de modelos GPT. Essa arquitetura utiliza o Mecanismo de Auto-Atenção para capturar com eficácia as dependências de longo prazo em sequências de texto e se destaca em tarefas de geração de linguagem natural.

2. tamanho do parâmetro e número de camadas

- Número total de parâmetros: 14 bilhões (14B) Parâmetros.

- Número de andares do modelo: 40

3. comprimento do contexto

- Comprimento do contexto inicial: 4,096 Token.

- Extensão do treinamento de médio prazo: Na fase intermediária do treinamento, o comprimento do contexto do Phi-4 foi estendido para 16,000 Token (16K), que melhora a capacidade do modelo de lidar com textos longos.

4. glossário e lexer

- Separadores: Usando o Divisor de tiktokenA empresa oferece suporte a vários idiomas e tem um melhor efeito de divisão de palavras.

- Tamanho do glossário: 100,352Isso inclui alguns tokens reservados não utilizados.

III Mecanismos de atenção e codificação de posição

1. mecanismos de atenção global

O Phi-4 usa Mecanismo de atenção plenaou seja, a autoatenção é computada para toda a sequência de contextos. Isso contrasta com o modelo predecessor, Phi-3-medium, que usa 2.048 Token da janela deslizante, enquanto o Phi-4 executa o cálculo da atenção global diretamente nos contextos de 4.096 tokens (inicial) e 16.000 tokens (estendido), melhorando a capacidade do modelo de capturar dependências de longo alcance.

2. codificação de posição rotativa (RoPE)

Para suportar contextos mais longos, o Phi-4 foi adaptado no meio do treinamento para Embeddings de posição rotativa (RoPE) da frequência básica:

- Ajuste da frequência básica: Aumentar a frequência básica do RoPE para 250,000para acomodar o comprimento do contexto de 16K.

- Função: O RoPE ajuda o modelo a manter a eficácia da codificação posicional em sequências longas, permitindo que o modelo mantenha um bom desempenho em textos mais longos.

IV Estratégias e métodos de treinamento

1. o conceito de priorização da qualidade dos dados

A estratégia de treinamento do Phi-4 se baseia em Qualidade dos dados no núcleo. Ao contrário de outros modelos que são pré-treinados usando principalmente dados orgânicos da Internet (por exemplo, conteúdo da Web, código etc.), o Phi-4 introduz estrategicamente ao longo do processo de treinamento um Dados sintéticos.

2. geração e aplicação de dados sintéticos

Dados sintéticos desempenhou um papel fundamental no pré-treinamento e no treinamento intermediário do Phi-4:

- Várias técnicas de geração de dados:

- Prompting multiagente: A diversidade de dados é enriquecida pelo uso de vários modelos de linguagem ou agentes para gerar dados em conjunto.

- Fluxos de trabalho de auto-revisão: Depois que o modelo gera o resultado inicial, ele realiza a autoavaliação e a correção para melhorar iterativamente a qualidade do resultado.

- Reversão de instruções: A geração de instruções de entrada correspondentes a partir de saídas existentes aumenta a capacidade do modelo de entender e gerar instruções.

- Vantagens dos dados sintéticos:

- Aprendizado estruturado e progressivo: Os dados sintéticos permitem o controle preciso da dificuldade e do conteúdo, orientando gradualmente o modelo a aprender habilidades complexas de raciocínio e solução de problemas.

- Melhorar a eficiência do treinamento: A geração de dados sintéticos pode fornecer dados de treinamento direcionados para os pontos fracos do modelo.

- Evite a contaminação dos dados: Como os dados sintéticos são gerados, evita-se o risco de que os dados de treinamento contenham o conteúdo do conjunto de análise.

3. triagem fina e filtragem de dados orgânicos

Além dos dados sintéticos, o Phi-4 se concentra em selecionar e filtrar cuidadosamente dados de alta qualidade de várias fontes Dados orgânicos::

- Fontes de dados: Inclui conteúdo da Web, livros, bibliotecas de códigos, artigos acadêmicos e muito mais.

- Filtragem de dados:

- Remova o conteúdo de baixa qualidade: Use métodos automatizados e manuais para filtrar conteúdo sem sentido, incorreto, duplicado ou prejudicial.

- Evitar a contaminação dos dados: Um algoritmo híbrido de n-grama (13-grama e 7-grama) foi usado para desduplicação e descontaminação para garantir que os dados de treinamento não contivessem conteúdo do conjunto de revisões.

4. estratégia de combinação de dados

O Phi-4 foi otimizado na composição dos dados de treinamento com as seguintes proporções:

- Dados sintéticos: tomar posse de 40%.

- Reescrita na Web: tomar posse de 15%No caso de uma nova amostra de treinamento, ela é reescrita a partir de conteúdo da Web de alta qualidade para gerar uma nova amostra de treinamento.

- Dados orgânicos da Web: tomar posse de 15%O conteúdo da Web é uma seleção de conteúdo valioso da Web.

- Dados de código: tomar posse de 20%incluindo a base de código pública e os dados de síntese de código gerados.

- Aquisições direcionadas: tomar posse de 10%incluindo artigos acadêmicos, livros profissionais e outros conteúdos de alto valor.

5. processo de treinamento em vários estágios

Fase de pré-treinamento:

- Objetivo: Modelagem da compreensão linguística subjacente e das habilidades geradoras.

- Volume de dados: Marque uma consulta 10 trilhões (10T) Token.

Fase de treinamento de médio prazo:

- Objetivo: Ampliação do comprimento do contexto para melhorar o processamento de textos longos.

- Volume de dados: 250 bilhões (250B) Token.

Fase pós-treinamento (ajuste fino):

- Supervised Fine Tuning (SFT): O ajuste fino usando dados de alta qualidade e de vários domínios melhora a capacidade do modelo de seguir instruções e a qualidade das respostas.

- Otimização de preferências diretas (DPO): Utilizar Pesquisa de Token Pivotal (PTS) e outros métodos para otimizar ainda mais o resultado do modelo.

V. Técnicas de treinamento inovadoras

1. Pivotal Token Search (PTS)

Metodologia PTS é uma grande inovação no processo de treinamento do Phi-4:

- Princípio: Ao identificar os principais tokens que têm um impacto significativo na exatidão da resposta durante o processo de geração, o modelo é direcionado para otimizar a previsão desses tokens.

- Vantagens:

- Melhorar a eficiência do treinamento: Concentrar sua otimização nas partes que têm o maior impacto nos resultados é duas vezes mais eficaz.

- Desempenho aprimorado do modelo: Ajuda o modelo a fazer as escolhas certas nos principais pontos de decisão e melhora a qualidade geral do resultado.

2. otimização aprimorada de preferências diretas (DPO)

- Método DPO: A otimização é realizada diretamente usando dados de preferência para tornar o resultado do modelo mais consistente com as preferências humanas.

- Pontos de inovação:

- Combinado com PTS: A introdução de pares de dados de treinamento gerados por PTS no DPO melhora a otimização.

- Avaliação de indicadores: Meça a otimização com mais precisão, avaliando o desempenho do modelo no Token principal.

VI. recursos e vantagens do modelo

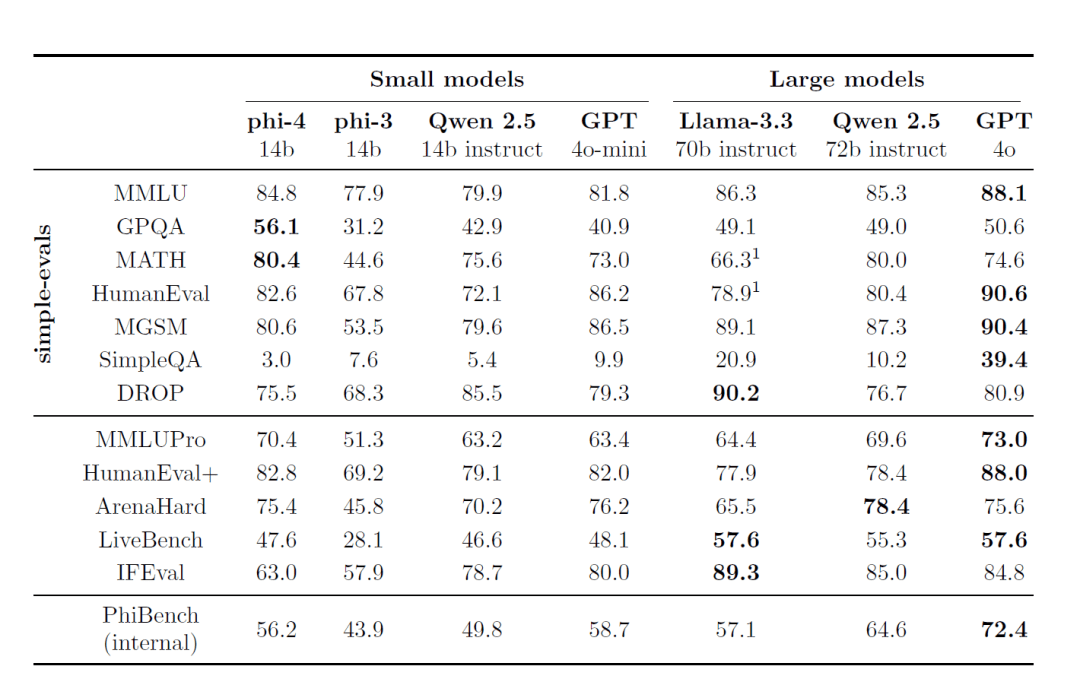

1. excelente desempenho

- Modelos pequenos, grandes recursos: Embora a escala de parâmetros seja apenas 14BNo entanto, o Phi-4 tem um bom desempenho em vários benchmarks de análise, especialmente em tarefas de raciocínio e resolução de problemas.

2. excelentes habilidades de raciocínio

- Resolução de problemas de matemática e ciências: existir GPQAeMATEMÁTICA Em testes de benchmark como este, o Phi-4 tem resultados ainda melhores do que o modelo do professor GPT-4o.

3. longos recursos de processamento contextual

- Extensão do comprimento do contexto: Ao expandir a duração do contexto no meio do treinamento para 16,000 Token, o Phi-4 é capaz de lidar com textos longos e dependências de longa distância com mais eficiência.

4. suporte multilíngue

- Cobertura de vários idiomas: Os dados de treinamento consistiram em Alemão, espanhol, francês, português, italiano, hindi, japonês e muitos outros idiomas.

- Competência interlinguística: É excelente em tarefas como tradução e questionários entre idiomas.

5. segurança e conformidade

- Princípios de IA responsável: O processo de desenvolvimento segue rigorosamente os Princípios de IA Responsável da Microsoft, com foco na segurança e na ética do modelo.

- Descontaminação de dados e proteção da privacidade: Estratégias rigorosas de desduplicação e filtragem de dados são usadas para evitar que conteúdos confidenciais sejam incluídos nos dados de treinamento.

VII - Benchmarks e desempenho

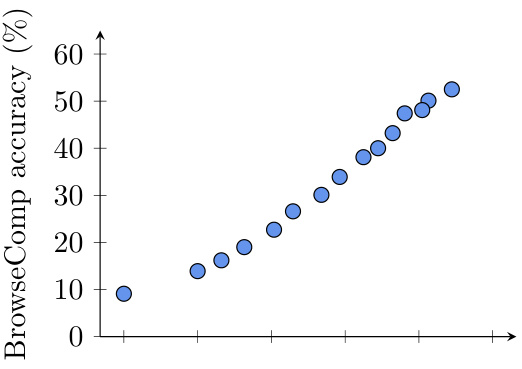

1. benchmarking externo

O Phi-4 demonstra desempenho líder em vários benchmarks de análise disponíveis publicamente:

- MMLU (Multitasking Language Understanding): Obteve excelentes resultados em testes complexos de compreensão de múltiplas tarefas.

- GPQA (Questionário STEM de nível de pós-graduação): se destacou no difícil questionário STEM, com pontuação mais alta do que alguns dos modelos em escala maior.

- MATH (competição de matemática): Na resolução de problemas matemáticos, o Phi-4 demonstra sólidos recursos de raciocínio e computação.

- HumanEval / HumanEval+ (geração de código): Nas tarefas de geração e compreensão de código, o Phi-4 supera os modelos de seu tamanho e até se aproxima de modelos maiores.

2. suíte de avaliação interna (PhiBench)

Para obter informações sobre os recursos e as deficiências do modelo, a equipe desenvolveu um conjunto de avaliação interna especializada PhiBench::

- A tarefa de diversificação: Inclui depuração de código, conclusão de código, raciocínio matemático e identificação de erros.

- Orientação sobre otimização de modelos: Ao analisar os resultados do PhiBench, a equipe conseguiu direcionar melhorias para o modelo.

VIII. segurança e responsabilidade

1. estratégia de alinhamento de segurança rigorosa

O desenvolvimento do Phi-4 segue o modelo da Microsoft Princípios para uma IA responsávelO foco é a segurança e a ética do modelo durante o treinamento e o ajuste fino:

- Proteção contra conteúdo nocivo: Reduza a probabilidade de o modelo gerar conteúdo inadequado incluindo dados de ajuste fino de segurança na fase pós-treinamento.

- Teste de equipe vermelha e avaliação automatizada: Foram realizados testes extensivos com a equipe vermelha e avaliações de segurança automatizadas, abrangendo dezenas de categorias de risco em potencial.

2. descontaminação de dados e prevenção de sobreajuste

- Estratégias aprimoradas de descontaminação de dados: Um algoritmo híbrido de 13 e 7 gramas é usado para remover qualquer possível sobreposição dos dados de treinamento com os benchmarks de revisão e evitar o ajuste excessivo do modelo.

IX. recursos e tempo de treinamento

1. tempo de treinamento

Embora o relatório oficial não especifique o tempo total de treinamento para o Phi-4, considere:

- Escala do modelo: Parâmetros 14B.

- Volume de dados de treinamento: Token 10T na fase de pré-treinamento, Token 250B no meio do treinamento.

Pode-se supor que todo o processo de treinamento levou um tempo considerável.

2. consumo de recursos da GPU

| GPUs | 1920 H100-80G |

| Tempo de treinamento | 21 dias |

| Dados de treinamento | 9.8T tokens |

X. Aplicativos e limitações

1. cenários de aplicativos

- Sistema de perguntas e respostas: O Phi-4 tem bom desempenho em tarefas complexas de quizzing e é adequado para todos os tipos de aplicativos de quizzing inteligente.

- Geração e compreensão de códigos: Excelente em tarefas de programação e pode ser usado em cenários como tutoria de código, geração automática e depuração.

- Tradução e processamento multilíngue: Suporte multilíngue para serviços de idiomas globalizados.

2) Limitações potenciais

- Limite de conhecimento: O conhecimento do modelo se limita aos dados de treinamento e pode não saber nada sobre os eventos que ocorrem após o treinamento.

- Desafio de sequência longa: Embora o comprimento do contexto seja estendido para 16K, ainda pode haver desafios ao lidar com sequências mais longas.

- Controle de riscos: Apesar das rigorosas medidas de segurança, os modelos ainda podem estar sujeitos a ataques adversários ou à geração inadvertida de conteúdo inadequado.

O sucesso do Phi-4 demonstra a importância da qualidade dos dados e da estratégia de treinamento no desenvolvimento de modelos de linguagem em grande escala. Por meio de métodos inovadores de geração de dados sintéticos, estratégias cuidadosas de combinação de dados de treinamento e técnicas avançadas de treinamento, o Phi-4 alcança excelente desempenho, mantendo um pequeno tamanho de parâmetro:

- As habilidades de raciocínio são excelentes: Excelente nas áreas de matemática, ciências e programação.

- Processamento de textos longos: O comprimento estendido do contexto dá ao modelo uma vantagem em tarefas de processamento de textos longos.

- Segurança e responsabilidade: A adesão estrita aos princípios de IA responsável garante que os modelos sejam seguros e éticos.

O Phi-4 estabelece uma nova referência no desenvolvimento de modelos quantitativos paramétricos pequenos, demonstrando que, ao se concentrar na qualidade dos dados e nas estratégias de treinamento, é possível obter um desempenho superior mesmo em escalas de parâmetros menores.

Referências: /https://www.microsoft.com/en-us/research/uploads/prod/2024/12/P4TechReport.pdf

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...