Think&Cite: melhorando a precisão da citação de textos usando técnicas de pesquisa em árvore

resumos

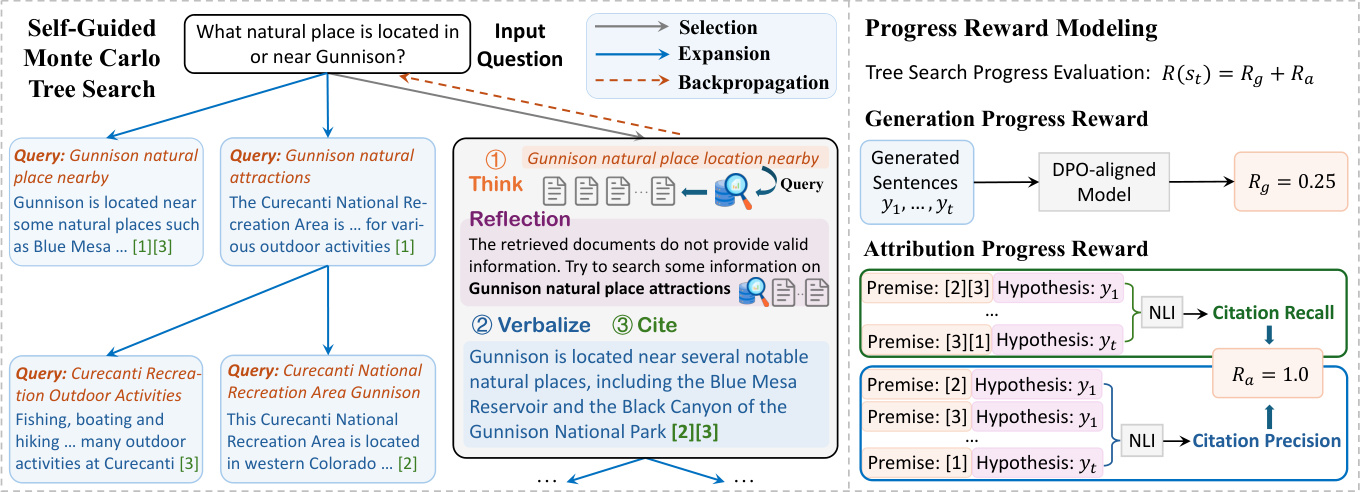

Embora os modelos de linguagem grande (LLMs) tenham um bom desempenho, eles são propensos a alucinar e gerar informações factualmente imprecisas. Esse desafio tem motivado esforços na geração de textos de atributos, o que faz com que os LLMs gerem conteúdo que contenha evidências de apoio. Neste artigo, propomos uma nova estrutura chamada Think&Cite e formulamos a geração de texto de atributos como um problema de raciocínio de várias etapas com pesquisa integrada. Especificamente, propomos o Self-Guided Monte Carlo Tree Search (SG-MCTS), que utiliza a capacidade de autorreflexão dos LLMs para refletir sobre os estados intermediários do MCTS, orientando assim o processo de expansão da árvore. Para fornecer feedback confiável e abrangente, introduzimos o Progress Reward Model (PRM), que mede o progresso da pesquisa em árvore desde o nó raiz até o estado atual, tanto da perspectiva generativa quanto da de atributos. Realizamos experimentos abrangentes em três conjuntos de dados e os resultados mostram que nosso método supera significativamente o método de linha de base.

1 Introdução

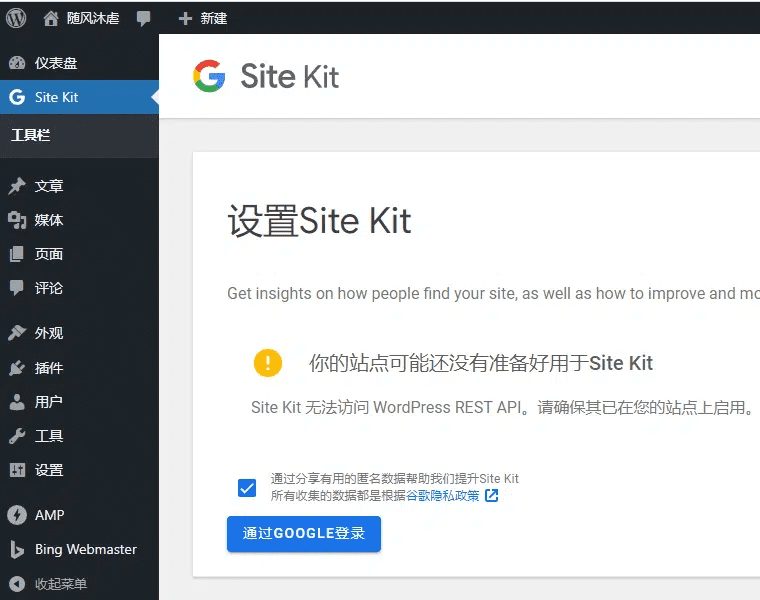

Os modelos de linguagem em grande escala (LLMs) (Zhao et al., 2023) têm bom desempenho em muitas tarefas de processamento de linguagem natural. Apesar desses avanços, os LLMs frequentemente geram respostas que contêm informações ilusórias e imprecisas (Ji et al., 2023; Huang et al., 2023; Zhang et al., 2023). Esse problema compromete sua confiabilidade e, o que é mais importante, a confiança dos usuários nos LLMs. Para melhorar a confiabilidade dos LLMs, foi proposto um novo paradigma de geração, a geração de texto de atributos, que permite que os LLMs gerem respostas que contenham citações no texto para fornecer evidências (Gao et al., 2023b), conforme mostrado na Figura 1.

Figura 1: Com uma pergunta, o modelo gera texto citando passagens do corpus como evidência de apoio.

A maioria dos trabalhos existentes (Slobodkin et al., 2024; Sun et al., 2024; Fierro et al., 2024) simplesmente solicita que os LLMs forneçam citações ao gerar texto. Além disso, outros trabalhos (Li et al., 2024; Huang et al., 2024) tentam ajustar os LLMs em grandes quantidades de dados de treinamento supervisionados que contêm texto com citações anotadas. Apesar desses esforços recentes, o desenvolvimento de LLMs que aprendem a gerar conteúdo fiel com citações confiáveis continua sendo um desafio em aberto. Em primeiro lugar, os métodos existentes usam um paradigma de geração autorregressiva, que pode ser caracterizado como "Sistema 1", um modo de pensar rápido e instintivo, mas insuficientemente preciso (Kahneman, 2011). Como resultado, qualquer erro gerador intermediário (por exemplo, representação ou citação incorreta) pode resultar em uma resposta final incorreta. Inspirados pela pesquisa de raciocínio complexo (Zhang et al., 2024; Wang et al., 2024), nosso objetivo foi desenvolver um modelo para o paradigma do "Sistema 2" para citar evidências externas, o que exige um pensamento mais profundo, cuidadoso e lógico (Kahneman, 2011). Em segundo lugar, a geração de texto de atributos geralmente envolve a geração de textos longos. liu et al. (2023) descobriram que as respostas longas aos LLMs existentes geralmente contêm declarações sem suporte e citações imprecisas. Argumentamos que a falta de planejamento explícito de geração em trabalhos anteriores prejudicou o progresso de tais sistemas.

Neste artigo, apresentamos o Think&Cite, uma nova estrutura para integrar algoritmos de pesquisa na geração de textos de atributos. Conceituamos a tarefa de geração como um problema de inferência em várias etapas, no qual o modelo gera uma frase em cada etapa por meio de um paradigma iterativo de pensar-expressar-referir. Para aprimorar esse processo de geração, propomos o Self-Guided Monte Carlo Tree Search (SG-MCTS), que amplia o MCTS clássico com duas inovações. Primeiro, nossa abordagem utiliza o recurso de autorreflexão dos LLMs para refletir sobre os estados intermediários do MCTS em tempo real, orientando assim o processo de expansão da árvore e evitando ativamente caminhos de inferência inadequados. Isso contrasta com os trabalhos anteriores que refletem principalmente sobre o resultado final ou a trajetória completa. Em segundo lugar, propomos o Modelo de Recompensa de Progresso (PRM), que mede o progresso da pesquisa em árvore desde o nó raiz até o estado atual, tanto da perspectiva generativa quanto da perspectiva de atributos. Em contraste com a avaliação apenas de etapas individuais, o modelo de recompensa baseado no progresso fornece uma avaliação confiável e abrangente para orientar o processo de pesquisa do MCTS.

Até onde sabemos, somos os primeiros a aplicar um algoritmo de pesquisa em árvore à tarefa de geração de texto de atributos. Realizamos experimentos abrangentes em três conjuntos de dados para validar a eficácia de nossa abordagem. Os resultados mostram que nosso modelo supera significativamente as dicas anteriores e as linhas de base ajustadas.

2 Trabalhos relacionados

Geração de texto com atribuição. Modelos de linguagem grandes (LLMs) têm sido usados para geração de texto com atribuição devido a seus excelentes recursos de geração de linguagem (Gao et al., 2023b; Huang et al., 2024; Sun et al., 2024; Li et al., 2024; Slobodkin et al., 2024). Os LLMs para geração de texto com atribuição podem ser divididos em duas categorias. O trabalho gerado pode ser dividido em duas categorias. O primeiro tipo envolve o ajuste fino do LLM usando aprendizagem de preferências (Li et al., 2024) e aprendizagem por reforço (Huang et al., 2024), que ensina o LLM a gerar citações relevantes e de apoio para obter recompensas mais altas. Entretanto, essa abordagem depende de humanos para reunir conjuntos de dados de alta qualidade com citações anotadas no texto. Outra classe de trabalho instrui diretamente o LLM a gerar texto com atribuições por meio do planejamento de atribuição e geração (Slobodkin et al., 2024) ou usando um validador externo para orientar a geração (Sun et al., 2024). No entanto, essa abordagem gera texto e citações de maneira autorregressiva, em que qualquer geração intermediária imprecisa está sujeita a falhas no processo subsequente. Por outro lado, nossa abordagem propõe a busca em árvore autoguiada com recompensas progressivas para considerar vários caminhos.

LLM com busca em árvore: a integração de algoritmos de busca em árvore com LLM tem atraído muita atenção. Estudos recentes investigaram o uso de métodos de busca em árvore para aprimorar o desempenho do LLM durante a inferência (Zhang et al., 2024; Wang et al., 2024; Ye e Ng, 2024). Sutton (2019) enfatizou a superioridade do escalonamento no aprendizado e na busca em relação a outros métodos. Evidências empíricas sugerem ainda que a computação do tempo de inferência estendido pode melhorar significativamente o desempenho do LLM sem a necessidade de treinamento adicional (Brown et al., 2024; Snell et al., 2024).A busca (Hart et al., 1968) e a busca em árvore de Monte Carlo (MCTS) (Browne et al., 2012) são usadas como técnicas de planejamento para melhorar o desempenho dos LLMs na solução de problemas complexos de inferência. Esses algoritmos de busca têm sido amplamente usados no aprendizado por reforço (Silver et al., 2017) e em muitos aplicativos do mundo real, como o AlphaGo (Silver et al., 2016). Nosso trabalho é o primeiro a aplicar um algoritmo de pesquisa em árvore (ou seja, pesquisa em árvore de Monte Carlo) para resolver a tarefa de geração de texto com atribuição. Além disso, propomos o MCTS autoguiado, que se baseia no poder de reflexão do LLM para melhorar a expansão da árvore.

3 Formulação do problema

Nossa estrutura proposta tem como objetivo permitir que o LLM Mθ A geração de respostas com citações no texto que servem como evidência do conteúdo do resultado é chamada de geração de texto com atribuição (Slobodkin et al., 2024; Gao et al., 2023a).

Formalmente, dada uma pergunta de entrada x e um corpus de passagens de texto D, o modelo Mθ Necessidade de gerar uma resposta y = (y 1 , ... , y T ), a resposta consiste em T sentenças, sendo que cada sentença yt Referências à lista de parágrafos de D, denotadas como Ct = {C t,1 , ... , C t,m } Devido ao benefício marginal de combinar mais citações (Gao et al., 2023b), neste documento permitimos até três citações por sentença (m ≤ 3) e elas estão entre colchetes, por exemplo, [1][2]. Também nos concentramos em cenários de conhecimento intensivo, em que o problema envolve conhecimento mundial e em que a maioria das frases no LLM contém vários fatos e exige citações de apoio como evidência. Seguindo trabalhos anteriores (Gao et al., 2023b; Piktus et al., 2021), dividimos o corpus D em parágrafos de 100 palavras para recuperação, o que facilita a verificação por humanos e não introduz muitas informações irrelevantes.

Por meio de um paradigma iterativo de "pensar-expressar-citar", propomos a busca autoguiada em árvore de Monte Carlo (SG-MCTS), que amplia o MCTS clássico por meio de duas inovações. Para aprimorar esse processo generativo, propomos o Self-Guided Monte Carlo Tree Search (SG-MCTS), que amplia o MCTS clássico por meio de duas inovações. Primeiro, nossa abordagem utiliza o recurso de autorreflexão do LLM para refletir sobre os estados intermediários do MCTS em tempo real, orientando assim o processo de expansão da árvore e evitando ativamente caminhos de inferência insuficientes. Isso contrasta com os trabalhos anteriores que refletem principalmente sobre o resultado final ou a trajetória completa. Em segundo lugar, propomos o Modelo de Recompensa de Progresso (PRM) para medir o progresso da pesquisa em árvore desde o nó raiz até o estado atual em termos de dois aspectos, ou seja, progresso de geração e progresso de atribuição. Em comparação com a avaliação apenas de etapas individuais, o modelo de recompensa baseado no progresso pode fornecer uma avaliação confiável e abrangente para orientar o processo de pesquisa do MCTS.

Até onde sabemos, somos os primeiros a aplicar um algoritmo de pesquisa em árvore à tarefa de geração de texto com atribuição. Realizamos experimentos abrangentes em três conjuntos de dados para validar a eficácia da nossa abordagem. Os resultados mostram que nosso modelo supera significativamente o desempenho de linhas de base anteriores baseadas em dicas e com ajuste fino.

Figura 2: A estrutura geral da nossa abordagem Think&Cite proposta.

4 Metodologia

A estrutura THINK&CITE proposta foi desenvolvida com base em um agente de linguagem para a geração de texto de atributos, usando o Self-Guided Monte Carlo Tree Search (SG-MCTS) para planejar e pesquisar vários caminhos de geração e o Progress Reward Modelling (PRM) para fornecer sinais assintoticamente refinados ao processo de pesquisa. A Figura 2 mostra a arquitetura geral da nossa abordagem.

4.1 Agente de geração de texto de atributos

Inspirados em trabalhos anteriores (Yao et al., 2022; Chen et al., 2023), desenvolvemos um agente linguístico para resolver a tarefa de geração de texto com atribuição, que executa um processo iterativo de pensar-verbalizar-citar que aproveita os recursos de inferência e planejamento do LLM.

Iterativo Pensar-Verbalizar-Citar. Para gerar a enésima frase, o agente primeiro pensa ativamente no próximo blueprint a ser gerado (por exemplo, tópico de conteúdo ou resumo) como uma consulta de pesquisa q t Em seguida, o agente usa a ferramenta de pesquisa para recuperar os principais parágrafos D mais relevantes do corpus D fornecido por meio da operação Search (ou seja, "Search: {query}"). Em seguida, o agente usa a ferramenta de pesquisa para recuperar os K parágrafos mais relevantes D do corpus D fornecido por meio da operação Search (ou seja, "Search: {query}"). t . Com base nos trechos recuperados, o agente referencia, por meio da operação Generate (ou seja, "Generate: {sentence}"), o texto do arquivo Dt Lista de parágrafos Ct para expressar uma sentença y t . A consulta histórica, os parágrafos recuperados, as sentenças geradas e as citações (denotadas como H = {(q i , D i , y i , C i )}^t^ i=1 ) será usado como um contexto para a próxima etapa de pensamento e expressão. Se o agente considerar a tarefa resolvida, ele pode emitir "End" para encerrar o processo. Dessa forma, o agente pode planejar e recuperar informações diferentes de forma ponderada, o que pode levar em conta dinamicamente as mudanças no foco do conteúdo à medida que o processo de geração prossegue, ao contrário de trabalhos anteriores que se basearam em corpora de referência estáticos (Slobodkin et al., 2024; Huang et al. ..., 2024) é diferente. Além disso, esse paradigma é semelhante ao trabalho recente sobre geração aprimorada por recuperação iterativa (Jiang et al., 2023; Shao et al., 2023), mas difere no fato de que nosso trabalho exige que o modelo preveja planos de conteúdo para a próxima geração para recuperar informações relevantes e selecionar cuidadosamente as referências apropriadas para mesclá-las nos locais apropriados no texto gerado.

4.2 Pesquisa de árvore Monte Carlo autoguiada

Formulamos a geração de texto com atribuição como um problema de inferência de várias etapas no qual o modelo é ponderado sobre a atribuição do texto. A busca em árvore de Monte Carlo tornou-se um algoritmo de busca eficaz para muitas tarefas de tomada de decisão (Silver et al., 2016; Ye et al., 2021). Neste trabalho, propomos o Self-Guided Monte Carlo Tree Search (SG-MCTS), que utiliza a capacidade de autorreflexão do LLM para orientar o processo de busca do MCTS. Trabalhos anteriores (Shinn et al., 2023; Zhou et al., 2024; Yu et al., 2024) geralmente refletem sobre o resultado final ou a trajetória completa, que é ineficiente e esparsa. Em contrapartida, nossa abordagem visa criticar e refletir sobre o estado intermediário do MCTS para orientar a expansão da árvore em tempo real e ignorar ativamente caminhos de geração errôneos.

Normalmente, o MCTS é baseado em um modelo de estratégia πθ Construa a árvore de pesquisa T, que geralmente é LLM M θ . Nessa árvore, o nó st = [q t , D t , y t , C t ] denota o estado do décimo nível da árvore, incluindo a consulta de pesquisa q t D t Sentenças de expressão yt e citou os parágrafos C t . O nó raiz s0 = [x] denota o problema de entrada. Em cada iteração, o SG-MCTS segue quatro etapas, ou seja, seleção, extensão guiada por reflexão, avaliação e retropropagação.

Fase de seleção. A fase de seleção tem como objetivo identificar um nó s da árvore de pesquisa Tt para expansão subsequente. O algoritmo UCT (Upper Confidence Constraint) aplicado a árvores (Kocsis e Szepesvári, 2006) é usado para selecionar o melhor nó com a maior pontuação UCT:

UCT(s) t ) = V(s t ) + w √(ln N(p) / N(s)) t )) (1)

onde V(s t ) é estimado no estágio de avaliação st A função de valor (recompensa esperada), N(s t ) é st a contagem de visitas, w é o peso da exploração de controle e p é o st do nó pai.

Fase de extensão orientada por reflexão . Na fase de extensão, ao gerar vários nós sucessores s t+1 Os nós selecionados são estendidos pelo processo think-verbalize-cite. s t A etapa Think primeiro gera um blueprint como uma consulta de pesquisa q̂ t+1 Ele extrai o assunto e o conteúdo da próxima frase, que será usada para recuperar o parágrafo D̂ t+1 . No entanto, o modelo de estratégia pode dar errado na fase de extensão, por exemplo, ao gerar consultas não específicas ou irrelevantes, o que pode prejudicar a recuperação subsequente de evidências e, por fim, levar à geração incorreta de frases. Portanto, apresentamos o modelo Reflexão etapa em que o modelo de estratégia se baseia na pergunta x e na passagem recuperada D̂t+1 Pesquisa reflexiva q̂t+1 para identificar erros:

u = M θ (q̂ t+1 , D̂ t+1 , x), (2)

onde o texto de reflexão u contém sugestões sobre determinados aspectos da pesquisa, por exemplo, que a consulta deve ser mais focada no tópico da pesquisa. Com base na reflexão, o modelo de estratégia reformula uma nova consulta qt+1 para recuperar o parágrafo D relevante t+1 ::

q t+1 , Dt+1 = M θ (u, q̂ t+1 , D̂ t+1 , H), (3)

em que H é o rastro do histórico. Observe que o processo acima pode ser repetido até que o modelo determine que a evidência recuperada é favorável ou que o número máximo de iterações seja atingido. Por fim, as etapas Verbalize e Cite são extraídas de Dt+1 Gerar a próxima sentença y t+1 e com citações precisas C t+1 ::

y t+1 , Ct+1 = M θ (q t+1 , D t+1 , H). (4)

O novo nó consiste na consulta, no corpus recuperado, na frase gerada e no parágrafo citado, denotados como st+1 = [q t+1 , D t+1 , y t+1 , C t+1 ] Em comparação com as expansões simples no MCTS típico, nossa abordagem aprimora os nós de expansão defeituosos para evitar a geração de baixa qualidade. Como as árvores MCTS são construídas de forma incremental, melhorar a qualidade da próxima operação permite que o modelo navegue por caminhos mais favoráveis em um amplo espaço de pesquisa, melhorando assim a qualidade geral da pesquisa da árvore.

Fase de avaliação. A fase de avaliação tem como objetivo usar o modelo de recompensa de progresso (consulte a Seção 4.3) para calcular o novo nó de extensão st+1 A recompensa esperada de R(s t+1 ). A avaliação do progresso envolve dois aspectos: geração e atribuição. Geração de incentivos ao progresso Rg Medição de sentenças geradas até o momento y 1 , ... , yt+1 a qualidade do texto. Vesting Progress Recompensa Ra Avaliação das sentenças geradas y 1 , ... , yt+1 e citou os parágrafos C 1 , ... , Ct+1 consistência de atribuição entre eles. Por fim, a recompensa total é calculada como a soma das duas: R(s t+1 ) = R g + R a .

Fase de retropropagação. Na fase de retropropagação, o novo nó st+1 A recompensa para R(s t+1 ) é propagado de volta para seu nó pai s t que atualiza cada nó no caminho do nó raiz até seu pai s 0 , s 1 , ... , st A função de valor do

N novo (s i ) = N antigo (s i ) + 1, 0 ≤ i ≤ t (5)

V novo (s i ) = (V antigo (s i )N antigo (s i ) + R(s t+1 )) / N novo (s i ) (6)

onde N antigo (s i ) e V antigo (s i ) são os nós si das funções de contagem e valor acessadas anteriormente.

4.3 Modelo de recompensa por progresso

Modelos anteriores de recompensa por resultado (Cobbe et al., 2021; Hosseini et al., 2024) e modelos de recompensa por processo (Lightman et al., 2024; Dai et al., 2024) se concentraram na avaliação do resultado final ou das etapas intermediárias. Neste trabalho, propomos que, após a próxima etapa, a busca da árvore de medição a partir da raiz s0 para declarar st+1 O progresso. Como o texto com atribuição inclui o conteúdo do texto e suas citações, criamos dois aspectos de recompensas de progresso, recompensas de progresso de geração e recompensas de progresso de atribuição, para avaliar a qualidade do conteúdo do texto gerado e a relevância das citações, respectivamente.

4.3.1 Geração de incentivos de progresso

Na otimização de preferência direta (DPO) (Rafailov et al., 2023), as proporções logarítmicas em nível de marcador podem ser interpretadas como

recompensas implícitas em nível de marcador sob a formulação de aprendizagem por reforço de entropia máxima (RL). Portanto, propomos utilizar o modelo de alinhamento de DPO existente para medir a geração da próxima frase yt+1 Sentenças pós-geradas y1:t+1 = y 1 , ... , yt+1 O índice de qualidade de R g .

Especificamente, definimos um processo de decisão de Markov (MDP) em nível de sentença em que o estado st = (x, y 1 , ... , y t ) denota as entradas e sentenças geradas até o momento, e o estado inicial s0 = x é um problema de entrada. A ação at = yt+1 denota a próxima frase a ser gerada. Assim, o objetivo de otimização da RLHF pode ser reescrito como um problema de RL de entropia máxima no nível da frase:

E emπθ(-|st)~ [∑^T^t=1 r'(s t , a t )] + βE s0x~ [H(π θ (-|s 0 ))],

onde a função de recompensa em nível de sentença r' pode ser calculada como:

r'(s t , a t ) = { βlog π ref (a t |s t ), se st+1 não é o fim da linha

{ r'(y|x) + βlog π ref (a t |s t ) Se s t+1 É o fim da linha.

A fórmula RL de entropia máxima deriva a função de valor ideal V e a função Q Q como:

Q(s t , a t ) = r'(s t , a t ) + V(s t+1 ),

V(s t ) = log ∑a exp(Q(s t , a)), quando t ≤ T .

Portanto, a política ideal π é derivada da seguinte forma:

⇒ βlog π(a t |s t ) = Q(s t , a t ) - V(s t ),

⇒ βlog (π(a t |s t ) / π ref (a t |s t )) = V(s t+1 ) - V(s t ).

Isso nos motivou a usar a estratégia DPO para derivar a soma parcial de recompensas para formular respostas parciais y1:t+1 Incentivos ao progresso R g ::

∑^t^k=0 βlog (π(a k |s k ) / π ref (a k |s k )) = V(s t+1 ) - V(s 0 ),

⇒ R g (y 1:t+1 ) = ∑^t^k=0 wk log (π(y k+1 |x, y 1:k ) / π ref (y k+1 |x, y 1:k )),

onde y1:k denota y 1 , ... , y k wk = 1 / (t+1) é o peso da razão de verossimilhança de cada nível de sentença.

4.3.2 Prêmios de progresso de atributos

Usamos duas métricas de citação usadas em trabalhos anteriores (Gao et al., 2023b), recall e precisão de citação, para representar a recompensa de progresso de atribuição R a .

Especificamente, a recordação de citações mede a resposta parcial y1:t+1 de frases que poderiam ser apoiadas pela passagem citada correspondente. Usamos o modelo NLI (Honovich et al., 2022) para verificar se as passagens citadas poderiam derivar respostas do modelo. Para cada frase yi (1 ≤ i ≤ t + 1), teremos Ci As passagens citadas em são unidas como uma premissa e a sentença gerada yi como premissas para o modelo NLI. Definimos a recuperação da citação como 1 se a premissa contiver uma suposição e 0, caso contrário. A precisão da citação avalia a porcentagem de citações que apoiam a frase correspondente. Usamos o mesmo modelo NLI acima para calcular a pontuação de precisão. Para cada citação c i,j Se (1) Ci Todas as citações em y contêm a sentença gerada yi e (2) Ci \ {c i,j } sem a sentença y i Caso contrário, a pontuação de precisão é definida como 0. Calculamos a pontuação de precisão (0 ou 1) para cada citação e calculamos a média de todas as citações. Por fim, calculamos a pontuação F1 como a recompensa de progresso atribuída R a (y 1:t+1 , C 1 , ... , C t+1 ) para fornecer uma métrica de qualidade de atribuição equilibrada entre as frases geradas e as passagens citadas.

5 experimentos

5.1 Configuração experimental

Conjuntos de dados. Para a avaliação, usamos o teste de referência ALCE (Gao et al., 2023b), que consiste em três conjuntos de dados: (1) ASQA (Stelmakh et al., 2022), um conjunto de dados de controle de qualidade de formato longo que contém perguntas ambíguas que exigem várias respostas para abranger diferentes aspectos; (2) QAMPARI (Amouyal et al. 2022), um conjunto de dados de QA factual em que a resposta a cada pergunta é uma lista de entidades extraídas de diferentes passagens; e (3) ELI5 (Fan et al., 2019), um conjunto de dados de QA de formato longo que contém perguntas do tipo como/por que/como. Para o ASQA e o QAMPARI, a maioria das perguntas pode ser respondida por meio da Wikipédia, portanto, usamos o instantâneo da Wikipédia de 2018/12/20 como corpus. Para o ELI5, como suas perguntas são tematicamente diversas, usamos o Sphere (Piktus et al., 2021) (uma versão filtrada do Common Crawl) como corpus. Seguindo Gao et al. (2023b), usamos GTR (Ni et al., 2022) para a Wikipédia e Sphere BM25 (Robertson et al., 2009) para recuperar as 100 primeiras passagens como um corpus para cada pergunta. Consulte o Apêndice A para obter mais detalhes.

Métricas de avaliação. Usamos as métricas de avaliação do teste de referência original do ALCE. Para avaliar a exatidão do resultado, usamos Exact Match (EM) Recall da ASQA, Recall-5 da QAMPARI e Statement Recall da ELI5 para medir a porcentagem de respostas corretas (peças-chave de informação) no resultado. Além disso, calculamos a Precisão como uma métrica de correção para o conjunto de dados QAMPARI para medir a porcentagem de respostas corretas nas respostas geradas. Para avaliar a qualidade da citação do resultado, calculamos o Citation Recall, que mede a porcentagem de sentenças no resultado que podem ser deduzidas das passagens citadas, e o Citation Precision, que mede a porcentagem de citações que podem ajudar a apoiar as sentenças do resultado.

Linha de base. Comparamos nossa abordagem com aquela baseada em ChatGPT e GPT-40 são comparados com as seguintes linhas de base:

Baunilha RAG O modelo foi instruído diretamente a gerar respostas com base nos cinco primeiros parágrafos fornecidos e a citá-los de acordo. Usamos o aprendizado de contexto com duas apresentações (Brown et al., 2020).

O RAG de resumo/trecho fornece um resumo ou trecho do parágrafo, e não o texto completo. O modelo gerará respostas com citações baseadas nos primeiros 10 resumos ou trechos de parágrafos.

O Interact permite que o modelo acesse ainda mais o texto completo de determinados parágrafos no método RAG de resumo/trecho. O modelo pode apresentar uma ação "Check: Document [1] [2]" para obter o texto completo do documento correspondente.

O Inline Search permite que o modelo solicite uma ação "Search: {query}" para recuperar os parágrafos mais relevantes entre os 100 principais. Esse método é semelhante ao nosso, pois funciona como uma comparação direta.

O ReRank obtém aleatoriamente quatro respostas para cada pergunta e seleciona a melhor resposta com base em uma métrica de recuperação de citações.

A linha de base acima foi aplicada e avaliada no teste de referência ALCE original, conforme relatado em (Gao et al., 2023b). Além disso, comparamos nossa abordagem com trabalhos anteriores sobre geração de texto com atribuição.FG-Reward (Huang et al., 2024) sugere o uso de recompensas refinadas como sinais de treinamento para ajustar o LLaMA-2-7B (Touvron et al., 2023) para gerar respostas atribuíveis.VTG (Sun et al., 2024) usa memórias variáveis e um validador de duas camadas para gerar respostas atribuíveis.VTG (Sun et al., 2024) usa memórias variáveis e um validador de duas camadas para gerar respostas atribuíveis. 2024) usou memórias em evolução e um validador de duas camadas para orientar o modelo generativo (ou seja, text-davinci-003).APO (Li et al., 2024) reuniu um conjunto de dados de pares de preferências e aplicou a otimização de preferências ao LLaMA-2-13B para geração de texto com atribuição.

Detalhes da implementação. Usamos o LLaMA-3.1-8B-Instruct e o GPT-40 como nossos modelos de estratégia para avaliar o desempenho de nossa abordagem. Para os modelos de recompensa, usamos o modelo DPO, Llama-3-8B-SFR-Iterative-DPO-R¹, para calcular as recompensas de progresso generativo e o modelo NLI, T5-XXL-TRUE-NLI-Mixture (Honovich et al., 2022), para calcular as recompensas de progresso atributivo. Para cada consulta de pesquisa, recuperamos as três principais passagens do corpus como referências candidatas D t . No algoritmo UCT (Equação 1), o peso w é definido como 0,2. Para o SG-MCTS, estendemos três nós filhos para cada nó pai e definimos o nível máximo da árvore como 6 e o número máximo de iterações para o MCTS como 30.

5.2 Principais resultados

A Tabela 1 mostra os resultados do nosso método e da linha de base nos três conjuntos de dados.

Em primeiro lugar, é possível observar que os três métodos Retrieval Augmented Generation (RAG) apresentam desempenho moderado, embora o uso de resumos ou trechos possa melhorar a correção. No entanto, esse aprimoramento ocorre às custas da qualidade da citação, pois as informações do parágrafo são altamente compactadas. O ReRank leva a um aprimoramento consistente da qualidade da citação nos três conjuntos de dados (por exemplo, o RAG de baunilha melhora a recuperação da citação de 73,61 TP3T para 84,81 TP3T no ASQA). Como comparação direta, o Inline Search é semelhante à nossa abordagem, mas tem um desempenho pior em comparação com as outras linhas de base de dicas. Isso se deve ao fato de simplesmente solicitar consultas de pesquisa sem considerar a qualidade e a relevância das evidências.

Em segundo lugar, com o ajuste fino do LLM em dados de treinamento supervisionado com citações anotadas, o FG-Reward e o APO mostram maior qualidade de citação nos conjuntos de dados ASQA e ELI5, mas não melhoram o desempenho no QAMPARI. Além disso, o VTG emprega um validador generativo e um validador na memória para avaliar o suporte lógico das evidências, o que resulta em uma qualidade de citação forte (por exemplo, recall de citação de 86,71 TP3T no ASQA). No entanto, os LLMs ajustados são limitados pela qualidade e pela quantidade de dados de treinamento supervisionado, em que as evidências de apoio exigem um custo significativo para serem vinculadas à fonte correta. Além disso, esses métodos ainda dependem da geração autorregressiva, que é um modo de pensar rápido, mas menos preciso. Consequentemente, quaisquer erros de geração intermediários (por exemplo, representações errôneas ou citações inadequadas) levarão a problemas com a resposta final.

| ASQA | QAMPARI | ELI5 | |

|---|---|---|---|

| Correção | Citação | Correção | Citação |

| EM Rec. | Rec. | Prec. | Recall-5 |

| ChatGPT | |||

| Baunilha RAG | 40.4 | 73.6 | 72.5 |

| com ReRank | 40.2 | 84.8 | 81.6 |

| Resumo do RAG | 43.3 | 68.9 | 61.8 |

| com Interact | 39.1 | 73.4 | 66.5 |

| Snippet RAG | 41.4 | 65.3 | 57.4 |

| com o Interact | 41.2 | 64.5 | 57.7 |

| Pesquisa em linha | 32.4 | 58.3 | 58.2 |

| GPT-40 | |||

| Baunilha RAG | 41.3 | 68.5 | 75.6 |

| com ReRank | 42.1 | 83.4 | 82.3 |

| Resumo do RAG | 46.5 | 70.2 | 67.2 |

| com Interact | 48.1 | 73.1 | 72.8 |

| Snippet RAG | 45.1 | 68.9 | 66.5 |

| com o Interact | 45.2 | 67.8 | 66.7 |

| Pesquisa em linha | 40.3 | 65.7 | 66.9 |

| FG-Reward | 40.1 | 77.8 | 76.3 |

| VTG | 41.5 | 86.7 | 80.0 |

| APO | 40.5 | 72.8 | 69.6 |

| Nosso (LLaMA) | 45.2 | 82.3 | 80.6 |

| Nosso (GPT-40) | 50.1 | 89.5 | 87.1 |

Tabela 1: Resultados da avaliação da geração de texto de atributos em três conjuntos de dados. "Rec." e "Prec." são abreviações para recall e precisão. As fontes em negrito e sublinhadas indicam o melhor e o segundo melhor resultado em cada conjunto de dados, respectivamente.

Por fim, nossa abordagem supera significativamente todas as abordagens anteriores nos três conjuntos de dados.O Think&Cite formula a tarefa de geração de texto de atributos como um problema de raciocínio em várias etapas e introduz um modo lento e deliberado de reflexão para buscar a melhor solução. Ao propor um algoritmo MCTS autoguiado, o Think&Cite utiliza a capacidade de autorreflexão dos LLMs para orientar o processo de expansão da árvore. Além disso, o modelo de recompensa de progresso proposto pode fornecer feedback abrangente e confiável para ajudar o modelo a explorar melhores respostas geradas.

5.3 Análises adicionais

Relatamos análises adicionais do nosso método no ASQA usando o GPT-40, pois obtivemos resultados semelhantes em outros conjuntos de dados.

Estudo de ablação. Para validar a eficácia de nossa estrutura proposta, analisamos seus principais elementos de design para ablação. Projetamos quatro variantes: (1) sem SG-MCTS remove o MCTS autoguiado e gera respostas diretamente, passo a passo; (2) sem Reflexão remove a etapa de reflexão e emprega o algoritmo MCTS básico; (3) sem Recompensa GP remove a necessidade de gerar recompensas de progresso R g (4) sem recompensa de PA Removidas as recompensas de progresso de aquisição R a Mostramos os resultados na Tabela 2. Mostramos os resultados na Tabela 2. Todas as variantes têm desempenho pior do que o método original, indicando a eficácia de cada componente. Especificamente, o desempenho do SG-MCTS sem SG é significativamente pior, o que sugere que a integração de um algoritmo de pesquisa na geração de texto com atribuição é altamente benéfica. O uso do MCTS básico (sem Reflexão) leva a uma pior qualidade de citação, devido à introdução de referências falsas sem refletir sobre os resultados recuperados. Da mesma forma, tanto sem o GP Reward quanto sem o AP Reward levam a um desempenho pior, sugerindo que tanto a geração quanto a verificação da qualidade da citação são essenciais.

| Método | Correção | Citação |

|---|---|---|

| EM Rec. | Rec. | Prec. |

| Think&Cite | 50.1 | 89.5 |

| c/oSG-MCTS | 42.1 | 78.2 |

| semReflexão | 46.5 | 83.6 |

| sem prêmio GPR | 47.1 | 86.2 |

| semAPReward | 46.7 | 81.3 |

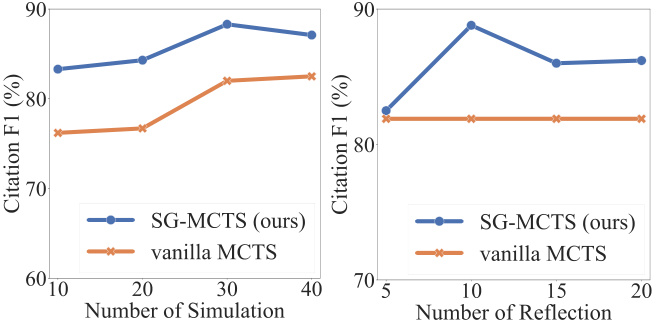

Autorreflexão e simulação. Em cada simulação, o SG-MCTS segue quatro etapas principais e emprega a autorreflexão para melhorar a qualidade dos estados intermediários na extensão, criticando e melhorando as consultas de erro. Para verificar a eficácia da reflexão, comparamos o desempenho entre o aumento do número máximo de simulações e o aumento do número máximo de operações de reflexão. Primeiro, alteramos o número máximo de simulações para {10, 20, 30, 40} e fixamos o número máximo de reflexões em 10. Da mesma forma, alteramos o número máximo de reflexões para {5, 10, 15, 20} e fixamos o número máximo de simulações em 30. Mostramos as pontuações F1 com base na citação, recuperação e precisão na Figura 3. A figura mostra que aumentar o número de simulações e o número de reflexões melhora o desempenho da geração de texto com atribuição. Isso é esperado, pois uma exploração mais extensa aumenta a probabilidade de encontrar a geração correta. No entanto, mais etapas de reflexão podem "pensar demais" no modelo, introduzindo ruído e levando à degradação do desempenho. O SG-MCTS supera o MCTS de baunilha sem reflexão porque pode haver pesquisas incorretas no nó pai, fazendo com que o processo de raciocínio no nó filho estendido continue pelo caminho errado. A etapa de reflexão melhora as recuperações incorretas devido a consultas insuficientes, permitindo assim que a exploração subsequente prossiga com mais precisão.

Figura 3: Resultados no ASQA com relação ao número de simulações (lado esquerdo) ou ao número de etapas de reflexão (lado direito).

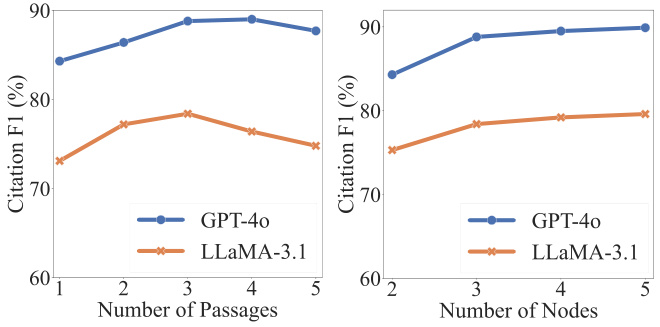

Análise de hiperparâmetros. Dois hiperparâmetros são essenciais para a correção e a qualidade das citações: cada consulta qt Número de parágrafos recuperados |D t | e nós filhos estendidos na pesquisa de árvore st+1 O número de parágrafos recuperados. Conforme mostrado na Figura 4, a qualidade das citações pode ser melhorada inicialmente com o aumento do número de parágrafos recuperados. Entretanto, aumentos adicionais acima de um determinado limite levam a um desempenho pior, principalmente porque a fusão de mais parágrafos introduz ruído que afeta negativamente a confiabilidade do conteúdo gerado. Por outro lado, observamos que o aumento do número de nós expandidos leva a um aprimoramento consistente, embora esse aprimoramento se estabilize posteriormente. Como a expansão de mais nós resulta em custos computacionais mais altos, extraímos três filhos para cada nó pai.

Figura 4: Resultados no ASQA com relação ao número de parágrafos (lado esquerdo) ou ao número de nós estendidos (lado direito).

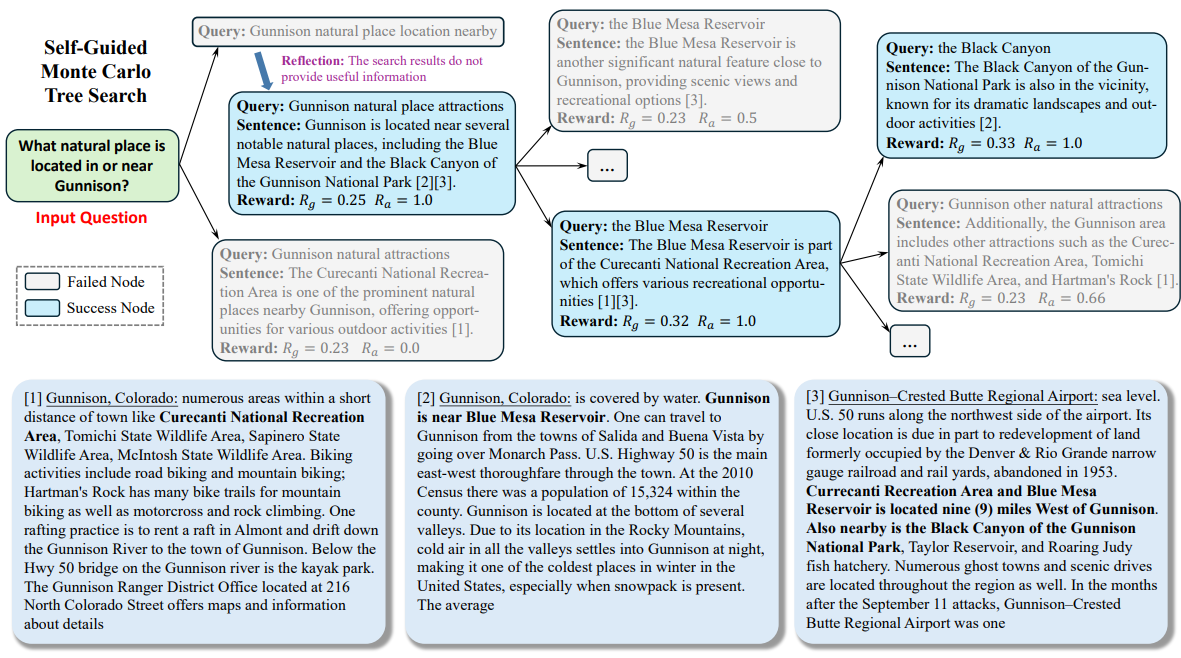

5.4 Estudos de caso

Para facilitar a compreensão de todo o fluxo de trabalho do nosso método, realizamos uma análise qualitativa no ASQA. Mostramos um exemplo no Apêndice C. Durante todo o processo de pesquisa, o LLM trata o problema de entrada como o nó raiz e expande gradualmente a árvore de pesquisa para chegar ao estado final. Como mostrado, o modelo primeiro gera uma consulta (ou seja, "Localização de atrações naturais próximas a Gunnison") para recuperar passagens. Como a passagem não contém informações válidas necessárias para responder à pergunta, o modelo reflete e propõe uma nova consulta (ou seja, "Gunnison natural attraction sites") para recuperação. Com base nos parágrafos recuperados, o modelo gera frases e faz referência ao segundo e ao terceiro parágrafos (ou seja, "[2][3]"). Ao seguir um processo de geração em várias etapas, o modelo pode pensar profundamente sobre o tópico e gerar conteúdo confiável com citações precisas.

6 Conclusão

Neste trabalho, apresentamos o Think&Cite, uma nova estrutura para a geração de textos de atributos com pesquisa de árvore integrada. O Think&Cite baseia-se no paradigma iterativo de geração think-express-cite. Para aprimorar o processo de geração, propomos o Self-Guided Monte Carlo Tree Search, que explora a capacidade de autorreflexão dos LLMs para criticar e corrigir os estados intermediários dos MCTSs a fim de orientar a expansão da árvore. Além disso, propomos o Modelo de Recompensa de Progresso para medir o progresso da pesquisa em árvore e fornecer feedback confiável. Experimentos extensivos em três conjuntos de dados mostram que o Think&Cite proposto supera os métodos tradicionais de dicas e ajuste fino.

limitações

O escopo de nossos experimentos é limitado pelo custo computacional significativo dos métodos de pesquisa baseados em árvores. Trabalhos futuros poderão explorar uma gama maior de conjuntos de dados de geração de texto de atributos. Em nosso modelo, a pesquisa em árvore de Monte Carlo é usada para a geração autoguiada. Trabalhos futuros poderão explorar algoritmos de pesquisa adicionais para avaliar a generalidade e a robustez de nossa estrutura proposta.

apêndice

Um conjunto de dados

Avaliamos nossa abordagem no benchmark ALCE, que consiste em três conjuntos de dados. Especificamente, o conjunto de dados ASQA (Stelmakh et al., 2022) contém 948 perguntas com respostas que podem ser encontradas na Wikipédia; o conjunto de dados QAMPARI (Amouyal et al., 2022) contém 1.000 perguntas baseadas na Wikipédia; e o conjunto de dados ELI5 (Fan et al., 2019) contém 1.000 perguntas e as respostas podem ser encontradas no Sphere (Piktus et al., 2021). Os detalhes desses três conjuntos de dados são apresentados na Tabela 3.

| conjunto de dados | Corpus (passagens #) | Tipo de problema |

|---|---|---|

| ASQA | Wikipedia (21 milhões) | factual |

| QAMPARI | Wikipedia (21 milhões) | Fato (tabulação) |

| ELI5 | Sphere (899 milhões) | Por que/como/o quê |

Dicas B

Instruímos o LLM a realizar uma pesquisa de árvore autoguiada para gerar textos de atributos de uma forma de aprendizado sem amostras. As dicas de aprendizado de contexto para os conjuntos de dados ASQA, QAMPARI e ELI5 são mostradas nas Tabelas 4, 5 e 6, respectivamente. Em seguida, criamos quatro exemplos contextuais que foram selecionados para serem consistentes com o benchmark ALCE (Gao et al., 2023b).

C Estudos de caso

Mostramos um exemplo do ASQA na Figura 5.

Sua meta é escrever uma resposta precisa, interessante e concisa para uma determinada pergunta usando apenas os resultados de pesquisa fornecidos e citando-os corretamente. Use um tom justo e jornalístico. Sempre indique uma citação para qualquer fato. Você pode usar quatro ações:

- """Search: keywords""", que solicita algumas palavras-chave e recupera os documentos mais relevantes com base no histórico de pesquisa e geração.

- """Refletir: ideias"""" e refletir sobre os resultados da pesquisa se um documento válido não foi obtido para responder à pergunta.

- """Output: sentence """que gera uma resposta longa com base no documento recuperado. Na resposta, ele é citado corretamente usando [1][2][3]. Cite pelo menos um documento e até três documentos por sentença. Se vários documentos suportarem a frase, apenas o subconjunto menos suficiente de documentos será citado.

- """End"""", ele encerra a tarefa do questionário.

Aqui estão alguns exemplos:

Pergunta: Quem estabeleceu o recorde do tiro de maior distância?

Busca : Registro de tiro de distância mais longa

Documento[1] (Legenda: David Akers) estabeleceu o recorde de maior field goal ao chutar um field goal de 63 jardas por cima do travessão.

Documentação[2] (Título: Dirk Borgognone) Dirk Borgognone, Dirk Ronald Borgognone (nascido em 9 de janeiro de 1968) é um ex-craque nacional...

Documento[3] (Título: Russell Elkseben) contra a Universidade do Colorado. Apesar dos problemas iniciais no jogo, incluindo...

Reflexão: Os resultados da pesquisa não forneceram informações válidas para responder à pergunta. É melhor pesquisar o recorde do gol de campo mais longo da NFL.

Busca : Recorde de gol de campo mais longo na NFL

Documento[4] (Título: Field Goal) em direção à sua própria zona final. O gol de campo mais longo da história da NFL é de 64 jardas, um recorde estabelecido por...

Documento [5] (Título: Alcance do gol de campo) zona final em cada extremidade) era de apenas 66 jardas. Scaccia, jogando futebol de salão, tentou um gol de 64 jardas...

Documento[6] (Título: Range of Shots) Esta conquista não é um registro oficial. Todos os tiros acima foram bem-sucedidos...

Resultado: O recorde do gol de campo mais longo em um jogo da NFL é de 64 jardas, estabelecido por Matt Prater[4].

Busca : Registro da tacada mais longa em qualquer nível de competição, faculdade

Documento[7] (Título: Field Goal) em direção à sua própria zona final. O gol de campo mais longo da história da NFL é de 64 jardas, um recorde estabelecido por...

Documentação[8] (Título: Alcance dos chutes) A linha de 35 a 40 jardas (mais próxima em ventos cruzados) geralmente tenta os chutes mais arriscados...

Documento[9] (Título: Alcance do gol de campo) NFL, e foi banido pela NCAA desde 1989) é de 68 jardas, mantida por Fabrizio Scaccia...

Resultado: No entanto, o recorde do gol de campo mais longo em qualquer nível de competição é de 69 jardas, chutado pelo kicker universitário Ove Johansson em um jogo de futebol americano de 1976 entre a Abilene Christian University e a East Texas State University[8]. O final.

Sua meta é escrever uma resposta precisa, interessante e concisa para uma determinada pergunta usando apenas os resultados de pesquisa fornecidos e citando-os corretamente. Use um tom justo e jornalístico. Sempre indique uma citação para qualquer fato. Você pode usar quatro ações:

- """Search: keywords""", que solicita algumas palavras-chave e recupera os documentos mais relevantes com base no histórico de pesquisa e geração.

- """Refletir: ideias"""" e refletir sobre os resultados da pesquisa se um documento válido não foi obtido para responder à pergunta.

- """Output: sentence """que gera uma resposta longa com base no documento recuperado. Na resposta, ele é citado corretamente usando [1][2][3]. Cite pelo menos um documento e até três documentos por sentença. Se vários documentos suportarem a frase, apenas o subconjunto menos suficiente de documentos será citado.

- """End"""", ele encerra a tarefa do questionário.

Aqui estão alguns exemplos:

Pergunta: Que livros Nevil Shute escreveu?

Busca : Temas de Neville Shute Transtornos sociais

Documento[1] (Título: Nevil Shute) Estágios iniciais. Meus parabéns". Sua reputação como escritor levou o Ministério da Informação a enviá-lo para...

Documento [2] (Título: Nevil Shute) O tema é cruzar barreiras sociais como classe ("The Lonely Road" e "The Landing"), raça...

Documento[3] (Título: Nevil Shute) Empresa de construção de aeronaves, Airspeed Ltd. Seus romances cresceram em popularidade, mas ele se tornou mais famoso...

Resultados: Beyond the Black Stump [2], Lonely Road [2], Chessboard [2], In the Damp [2], Toolroom Trustee [2], Around the Bend [2].

Busca : Nevil Shute Simple Readable Style

Documentos[4] (Nevil Shute) Empresa de construção de aeronaves, Airspeed Ltd. Seus romances cresceram em popularidade, mas ele se tornou mais famoso...

Document[5] (Checkerboard) People of Burma", ambos fundamentais para a história do livro. Schutt está preocupado com as vendas do livro...

Documentação[6] (úmida) Ele usou a ideia de votar várias vezes no conto "A curiosa República de Gondor"...

Reflexão: Os resultados da pesquisa não forneceram nenhuma informação útil para responder à pergunta. É melhor procurar livros de Nevil Shute da década de 1950.

Busca : Livros da década de 1950 de Nevil Shute

Documento[7] (Nevil Shute) Estágios iniciais. Meus parabéns". Sua reputação como escritor levou o Ministério da Informação a enviá-lo para...

Documento [8] (Nevil Shute) O tema é a transposição de barreiras sociais, como classe ("The Lonely Road" e "The Landing"), raça ("The Chessboard")...

Documentação[9] (Nevil Shute) Empresa de construção de aeronaves, Airspeed Ltd. Seus romances cresceram em popularidade, mas ele ficou mais famoso...

Saída: Malazan [7], Stephen Morris [7].

próximo

Sua meta é escrever uma resposta precisa, interessante e concisa para uma determinada pergunta usando apenas os resultados de pesquisa fornecidos e citando-os corretamente. Use um tom justo e jornalístico. Sempre indique uma citação para qualquer fato. Você pode usar quatro ações:

- """Search: keywords""", que solicita algumas palavras-chave e recupera os documentos mais relevantes com base no histórico de pesquisa e geração.

- """Refletir: ideias"""" e refletir sobre os resultados da pesquisa se um documento válido não foi obtido para responder à pergunta.

- """Output: sentence """que gera uma resposta longa com base no documento recuperado. Na resposta, ele é citado corretamente usando [1][2][3]. Cite pelo menos um documento e até três documentos por sentença. Se vários documentos suportarem a frase, apenas o subconjunto menos suficiente de documentos será citado.

- """End"""", ele encerra a tarefa do questionário.

Aqui estão alguns exemplos:

Pergunta: O que causa o transtorno bipolar?

Busca : O que é transtorno bipolar?

Documento [1] (Título: Transtorno Bipolar Tipo II) Pesquisa sobre o estabelecimento de limites pessoais de percepção e comportamento. A pesquisa sugere o seguinte...

Documento [2] (Título: Biology of Bipolar Disorder - Biologia do Transtorno Bipolar) As regiões cerebrais localizadas nessas áreas são consideradas como o mecanismo do transtorno bipolar...

Documento [3] (Título: Biology of Bipolar Disorder) independentemente da polaridade. A inflamação foi relatada no transtorno bipolar...

Reflexão: Os resultados da pesquisa não forneceram informações válidas para responder à pergunta. É melhor procurar por sintomas de transtorno bipolar.

Busca : Quais são os sintomas do transtorno bipolar? Quanto tempo eles duram?

Documento [4] (Título: Transtorno Bipolar | Definição no Dicionário Médico) Transtorno Bipolar | Definição de Transtorno Bipolar...

Documento [5] (Título: Mania e Transtorno Bipolar) pode variar de deprimido a "muito feliz" em um único dia, ou mesmo em alguns dias, o que...

Documento [6] (Título: For Individuals - Adam Schwartz) For Individuals 2014 Adam Schwartz As informações são extensas e abrangem...

Resultado: O transtorno bipolar é um distúrbio de humor que causa mudanças extremas de humor, variando de euforia a depressão [4]. As mudanças de humor podem variar de dias a meses [5].

Busca : O que causa o transtorno bipolar?

Documento [7] (Título: Transtorno Bipolar) O transtorno bipolar é geralmente um transtorno cíclico no qual o indivíduo apresenta depressão...

Documento [8] (Título: Depression Bipolar Disorder Symptoms 2019 | Beat Depression) Sintomas de transtorno bipolar depressivo 2019.

A documentação[9] (Título: Transtornos mentais) pode incluir fatores parentais, inclusive rejeição dos pais, falta de carinho dos pais...

RESULTADO: Ainda não temos certeza dos fatores exatos que contribuem para essa doença, mas acredita-se que a genética seja um fator importante [7].

próximo

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...