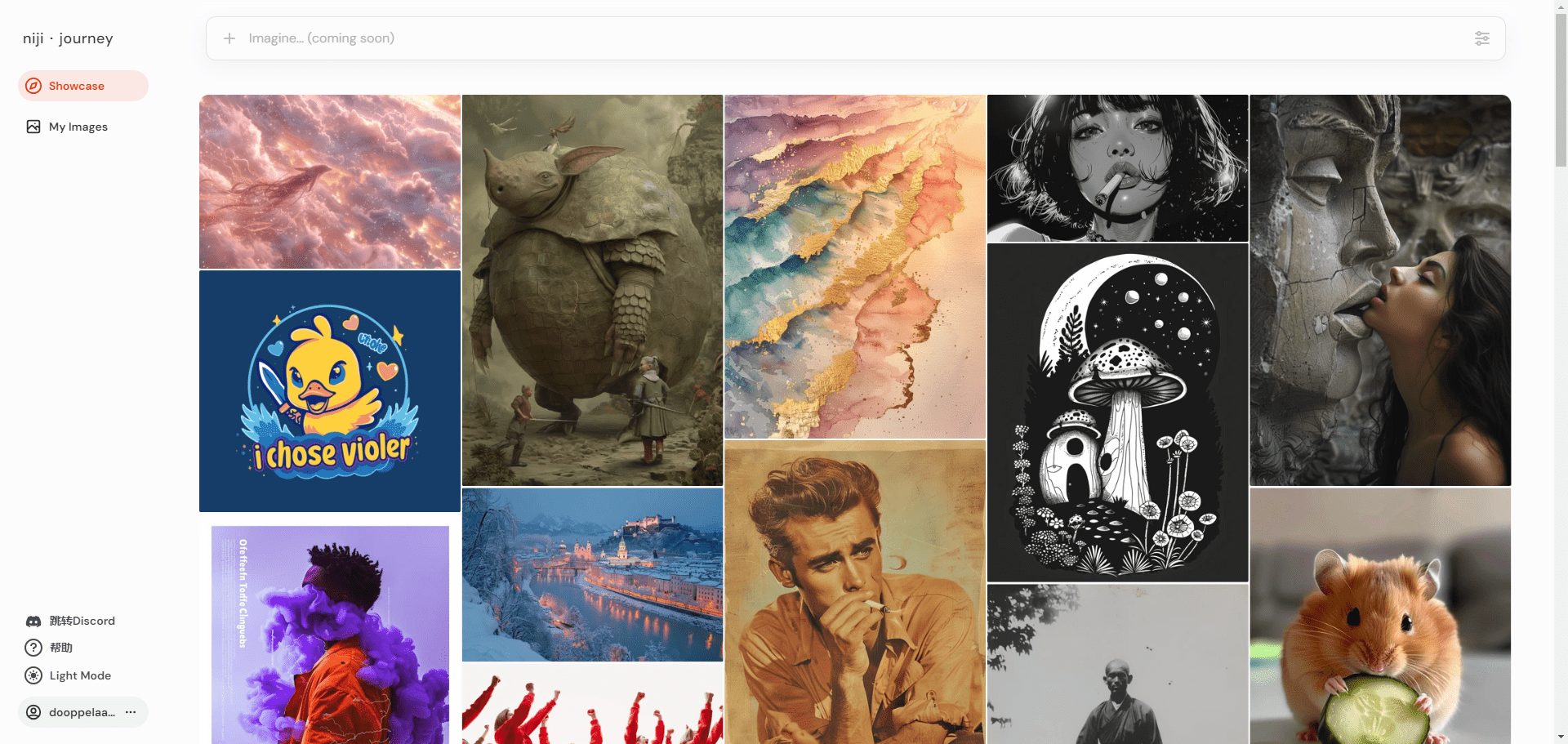

Tarsier: um modelo de compreensão de vídeo de código aberto para gerar descrições de vídeo de alta qualidade

Introdução geral

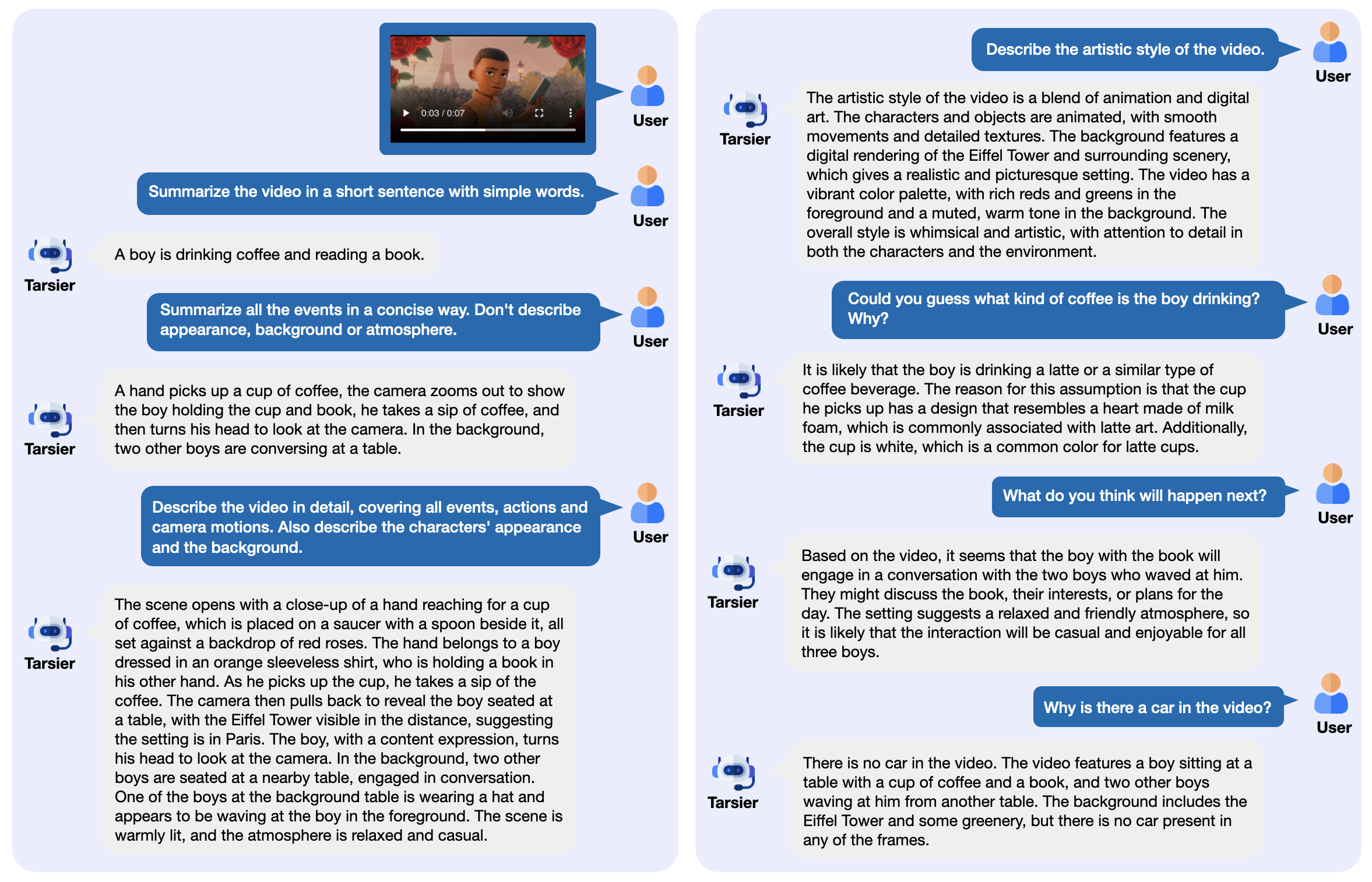

Tarsier é uma família de modelos de linguagem de vídeo de código aberto desenvolvida pela ByteDance, usada principalmente para gerar descrições de vídeo de alta qualidade. Ele consiste em uma estrutura simples: o CLIP-ViT processa os quadros de vídeo e analisa as relações temporais em combinação com um modelo de linguagem grande (LLM). A versão mais recente, Tarsier2-7B (lançada em janeiro de 2025), atingiu o nível mais alto em 16 benchmarks públicos e pode competir com modelos como o GPT-4o. O Tarsier é compatível com descrição de vídeo, perguntas e respostas e geração de legendas com amostra zero, e o código, os modelos e os dados estão disponíveis publicamente no GitHub. O projeto também lançou o benchmark DREAM-1K para avaliar os recursos de descrição de vídeo, que contém 1.000 clipes de vídeo diversos.

Lista de funções

- Gerar descrições detalhadas de vídeos: analise o conteúdo do vídeo e produza um texto detalhado.

- Suporte a vídeo Q&A: responda a perguntas relacionadas a vídeos, como eventos ou detalhes.

- Geração de legendas com amostragem zero: gera legendas para vídeos sem treinamento.

- Compreensão de vídeo multitarefa: destaca-se em várias tarefas, como questionários e legendas.

- Implementação de código aberto: forneça pesos de modelo e código para execução local ou na nuvem.

- Fornece ferramentas de avaliação: inclui o conjunto de dados DREAM-1K e a metodologia de avaliação AutoDQ.

Usando a Ajuda

O Tarsier é adequado para usuários com formação técnica, como desenvolvedores ou pesquisadores. Instruções detalhadas de instalação e uso são fornecidas abaixo.

Processo de instalação

- Preparação do ambiente

Requer Python 3.9 ou posterior. Recomenda-se um ambiente virtual:

conda create -n tarsier python=3.9

conda activate tarsier

- armazém de clones

Faça o download do código do projeto Tarsier:

git clone https://github.com/bytedance/tarsier.git

cd tarsier

git checkout tarsier2

- Instalação de dependências

Execute o script de instalação:

bash setup.sh

Isso instalará todas as bibliotecas necessárias, como o PyTorch e as ferramentas do Hugging Face.

- Suporte a GPU (opcional)

Se você tiver uma GPU NVIDIA, instale o PyTorch com CUDA:

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu118

- Modelos para download

Faça download de modelos do Hugging Face, por exemplo, Tarsier2-7B:

huggingface-cli download omni-research/Tarsier2-7b

Outros modelos, como o Tarsier-34b ou o Tarsier2-Recap-7b, também estão disponíveis nos links oficiais.

- Verificar a instalação

Execute o script de teste rápido:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --input_path assets/videos/coffee.gif

O resultado deve ser uma descrição do vídeo, como "Um homem pega uma xícara de café com espuma em forma de coração e toma um gole".

Funções principais

Gerar descrição do vídeo

- mover

- Prepare um arquivo de vídeo (compatível com formatos como MP4, GIF, etc.).

- Executar comando:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --instruction "Describe the video in detail." --input_path your/video.mp4

- A saída é exibida no terminal, por exemplo, descrevendo as ações e cenas do vídeo.

- tomar nota de

- Vídeos muito longos podem exigir mais memória, por isso recomendamos testar primeiro com um vídeo curto.

- Parâmetros ajustáveis, como a taxa de quadros (consulte

configs/tarser2_default_config.yaml).

Vídeo de perguntas e respostas

- mover

- Especifique perguntas e vídeos:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --instruction "视频里的人在做什么?" --input_path your/video.mp4

- Dê uma resposta direta, por exemplo, "He's drinking coffee" (Ele está tomando café).

- chamar a atenção para algo

- As perguntas devem ser específicas e evitar ambiguidades.

- Suporta chinês e outros idiomas, sendo que o chinês é o melhor.

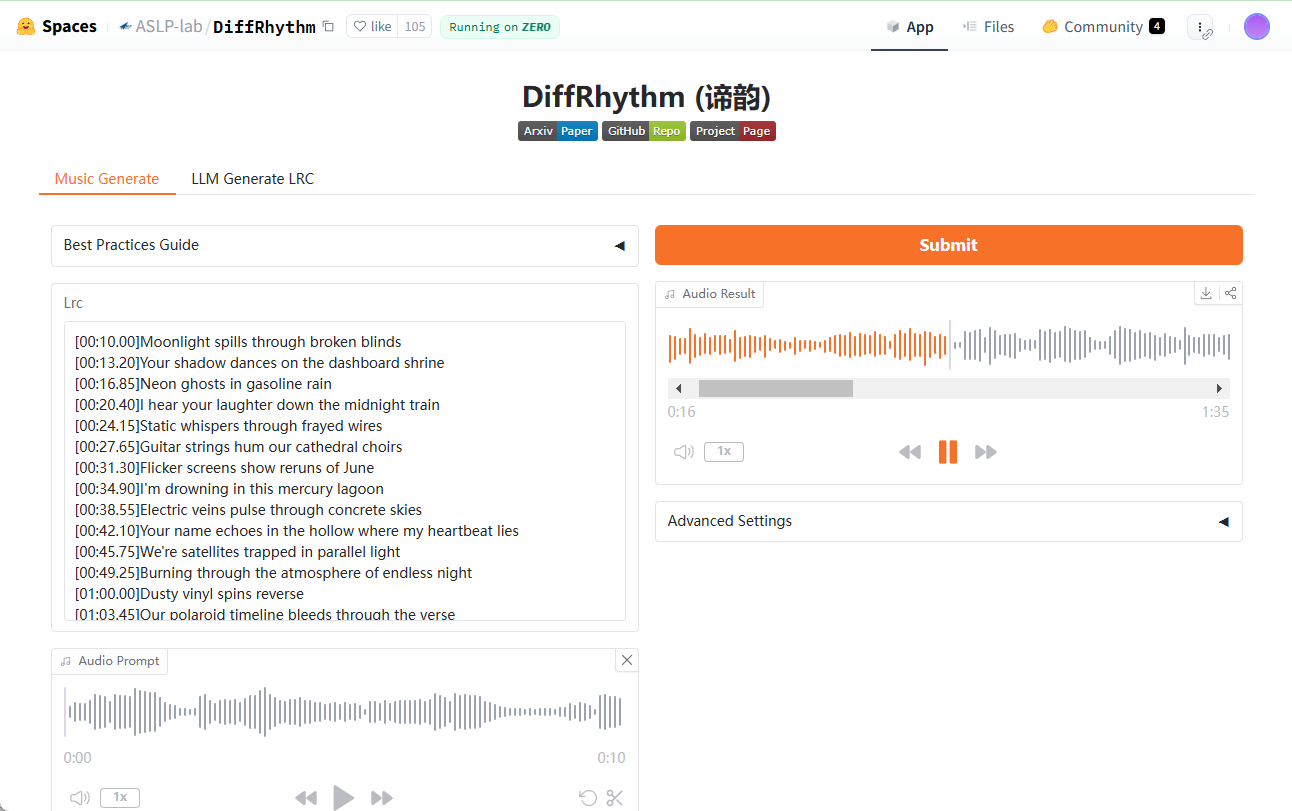

Geração de legendas com zero amostras

- mover

- Modifique o arquivo de configuração para ativar o modo de legenda (

configs/tarser2_default_config.yamlconfigurartask: caption). - Em execução:

python3 -m tasks.inference_quick_start --model_name_or_path path/to/Tarsier2-7b --config configs/tarser2_default_config.yaml --input_path your/video.mp4

- Emite legendas curtas, como "Drinking coffee alone" (Tomando café sozinho).

Implantação de serviços locais

- mover

- Instale o vLLM (versão recomendada 0.6.6):

pip install vllm==0.6.6

- Inicie o serviço:

python -m vllm.entrypoints.openai.api_server --model path/to/Tarsier2-7b

- Chamado com uma API:

curl http://localhost:8000/v1/completions -H "Content-Type: application/json" -d '{"prompt": "描述这个视频", "video_path": "your/video.mp4"}'

- vantagem

- O vídeo pode ser processado em lotes.

- Fácil integração com outros sistemas.

Operação da função em destaque

Avaliação do DREAM-1K

- mover

- Faça o download do conjunto de dados DREAM-1K:

wget https://tarsier-vlm.github.io/DREAM-1K.zip

unzip DREAM-1K.zip

- Avaliação operacional:

bash scripts/run_inference_benchmark.sh path/to/Tarsier2-7b output_dir dream

- O resultado inclui métricas, como pontuações F1, que mostram a qualidade da descrição.

Avaliação do AutoDQ

- mover

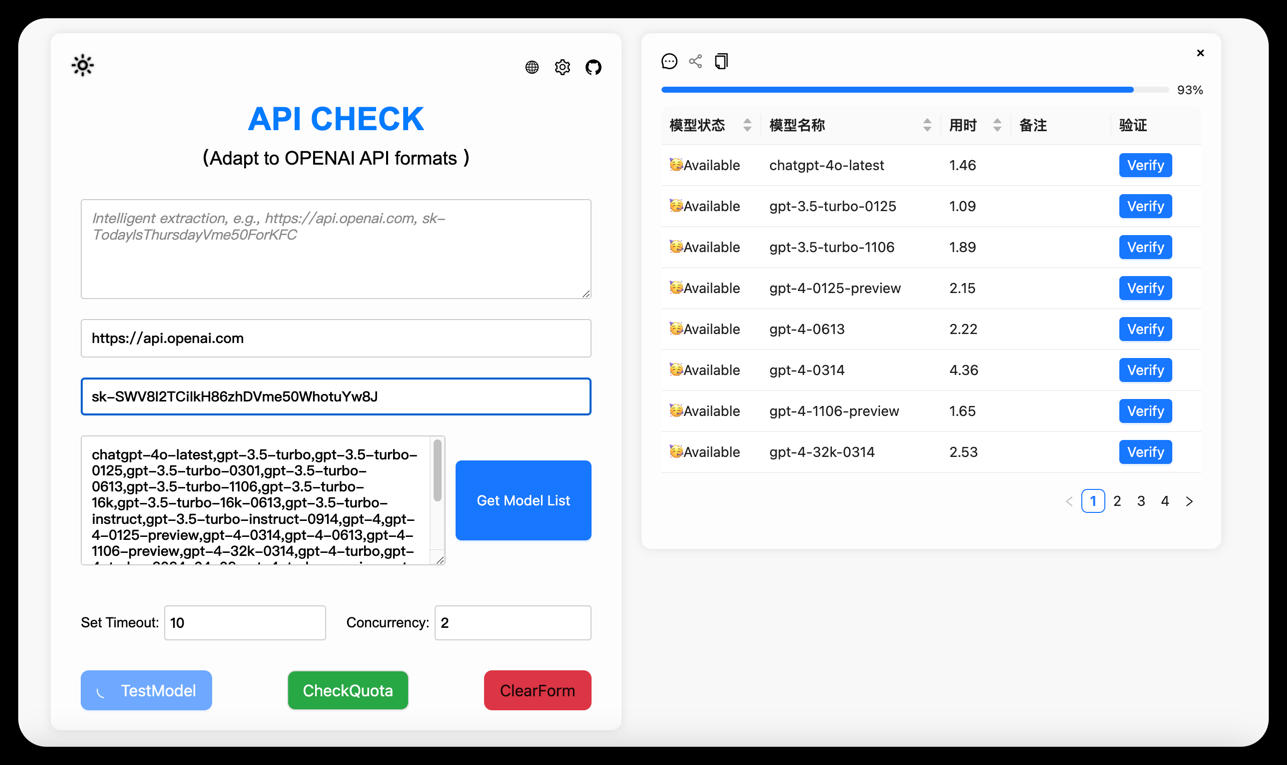

- Garantir a instalação ChatGPT dependências (é necessária a configuração do Azure OpenAI).

- Execute o script de avaliação:

python evaluation/metrics/evaluate_dream_gpt.py --pred_dir output_dir/dream_predictions

- Gera uma pontuação de avaliação automatizada que mede a precisão da descrição.

Perguntas frequentes

- falha na instalaçãoVerifique a versão e a rede do Python, atualize o pip (

pip install -U pip). - Carregamento lento do modeloVerifique se você tem espaço suficiente em disco; recomenda-se pelo menos 50 GB.

- Sem saída de GPU: Executar

nvidia-smiVerifique se o CUDA está funcionando corretamente.

Experiência on-line

- entrevistas Demonstração on-line do Tarsier2-7BSe você quiser testar a descrição e a função de perguntas e respostas, carregue um vídeo.

Com essas etapas, você pode lidar facilmente com tarefas de vídeo com o Tarsier. Seja para gerar descrições ou implantar serviços, é simples e eficiente.

cenário do aplicativo

- Agrupamento de conteúdo de vídeo

Os profissionais de mídia podem usar o Tarsier para gerar resumos de vídeo e organizar rapidamente as filmagens. - Assistência de vídeo educacional

Os professores podem gerar legendas ou questionários para os vídeos do curso para aprimorar o ensino e a aprendizagem. - Análise de vídeo curto

Os profissionais de marketing podem analisar o conteúdo de vídeos curtos, como o TikTok, e extrair mensagens importantes para promoção.

QA

- Quais formatos de vídeo são suportados?

Compatível com MP4, GIF, AVI, etc., desde que o FFmpeg possa decodificá-los. - Quais são os requisitos de hardware?

Mínimo de 16 GB de RAM e 4 GB de memória de vídeo, GPU NVIDIA recomendada (por exemplo, 3090). - Ele está disponível comercialmente?

Sim, o Tarsier usa a licença Apache 2.0 e o uso comercial é permitido, sujeito aos termos.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...