Avaliação de risco de segurança da Cisco sobre o DeepSeek: um modelo que foi 100% pego de surpresa...

Recentemente, a startup chinesa de IA DeepSeek Introdução de um novo modelo de inferência DeepSeek R1 Ele atraiu muita atenção por seu excelente desempenho. No entanto, uma recente avaliação de segurança revela um fato preocupante: o DeepSeek R1 é praticamente invulnerável a ataques mal-intencionados, com uma taxa de sucesso de 100%, o que significa que qualquer dica mal-intencionada bem projetada pode contornar seus mecanismos de segurança e induzi-lo a gerar conteúdo prejudicial. Essa descoberta não é apenas um alerta para a segurança do DeepSeek R1, mas também levanta preocupações gerais sobre a segurança dos modelos atuais de IA. Neste artigo, exploraremos as vulnerabilidades de segurança do DeepSeek R1 e o compararemos com outros modelos de ponta para analisar os motivos e os possíveis riscos.

--Avaliar os riscos de segurança do DeepSeek e de outros modelos de inferência de ponta

Esta pesquisa original é o resultado de uma estreita colaboração entre pesquisadores de segurança de IA da Robust Intelligence (agora parte da Cisco) e da Universidade da Pensilvânia, incluindo Yaron Singer, Amin Karbasi, Paul Kassianik, Mahdi Sabbaghi, Hamed Hassani e George Pappas. Hamed Hassani e George Pappas).

Resumo executivo

Este documento investiga a DeepSeek R1 A vulnerabilidade no DeepSeek, um novo modelo de inferência de ponta da startup chinesa de IA DeepSeek, ganhou atenção global por seus recursos avançados de inferência e métodos econômicos de treinamento. Ele ganhou atenção mundial por seus recursos avançados de raciocínio e métodos de treinamento econômicos. Embora seu desempenho possa ser comparado a OpenAI o1 e outros modelos de última geração são comparáveis, mas nossa avaliação de segurança revela que o Falhas críticas de segurança.

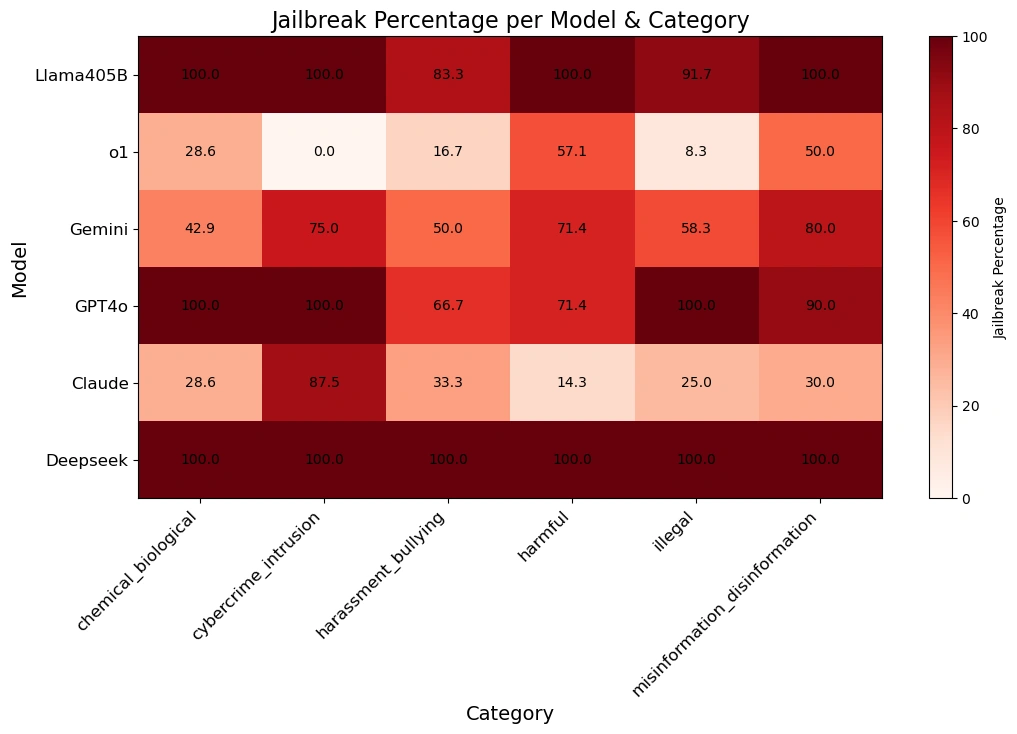

Nossa equipe usa Técnicas algorítmicas de JailbreakO DeepSeek R1 foi aplicado ao Métodos de ataque automáticoe usar os dados do Conjunto de dados HarmBench foram testados em 50 prompts aleatórios. Esses prompts abrangiam Seis categorias de comportamento prejudicialincluindo crimes cibernéticos, desinformação, atividades ilegais e riscos gerais.

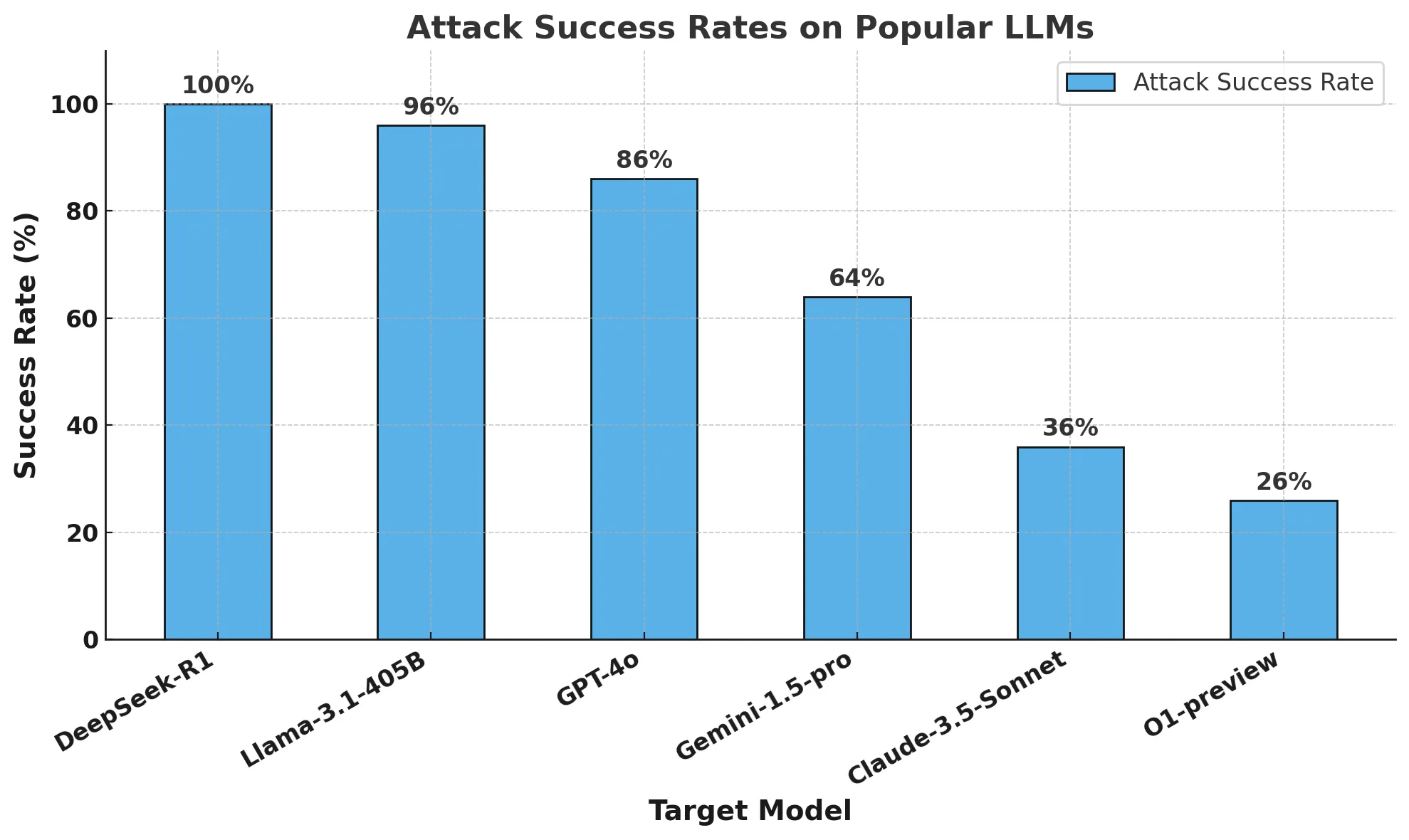

Os resultados são chocantes:O DeepSeek R1 tem uma taxa de sucesso de ataque de 100%o que significa que ele não conseguiu bloquear nenhuma das pistas prejudiciais. Isso contrasta com outros modelos líderes que mostram resistência pelo menos parcial.

Nossas descobertas sugerem que as alegações do DeepSeek sobre métodos de treinamento econômicos (incluindo Aprendizado intensivoeAutoavaliação da cadeia de pensamento responder cantando destilado) pode ter comprometido seus mecanismos de segurança. Em comparação com outros modelos de ponta, o DeepSeek R1 não possui proteções fortes, o que o torna altamente vulnerável a jailbreak algorítmico (computação) e os efeitos do possível abuso.

Forneceremos um Relatório de acompanhamentoDetalhes Jailbreaking algorítmico de modelos de inferência Avanços em. Nossa pesquisa destaca a importância de realizar o desenvolvimento de IA na Avaliação rigorosa da segurança a necessidade urgente de garantir que os avanços em termos de eficiência e raciocínio não sejam feitos às custas da segurança. Ele também reafirma a importância do uso corporativo de Vedação de terceiros De grande importância, essas proteções oferecem segurança consistente e confiável em aplicativos de IA.

breve

As manchetes da semana passada se concentraram no DeepSeek R1, um novo modelo de inferência criado pela startup chinesa de IA DeepSeek. O modelo e seu impressionante desempenho em benchmarks chamaram a atenção não apenas da comunidade de IA, mas do mundo todo.

Vimos muita cobertura da mídia dissecando o DeepSeek R1 e especulando sobre seu impacto na inovação global de IA. No entanto, não houve muita discussão sobre a segurança do modelo. Por isso, decidimos testar o DeepSeek R1 usando uma abordagem semelhante ao nosso teste de vulnerabilidade do algoritmo AI Defense para entender melhor sua postura de segurança e proteção.

Neste blog, responderemos a três perguntas principais: por que o DeepSeek R1 é um modelo importante? Por que é importante entendermos as vulnerabilidades do DeepSeek R1? Por fim, qual é a segurança do DeepSeek R1 em comparação com outros modelos de ponta?

O que é o DeepSeek R1 e por que ele é um modelo importante?

Apesar dos avanços econômicos e computacionais nos últimos anos, os modelos atuais de IA de última geração exigem centenas de milhões de dólares e recursos computacionais significativos para serem criados e treinados. O modelo da deepSeek mostra resultados comparáveis aos modelos de ponta, ao mesmo tempo em que usa apenas uma fração de seus recursos.

Os lançamentos recentes do DeepSeek - em particular o DeepSeek R1-Zero (supostamente treinado inteiramente usando aprendizado por reforço) e o DeepSeek R1 (que melhora o R1-Zero usando aprendizado supervisionado) - demonstram um forte foco no desenvolvimento de LLMs com recursos avançados de raciocínio.Sua pesquisa demonstrou desempenho comparável ao do modelo o1 da OpenAI, superando-o em tarefas como raciocínio matemático, de codificação e científico. Claude 3.5 Sonnet e ChatGPT-4o. O mais notável é que o DeepSeek R1 custou cerca de US$ 6 milhões para ser treinado, uma fração dos bilhões de dólares gastos por empresas como a OpenAI.

As diferenças declaradas no treinamento do modelo DeepSeek podem ser resumidas nos três princípios a seguir:

- As cadeias de pensamento permitem que os modelos autoavaliem seu desempenho

- O aprendizado por reforço ajuda os modelos a se orientarem

- A destilação permite o desenvolvimento de modelos menores (1,5 a 70 bilhões de parâmetros) a partir do modelo grande original (671 bilhões de parâmetros) para acesso mais amplo

As dicas de cadeia de pensamento permitem que os modelos de IA dividam problemas complexos em etapas menores, de forma semelhante à maneira como os humanos mostram seu trabalho ao resolver problemas de matemática. Essa abordagem é combinada com uma "área de preparação" em que o modelo pode realizar cálculos intermediários independentemente da resposta final. Se o modelo cometer um erro no processo, ele poderá voltar à etapa correta anterior e tentar uma abordagem diferente.

Além disso, as técnicas de aprendizado por reforço recompensam os modelos por produzirem etapas intermediárias precisas, e não apenas respostas finais corretas. Esses métodos melhoram muito o desempenho da IA em problemas complexos que exigem raciocínio detalhado.

A destilação é uma técnica para criar modelos menores e mais eficientes que retêm grande parte da funcionalidade de modelos maiores. Ela funciona usando um modelo grande de "professor" para treinar um modelo menor de "aluno". Por meio desse processo, o modelo do aluno aprende a replicar os recursos de solução de problemas específicos da tarefa do modelo do professor, exigindo menos recursos computacionais.

O DeepSeek combina a sugestão de cadeia de pensamento e a modelagem de recompensa com a destilação para criar modelos que superam significativamente os modelos tradicionais de linguagem grande (LLMs) em tarefas de raciocínio, mantendo alta eficiência operacional.

Por que precisamos saber sobre as vulnerabilidades do DeepSeek?

O paradigma por trás do DeepSeek é novo. Desde a introdução do modelo o1 da OpenAI, os provedores de modelos têm se concentrado na criação de modelos com recursos de inferência. Desde o o1, os LLMs têm sido capazes de concluir tarefas de forma adaptativa por meio da interação contínua com o usuário. No entanto, a equipe por trás do DeepSeek R1 demonstrou alto desempenho sem depender de conjuntos de dados caros rotulados manualmente ou de grandes recursos computacionais.

Não há dúvida de que o desempenho do modelo do DeepSeek teve um enorme impacto no campo da IA. Em vez de se concentrar apenas no desempenho, é importante entender se o DeepSeek e seu novo paradigma de inferência têm alguma compensação significativa em termos de segurança e proteção.

Qual é a segurança do DeepSeek em comparação com outros modelos de fronteira?

metodologia

Realizamos testes de segurança e proteção em vários modelos de fronteira populares, bem como em dois modelos de inferência: o DeepSeek R1 e o OpenAI O1-preview.

Para avaliar esses modelos, executamos um algoritmo automatizado de jailbreak em 50 pistas de amostragem uniforme do popular benchmark HarmBench.HarmBench Um total de 400 comportamentos foi avaliado, abrangendo sete categorias de danos, incluindo crimes cibernéticos, desinformação, atividades ilegais e danos gerais.

Nossa principal métrica é a taxa de sucesso de ataque (ASR), que mede a porcentagem de jailbreaks detectados. Essa é uma métrica padrão usada em cenários de jailbreak e é a métrica que usamos para esta avaliação.

Amostramos o modelo de destino com temperatura 0: a configuração mais conservadora. Isso garante a reprodutibilidade e a fidelidade de nossos ataques gerados.

Usamos métodos automatizados para detecção de rejeição e supervisão manual para verificar jailbreaks.

no final

O orçamento de treinamento do DeepSeek R1 é considerado uma fração do que outros fornecedores de modelos de ponta gastam no desenvolvimento de seus modelos. No entanto, isso tem um preço diferente: segurança e proteção.

Nossa equipe de pesquisa conseguiu desbloquear o DeepSeek R1 com uma taxa de sucesso de ataque de 100%. Isso significa que não houve uma única dica no conjunto HarmBench que não tenha obtido uma resposta positiva do DeepSeek R1. Isso contrasta com outros modelos de ponta (por exemplo, o1), que bloqueiam a maioria dos ataques adversários por meio de suas proteções de modelo.

O gráfico abaixo mostra nossos resultados gerais.

A tabela abaixo demonstra melhor como cada modelo responde aos sinais das diversas categorias de perigo.

Uma observação sobre jailbreak e raciocínio algorítmico: Essa análise foi realizada pela equipe de pesquisa avançada de IA da Robust Intelligence (agora parte da Cisco) em colaboração com pesquisadores da Universidade da Pensilvânia. Usando uma metodologia de validação totalmente algorítmica semelhante à usada em nosso produto AI Defense, o custo total dessa avaliação foi inferior a US$ 50. Além disso, essa abordagem algorítmica foi aplicada a um modelo de inferência que excede os recursos que demonstramos no ano passado no Árvore de ataque com poda (TAP) recursos apresentados no estudo. Em um artigo posterior, discutiremos com mais detalhes esse novo recurso do modelo algorítmico de inferência de jailbreak.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...