RunPod: serviço de nuvem de GPU projetado para IA com SD de inicialização rápida e pagamento por segundo

Introdução geral

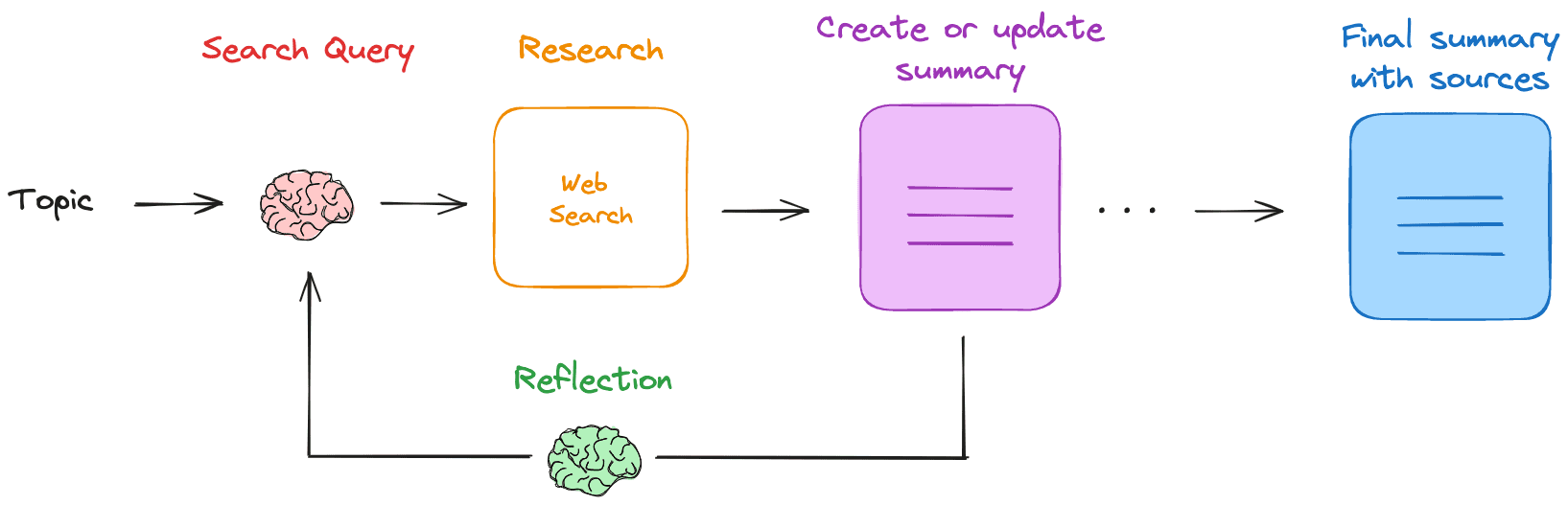

O RunPod é uma plataforma de computação em nuvem projetada especificamente para IA, com o objetivo de fornecer aos desenvolvedores, pesquisadores e empresas uma solução completa para o desenvolvimento, treinamento e dimensionamento de modelos de IA. A plataforma integra recursos de GPU sob demanda, raciocínio sem servidor, dimensionamento automático e muito mais para oferecer suporte avançado a todas as fases dos projetos de IA. A filosofia principal do RunPod é simplificar o processo de desenvolvimento de IA, permitindo que os usuários se concentrem na inovação do modelo sem precisar se preocupar muito com problemas de infraestrutura.

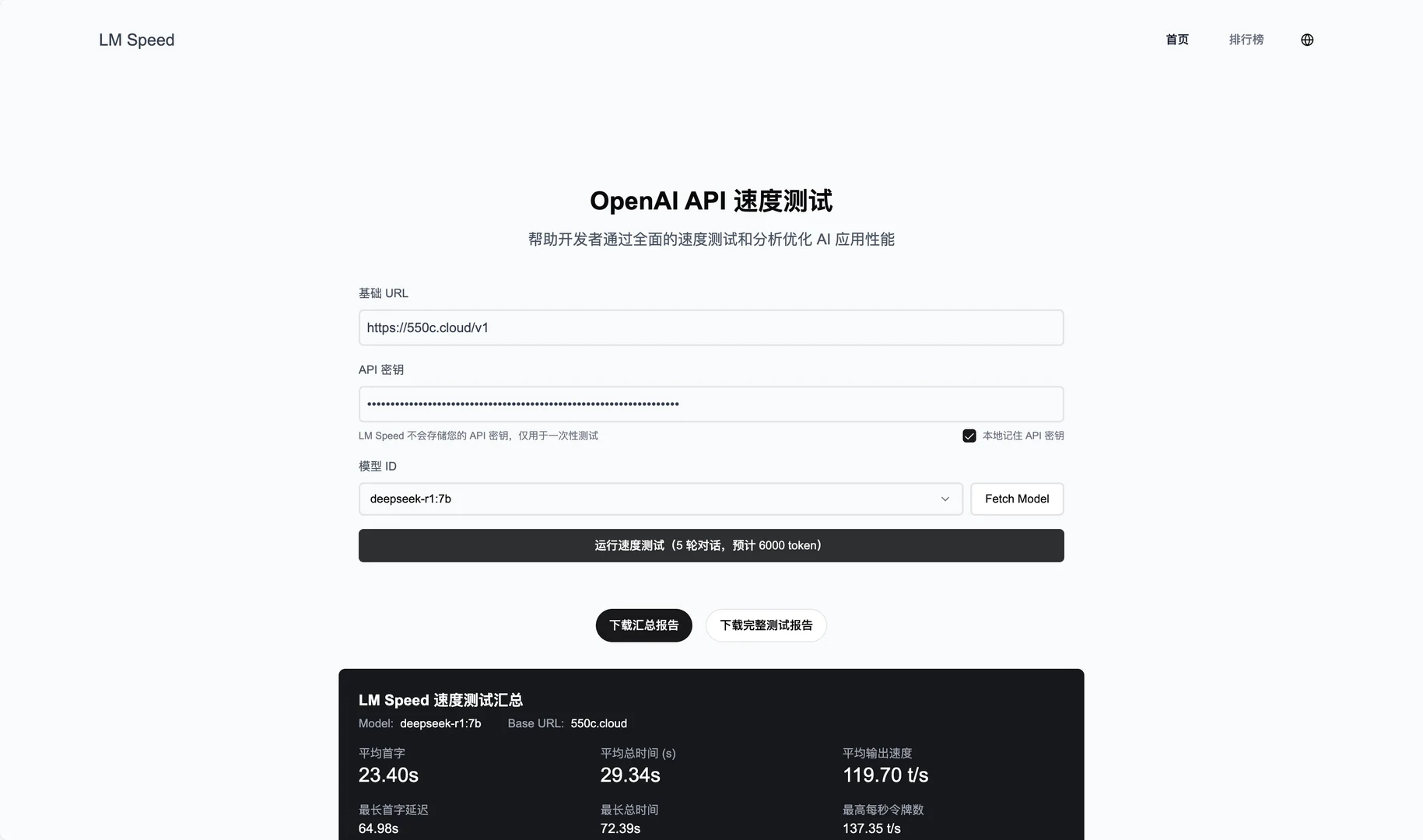

O pagamento somente no momento da solicitação e a inicialização rápida a frio são adequados para serviços de baixa frequência e exigem uma operação de alta qualidade. Enquanto isso, a classe de processamento de linguagem natural de grandes modelos de linguagem suporta o pagamento por tokens.

Lista de funções

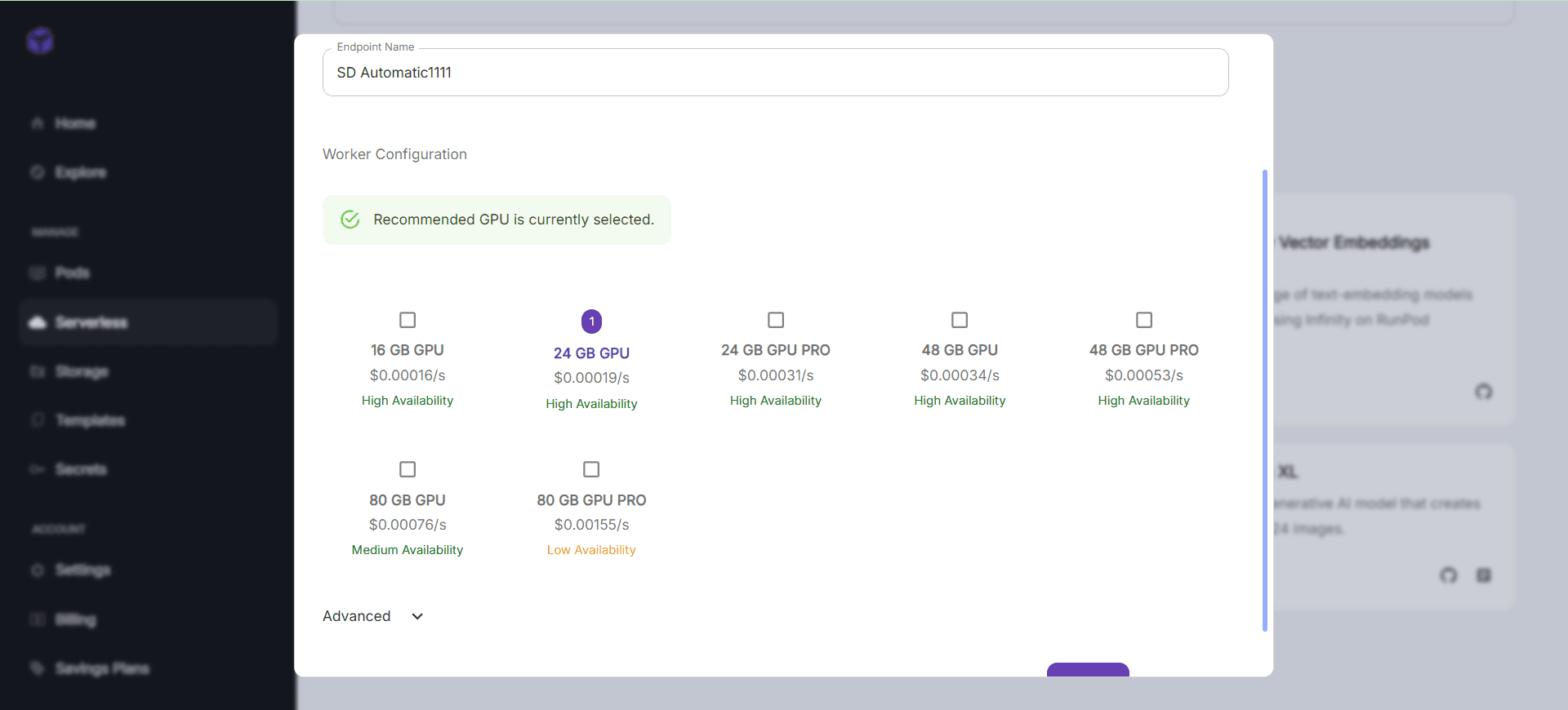

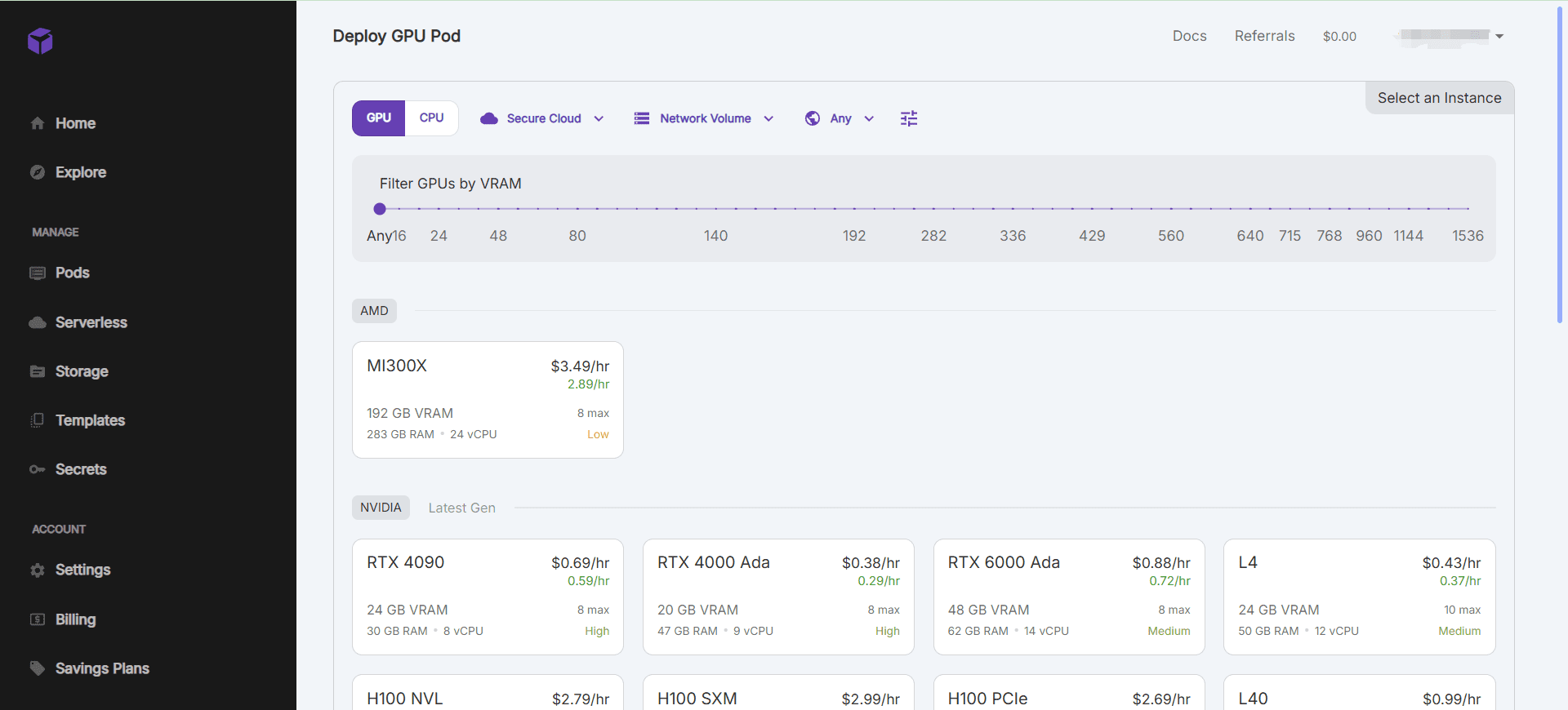

- Recursos de GPU sob demandaInicialização rápida de instâncias de GPU e suporte a vários modelos de GPU para atender a diferentes requisitos aritméticos.

- Raciocínio sem servidorCapacidade de raciocínio: dimensiona automaticamente os recursos de raciocínio para lidar eficientemente com cargas de trabalho variáveis.

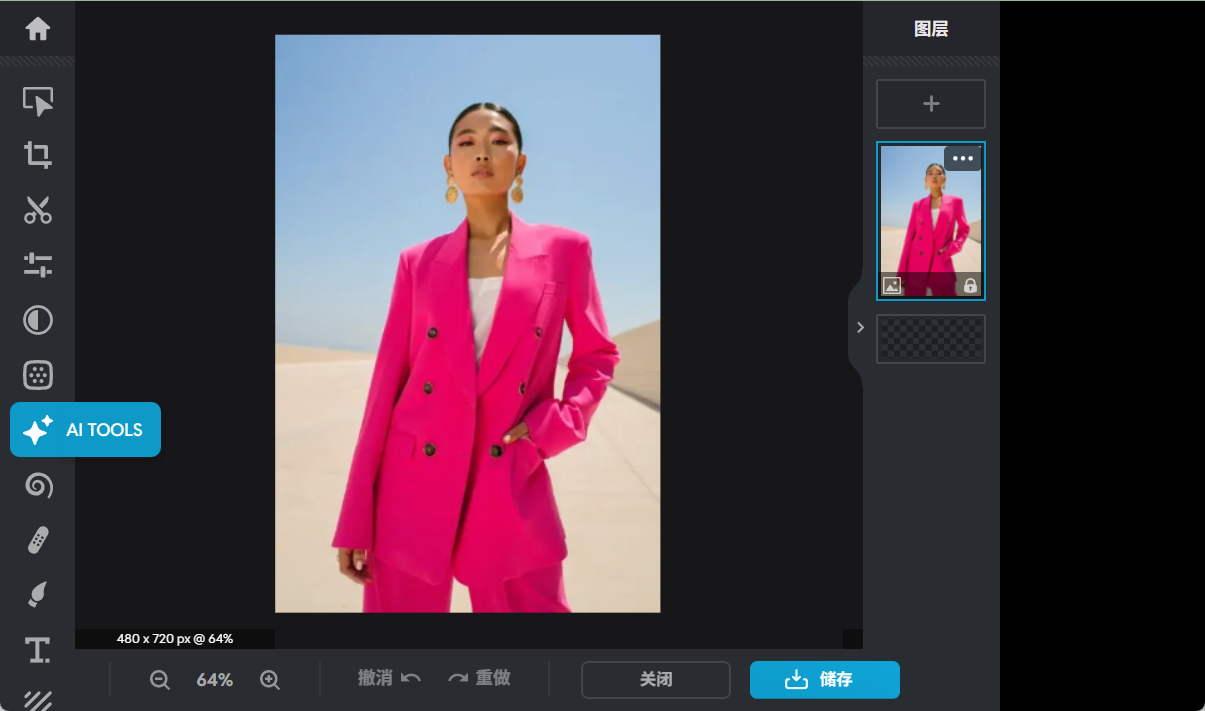

- Integração do ambiente de desenvolvimentoAmbiente de desenvolvimento de IA pré-configurado com suporte para estruturas e ferramentas de aprendizagem profunda comumente usadas.

- Gerenciamento e armazenamento de dadosSolução integrada de armazenamento de dados com mecanismos eficientes de transferência e acesso a dados.

- Colaboração e controle de versãoSuporte ao desenvolvimento colaborativo em equipe e recursos de versão de modelos.

Usando a Ajuda

Instalação e uso

- Criação de uma instância de GPU::

- Depois de fazer login, vá para a página do console e clique em "Create Pod" (Criar pod).

- Selecione o modelo e a configuração de GPU desejados e clique em "Create" (Criar) para iniciar a instância.

- Depois que a instância é iniciada, ela pode ser operada via SSH ou conexão de terminal da Web.

- Uso de ambientes pré-configurados::

- O RunPod oferece uma ampla variedade de ambientes de desenvolvimento de IA pré-configurados, como PyTorch, TensorFlow e outros.

- Ao criar uma instância, você pode selecionar o modelo de ambiente desejado e iniciar rapidamente o desenvolvimento do projeto.

- gerenciamento de dados::

- O RunPod oferece uma solução integrada de armazenamento de dados para gerenciar conjuntos de dados no console.

- Suporta o upload, o download e o compartilhamento de dados para garantir a segurança dos dados e a proteção da privacidade.

- Colaboração e controle de versão::

- Suporta o desenvolvimento de equipes colaborativas, os membros da equipe podem ser convidados a trabalhar em projetos juntos.

- Fornece a função de gerenciamento de versões de modelos, facilitando o rastreamento e o gerenciamento de diferentes versões de modelos.

- Raciocínio sem servidor::

- O RunPod oferece suporte à arquitetura sem servidor e dimensiona automaticamente os recursos de inferência.

- Os pontos de extremidade da API podem ser configurados no console para habilitar serviços de inferência on-line para modelos.

fluxo de trabalho

- Exemplo de GPU de início rápido::

- Faça login no console e selecione "Create Pod" (Criar pod).

- Selecione o modelo e a configuração de GPU desejados e clique em "Create" (Criar).

- Depois que a instância é iniciada, ela é operada via SSH ou conexão de terminal da Web.

- Uso de ambientes pré-configurados::

- Ao criar uma instância, selecione o modelo de ambiente desejado.

- Depois de conectar a instância, você pode usar diretamente o ambiente de desenvolvimento pré-configurado para o desenvolvimento do projeto.

- gerenciamento de dados::

- Gerencie conjuntos de dados no console para suportar o upload, o download e o compartilhamento de dados.

- Garantir a segurança dos dados e a proteção da privacidade.

- Colaboração e controle de versão::

- Convide os membros da equipe para trabalharem juntos em projetos e use recursos de controle de versão para rastrear e gerenciar versões de modelos.

- Raciocínio sem servidor::

- Configure os pontos de extremidade da API no console para ativar os serviços de inferência on-line para modelos.

- Dimensione automaticamente os recursos de inferência para lidar eficientemente com cargas de trabalho variáveis.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...