O que é o MCP Open Protocol?

É isso que estamos fazendo na Antrópica Um padrão aberto desenvolvido para enfrentar o principal desafio dos aplicativos de modelagem de linguagem grande (LLM): conectá-los aos seus dados.

Não há necessidade de criar integrações personalizadas para cada fonte de dados. O MCP fornece um protocolo para conectar todas as fontes de dados:

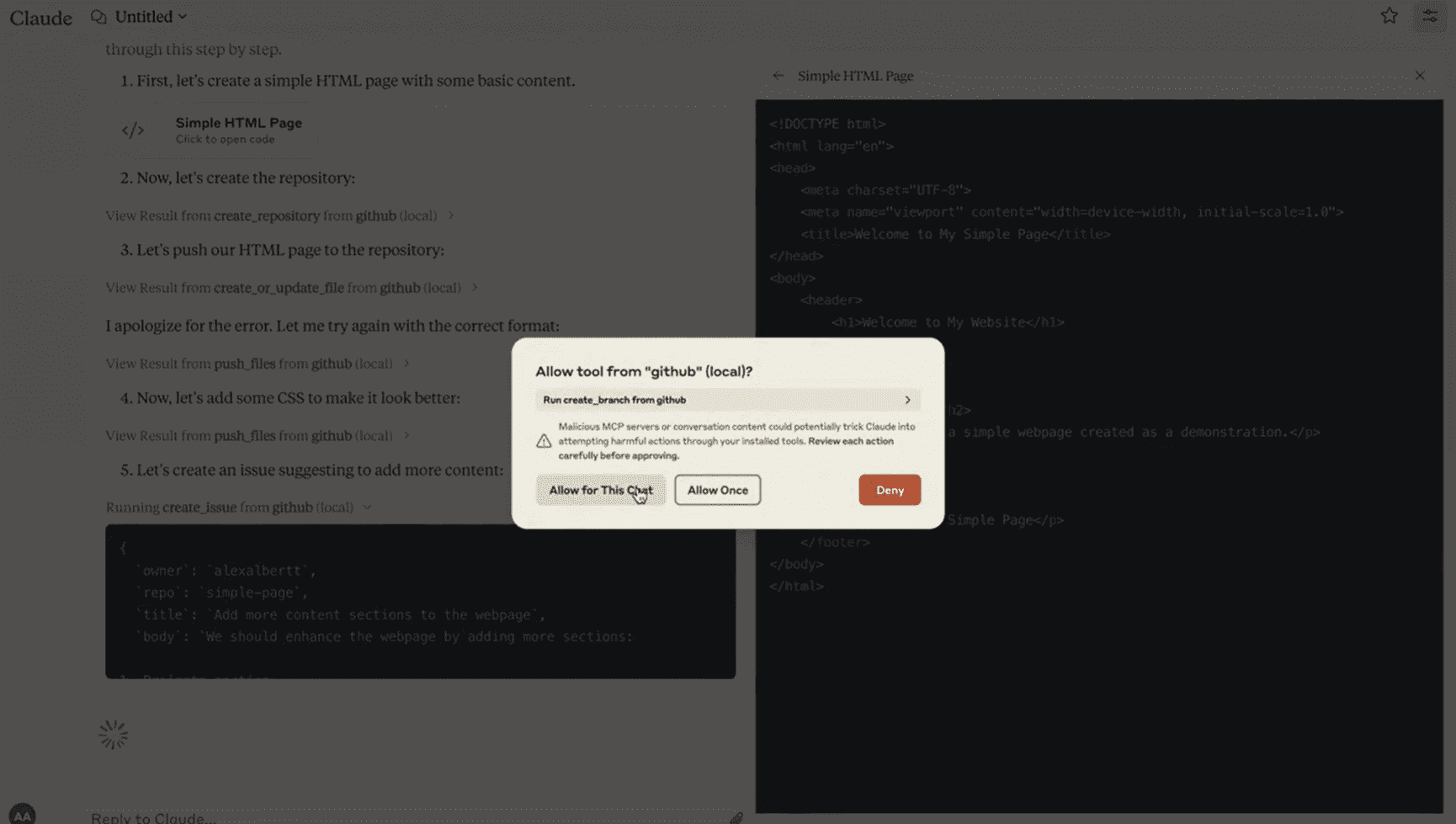

Abaixo está uma lista das maneiras mais comuns de usar o Claude Uma rápida demonstração do aplicativo de desktop no qual configuramos o MCP:

Veja como Claude se conecta diretamente ao GitHub, cria uma nova base de código (repo) com um simples MCP A integração inicia uma RP.

Depois de configurar o MCP no aplicativo de desktop Claude, levou menos de uma hora para criar essa integração.

Fazer com que o LLM interaja com sistemas externos geralmente não é fácil.

Atualmente, cada desenvolvedor precisa escrever um código personalizado para conectar seu aplicativo LLM a uma fonte de dados. Essa é uma tarefa tediosa e repetitiva.

O MCP resolve esse problema por meio de um protocolo padrão para o compartilhamento de recursos, ferramentas e dicas.

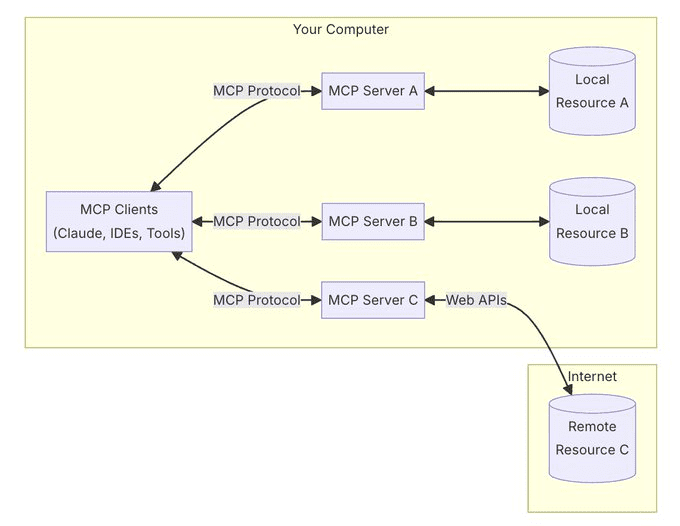

Em sua essência, o MCP segue uma arquitetura cliente-servidor na qual vários serviços podem se conectar a qualquer cliente compatível.

Os clientes são aplicativos semelhantes aos aplicativos de desktop, IDEs ou ferramentas de IA da Claude. Os servidores são adaptadores leves responsáveis pela exposição das fontes de dados.

Um dos pontos fortes do MCP é que ele pode lidar com recursos locais (seus bancos de dados, arquivos, serviços) e recursos remotos (APIs como Slack ou GitHub) por meio do mesmo protocolo.

Um servidor MCP não compartilha apenas dados. Além dos recursos (arquivos, documentos, dados), eles também podem ser expostos:

- Ferramentas (integração de API, operações)

- Dicas (interações de modelo)

A segurança é integrada ao protocolo - os servidores controlam seus próprios recursos, não há necessidade de compartilhar chaves de API com provedores de LLM e os limites do sistema são claros.

Atualmente, o MCP só oferece suporte à implementação local - o servidor deve estar em execução em seu computador.

No entanto, estamos desenvolvendo funcionalidades para dar suporte a servidores remotos e fornecer autenticação de nível empresarial para que as equipes possam compartilhar com segurança suas fontes contextuais em toda a organização.

Estamos construindo um mundo em que a IA pode se conectar a qualquer fonte de dados por meio de um único protocolo elegante - o MCP é o tradutor universal.

Integre o MCP em seu cliente uma vez e conecte-se a qualquer fonte de dados a qualquer momento.

Comece a usar o MCP em menos de 5 minutos - criamos servidores para GitHub, Slack, bancos de dados SQL, arquivos locais, mecanismos de pesquisa e muito mais.

Instale o aplicativo de desktop Claude e siga nosso guia passo a passo para conectar seu primeiro servidor:

https://modelcontextprotocol.io/quickstart

Assim como o LSP fez com os IDEs, estamos transformando o MCP em um padrão aberto para a integração do LLM.

Crie seu próprio servidor, contribua com o protocolo e, juntos, moldem o futuro da integração de IA:

https://github.com/modelcontextprotocol

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...