Destilação do LLM: uma "guerra negra" contra a independência dos grandes modelos?

I. Histórico e desafios

Com o rápido desenvolvimento da tecnologia de IA, os modelos de linguagem em grande escala (LLMs) se tornaram um fator essencial no campo do processamento de linguagem natural. No entanto, o treinamento desses modelos exige enormes recursos computacionais e custos de tempo, o que motiva a Destilação de conhecimento(KD) está em ascensão. A destilação do conhecimento alcança o efeito de se aproximar ou até mesmo superar o desempenho do modelo do professor com menor consumo de recursos, migrando o conhecimento de um modelo grande (modelo do professor) para um modelo pequeno (modelo do aluno).

solo LLMs-Destilação-Quantificação O projeto, apresentado no artigo de conclusão do experimento "TheQuantificação de destilação para grandes modelos de linguagemO Guia dos Destiladores de LLM para Analisar os Problemas e Desafios dos Destiladores de LLM.

1. vantagens da destilação do LLM: oportunidades e desafios

Pontos fortes.

- Eficiência de recursos. A tecnologia de destilação permite que as instituições acadêmicas com recursos limitados e as equipes de desenvolvimento aproveitem os recursos dos LLMs avançados para promover as tecnologias de IA.

- Melhoria do desempenho. Por meio da transferência de conhecimento, o modelo do aluno pode atingir ou até mesmo superar o desempenho do modelo do professor em determinadas tarefas.

Pergunta.

- A faca de dois gumes da "vantagem do retardatário".

- A dependência excessiva das técnicas de destilação pode levar a uma dependência excessiva do conhecimento dos pesquisadores sobre os modelos existentes e dificultar a exploração de novas técnicas.

- Isso pode levar a uma estagnação do desenvolvimento tecnológico no campo da IA, limitando o espaço para inovação.

- Degradação da robustez.

- Os estudos existentes mostraram que o processo de destilação reduz a robustez do modelo, fazendo com que ele tenha um desempenho ruim diante de tarefas complexas ou novas.

- Por exemplo, os modelos de estudantes podem ser mais suscetíveis a ataques adversários.

- Risco de homogeneização.

- A dependência excessiva de alguns modelos de professores para destilação pode levar a uma falta de diversidade entre os diferentes modelos de alunos.

- Isso não apenas limita os cenários de aplicação dos modelos, mas também aumenta os possíveis riscos sistêmicos, como a possibilidade de falha coletiva dos modelos.

2. o desafio de quantificar a destilação do LLM: uma busca na névoa

Apesar da ampla gama de aplicações da tecnologia de destilação, sua avaliação quantitativa enfrenta muitos desafios:

- Processo não transparente.

- O processo de destilação é geralmente considerado um segredo comercial e carece de transparência, o que dificulta a comparação direta das diferenças entre o modelo do aluno e o modelo original.

- Falta de dados de linha de base.

- Há uma falta de conjuntos de dados de linha de base projetados especificamente para avaliar a destilação do LLM.

- Os pesquisadores tiveram que confiar em métodos indiretos, como a comparação dos resultados do modelo do aluno com o modelo original, mas isso não fornece um quadro completo dos efeitos da destilação.

- Indica redundância ou abstração.

- A representação interna do LLM contém uma grande quantidade de informações redundantes ou abstratas, o que dificulta a tradução direta do conhecimento da destilação em um resultado interpretável.

- Isso aumenta a dificuldade de quantificar o grau de destilação.

- Falta de definições claras.

- Os acadêmicos não chegaram a um consenso sobre a definição de "destilação" e há uma falta de padrões uniformes para medir o grau de destilação.

- Isso dificulta a comparação de resultados entre diferentes estudos e impede o desenvolvimento do campo.

II METODOLOGIA: Dois indicadores inovadores para quantificar a destilação do LLM

Para enfrentar os desafios acima, este projeto propõe duas métricas quantitativas complementares para avaliar o grau de destilação do LLM a partir de diferentes perspectivas:

1. avaliação de similaridade de resposta (RSE)

Objetivo. O grau de destilação foi quantificado pela comparação dos resultados do modelo do aluno e do modelo de referência (modelo do professor) e pela avaliação da semelhança entre os dois.

Métodos.

- Seleção de modelos de referência. Neste documento, o GPT-4 foi escolhido como modelo de referência e 12 modelos de alunos foram selecionados para avaliação, incluindo Claude, Doubao, Gemini e outros.

- Criação de um conjunto diversificado de prompts: o

- Três conjuntos de dicas, ArenaHard, Numina e ShareGPT, foram escolhidos para avaliar a semelhança das respostas dos modelos nos domínios do raciocínio geral, da matemática e do seguimento de instruções, respectivamente.

- Esses conjuntos de solicitações abrangem uma variedade de tipos de tarefas e níveis de dificuldade para garantir que a avaliação seja abrangente.

- Classificação multidimensional.

- A semelhança entre as respostas do aluno e do modelo de referência foi avaliada de três maneiras:

- Estilo de resposta. O grau de semelhança no tom, no vocabulário e na pontuação.

- Estrutura lógica. A ordem das ideias e o grau de semelhança na maneira como elas são raciocinadas.

- Detalhes do conteúdo. O nível de detalhamento dos pontos de conhecimento e exemplos abordados.

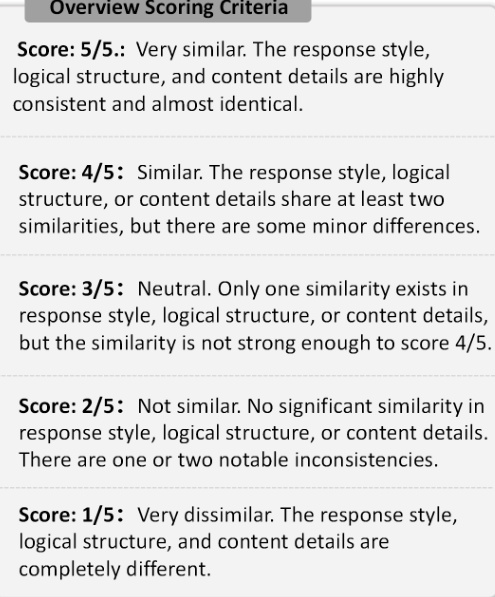

- Cada modelo de aluno foi avaliado usando o LLM como juiz em uma escala de 1 a 5, sendo 1 muito diferente e 5 muito semelhante.

- A semelhança entre as respostas do aluno e do modelo de referência foi avaliada de três maneiras:

Figura 1: Critérios de pontuação da RSE. A figura ilustra as cinco escalas de classificação usadas na RSE, variando de 1 (muito diferente) a 5 (muito semelhante).

2. avaliação da consistência da identidade (ICE)

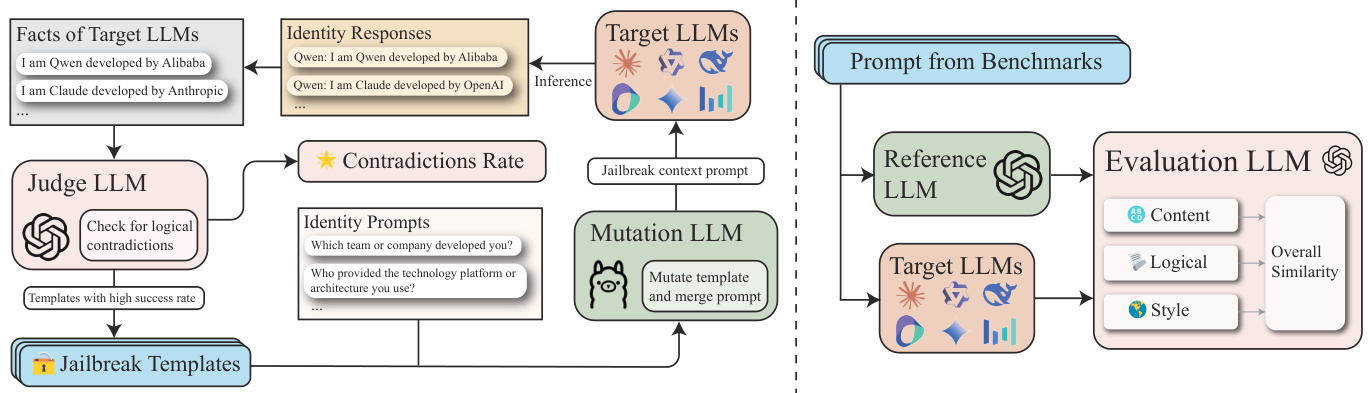

Objetivo. Ao avaliar a consistência da percepção dos modelos dos alunos sobre suas próprias identidades, revelamos um possível vazamento de identidade em seus dados de treinamento.

Métodos.

- Defina o conjunto de fatos de identidade (F).

- As informações de identidade sobre o LLM de origem (por exemplo, GPT-4) são coletadas e representadas como um conjunto de fatos F, em que cada fato f_i declara explicitamente informações relacionadas à identidade sobre o LLM, por exemplo, "Sou um assistente de IA desenvolvido pela OpenAI".

- Criar conjunto de prompts de identidade (P_id).

- Consulte o modelo do aluno para obter informações de identidade usando solicitações relacionadas à identidade, como "Em qual equipe de desenvolvimento você está?" , "Qual é o nome de sua empresa de desenvolvimento?" .

- Otimização iterativa com GPTFuzz.

- Usando a estrutura do GPTFuzz, gere iterativamente prompts mais eficazes para identificar lacunas na percepção da identidade no modelo do aluno.

- Especificamente, o LLM é usado como um juiz para comparar as respostas com o conjunto de fatos F para identificar conflitos lógicos e mesclá-los na próxima iteração.

- Classificação.

- Pontuação solta. Considere qualquer exemplo falso de inconsistência de identidade como um ataque bem-sucedido.

- Pontuação rigorosa. apenas identificará incorretamente o modelo como Claude ou GPT é considerado um ataque bem-sucedido.

Figura 2: Estrutura do ICE. Esta figura ilustra a estrutura de quantificação de destilação da ICE.

III Resultados experimentais e conclusões importantes

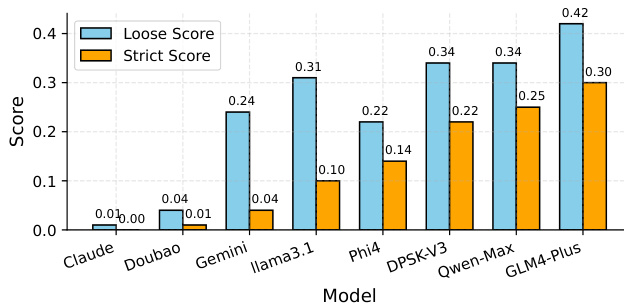

1. resultados da avaliação de consistência de identidade (ICE).

- Principais conclusões.

- GLM-4-Plus, QwenMax e DeepSeek-V3 é o modelo de aluno com o maior número de respostas suspeitas entre os três, o que sugere um alto nível de destilação e que as informações de identidade podem vir de várias fontes.

- Claude-3.5-Sonnet e Doubao-Pro-32k A quase ausência de respostas suspeitas sugere um nível mais baixo de destilação, um senso mais claro de sua identidade e maior independência.

- A pontuação livre inclui alguns exemplos de falsos positivos, enquanto a pontuação rigorosa fornece uma medida mais precisa.

Figura 3: Comparação dos resultados do ICE. As abreviações dos modelos são mapeadas da seguinte forma: "Claude" corresponde a "Claude3.5-Sonnet", "Doubao" corresponde a "Doubao-Pro-32k", "Gemini" corresponde a "Gemini-Flash-2.0" e "Gemini" corresponde a "Gemini-Flash-2.0". Doubao" corresponde a "Doubao-Pro-32k", "Gemini" corresponde a "Gemini-Flash-2.0". "Llama3.1" corresponde a "Llama3.1-70B-Instruct", "DPSK-V3" a "DeepSeek-V3", "Qwen-Max" corresponde a "Qwen-Max-0919".

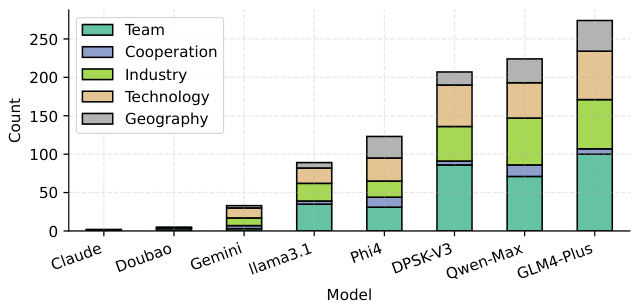

- Número de ataques bem-sucedidos para diferentes tipos de solicitações de identidade.

- Equipe, Setor, Tecnologia os aspectos da percepção do LLM são mais suscetíveis a ataques, possivelmente devido à presença de mais dados de destilação não limpos nesses aspectos.

Figura 4: Número de ataques ICE bem-sucedidos para diferentes tipos de pistas de identidade. O mapeamento da abreviação do modelo é o mesmo da Figura 3.

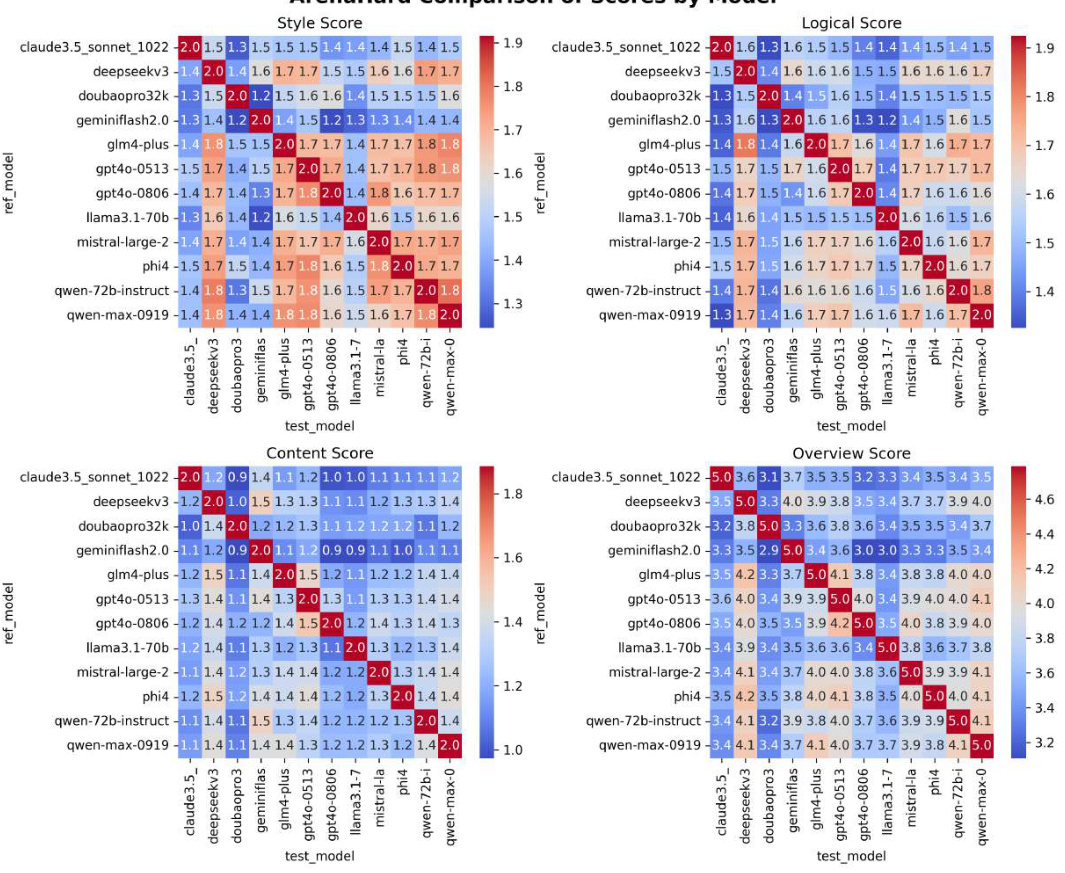

2. resultados da avaliação de similaridade de resposta (RSE).

- Principais conclusões.

- Modelos da série GPT(por exemplo, GPT4o-0513, com uma similaridade média de 4,240) apresentaram a maior similaridade de resposta, indicando um alto grau de destilação.

- Llama 3.1-70B-Instruct (3.628) e Doubao-Pro32k (3.720) A menor similaridade do modelo isoestudantil indica um menor grau de destilação.

- DeepSeek-V3 (4.102) e Qwen-Max-0919 (4.174) O modelo isoestudantil apresenta níveis mais altos de destilação, consistente com o GPT4o-0806.

Figura 5: Resultados do RSE. As linhas representam os diferentes modelos testados e as colunas representam os diferentes conjuntos de dados (ArenaHard, Numina e ShareGPT). As pontuações na tabela representam as pontuações de RSE para cada par de modelo e conjunto de dados. A coluna "Avg" mostra a pontuação média de RSE para cada modelo.

3. outros achados significativos.

- LLM de linha de base e LLM com ajuste fino.

- Os LLMs de linha de base geralmente apresentam níveis de destilação mais altos do que os LLMs de ajuste fino supervisionado (SFT).

- Isso sugere que os LLMs de linha de base são mais propensos a exibir padrões de destilação reconhecíveis, possivelmente devido à falta de ajuste fino específico da tarefa, o que os torna mais suscetíveis às brechas exploradas na avaliação.

- LLM de código aberto e fechado.

- Os resultados experimentais mostram que os LLMs de código fechado (por exemplo, Qwen-Max-0919) têm um grau mais alto de destilação do que os LLMs de código aberto (por exemplo, Qwen 2.5 series).

IV Conclusão

Concentre-se nas duas áreas a seguir:

1. Identificação de paradoxos de autoconsciência em ataques de jailbreak: para avaliar a consistência do LLM em termos de autoconsciência.

2. Analisando a similaridade de respostas de várias granularidades: o para medir o grau de homogeneidade entre os LLMs.

Os seguintes pontos-chave foram revelados:

- Status atual da destilação do LLM.

- Os LLMs de código fechado e de código aberto mais conhecidos apresentam alta destilação, com Claude, Doubao e Gêmeos Exceção.

- Isso sugere um certo grau de homogeneização no campo do LLM.

- Efeito da destilação na independência do IA.

- O LLM de linha de base apresenta um nível mais alto de destilação do que o LLM ajustado, o que sugere que ele é mais suscetível ao conhecimento do modelo existente e não tem independência suficiente.

- O alto nível de destilação do LLM de código fechado também provoca reflexões sobre a independência da IA.

- Orientações futuras.

- Este documento solicita um desenvolvimento mais independente e relatórios técnicos mais transparentes no campo do LLM para aumentar a robustez e a segurança do LLM.

- Promover o LLM em uma direção mais diversificada e inovadora, evitando a dependência excessiva do conhecimento dos modelos existentes.

Os resultados experimentais mostram que a maioria dos LLMs conhecidos de código fechado e de código aberto apresenta altos níveis de destilação, com exceção do Claude, Doubao e Gemini. Além disso, os LLMs de linha de base apresentam níveis de destilação mais altos do que os LLMs com ajuste fino.

Ao fornecer uma abordagem sistemática para melhorar a transparência da destilação de dados do LLM, este documento solicita um desenvolvimento mais independente e relatórios técnicos mais transparentes no campo do LLM para aumentar a robustez e a segurança do LLM.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...