LazyLLM: a ferramenta de desenvolvimento de código reduzido de código aberto da Shangtang para a criação de aplicativos corporais multiinteligentes

Introdução geral

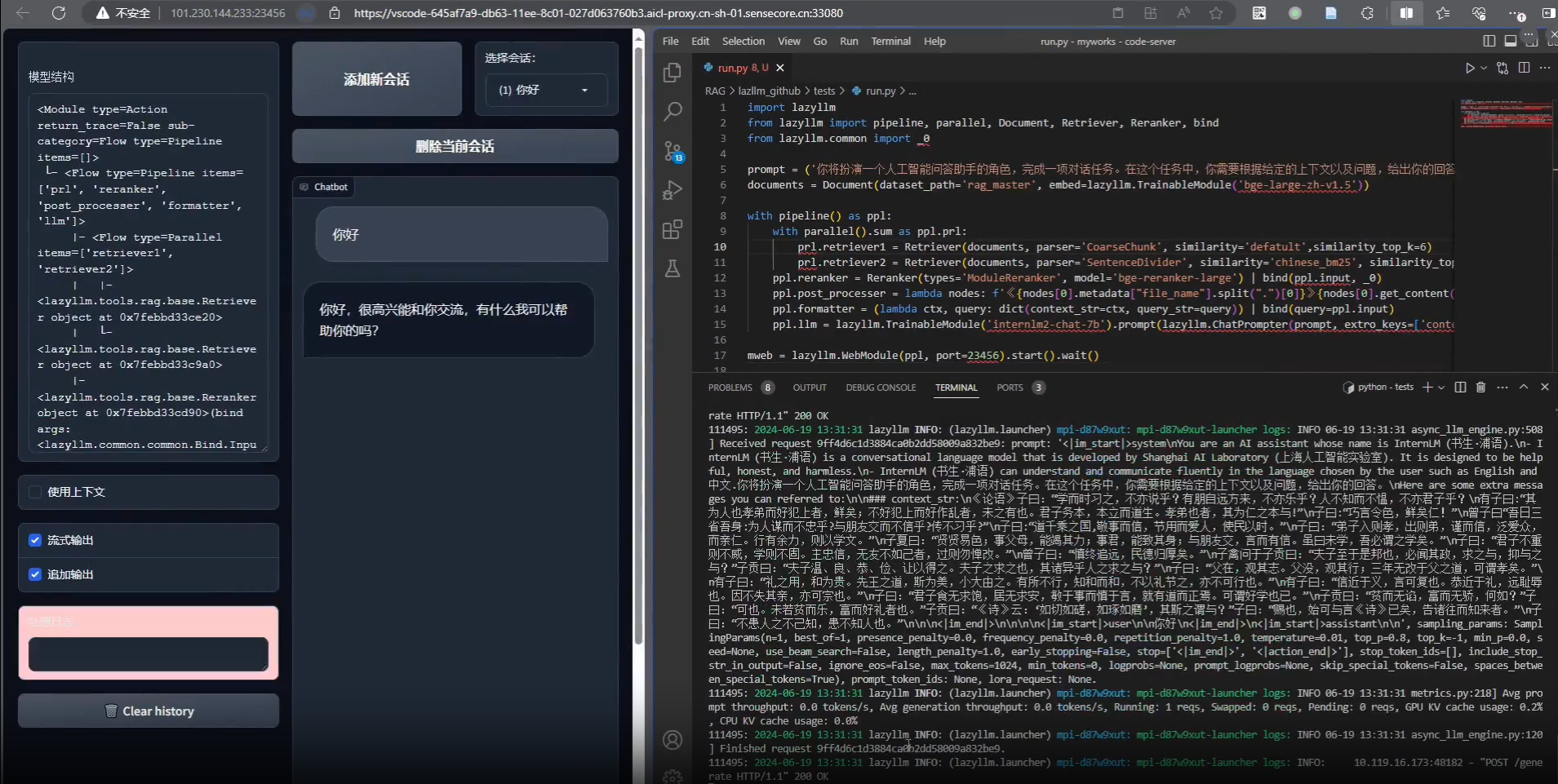

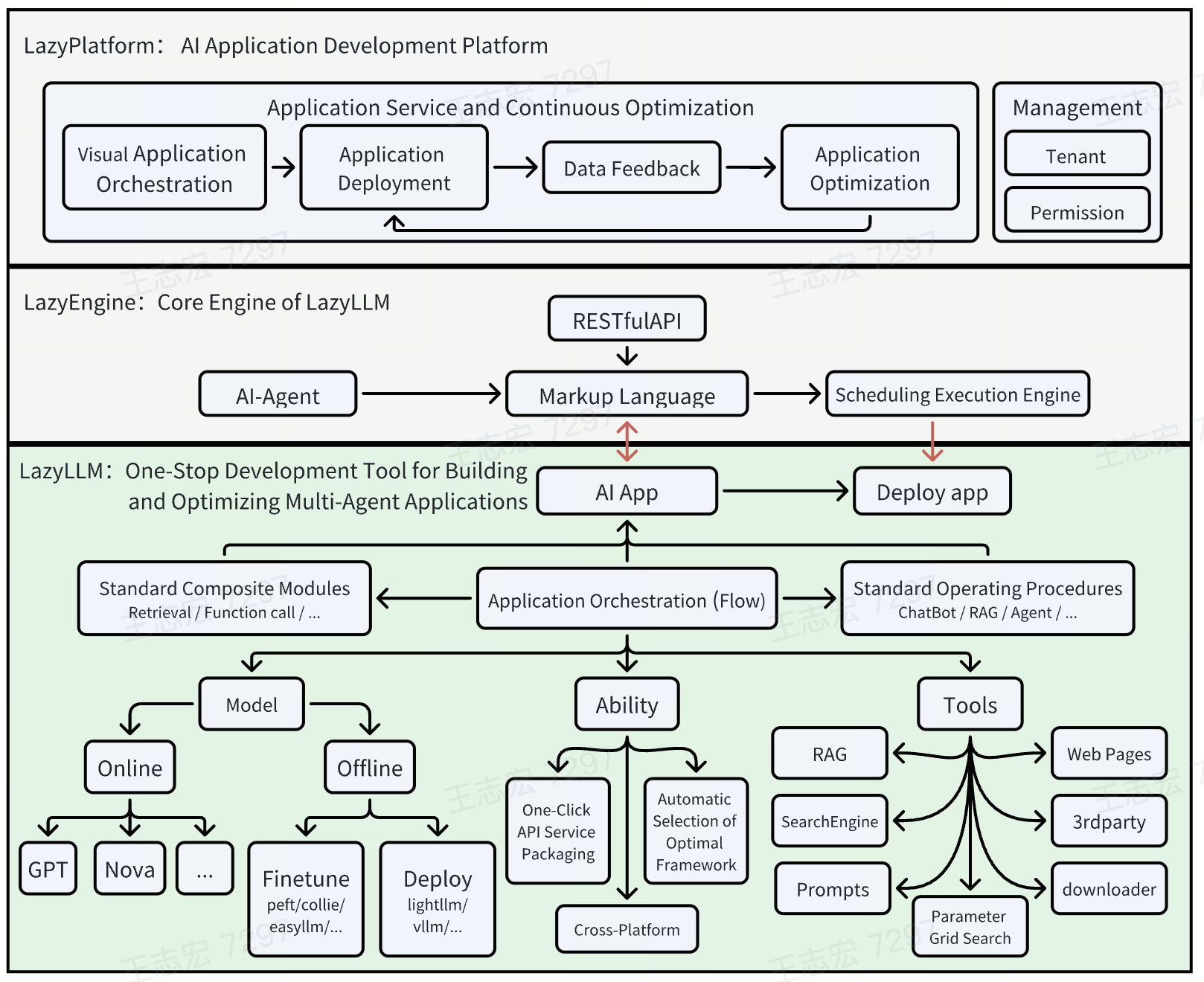

O LazyLLM é uma ferramenta de código aberto desenvolvida pela equipe do LazyAGI, com foco na simplificação do processo de desenvolvimento de aplicativos de modelos grandes de inteligência múltipla. Ela ajuda os desenvolvedores a criar rapidamente aplicativos complexos de IA e economizar tempo em configurações de engenharia tediosas por meio da implantação com um clique e de mecanismos de gateway leves. Seja você um desenvolvedor iniciante ou experiente, o LazyLLM oferece suporte: os novatos podem começar facilmente com módulos pré-construídos, enquanto os especialistas podem obter desenvolvimento avançado com recursos flexíveis de personalização. A ferramenta enfatiza a eficiência e a praticidade, integrando os componentes preferidos para garantir que os aplicativos prontos para produção sejam criados com o menor custo possível. Com mais de 1100 estrelas no GitHub e uma comunidade ativa, as atualizações são contínuas.

Lista de funções

- Implemente aplicativos complexos com um cliqueSuporte ao processo completo, desde a validação do protótipo até a liberação da produção, com configuração automatizada de serviços de submódulos.

- Compatibilidade entre plataformasAdaptação a servidores bare metal, máquinas de desenvolvimento, clusters Slurm e nuvens públicas sem alterações no código.

- Gerenciamento de fluxo de dados (Flow)Fornece processos predefinidos, como pipeline e paralelo, para organizar facilmente a lógica de aplicativos complexos.

- componente modularSuporte para personalização e extensões, integração de algoritmos de usuário ou ferramentas de terceiros.

- Mecanismo de gateway leveSimplifique a inicialização do serviço e a configuração de URL para um desenvolvimento mais eficiente.

- Oferece suporte ao desenvolvimento de várias inteligênciasCrie rapidamente aplicativos com vários agentes de IA adaptados a tarefas de modelos grandes.

Usando a Ajuda

Processo de instalação

O LazyLLM é um projeto de código aberto baseado em Python, cujo processo de instalação é simples e direto. Aqui estão as etapas detalhadas:

Preparação ambiental

- Verificação dos requisitos do sistemaVerifique se você tem o Python 3.8 ou superior instalado em seu dispositivo.

- Instalação do GitSe você não tiver o Git instalado, poderá usar uma ferramenta de linha de comando, como

apt-get install gittalvezbrew install git) Instalação. - Criação de um ambiente virtual (opcional, mas recomendado)::

python -m venv lazyllm_env source lazyllm_env/bin/activate # Linux/Mac lazyllm_env\Scripts\activate # Windows

Download e instalação

- Clonagem de um repositório do GitHub::

git clone https://github.com/LazyAGI/LazyLLM.git cd LazyLLM - Instalação de dependências::

- Execute o seguinte comando para instalar as bibliotecas necessárias:

pip install -r requirements.txt - Se você encontrar um conflito de dependências, tente atualizar o pip:

pip install --upgrade pip

- Execute o seguinte comando para instalar as bibliotecas necessárias:

- Verificar a instalação::

- Execute o código de amostra para confirmar a instalação bem-sucedida:

python -m lazyllm --version - Se o número da versão for retornado (por exemplo, v0.5), a instalação estará concluída.

- Execute o código de amostra para confirmar a instalação bem-sucedida:

Opcional: implantação do Docker

- O LazyLLM oferece suporte ao empacotamento de imagens com um clique do Docker:

- Instale o Docker (consulte o site oficial: https://docs.docker.com/get-docker/).

- Execute-o no diretório raiz do projeto:

docker build -t lazyllm:latest . docker run -it lazyllm:latest

Como usar

No centro do LazyLLM está a capacidade de criar rapidamente aplicativos de IA por meio da modularidade e do gerenciamento do fluxo de dados. Abaixo está um guia detalhado de como fazer para os principais recursos:

Recurso 1: Implemente aplicativos complexos com um clique

- procedimento::

- Preparação do arquivo de configuração do aplicativo: Crie o

config.yamlDefina módulos e serviços. Por exemplo:modules: - name: llm type: language_model url: http://localhost:8000 - name: embedding type: embedding_service url: http://localhost:8001 - Início dos serviços::

python -m lazyllm deploy - verificar statusSaída de registro de acesso para confirmar que todos os módulos estão funcionando corretamente.

- Preparação do arquivo de configuração do aplicativo: Crie o

- Descrição em destaqueEsse recurso conecta automaticamente os submódulos por meio de um gateway leve, eliminando a necessidade de configurar manualmente os URLs e tornando-o ideal para prototipagem rápida.

Recurso 2: Compatibilidade entre plataformas

- procedimento::

- Plataformas designadasAdicionar parâmetros à linha de comando, por exemplo:

python -m lazyllm deploy --platform slurm - Ambientes de comutaçãoNão há necessidade de alterar o código, basta substituir

--platformparâmetros (por exemplocloudtalvezbare_metal).

- Plataformas designadasAdicionar parâmetros à linha de comando, por exemplo:

- cenário do aplicativoOs desenvolvedores podem migrar sem problemas para a nuvem após o teste local para reduzir o esforço de adaptação.

Função 3: Gerenciamento de fluxo de dados (fluxo)

- procedimento::

- Definição do fluxo de dadosChamada de um fluxo predefinido em um script Python, como a criação de um pipeline:

from lazyllm import pipeline flow = pipeline( step1=lambda x: x.upper(), step2=lambda x: f"Result: {x}" ) print(flow("hello")) # 输出 "Result: HELLO" - Execução de processos complexosMultitarefa: Multitarefa em combinação com Parallel ou Diverter:

from lazyllm import parallel par = parallel( task1=lambda x: x * 2, task2=lambda x: x + 3 ) print(par(5)) # 输出 [10, 8]

- Definição do fluxo de dadosChamada de um fluxo predefinido em um script Python, como a criação de um pipeline:

- Descrição em destaqueO Flow oferece interfaces padronizadas para reduzir a duplicação da conversão de dados e apoiar o desenvolvimento colaborativo entre os módulos.

Função 4: Personalização de componentes modulares

- procedimento::

- Registro de funções personalizadas::

from lazyllm import register @register def my_function(input_text): return f"Processed: {input_text}" - Integração em aplicativosChamado na configuração do fluxo ou da implantação

my_function.

- Registro de funções personalizadas::

- Uso avançadoSuporte ao registro de comandos Bash para desenvolvimento de scripts híbridos.

Dicas e truques

- ajustar os componentes durante o teste: Adições em tempo de execução

--verbosepara visualizar o registro detalhado:python -m lazyllm deploy --verbose - Suporte à comunidadeVocê pode enviar feedback sobre os problemas do GitHub e a equipe responderá em tempo hábil.

- atualizaçãoPuxe o código mais recente regularmente:

git pull origin main

Com essas etapas, você pode começar a usar o LazyLLM rapidamente e criar aplicativos que variam de protótipos simples a modelos grandes em nível de produção.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...