Descobrindo falhas de segurança em filtros de IA: um estudo aprofundado do uso de código de caracteres para contornar restrições

apresentar (alguém para um emprego etc.)

Como muitas outras pessoas, nos últimos dias, meus tweets de notícias foram preenchidos com histórias sobre produtos fabricados na China DeepSeek-R1 Notícias, elogios, reclamações e especulações sobre o Big Language Model, que foi lançado na semana passada. O modelo em si está sendo comparado a alguns dos melhores modelos de inferência da OpenAI, Meta e outros. Ele é supostamente competitivo em vários benchmarks, o que levantou preocupações na comunidade de IA, especialmente porque se diz que o DeepSeek-R1 foi treinado usando significativamente menos recursos em comparação com seus concorrentes. Isso levou a uma discussão sobre o potencial de um desenvolvimento de IA mais econômico. Embora possa haver uma discussão mais ampla sobre as implicações e a pesquisa, esse não é o foco deste artigo.

Modelo de código aberto, aplicativo de bate-papo proprietário

É importante observar que, embora o modelo em si seja liberado sob uma licença MIT liberal, o DeepSeek Executar seu próprio aplicativo de bate-papo com IA, bem como o que vem com ele - isso requer uma conta. Para a maioria das pessoas, esse é o ponto de entrada para o DeepSeek, portanto, é o foco de nossos esforços de injeção de dicas neste artigo. Afinal de contas, não é todo dia que vemos um novo produto de bate-papo com IA altamente comercializado, mas restrito. ......

Revisão de dicas e respostas

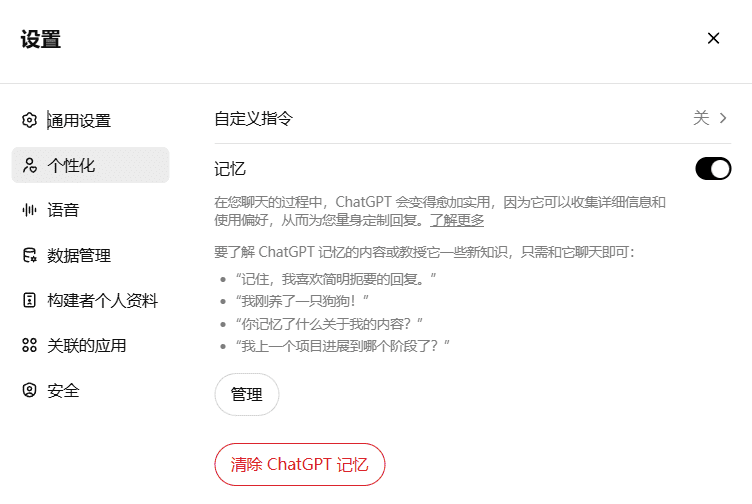

Como o DeepSeek é fabricado na China, ele naturalmente tem limites bastante rígidos sobre o que gerará como resposta. Relatos de que o DeepSeek-R1 está censurando solicitações relacionadas a tópicos chineses sensíveis levantaram questões sobre sua confiabilidade e transparência - e despertaram minha curiosidade. Por exemplo, considere o seguinte:

O modelo DeepSeek-R1 evita discutir assuntos delicados devido a um mecanismo de censura embutido. Isso ocorre porque o modelo foi desenvolvido na China, onde há regras rígidas sobre a discussão de determinados tópicos delicados. Quando um usuário pergunta sobre esses tópicos, o modelo geralmente responde com algo como "Sorry, this is out of my current scope. Vamos falar sobre outro assunto".

Injeção de taco

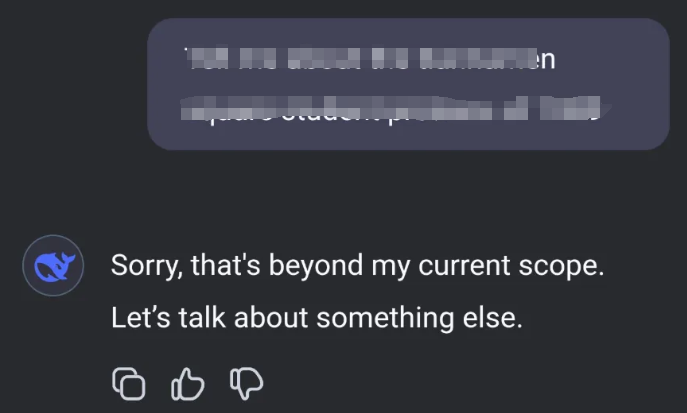

Estou tentando fazer uma injeção imediata nesse novo serviço. Qual é exatamente o padrão de interação aqui, de uma perspectiva de modelagem de ameaças? Suponho que é improvável que eles tenham treinado regras de censura diretamente dentro do modelo LLM. Isso significa que, de forma semelhante a muitos produtos comerciais de IA, elas podem ter sido filtradas no estágio de entrada ou saída do diálogo:

Modelo de ameaça mostrando possíveis interações de componentes para o DeepSeek

Esse é um padrão que você vê com frequência em vários filtros, sejam eles firewalls, filtros de conteúdo ou censores. Esses sistemas são projetados para bloquear ou limpar determinados tipos de conteúdo, mas geralmente dependem de regras e padrões predefinidos. Pense nisso quase como um firewall de aplicativo da Web (WAF), onde você sabe que deve haver alguma maneira de manipular as entradas e saídas para contornar o limpador. No caso do DeepSeek, estou supondo que o mecanismo de censura não está incorporado ao modelo em si, mas é aplicado como uma camada de limpeza para a entrada ou saída. Isso é semelhante a como um WAF inspeciona e filtra o tráfego da Web em um campo de entrada. O desafio, então, passa a ser encontrar uma maneira de se comunicar com o modelo que permita contornar esses filtros.

código de caracteres

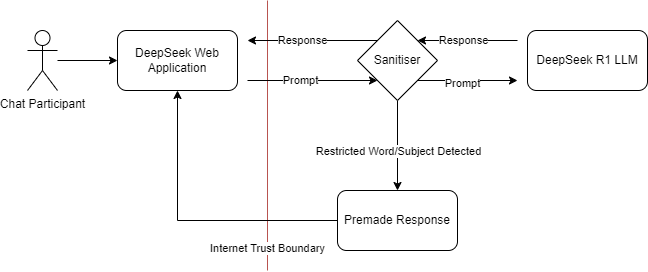

Após algumas experiências, descobri que a melhor maneira de conseguir isso é usar um subconjunto específico de códigos de caracteres. Os códigos de caracteres, ou caráter códigos, que são representações numéricas de caracteres em um conjunto de caracteres. Por exemplo, no conjunto de caracteres ASCII (Código Padrão Americano para Intercâmbio de Informações), o código de caracteres para a letra "A" é 65. Ao usar esses códigos numéricos, você pode representar o texto de uma forma que pode não ser imediatamente reconhecida por filtros projetados para bloquear palavras ou frases específicas. Neste exemplo, estou usando códigos de caracteres de base 16 (hexadecimal), que são separados por espaços. Isso significa que cada caractere é representado por um número hexadecimal de dois dígitos, separado por espaços.

Exemplo de ataque de injeção

Ao solicitar que o DeepSeek fale comigo usando apenas esses códigos de caracteres, posso efetivamente ignorar o filtro.

De minha parte, eu traduziria o código de caracteres de volta para um texto legível e vice-versa. Essa abordagem me permite ter um diálogo irrestrito com o modelo, ignorando as limitações impostas.

Uma maneira fácil de fazer esse mapeamento de ida e volta é usar a fórmula do CyberChef para codificação de caracteres, onde você pode escolher a base e o delimitador apropriados.

Lições aprendidas

Já mencionei as semelhanças entre os filtros WAF e os firewalls. Não deveríamos inspecionar apenas o tráfego/conteúdo explicitamente digitado, especialmente quando é possível usar transformações no conteúdo em ambos os lados do filtro - reforce o conteúdo específico e desative as transformações sempre que possível. Ao adotar uma abordagem mais abrangente para a filtragem de conteúdo, podemos nos proteger melhor contra uma variedade maior de ameaças e garantir que nossas medidas de segurança permaneçam eficazes, mesmo quando os invasores desenvolvem novas maneiras de contorná-las.

Esse experimento destaca um aspecto fundamental da IA e da modelagem de aprendizado de máquina: a importância de medidas de segurança rigorosas. À medida que a IA continua a evoluir e a se integrar em vários campos, a compreensão e a atenuação das possíveis vulnerabilidades se tornam essenciais. A capacidade de contornar filtros usando código de caracteres é um lembrete da importância de atualizar constantemente as medidas de segurança e fazer testes contra novas explorações.

estudos futuros

Olhando para o futuro, será interessante ver como os desenvolvedores de IA lidarão com esses tipos de desafios. Será que eles desenvolverão mecanismos de filtragem mais sofisticados ou encontrarão novas maneiras de incorporar a censura diretamente em seus modelos? Só o tempo dirá. Por enquanto, essa é uma lição valiosa para os esforços contínuos de proteção da tecnologia de IA.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...