Recursos do DeepSeek-R1 em detalhes, com relatório de avaliação chinês

leitura rápida

Experiência:DeepSeek Site oficial: chat.deepseek.com Converse com o DeepSeek-R1 e ative o botão "Deep Thinking" (Pensamento profundo). Visite API compatível com o formato OpenAI .

Bem-estar:Implementando o modelo de código aberto DeepSeek-R1 on-line com potência de GPU gratuita eDistribuição de 1001 créditosTP4T DeepSeek-R1eAs 5 principais plataformas de inferência de IA que usam uma versão completa do DeepSeek-R1 gratuitamente

Recorrência:Tentativas recentes de reproduzir Há vários projetos para o DeepSeek-R1, portanto, fique de olho nos artigos a seguir:TinyZero: uma réplica de baixo custo do efeito epifânico do DeepSeeK-R1 Zero eOpen R1: o rosto abraçado replica o processo de treinamento do DeepSeek-R1 eReplicando o DeepSeek-R1: 8 mil exemplos matemáticos ajudam modelos pequenos a obter avanços na inferência por meio do aprendizado por reforço E tem mais:R1 Overthinker: forçando os modelos R1 do DeepSeek a pensar mais .

Resumo:Comprimento do contexto: 128K, US$ 2,19/por milhão de tokens de saída (Poundland no mundo dos grandes modelos), desempenho equivalente ao do OpenAI-o1, todos os modelos de código aberto livremente destilados e usados comercialmente, funcionalidade de front-end criativa para escrever

Modelo básico: Tanto o DeepSeek-R1-Zero quanto o DeepSeek-R1 são treinados com base no DeepSeek-V3-Base, e o DeepSeek-R1 é aprimorado por uma pequena quantidade de dados CoT longos, o que torna a saída mais estruturada e parcimoniosa.

Modelos de destilação (aprimoramento geral dos recursos de miniaturas de código aberto existentes): Destilando o DeepSeek-R1 em vários modelos menores que são ( Ollama (disponível para download)

Qwen2.5-Math-1.5B, Qwen2.5-Math-7B, Qwen2.5-14B, Qwen2.5-32B, Llama-3.1-8B, Llama-3.3-70B-Instruct

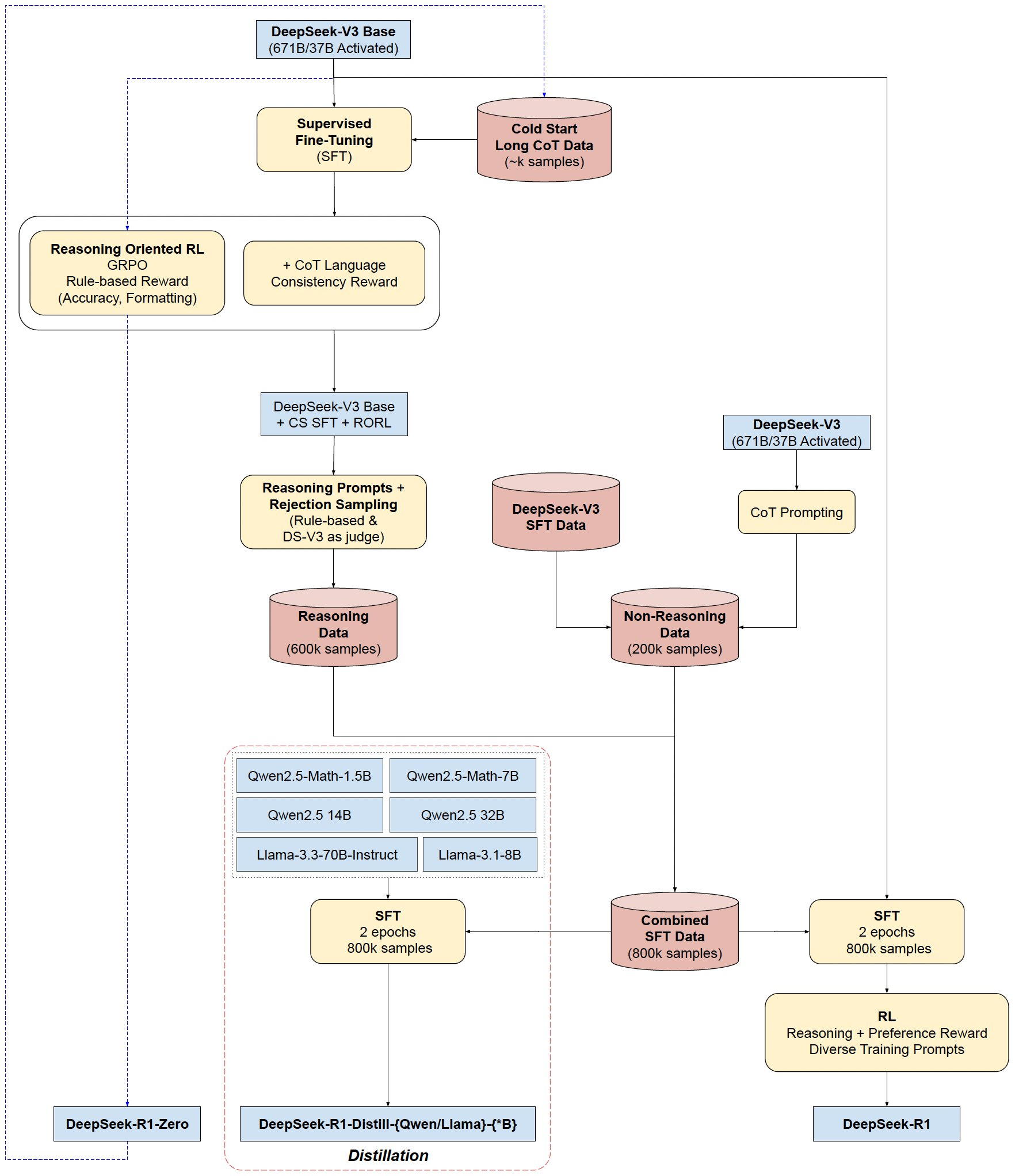

Fluxo de treinamento do DeepSeek-R1(-Zero)

- Partida a frio: ajuste fino no exemplo de CoT

- Aprendizado por reforço de raciocínio: adição de recompensas de consistência linguística

- Geração de dados: criados 80 10.000 amostras de treinamento

- Aprendizagem por reforço final: competências equilibradas (tanto de raciocínio quanto genéricas) por meio de feedback combinado

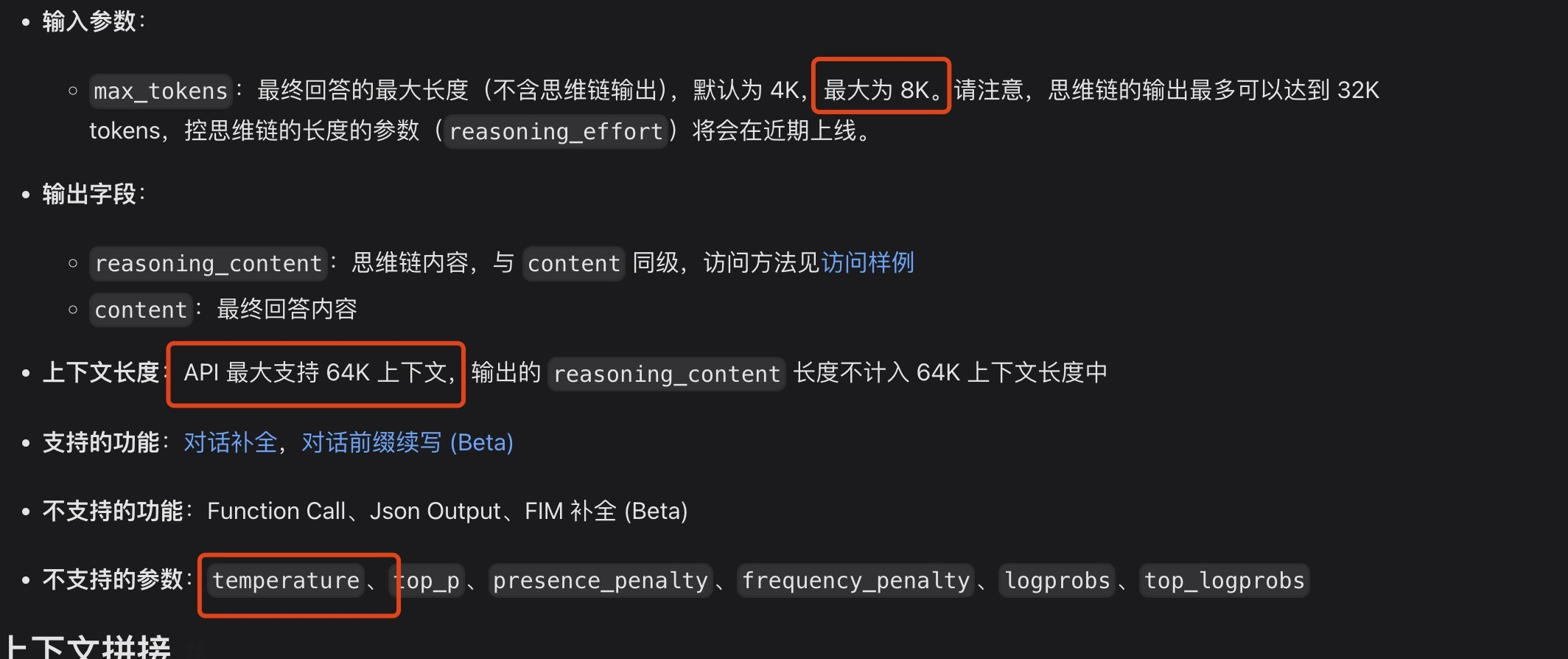

problema, o comprimento do contexto da API pode não ser suficiente na programação

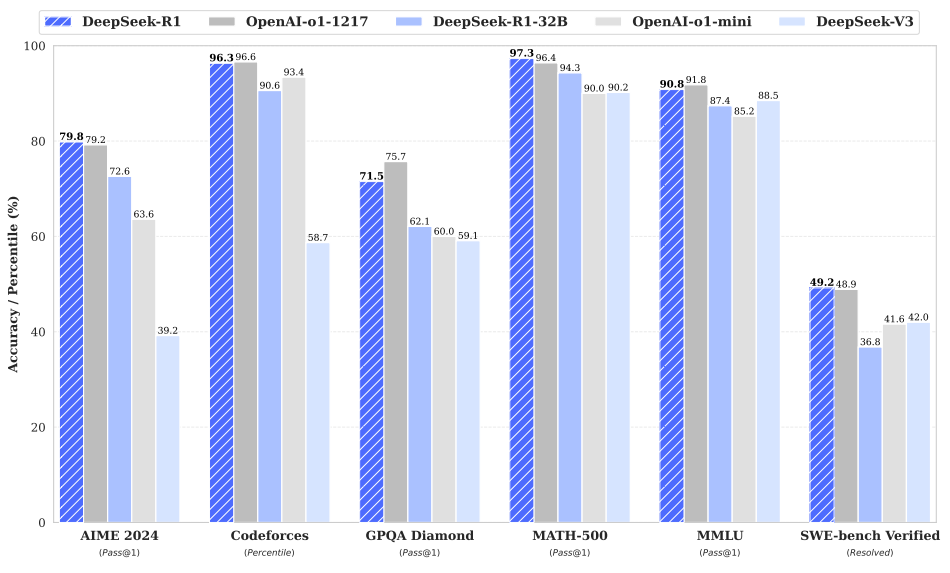

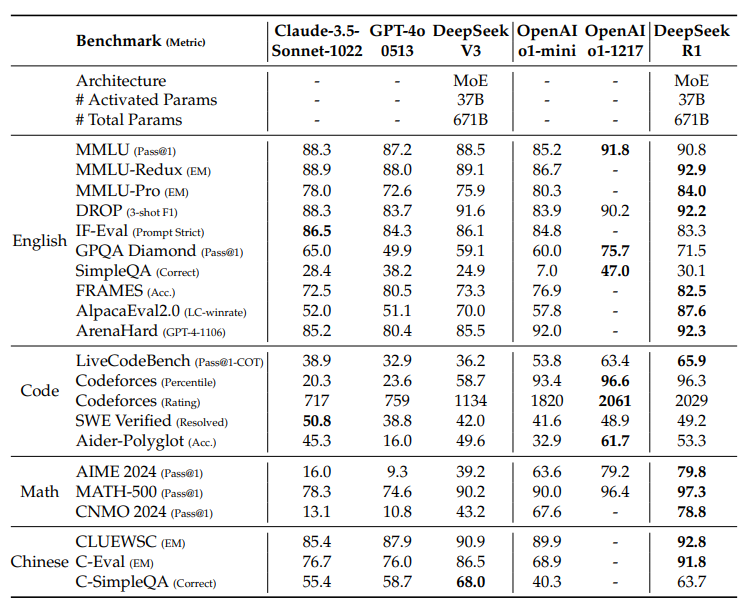

Avaliação de benchmark

Fortes habilidades de raciocínio:

Tem bom desempenho em problemas de matemática, alcançando desempenho comparável ao do OpenAI-01-1217. Obteve uma pontuação surpreendentemente alta (97,3%) no benchmark MATH-500.

Bom desempenho em tarefas de algoritmo de codificação, como Codeforces e LiveCodeBench.

Demonstrar recursos sólidos em tarefas que exigem raciocínio complexo, como FRAMES.

Fortes recursos de uso geral:

Excelente desempenho em benchmarks baseados em conhecimento, como MMLU, MMLU-Pro e GPQA Diamond.

Também se destacou na escrita, respondendo a perguntas de campo aberto e em uma variedade de outras tarefas.

Excelentes taxas de vitória de controle de comprimento em benchmarks como o AlpacaEval 2.0 e o ArenaHard, demonstrando que ele lida de forma inteligente com consultas não orientadas para exames.

Capacidade de gerar resumos concisos e evitar preconceitos quanto ao tamanho.

Boa legibilidade:Com dados de cold-start e um design específico no processo de treinamento, a saída do DeepSeek-R1 é mais fácil de ler, usando o formato e a estrutura adequados.

Multilinguismo:Embora atualmente seja otimizado principalmente para chinês e inglês, ele demonstra alguma capacidade de lidar com consultas em vários idiomas.

Capacidade de seguir instruções:Ele teve um bom desempenho no benchmark IF-Eval, demonstrando sua capacidade de entender e seguir instruções.

Capacidade autoevolutiva:Por meio da aprendizagem por reforço, os modelos podem aprender de forma autônoma e aprimorar suas habilidades de raciocínio, além de serem capazes de lidar com problemas complexos aumentando seu tempo de raciocínio.

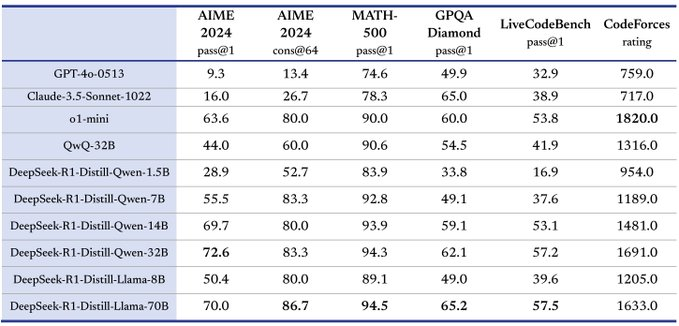

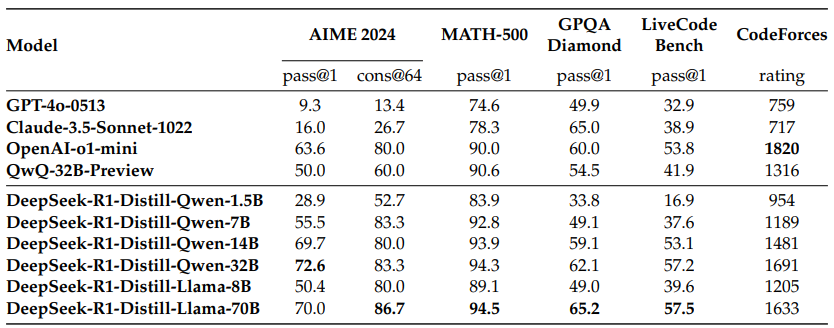

Excelente potencial de destilação:O DeepSeek-R1 pode ser usado como um modelo de professor para destilar o poder de inferência em modelos menores, e os modelos destilados têm excelente desempenho, por exemplo, o DeepSeek-R1-Distill-Qwen-32B, que supera significativamente os outros modelos em vários benchmarks.

Sobre os recursos de programação local

Se você acha que a v3 é boa o suficiente para programação, qual é o modelo de destilação alternativo para desktop? Em comparação com o DeepSeek V3, qual modelo de destilação é comparável? De acordo com a pontuação do LiveCodeBench, o DeepSeek V3 tem pontuação de 42,2 e o modelo de destilação Qwen 14B tem pontuação de 53,1, que tem desempenho comparável e um tamanho de classe relativamente desktop para poder ser executado, e é recomendado usar o 14B no desktop.

DeepSeek-R1: Motivando o raciocínio LLM por meio do aprendizado por reforço.

Publicado por DeepSeek-AI

Original: https://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf

resumos

Apresentamos nossos modelos de inferência de primeira geração, DeepSeek-R1-Zero e DeepSeek-R1. O DeepSeek-R1-Zero, um modelo treinado por aprendizado por reforço (RL) em larga escala sem uma etapa inicial de ajuste fino supervisionado (SFT), demonstra inferência superior. Com a RL, o DeepSeek-R1-Zero surge naturalmente com muitos comportamentos de inferência poderosos e interessantes. No entanto, ele também encontra alguns desafios, como a baixa legibilidade e a mistura de idiomas. Para resolver esses problemas e melhorar ainda mais o desempenho da inferência, apresentamos o DeepSeek-R1, que combina treinamento em vários estágios e dados de início frio antes da RL. O DeepSeek-R1 atinge um desempenho comparável ao do OpenAI-01-1217 em tarefas de inferência. Para apoiar a comunidade de pesquisa, abrimos o código-fonte do DeepSeek-R1-Zero, do DeepSeek-R1 e de seis modelos densos (1,5B, 7B, 8B, 14B, 32B, 70B) com base nos refinamentos do Qwen e do Llama.

Fig. 1 | Desempenho de benchmark do DeepSeek-R1.

diretório (no disco rígido do computador)

1 Introdução

1.1 Contribuições

1.2 Resumo dos resultados da avaliação

2 Metodologia

2.1 Visão geral

2.2 DeepSeek-R1-Zero: aprendizado por reforço baseado em modelos fundamentais

2.2.1 Algoritmo de aprendizado aprimorado

2.2.2 Modelagem de incentivos

2.2.3 Modelos de treinamento

2.2.4 Desempenho do DeepSeek-R1-Zero, processos autoevolutivos e momentos de epifania

2.3 DeepSeek-R1: Aprendizado por reforço com um início frio

2.3.1 Partida a frio

2.3.2 Aprendizado por reforço orientado por raciocínio

2.3.3 Rejeição da amostragem e supervisão do ajuste fino

2.3.4 Aprendizado por reforço para todos os cenários

2.4 Destilação: aumento de modelos pequenos com poder de raciocínio

3 experimentos

3.1 Avaliação do DeepSeek-R1

3.2 Avaliação da modelagem de destilação

4 Discussão

4.1 Destilação vs. aprendizado intensivo

4.2 Tentativas fracassadas

5 Conclusões, limitações e trabalhos futuros

1. introdução

Nos últimos anos, os modelos de linguagem em grande escala (LLMs) passaram por uma rápida iteração e desenvolvimento (Anthropic, 2024; Google, 2024; OpenAI, 2024a), fechando gradualmente a lacuna que leva à inteligência geral artificial (AGI).

Recentemente, o pós-treinamento tornou-se uma parte importante do processo completo de treinamento. Foi demonstrado que ele melhora a precisão das tarefas de raciocínio, alinha-se com os valores sociais e adapta-se às preferências do usuário, exigindo relativamente poucos recursos computacionais em relação ao pré-treinamento. Em termos de capacidade de raciocínio, a família de modelos o1 da OpenAI (OpenAI, 2024b) introduz, pela primeira vez, o escalonamento ao raciocinar, aumentando o comprimento do processo de raciocínio de cadeia de pensamento. Essa abordagem levou a avanços significativos em uma variedade de tarefas de raciocínio, como raciocínio matemático, de codificação e científico. No entanto, o desafio do dimensionamento eficaz do tempo de teste continua sendo uma questão em aberto para a comunidade de pesquisa. Alguns trabalhos anteriores exploraram várias abordagens, incluindo modelos de recompensa baseados em processos (Lightman et al., 2023; Uesato et al., 2022; Wang et al., 2023), aprendizado por reforço (Kumar et al., 2024) e algoritmos de busca, como a busca em árvore Monte-Carlo e a busca em pacote (Feng et al., 2024; Trinh et al., 2024). 2024; Trinh et al.) No entanto, nenhum desses métodos conseguiu obter um desempenho de inferência generalizada comparável à família de modelos o1 da OpenAI.

Neste artigo, damos o primeiro passo para aprimorar os recursos de raciocínio dos modelos de linguagem usando a aprendizagem por reforço (RL) pura. Nosso objetivo é explorar o potencial do LLM para desenvolver recursos de raciocínio sem nenhum dado supervisionado, concentrando-nos na autoevolução por meio de um processo de RL puro. Especificamente, usamos o DeepSeek-V3-Base como modelo de base e o GRPO (Shao et al., 2024) como estrutura de RL para melhorar o desempenho do modelo no raciocínio. Durante o processo de treinamento, o DeepSeek-R1-Zero emerge naturalmente com muitos comportamentos de inferência poderosos e interessantes. Após milhares de etapas de RL, o DeepSeek-R1-Zero apresenta excelente desempenho em benchmarks de inferência. Por exemplo, o AIME 2024的pass@1得分从15.6%提高到71.0% e, por votação majoritária, a pontuação é melhorada ainda mais para 86,7%, atingindo o nível de desempenho do OpenAI-01-0912.

No entanto, o DeepSeek-R1-Zero enfrenta desafios como baixa legibilidade e mistura de idiomas. Para resolver esses problemas e melhorar ainda mais o desempenho da inferência, apresentamos o DeepSeek-R1, que combina uma pequena quantidade de dados de cold-start com um processo de treinamento em vários estágios. Especificamente, primeiro coletamos milhares de dados de cold-start para fazer o ajuste fino do modelo DeepSeek-V3-Base. Depois disso, executamos a RL orientada por inferência semelhante ao DeepSeek-R1-Zero. À medida que o processo de RL se aproxima da convergência, criamos novos dados de SFT por amostragem de rejeição de pontos de verificação de RL, combinamos esses dados com dados supervisionados do DeepSeek-V3 nos domínios de escrita, questionamento factual e autoconsciência e, em seguida, treinamos novamente o modelo DeepSeek- V3-Base. Depois de fazer o ajuste fino com os novos dados, esse ponto de verificação passa por um processo de RL adicional, que leva em conta as dicas de todos os cenários. Após essas etapas, obtemos um ponto de verificação chamado DeepSeek-R1, cujo desempenho é comparável ao do OpenAI-01-1217.

Além disso, exploramos a destilação do DeepSeek-R1 para modelos densos menores. Usando o Qwen 2.5-32B (Qwen, 2024b) como modelo de base, a destilação diretamente do DeepSeek-R1 supera a aplicação da RL sobre ele, sugerindo que os padrões de inferência encontrados no modelo de base maior são essenciais para melhorar a inferência. Abrimos o código aberto da família de modelos Qwen e Llama (Dubey et al., 2024) para destilação. Notavelmente, nosso modelo destilado de 14B supera substancialmente o QwQ-32B-Preview (Qwen, 2024a) de código aberto de última geração, e os modelos destilados de 32B e 70B estabelecem um novo recorde de benchmarks de raciocínio em modelos densos.

1.1 Contribuições

Pós-treinamento: aprendizado por reforço em larga escala com base em modelos básicos

- Aplicamos o aprendizado por reforço (RL) diretamente ao modelo subjacente sem depender do ajuste fino supervisionado (SFT) como uma etapa preliminar. Essa abordagem permite que o modelo explore a Cadeia de Pensamento (CoT) para solucionar problemas complexos, levando ao desenvolvimento do DeepSeek-R1-Zero. O DeepSeek-R1-Zero demonstra a capacidade de autovalidar, refletir e desenvolver a CoT, o que representa um marco importante para a comunidade de pesquisa. Notavelmente, este é o primeiro estudo público a validar que a capacidade de raciocínio do LLM pode ser motivada por RL pura sem a necessidade de SFT.

- Descrevemos o processo usado para desenvolver o DeepSeek-R1. O processo consiste em duas fases de RL destinadas a descobrir padrões de raciocínio aprimorados e alinhá-los com as preferências humanas, e duas fases de SFT que servem como sementes para os recursos de raciocínio e não raciocínio do modelo. Acreditamos que o processo beneficiará o setor com a criação de modelos melhores.

Destilação: modelos pequenos podem ser poderosos

- Demonstramos que os padrões de inferência de modelos grandes podem ser destilados em modelos menores para obter melhor desempenho em comparação com os padrões de inferência descobertos por meio de RL em modelos pequenos. O DeepSeek-R1 de código aberto e sua API beneficiarão a comunidade de pesquisa na destilação de modelos pequenos melhores no futuro.

- Usando dados de inferência gerados pelo DeepSeek-R1, ajustamos vários modelos densos amplamente usados na comunidade de pesquisa. Os resultados da avaliação mostram que os modelos densos pequenos destilados têm um bom desempenho em benchmarks. O DeepSeek-R1-Distill-Qwen-7B atinge uma pontuação de 55,51 TP3T no AIME 2024, superando o QwQ-32B-Preview. obteve 72,61 TP3T no AIME 2024, 94,31 TP3T no MATH-500 e 57,21 TP3T no LiveCodeBench. Esses resultados são significativamente melhores do que os modelos de código aberto anteriores e comparáveis ao o1-mini. Abrimos para a comunidade os pontos de verificação de destilação 1.5B, 7B, 8B, 14B, 32B e 70B com base nas séries Qwen2.5 e Llama3.

1.2 Resumo dos resultados da avaliação

- Tarefas de inferência:(1) O DeepSeek-R1 obteve uma pontuação pass@1 de 79,81 TP3T no AIME 2024, superando ligeiramente o desempenho do OpenAI-o1-1217. No MATH-500, ele obteve uma pontuação impressionante de 97,31 TP3T, que é comparável ao desempenho do OpenAI-o1-1217 e significativamente melhor do que outros modelos. (2) Em tarefas relacionadas à codificação, o DeepSeek-R1 demonstrou nível de especialista na tarefa de competição de código, pois obteve uma classificação Elo de 2.029 no Codeforces, superando o desempenho do participante humano de 96,31 TP3T nessa competição. Para tarefas relacionadas à engenharia, o DeepSeek-R1 teve um desempenho ligeiramente melhor do que o DeepSeek-V3, que ajuda os desenvolvedores a trabalhar no mundo real.

- **** conhecimento: em benchmarks como MMLU, MMLU-Pro e GPQA Diamond, o DeepSeek-R1 obtém resultados excepcionais, superando significativamente o DeepSeek-V3, com pontuação de 90,8% no MMLU, 84,0% no MMLU-Pro e GPQA Diamond Embora seu desempenho seja ligeiramente inferior ao do OpenAI-01-1217 nesses benchmarks, o DeepSeek-R1 supera os outros modelos de código fechado, demonstrando sua vantagem competitiva em tarefas educacionais. No benchmark factual SimpleQA, o DeepSeek-R1 supera o DeepSeek-V3, demonstrando sua capacidade de lidar com consultas baseadas em fatos. Uma tendência semelhante é observada no OpenAI-o1 além do 4o para esse benchmark.

- Outros: o DeepSeek-R1 também teve bom desempenho em várias tarefas, incluindo redação criativa, resposta a perguntas gerais, edição, resumo e outras. Ele alcançou uma taxa de vitória de controle de comprimento de 87,61 TP3T no AlpacaEval 2.0 e 92,31 TP3T no ArenaHard, demonstrando sua forte capacidade de processar de forma inteligente consultas não voltadas para exames. Além disso, o DeepSeek-R1 tem bom desempenho em tarefas que exigem compreensão de contexto longo, superando significativamente o DeepSeek-V3 no teste de benchmark de contexto longo.

2. metodologia

2.1 Visão geral

Trabalhos anteriores se basearam muito em grandes quantidades de dados supervisionados para melhorar o desempenho do modelo. Neste estudo, demonstramos que a inferência pode ser significativamente aprimorada pelo aprendizado por reforço (RL) em larga escala, mesmo sem usar o ajuste fino supervisionado (SFT) como um cold-start. Além disso, o desempenho pode ser aprimorado ainda mais com a inclusão de uma pequena quantidade de dados de cold-start. Nas seções a seguir, apresentamos (1) DeepSeek-R1-Zero, que aplica RL diretamente ao modelo básico sem nenhum dado SFT, e (2) DeepSeek-R1, que aplica RL a partir de pontos de verificação ajustados com milhares de exemplos longos de Chain of Thoughts (CoT) e (3) destilando o poder de inferência do DeepSeek-R1 em modelos pequenos e densos.

2.2 DeepSeek-R1-Zero: aprendizado por reforço baseado em modelos fundamentais

O aprendizado por reforço demonstrou uma eficácia significativa em tarefas de inferência, conforme demonstrado em nosso trabalho anterior (Shao et al., 2024; Wang et al., 2023). No entanto, essas tarefas dependem muito de dados supervisionados, cuja coleta consome muito tempo. Nesta seção, exploramos o potencial do LLM para desenvolver habilidades de raciocínio sem nenhum dado supervisionado, concentrando-nos na autoevolução por meio de um processo de aprendizagem por reforço puro. Começamos com uma breve visão geral do nosso algoritmo de aprendizagem por reforço e, em seguida, apresentamos alguns resultados interessantes, que esperamos que forneçam percepções valiosas para a comunidade.

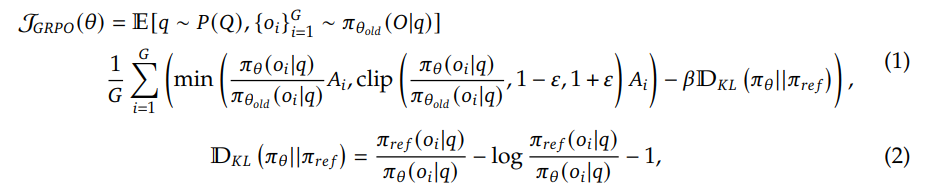

Otimização da estratégia relativa do grupo Para economizar o custo de treinamento da RL, empregamos a otimização da estratégia relativa do grupo (GRPO) (Shao et al., 2024), que abandona o modelo crítico, que geralmente tem o mesmo tamanho do modelo de estratégia e, em vez disso, estima a linha de base a partir das pontuações do grupo. Especificamente, para cada problema q, o GRPO coleta amostras de um conjunto de saídas {o1, o2,..., oG} da estratégia antiga πθold e, em seguida, otimiza o modelo de estratégia πθ maximizando o seguinte objetivo:

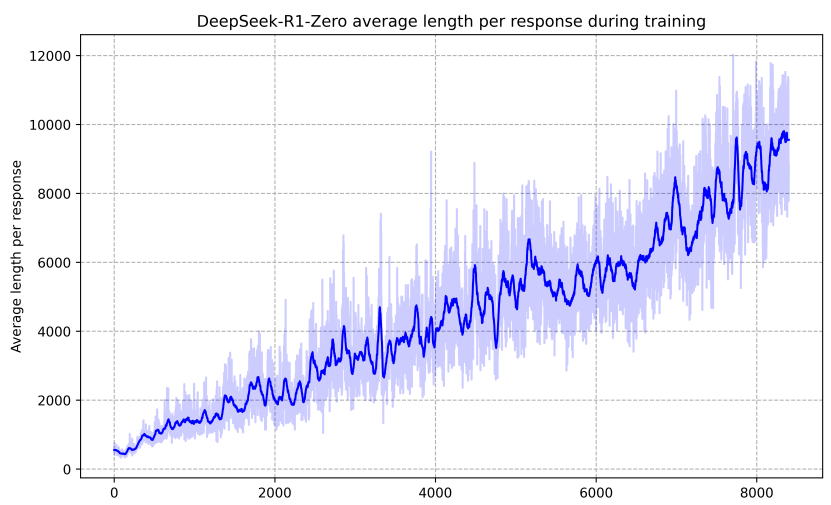

em que ɛ e β são hiperparâmetros e Ai é a dominância, usando os prêmios correspondentes aos resultados dentro de cada grupo {r1,r2, . . . , rG} para o cálculo:

A recompensa é a fonte do sinal de treinamento, que determina a direção de otimização da RL. Para treinar o DeepSeek-R1-Zero, usamos um sistema de recompensas baseado em regras que consiste nos dois tipos principais de recompensas a seguir:

- Recompensas de precisão: os modelos de recompensa de precisão avaliam se uma resposta está correta. Por exemplo, para problemas de matemática com resultados determinísticos, o modelo precisa fornecer a resposta final em um formato especificado (por exemplo, dentro de uma caixa) para que a verificação da correção baseada em regras possa ser realizada de forma confiável. Da mesma forma, para problemas de LeetCode, o compilador pode ser usado para gerar feedback com base em casos de teste predefinidos.

- Recompensa de formato: além do modelo de recompensa de precisão, usamos um modelo de recompensa de formato que força o modelo a colocar o processo de pensamento entre os rótulos '' e ''.

Não usamos modelos de recompensa neural de resultado ou de processo no desenvolvimento do DeepSeek-R1-Zero porque descobrimos que os modelos de recompensa neural podem sofrer de hacking de recompensa durante o aprendizado de reforço em larga escala e que o retreinamento do modelo de recompensa exige recursos de treinamento adicionais, o que pode complicar o processo geral de treinamento.

Para treinar o DeepSeek-R1-Zero, primeiro projetamos um modelo simples que instrui o modelo básico a seguir as instruções que especificamos. Conforme mostrado na Tabela 1, esse modelo exige que o DeepSeek-R1-Zero gere primeiro o processo de raciocínio e depois a resposta final. Limitamos intencionalmente as restrições a esse formato estrutural para evitar qualquer viés específico do conteúdo, como reforçar o raciocínio reflexivo ou promover estratégias específicas de solução de problemas, para garantir que pudéssemos observar com precisão a progressão natural do modelo por meio do processo de aprendizado por reforço (RL).

用户与助手之间的对话。用户提出一个问题,助手解决该问题。

助手首先在脑海中思考推理过程,然后为用户提供答案。

推理过程和答案分别用 <think> </think> 和 <answer> </answer> 标签括起来,即:

<think> 此处为推理过程 </think>

<answer> 此处为答案 </answer>。

用户:提示。助手:

Tabela 1 | Modelos para DeepSeek-R1-Zero. Durante o treinamento, ochamar a atenção para algoserá substituído por um problema de raciocínio específico.

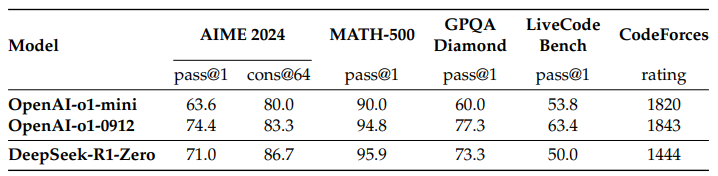

Desempenho do DeepSeek-R1-Zero A Figura 2 mostra a trajetória de desempenho do DeepSeek-R1-Zero no benchmark AIME 2024 durante o treinamento de aprendizado por reforço (RL). Conforme mostrado, o desempenho do DeepSeek-R1-Zero apresenta um aprimoramento constante e consistente à medida que o treinamento de RL progride. Notavelmente, a pontuação média de pass@1 do AIME 2024 mostra um crescimento significativo, saltando de um TP3T inicial de 15,61 para um impressionante TP3T de 71,01, atingindo um nível de desempenho comparável ao OpenAI-01-0912. Essa melhoria significativa destaca a eficácia do nosso algoritmo de RL na otimização do desempenho do modelo.

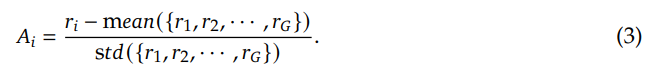

A Tabela 2 fornece uma análise comparativa do DeepSeek-R1-Zero e do modelo o1-0912 da OpenAI em vários benchmarks relacionados à inferência. Os resultados mostram que o RL faz

Tabela 2 | Comparação dos modelos DeepSeek-R1-Zero e OpenAI o1 em benchmarks relacionados à inferência.

Fig. 2 | Precisão AIME do DeepSeek-R1-Zero durante o treinamento. Para cada problema, coletamos amostras de 16 respostas e calculamos a precisão média geral para garantir uma avaliação estável.

O DeepSeek-R1-Zero consegue uma inferência poderosa sem nenhum ajuste fino supervisionado dos dados. Essa é uma conquista digna de nota, pois destaca a capacidade do modelo de aprender e generalizar com eficiência somente por meio da RL. Além disso, o desempenho do DeepSeek-R1-Zero pode ser aprimorado ainda mais com a aplicação de votação por maioria. Por exemplo, ao usar a votação por maioria nos benchmarks AIME, o desempenho do DeepSeek-R1-Zero melhora de 71,01 TP3T para 86,71 TP3T, superando assim o desempenho do OpenAI-01-0912. O fato de o DeepSeek-R1-Zero alcançar um desempenho tão competitivo com e sem votação majoritária destaca seus sólidos recursos subjacentes e seu potencial para desenvolvimento adicional em tarefas de raciocínio.

Processo autoevolutivo do DeepSeek-R1-Zero O processo autoevolutivo do DeepSeek-R1-Zero é uma demonstração fascinante de como a RL pode levar os modelos a melhorar seu raciocínio de forma autônoma. Ao iniciar a RL diretamente do modelo básico, podemos monitorar de perto o progresso do modelo sem estarmos sujeitos a uma fase de ajuste fino supervisionado. Essa abordagem oferece uma visão clara de como o modelo evolui ao longo do tempo, especialmente em termos de sua capacidade de lidar com tarefas de raciocínio complexas.

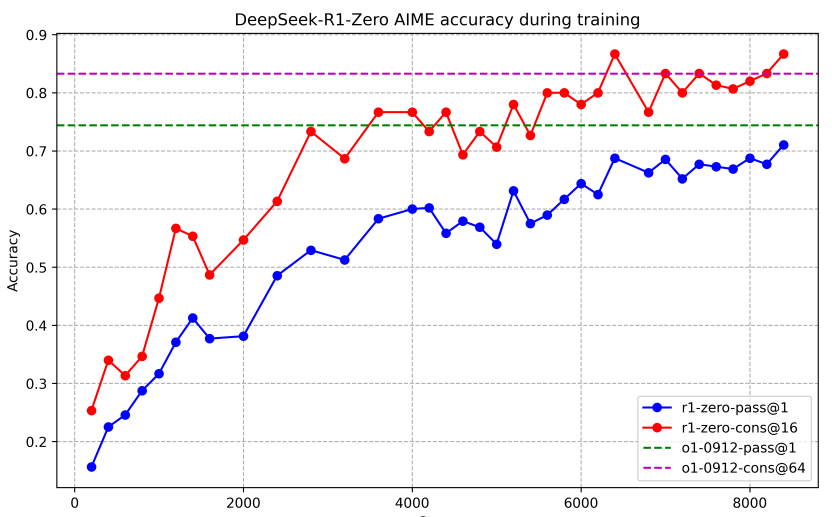

Conforme mostrado na Figura 3, o tempo de raciocínio do DeepSeek-R1-Zero mostra um aprimoramento contínuo durante todo o processo de treinamento. Esse aprimoramento não é resultado de ajuste externo, mas sim de um desenvolvimento intrínseco do modelo. O DeepSeek-R1-Zero naturalmente ganha a capacidade de resolver tarefas de raciocínio cada vez mais complexas utilizando computação de tempo de teste estendida. Essa computação varia da geração de centenas a milhares de tokens de inferência, permitindo que o modelo explore e refine seus processos de pensamento com maior profundidade.

Um dos aspectos mais marcantes dessa autoevolução é o surgimento de comportamentos complexos à medida que a computação aumenta durante os testes. A reflexão - ou seja, o modelo revisitando e reavaliando suas etapas anteriores - bem como a exploração de abordagens alternativas de solução de problemas - surge espontaneamente. Esses comportamentos não são explicitamente programados, mas surgem como resultado da interação do modelo com o ambiente de aprendizado por reforço. Esse desenvolvimento espontâneo aprimora significativamente os recursos de raciocínio do DeepSeek-R1-Zero, permitindo que ele enfrente tarefas mais desafiadoras com maior eficiência e precisão.

Fig. 3 | Duração média da resposta do DeepSeek-R1-Zero no conjunto de treinamento do processo de RL. O DeepSeek-R1-Zero aprende naturalmente a resolver tarefas de inferência levando mais tempo para pensar.

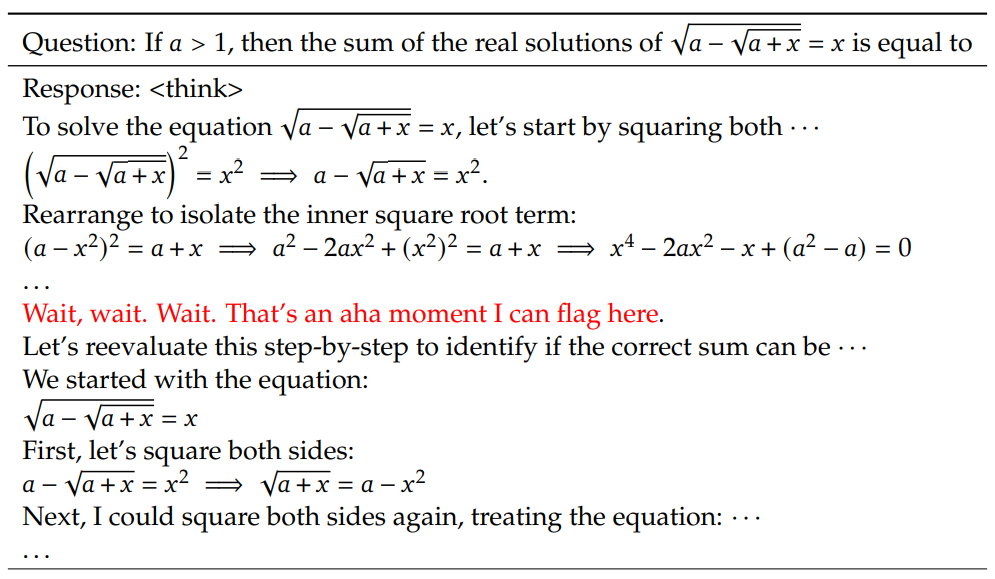

Momentos de epifania no DeepSeek-R1-Zero Um fenômeno particularmente interessante observado durante o treinamento do DeepSeek-R1-Zero é a ocorrência de "momentos de epifania". Conforme mostrado na Tabela 3, esse momento ocorre na versão intermediária do modelo. Nesse estágio, o DeepSeek-R1-Zero aprende a alocar mais tempo de raciocínio para o problema, reavaliando sua abordagem inicial. Esse comportamento não é apenas uma prova dos crescentes recursos de inferência do modelo, mas também um exemplo fascinante de como o aprendizado por reforço pode levar a resultados inesperados e complexos.

Tabela 3 | Um interessante "momento de epifania" na versão intermediária do DeepSeek-R1-Zero. O modelo aprende a repensar usando um tom antropomórfico. Esse também foi nosso próprio momento de epifania, permitindo-nos testemunhar o poder e a beleza do aprendizado por reforço.

Esse momento foi uma "epifania" não apenas para o modelo, mas também para os pesquisadores que observaram seu comportamento. Ele ressalta o poder e a beleza da aprendizagem por reforço: em vez de ensinar explicitamente a um modelo como resolver um problema, simplesmente fornecemos a ele os incentivos certos, e ele desenvolve de forma autônoma estratégias avançadas de resolução de problemas. O "momento de epifania" é um poderoso lembrete do potencial da RL para desbloquear novos níveis de inteligência nos sistemas de IA, abrindo caminho para modelos mais autônomos e adaptáveis no futuro.

Desvantagens do DeepSeek-R1-Zero Embora o DeepSeek-R1-Zero apresente fortes recursos de raciocínio e desenvolva de forma autônoma comportamentos de raciocínio inesperados e poderosos, ele também enfrenta alguns problemas. Por exemplo, o DeepSeek-R1-Zero tem dificuldades com a legibilidade ruim e a mistura de idiomas. Para tornar o processo de raciocínio mais legível e compartilhá-lo com a comunidade aberta, exploramos o DeepSeek-R1, uma abordagem que utiliza a RL com dados de cold-start amigáveis ao ser humano.

2.3 DeepSeek-R1: Aprendizado por reforço com um início frio

Inspirados pelos resultados promissores do DeepSeek-R1-Zero, surgem duas perguntas naturais: 1) O desempenho da inferência pode ser melhorado ainda mais ou a convergência pode ser acelerada com a incorporação de uma pequena quantidade de dados de alta qualidade como um cold-start? e 2) Como podemos treinar um modelo fácil de usar que não só produza Cadeias de Pensamento (CoTs) claras e coerentes, mas também demonstre fortes capacidades de generalização? Para responder a essas perguntas, projetamos um processo para treinar o DeepSeek-R1. O processo consiste em quatro fases, conforme descrito abaixo.

Diferentemente do DeepSeek-R1-Zero, para evitar uma fase inicial instável de cold-start quando o treinamento de RL começa a partir do modelo básico, para o DeepSeek-R1 construímos e coletamos uma pequena quantidade de dados de CoT longos para ajustar o modelo como um participante inicial de RL. Para coletar esses dados, exploramos várias abordagens: usar prompts de poucos exemplos com CoTs longos como exemplos, solicitar diretamente ao modelo que gerasse respostas detalhadas com reflexão e validação, coletar a saída do DeepSeek-R1-Zero em um formato legível e pós-processar os resultados por meio de anotadores humanos.

Neste trabalho, coletamos milhares de dados de cold-start para fazer o ajuste fino do DeepSeek-V3-Base como ponto de partida para a RL. As vantagens dos dados de cold-start em relação ao DeepSeek-R1-Zero incluem:

- Legibilidade: uma das principais limitações do DeepSeek-R1-Zero é que seu conteúdo geralmente não é legível. As respostas podem misturar vários idiomas ou não ter a formatação de marcação usada para destacar as respostas do usuário. Em vez disso, ao criar dados de cold-start para o DeepSeek-R1, projetamos um esquema legível que inclui um resumo no final de cada resposta e filtra as respostas que não são facilmente legíveis. Aqui, definimos o formato de saída como | special_token | | special_token |

, em que o processo de raciocínio é o CoT da consulta e o resumo é usado para resumir os resultados do raciocínio. - Potencial: ao usar um humano antes de criar um modelo para dados de cold-start, observamos um melhor desempenho em relação ao DeepSeek-R1-Zero. Argumentamos que o treinamento iterativo é uma maneira melhor de raciocinar sobre modelos.

Depois de fazer o ajuste fino do DeepSeek-V3-Base em dados de cold-start, aplicamos o mesmo processo de treinamento de aprendizagem por reforço em larga escala empregado no DeepSeek-R1-Zero. O foco dessa fase foi aprimorar os recursos de inferência do modelo, especialmente em tarefas que exigem inferência, como codificação, raciocínio matemático, científico e lógico envolvendo perguntas explícitas. Durante o processo de treinamento, observamos que o CoT frequentemente apresenta mistura de idiomas, especialmente quando as dicas de RL envolvem vários idiomas. Para atenuar o problema da mistura de idiomas, introduzimos uma recompensa de consistência linguística durante o treinamento de RL, que foi calculada como a proporção de palavras no idioma de destino no CoT. Embora os experimentos de ablação mostrem que esse alinhamento leva a uma leve degradação do desempenho do modelo, essa recompensa é consistente com as preferências humanas, tornando-a mais legível. Por fim, combinamos as recompensas de precisão e consistência linguística na tarefa de raciocínio, somando-as diretamente para formar a recompensa final. Em seguida, aplicamos o treinamento de aprendizagem por reforço (RL) no modelo ajustado até que ele atinja a convergência na tarefa de inferência.

Quando a RL orientada por inferência converge, usamos os pontos de verificação gerados para coletar dados de SFT (ajuste fino supervisionado) para as rodadas subsequentes. Diferentemente dos dados iniciais de partida a frio, que se concentram principalmente no raciocínio, essa fase incorpora dados de outros domínios para aprimorar os recursos do modelo na escrita, na interpretação de papéis e em outras tarefas de uso geral. Especificamente, geramos dados e ajustamos o modelo conforme descrito abaixo.

Dados de inferência Selecionamos dicas de inferência e geramos trajetórias de inferência realizando amostragem de rejeição dos pontos de verificação treinados em RL descritos acima. Na fase anterior, incluímos apenas dados que poderiam ser avaliados usando recompensas baseadas em regras. No entanto, nesta fase, ampliamos o conjunto de dados combinando mais dados, alguns dos quais usam modelos de recompensa generativos, alimentando rótulos reais e previsões de modelos no DeepSeek-V3 para julgamento. Além disso, como a saída do modelo às vezes é confusa e difícil de ler, filtramos as cadeias de pensamento com linguagem mista, parágrafos longos e blocos de código. Para cada dica, coletamos amostras de várias respostas e mantivemos apenas a resposta correta. No total, coletamos cerca de 600.000 amostras de treinamento relacionadas ao raciocínio.

Dados não fundamentados Para dados não fundamentados, como escrita, questionamento factual, autoconsciência e tradução, empregamos o processo do DeepSeek-V3 e reutilizamos partes do conjunto de dados SFT do DeepSeek-V3. Para determinadas tarefas que não sejam de raciocínio, invocamos o DeepSeek-V3 para gerar cadeias de pensamento em potencial por meio de um prompt antes de responder a uma pergunta. No entanto, para consultas simples (por exemplo, "hello"), não fornecemos CoTs nas respostas. Por fim, coletamos um total de cerca de 200.000 amostras de treinamento que não estão relacionadas à inferência.

Fizemos o ajuste fino do DeepSeek-V3-Base por dois períodos usando o conjunto de dados com curadoria acima, com cerca de 800.000 amostras.

Para alinhar ainda mais o modelo com as preferências humanas, implementamos uma segunda fase de aprendizado por reforço com o objetivo de aumentar a utilidade e a inocuidade do modelo e, ao mesmo tempo, aprimorar continuamente seus recursos de raciocínio. Especificamente, treinamos o modelo usando uma combinação de sinais de recompensa e várias distribuições de dicas. Para dados de inferência, seguimos a abordagem delineada no DeepSeek-R1-Zero, que usa recompensas baseadas em regras para orientar o processo de aprendizagem nos domínios do raciocínio matemático, de codificação e lógico. Para dados gerais, contamos com modelos de recompensa para capturar as preferências humanas em cenários complexos e detalhados. Baseamo-nos no processo do DeepSeek-V3 e usamos pares de preferências e distribuições de dicas de treinamento semelhantes. Para sermos úteis, nos concentramos exclusivamente no resumo final, garantindo que a avaliação enfatize a utilidade e a relevância da resposta para o usuário, minimizando a interferência no processo de raciocínio subjacente. Para ser inofensivo, avaliamos toda a resposta do modelo, inclusive o processo de raciocínio e o resumo, para identificar e atenuar os possíveis riscos, vieses ou conteúdo prejudicial que possam ter surgido durante o processo de geração. Por fim, a integração de sinais de recompensa e várias distribuições de dados nos permite treinar um modelo que se destaca no raciocínio e prioriza tanto a utilidade quanto a inocuidade.

2.4 Destilação: aumento de modelos pequenos com poder de raciocínio

Para tornar mais eficientes os modelos pequenos com recursos de inferência como o DeepSeek-R1, ajustamos diretamente os modelos de código aberto, como o Qwen (Qwen, 2024b) e o Llama (AI@Meta, 2024), usando as 800.000 amostras coletadas pelo DeepSeek-R1 (conforme detalhado em §2.3.3). Nossas descobertas sugerem que esse método simples de destilação pode melhorar significativamente a inferência de modelos pequenos. Os modelos básicos que usamos aqui são Qwen2.5-Math-1.5B, Qwen2.5-Math-7B, Qwen2.5-14B, Qwen2.5-32B, Llama-3.1-8B e Llama-3.3-70B-Instruct. Llama-3.1.

Para o modelo de destilação, aplicamos somente a SFT e não incluímos o estágio de RL, embora a fusão da RL possa melhorar significativamente o desempenho do modelo. Nosso principal objetivo aqui é demonstrar a eficácia da técnica de destilação, deixando a exploração do estágio de RL para a comunidade de pesquisa mais ampla.

3. experimentos

avaliação comparativa Publicamos os resultados em MMLU (Hendrycks et al., 2020), MMLU-Redux (Gema et al., 2024), MMLU-Pro (Wang et al., 2024), C-Eval (Huang et al., 2023) e CMMLU (Li et al., 2023), IFEval (Zhou et al., 2023), FRAMES (Krishna et al., 2024), GPQA Diamond (OpenAI Diamond) (Rein et al., 2023) e IFEval (Zhou et al., 2023), FRAMES (Krishna et al., 2024), GPQA Diamond (Rein et al., 2023), SimpleQA (OpenAI, 2024c), C-SimpleQA (He et al., 2024), SWE- Bench Verified (OpenAI, 2024d), Aider¹ , LiveCodeBench (Jain et al., 2024) (2024-08 - 2025-01), Codeforces², Olimpíada Nacional Chinesa de Matemática do Ensino Médio (CNHSMOA) School Mathematics Olympiad (CNMO 2024)³, e American Invitational Mathematics Examination 2024 (AIME 2024) (MAA, 2024). Além dos testes de referência padrão, usamos o LLM como júri para avaliar o desempenho de nossos modelos em tarefas geradoras abertas. Especificamente, seguimos as configurações originais do AlpacaEval 2.0 (Dubois et al., 2024) e do Arena-Hard (Li et al., 2024), que utilizam o GPT-4-Turbo-1106 como júri para comparações entre pares. Aqui, fornecemos apenas os resumos finais para avaliação a fim de evitar o viés de comprimento. Para modelos de destilação, relatamos resultados representativos no AIME 2024, MATH-500, GPQA Diamond, Codeforces e LiveCodeBench.

Dicas de avaliação Seguindo a configuração do DeepSeek-V3, os benchmarks padrão, como MMLU, DROP, GPQA Diamond e SimpleQA, são avaliados usando prompts da estrutura simple-evals. Para o MMLU-Redux, usamos o formato de prompt Zero-Eval (Lin, 2024) na configuração de amostra zero. Para MMLU-Pro, C-Eval e CLUE-WSC, como os prompts originais foram subamostrados, modificamos ligeiramente os prompts para a configuração de amostra zero. A CoT em poucas amostras pode prejudicar o desempenho do DeepSeek-R1. Os outros conjuntos de dados seguem o protocolo de avaliação original com dicas padrão fornecidas por seus criadores. Para a avaliação comparativa de código e matemática, o conjunto de dados HumanEval-Mul abrange oito linguagens de programação principais (Python, Java, C++, C#, JavaScript, TypeScript, PHP e Bash). O desempenho do modelo no LiveCodeBench é avaliado usando o formato CoT, com dados coletados entre agosto de 2024 e janeiro de 2025. O conjunto de dados Codeforces foi avaliado usando perguntas de 10 competições Div.2, bem como casos de teste produzidos por especialistas e, em seguida, foram calculadas as classificações e porcentagens esperadas dos concorrentes. Os resultados da validação do SWE-Bench foram obtidos por meio de uma estrutura sem agente (Xia et al., 2024). Os benchmarks relacionados ao AIDER foram medidos usando o formato "diff", e a saída do DeepSeek-R1 foi limitada a 32.768 tokens por benchmark.

linha de base (em levantamento geodésico) Realizamos avaliações abrangentes em relação a várias linhas de base avançadas, incluindo DeepSeek-V3, Claude-Sonnet-3.5-1022, GPT-40-0513, OpenAI-01-mini e OpenAI-01-1217. Devido ao difícil acesso à API do OpenAI-01-1217 na China continental. relatamos seu desempenho com base em relatórios oficiais. Para o modelo de destilação, também comparamos o modelo de código aberto QwQ-32B-Preview (Qwen, 2024a).

Gerar configurações Para todos os nossos modelos, o comprimento máximo de geração é definido como 32.768 tokens. Para benchmarks que exigem amostragem, usamos uma temperatura de 0,6, um valor top-p de 0,95 e geramos 64 respostas para cada consulta para estimar pass@1.

3.1 Avaliação do DeepSeek-R1

Para benchmarks de conhecimento voltados para a educação, como MMLU, MMLU-Pro e GPQA Diamond, o DeepSeek-R1 demonstra desempenho superior ao DeepSeek-V3. Essa melhoria é atribuída principalmente ao aumento da precisão em problemas relacionados a STEM, em que ganhos significativos são obtidos por meio da aprendizagem por reforço (RL) em grande escala. Além disso, o DeepSeek-R1 tem um bom desempenho no FRAMES, uma longa tarefa de controle de qualidade dependente do contexto, demonstrando seus sólidos recursos de análise de documentos. Isso destaca o potencial dos modelos de inferência em tarefas de pesquisa e análise de dados orientadas por IA. No benchmark factual SimpleQA, o DeepSeek-R1 supera o DeepSeek-V3, demonstrando sua capacidade de lidar com consultas baseadas em fatos. Uma tendência semelhante foi observada quando o OpenAI-01 superou o GPT-40 nesse benchmark. No entanto, o DeepSeek-R1 não tem um desempenho tão bom quanto o DeepSeek-V3 no benchmark chinês SimpleQA, principalmente devido à sua tendência de se recusar a responder a determinadas consultas após uma RL segura. Na ausência de uma RL segura, o DeepSeek-R1 pode atingir uma precisão de mais de 70%.

Tabela 4 | Comparação entre o DeepSeek-R1 e outros modelos representativos.

O DeepSeek-R1 também obteve resultados impressionantes no IF-Eval, um teste de referência criado para avaliar a capacidade de um modelo de seguir instruções de formato. Essas melhorias podem estar relacionadas aos dados de adesão às instruções incluídos nos estágios finais do ajuste fino supervisionado (SFT) e do treinamento de RL. Além disso, foi observado um desempenho superior no AlpacaEval2.0 e no ArenaHard, demonstrando que o DeepSeek-R1 tem uma vantagem em tarefas de escrita e respostas a perguntas de domínio aberto. Seu desempenho significativamente melhor do que o do DeepSeek-V3 destaca os benefícios de generalização da RL em larga escala, que não só melhora a inferência, mas também o desempenho em vários domínios. Além disso, o DeepSeek-R1 gera resumos concisos, e a média no ArenaHard token de 689 e uma média de 2.218 caracteres no AlpacaEval 2.0. Isso indica que o DeepSeek-R1 evita a introdução de viés de comprimento durante a avaliação baseada em GPT, solidificando ainda mais sua robustez em várias tarefas.

Para tarefas matemáticas, o desempenho do DeepSeek-R1 é comparável ao do OpenAI-01-1217, superando significativamente os outros modelos. Uma tendência semelhante é observada em tarefas de algoritmo de codificação, como o LiveCodeBench e o Codeforces, em que os modelos centrados em inferência dominam esses benchmarks. Para tarefas de codificação voltadas para engenharia, o OpenAI-01-1217 supera o DeepSeek-R1 no Aider, mas atinge desempenho comparável no SWE Verified. Acreditamos que o desempenho do DeepSeek-R1 para tarefas de engenharia será aprimorado na próxima versão, pois a quantidade de dados de treinamento de RL relevantes ainda é muito limitada neste momento.

3.2 Avaliação da modelagem de destilação

Tabela 5 | Comparação do modelo de destilação DeepSeek-R1 com outros modelos comparáveis no teste de referência de correlação de inferência.

Conforme mostrado na Tabela 5, a simples destilação da saída do DeepSeek-R1 permite que o eficiente DeepSeek-R1-7B (ou seja, DeepSeek-R1-Distill-Qwen-7B, doravante denominado por esse nome) supere os modelos sem inferência, como o GPT-40-0513, em todos os aspectos. O DeepSeek-R1-14B supera o QwQ-32B-Preview em todas as métricas de avaliação, enquanto o DeepSeek-R1-32B e o DeepSeek-R1-70B superam significativamente o o1-mini na maioria dos benchmarks. Esses resultados demonstram o forte potencial do distill. Além disso, descobrimos que a aplicação da RL a esses modelos de destilação leva a ganhos adicionais significativos. Acreditamos que vale a pena explorar isso mais a fundo e, portanto, apresentamos aqui apenas os resultados do modelo simples de destilação SFT.

4. discussão

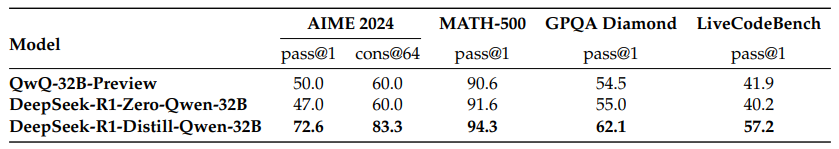

4.1 Destilação vs. aprendizado intensivo

Tabela 6 | Comparação entre o modelo de destilação e o modelo RL no benchmark de correlação de inferência.

Na Seção 3.2, podemos ver que, ao destilar o DeepSeek-R1, modelos pequenos podem obter resultados impressionantes. No entanto, uma pergunta permanece: os modelos podem ser treinados com a RL de grande escala discutida neste artigo (sem destilação) para obter um desempenho comparável?

Para responder a essa pergunta, realizamos o treinamento de RL em larga escala do Qwen-32B-Base usando dados matemáticos, de código e STEM para mais de 10.000 etapas, resultando no DeepSeek-R1-Zero-Qwen-32B. Os resultados experimentais (mostrados na Fig. 6) mostram que o modelo básico do 32B, após o treinamento de RL em larga escala, atinge um desempenho comparável ao do QwQ-32B-Preview em um nível comparável. No entanto, o DeepSeek-R1-Distill-Qwen-32B, que é destilado do DeepSeek-R1, supera significativamente o DeepSeek-R1-Zero-Qwen-32B em todos os benchmarks. Portanto, podemos tirar duas conclusões: primeiro, destilar o modelo mais potente em um modelo menor produz excelentes resultados enquanto os modelos menores que dependem das RLs de grande escala mencionadas neste artigo exigem enorme capacidade de computação e podem nem mesmo atingir o desempenho da destilação. Em segundo lugar, embora a estratégia de destilação seja econômica e eficiente, modelos de base mais avançados e aprendizagem por reforço em grande escala ainda podem ser necessários para ir além dos limites da inteligência.

4.2 Tentativas fracassadas

Durante os estágios iniciais de desenvolvimento do DeepSeek-R1, também nos deparamos com algumas falhas e contratempos. Compartilhamos nossas falhas aqui para fornecer insights, mas isso não significa que esses métodos sejam incapazes de desenvolver modelos de inferência eficazes.

Modelagem de recompensa de processo (PRM) A PRM é uma maneira sensata de orientar os modelos a adotar métodos melhores para resolver tarefas de raciocínio (Lightman et al., 2023; Uesato et al., 2022; Wang et al., 2023). Na prática, porém, há três limitações principais do PRM que podem impedir seu sucesso final. Em primeiro lugar, é difícil definir explicitamente etapas de granularidade fina no raciocínio geral. Em segundo lugar, determinar se a etapa intermediária atual está correta é uma tarefa difícil. A anotação automática usando modelos pode não produzir resultados satisfatórios, enquanto a anotação manual não favorece o dimensionamento. Em terceiro lugar, uma vez introduzido o PRM baseado em modelos, ele inevitavelmente levará ao hacking de recompensas (Gao et al., 2022), e o retreinamento do modelo de recompensas exige recursos de treinamento adicionais, o que pode complicar o processo geral de treinamento. Em resumo, embora o PRM demonstre uma boa capacidade de reordenar as respostas top-N geradas pelo modelo ou de auxiliar na busca guiada (Snell et al., 2024), suas vantagens são limitadas quando comparadas à sobrecarga computacional adicional introduzida durante o aprendizado por reforço em larga escala em nossos experimentos.

Monte Carlo Tree Search (MCTS) Inspirado pelo AlphaGo (Silver et al., 2017b) e AlphaZero (Silver et al., 2017a), exploramos o uso do Monte Carlo Tree Search (MCTS) para aumentar a escalabilidade da computação no momento do teste. Essa abordagem envolve a decomposição da resposta em partes menores para permitir que o modelo explore sistematicamente o espaço da solução. Para facilitar isso, solicitamos ao modelo que gere vários rótulos que correspondam a etapas de inferência específicas necessárias para a pesquisa. Para o treinamento, primeiro usamos as dicas coletadas para encontrar respostas por meio de um MCTS orientado por um modelo de valor pré-treinado. Em seguida, usamos os pares de perguntas e respostas gerados para treinar o modelo de ator e o modelo de valor, aprimorando assim o processo de forma iterativa.

No entanto, essa abordagem encontra vários desafios ao ampliar o treinamento. Em primeiro lugar, ao contrário do xadrez, em que o espaço de busca é relativamente bem definido, a geração de tokens apresenta um espaço de busca exponencialmente maior. Para resolver esse problema, definimos um limite máximo de expansão para cada nó, mas isso pode fazer com que o modelo caia em um ótimo local. Em segundo lugar, o modelo de valor afeta diretamente a qualidade da geração, pois orienta cada etapa do processo de pesquisa. O treinamento de um modelo de valor de granulação fina é inerentemente difícil, o que dificulta o aprimoramento iterativo do modelo. Embora o sucesso central do AlphaGo dependa do treinamento de modelos de valor para melhorar seu desempenho de forma incremental, é difícil replicar esse princípio em nosso cenário devido à complexidade da geração de marcadores.

Concluindo, embora o MCTS possa melhorar o desempenho durante a inferência quando associado a modelos de valores pré-treinados, o aprimoramento iterativo do desempenho do modelo durante a autopesquisa continua sendo um desafio difícil.

5 Conclusões, limitações e trabalhos futuros

Neste artigo, compartilhamos nosso processo para aprimorar a inferência de modelos por meio do aprendizado por reforço (RL). O DeepSeek-R1-Zero representa uma abordagem de RL pura que não depende de dados de cold-start e alcança um bom desempenho em várias tarefas. O DeepSeek-R1 é ainda mais poderoso, pois utiliza dados de cold-start e ajuste fino de RL iterativo. Por fim, o DeepSeek-R1 alcança um desempenho comparável ao do OpenAI-01-1217 em uma variedade de tarefas.

Exploramos ainda mais o poder de raciocínio em modelos pequenos e densos. Usamos o DeepSeek-R1 como um modelo de professor para gerar 800 mil dados e ajustamos vários modelos pequenos e densos. Os resultados são promissores: o DeepSeek-R1-Distill-Qwen-1.5B supera o GPT-40 e o Claude-3.5-Sonnet no teste de benchmarking de matemática, com uma pontuação AIME de 28,91 TP3T e uma pontuação MATH de 83,91 TP3T. Os outros modelos densos também obtiveram resultados impressionantes, significativamente melhores do que os outros modelos de ajuste fino de instruções baseados nos mesmos pontos de verificação subjacentes.

No futuro, planejamos investigar o DeepSeek-R1 nas seguintes áreas:

- Capacidades genéricas: atualmente, o DeepSeek-R1 é menos capaz do que o DeepSeek-V3 em tarefas como chamadas de função, diálogos de várias rodadas, interpretação de papéis complexos e saída json.

- Mistura de idiomas: o DeepSeek-R1 está atualmente otimizado para chinês e inglês, o que pode levar a problemas de mistura de idiomas ao processar consultas em outros idiomas. Por exemplo, o DeepSeek-R1 pode raciocinar e responder em inglês mesmo que a consulta esteja em um idioma diferente do inglês ou do chinês. Pretendemos abordar essa limitação em uma atualização futura.

- Engenharia de dicas: ao avaliar o DeepSeek-R1, descobrimos que ele é sensível a dicas. Dicas com menos amostras degradam consistentemente seu desempenho. Portanto, recomendamos que os usuários descrevam o problema diretamente e especifiquem o formato de saída usando a configuração de amostra zero para obter melhores resultados.

- Tarefas de engenharia de software: a RL em larga escala não tem sido amplamente aplicada a tarefas de engenharia de software devido ao longo tempo de avaliação, que afeta a eficiência do processo de RL. Como resultado, o DeepSeek-R1 ainda não mostrou uma grande melhoria no desempenho em benchmarks de engenharia de software em relação ao DeepSeek-V3. As versões futuras abordarão esse problema implementando a amostragem de rejeição em dados de engenharia de software ou mesclando avaliações assíncronas no processo de RL para aumentar a eficiência.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...