Command R7B: recuperação e raciocínio aprimorados, suporte multilíngue, IA geradora rápida e eficiente

O menor modelo da nossa família R oferece velocidade, eficiência e qualidade de alto nível para criar aplicativos avançados de IA em GPUs comuns e dispositivos de borda.

Hoje, temos o prazer de lançar Comando R7B, o menor, mais rápido e último modelo da nossa série R de modelos de linguagem grande (LLMs) desenvolvidos especificamente para a empresa. O Command R7B oferece desempenho líder do setor em sua classe de modelos ponderados abertos, capazes de lidar com tarefas do mundo real que são importantes para os usuários. O modelo foi projetado para desenvolvedores e empresas que precisam otimizar a velocidade, a relação custo-benefício e os recursos computacionais.

Como outros modelos da família R, o Command R7B oferece um comprimento de contexto de 128k e se destaca em vários cenários importantes de aplicativos comerciais. Ele combina um forte suporte a vários idiomas, Retrieval Augmented Generation (RAG) validado por referência, raciocínio, uso de ferramentas e comportamento de agentes. Graças ao seu tamanho compacto e à sua eficiência, ele pode ser executado em GPUs de baixo custo, MacBooks e até mesmo em CPUs, reduzindo drasticamente o custo de colocar aplicativos de IA em produção.

Alto desempenho em um pacote pequeno

Um modelo abrangente

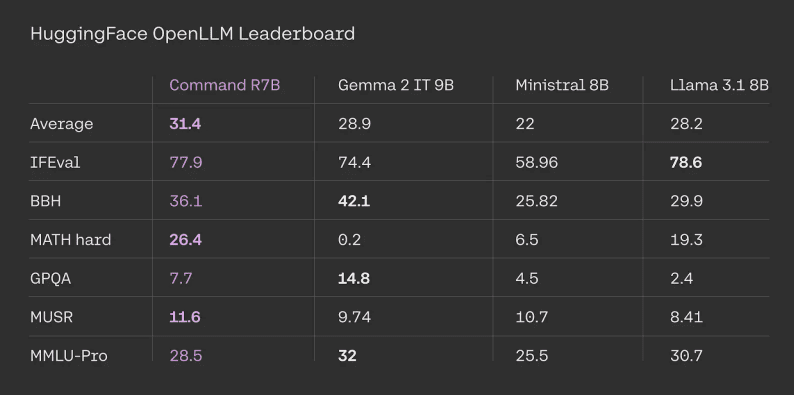

O Command R7B tem um bom desempenho em benchmarks padronizados e verificáveis externamente, como Tabelas de classificação do HuggingFace Open LLM. O Command R7B ficou em primeiro lugar, em média, em todas as tarefas, com bom desempenho em comparação com outros modelos de ponderação aberta comparáveis.

Resultados da avaliação da tabela de classificação do HuggingFace. Os resultados do Command R7B são calculados por nós com base nas dicas e nos códigos de avaliação fornecidos pelo HuggingFace oficial.

Ganhos de eficiência em tarefas de matemática, código e raciocínio

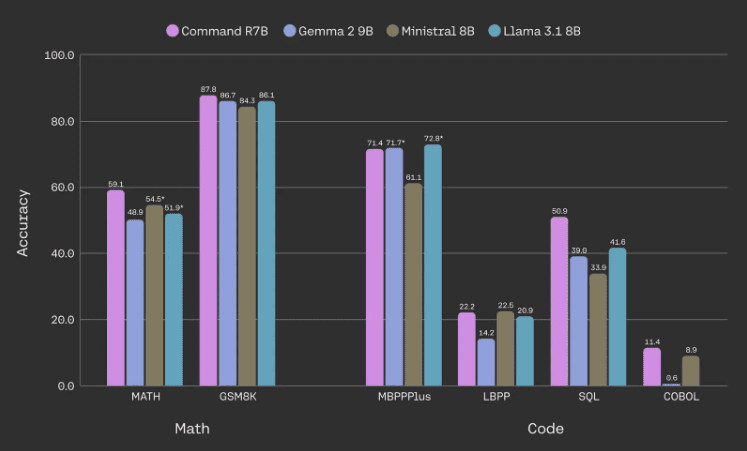

Um dos principais focos do Command R7B é melhorar o desempenho em matemática e raciocínio, escrita de código e tarefas multilíngues. Em particular, o modelo é capaz de igualar ou superar o desempenho de modelos comparáveis com ponderação aberta em benchmarks comuns de matemática e código, usando menos parâmetros.

Desempenho do modelo em matemática e benchmarking de código. Todos os dados são de avaliações internas; os números marcados com um asterisco são de resultados relatados externamente, que são mais altos. Usamos a versão básica do MBPPPlus, a média do LBPP é calculada em 6 linguagens, a média do SQL é calculada em 3 conjuntos de dados (seções de dificuldade mais alta e superalta do SpiderDev e Test only, BirdBench e um conjunto de dados interno) e o COBOL é um conjunto de dados que desenvolvemos internamente.

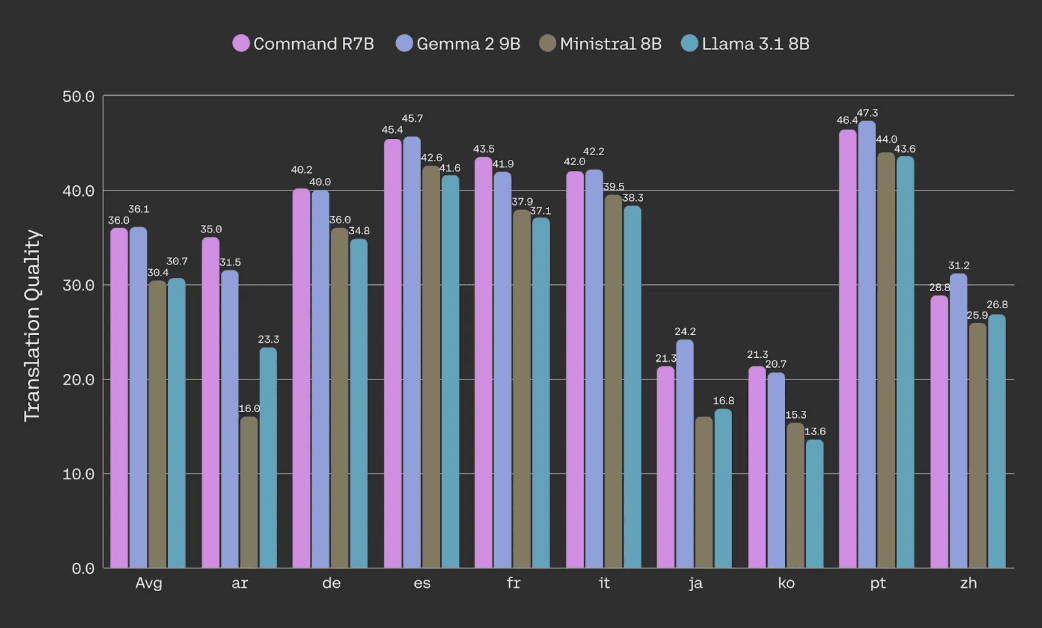

Qualidade de tradução de documentos avaliada usando o conjunto de dados NTREX (por meio de métricas de corpus spBLEU).

O melhor RAG da categoria, uso de ferramentas e inteligência

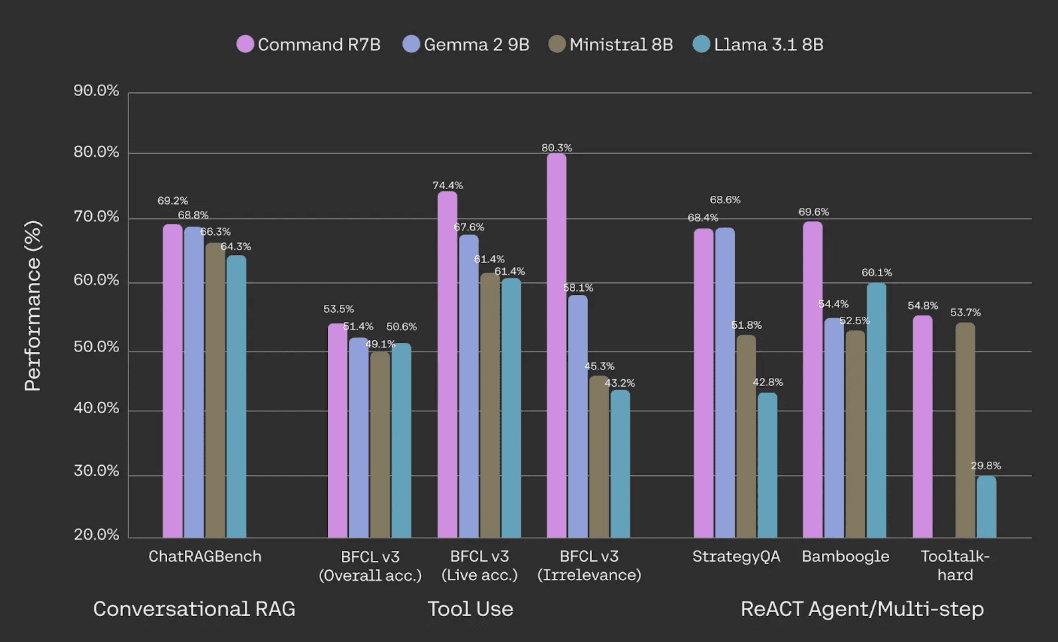

O Command R7B supera outros modelos de ponderação abertos de tamanho comparável no tratamento de aplicativos comerciais essenciais, como RAG, uso de ferramentas e inteligências de IA. Ele é ideal para organizações que buscam um modelo econômico com base em documentos e dados internos. Assim como em nossos outros modelos da série R, nosso RAG São fornecidas referências locais em linha, o que reduz bastante as ilusões e facilita a verificação de fatos.

Avaliação de desempenho no ChatRAGBench (média de 10 conjuntos de dados), BFCL-v3, StrategyQA, Bamboogle e Tooltalk-hard. Consulte a nota de rodapé [1] abaixo para obter a metodologia e mais detalhes.

Em termos de uso de ferramentas, vemos que, em comparação com modelos de escala comparáveis, o Command R7B é mais eficiente em termos de padrão industrial Tabela de classificação de chamadas de função de Berkeley Isso mostra que o Command R7B é particularmente bom no uso de ferramentas em ambientes diversos e dinâmicos no mundo real e é capaz de evitar chamadas desnecessárias a ferramentas, um aspecto importante do uso de ferramentas em aplicativos do mundo real. Isso demonstra que o Command R7B é particularmente hábil no uso de ferramentas em ambientes diversos e dinâmicos no mundo real e é capaz de evitar chamadas desnecessárias de ferramentas, um aspecto importante do uso de ferramentas em aplicações do mundo real.

Otimização para casos de uso corporativo

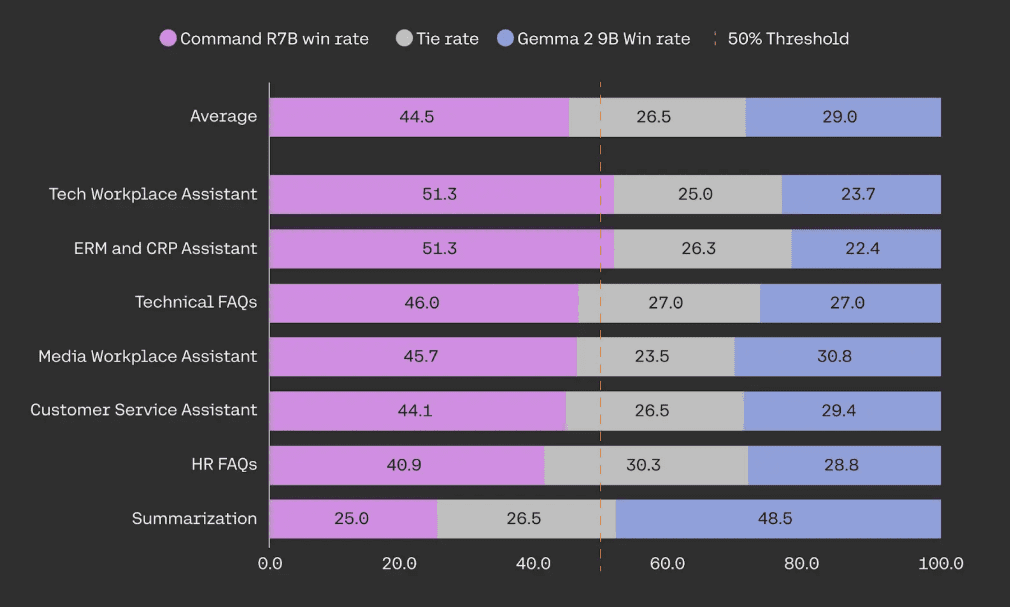

Nossos modelos são otimizados para atender aos recursos de que as organizações precisam ao implantar sistemas de IA no mundo real. A R-Series oferece um equilíbrio incomparável entre eficiência e desempenho robusto. O Command R7B supera o desempenho de modelos de tamanho semelhante, com ponderação aberta, em testes cegos frente a frente em casos de uso do RAG para a criação de assistentes de IA importantes para os clientes, como atendimento ao cliente, RH, conformidade e funções de suporte de TI.

Na avaliação humana, o Command R7B foi testado em comparação com o Gemma 2 9B em uma amostra de 949 casos de uso de RAG empresarial. Todos os exemplos foram anotados às cegas pelo menos três vezes por anotadores humanos especialmente treinados para avaliar a fluência, a fidelidade e a utilidade da resposta.

Eficiente e rápido

O tamanho compacto do Command R7B proporciona uma pequena área de serviço para prototipagem e iteração rápidas. Ele se destaca em casos de uso em tempo real de alta taxa de transferência, como chatbots e assistentes de código. Ele também oferece suporte ao raciocínio no lado do dispositivo, reduzindo drasticamente o custo de implementação da infraestrutura, como GPUs e CPUs de nível de consumidor.

Nesse processo, não comprometemos nossos padrões de segurança e privacidade de nível empresarial para garantir a proteção dos dados de nossos clientes.

Início rápido

O Command R7B está disponível hoje em Plataforma Cohere Ele também pode ser usado no HuggingFace Sobre o acesso. Temos o prazer de liberar os pesos do modelo para fornecer à comunidade de pesquisa de IA um acesso mais amplo à tecnologia de ponta.

| Coesão Preços de API | importação Token | Token de saída |

|---|---|---|

| Comando R7B | $0.0375 / 1M | $0.15 / 1M |

[1] RAG conversacional: um teste de desempenho médio no benchmark ChatRAGBench em 10 conjuntos de dados, testando a capacidade de gerar respostas em uma variedade de ambientes, incluindo tarefas de conversação, processamento de entradas longas, análise de formulários e extração e manipulação de informações de dados em um ambiente financeiro. Aprimoramos a metodologia de avaliação usando a integração do discriminador PoLL (Verga et al., 2024) em combinação com Haiku, GPT3.5 e Command R, o que proporcionou maior consistência (kappa de Fleiss = 0,74 em comparação com 0,57 na versão original, com base em 20.000 classificações manuais). Uso da ferramenta: desempenho no benchmark BFCL-v3 de 12 de dezembro de 2024. Todas as pontuações disponíveis são de tabelas de classificação públicas, caso contrário, avaliações internas usando a base de código oficial. Para os concorrentes, informamos a maior pontuação do BFCL "solicitada" ou "chamada de função". Informamos a pontuação geral, a pontuação do subconjunto em tempo real (testando o uso de ferramentas em ambientes reais, diversos e dinâmicos) e a pontuação do subconjunto irrelevante (testando como o modelo evita chamar ferramentas desnecessariamente). REAGIR A capacidade das inteligências conectadas à Internet de decompor problemas complexos e desenvolver planos para a execução bem-sucedida da pesquisa foi avaliada por meio do Bamboogle e do StrategyQA. O Bamboogle foi avaliado por meio da integração do PoLL e o StrategyQA foi avaliado avaliando se o modelo seguiu as instruções do formato e, por fim, respondeu "Sim ' ou 'Não' para fazer um julgamento. Usamos os conjuntos de testes de Chen et al. (2023) e Press et al. (2023).O ToolTalk desafia o modelo a realizar raciocínios complexos e a buscar ativamente informações do usuário para concluir tarefas complexas do usuário, como gerenciamento de contas, envio de e-mails e atualização de calendários.O ToolTalk-hard é avaliado usando a taxa de sucesso suave da biblioteca oficial do ToolTalk. O ToolTalk exige que o modelo exponha uma API de chamada de função, que o Gemma 2 9B não tem.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...