BrowseComp: OpenAI lança novo benchmark para avaliar a capacidade de recuperação de informações das redes de IA

Recentemente, a OpenAI lançou um projeto chamado NavegarComp um novo teste de benchmark projetado para avaliar a capacidade dos agentes de IA de navegar na Internet. O benchmark consiste em 1.266 perguntas que abrangem uma ampla gama de domínios, desde a descoberta científica até a cultura pop, e exige que o agente navegue persistentemente em um ambiente aberto da Web em busca de respostas difíceis de encontrar e entrelaçadas com informações.

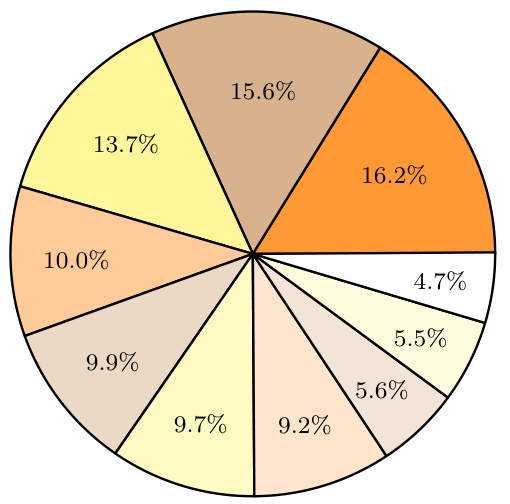

Figura 1: Desempenho do BrowseComp de uma versão anterior do OpenAI Deep Research sob diferentes esforços de navegação. A precisão melhora suavemente à medida que a quantidade de computação no momento do teste aumenta.

Os Benchmarks existentes estão "saturados" e o BrowseComp foi desenvolvido para essa finalidade.

Atualmente, alguns benchmarks populares, como o SimpleQA, concentram-se na capacidade de um modelo de recuperar fatos simples e isolados. Para modelos avançados como o GPT-4o, que é equipado com ferramentas de navegação, essas tarefas se tornaram simples demais e se aproximam da saturação de desempenho. Isso significa que benchmarks como o SimpleQA não são mais eficazes para diferenciar os verdadeiros recursos dos modelos ao lidar com informações mais complexas que exigem uma exploração profunda da rede para serem encontradas.

Foi para preencher essa lacuna que a OpenAI desenvolveu o BrowseComp (que significa "Competição de Navegação"). O benchmark consiste em 1.266 perguntas desafiadoras e foi projetado para avaliar a capacidade dos agentes de IA de localizar perguntas difíceis de encontrar, com pontos de informações interligados e que podem exigir visitas a dezenas ou até centenas de sites para serem respondidas. A equipe publicou o benchmark no site da OpenAI repositório GitHub de provas simplese fornece informações detalhadasArtigos de pesquisa.

Conceito de design da BrowseComp

O BrowseComp foi originalmente projetado para preencher uma lacuna nos testes de benchmark existentes. Embora tenha havido vários benchmarks para avaliar os recursos de recuperação de informações no passado, a maioria deles se baseou em perguntas relativamente simples que podem ser facilmente resolvidas pelos modelos de linguagem existentes, e o BrowseComp se concentra em perguntas complexas que exigem pesquisas aprofundadas e raciocínio criativo para encontrar as respostas.

Aqui estão alguns exemplos de problemas no BrowseComp:

- Exemplo de pergunta 1Entre 1990 e 1994, quais times de futebol jogaram em partidas com árbitros brasileiros nas quais houve quatro cartões amarelos (dois para cada time), três dos quais foram emitidos no segundo tempo, e quatro substituições foram feitas durante a partida, uma das quais devido a uma contusão nos primeiros 25 minutos do jogo?

- resposta de referênciaIrlanda x Romênia

- Exemplos de perguntas 2Descrição: Identifique um personagem fictício que ocasionalmente quebra a quarta parede para interagir com o público, é conhecido por seu humor e tem um programa de televisão que foi ao ar entre as décadas de 1960 e 1980 e teve menos de 50 episódios.

- resposta de referênciaHomem de plástico

- Exemplos de perguntas 3Favor identificar o título de um artigo científico apresentado em uma conferência da EMNLP entre 2018 e 2023, no qual o primeiro autor tenha se formado na Dartmouth College e o quarto autor tenha se formado na University of Pennsylvania.

- resposta de referência:: Fundamentals of Breadmaking: The Science of Bread

Recursos exclusivos do BrowseComp

- desafiadorOs problemas do BrowseComp são cuidadosamente projetados para garantir que os modelos existentes não possam ser resolvidos em um curto período de tempo. Os instrutores humanos realizam várias rodadas de validação ao criar os problemas para garantir que eles sejam difíceis. Abaixo estão alguns dos critérios usados para avaliar a dificuldade dos problemas:

- Não resolvido pelos modelos existentesOs instrutores foram solicitados a verificar se o GPT-4o (com e sem navegação), o OpenAI o1 e as versões anteriores do modelo de pesquisa profunda não abordavam esses problemas.

- Não disponível nos resultados da pesquisaObservação: Foi solicitado aos instrutores que fizessem cinco pesquisas simples no Google e verificassem se as respostas não estavam nas primeiras páginas dos resultados da pesquisa.

- Os seres humanos não conseguem resolver isso em dez minutos.Descrição: Os instrutores foram solicitados a criar problemas que fossem difíceis o suficiente para que outra pessoa não conseguisse resolvê-los em dez minutos. Em alguns dos problemas, um segundo instrutor tenta encontrar a resposta. Os instrutores que criaram problemas que foram resolvidos em mais de 40% foram solicitados a revisar seus problemas.

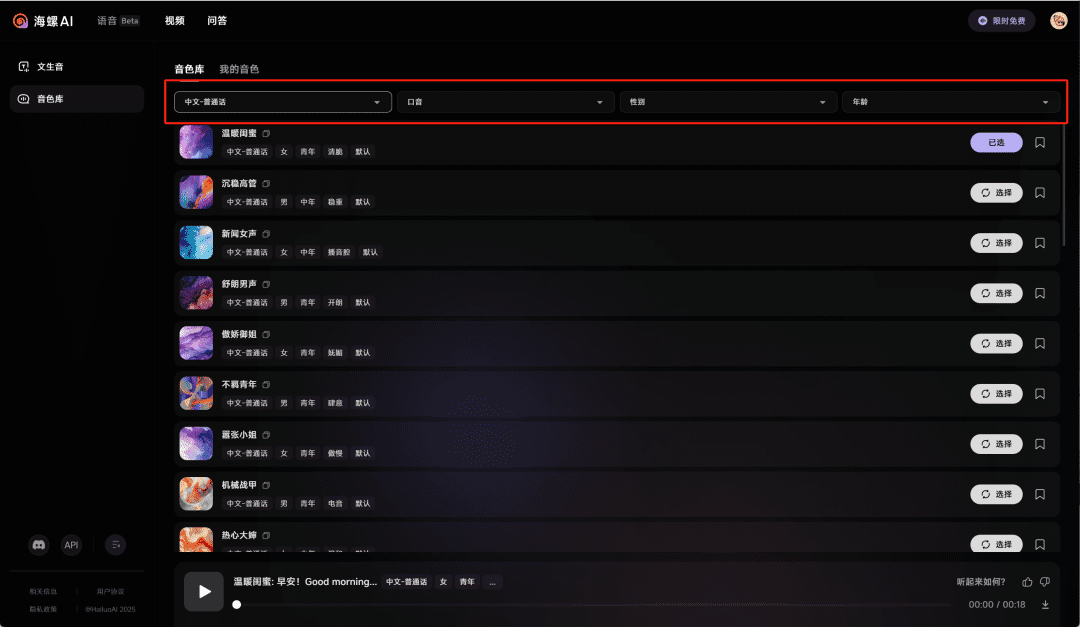

Figura 2: Distribuição de tópicos no BrowseComp. A distribuição de tópicos no BrowseComp é aprimorada pelas dicas do ChatGPT O modelo categorizou os temas de cada pergunta ex post. - Fácil de verificar: Apesar da dificuldade das perguntas, as respostas geralmente são curtas e claras, e facilmente verificáveis por respostas de referência. Esse design torna a avaliação comparativa desafiadora sem ser injusta.

- variegação:: As perguntas do BrowseComp abrangem uma ampla variedade de áreas, incluindo televisão e cinema, ciência e tecnologia, arte, história, esportes, música, videogames, geografia e política. Essa diversidade garante que os testes sejam abrangentes.

Avaliação do desempenho do modelo

Os testes no BrowseComp mostraram que o desempenho dos modelos existentes é misto:

- GPT-4o responder cantando GPT-4.5 Sem a função de navegação, a precisão é próxima de zero. Mesmo com a função de navegação ativada, a precisão do GPT-4o só melhora de 0,6% para 1,9%, o que mostra que a função de navegação sozinha não é suficiente para resolver problemas complexos.

- OpenAI o1 O modelo não tem uma função de navegação, mas atinge uma precisão de 9,91 TP3T devido à sua forte capacidade de raciocínio, o que sugere que algumas respostas podem ser obtidas por meio do raciocínio de conhecimento interno.

- Pesquisa profunda da OpenAI O modelo teve o melhor desempenho, com uma precisão de 51,51 TP3T. O modelo pesquisa a rede de forma autônoma, avaliando e sintetizando informações de várias fontes e adaptando sua estratégia de pesquisa para permitir que ele resolva problemas que, de outra forma, não poderiam ser resolvidos.

análise aprofundada

1. erros de calibração

Embora o modelo da Deep Research tenha um bom desempenho em termos de precisão, ele tem um alto erro de calibração. Isso significa que o modelo não tem uma avaliação precisa de sua própria incerteza ao dar respostas incorretas com confiança. Esse fenômeno é particularmente evidente em modelos com recursos de navegação, o que sugere que o acesso a ferramentas da Web pode aumentar a confiança do modelo em respostas incorretas.

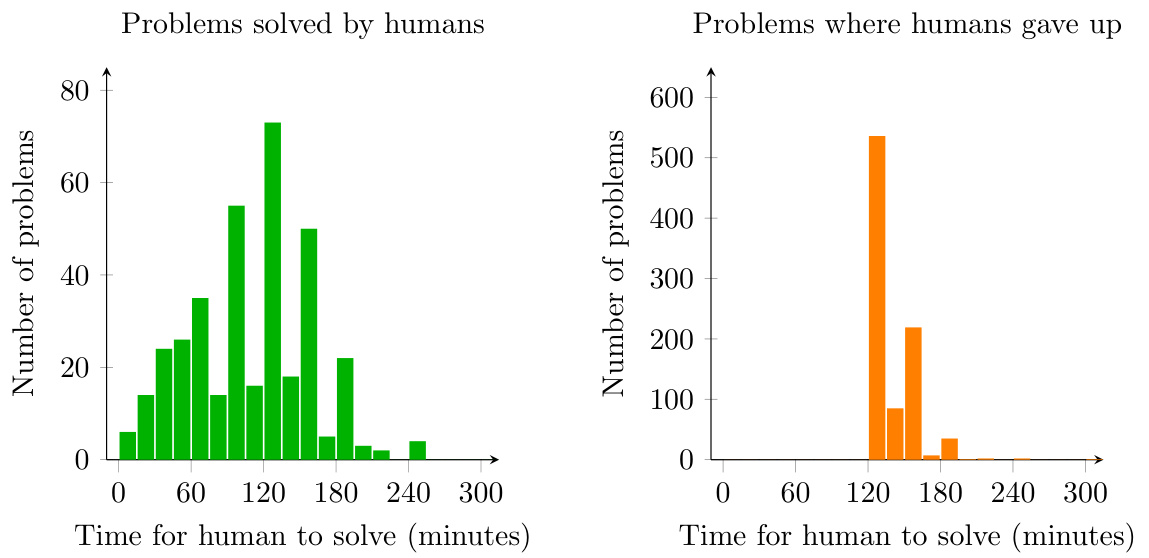

Figura 3: Histograma mostrando o tempo que um humano leva para resolver um problema de BrowseComp ou desistir. Os instrutores só podiam desistir depois de tentar resolver o problema por pelo menos duas horas.

2. impacto dos recursos de computação

Os resultados do teste mostram que o desempenho do modelo melhora gradualmente à medida que os recursos computacionais são aumentados no momento do teste. Isso sugere que os problemas do BrowseComp exigem uma quantidade significativa de esforço de pesquisa e raciocínio, e que mais recursos computacionais podem melhorar significativamente o desempenho do modelo.

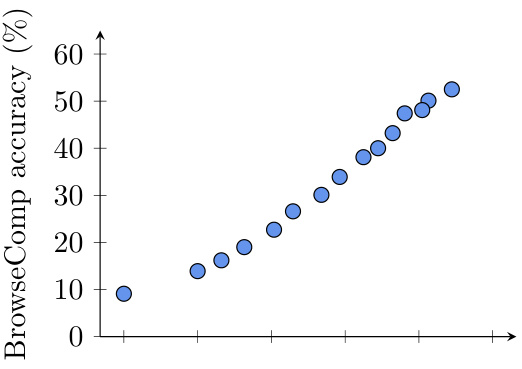

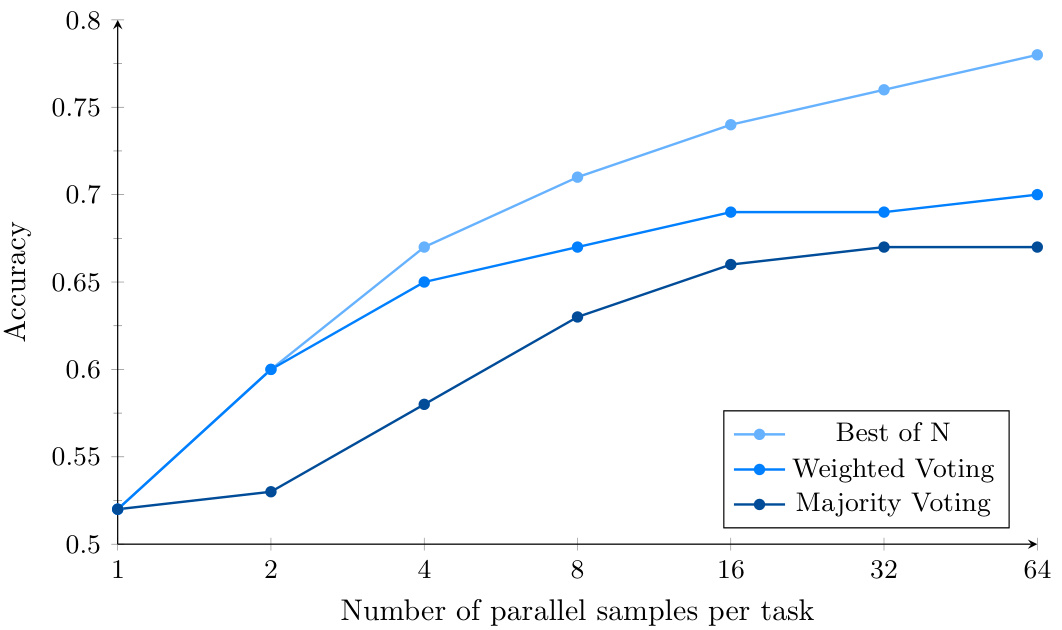

Figura 4: Desempenho do BrowseComp para Deep Research ao usar amostragem paralela e votação baseada em confiança. O esforço computacional adicional melhora ainda mais o desempenho do modelo com o Best-of-N.

3. estratégias de agregação

O desempenho do modelo pode ser melhorado ainda mais por meio de várias tentativas e usando diferentes estratégias de agregação (por exemplo, votação majoritária, votação ponderada e melhor escolha). 15% a 25%. onde a estratégia de melhor escolha tem o melhor desempenho, indicando que o modelo Deep Research tem um alto nível de precisão na identificação da resposta correta.

chegar a um veredicto

O lançamento do BrowseComp oferece uma nova dimensão na avaliação de agentes de IA. Ele não apenas testa a capacidade de recuperação de informações de um modelo, mas também examina sua persistência e criatividade em problemas complexos. Embora o desempenho dos modelos existentes no BrowseComp ainda precise ser aprimorado, o lançamento desse teste de benchmark, sem dúvida, avançará a pesquisa no campo da IA.

No futuro, à medida que mais modelos forem envolvidos e a tecnologia avançar, podemos esperar que o desempenho dos agentes de IA no BrowseComp continue a melhorar, levando, em última análise, a agentes de IA mais confiáveis e fidedignos.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...