JavaでOllama APIを使う

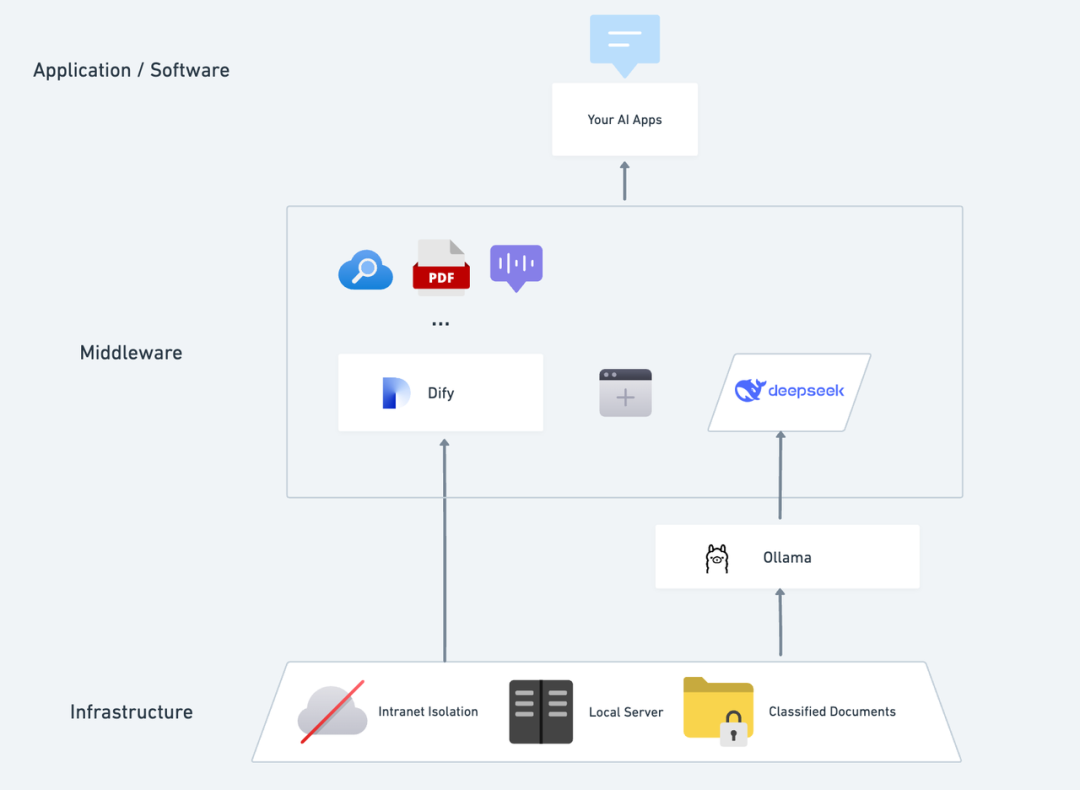

この記事では オーラマ このドキュメントは、開発者が素早くスピードアップし、Ollamaの機能を最大限に活用できるように設計されています。アプリケーションから直接Ollama APIを呼び出すことも、Spring AIコンポーネントからOllamaを呼び出すこともできます。このドキュメントを学ぶことで、Ollamaをプロジェクトに簡単に統合することができます。

I. 環境準備

JavaでOllama APIを使うには、以下の環境とツールを用意してください:

- Java開発キット(JDK) JDKバージョン1.8以降をインストールしてください。

- 建築ツール プロジェクトの依存関係を管理するために、MavenやGradleなどがある。

- HTTPクライアント・ライブラリ Apache HttpClientやOkHttpなど、適切なHTTPクライアント・ライブラリを選択する。

オッラマの直接使用

Ollamaをあなたのアプリケーションに簡単に統合できる、サードパーティが開発したコンポーネントがgithubにたくさんある。 アセデム 例えば、以下の3つのステップを踏むことができる(ここではプロジェクト管理のためにmavenを使用):

- pom.xmlにollama依存性を追加する。

<repositories>

<repository>

<id>jitpack.io</id>

<url>https://jitpack.io</url>

</repository>

</repositories>

<dependencies>

<dependency>

<groupId>com.github.Asedem</groupId>

<artifactId>OllamaJavaAPI</artifactId>

<version>master-SNAPSHOT</version>

</dependency>

</dependencies>

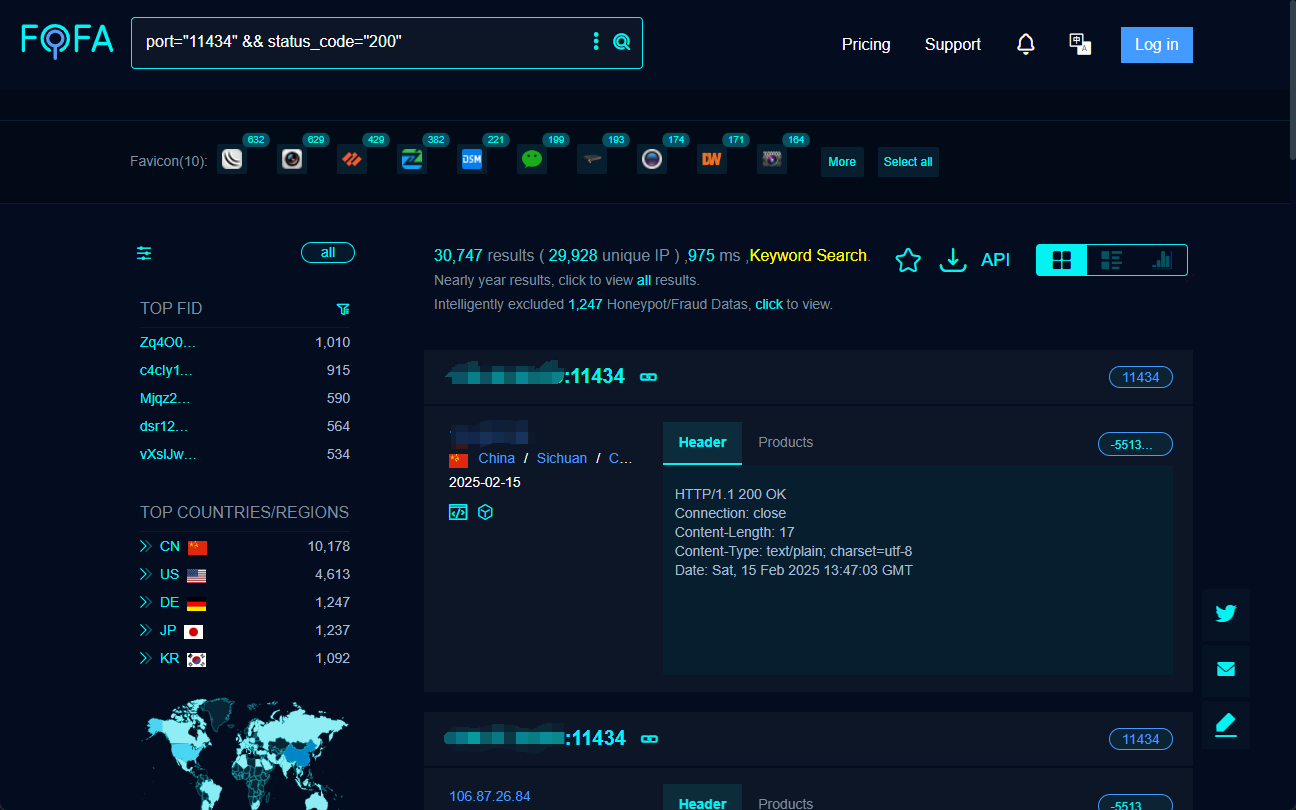

- Ollamaの初期化

// 默认情况下,它将连接到 localhost:11434

Ollama ollama = Ollama.initDefault();

// 对于自定义值

Ollama ollama = Ollama.init("http://localhost", 11434);

- オッラマの使用

- 対話

String model = "llama2:latest"; // 指定模型

String prompt = "为什么天空是蓝色的?"; // 提供提示

GenerationResponse response = ollama.generate(new GenerationRequest(model, prompt));

// 打印生成的响应

System.out.println(response.response());

- 現地モデル一覧

List<Model> models = ollama.listModels(); // 返回 Model 对象的列表

- モデル情報の表示

ModelInfo modelInfo = ollama.showInfo("llama2:latest"); // 返回 ModelInfo 对象

- レプリケーション・モデル

boolean success = ollama.copy("llama2:latest", "llama2-backup"); // 如果复制过程成功返回 true

- モデルの削除

boolean success = ollama.delete("llama2-backup"); // 如果删除成功返回 true

春のAIでオラマを呼び出す

春のAI入門

Spring AIは、AIエンジニアリングのために設計されたアプリケーションフレームワークです。主な機能は以下の通り:

- AIプロバイダー間のAPIサポート:Spring AIは、複数のAIサービスプロバイダーのチャット、テキストから画像への変換、組み込みモデルとのインタラクションをサポートするポータブルなAPIセットを提供します。

- 同期APIとストリーミングAPIのオプション:フレームワークは同期APIとストリーミングAPIをサポートし、開発者に柔軟なインタラクション・メソッドを提供する。

- モデル固有機能へのアクセス:開発者が設定パラメータを介してモデル固有機能にアクセスできるようにすることで、よりきめ細かな制御が可能になります。

Spring AIを使う

- pom.xmlにSpring AI依存性を追加する

<dependencies>

<dependency>

<groupId>io.springboot.ai</groupId>

<artifactld>spring-ai-ollama-spring-boot-starter</artifactld>

<version>1.0.3</version>

</dependency>

</dependencies>

注:IDEAを使用してプロジェクトを作成する場合は、直接依存関係を指定することができます、システムは自動的に次の図に示すように、手動で修正する必要はありませんpom.xmlファイルを完了します:

- Spring AIとOllamaの設定をSpring Bootアプリケーションの設定ファイルに追加する。例

ai:

ollama:

base-url: http://localhost:11434

chat:

options:

model: llama3.1:latest

- テキスト生成や対話にはOllamaを使う:

まず、Ollama APIを呼び出すSpring Bootコントローラを作成する:

import jakarta.annotation.Resource;

import org.springframework.ai.chat.model.ChatResponse;

import org.springframework.ai.chat.prompt.Prompt;

import org.springframework.ai.ollama.OllamaChatModel;

import org.springframework.ai.ollama.api.OllamaOptions;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

@RestController

public class OllamaController {

@Resource

private OllamaChatModel ollamaChatModel;

@RequestMapping(value = "/ai/ollama")

public Object ollama(@RequestParam(value = "msg")String msg){

ChatResponse chatResponse=ollamaChatModel.call(new Prompt(msg, OllamaOptions.create()

.withModel("llama3.1:latest")//指定使用哪个大模型

.withTemperature(0.5F)));

System.out.println(chatResponse.getResult().getOutput().getContent());

return chatResponse.getResult().getOutput().getContent();

}

}

次にプロジェクトを実行し、ブラウザにURLを入力する。 http://localhost:8080/ai/ollama?msg="提示词" 結果は以下の通り:

参照文献

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません