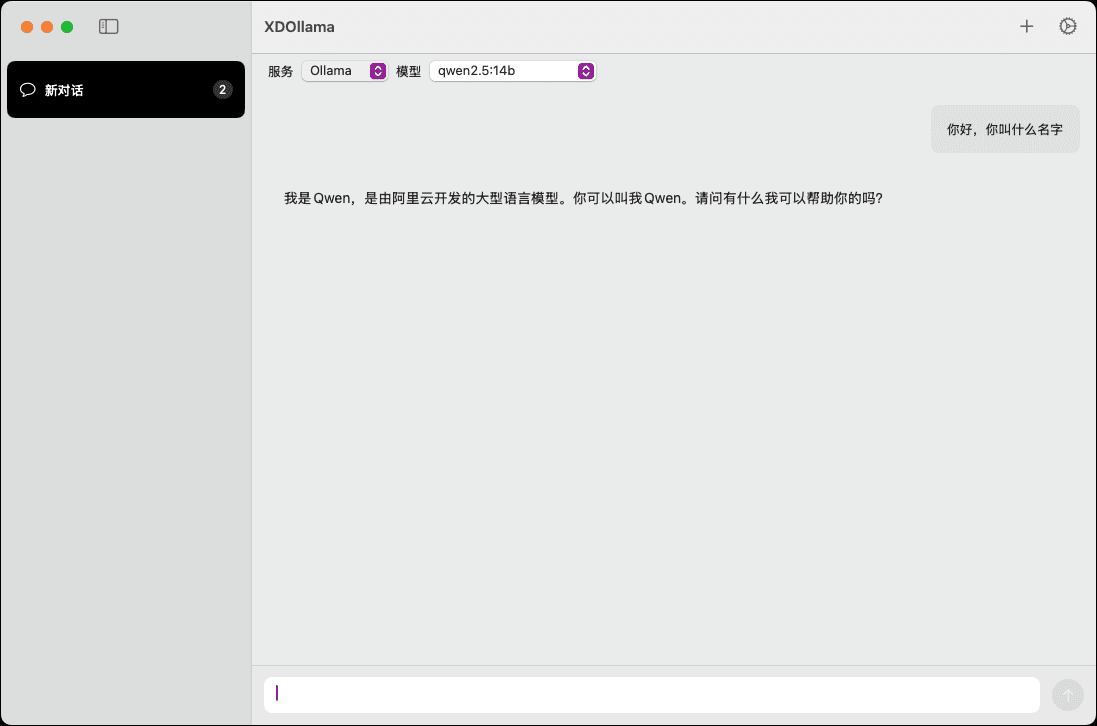

XDOllama: MacOS上でOllamaを素早く呼び出すためのAIモデル・インターフェース。

はじめに

XDOllamaは、MacOSユーザー向けに設計されたデスクトップ・アプリケーションで、Ollama、Dify、XDOllamaを素早く呼び出すことができます。 シンファレンス 簡素化されたインターフェースと操作プロセスにより、ユーザーはローカルまたはオンラインのAIモデルを簡単に呼び出すことができます。このアプリケーションは、ユーザーが簡素化されたインターフェースと操作プロセスを通じて、ローカルまたはオンラインのAIモデルを簡単に呼び出すことを可能にし、作業効率とエクスペリエンスを向上させます。

機能一覧

- ローカル オーラマ モデリング

- オンライン・オラマ・モデルを呼ぶ

- ローカルXinferenceモデルを呼び出す

- オンラインXinferenceモデルを呼び出す

- ローカル ダイファイ アプライアンス

- オンラインDifyアプリケーションの呼び出し

- 複数のAIフレームワークをサポート

- 使いやすいインターフェースデザイン

- 効率的なモデル呼び出し速度

ヘルプの使用

設置プロセス

- DMGファイルをダウンロードする。

- ダウンロードしたDMGファイルをダブルクリックして開きます。

- XDOllama.appをアプリケーションフォルダにドラッグします。

- インストールが完了したら、アプリケーションを開いてください。

使用ガイドライン

- XDOllamaアプリケーションを開きます。

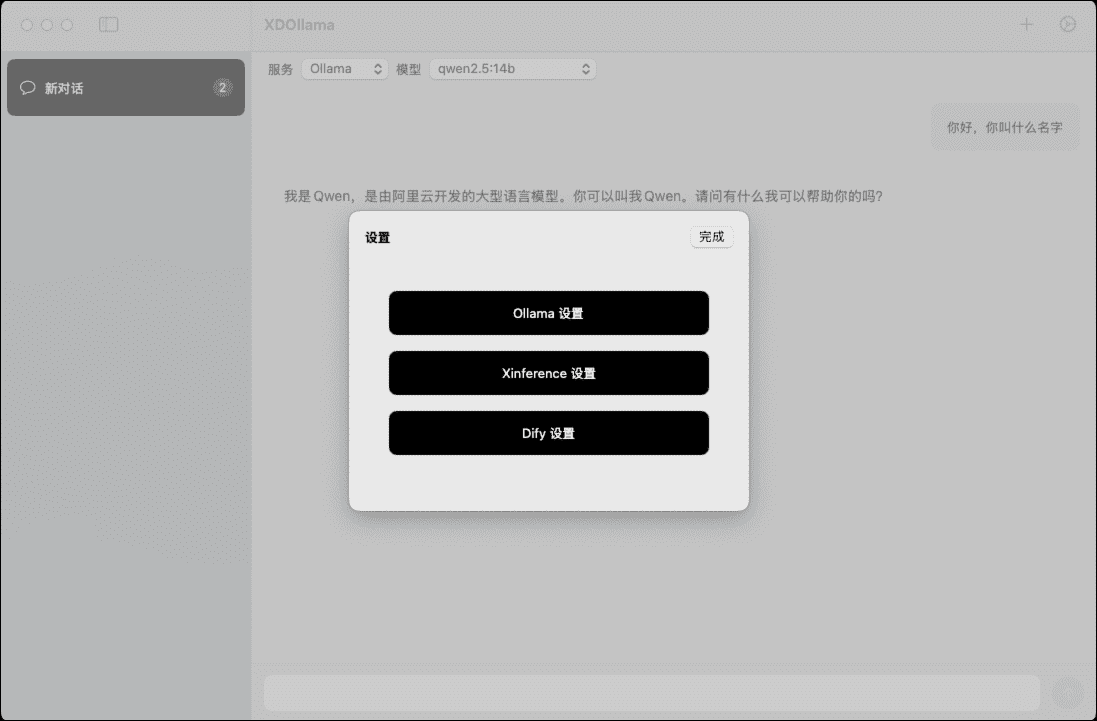

- 呼び出すAIモデル(Ollama、Dify、Xinference)を選択します。

- 通話方法(ローカルまたはオンライン)を選択します。

- プロンプトに従って、関連するパラメータと設定を入力します。

- Call "ボタンをクリックし、モデルがロードされ実行されるのを待つ。

- モデル出力の表示と使用

詳細な機能操作の流れ

地元オッラマのモデルを呼び出す

- メイン画面から「Ollama」を選択。

- ローカル」通話方法を選択する。

- モデルのパスとパラメータを入力する。

- Call "ボタンをクリックし、モデルがロードされるのを待つ。

- モデルの出力を見る。

オンライン・オラマ・モデルを呼ぶ

- メイン画面から「Ollama」を選択。

- オンライン」の通話方法を選択する。

- オンラインモデルのURLとパラメータを入力します。

- Call "ボタンをクリックし、モデルがロードされるのを待つ。

- モデルの出力を見る。

ローカルXinferenceモデルを呼び出す

- メイン画面で「Xinference」を選択。

- ローカル」通話方法を選択する。

- モデルのパスとパラメータを入力する。

- Call "ボタンをクリックし、モデルがロードされるのを待つ。

- モデルの出力を見る。

オンラインXinferenceモデルを呼び出す

- メイン画面で「Xinference」を選択。

- オンライン」の通話方法を選択する。

- オンラインモデルのURLとパラメータを入力します。

- Call "ボタンをクリックし、モデルがロードされるのを待つ。

- モデルの出力を見る。

ローカルDifyアプリケーションの呼び出し

- メイン画面から「Dify」を選択。

- ローカル」通話方法を選択する。

- アプリケーションのパスとパラメータを入力する。

- Call "ボタンをクリックし、アプリケーションがロードされるのを待つ。

- アプリケーションの出力を見る。

オンラインDifyアプリケーションの呼び出し

- メイン画面から「Dify」を選択。

- オンライン」の通話方法を選択する。

- オンライン申請のURLとパラメータを入力します。

- Call "ボタンをクリックし、アプリケーションがロードされるのを待つ。

- アプリケーションの出力を見る。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません