アテンション・メカニズム(注意のメカニズム)とは何か?

注意メカニズムの定義

注意メカニズム(Attention Mechanism)は、人間の認知プロセスを模倣する計算技術で、当初は機械翻訳の分野で応用され、後にディープラーニングの重要な一部となった。核となる考え方は、人間が読書をする際に自動的にキーワードに注目するように、情報を処理する際にモデルが入力の関連部分に動的に注目するようにすることである。入力要素の重要性は、異なる重みを割り当てることで表現され、重みが大きいほど強い注意を表す。技術的な実装としては、アテンション関数はクエリをキーと値のペアのセットにマッピングし、重み付けされた和として出力する。

最も一般的な実装はドット積アテンションであり、アテンション分布はクエリーとキーのドット積を計算することで得られる。注意メカニズムの成功は、従来のリカレント・ニューラル・ネットワークに存在した長距離依存性の問題を解決し、長いデータ列を効率的に扱う能力にある。開発とともに、アテンション・メカニズムは当初のエンコーダー・デコーダー・アーキテクチャから、トランスフォーマー・アーキテクチャのコア・コンポーネントとなったセルフ・アテンションなどの形態に拡張されてきた。この技術は機械翻訳の品質を向上させただけでなく、画像処理、音声認識など多くの分野で広く利用されており、重要な情報を捉えるモデルの能力を大幅に向上させている。

注意メカニズムの歴史的起源

- 認知心理学の基礎注意のメカニズムという概念は、人間の認知心理学の研究にそのルーツがある。早くも19世紀には、心理学者のウィリアム・ジェームズは、注意とは「心が、同時に存在する数多くの対象や思考のうちの1つに集中するプロセス」であると提唱した。この人間の選択的注意のメカニズムは、計算モデルの理論的基礎を提供する。

- 計算モデリングの初期の試み1990年代、研究者たちはニューラルネットワークに注意という考え方を導入し始めた。1997年にジョシュア・ベンジオのチームによって提案されたアラインメント・モデルは、配列対配列学習の性能を向上させるための注意メカニズムのプロトタイプとして見ることができる。

- 機械翻訳のブレークスルー2014年、バフダナウらはニューラル機械翻訳において初めて注意メカニズムを実装し、ソフトアライメントによって長文の翻訳品質を大幅に改善することに成功した。この研究は、自然言語処理の分野における注意メカニズムの幅広い応用への道を開いた。

- 変圧器アーキテクチャの革新2017年、ヴァスワニらは論文『Attention Is All You Need』を発表した。この論文では、従来のリカレント・ニューラル・ネットワークの構造を排し、アテンション・メカニズムに完全に基づいたトランスフォーマー・アーキテクチャを構築し、新たなパフォーマンス・ベンチマークを生み出している。

- クロス・ドメインの拡大研究の深化に伴い、アテンションメカニズムは自然言語処理からコンピュータビジョン、音声認識、レコメンダーシステムなど様々な分野に拡張され、深層学習モデルの重要な一部となっている。

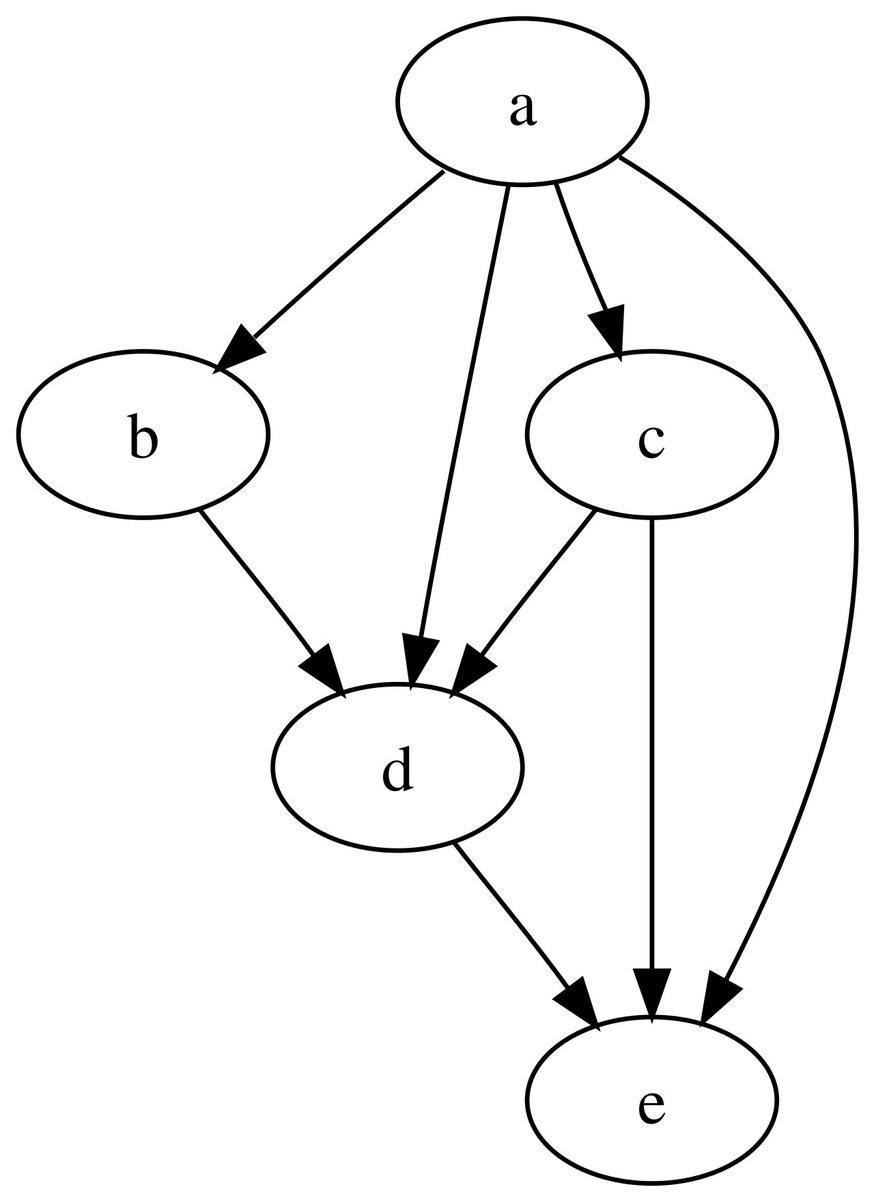

注意のメカニズム

- 入力信号段入力シーケンスはまずベクトル表現に変換され、各単語や要素は高次元ベクトルに対応する。これらのベクトルには、要素そのものに関する情報と、シーケンス内での位置に関する情報の両方が含まれている。

- クエリ・キーバリュー・フレームワークアテンション・メカニズムでは、クエリー(Query)、キー(Key)、バリュー(Value)という3つの要素を使用する。Query(クエリ)はその時点で注目されるべきものを表し、Key(キー)は比較される対象を表し、Value(値)は実際に抽出される情報である。

- 類似性の計算注目度スコアは、クエリと各キーの類似度を計算することで得られる。一般的に使用される類似度の計算方法には、ドット積法、加算注目度法などがある。

- 体重正規化ソフトマックス関数を用いてアテンション・スコアを確率分布に変換し、すべての重みの和が1になるようにして、アテンション重み行列を形成する。

- 加重合計出力最後に、注意の重みは、対応する値ベクトルと乗算され合計され、重み付き出力表現が得られる。この出力は、入力シーケンスの中で最も関連性の高い情報を集約したものである。

主な注意メカニズムの種類

- ソフトな注意とハードな注意ソフトな注意は、入力シーケンス全体に連続的な重みを割り当てるもので、微分可能で訓練が容易である。ハードな注意は、特定の場所にのみ焦点を当てるもので、計算効率は良いが微分可能ではなく、強化学習などの方法による訓練が必要である。

- グローバルな注目とローカルな注目大局的注意はすべての入力位置を考慮し、計算オーバーヘッドは大きいが精度は高い。局所的注意はウィンドウ内のいくつかの位置にのみ焦点を当て、精度と効率のバランスをとる。

- 自己注意メカニズム自己注意は、内部注意としても知られ、シーケンス内の各位置が、シーケンス内のすべての位置に対する注意の重みを計算することを可能にする。

- ロング・アテンション複数の注意ヘッドを並列化し、モデルが異なる表現部分空間の情報に同時に注意できるようにすることで、モデルの表現力と複数の関係を捉える能力を高める。

- 分注2つの異なるシーケンス間で使用され、一方のシーケンスがクエリーとして機能し、もう一方のシーケンスがキーと値を提供する。

アテンション・メカニズム適用のシナリオ

- 機械翻訳システムニューラル機械翻訳では、ターゲット言語の単語を生成する際に、モデルが自動的にソース言語の文の関連部分に焦点を当てることができるアテンションメカニズムによって、長い文の翻訳品質が大幅に向上します。

- 画像認識と処理コンピュータビジョンにおける注意メカニズムは、画像分類、ターゲット検出、画像生成タスクにおいて、モデルが画像の重要な領域に集中することを可能にし、良い結果をもたらしている。

- 音声認識技術音声認識における音声フレームと出力テキストの位置合わせ、異なる長さの入力シーケンスと出力シーケンスの処理、および認識精度の向上のためのアテンションメカニズム。

- 推奨されるシステムの最適化ユーザーの一連の行動を分析することで、アテンション・メカニズムがユーザーの興味の変化を捉え、推薦予測に最も重要な過去の行動に焦点を当てることができ、推薦精度が向上する。

- 医療診断機器医療画像解析において、注意メカニズムは、モデルの解釈可能性を向上させながら、モデルが病変部に焦点を当て、医師に意思決定支援を提供するのを助ける。

アテンション・メカニズムの有利な特徴

- 並列計算機能シーケンスを逐次的に処理するリカレント・ニューラル・ネットワークとは異なり、アテンション・メカニズムはすべてのポジションのアテンション・ウエイトを並列に計算することができるため、トレーニングと推論の効率が劇的に向上する。

- 長距離依存モデリングこれにより、長いシーケンスにおける依存性の捕捉問題を効果的に解決し、従来のRNNの勾配消失問題を克服することができる。

- 解釈可能性の向上注意の重み分布は、モデルの意思決定プロセスに対する視覚的な洞察を提供し、研究者がモデルの注意の焦点を理解するのに役立ち、モデルの透明性を高める。

- 柔軟性 建築設計主要構造を変更することなく、様々なニューラルネットワークアーキテクチャに簡単に統合できるため、モデル設計の可能性が広がる。

- マルチモーダルなフュージョン機能異なるモーダルデータ間の相互作用に精通し、テキスト、画像、音声など複数の情報を効果的に統合できる。

アテンション・メカニズム実現への課題

- 計算複雑性の問題注意メカニズムの計算の複雑さは、シーケンスの長さ(2乗ステップ)に比例して大きくなり、長いシーケンスを扱うときには計算量とメモリの制約に直面する。

- 膨大なメモリフットプリントアテンション・ウェイト・マトリクスを保存する必要があるため、シーケンスが長くなるとメモリ要件が劇的に増加し、ハードウェア・デバイスに大きな負荷がかかる。

- 過剰なスムージング現象アテンションウェイトが均等に配分されすぎていることがあり、その結果、モデルが重要な情報に効果的にフォーカスできず、モデルのパフォーマンスに影響を及ぼしている。

- トレーニングの不安定さ特にマルチヘッド注意では、注意ヘッド間で学習速度に一貫性がないため、ハイパーパラメータの微調整が必要となる。

- 位置情報のエンコーディングセルフアテンションメカニズムは、それ自体では位置を認識しないため、シーケンス順序情報を注入するために追加の位置コーディングが必要である。

アテンション・メカニズム改善の方向性

- 効率的な注意のデザイン研究者たちは、計算の複雑さを軽減し、モデルがより長いシーケンスを扱えるようにするために、スパース注意、ローカル注意などの複数のバリエーションを提案してきた。

- メモリ最適化ソリューションチャンキングや勾配チェックポイントのような技術を用いてメモリフットプリントを削減し、リソースに制約のある環境でも注意メカニズムが動作できるようにする。

- 構造革新の探求相対位置コーディングや回転位置コーディングなどの新しい手法を導入し、シーケンス内の位置関係や情報をより適切に扱えるようにする。

- マルチスケールアテンション異なる粒度の注意メカニズムを組み合わせることで、ローカルな詳細とグローバルなコンテキストの両方に焦点を当て、モデルのパフォーマンスを向上させる。

- 理論的基礎研究注意メカニズムの理論的分析を強化し、その仕組みと限界を理解し、より良いモデル設計を導く。

注意メカニズムの今後の発展

- 統一されたクロスモーダルアーキテクチャ注意メカニズムは、マルチモーダルデータを統一的に処理するための基本的な枠組みとして期待されており、マルチモーダルAIの開発を牽引する。

- 神経科学にインスパイアされたヒトの注意システムの神経メカニズムをさらに活用し、より生物学的に健全な注意のモデルを開発する。

- 適応的注意タスクの難易度に応じて注意の範囲と精度を自動的に調整し、計算効率を向上させる知的システムの開発

- 解釈可能性の向上注意メカニズムが提供する説明をより正確で信頼できるものにするために、視覚化技術と説明方法を組み合わせる。

- エッジデバイスの展開モデル圧縮と最適化により、アテンション・ベースのモデルをモバイルおよびIoTデバイス上で効率的に実行可能にする

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません