VITA: リアルタイム視覚・音声インタラクションのためのオープンソース・マルチモーダル大規模言語モデル

はじめに

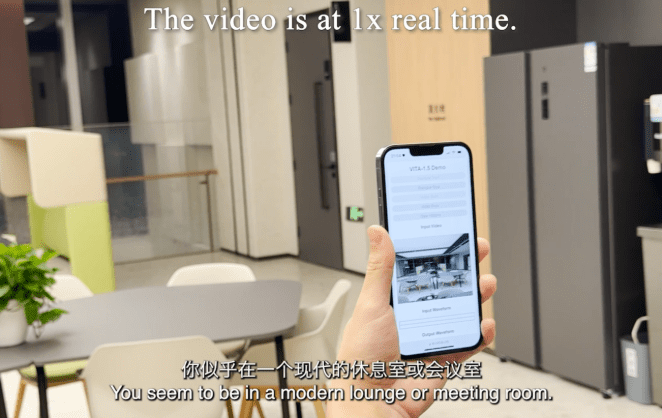

VITAは、真の完全なマルチモーダルインタラクションを実現する能力を開拓する、オープンソースの主要な対話型マルチモーダル大規模言語モデリングプロジェクトです。プロジェクトは2024年8月にVITA-1.0を発表し、初のオープンソース対話型マルチモーダル大規模言語モデルの先駆者となりました。2024年12月、プロジェクトはメジャーアップグレードバージョンのVITA-1.5を発表し、インタラクション体験とパフォーマンスを大幅に改善しました。VITAモデルは、画像、ビデオ、音声などのマルチモーダル入出力をサポートし、リアルタイムインタラクション機能を備え、エンドツーエンドの音声インタラクションの待ち時間を4秒から1.5秒に大幅に短縮しました。VITAモデルは、画像、ビデオ、音声などのマルチモーダル入出力をサポートし、リアルタイム・インタラクション機能を備えているため、エンド・ツー・エンドの音声インタラクションの待ち時間を4秒から1.5秒に大幅に短縮し、ユーザー体験を大幅に改善します。完全なオープンソースプロジェクトとして、VITAは研究者や開発者がマルチモーダルAIを探求するための理想的なプラットフォームを提供します。

機能一覧

- マルチモーダル入力処理:画像、ビデオ、音声などの入力に対応

- リアルタイムの音声対話:エンド・ツー・エンドの音声対話の待ち時間はわずか1.5秒

- ビジュアル分析機能:強力な画像・映像の理解・分析機能

- 音声処理:音声認識と音声合成をサポート

- クロスモーダル理解:テキスト、画像、音声の知的相関を目指して

- オープンソースのサポート:トレーニングおよび推論コードはすべてオープンです。

- 事前学習済みモデル:複数のバージョンの事前学習済みモデルを利用可能

- 柔軟な導入オプション:複数のハードウェアプラットフォームの導入をサポート

VITA-1.5の概要

2024年8月12日、我々は以下を発表した。 VITA-1.0これは 初のオープンソース・インタラクティブ・オールインワン・マルチモーダル・マクロ言語モデル.そして今(2024年12月20日)、私たちはあなたに次の記事をお届けする。 新バージョンVITA-1.5!

VITA-1.5の新機能は?

を発表する。 VITA-1.5を発表した:

- インタラクションの待ち時間を大幅に短縮..エンド・ツー・エンドの音声インタラクションの待ち時間は、以前より長くなっている。 約4秒 削減 1.5秒ほぼ瞬時のインタラクションを可能にし、ユーザー体験を大幅に向上させる。

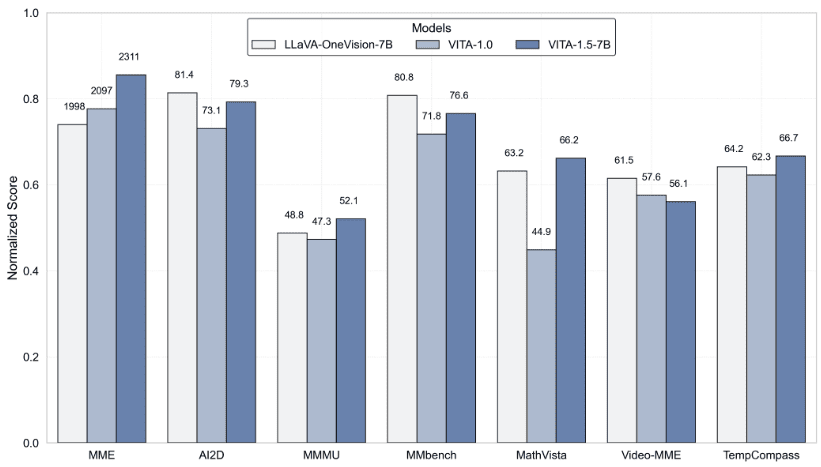

- マルチモーダル性能の向上.で エムエムイーそしてMMBench 歌で応える 数学ビスタ のようなマルチモーダルベンチマークにおける平均的なパフォーマンスである。 59.8 に引き上げる。 70.8.

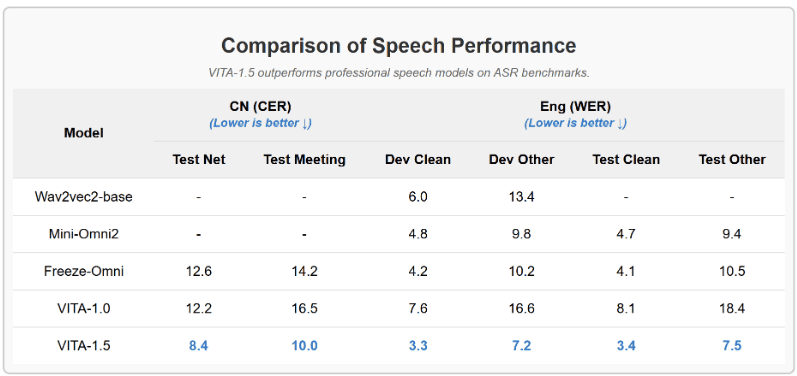

- 音声処理能力の強化..ASR WER(Word Error Rate, Test Other)は、従来の1.5倍から2.5倍に向上し、音声処理能力の新たなレベルを達成した。 18.4 に減少 7.5.さらに エンド・ツー・エンドTTSモジュール VITA-1.0のスタンドアロンTTSモジュールに代わるもので、大規模な言語モデルの埋め込みを入力として受け付ける。

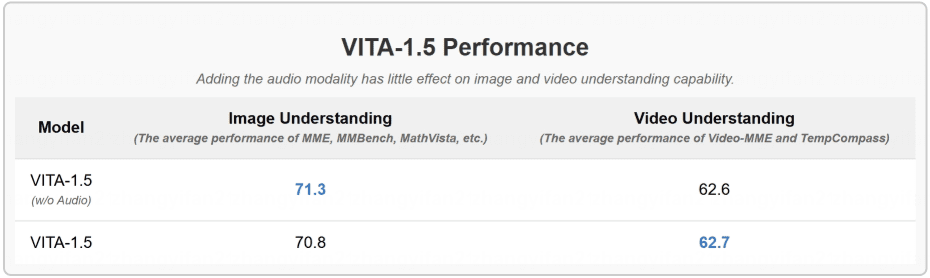

- 段階的トレーニング戦略.このように、音声モジュールの搭載は、他のマルチモーダル性能(視覚-言語)にはほとんど影響を与えない。画像理解の平均成績は71.3から70.8に低下しただけである。

結果

- 画像・映像理解ベンチマークテストの評価

- VITA-1.5、ASRベンチマークでプロフェッショナル音声モデルを上回る

- 音声モダリティを組み込んでも、画像や映像の理解にはほとんど影響がない。

ヘルプの使用

1.環境設定とインストール

1.1 基礎要件

- Python環境

- PyTorchフレームワーク

- CUDAサポート(GPUアクセラレーション推奨)

1.2 インストールの手順

# 克隆项目仓库

git clone https://github.com/VITA-MLLM/VITA.git

cd VITA

# 安装依赖

pip install -r requirements.txt

2.モデルの使用

2.1 訓練済みモデルをロードする:

from vita.model.builder import load_pretrained_model

from vita.conversation import conv_templates

from vita.util.mm_utils import get_model_name_from_path

# 加载模型

model_path = 'VITA/vita'

model_name = get_model_name_from_path(model_path)

tokenizer, model, image_processor, _ = load_pretrained_model(

model_path,

None,

model_name,

model_type='mixtral-8x7b',

device_map='auto'

)

2.2 オーディオ処理の構成:

# 初始化音频编码器

audio_encoder = model.get_audio_encoder()

audio_encoder.to(dtype=torch.float16)

audio_processor = audio_encoder.audio_processor

3.リアルタイム・インタラクティブ機能

- リアルタイムの音声入力と応答をサポート

- 統合された画像認識と解析

- 複数ラウンドの対話インタラクションをサポート

- 完全な対話テンプレート・システムの提供

4.高度な機能の使用

4.1 マルチモーダル入力処理:

- バッチ画像処理に対応

- ビデオストリームのリアルタイム分析

- オーディオ・ストリームの処理と合成

4.2 モデルのトレーニングと微調整:

- 完全なトレーニングスクリプトを提供

- 継続学習機能のサポート

- カスタムデータセットのトレーニングサポート

5.評価とテスト

- 主流のマルチモーダル評価ベンチマークをサポート

- 統合VLMEvalKit評価ツール

- 詳細なパフォーマンステスト指標を提供

6.注意事項

- モデル推論にはGPUを推奨

- 特に大規模なマルチモーダル入力を扱う場合は、メモリ管理に注意する。

- プロジェクトのアップデートを定期的にチェックし、最新の機能や最適化を確認する。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません