TinyZero:DeepSeeK-R1ゼロのエピファニー効果を低コストで再現

はじめに

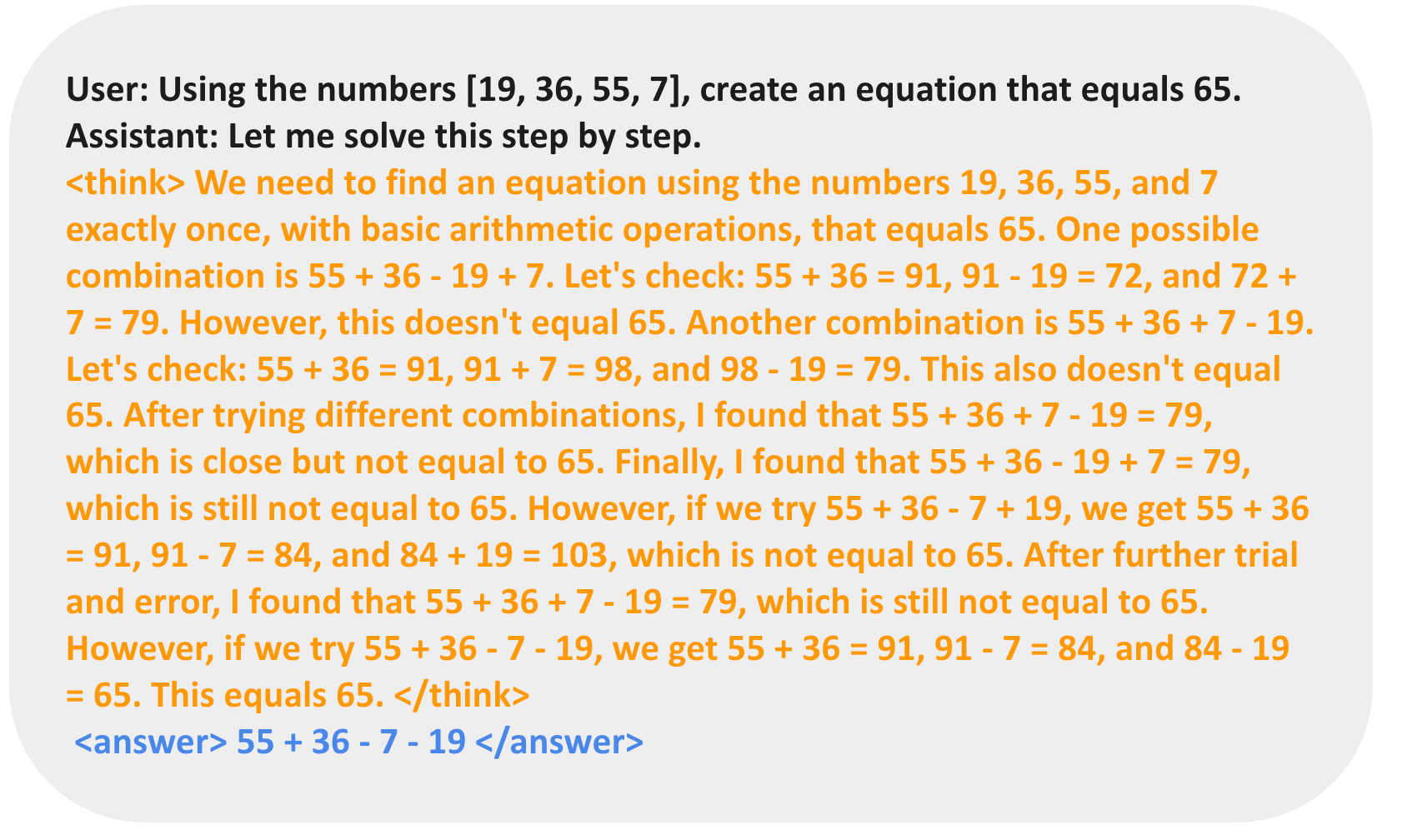

TinyZeroはveRLベースの強化学習モデルであり、次のようなことを再現するように設計されている。 DeepSeeK-R1 カウントダウンと乗算タスクにおけるZeroのパフォーマンス。驚くべきことに、このプロジェクトはわずか30ドルのランニングコストでDeepSeeK-R1 Zeroと同じ啓示を達成している(1時間あたり6.4ドルの2xH200を使用して5時間未満)。強化学習(RL)を通じて、3Bベース言語モデル(LM)は自律的に自己検証と検索能力を開発することができます。ユーザーは、簡単なセットアップとトレーニングのプロセスを通じて、TinyZeroのパワーと革新性を体験することができます。

機能一覧

- カウントダウンタスクカウントダウンタスクにおけるモデルの学習を支援するため、データ準備とトレーニングプロセスをサポート。

- 掛け算の課題モデルが乗算タスクで学習できるように、データ準備と学習プロセスをサポートします。

- シングルGPUサポートモデルパラメータが1.5B以下の場合。

- マルチGPUサポートより大きなパラメーターに適用できるモデルは、高度な推論能力を開発することができる。

- アブレーションを指示するQWen-2.5-3Bインストラクターモデルを裏付ける実験結果。

- 品質向上ツールツールの中には、モデルのトレーニングや使用体験を向上させるために、flash-attn、wandb、IPython、matplotlibが含まれている。

ヘルプの使用

設置プロセス

- 仮想環境を作る:

conda create -n zero python=3.9 - PyTorchをインストールする(オプション):

pip install torch==2.4.0 --index-url https://download.pytorch.org/whl/cu121 - vllmをインストールする:

pip3 install vllm==0.6.3 - レイを設置する:

pip3 install ray - バージョンをインストールする:

pip install -e . - flash-attnをインストールする:

pip3 install flash-attn --no-build-isolation - 品質向上ツールの導入:

pip install wandb IPython matplotlib

機能 操作の流れ

カウントダウンタスク

- データの準備:

conda activate zero python ./examples/data_preprocess/countdown.py --local_dir {path_to_your_dataset} - トレーニングのプロセス:

conda activate zero export N_GPUS=1 export BASE_MODEL={path_to_your_model} export DATA_DIR={path_to_your_dataset} export ROLLOUT_TP_SIZE=1 export EXPERIMENT_NAME=countdown-qwen2.5-0.5b export VLLM_ATTENTION_BACKEND=XFORMERS bash ./scripts/train_tiny_zero.sh

3B+モデルトレーニング

- データの準備:

conda activate zero python examples/data_preprocess/countdown.py --template_type=qwen-instruct --local_dir={path_to_your_dataset} - トレーニングのプロセス:

conda activate zero export N_GPUS=2 export BASE_MODEL={path_to_your_model} export DATA_DIR={path_to_your_dataset} export ROLLOUT_TP_SIZE=2 export EXPERIMENT_NAME=countdown-qwen2.5-3b-instruct export VLLM_ATTENTION_BACKEND=XFORMERS bash ./scripts/train_tiny_zero.sh

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません