Spark-TTS:自然な音声を生成する音声合成ツール

はじめに

Spark-TTSは、SparkAudioチームによって開発され、GitHubでホストされているオープンソースの音声合成(TTS)ツールです。高度なディープラーニング技術に基づいており、複数の言語と音声スタイルをサポートし、開発者、研究者、コンテンツ制作者に適しています。使いやすさと高品質な音声出力に重点を置いたこのプロジェクトは、事前に学習されたモデルと、ユーザーが必要に応じて音声特性を調整できるカスタムトレーニングオプションを提供している。詳細な公式ドキュメントはないが、GitHubリポジトリにあるコードとコミュニティサポートにより、ユーザーはすぐに使い始め、その機能を探求することができる。Spark-TTSのオープンソースの性質により、音声合成の分野において、特にパーソナライズされた音声ソリューションが必要とされるシナリオにおいて有用なリソースとなっている。

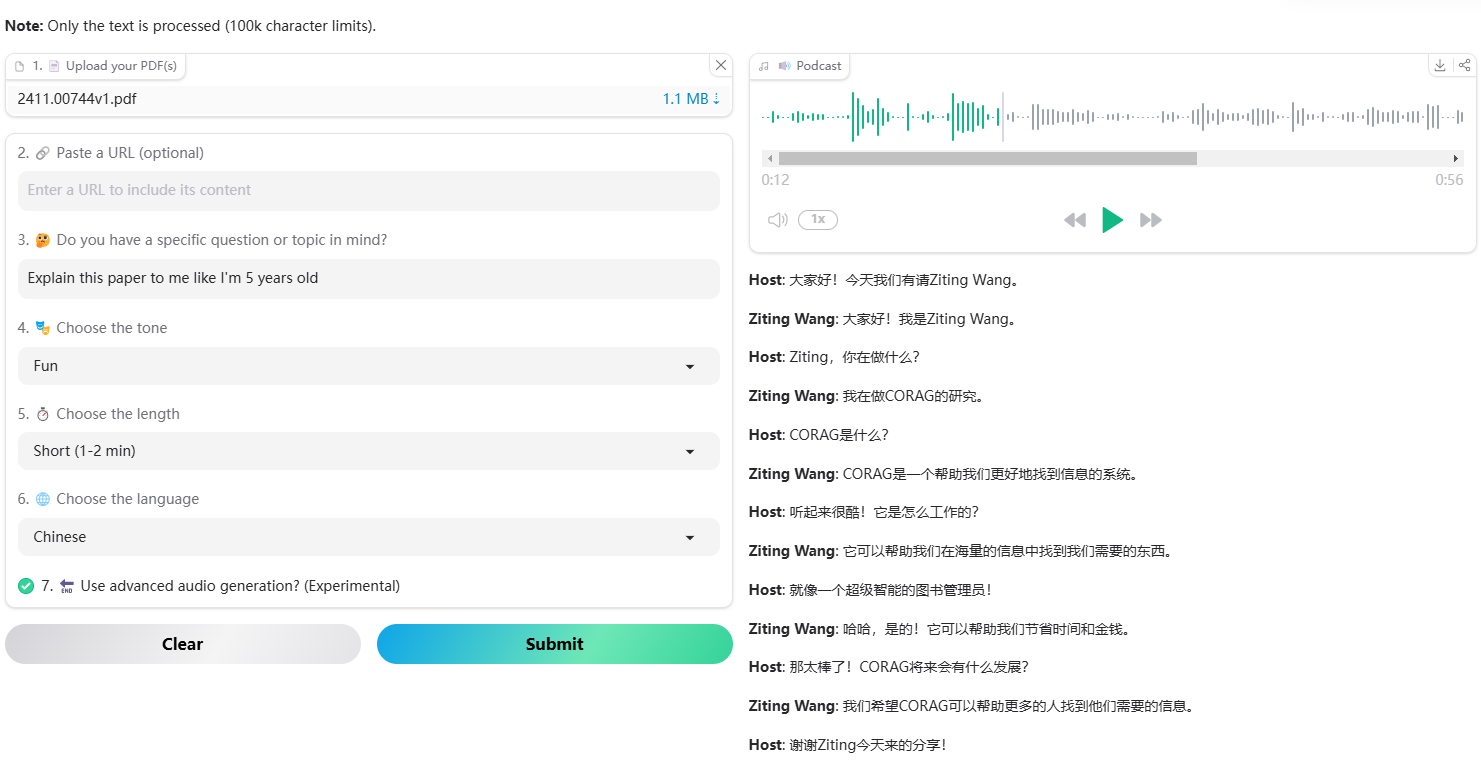

Spark-TTS音声生成インターフェース

Spark-TTSボイスクローニングインターフェース

機能一覧

- 音声合成入力されたテキストを素早く自然な音声に変換します。

- 訓練済みモデルのサポート既製のモデルを使用することで、ゼロから学習することなく音声を生成することができます。

- カスタマイズされたスピーチ・トレーニング自分のデータセットを使って、声のスタイルやイントネーションを調整しながらモデルを学習することができます。

- 複数の音声スタイル性別、速度、ピッチの異なる音声出力をサポート。

- オープンソースアクセスユーザーは自由にコードをダウンロードし、修正し、個々のニーズに合わせて最適化することができます。

- クロスプラットフォームの互換性汎用のプログラミング環境をベースとし、様々なOS上での動作をサポート。

ヘルプの使用

GitHub上のオープンソースプロジェクトであるSpark-TTSは、スタンドアロンのインストーラーやグラフィカルインターフェースを持っておらず、主に基本的なプログラミングスキルを持つユーザーを対象としています。以下は、ゼロから始めてその機能をフルに活用するための詳細なガイドです。

設置プロセス

Spark-TTSはGitHubベースのコードリポジトリなので、リポジトリをクローンして環境を設定して使用する必要があります。以下はその手順です:

- 環境準備

- コンピュータにPythonがインストールされていることを確認してください(推奨バージョン3.8以上)。

- GitHubからコードをダウンロードするためにGitをインストールします。Gitのウェブサイトからダウンロードしてインストールできます。

- (オプション)以下のような仮想環境ツールのインストール。

virtualenvプロジェクトの依存関係を分離する。

- クローン倉庫

- ターミナル(Windowsの場合はCMDまたはPowerShell、Mac/Linuxの場合はターミナル)を開く。

- 以下のコマンドを入力して、Spark-TTSリポジトリをローカルにクローンします:

git clone https://github.com/SparkAudio/Spark-TTS.git - クローニングが完了したら、プロジェクト・ディレクトリに移動する:

cd Spark-TTS

- 依存関係のインストール

- Spark-TTSは通常、ディープラーニングフレームワーク(PyTorchやTensorFlowなど)や音声処理ライブラリに依存している。のリポジトリをチェックしてください。

requirements.txtファイルがあれば)、以下のコマンドを実行して依存関係をインストールする:pip install -r requirements.txt - そうでなければ

requirements.txt一般的な依存関係には以下のようなものがある:pip install torch torchaudio numpy - お使いのハードウェア(CPUまたはGPU)に応じて、対応するバージョンのPyTorchをインストールしてください。

- Spark-TTSは通常、ディープラーニングフレームワーク(PyTorchやTensorFlowなど)や音声処理ライブラリに依存している。のリポジトリをチェックしてください。

- インストールの確認

- プロジェクトディレクトリに入ったら、簡単なテストスクリプトを実行します(リポジトリから提供されている場合)。例

python test.py - エラーが報告されなければ、環境は正常に設定されている。

- プロジェクトディレクトリに入ったら、簡単なテストスクリプトを実行します(リポジトリから提供されている場合)。例

主な機能

Spark-TTSの中核機能はテキストを音声に変換することであり、具体的な操作手順は以下の通りである:

1.事前学習済みモデルによる音声生成

- 準備したテキスト簡単なテキストファイルを作成する。

input.txt例えば、"Hello, this is test voice."。 - スクリプトの実行リポジトリが

generate.pyスクリプト(正確なファイル名は実際のリポジトリに基づく)をターミナルに入力する:python generate.py --input input.txt --output output.wav

- パラメータの説明::

--input入力テキストファイルのパスを指定する。--output生成された音声ファイルを保存するパスを指定します。output.wav).- スクリプトでサポートされている場合は

--modelパラメータは事前に訓練されたモデルを選択する。--voiceパラメーターでサウンドスタイルを調整する。

- 結局: 実行すると、生成された

output.wavファイルをオーディオ・プレーヤーで開いて、その効果を聞いてみてください。

2.カスタムモデルのトレーニング

- データセットの準備テキストとそれに対応するオーディオデータを提供する必要があります。データ形式は通常

.txtドキュメント(テキスト)と.wavファイル(オーディオ)のリポジトリを参照することをお勧めします。README.mdまたはexampleフォルダ。 - 設定パラメータ設定ファイルを編集する。

config.jsonまたは同様のファイル)で、学習率やバッチサイズなどの学習パラメータを設定する。設定ファイルがない場合は、スクリプト内で直接パラメータを変更する。 - プライミングトレーニング例えば、トレーニングスクリプトを実行する:

python train.py --data_path ./dataset --output_model my_model - トレーニングプロセスデータ量やハードウェアの性能にもよりますが、トレーニングには数時間から数日かかることもあります。トレーニングが終了すると、新しいモデルファイル(例えば

my_model.pth). - 新モデルの使用学習したモデルのパスを生成スクリプトに渡す:

python generate.py --input input.txt --model my_model.pth --output custom_output.wav

3.声のスタイルの調整

- Spark-TTSがマルチスタイル出力をサポートしている場合(コードやドキュメントで確認する必要があります)、パラメータで発話速度やピッチなどを調整することができます。例

python generate.py --input input.txt --speed 1.2 --pitch 0.8 --output styled_output.wav - パラメータの説明::

--speed1.0は正常、1.0より大きいと速く、1.0より小さいと遅い。--pitchピッチは、数値が高いほどピッチが高くなり、その逆も同様。

- 効果検証生成後に試聴し、納得がいくまで少しずつパラメーターを調整してください。

作業工程例

中国語のテキストを女性の音声に変換したいとします:

- 確立

test.txt今日はいい天気だ、公園に散歩に行こう」。 - コマンドを実行する:

python generate.py --input test.txt --voice female --output park.wav - プローブ

park.wavスピーチが自然でスムーズであることを確認する。 - ご満足いただけない場合は、パラメータを調整するか、新しいモデルをトレーニングしてみてください。

ほら

- 文書参照倉庫の優先的な眺め

README.md設置および使用に関する指示は、より具体的に内部に記載されている場合があります。 - ハードウェア要件GPUが利用できない場合は、CPUで実行できますが、速度は遅くなります。

- 地域支援もし問題が発生したら、GitHubのIssuesページで質問するか、Coqui TTSのような類似のTTSプロジェクトの解決策を検索してください。

以上の手順で、音声の生成や専用モデルのカスタマイズなど、Spark-TTSを簡単に使い始めることができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません