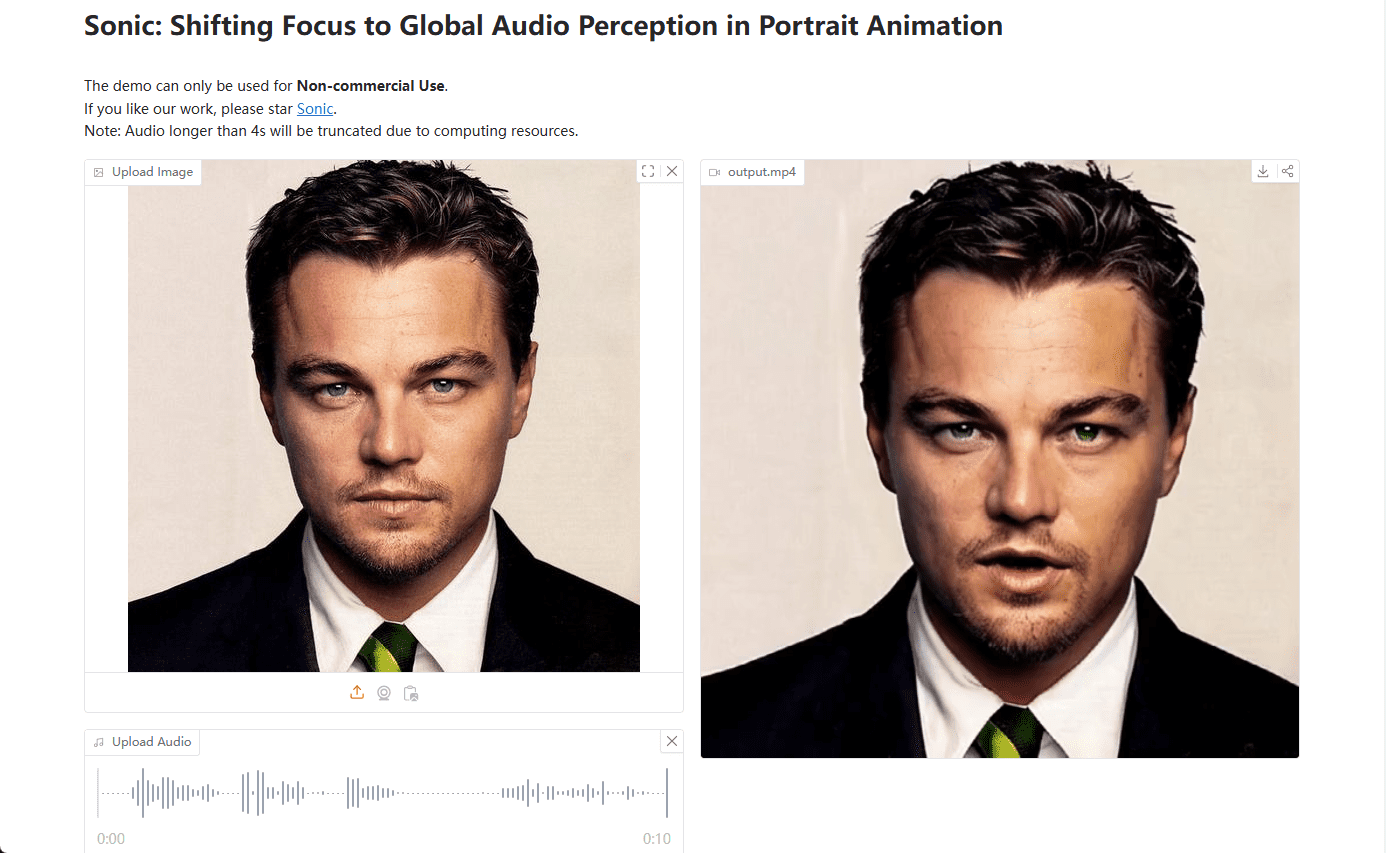

ソニック:音声でポートレート画像を生成し、生き生きとした表情のデジタルデモ映像を制作

はじめに

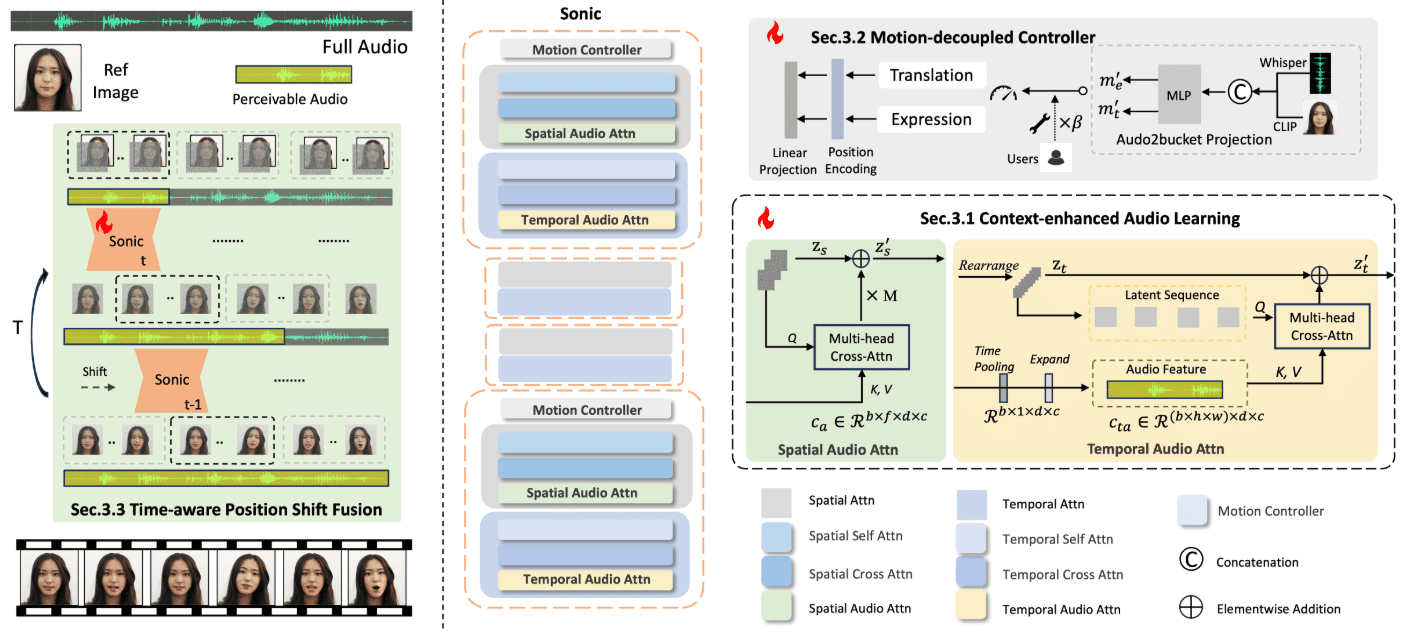

Sonicは、グローバルなオーディオ知覚に焦点を当てた革新的なプラットフォームで、オーディオによって駆動される鮮やかなポートレートアニメーションを生成するように設計されている。テンセントと浙江大学の研究者チームによって開発されたこのプラットフォームは、音声情報を使って表情や頭の動きを制御し、自然で流れるようなアニメーション動画を生成する。Sonicのコアテクノロジーには、コンテキストを強化した音声学習、モーション分離コントローラ、時間を意識したポジションシフト融合モジュールなどがある。これらの技術により、Sonicは様々なスタイルの画像や様々なタイプの音声入力を用いて、安定したリアルな長尺動画を生成することができます。

このプロジェクトのコードとウェイトは、社内のオープンソースレビューを通過した後にリリースされる(すでにリリース済み)。Windowsユーザー向けインストール手順.

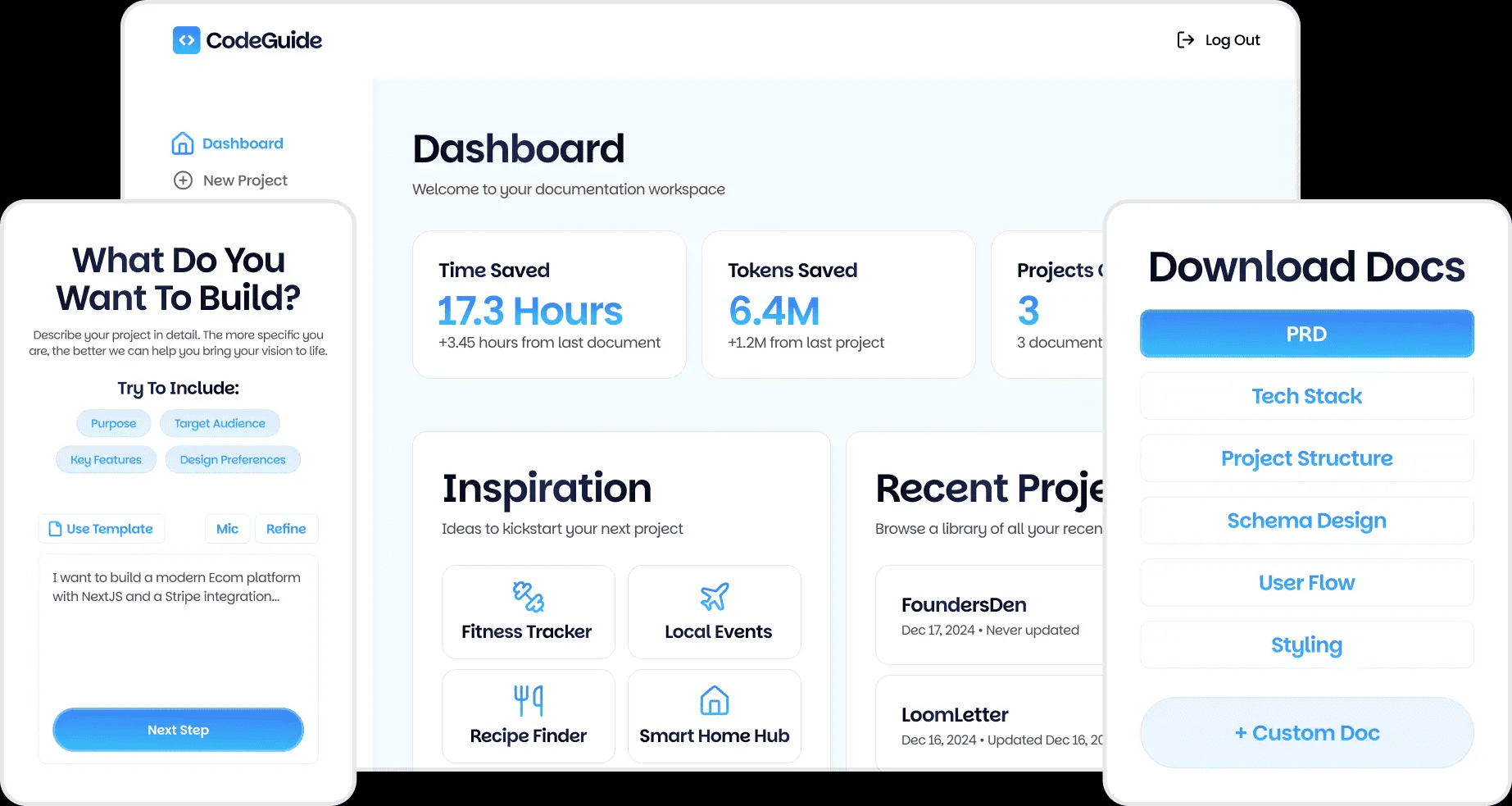

デモ:https://huggingface.co/spaces/xiaozhongji/Sonic

機能一覧

- コンテキスト拡張オーディオ学習長い時間セグメントから音声知識を抽出することで、表情や唇の動きに関する先験的な情報を得ることができます。

- モーション・デカップリング・コントローラ頭部と表情の動きを独立して制御し、より自然なアニメーションを実現。

- 時間を考慮したポジション・シフト・フュージョングローバルな音声情報を融合し、長く安定した映像を生成する。

- 多彩なビデオ生成さまざまなスタイルの画像と複数の解像度のビデオ生成に対応。

- オープンソースとクローズドソースの比較ソニックの長所である表現力と自然な頭の動きを示している。

ヘルプの使用

設置プロセス

Sonicプラットフォームは現在、社内でオープンソースのレビューが行われており、レビューが完了次第、コードとウェイトがGitHubにアップロードされる予定だ。ユーザーは以下の手順でSonicをインストールして使用することができる:

- ソニックのGitHubページをご覧ください。

- クローン倉庫

git clone https://github.com/jixiaozhong/Sonic.git - 依存関係をインストールします:

pip install -r requirements.txt - 事前に訓練されたモデルの重みをダウンロードし、指定されたディレクトリに置きます。

使用プロセス

- データ入力の準備アニメーションに必要なビデオ画像や音声ファイルを収集します。

- 生成されたスクリプトを実行する例えば、提供されたスクリプトを使って生成プロセスを実行する:

python generate.py --image input.jpg --audio input.wav - 調整パラメーター最良の結果を得るために、必要に応じて生成スクリプトのパラメーターを調整してください。

- 出力を見る生成されたビデオは、指定された出力ディレクトリに保存されます。

詳細な機能操作

- コンテキスト拡張オーディオ学習長い音声セグメントから学習することで、ソニックは音声の微妙な変化をとらえ、より自然な表情や唇の動きを作り出すことができます。

- モーション・デカップリング・コントローラコントローラは、頭の動きと表情の動きを別々に処理するため、生成されるアニメーションはよりリアルになります。コントローラのパラメータを調整することで、アニメーション効果を最適化できます。

- 時間を考慮したポジション・シフト・フュージョンこのモジュールは、グローバルなオーディオ情報を融合することで、生成された映像が長期間にわたって安定した状態を保つことを保証します。ユーザーは、時間窓パラメータを調整することで、映像の滑らかさと安定性を制御することができます。

- 多彩なビデオ生成Sonicは、さまざまなスタイルの画像(アニメ、リアルなど)と複数の解像度をサポートします。ユーザーは、ニーズに応じて適切な画像と音声入力を選択し、期待に応えるビデオエフェクトを生成できます。

ソニック・ワンクリック・インストーラー

百度:https://pan.baidu.com/share/init?surl=iCR4l4ClSRZswm1E2K_NNA&pwd=8520

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません