DeepSeek+Difyのプライベート展開:セキュアで制御可能なローカルAIアシスタントシステムの構築

中抜き

ディープシーク は、その高度なアルゴリズム・アーキテクチャとリフレクティブ・チェイニング機能により、AIとの対話に革命的な体験をもたらす画期的なオープンソースのビッグ言語モデルです。プライベートデプロイメントでは、データセキュリティと利用セキュリティを完全に制御できます。また、展開スキームを柔軟に調整し、便利なカスタムシステムを実装することができます。

ダイファイ 同じオープンソースのAIアプリケーション開発プラットフォームとして、完全なプライベートデプロイメントソリューションを提供します。ローカルに展開されたDeepSeekサービスをDifyプラットフォームにシームレスに統合することで、組織はデータのプライバシーを確保しながら、ローカルサーバー環境内で強力なAIアプリケーションを構築することができます。

プライベート・デプロイメント・オプションの利点は以下の通りである:

- 優れた性能 ビジネスモデルに匹敵する対話体験の提供

- 環境隔離 完全なオフライン運用により、データ漏洩のリスクを排除。

- データ制御性 コンプライアンス要件を満たすためのデータ資産の完全管理

プレ・ポジショニング

ハードウェア環境:

- CPU >= 2コア

- ビデオメモリ/RAM ≥ 16 GiB(推奨)

ソフトウェア環境:

- ドッカー

- Docker Compose

- オーラマ

- Dify コミュニティ版

配備開始

1.オッラマの設置

Ollamaは、DeepSeek、Llama、Mistralなどの大規模言語モデル(LLM)をシームレスにデプロイするために設計された、クロスプラットフォームの大規模モデル管理クライアント(MacOS、Windows、Linux)です。を提供します。

Ollamaのウェブサイトにアクセスし、画面の指示に従ってOllamaクライアントをダウンロード、インストールしてください。インストール後 ollama -v コマンドはバージョン番号を出力する。

➜~ollama-v

ollamaversionis0.5.5

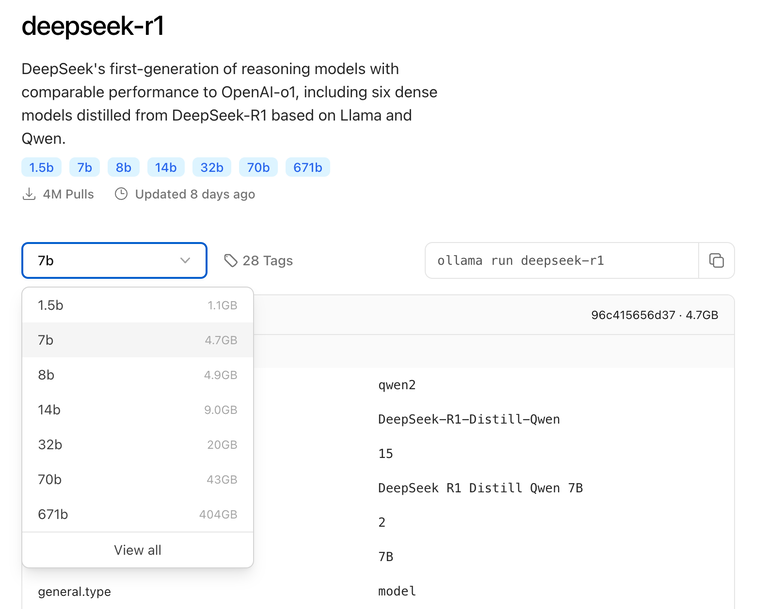

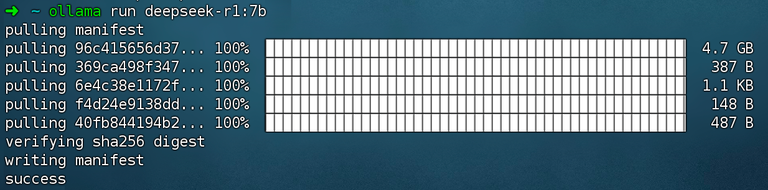

実際の環境構成に基づいて、導入に適した DeepSeek のサイズモデルを選択します。初期導入には、7B サイズのモデルをお勧めします。

コマンド実行 ollama run deepseek-r1:7b 取り付け ディープシークR1 モデル

2.Difyコミュニティ版をインストールする

DifyのGitHubプロジェクトのアドレスにアクセスし、以下のコマンドを実行して、コードリポジトリのプルおよびインストールプロセスを完了します。

gitclonehttps://github.com/langgenius/dify.git

cddify/docker

cp.env.example.env

dockercomposeup-d# 如果版本是 Docker Compose V1,使用以下命令:docker-compose up -d

コマンドを実行すると、すべてのコンテナのステータスとポートマッピングが表示されるはずだ。詳しい手順については Docker Composeのデプロイメント.

Dify Community Editionは、デフォルトでポート80を使用します。 http://your_server_ip プライベート化されたDifyプラットフォームにアクセスしてください。

3.DeepSeekとDifyの接続

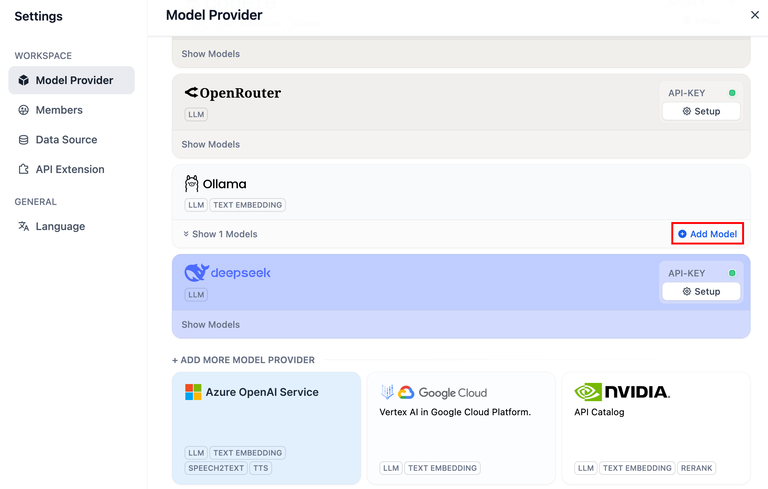

Difyプラットフォームの右上をクリックしてください。 アバター → 設定 → モデルサプライヤー Ollamaを選択し、Add Modelをタップします。

モデル・プロバイダ内の DeepSeek がオンライン API サービスに対応し、ローカルに配置された DeepSeek モデルが Ollama クライアントに対応します。DeepSeek モデルが Ollama クライアントによって正常にデプロイされていることを確認してください。

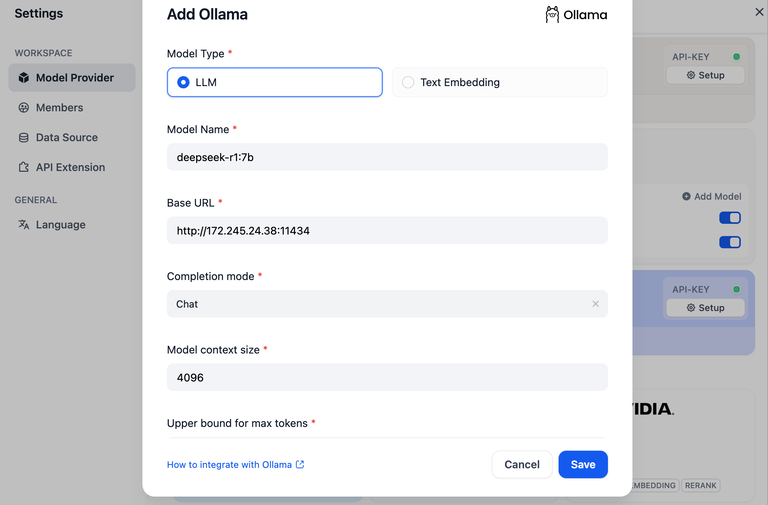

LLMモデルタイプを選択する。

- Model Nameには、配置したモデルのモデル名を記入します。上記でデプロイしたモデルはdeepseek-r1 7bなので

deepseek-r1:7b - ベースURL、Ollamaクライアントが動作しているアドレス。

http://your_server_ip:11434.接続に問題がある場合は一般的な問題. - その他のオプションはデフォルト値のまま。オプションによって DeepSeekモデルの説明生成されるトークンの最大長は32,768トークンである。

AIアプリケーションの構築

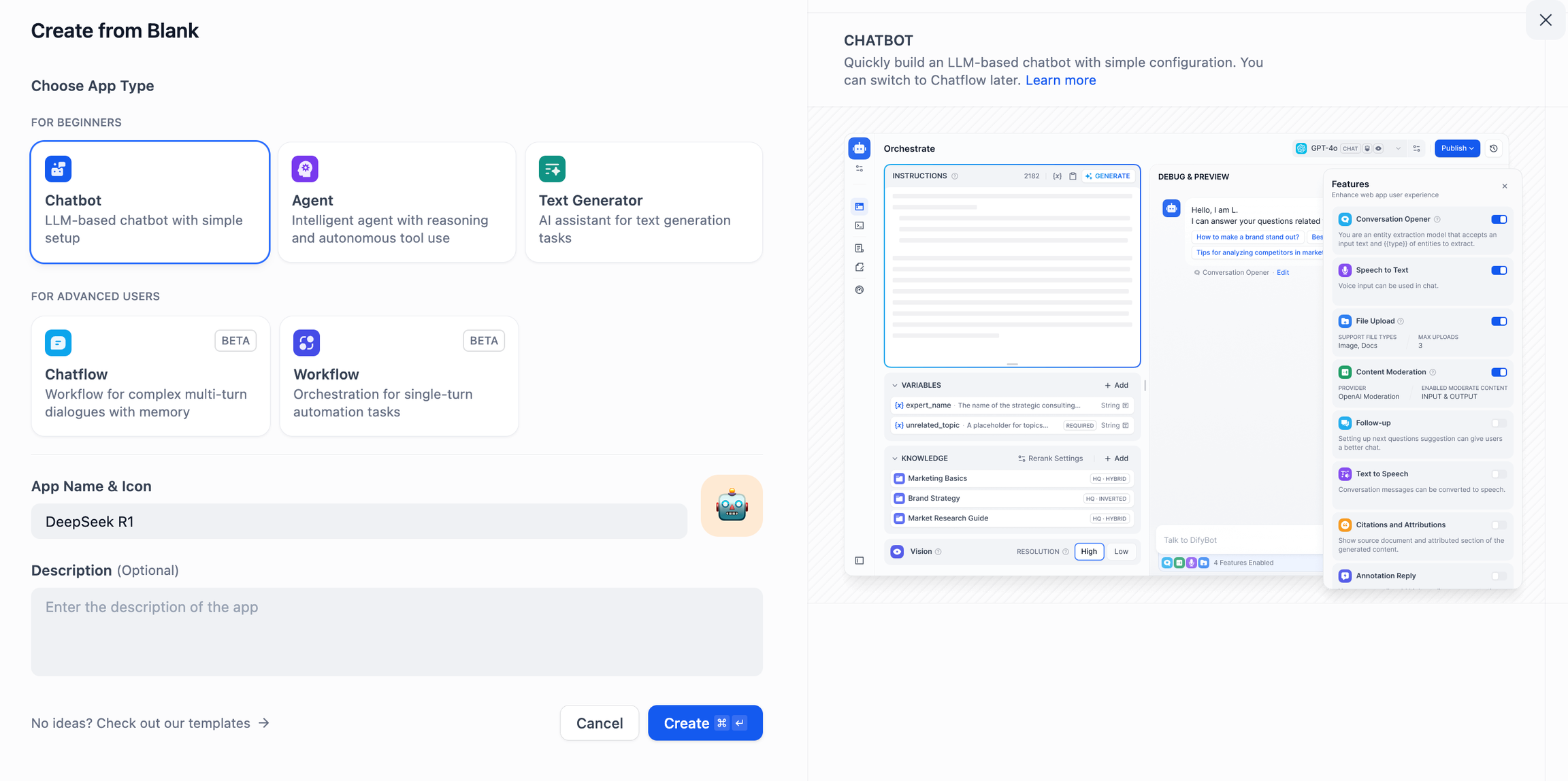

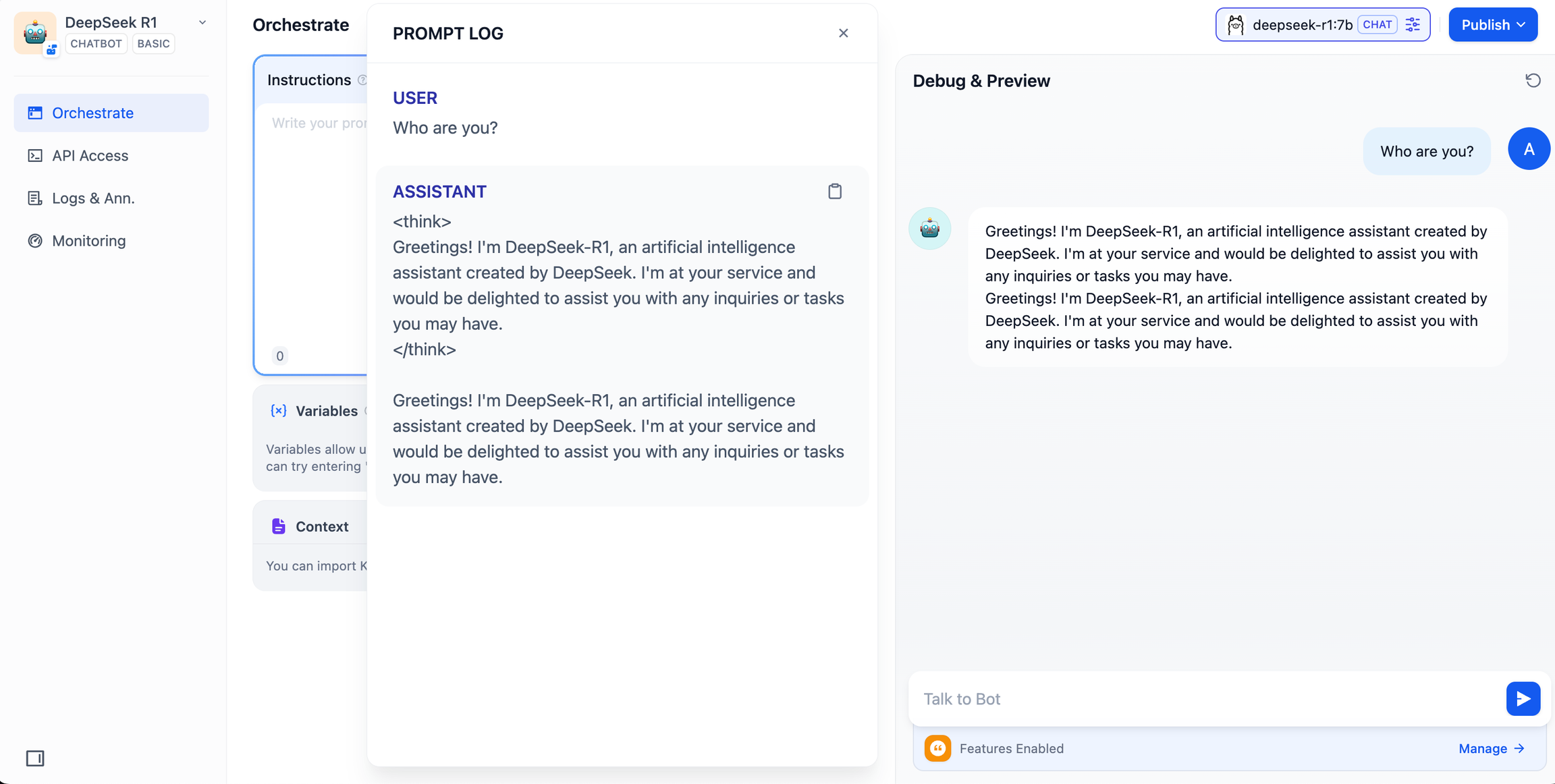

DeepSeek AIチャットボット(シンプルなアプリケーション)

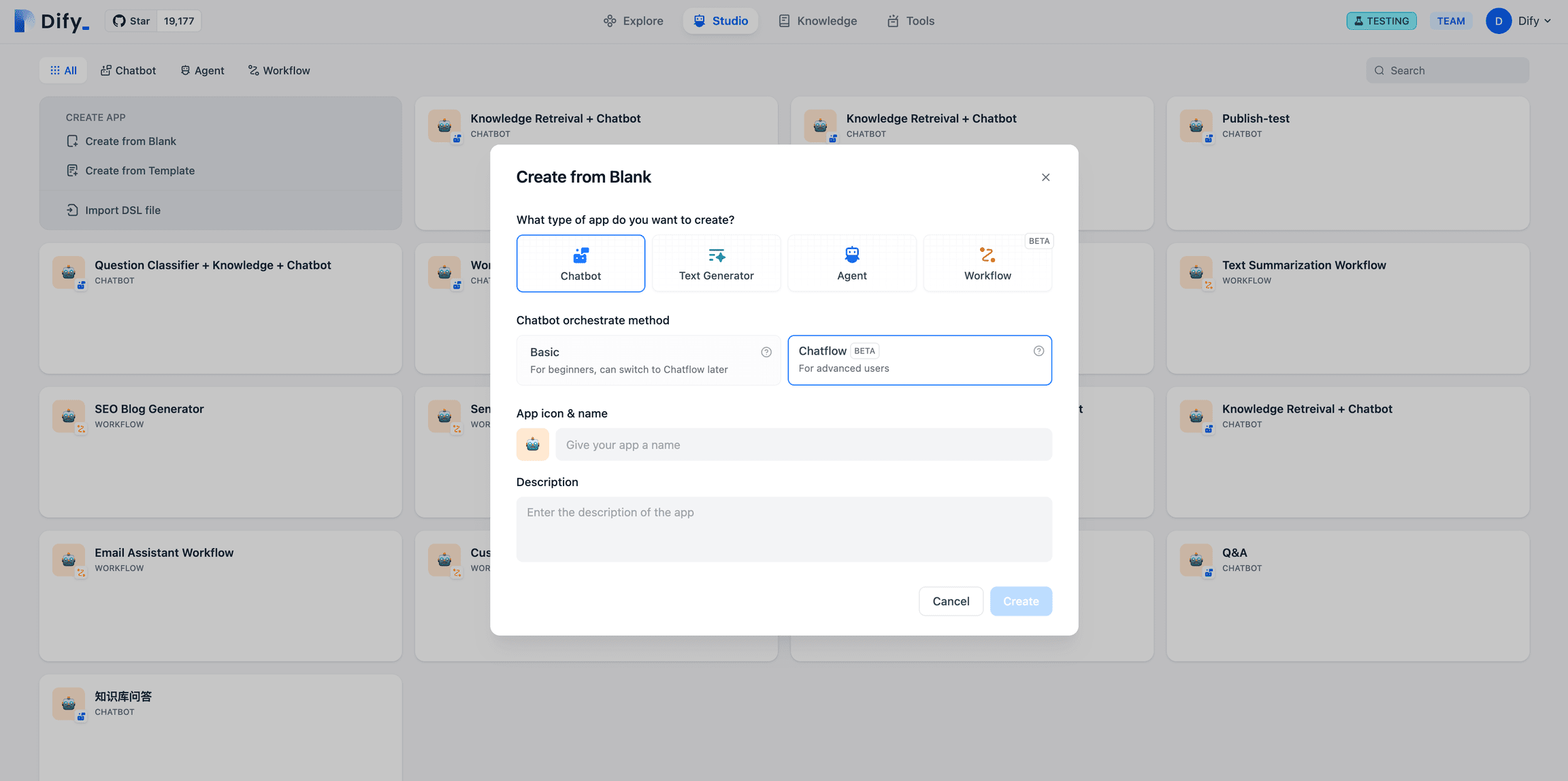

- Difyプラットフォームトップページの左側にある「Create a Blank App」をタップし、「Chat Assistant」タイプのアプリを選択し、簡単な名前を付けます。

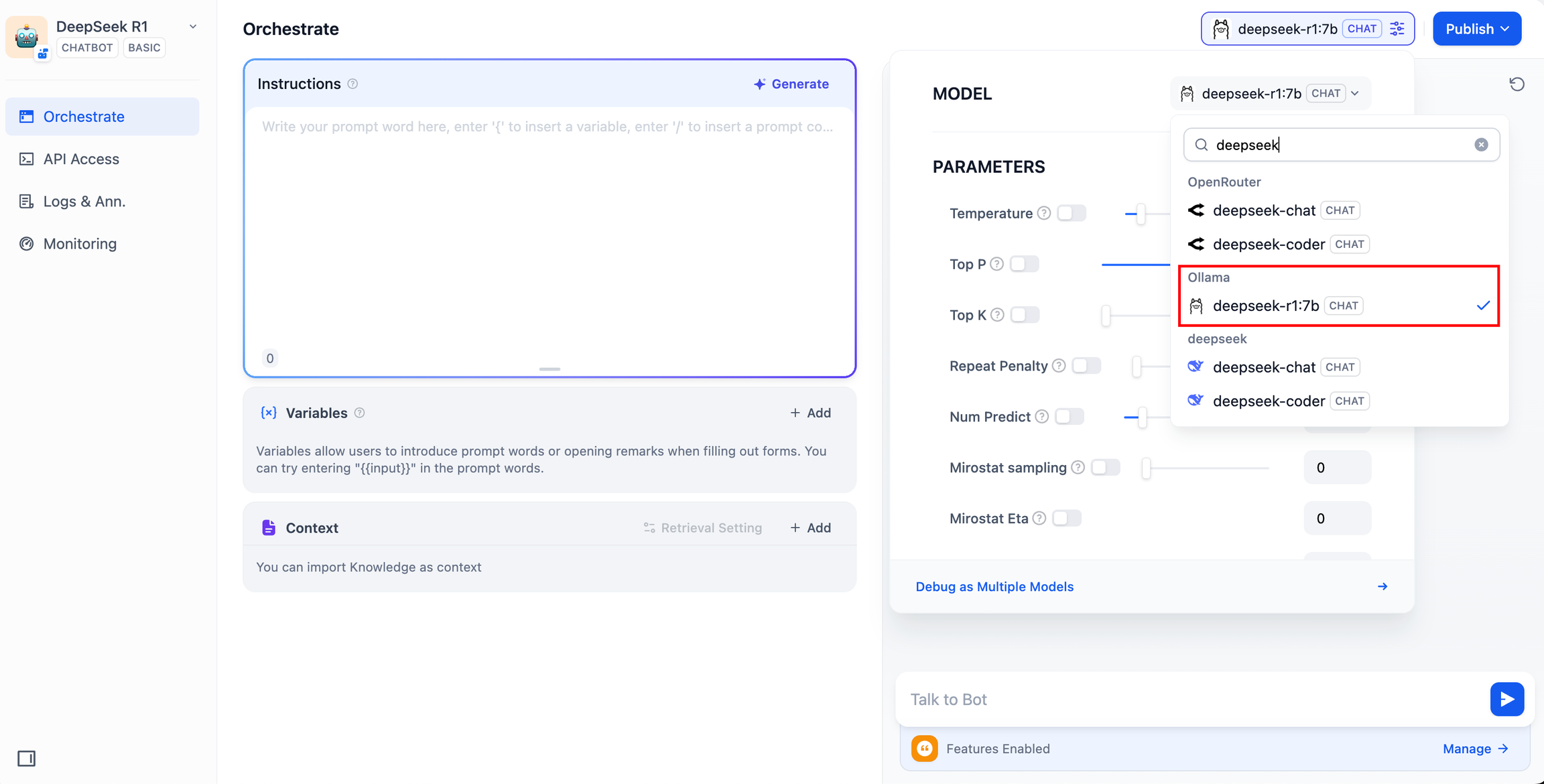

- 右上の「アプリケーションの種類」で、Ollamaフレームワークを選択します。

deepseek-r1:7bモデル

- プレビューダイアログボックスに内容を入力して、AIアプリケーションが動作することを確認します。応答が返ってくるということは、AIアプリケーションのビルドが完了したことを意味します。

- アプリの右上にある「公開」ボタンをタップすると、AIアプリへのリンクが表示され、他の人と共有したり、他のウェブサイトに埋め込むことができます。

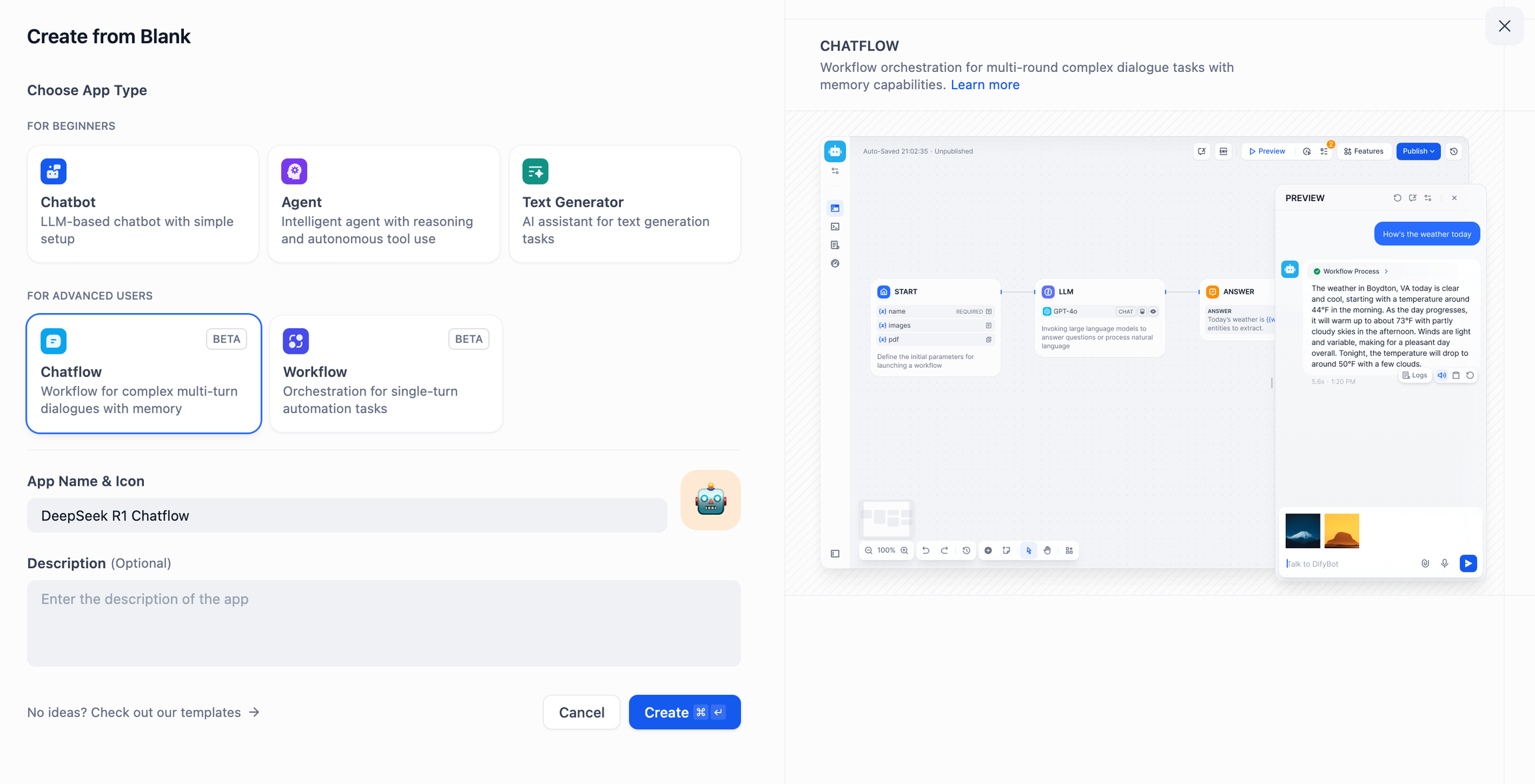

DeepSeek AIチャットフロー/ワークフロー(高度なアプリケーション)

チャットフロー ワークフロー アプリは、文書認識、画像認識、音声認識など、より複雑な機能を持つAIアプリケーションを構築するのに役立ちます。詳しい手順についてはワークフロー・ドキュメント.

- Difyプラットフォームのトップページ左側にある「Create a Blank App」をタップし、「Chatflow」または「Workflow」タイプのアプリを選択し、簡単な名前を付けます。

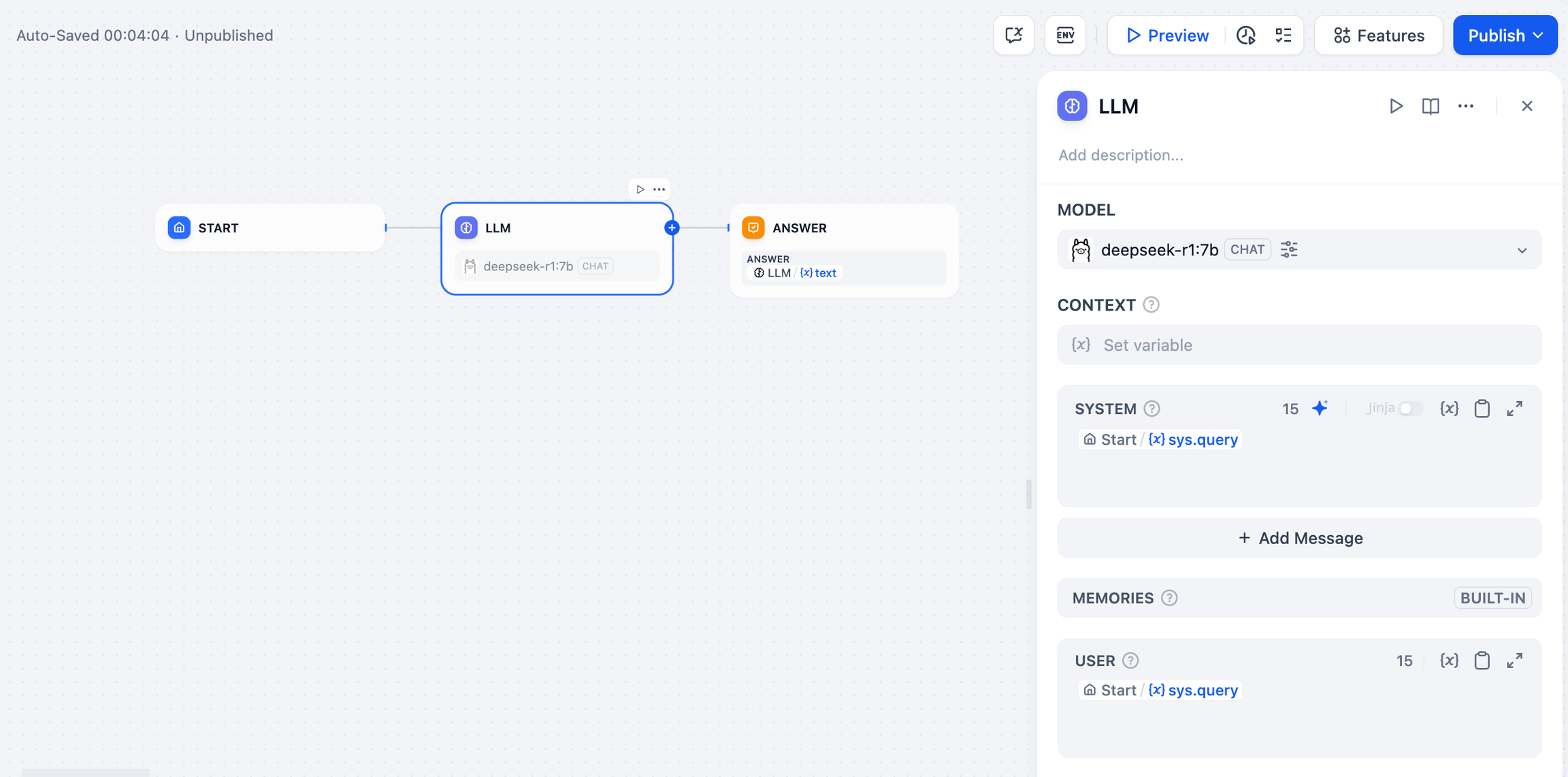

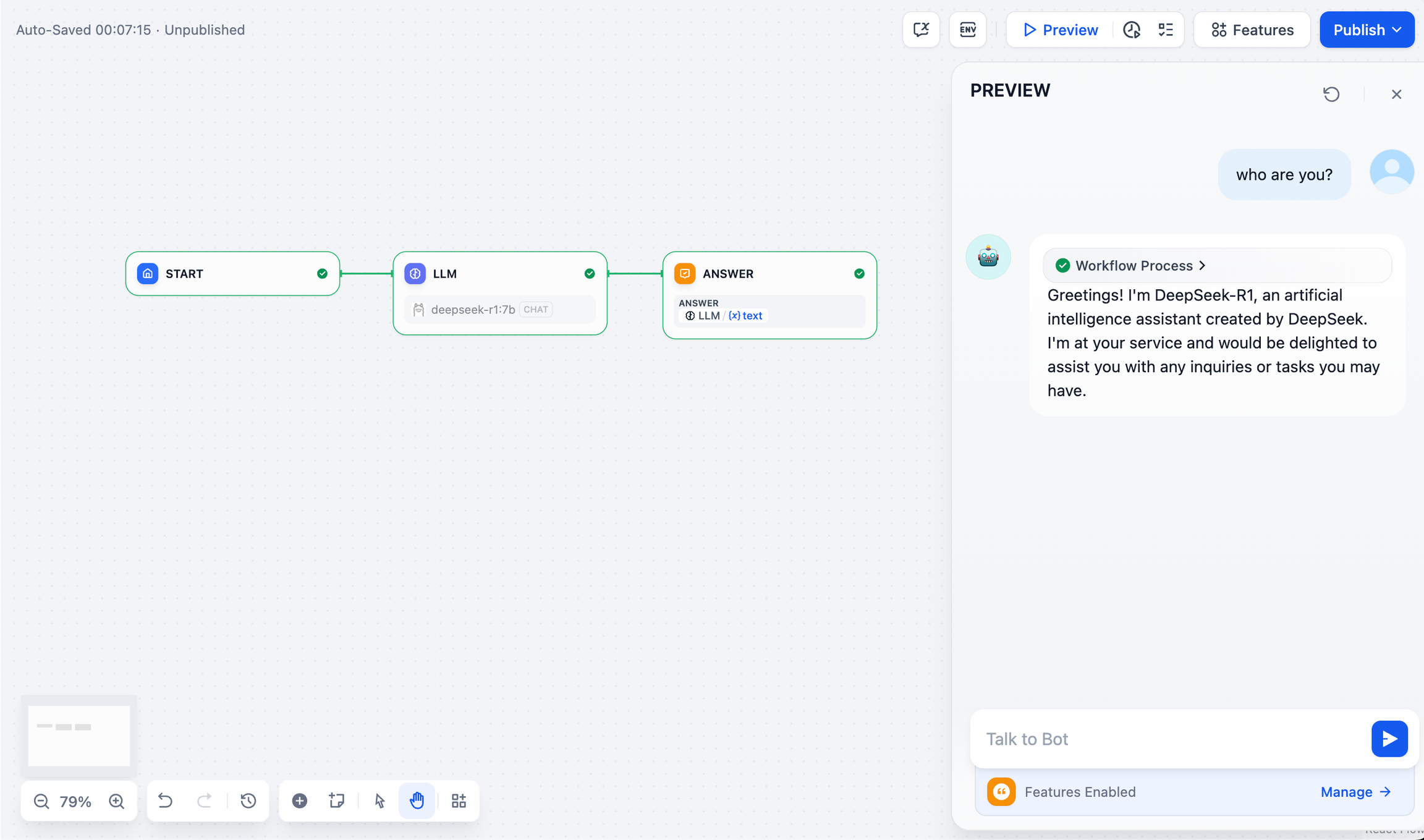

- LLMノードを追加するには、Ollamaフレームワークを選択します。

deepseek-r1:7bモデルを作成し{{#sys.query#}}変数を使用して開始ノードを接続する。

- エンドノードを追加して設定を完了します。テスト用のプレビュー・ボックスにコンテンツを入力できます。応答が生成されると、AIアプリケーションのビルドが完了したことになります。

一般的な問題

1.Dockerデプロイ時の接続エラー

DockerでDifyとOllamaをデプロイする際、以下のエラーが発生する場合があります:

httpconnectionpool(host=127.0.0.1,port=11434): max retries exceeded with url:/cpi/chat

(CausedbyNewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

fail to establish a new connection:[Errno 111] Connection refused'))

httpconnectionpool(host=localhost,port=11434): max retries exceeded with url:/cpi/chat

(CausedbyNewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

fail to establish a new connection:[Errno 111] Connection refused'))

エラーの原因 localhostは通常、ホストや別のコンテナではなく、コンテナ自体を指しています。この問題を解決するには、Ollamaサービスをネットワークに公開する必要があります。

macOSの環境設定方法:

OllamaがmacOSアプリケーションとして実行されている場合、launchctlを使って環境変数を設定する必要があります:

- これは

launchctl setenv環境変数の設定:

launchctlsetenvOLLAMA_HOST"0.0.0.0"

- Ollamaアプリケーションを再起動します。

- 上記の手順でうまくいかない場合は、以下の方法を使うことができる:

問題は、ドッカー内で host.docker.internalドッカーのホストにアクセスするために localhost と置き換える。 host.docker.internal サービス開始の準備が整いました:

http://host.docker.internal:11434

Linuxの環境設定方法:

Ollamaがsystemdサービスとして動作している場合は、次のようにします。 systemctl 環境変数の設定:

- これは

systemctl edit ollama.servicesystemdサービスを編集する。エディターが開きます。 - 各環境変数に対して

[Service]セクションの下にEnvironment::

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

- 保存して終了する。

- におも

systemdそしてオラマを再起動させる:

systemctldaemon-reload

systemctlrestartollama

Windowsの環境設定方法:

Windowsでは、Ollamaはあなたのユーザー環境変数とシステム環境変数を継承します。

- まず、タスクバーのOllamaをクリックしてプログラムを終了する。

- コントロールパネルからシステム環境変数を編集する

- 以下のようなユーザーアカウントの変数を編集または新規作成します。

OLLAMA_HOSTそしてOLLAMA_MODELSその他 - OK/適用をクリックして保存する

- 新しいターミナルウィンドウで実行する

ollama

2.Ollamaサービスのアドレスとポート番号を変更したいのですが。

Ollamaデフォルトバインディング 127.0.0.1 ポート11434でアクセスできます。 OLLAMA_HOST 環境変数はバインディングアドレスを変更する。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません