n8n Self-hosted AI Starter Kit: ローカルAI環境を素早く構築するためのオープンソーステンプレート

はじめに

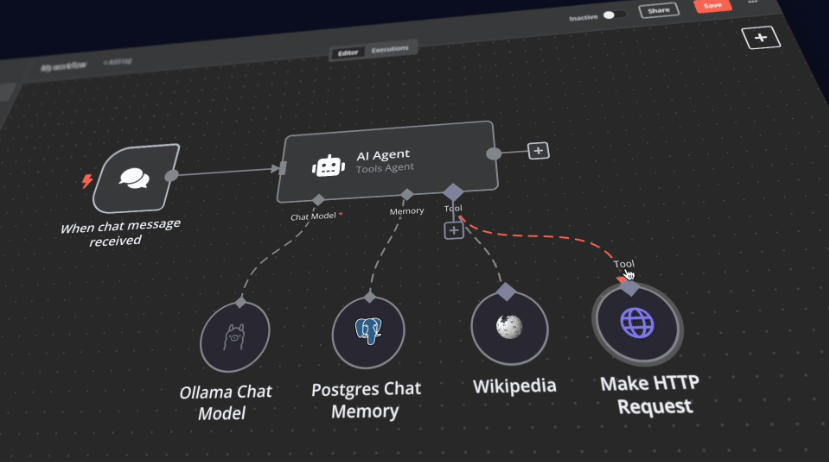

n8n Self-Hosted AI Starter Kitは、包括的なローカルAIとローコード開発環境を素早く初期化するために設計されたオープンソースのDocker Composeテンプレートです。n8nチームによってキュレートされたこのスイートは、セルフホスト型のn8nプラットフォームと、ユーザーがセルフホスト型のAIワークフローを迅速に構築できるよう、互換性のあるさまざまなAI製品やコンポーネントを組み合わせています。このスイートには、n8nローコードプラットフォーム、OllamaクロスプラットフォームLLMプラットフォーム、Qdrant高性能ベクトルストレージ、PostgreSQLデータベースが含まれ、インテリジェントエージェント、文書要約、インテリジェントチャットボット、プライベート金融文書分析など、様々なAIアプリケーションシナリオに対応します。

機能一覧

- n8nローコードプラットフォーム迅速なビルドワークフローをサポートする400以上の統合された高度なAIコンポーネントを提供します。

- Ollamaプラットフォーム最新のネイティブLLMのインストールと実行をサポートするクロスプラットフォームLLMプラットフォーム。

- Qdrantベクターストレージ包括的なAPIを備えたオープンソースの高性能ベクトル・ストレージ。

- PostgreSQLデータベース大量のデータを扱うための信頼性の高いデータベース。

- インテリジェント・エージェントミーティングやタスクのスケジューリングを行うAIエージェント。

- 文書概要社内のPDF文書を安全にまとめ、情報漏えいを防ぎます。

- インテリジェント・チャットボット企業コミュニケーションとITオペレーションを強化するインテリジェントなSlackボット。

- 私的財務書類の分析私的な財務書類分析を可能な限り低コストで。

ヘルプの使用

設置プロセス

- クローン倉庫::

bash

git clone https://github.com/n8n-io/self-hosted-ai-starter-kit.git

cd self-hosted-ai-starter-kit

- Docker Composeでn8nを実行する::

- Nvidia GPUユーザーへ:

docker compose --profile gpu-nvidia up注:DockerでNvidia GPUを使用したことがない場合は、Ollama Dockerの指示に従ってください。

- Mac/Apple Siliconユーザーの方へ:

- オプション1:CPUのみで動作:

docker compose --profile cpu up - オプション2:MacでOllamaを起動し、n8nインスタンスに接続する:

docker compose up次に、Ollamaの認証情報を変更します。

http://host.docker.internal:11434/ホストとしてね。

- オプション1:CPUのみで動作:

- 他のユーザーへ

docker compose --profile cpu up

- Nvidia GPUユーザーへ:

使用ガイドライン

- n8nの開始::

- インタビュー

http://localhost:5678n8nインターフェイスに入る。 - デフォルトアカウントでログインするか、新規アカウントを作成してください。

- インタビュー

- ワークフローの作成::

- n8nのインターフェイスで、"New Workflow "をクリックします。

- 左のメニューから目的のノードをワークスペースにドラッグします。

- 各ノードのパラメータと接続を設定する。

- ワークフローの実行::

- 設定が完了したら、「実行」ボタンをクリックしてワークフローを実行します。

- ワークフローの実行結果とログの表示

クイックスタートと使用

Self-Hosted AI Starter Kitの核となるのは、あらかじめネットワークとストレージが設定されたDocker Composeファイルです。インストールの手順が完了したら、以下のステップに従うだけで使い始めることができます:

- http://localhost:5678/设置n8n。この操作は一度だけ行う必要がある。

- http://localhost:5678/workflow/srOnR8PAY3u4RSwb.

- オプションテスト・ワークフローワークフローの実行を開始する。

- このワークフローを初めて実行する場合は、Llama 3.2のOllamaダウンロードが完了するまで待つ必要があるかもしれません。ドッカーコンソールのログで進捗を確認できます。

http://localhost:5678/来打开n8n。

n8nインスタンスでは、400を超えるインテグレーションや、AIエージェント、テキスト分類器、情報抽出器などの基本および高度なAIノードを利用できます。ローカルのランタイムでは、言語モデルとして Ollama ノードを、ベクトルストアとして Qdrant を使用していることを確認してください。

"銘記するこのスターターキットは、セルフホスト型のAIワークフローを始めるのに役立つように設計されています。本番環境に完全に最適化されているわけではありませんが、シームレスに連携する強力なコンポーネントを組み合わせており、概念実証プロジェクトに最適です。ニーズに合わせてカスタマイズできます。

"

アップグレード手順

Nvidia GPUの設定:

docker compose --profile gpu-nvidia pull

docker compose create && docker compose --profile gpu-nvidia up

マック/アップルシリコン・ユーザー向け

docker compose pull

docker compose create && docker compose up

非GPU設定の場合:

docker compose --profile cpu pull

docker compose create && docker compose --profile cpu up© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません