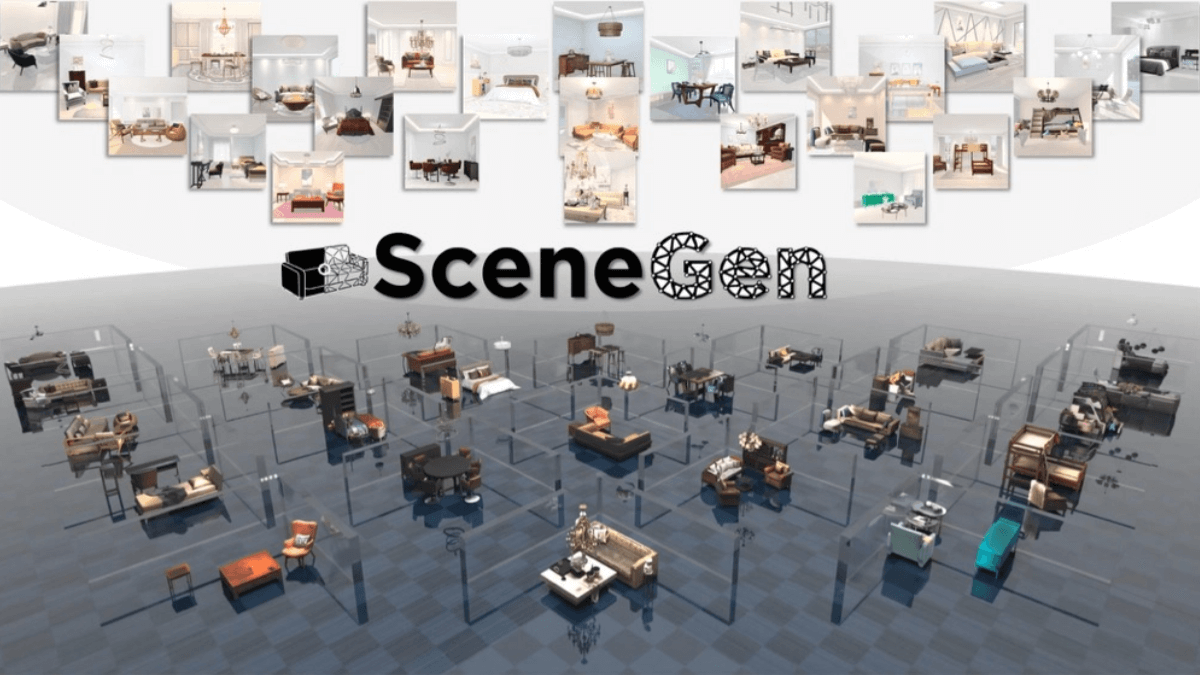

SceneGen - 上海交通大学オープンソース3Dシーン生成フレームワーク

SceneGenとは?

SceneGenは、上海交通大学の1枚の画像から3Dシーンを生成するオープンソースの手法であり、1枚のシーン画像とターゲットリソースマスクから、リソースの幾何学的構造、テクスチャ、相対的な空間位置を含む、複数の3Dリソースを含む完全なシーンを効率的に生成する。単一のシーン画像と対応するターゲットリソースマスクを入力として、複数の3Dリソースが単一のフィードフォワードプロセスで同時に生成され、それぞれが完全な幾何学構造、詳細なテクスチャ、正確な相対的空間位置を持ち、2D画像から3Dシーンへの直接変換を可能にします。

SceneGenの特徴

- シングルマップ入力コージェネレーション単一の2Dシーン画像とそれに対応するターゲットマスクに基づいて、シーン内の複数の3Dアセットのジオメトリ、テクスチャ、相対的な空間位置を、単一の順伝播プロセスによって同時に生成できるため、従来の3Dコンテンツ作成の複雑なプロセスが大幅に簡素化されます。

- ローカルとグローバルの情報集約特徴抽出の段階で、ユニークなモジュールは、シーンのローカルな詳細情報とグローバルなコンテキスト情報を効果的に集約することができ、生成された3Dアセットがローカルに微細であるだけでなく、高度な合理性とシーン全体のレイアウトとの整合性を維持することを保証します。

- 効率的なエンド・ツー・エンドの生成時間のかかる最適化や多段階のアセット検索とアセンブリに依存する従来のアプローチとは異なり、エンドツーエンドの生成アプローチは、煩雑な中間ステップを回避し、コンセプトからユーザビリティまでの3Dシーン生成の効率を大幅に改善します。

- 空間的関係の正確な予測ポジションヘッドを統合することで、シーン内の様々な3Dアセットの空間レイアウトを正確に予測・配置し、オブジェクト間の空間的関係の合理性を確保します。

SceneGenの強み

- 品質を生み出す生成された3Dシーンは、構造的に完全で微細なテクスチャを持ち、正確な空間関係を持ち、合成データと実世界データの両方で既存の手法(PartCrafter、MIDIなど)よりも幾何学的精度と視覚的品質が大幅に向上しています。

- 効率性の向上マルチリソース生成は、最適化を繰り返すことなく、1回のフィードフォワードで行うことができ、4つのアセットでテクスチャライズされたシーンを生成するのにかかる時間は、クオリティとスピードの両方を考慮すると、約2分です。

- 一般化能力単一の画像入力に対してのみ学習されるが、複雑なシーンへの適応性を高めるため、複数の画像入力によって生成の質をさらに向上させることができる。

SceneGenの公式サイトとは

- プロジェクトのウェブサイト:: https://mengmouxu.github.io/SceneGen/

- Githubリポジトリ:: https://github.com/mengmouxu/scenegen

- HuggingFaceモデルライブラリ:: https://huggingface.co/haoningwu/scenegen

- arXivテクニカルペーパー:: https://arxiv.org/pdf/2508.15769

SceneGenの対象者

- ゲーム開発者&インディーズ・プロデューサーリソースの限られた独立系ゲーム開発者や中小規模のスタジオにとって、SceneGenは3Dシーンアートアセットの作成にかかる時間と金銭的コストを劇的に削減することができます。開発者は、コンセプト画や参考写真を提供するだけで、ゲームエンジンで直接使用できる3Dシーンを素早く生成し、開発効率を大幅に改善します。

- 仮想現実(VR)および拡張現実(AR)コンテンツ制作者SceneGenのエンドツーエンドの生成機能は、多数のリアルでインタラクティブな仮想環境の効率的な構築を必要とするVR/ARアプリケーションのための、ユーザー体験型の没入型3Dシーンの迅速なプロトタイピングと制作に理想的に適しています。

- 不動産と建物の可視化のプロフェッショナル不動産業者、建築家、インテリアデザイナーは、SceneGenを使用することで、顧客の間取り図やインテリアの現場写真をインタラクティブな3D空間表示に素早く変換することができ、顧客が空間レイアウトやデザイン効果をより直感的に理解できるようになります。

- 映画・アニメ制作チーム映画、テレビ、アニメーションのプリコンセプトデザインとストーリーボードの段階で、チームはSceneGenを使用して、2Dのストーリーボードやシーンリファレンスを、ショットのプレビュー、コンポジションやライティングのテストに使用できる基本的な3Dレイアウトに素早く変換することで、プリプロダクションプロセスを加速することができます。

- エンボディドAI研究者ロボット、自律走行システム、その他の知能をシミュレートされた環境で学習させるためのトレーニングの鍵。研究者は、トレーニング環境として多数の多様な3Dシーンを必要としており、SceneGenの効率的な生成機能により、必要な仮想トレーニング世界を迅速に構築することができる。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません