プロンプト・オプティマイザー:主流AIモデルのプロンプト語を最適化するオープンソースツール

はじめに

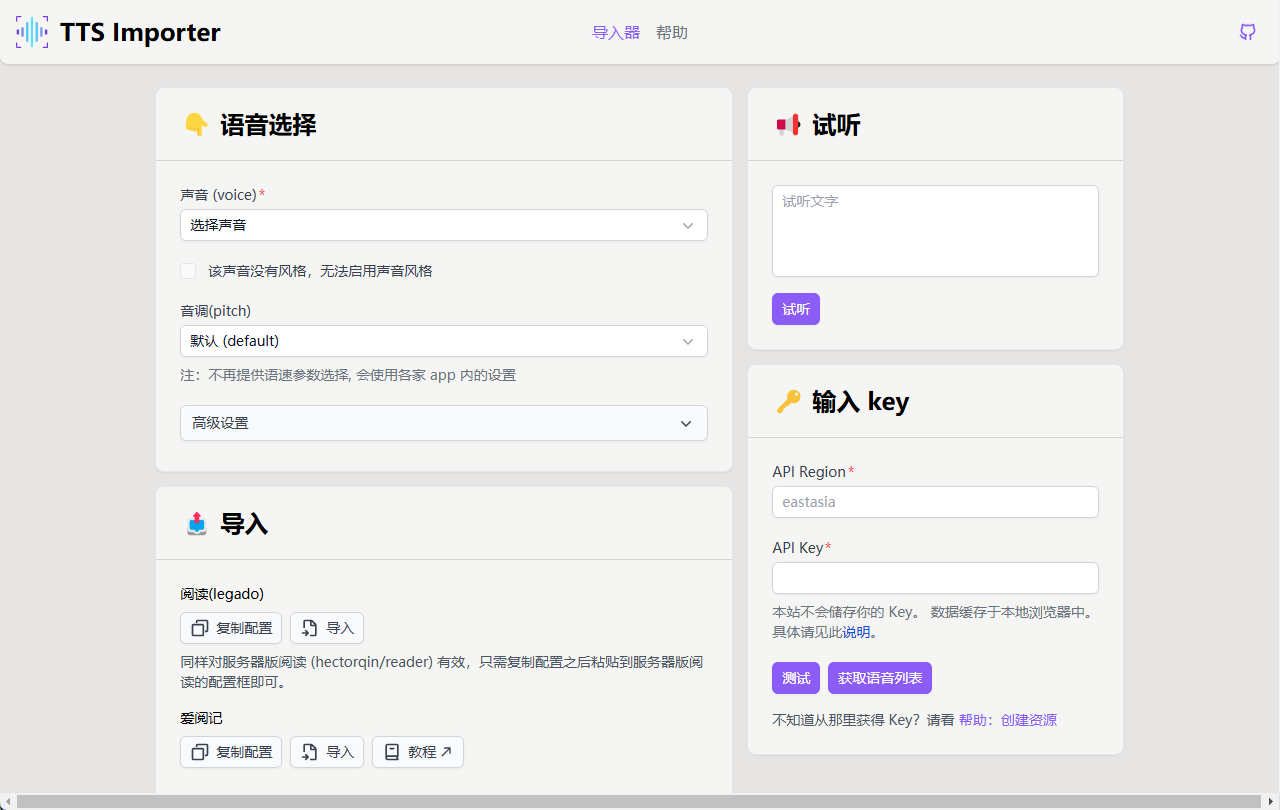

Prompt Optimizerは、GitHubのlinshenkxによって開発された、プロンプトワードの最適化に焦点を当てたオープンソースツールです。AIモデルのプロンプトワードをインテリジェントなアルゴリズムで最適化し、生成されるコンテンツの品質と精度を向上させます。このツールはVercelへのワンクリック導入をサポートしており、操作が簡単で開発者やAI愛好家に適している。このプロジェクトは、複数の主流AIモデル(OpenAI、Gemini、DeepSeekなど)を統合し、リアルタイムテストを提供するため、ユーザーは最適化された結果をすぐに確認することができる。また、プライバシー保護に重点を置いており、データ処理はすべてクライアント側で行い、APIキーと履歴はローカルで暗号化して保存することでセキュリティを確保している。Xプラットフォームではすでに多くの注目を集めており、ユーザーからは「ツールボックスの中の素晴らしいツール」とのコメントが寄せられている。

機能一覧

- スマートなキューの最適化アルゴリズムが自動的にユーザー入力のプロンプトを最適化し、AIが生成する結果の質を向上させます。

- リアルタイム効果テスト最適化された手がかり語の即時テストをサポートし、異なるモデルの出力比較を直接表示。

- マルチモデルの統合OpenAI、Gemini、DeepSeek、その他の主流AIモデルと互換性があり、多様なニーズに対応。

- Vercelへのワンクリック配備複雑な設定を必要としない簡単なデプロイメントプロセスを提供します。

- プライバシー保護メカニズムすべての操作はクライアント側で行われ、鍵や記録はローカルで暗号化されて保存されるため、データ漏洩のリスクはありません。

- マルチパッケージ・エンジニアリング構造コア機能(core)、UIコンポーネントライブラリ(ui)、ウェブアプリケーション(web)、Chromeプラグイン(extension)で拡張可能。

- 歴史管理最適化履歴を保存し、以前のキュー・ワード・スキームを再利用することができます。

ヘルプの使用

設置プロセス

Prompt OptimizerはGitHubベースのオープンソースプロジェクトで、ローカル開発とVercelのワンクリックデプロイをサポートしています。以下はインストールと使用の詳細な手順です:

モード1:ローカル・インストールと操作

- クローンプロジェクト

ターミナルで以下のコマンドを入力して、プロジェクトをローカルにクローンする:git clone https://github.com/linshenkx/prompt-optimizer.git

次にプロジェクト・ディレクトリに移動する:

cd prompt-optimizer

- 依存関係のインストール

このプロジェクトでは、パッケージ管理ツールとしてpnpmを使用しているので、pnpmがインストールされていることを確認してください。npm install -g pnpm(インストール)を実行します。そして実行する:pnpm installこれで必要な依存パッケージがすべてインストールされる。

- APIキーの設定

プロジェクトは様々なAIモデルをサポートしており、対応するAPIキーを設定する必要がある。プロジェクトのルート・ディレクトリに.envファイルに以下を追加する(実際のニーズに応じて設定を選択する):VITE_OPENAI_API_KEY=your_openai_api_key VITE_GEMINI_API_KEY=your_gemini_api_key VITE_DEEPSEEK_API_KEY=your_deepseek_api_key VITE_CUSTOM_API_KEY=your_custom_api_key VITE_CUSTOM_API_BASE_URL=your_custom_api_base_url VITE_CUSTOM_API_MODEL=your_custom_model_name鍵は、対応するAIサービス・プロバイダー(OpenAIのウェブサイトなど)から入手できる。

- 開発サービスの開始

以下のコマンドを実行して、ローカル開発環境を起動する:pnpm devまたは、以下のコマンドを使用して再構築し、再度実行する(初回起動時またはアップデート後に実行することを推奨):

pnpm dev:fresh起動すると、ブラウザは自動的に

http://localhost:xxxx(具体的なポート番号はターミナル・プロンプトに従う)、ツール・インターフェースにアクセスできる。

アプローチ2:Vercelのワンクリックデプロイメント

- GitHubのプロジェクトページを見る

https://github.com/linshenkx/prompt-optimizer を開き、右上の "Fork" ボタンをクリックしてプロジェクトを GitHub アカウントにコピーします。 - ヴェルセルへのインポート

Vercelにログインし、"New Project "をクリックし、"Import Git Repository "を選択し、プロジェクトのアドレスを入力する。https://github.com/your-username/prompt-optimizer). - 環境変数の設定

Vercelのプロジェクト設定で、"環境変数 "ページに行き、上記のAPIキーを追加する。VITE_OPENAI_API_KEY)を使用して、ローカル・コンフィギュレーションとの一貫性を確保している。 - 配備プロジェクト

Deploy "ボタンをクリックすると、Vercelが自動的にプロジェクトをビルドし、デプロイします。デプロイが完了すると、公開URL(例.https://prompt-optimizer-yourname.vercel.app)、このツールはこのリンクからアクセスできる。

主な機能

1.スマート・キューの最適化

- 手続き::

- ツールのホームページを開き、「Enter Prompt Words」というテキストボックスを見つける。

- 例えば、"AIについての記事を書くのを手伝ってください "というように、最初のプロンプトワードを入力する。

- 最適化」ボタンをクリックすると、システムが自動的に分析し、最適化されたプロンプトを生成します。例えば、「AI技術の発展について、よく構成された詳細な記事を書いてください」などです。

- 最適化結果は以下に表示され、そのままコピーして使用することができます。

- 使用シナリオライティングやコード生成など、AIのアウトプットの質を高める必要がある作業に最適。

2.リアルタイム効果テスト

- 手続き::

- 最適化されたプロンプトの下にある「テスト結果」ボタンをクリックします。

- ターゲットのAIモデル(OpenAIやGeminiなど)を選択すると、システムが対応するモデルを呼び出して出力を生成する。

- テスト結果はインターフェイスに表示され、オリジナルのキュー・ワードの出力と比較できる。

- 使用シナリオ最適化の結果が期待通りであることを確認し、素早くキュー・ワードを調整する。

3.マルチモデル対応の設定

- 手続き::

- 設定ページ(通常は右上の歯車アイコン)で、"モデル選択 "オプションに進みます。

- 構成されたモデル(OpenAI、Geminiなど)をドロップダウンメニューから選択するか、カスタムモデルのAPI情報を手動で入力する。

- 設定を保存した後、メインインターフェースに戻り、選択したモデルで最適化とテストを行うことができます。

- 使用シナリオモデル間で効果を比較する必要がある場合、柔軟にモデルを切り替えることができます。

4.閲覧履歴

- 手続き::

- 画面上の「履歴」ボタン(通常は時計のアイコン)をクリックします。

- このシステムには、過去に最適化されたキュー・ワードとそのテスト結果がリストアップされている。

- レコードをクリックすると詳細が表示されます。

- 使用シナリオ重複を避けるため、過去の最適化シナリオを見直す。

ほら

- ネットワーク接続が安定していることを確認し、APIコールが外部サービスへのリアルタイムのアクセスを必要とすることを確認する。

- APIキーは漏洩を避けるために安全に保管する必要がある。

- デプロイや運用に関する問題が発生した場合は、GitHubページの「Issues」掲示板を参照してください。

以上の手順で、ユーザーはプロンプト・オプティマイザーをすぐに使い始めることができ、ローカルで開発されたものであれ、オンラインで展開されたものであれ、プロンプトの単語を最適化し、AIモデルのパフォーマンスを向上させることが容易になります。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません