Ollamaに似たLLMフレームワークの棚卸し:大規模モデルをローカルに展開するための複数の選択肢

Ollamaフレームワークの登場は、人工知能と大規模言語モデル(LLM)の分野で多くの注目を集めている。このオープンソースのフレームワークは、ローカルでのLLMのデプロイと運用を簡素化することに重点を置いており、より多くの開発者がLLMの魅力を簡単に体験できるようになっている。しかし、市場に目を向けるとOllamaだけではなく、他にも同種のツールが多数登場しており、合わせて開発者により多様な選択肢を提供している。この記事では、以下のようなツールを詳しく見ていこう。 オーラマ これらのようないくつかの大規模なモデルフレームワークツールが、読者がこの分野の技術エコシステムをより包括的に理解し、自分に最も適したツールを見つける一助となれば幸いである。

オラマ・フレームワークの紹介

Ollamaは、ローカル環境における大規模言語モデル(LLM)の導入と運用を簡素化するために設計されています。Llama 2、Code Llama、Mistral、Gemmaなど、主流のLLMを幅広くサポートしており、ユーザーは必要に応じて独自のモデルをカスタマイズして作成することができます。 チャットGPT チャット・インターフェースにより、ユーザは追加開発なしにモデルと直接対話することができる。さらに、Ollamaのクリーンなコードと低いランタイムリソース使用量は、ローカルコンピュータ上で実行するのに理想的です。

Ollamaに似たツール

vLLMの紹介

ブイエルエルエム Vectorised Large Language Model Serving System (VLLM)は、LLM用にカスタマイズされた効率的な大規模モデル推論およびサービスエンジンです。vLLMは、革新的なPagedAttentionテクノロジー、継続的なバッチ処理、CUDAコアの最適化、および分散推論サポートにより、LLM推論のパフォーマンスを大幅に向上させます。革新的なPagedAttentionテクノロジー、継続的なバッチ処理、CUDAコアの最適化、分散推論サポートにより推論性能を向上。

特性

ブイエルエルエム vLLMは、PyTorch、TensorFlowなど様々なモデル形式をサポートしており、ユーザーのニーズに合わせて柔軟に選択することが可能です。同時に、vLLMはオンライン推論とバッチ推論をサポートする高性能な推論エンジンを搭載しており、多数の同時リクエストに迅速に対応し、高負荷のシナリオでも高いパフォーマンスを発揮します。

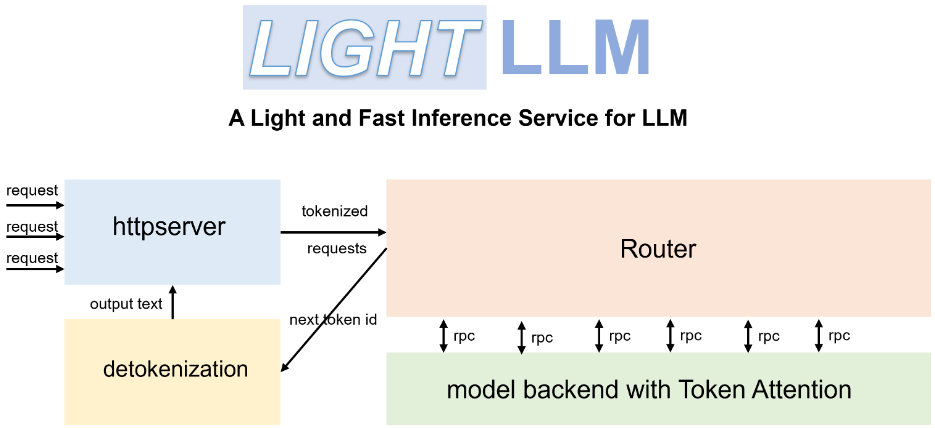

LightLLMの紹介

ライトLLM はPythonベースの軽量で高性能なLLM推論とサービスのフレームワークです。FasterTransformer、TGI、vLLM、FlashAttentionなど様々なオープンソース実装の長所を生かし、新しいLLMサービスモデルをユーザーに提供します。

特性

ライトLLM 独自の3プロセス・アーキテクチャは、トークン化、モデル推論、デトケン化の3つの主要ステップを切り離し、非同期コラボレーション・メカニズムを通じて並列に実行します。この設計により、GPUの利用率が大幅に向上し、データ転送による待ち時間が短縮されるため、推論の効率が効果的に改善されます。さらに、LightLLMはNopad no-fillオペレーションをサポートしており、長さの差が大きいリクエストをより効率的に処理し、無効なフィルを回避することができるため、リソースの利用率が向上します。

llama.cppの紹介

ラマ.cpp はCとC++で開発されたLLM推論エンジンである。アップル社のシリコンチップ用に深くパフォーマンス最適化されており、アップル社のデバイス上でMetaのLlama 2モデルを効率的に実行することができる。

特性

llama.cppの主な目的は、LLM推論を様々なハードウェアプラットフォームに実装し、最小限の構成で最高のパフォーマンスを提供することです。さらにパフォーマンスを向上させるために、llama.cppは1.5-bit、2-bit、3-bit、4-bit、5-bit、6-bit、8-bitの整数化など、様々な量子化オプションを提供し、推論を高速化し、メモリフットプリントを削減するように設計されています。さらに、llama.cppはCPU/GPU混在推論をサポートし、推論の柔軟性と効率をさらに向上させます。

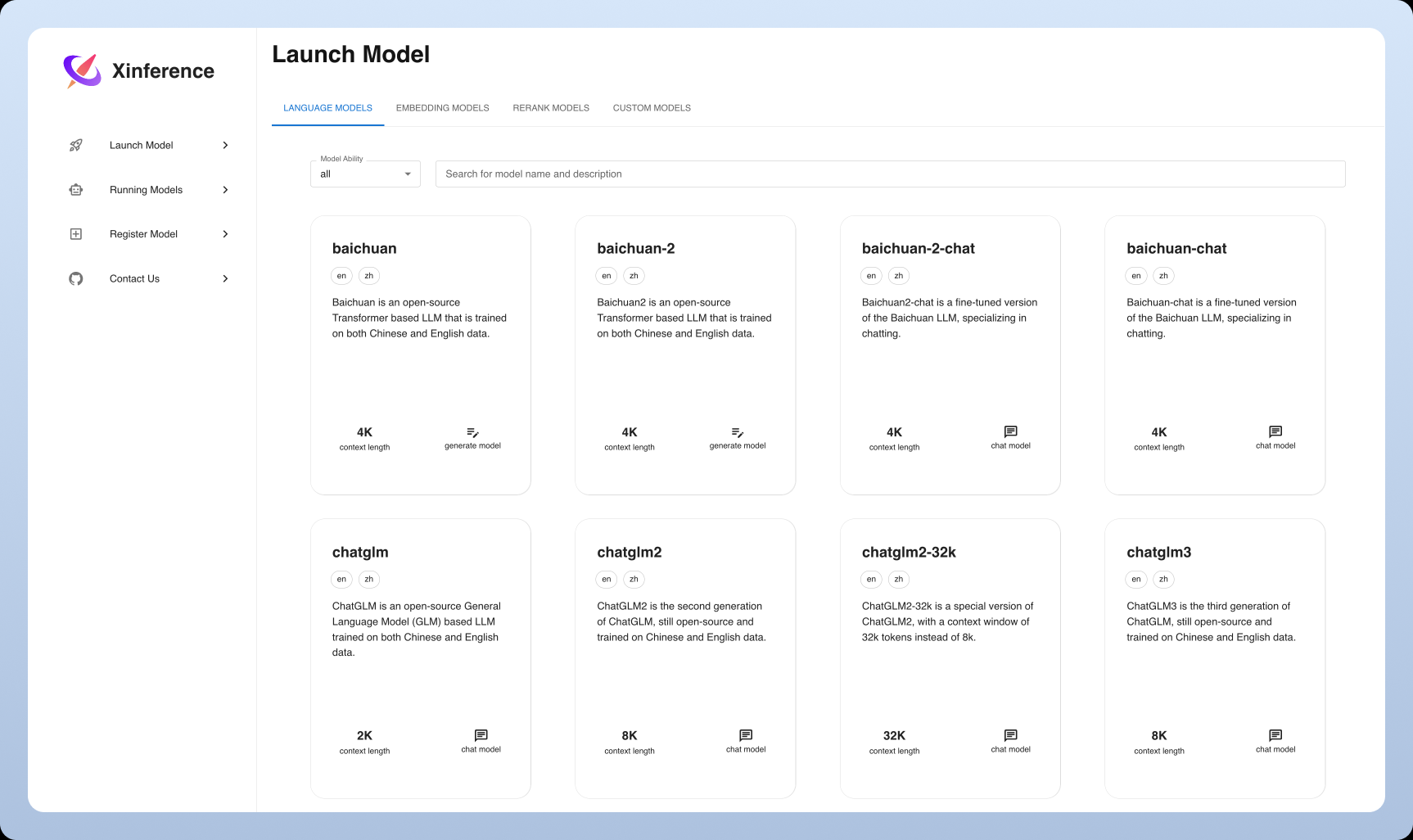

シンファレンス入門

シンファレンス は、LLMだけでなく、画像や音声を含む様々なモダリティのモデルをサポートする、新しい汎用推論フレームワークである。モデルの導入や利用の敷居を下げ、統一されたインターフェースとフレンドリーなユーザーエクスペリエンスを提供することを目指している。

特性

シンファレンス Xinferenceのハイライトは、マルチモーダルモデルを幅広くサポートしていることで、ユーザーは同じプラットフォーム上で異なるタイプのモデルを簡単に展開し、体験することができます。同時に、Xinferenceは使いやすさに重点を置き、Web UI、Pythonクライアントなどの多様な対話方法を提供し、モデルの統一的な管理と柔軟な拡張をサポートします。

ツールの比較と分析

インストールと展開

オーラマ インストールは非常に簡単で、Ollamaは明確で簡潔なインストールガイドを提供し、多くの主要なオペレーティングシステムをサポートしています。簡単なコマンドライン操作だけで、大規模な言語モデルを簡単に立ち上げることができます。

vLLM。 対照的に、vLLMのインストールはやや複雑で、ユーザーは以下を行う必要がある。事前にPython環境の設定と依存ライブラリのインストール。しかし一旦デプロイされれば、vLLMの効率的な推論性能は、特にパフォーマンスを重視するシナリオにおいて、ユーザーを大きく後押しするだろう。

LightLLM。 LightLLMのインストールプロセスは比較的ユーザーフレンドリーであり、詳細なインストールおよび設定ガイドが提供されているため、ユーザーはすぐに使い始めることができます。ユーザーは必要に応じて、展開に適したモデル形式を柔軟に選択することができます。

llama.cpp。 llama.cppのデプロイには、ある程度の技術的な知識が必要で、ユーザーにはまずいC++ 開発環境の設定しかし、技術愛好家や開発者にとっては、一度設定すれば、llama.cppの高性能推論エンジンは、モデル推論のあらゆる側面を深く制御し、究極のユーザーエクスペリエンスを提供します。

シンファレンス Xinferenceはインストールやデプロイも比較的簡単で、DockerイメージやPythonパッケージが提供され、ユーザーはすぐに環境を構築することができる。同時に、Xinferenceは包括的なWeb UIインターフェースも提供しており、利用の敷居を低くしている。

モデルのサポートと互換性

オーラマ モデルのサポートに関しては、OllamaはLlama 2やCode Llamaなど多くのオープンソースモデルをサポートし、ユーザーがカスタムモデルをアップロードできるなど、オープン性に優れている。さらにOllamaは、ユーザーが様々なモデルをすぐに使い始められるように、あらかじめ構築されたモデルのライブラリを提供している。

vLLM。 vLLMはモデルフォーマットの互換性に優れており、PyTorch、TensorFlow、その他多くの主要なモデルフォーマットをサポートしています。可能 ユーザーは柔軟にモデルを選択できる。vLLMは分散推論もサポートしており、複数のGPUの演算能力をフルに活用してモデルを並列実行できるため、推論効率がさらに向上する。

LightLLM。 また、LightLLMはモデルフォーマットの互換性にも優れており、一般的に使用されている様々なモデルフォーマットをサポートしています。同時に、LightLLMは豊富なAPIとツールを提供し、詳細なカスタマイズを容易にし、より幅広いユーザーのニーズに応えます。特別アプリケーションシナリオの必要性。

llama.cpp。 llama.cppはLlamaモデルを極限推論に最適化することに重点を置いていますが、他のモデルもサポートしています。その効率的な推論エンジンにより、llama.cppは大規模なデータセットを扱っても優れたパフォーマンスを維持することができます。

シンファレンス Xinferenceのハイライトの1つは、そのモデルサポートで、様々なLLMをサポートするだけでなく、安定拡散のような画像生成モデルもサポートしています。 ウィスパー と他の音声モデルとの強力なマルチモーダルモデル互換性を実証し、ユーザーに幅広い応用空間を提供します。

パフォーマンスと最適化

オーラマ OllamaはそのクリーンなAPIと効率的な推論パフォーマンスで知られているが、大量の同時リクエストのあるシナリオではパフォーマンスのボトルネックがあるかもしれない。それでもOllamaは、使いやすさと迅速なデプロイを求めるユーザーには良い選択だ。

vLLM。 vLLMは、極めて高いパフォーマンスを実現するために構築されています。PagedAttentionのような技術によってLLM推論性能を大幅に向上させ、特に多数の同時リクエストを処理する場合に、厳しいサービス性能要件のアプリケーションシナリオを満たすことができます。

LightLLM。 LightLLMはパフォーマンスの最適化にも力を入れている。独自の3プロセス・アーキテクチャと非同期コラボレーション・メカニズムにより、LightLLMはGPUの利用率と推論速度を効果的に向上させます。 さらに、LightLLMはNopadのノーフィル操作をサポートしており、リソースの利用率をさらに向上させています。 全体的なパフォーマンスに貢献.

llama.cpp。 llama.cppはパフォーマンスの面でも優れている。効率的な推論エンジンを備えているだけでなく、推論速度とメモリ使用量の間で柔軟性を持たせるために、様々な数量化オプションを提供している。均衡また、llama.cppはCPU/GPU混在推論をサポートしています。さらに、llama.cppはCPU/GPU混在推論もサポートしており、推論の柔軟性と効率をさらに高め、ユーザーは以下のような推論を行うことができます。さいゆうしゅうコンフィギュレーション。

シンファレンス Xinferenceはまた、性能の最適化も行っており、推論効率を向上させ、リソース消費を削減するために、モデルの定量化や刈り込みなどの技術をサポートしています。 さらに、Xinferenceは、マルチモーダルモデル推論のパフォーマンスを向上させるために繰り返し最適化されます。

総括と展望

Ollamaに類似したツールには、それぞれの特徴と利点があり、ユーザーはアプリケーションのシナリオと実際のニーズに応じて適切なフレームワークを選択することができます。 人工知能と大規模言語モデリング技術の継続的な発展により、これらのツールは改善とアップグレードを続け、より効率的で便利なソリューションをユーザーに提供する。 今後、これらのツールは、自然言語処理、インテリジェントな顧客サービス、テキスト生成などの分野でより大きな役割を果たし、人工知能技術の開発と応用をさらに促進し、最終的には気付く すべての人のための人工知能の美しいビジョン。

提言と提案

Ollamaは初心者や個人ユーザーには良い選択かもしれない。 OllamaはシンプルなAPIとフレンドリーなユーザー・インターフェースを提供しており、ユーザーは追加開発なしに直接モデルと対話することができる。 さらに、Ollamaは幅広いオープンソースモデルをサポートしているため、ユーザーはすぐに使い始め、様々なアプリケーションシナリオを試すことができ、LLMをローカルに展開する楽しさをすぐに体験することができる。

並行性の高いリクエストを処理する必要があるビジネス・ユーザーにとっては、vLLMの方が良い選択かもしれない。 vLLMの効率的な推論性能と分散推論サポートは、高度な並行シナリオの要求を満たし、事業継続性を確保するためのより安定した信頼性の高いソリューションをユーザーに提供することができる。安定性と継続性.

LightLLMとllama.cppは、カスタム開発と深い最適化のための一定の技術基盤を持つユーザーに適しています。 この2つのツールは、開発者により大きな柔軟性と、基礎となる 可 の責任はユーザーにある。スペック よりパーソナライズされた高性能のLLMアプリケーションを作成します。

Xinferenceはまた、マルチモーダルモデルを試してみたい人や、既成概念にとらわれない体験を求めている人のための選択肢でもある。 Xinferenceは、マルチモーダルモデルを使用するための障壁を低くし、ユーザーが単一のプラットフォーム上で幅広いAIモデルのパワーを体験できるようにします。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません