1つのハブ:OpenAIインターフェースの管理と配布、複数のモデルと統計機能のサポート

はじめに

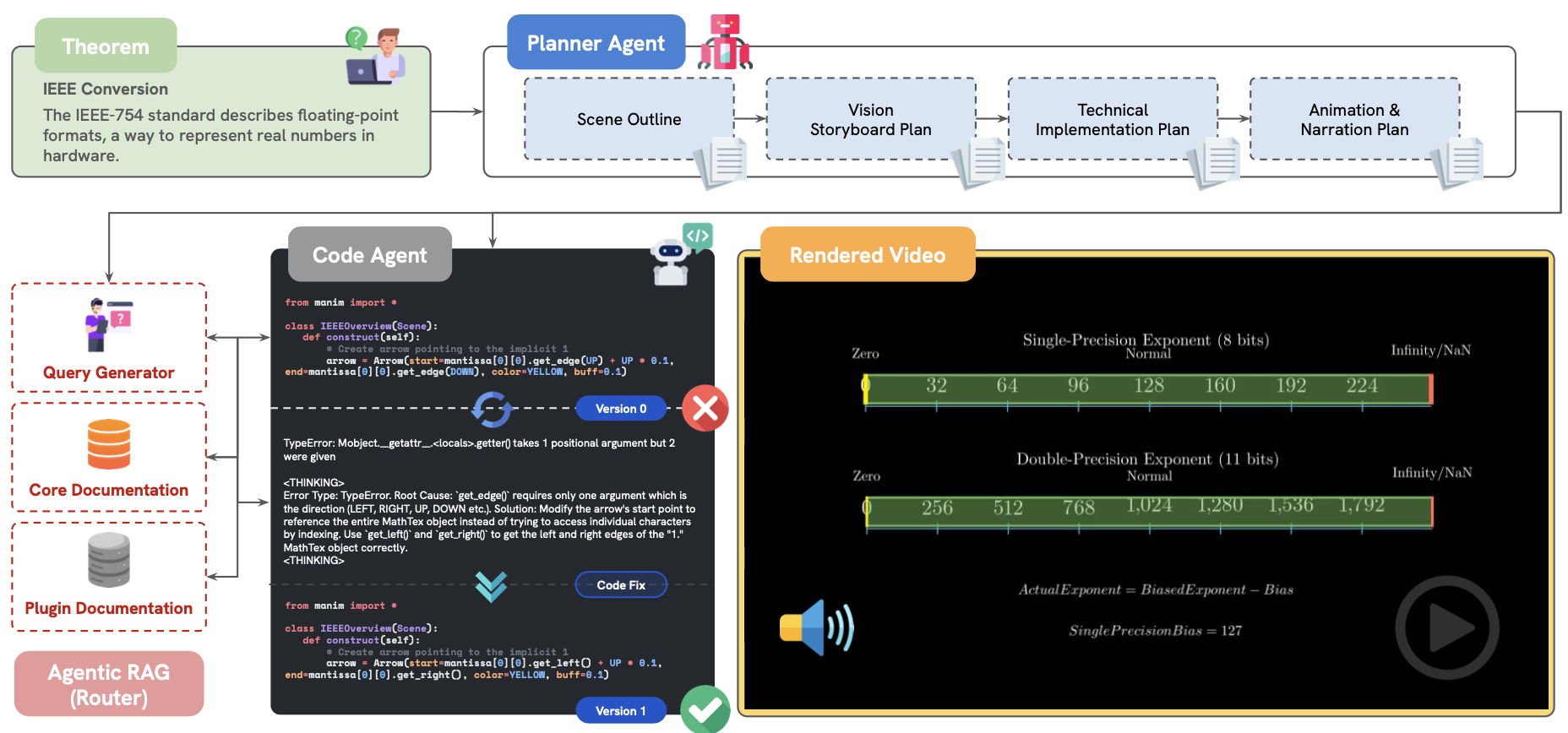

ワン・ハブはウェブベース つのAPI OpenAIのインターフェース管理・配信システムの第二弾。より広範なモデルのサポートと統計の向上を目指してMartialBEによって開発されたOne Hubは、新しいユーザーダッシュボードと管理者統計インターフェースを備えた新しいユーザーインターフェースと、リファクタリングされたトランジットプロバイダーモジュールを特徴としています。非OpenAIモデルを含む幅広いモデルの関数呼び出しをサポートし、豊富な設定オプションと監視機能を提供します。 One Hubは、OpenAIインターフェースの管理と配布を必要とする開発者と企業を対象としており、幅広いAIモデルをより効率的に使用および監視するのに役立ちます。

機能一覧

- 幅広いOpenAIおよび非OpenAIモデルのファンクションコールをサポートします。

- 新しいユーザー・ダッシュボードと管理者統計インターフェース

- トランジット・プロバイダー・モジュールのリファクタリングにより、ユーザー・モデル・リストの動的な返却をサポート。

- TTS 機能の Azure Speech エミュレーションのサポート

- 個別のhttp/socks5プロキシの設定をサポート

- カスタマイズされたスピードモデルと経過時間のロギング要求のサポート

- テレグラムボットとモデル有料視聴のサポート

- モデルのワイルドカードとプロファイル・ランチャーのサポート

- プロメテウスのモニタリングに対応

- 支払いおよびユーザーグループRPM設定のサポート

ヘルプの使用

設置プロセス

- プロジェクトコードをクローンする:

git clone https://github.com/MartialBE/one-hub.git

- プロジェクト・カタログにアクセスする:

cd one-hub

- 環境変数と依存関係を設定する:

cp config.example.yaml config.yaml

必要に応じて修正する config.yaml ファイルの設定項目。

- Dockerで起動する:

docker-compose up -d

または、ローカル環境を使用して開始する:

go run main.go

使用機能

ユーザー・ダッシュボード

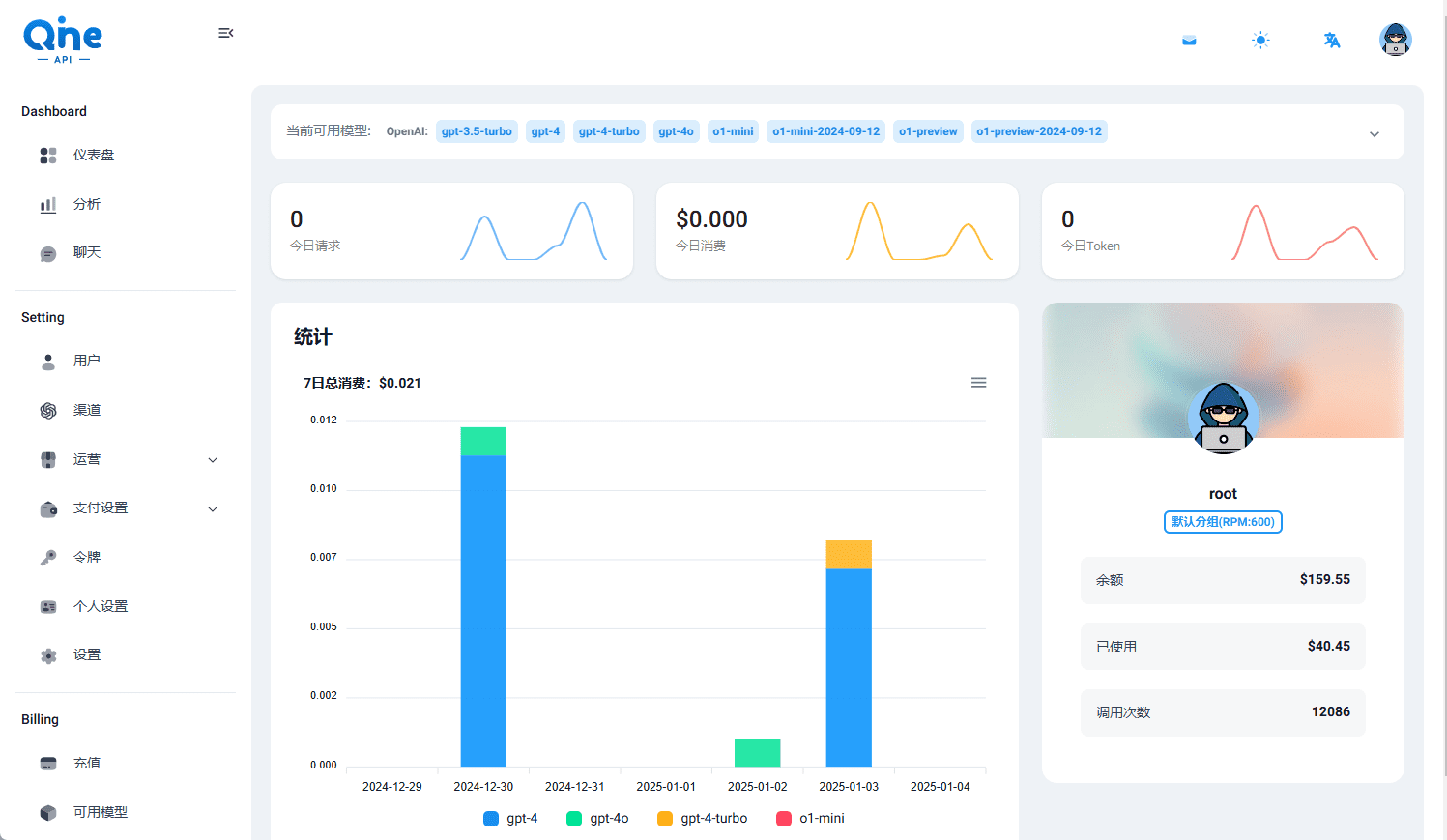

ユーザーダッシュボードは、ユーザーがAPIコールを表示および管理できる直感的なインターフェースを提供します。ダッシュボードでは、APIの使用状況をリアルタイムで監視し、詳細なコールログと統計情報を表示できます。

管理者統計インターフェース

管理者統計インターフェースは、管理者に包括的なデータ分析ツールを提供します。管理者は、すべてのユーザーのAPIコールを表示し、詳細な統計レポートを作成し、データに基づいて最適化と調整を行うことができます。

トランジット・プロバイダー・モジュール

Transit Providerモジュールは、ユーザーモデルリストの動的なリターンをサポートし、個々のhttp/socks5プロキシを構成することができます。管理者は必要に応じてプロバイダを追加または削除し、APIコールのパフォーマンスと安定性を最適化するために異なるプロキシ設定を行うことができます。

Azure SpeechはTTS機能をエミュレートする

One Hubは、TTS機能をエミュレートするAzure Speechの使用をサポートしており、ユーザーはAzure Speechサービスを設定して、高品質の音声出力を生成することができます。設定方法は以下の通り:

- ある

config.yamlファイルに Azure Speech 設定を追加します:

azure_speech:

api_key: "your_api_key"

region: "your_region"

- 設定を有効にするには、One Hubサービスを再起動します。

カスタマイズされた速度モデルとログ要求の経過時間

ユーザーはOne Hubでスピードモデルをカスタマイズし、各APIコールのリクエスト経過時間を表示できます。これらの機能により、ユーザーはモデルのパフォーマンスを最適化し、APIコールを効率的に行うことができます。

テレグラムボットとモデル有料視聴のサポート

One HubはTelegramボットによる通知と管理をサポートしており、ユーザーはTelegram上でAPI呼び出しの通知をリアルタイムで受け取ることができる。さらに、One Hubは使用ごとの課金モデルをサポートしており、ユーザーは使用量に応じて柔軟に課金・管理することができる。

詳しい操作手順

- One Hubにログイン後、ユーザーダッシュボードにアクセスしてAPIコールを表示します。

- 管理者インターフェイスで、ベンダーの追加または削除、およびエージェント設定を行います。

- Azure Speechサービスが音声出力を生成するように設定します。

- 速度測定モデルをカスタマイズして、APIコールのリクエスト経過時間を表示します。

- Telegramボットで通知を受け取り、モデルのペイ・パー・ビューを管理する。

上記の詳細なヘルプにより、ユーザーはOne Hubをすぐに使い始めることができ、OpenAIインターフェースの管理と配布のための豊富な機能をフルに活用することができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません