Ollama+LangGraph 学術研究レポート作成アシスタントのローカル展開

はじめに

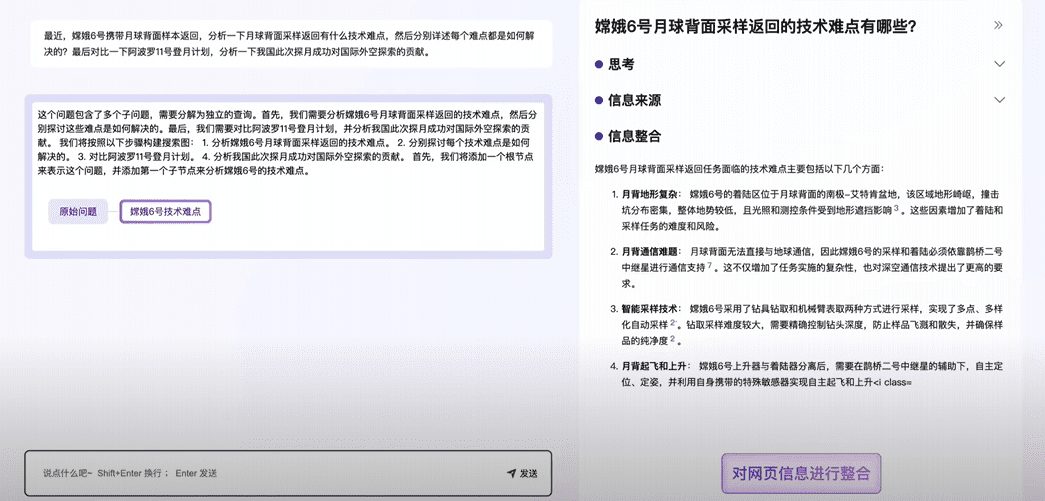

オーラマ Deep Researcherは、LangChainチームによって開発された、完全にネイティブで動作するウェブリサーチとレポート生成アシスタントです。Ollamaがホストする任意のLarge Language Model (LLM)を使用し、ユーザがリサーチトピックを入力すると、自動的にウェブ検索クエリを生成し、情報を収集し、コンテンツを要約し、ソースを含むMarkdownレポートを生成します。すべてのプロセスは、プライバシーを保護し、追加費用なしで、外部モデルを呼び出すためのインターネット接続を必要とせずに行われます。DuckDuckGo, Tavilyまたは 当惑 などの検索ツール、ユーザーは調査サイクルの数をカスタマイズすることができ、詳細な調査を必要とし、構造化されたレポートを生成するユーザーに適しています。簡単にインストールでき、オープンソースで無料です。

機能一覧

- ローカルオペレーティング言語モデル(LOLM)外部APIを使わず、Ollamaを通してネイティブのLLMを使う。

- 検索クエリの自動生成ユーザーテーマに基づいて正確なウェブ検索語を生成します。

- ウェブ情報収集DuckDuckGo(デフォルト)、Tavily、Perplexityの検索に対応。

- コンテンツの要約と最適化検索結果を分析し、欠点を見つけ、要約を改善する。

- マークダウン・レポートの作成すべての出典を引用した構造化されたレポートを出力する。

- リサーチの深さをカスタマイズするユーザーはサイクル数を設定し、試験の詳細レベルをコントロールすることができる。

- ワークフローの可視化スルー ラングラフ スタジオ 操作の各ステップを表示します。

- 複数のモデルをサポート互換性がある ディープシーク R1、ラマ3.2、その他のモデル。

ヘルプの使用

設置プロセス

Ollama Deep Researcherはローカル環境のサポートが必要です。以下は、MacとWindowsユーザのための詳細な手順です。

マックユーザー

- Ollamaをインストールする

- OllamaのウェブサイトからMac版のインストーラーをダウンロードしてください。

- インストール後、ターミナル

ollama --versionバージョンを確認する。

- プルモデル

- それをターミナルに入力する:

ollama pull deepseek-r1:8b推奨モデルのダウンロード - こちらも利用可能

ollama pull llama3.2.

- それをターミナルに入力する:

- クローンプロジェクト

- 以下のコマンドを実行する:

git clone https://github.com/langchain-ai/ollama-deep-researcher.git cd ollama-deep-researcher

- 以下のコマンドを実行する:

- 仮想環境の構築(推奨)

- Python 3.9+がインストールされていることを確認してください。実行してください:

python -m venv .venv source .venv/bin/activate

- Python 3.9+がインストールされていることを確認してください。実行してください:

- 依存関係をインストールして開始する

- インプット:

curl -LsSf https://astral.sh/uv/install.sh | sh uvx --refresh --from "langgraph-cli[inmem]" --with-editable . --python 3.11 langgraph dev - ブラウザを起動するとLangGraph Studioが開きます(デフォルト)。

http://127.0.0.1:2024).

- インプット:

Windowsユーザー

- Ollamaをインストールする

- OllamaのウェブサイトからWindows版をダウンロードしてください。

- インストール後、コマンドラインから

ollama --version検証。

- プルモデル

- インプット:

ollama pull deepseek-r1:8b.

- インプット:

- クローンプロジェクト

- 走っている:

git clone https://github.com/langchain-ai/ollama-deep-researcher.git cd ollama-deep-researcher

- 走っている:

- 仮想環境の構築

- Python 3.11をインストールし("Add to PATH "にチェックを入れて)、実行する:

python -m venv .venv .venv\Scripts\Activate.ps1

- Python 3.11をインストールし("Add to PATH "にチェックを入れて)、実行する:

- 依存関係をインストールして開始する

- インプット:

pip install -e . pip install -U "langgraph-cli[inmem]" langgraph dev - 発売後のアクセス

http://127.0.0.1:2024.

- インプット:

設定検索ツール(オプション)

- DuckDuckGoはデフォルトで使用され、APIキーは必要ありません。

- もし タヴィリー あるいは当惑:

- のコピーを取る。

.env.exampleというのも.env. - コンパイラ

.envキーを追加する:TAVILY_API_KEY=your_tavily_key PERPLEXITY_API_KEY=your_perplexity_key - オプション設定:

OLLAMA_BASE_URL(デフォルト)http://localhost:11434).MAX_WEB_RESEARCH_LOOPS(デフォルト3)。

- のコピーを取る。

使用方法

- LangGraphスタジオを開く

- サービス開始後

http://127.0.0.1:2024. - インターフェイスは左右に分かれており、左がコンフィギュレーション、右が入力と結果となっている。

- サービス開始後

- 設定パラメータ

- 検索ツールDuckDuckGo、Tavily、Perplexityからお選びください。

- モデリングダウンロードしたモデルの名前を入力してください。

deepseek-r1:8b). - サイクル数デフォルトは3回。

- 設定を保存します。

- テーマを入力する

- 右側の入力ボックスに「機械学習の未来」などの研究テーマを入力してください。

- Run "をクリックし、調査を開始する。

- プロセスと結果を見る

- Studioは、クエリーの生成、検索、サマリーなど、各ステップを表示します。

- 終了すると、Markdownレポートはプロジェクトフォルダのグラフ状態に保存されます。

注目の機能操作

- 調査の深さを調整する

- コンフィギュレーションの変更

MAX_WEB_RESEARCH_LOOPS回数を5回に設定すると、結果はより包括的になるが、より時間がかかる。

- コンフィギュレーションの変更

- トグル検索ツール

- DuckDuckGo 無料だが結果は限定的, Tavily より詳細(キーが必要)。切り替え後、サービスを再起動してください。

- モデルの互換性チェック

- エラーが報告された場合(例えば

KeyError: 'query')、モデルがJSON出力をサポートしていないことを示します。への切り替えは ディープシークR1 (8B)またはラマ3.2.

- エラーが報告された場合(例えば

ほら

- ハードウェア要件8Bモデルは8GB、13Bモデルは16GBのメモリーが必要。

- ブラウザの互換性Firefoxを推奨しますが、Safariではセキュリティ警告が出る場合があります。

- エラー検出もし行き詰まったら、端末のログをチェックしてください。依存関係の更新やモデルの変更が必要かもしれません。

アプリケーションシナリオ

- 学術研究

- シーンの説明生徒が「ニューラルネットワーク最適化法」と入力すると、ツールが検索し、引用文献を含むレポートを作成するので、情報を探す時間が節約できる。

- 業界分析

- シーンの説明2025年までのAI市場動向」は、意思決定を支援する詳細なサマリーを提供するツールである。

- テクニカル・ラーニング

- シーンの説明開発者が「Python非同期プログラミング」と入力すると、チュートリアルレポートが生成され、自習が容易になります。

品質保証

- ネットワークは必要ですか?

- ローカルモデルはインターネット接続を必要としないが、ウェブ検索には接続が必要。オフラインの場合は、既存のデータしか使用できない。

- 中国語に対応していますか?

- サポートしています。中国語のテーマを入力すると、中国語の検索結果が生成されるが、検索ツールによって効果は異なる。

- 報告書を修正することは可能か?

- Markdownファイルは直接編集できる。

- JSONエラーが発生した場合はどうすればよいですか?

- これは、モデルが構造化出力をサポートしていないことを意味します。DeepSeek R1 (8B) または Llama 3.2 で再試行してください。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません