MuseV+Muse Talk:完全なデジタルヒューマンビデオ生成フレームワーク|ポートレートからビデオへ|ポーズからビデオへ|リップシンク

はじめに

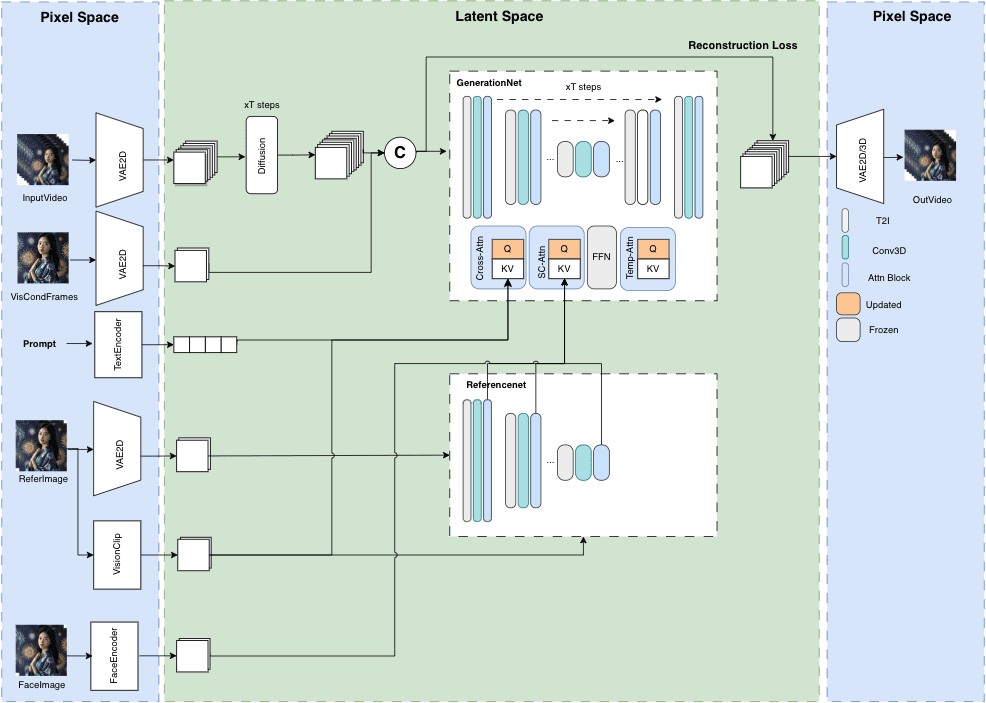

MuseVは、長さ無制限で忠実度の高いアバター動画生成を目的としたGitHub上の公開プロジェクトです。拡散技術に基づき、Image2Video、Text2Image2Video、Video2Videoなど様々な機能を提供する。モデル構造の詳細、ユースケース、クイックスタートガイド、推論スクリプト、謝辞が掲載されています。

MuseVは、拡散モデルに基づいたバーチャルヒューマン映像生成フレームワークで、以下のような特徴がある:

特にカメラ位置が固定されたシーンにおいて、誤差の蓄積の問題なしに、新しい視覚的条件付き並列ノイズ除去スキームを用いた無限長生成をサポートする。

キャラクタータイプのデータセットで訓練されたアバタービデオ生成のための事前訓練モデルが提供される。

画像から動画、テキストから画像から動画、動画から動画の生成に対応。

base_model、lora、controlnetなど、Stable Diffusionのグラフィック生成エコシステムと互換性があります。

IPAdapter、ReferenceOnly、ReferenceNet、IPAdapterFaceIDなど、複数の参照画像技術をサポート。

トレーニングコードも後ほど公開する予定だ。

機能一覧

長さ無制限のビデオ生成

高忠実度バーチャル人体画像

多彩なサポート:Image2Video、Text2Image2Video、Video2Video

明確なモデル構造とユースケース

クイック・スタートと推論スクリプト

ヘルプの使用

GitHubリポジトリでアップデートやダウンロード可能なリソースを確認する

クイックスタートガイドに従ってプロジェクトの初期設定を行う

提供された推論スクリプトを使用して、ビデオコンテンツを生成する。

併用法:

方法1:ライブビデオ録画+ミューズ・トーク

方法2:写真+MuseV+ミューズトーク

完成品

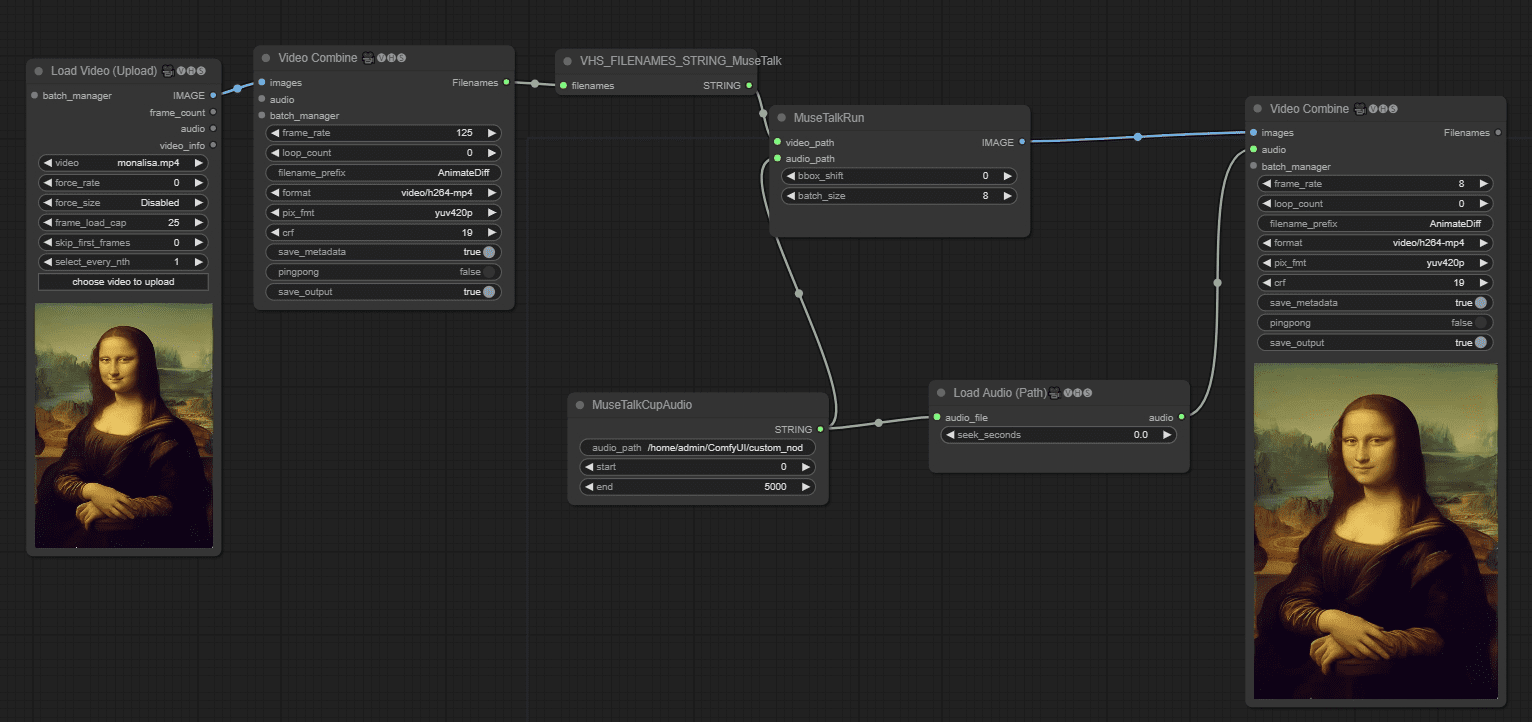

静止画のループ動画から、アニメキャラを喋らせる、アニメキャラの唇自体が無いので喋り方に違和感がある、次回は「唇」のある画像に変更した方が良い、出来れば「実在の人物」が良い。公式で45秒の動画テスト環境で15分ほど待つ

ComfyUIワークフローでビデオを語る

打ち上げ MuseTalk MuseTalkは、リアルタイムで高品質な口元シンクロモデルです(NVIDIA Tesla V100で30fps+)。 MuseTalkは、完全なアバターソリューションとして、MuseVで生成されたような入力ビデオに適用できます。

MuseVオンライン体験 / Windowsワンクリックインストールパッケージ

リンク:https://pan.quark.cn/s/ed896ceda5c8

抽出コード: JygA

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません