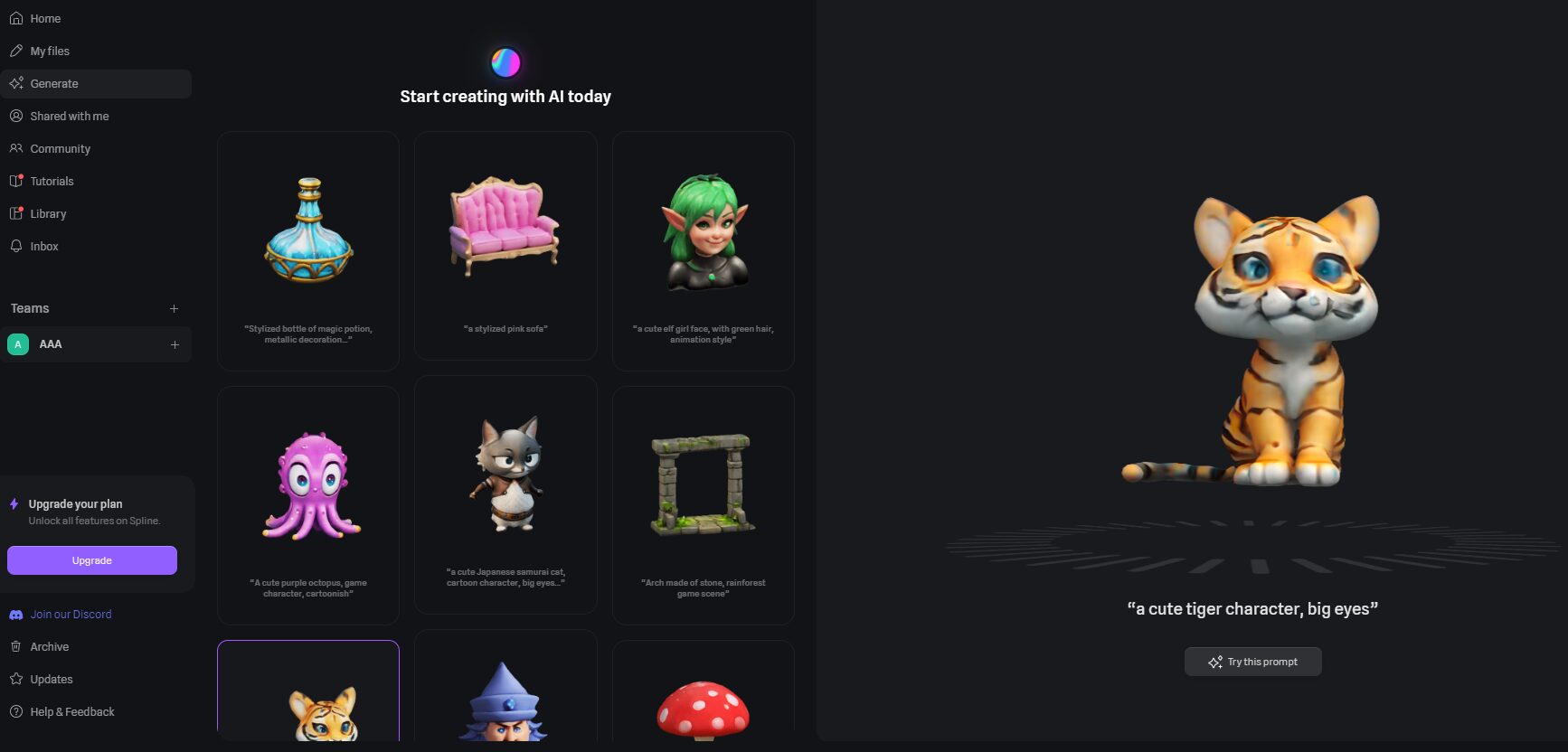

MobileCLIP2 - アップルのオープンソースによる効率的なエンドサイド・マルチモーダルモデル

MobileCLIP2とは

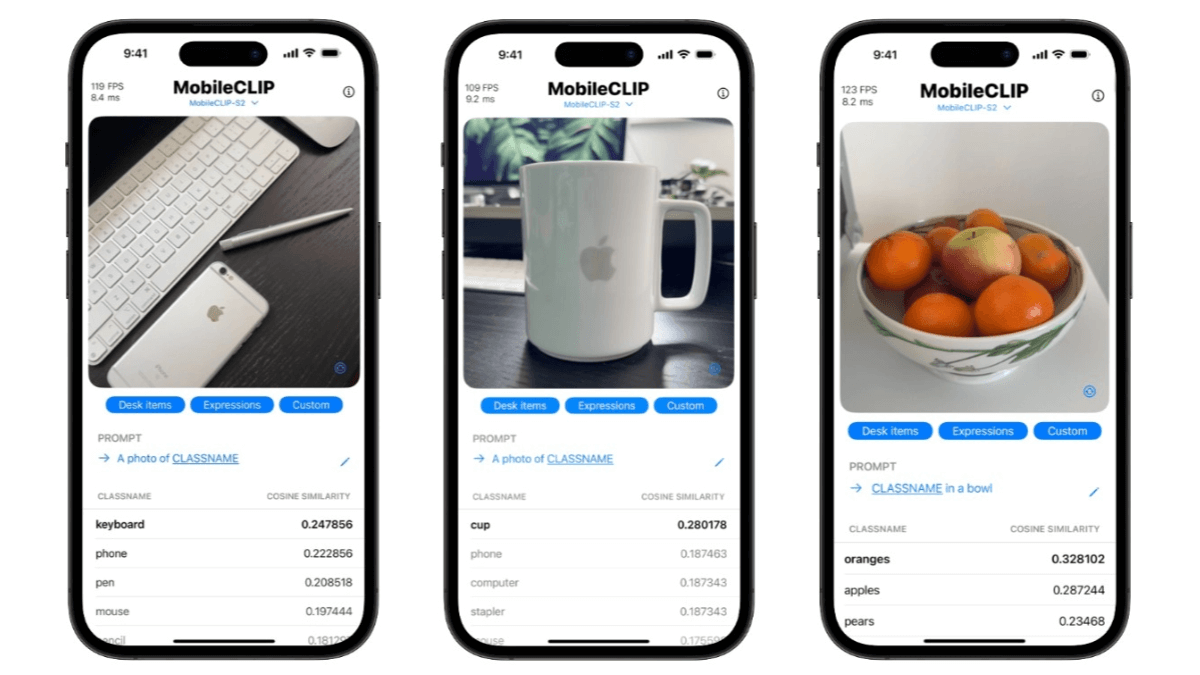

MobileCLIP2は、Apple社の研究者によって導入された効率的なエンドサイド・マルチモーダルモデルであるMobileCLIPのアップグレード版である。MobileCLIP2はゼロサンプル分類タスクで良好な性能を発揮し、例えばImageNet-1kのゼロサンプル分類タスクでは、MobileCLIP-Bと比較して精度が2.2%向上した。-MobileCLIP2-S4は、SigLIP-SO400M/14と同等の性能を維持しながら、モデルサイズが小さく、推論レイテンシが低い。また、視覚言語モデルの評価や集中的な予測タスクなど、さまざまなダウンストリームタスクで優れた性能を発揮しています。

MobileCLIP2の特徴

- 効率的なマルチモーダル理解画像とテキストを同時に処理し、画像とテキストの正確なマッチングと理解を可能にする能力。

- 軽量モデル・アーキテクチャモバイル機器やエッジコンピューティング環境での迅速な展開と運用のために、効率的なモデル構造を設計。

- ゼロサンプルの分類能力学習データを追加することなく画像を直接分類することは、適応性が高く、新しいタスクに素早く適用することができます。

- 低遅延推論モデルの推論速度を最適化することで、リソースに制約のあるデバイスでも高速なレスポンスを実現し、ユーザーエクスペリエンスを向上させます。

- プライバシーエンドサイドの処理をサポートするため、データをクラウドにアップロードする必要がなく、ユーザーのプライバシーを保護し、プライバシー要件の高いアプリケーションシナリオに適しています。

- 強力な特徴抽出画像やテキストから高品質なマルチモーダル特徴量を抽出し、画像分類やターゲット検出など、様々な下流タスクに広く利用することができます。

- て微調整と最適化により、さまざまなタスクやデータセットに適応し、優れた汎化能力を発揮します。

MobileCLIP2の主な利点

- 高性能MobileCLIP2は、高いパフォーマンスを維持しながら、モデルの計算複雑性と推論レイテンシを大幅に削減し、リソースに制約のあるデバイスでの高速動作に適しています。

- 軽量アーキテクチャMobileCLIP2-BやMobileCLIP2-S4などの軽量モデルで設計されており、モバイル機器やエッジコンピューティング環境への効率的な導入を可能にします。

- 猛特訓マルチモーダル強化学習を最適化することで、画像とテキストを共同で理解するモデルの能力が向上し、マルチモーダル特徴の表現が強化される。

- プライバシーエンドサイド処理をサポートしているため、データをクラウドにアップロードする必要がなく、ユーザーのプライバシーを効果的に保護し、特にプライバシー要件が高いアプリケーションシナリオに適している。

- ゼロサンプル学習強力なゼロサンプル分類機能により、クラス固有の学習データがなくても、テキスト記述から画像を分類することができます。

MobileCLIP2の公式ウェブサイトは?

- Githubリポジトリ:: https://github.com/apple/ml-mobileclip

- HuggingFaceモデルライブラリ:: https://huggingface.co/collections/apple/mobileclip2-68ac947dcb035c54bcd20c47

MobileCLIP2の対象者

- IoT開発者このモデルは、スマートホームや防犯カメラなどのIoT機器に統合して、局所的なインテリジェントな意思決定を行うことができる。

- 人工知能研究者マルチモーダルモデルの最適化と応用を研究し、新しいアルゴリズムとテクニックを探求するために使用できます。

- データサイエンティストMobileCLIP2のマルチモーダル特徴抽出機能は、機械学習プロジェクトに高品質な特徴を提供するために活用できます。

- プライバシー擁護者医療や金融の分野など、データのプライバシーが厳しく要求されるアプリケーションに適しています。

- 教育者画像とテキストを組み合わせることで、教育や学習を向上させるインテリジェント・チュータリング・ソフトウェアなどの教育ツールの開発に利用できる。

- コンテンツクリエーターモデルを使って、クリエイティブなテキストを作成したり、画像を分類したりすることができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません