MiniMax初のオープンソースMiniMax-01、4Mの超ロング・コンテキスト、新アーキテクチャ、トランスフォーマーに挑戦

「MoE」+「前例のない大規模な生産環境への導入」。 雷 注目」と「フレームワークからCUDAレベルまでのソフトウェアとエンジニアリングのリファクタリング」。

その答えは、トップモデルの能力を結びつけ、コンテキストの長さを400万トークンレベルまで引き上げた新しいモデルである。

1月15日、マクロモデリング会社MiniMaxは、長らく予告されていた新モデルシリーズ:MiniMax-01を正式に発表した。MiniMax-01は、ベースとなる言語マクロモデルMiniMax-Text-01と、その上に軽量なViTモデルを統合して開発されたビジュアルマルチモーダルマクロモデルMiniMax-VL-01で構成されている。

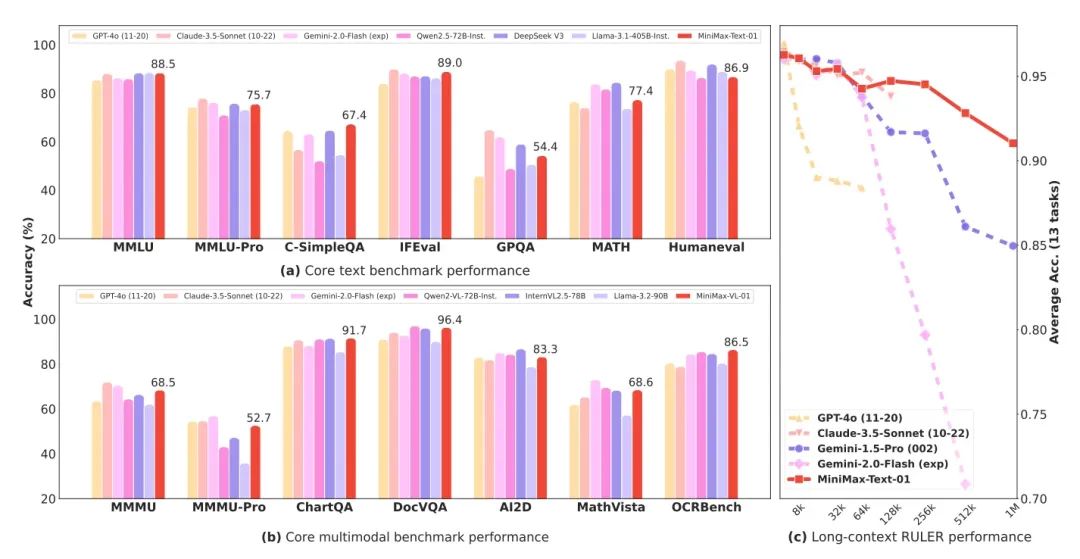

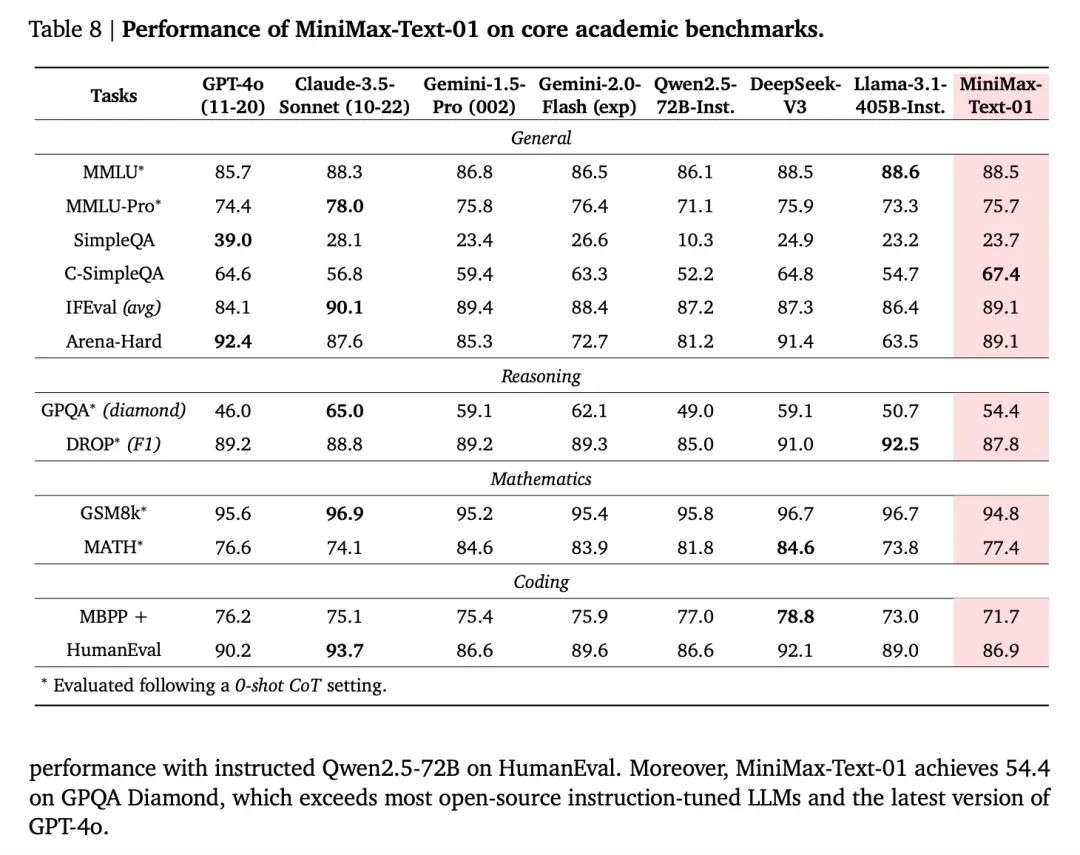

MiniMax-01は、4,560億の総パラメーターと32のエキスパートを持つMoE(Mixed Expert)モデルであり、いくつかの主流レビューセットにおいて、GPT-4oやクロード3.5ソネットに匹敵する総合力を発揮すると同時に、今日のトップモデルの20~32倍のコンテキスト長を持ち、より長い入力長を持つため、性能減衰が最も長いモデルでもある。は、性能の減衰が最も遅いモデルである。つまり、実質400万トークンのコンテキストなのだ。

- 基本言語マクロモデルMiniMax-Text-01、視覚マルチモーダル・マクロモデルMiniMax-VL-01

- Lightningの新しいアテンション・アーキテクチャ「Square to Linear」が推論コストを劇的に削減

- 重いオープンソース、テキストモデルパラメータは最大4,560億、32人のエキスパート

- 400万語の超ロング・コンテクストと海外トップモデルに匹敵するパフォーマンス

- モデル、コード、テクニカルレポートのすべてが発表された!

また、ウェブ・エクスペリエンスとAPIの両方が現在稼動しており、記事末尾のアドレスでオンラインおよび市販されている。

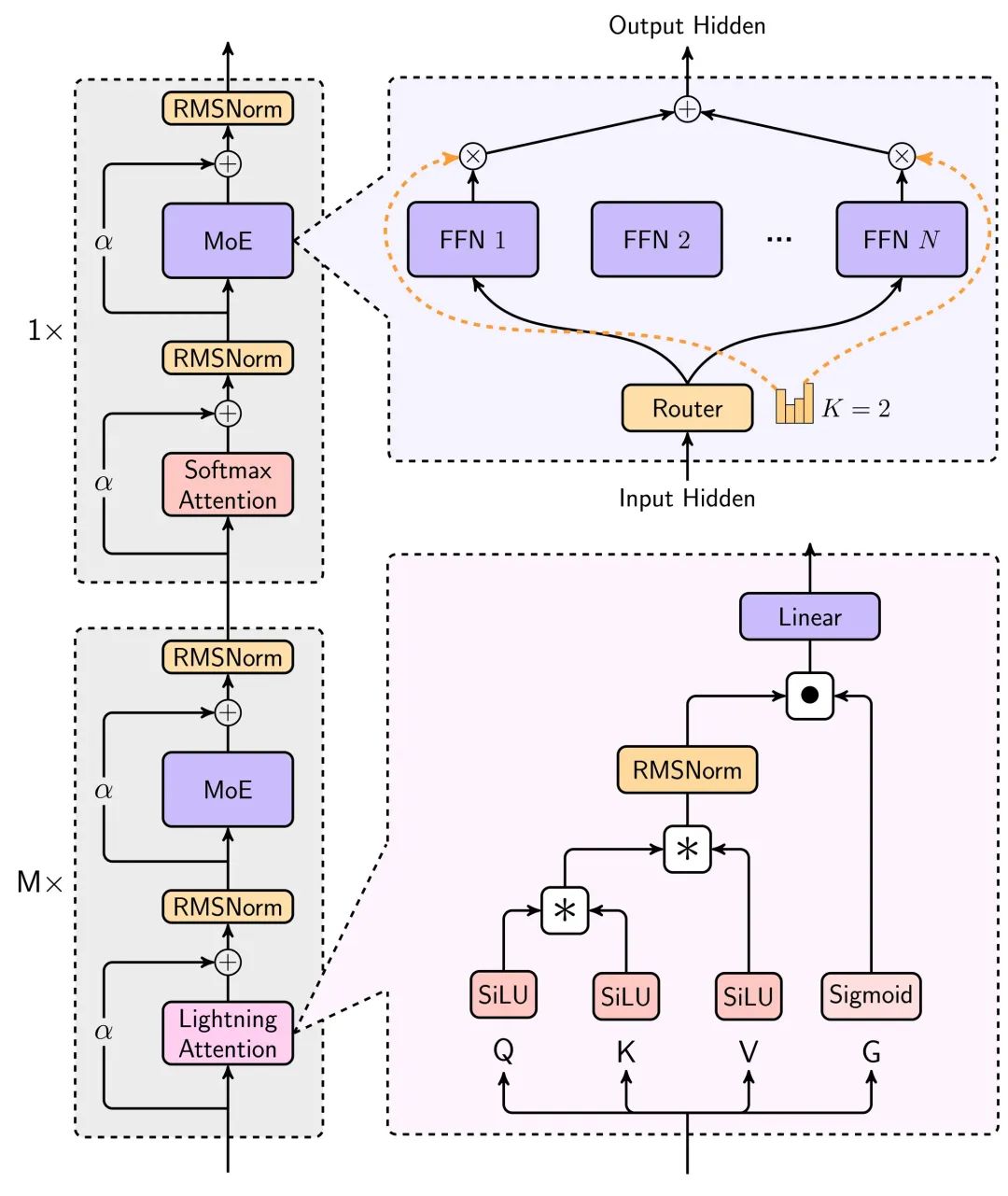

新技術:ライトニング・アテンション

このモデルで最も驚くべきことは、新しいリニア・アテンション・アーキテクチャーだ。

我々はすべての実際のAIの使用では、長いテキストが重要であることを知っている、文字チャットの長いメモリは、コードを記述するAIコーディング、エージェントは、さまざまなタスクを完了するために、シナリオは長いテキストと不可分である。

大型モデルは価格が下がっているが、使用される状況が長くなればなるほど、速度が遅くなり、価格も高くなる。

この問題の根源は 変圧器 このアーキテクチャの計算量は2次関数的である。推論の演算消費量は、コンテキストが増加するにつれて指数関数的に増加する。

今回、MiniMaxの新モデルは、長文の計算・推論時間を大幅に短縮できる線形注意メカニズム「ライトニング・アテンション・メカニズム」を採用している。

このモデリングに関する主なアーキテクチャ図は、テクニカルレポートで見ることができる。

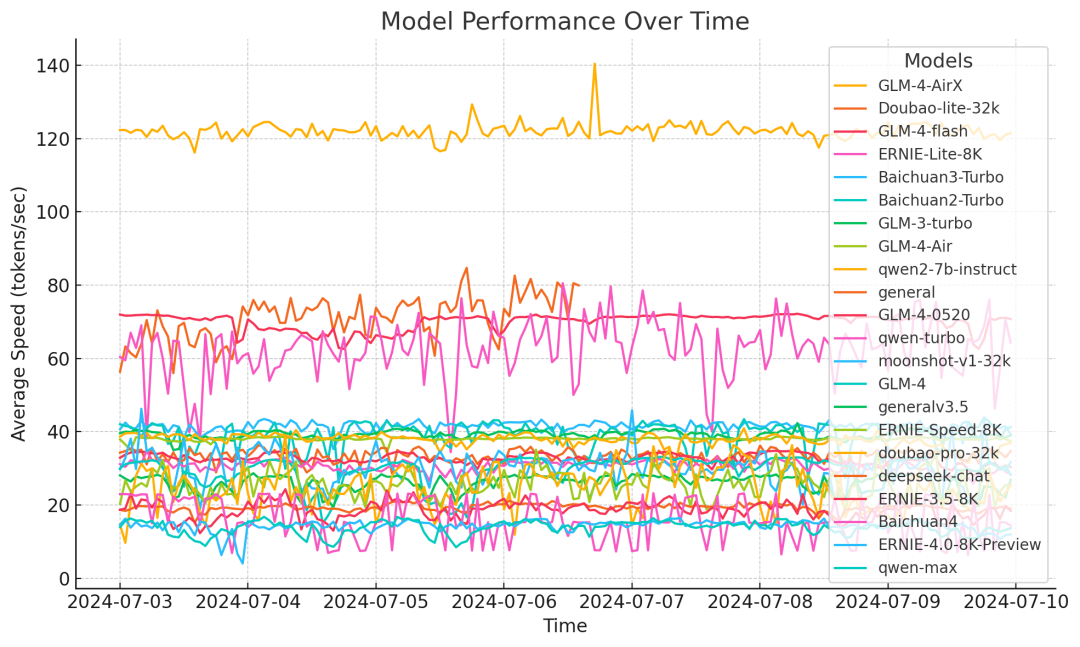

このアーキテクチャによるモデル推論リソースの消費量の削減は、長いテキストに対する推論時間を比較した以下のグラフでわかるように、非常に大きなものである。このグラフでは、コンテキストが増え続けるにつれて、推論時間が指数関数的にではなく、線形に近い形でゆっくりと増加するように線形注意が使用されている。

より詳細な説明は、記事末尾のテクニカルレポートに掲載されている。

計算量が減り、価格も下がり、本当に使える長いテキストを書くのにパフォーマンスが落ちることはない。

下のグラフは、非常に長いテキスト評価セットでのText-1のパフォーマンスを示しており、512K以上の長さの区間では驚くほどText-1が優れている。 ジェミニ 2.0フラッシュ

技術レポートのもうひとつの非常に興味深い点は、文脈が改善されるにつれて徐々に増加するモデルのIn-Context Learning(文脈内学習)能力が、長い記憶を必要とするタスクだけでなく、AIライティングにも大きな助けになるということだ。

全体として、ライトニング・アテンション・メカニズムの応用により、大型モデルの長文の使い勝手が飛躍的に向上し、価格ももう一桁下がる可能性があり、今後が非常に楽しみである。

モデルのパフォーマンス、第一線の平準化

モデルのパフォーマンス指標に関しては、オープンソースのモデルとして、多くの指標で海外の最高のクローズドソースモデルに追いついている。

また、モデルには最適化と反復のためのコンク・プラットフォームからのフィードバックがあるため、実際のシナリオのユーザー・エクスペリエンスも保証される。

テストセットを構築するために、実際のユーザーの使用シナリオを正式に使用すると、実際のシナリオでも非常に明るいパフォーマンスを見ることができます、特に顕著なシナリオは3つです:創造的な文章、知識クイズ、長いテキスト。

また、視覚認識モデル「MiniMax-VL-01」の性能は、基本的にすべての指標で海外トップモデルと同等かそれ以上であり、特に実用的なOCRやチャートシーンで高い評価を得ている。

次ページ トランスフォーマーの瞬間

モデルの世代交代が激しくなくなると、コンテキストの長さと論理的な推論が最も重視される2つの方向性になる。

文脈から言えば、ジェミニはかつて最長だった。さらに、ディープマインドのデムシ・ハサビスCEOは、グーグル社内で、ジェミニ・モデルはすでに実験で1000万トークンの長さを達成しており、最終的には「無限の長さに達する」と考えられていることを明らかにしたが、ジェミニが今それを阻んでいるのは、それに対応するコストだ。しかし、ジェミニが今それをするのを止めているのは、それに対応するコストだ。最近のインタビューで、ディープマインドは現在、このコスト問題を解決する新しいアプローチを持っていると語った。

つまり、コストを下げながら、コンテキストの長さを先に上げられる方が優位に立てるということだろう。MiniMax-01が示した結果から判断すると、本当に質的な効率化が図られている。

この徹底的なテクニカルレポートの中で、ハードウェアの使用効率は一つの統計で見ることができる - 推論では、MiniMaxはH20 GPU上で75% MFUに達する。

MFU(Machine FLOPs Utilization)とは、動作中のモデルによるハードウェア計算能力(FLOPs、すなわち1秒あたりの浮動小数点演算)の実際の利用率のことです。つまり、MFUは、モデルがハードウェア性能をフルに活用しているかどうかを表します。利用率が高ければ、コスト面で有利になることは間違いない。

ミニマックス01は、最近のデッド・オン・ザ・ウォール論争における稀有なサプライズのひとつであることは間違いない。また、最近多くの議論を呼んでいるのがDeepSeek V3である。 上述したように、今日の2つの重要な方向性、1つは推論において、もう1つはより長い文脈において、それぞれDeepseek V3とMiniMax-01が代表的である。

興味深いことに、技術的なルートという点では、両者とも今日のブームの基礎を築いたTransformerのコアとなる注意メカニズムをある程度最適化しており、ハードウェアとソフトウェアが一体となった大胆なリファクタリングだ。deepSeek V3はNvidiaのカードを搾り取るようなものだと評されているが、MiniMaxがこのような高い推論MFUを達成するためには、次のようなことも極めて重要だ。トレーニングフレームワークとハードウェアを直接最適化している。

MiniMaxの報告によると、両社は線形注意力のためのCUDAカーネルを自社で直接、ゼロから段階的かつ綿密に開発し、GPUリソースの効率的な使用を最適化するために、この目的のために付随するさまざまなフレームワークを開発した。両社は、ハードウェアとソフトウェアの能力をより緊密に統合することで目標を達成した。

もう一つ興味深い観察点は、この傑出した2社は、いずれもChatGPTの出現以前から既に大型モデル技術の研究開発に投資してきた企業であり、この2モデルの驚くべき点は、過去によく見られた「GPT4に追いつく」モードではなく、技術の進化に対する彼ら自身の判断に基づき、多額の投資を行い、イノベーションに若干の賭けさえ行い、持続的な堅実な作業の積み重ねの後に答えを出したことである。そうではなく、技術の進化に関する彼ら自身の判断に基づき、彼らは多額の投資を行い、さらにはイノベーションにいくつかの賭けをし、持続的で堅実な一連の作業の後に答えを出した。

そして、これらの答えのどれもが、自分自身のためだけのものでもない。彼らは皆、かつて研究室で立ち往生していたコンセプトが、現実のシナリオで大規模に展開されたときに約束した効果を発揮できることを証明しようとしているのであり、そうすることによって、より多くの人々がそれを最適化し続けることを可能にしているのだ。

トランスフォーマーが登場した頃を彷彿とさせる。

アテンション・メカニズムが研究室でも流行し、それでも論争が続いていたとき、その可能性を信じたグーグルが、理論的な実験から大規模な展開で実施される現実のものにするための演算とリソースを本当に積み上げたのだ。次に、今日の繁栄につながる実証済みのルートに人々が群がったことである。

Transformerはより多くのレイヤーを重ね、より多くのパワーを使い、MiniMax-01は古い注意メカニズムをオーバーホールしようとしている。注意のメカニズムを強調するためにグーグルの研究者がつけた有名な論文タイトル「Attention is all you need(必要なのは注意だけ)」も、ミニマックスにはぴったりだ。-必要なのは注意だけだ。

「このモデルは現在、通常のソフトマックス注意の1/8を維持している。我々はより効率的なアーキテクチャに取り組んでおり、最終的にはソフトマックスの注意を完全に除去し、計算過多となることなく無制限のコンテキストウィンドウを実現することが可能になる。"

モデル価格

インプット:100万ドル トークン

出力:800万ドル/トークン

基本的には目を閉じて使う。

モデリング・リソース

コードhttps://github.com/MiniMax-AI/MiniMax-01

モデルhttps://huggingface.co/MiniMaxAI/MiniMax-Text-01, https://huggingface.co/MiniMaxAI/MiniMax-VL-01

テクニカルレポート:https://filecdn.minimax.chat/_Arxiv_MiniMax_01_Report.pdf

ウェブサイド:https://hailuo.ai

API。 https://www.minimaxi.com/

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません